深度卷积网络的自然场景文本检测研究综述

宋传鸣,王一琦,武惠娟,何熠辉,3,洪 飏,王相海

1(辽宁师范大学 计算机与人工智能学院,辽宁 大连 116081)

2(辽宁师范大学 文学院,辽宁 大连 116081)

3(中国科学院大连化学物理研究所 科学传播处,辽宁 大连 116023)

4(苏州大学 江苏省计算机信息处理技术重点实验室,江苏 苏州 215006)

1 引 言

文字作为人类记录信息和传达信息的重要媒介,广泛地出现在各类自然场景图像中.对自然场景中的文本进行自动检测及识别,不仅能够提取图像的高层语义,还有助于自然场景图像的分析与理解.鉴于此,车牌识别、图像检索、即时翻译、自动驾驶、智能导航、大数据场景解析等诸多视觉应用均需对自然场景图像中的整个单词或句子的文本位置进行定位,其检测精度对于保证特征提取、文本分析和文字识别等后续处理的效率具有关键作用.在这种情况下,自然场景文本检测已经成为目前文本检测与识别领域的热点问题之一.

除了受到复杂背景、光照变化、拍摄视角等外部干扰外,自然场景文本检测还面临文字种类丰富、排列方向多样、文本行组成复杂、文本长宽比不一等诸多自身结构因素的严峻挑战[1].于是,连通域分析、滑动检测窗等传统文本检测方法囿于人工设计特征的分类能力不足,抵抗复杂背景、混合噪声、低对比度和颜色多变等干扰的鲁棒性不够,导致其在较长的一段时间内难以取得较大突破,始终无法满足复杂自然场景的文本检测需求[1].鉴于深层神经网络能够突破人工预设特征的局限,允许计算机在海量的图像数据集中自主学习有效的特征表示,基于深度卷积网络的检测方法已发展成为自然场景文本检测领域的主流方法.它利用一系列卷积结构和大量的网络参数将图像的浅层特征组合成高层特征,再用高层特征表示更加抽象的语义信息,进而表现出了更强的数据特征表示能力及非线性拟合能力.因此,与传统方法相比,深层网络能更加有效地求解复杂自然场景下的从图像特征到文本位置的非线性预测问题,并且出现了一系列诸如基于区域建议的文本检测方法、基于语义分割的文本检测方法、基于端到端的文本检测方法等[1,2],取得了不错的文本检测效率和应用效果.

为了清晰地梳理代表性方法的研究进展,文献[1-3]从主要技术原理的角度,对自然场景文本检测的传统方法和深度学习方法进行了分类阐述和对比分析,文献[4]则从技术实现特点的角度对基于深度学习的文本检测与识别方法的核心思想、关键技术做了广泛调研和全面评价.然而,文献[1-4]均重点考察了各种方法所采用的网络模型的设计思路和工作机制,却忽视了对其主干网络的梳理与讨论.事实上,不同的骨干网络架构所具备的特征提取效率、拟合能力、收敛效率和功能特点互有差异,将直接影响到其下游模块的技术思路及其处理性能[5,6].

鉴于此,本文通过对近十年的基于深度学习的自然场景文本检测主流方法进行归纳和整理,将其骨干网络架构划分为VGG(visual geometry group)网络[7]、残差网络(residual networks,ResNet)[8]和特征金字塔网络(feature pyramid networks,FPN)[9]3种形式;然后,从自然场景文本检测的技术特点出发,在回顾其发展历程和早期研究工作的基础上,依据骨干网络的不同将现有基于深度卷积网络的自然场景文本检测方法划分为3类,即基于VGG网络的检测方法、基于残差网络的检测方法和基于特征金字塔网络的检测方法,并对基于不同骨干网络实现的文本检测方法进行阐述,评价其优势和不足;在此基础上,对代表性方法在公共数据集上的客观性能进行比较分析,进而展望自然场景文本检测技术的未来发展趋势.

2 相关背景

随着即时翻译、场景解析、自动驾驶等实际应用的推进与产业化,越来越多的研究人员和国内外大型人工智能企业在自然场景文本检测与识别技术上投入了大量的研究精力,例如谷歌[10]、微软[11,12]、阿里[13]和旷视[14]等,进而推动了自然场景文本检测方法与应用的不断发展.

2.1 传统的自然场景文本检测方法概述

自然场景文本检测的相关研究最早可追溯至20世纪90年代初.研究人员将传统的计算机视觉技术应用于自然图像文本检测与识别领域并获得了一系列成果,其中最具代表性的方法包括最大稳定极值区域方法(maximally stable extremal regions,MSER)[15]、基于连通域分析的笔划宽度变换方法[16]和基于滑动窗口的区域特征分类方法[17,18].文献[15]提出了一种基于文本行假设手段的端到端文本定位和识别方法,首先检测得到最大稳定极值区域集合,再利用支持向量机(support vector machine,SVM)[19]过滤集合中的非文本元素得到检测结果.文献[16]提出了一种基于笔划宽度变换的自然场景文本检测方法,其主要思想是利用坎尼算子和笔划宽度变换计算文字笔划的候选连通域,再采用形态学分析和字符聚合操作得到文本行.针对中文字符结构复杂的问题,文献[20]首先利用坎尼算子和局部梯度方向算子细化最大稳定极值区域,然后通过区域长宽比、欧拉数和区域面积比、包围盒等几何先验建立联合约束,实现文本区域的过滤和聚合,进而采用支持向量机完成文本区域的决策,提出了边缘增强的最大稳定极值区域检测方法.

尽管传统的文本检测方法在自然场景下取得了一定的效果,可是这些方法通常均需要人工设计复杂的检测特征、特征分类器及其后处理流程.而且,不同于规则的文档图像,自然场景下的文本检测主要存在不规则尺寸、模糊背景、目标遮挡、任意文本排列方向和异常变化的纵横比等特点,这给自然场景文本检测带来了巨大挑战.并且,随着含有文字目标的自然场景愈趋复杂,这些传统技术愈发难以满足实际应用对自然场景文本检测精度和效率所提出的越来越高的迫切需求.

2.2 面向自然场景文本检测的深层神经网络概述

考虑到文本检测作为目标检测的特例,研究人员将用于目标检测的深层神经网络模型引进自然场景文本检测,取代了传统基于人工设计特征的图像文本检测方法.其主要思想是,通过深层神经网络模型提取自然场景图像中文字前景区域和非文字背景区域的纹理、边缘、轮廓和颜色等局部/全局特征,从而达到判别文本区域、定位文本位置的目的,取得了不错的处理效率和快速的研究进展.

总体上看,深层神经网络主要包括卷积神经网络和循环神经网络[4].其中,卷积神经网络是一种带有卷积结构的深层神经网络,卷积结构可以减小网络占用的内存空间,而池化层既能够减少网络参数的数量并缓解模型的过拟合问题,又增强了所提取特征的旋转和平移不变性.卷积神经网络的这些特点使其在图形、图像的数据分析与处理领域得到了广泛的应用;循环神经网络的最大特点在于网络隐含层的输入包含当前时刻隐含层的输入和上一时刻隐含层的输出,网络会对前面的信息进行记忆并作用于当前输出,从而学习到具有时序的数据特征,擅长处理具有时序性特征的语音、视频等数据.因此,根据两类深层神经网络的特点及其技术优势,卷积神经网络更加适用于包括自然场景文本检测在内的目标检测领域并发挥了重要作用.

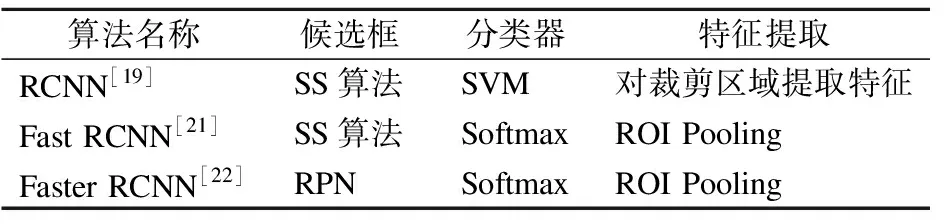

率先将深度卷积神经网络应用于目标检测领域的算法是RCNN[21].该网络模型在AlexNet[22]的基础上引进了线性回归和SVM等算法,实现了目标检测的目的.针对RCNN中候选区域生成的缩放问题,Fast RCNN[23]进一步提出了感兴趣区域池化层(ROIPooling),其作用是在不同尺度下的特征图上提取每个感兴趣区域的特定尺寸的特征向量.同时,Fast RCNN还采用Softmax函数取代RCNN的支持向量机来完成分类操作,其最大的好处在于有效提高处理速度并加速整个网络的训练.不过,在提取候选框的过程中,Fast RCNN采用的选择搜索算法存在耗时较长的问题.于是,Faster RCNN[24]在Fast RCNN模型中添加了区域推荐(region proposal network,RPN)模块,通过共享卷积特征的方式将RPN和Fast RCNN合并为一个网络,实现了端到端的目标检测网络框架.表1对RCNN系列的不同框架进行了对比,其中,RCNN只利用卷积结构完成特征提取作用;Fast RCNN将特征提取、分类和边界框回归都融合到了卷积网络中;而Faster RCNN在Fast RCNN中添加了区域推荐模块,显著提升了模型的目标检测效率.

表1 RCNN系列框架对比Table 1 Framework comparison of RCNN series

目前,由RCNN继承和发展出来的Faster RCNN系列模型被广泛应用于自然场景文本检测领域,基于深度卷积网络的自然场景文本检测已成为计算机视觉领域的热点问题,吸引了众多的国内外研究机构与学者展开深入研究.下文将对基于深度卷积网络的自然场景文本检测方法进行分类阐述,对比分析各类方法的基本思想及其技术特点.

3 自然场景文本检测方法

AlexNet的出现使卷积神经网络迎来了历史性突破和深度学习技术的爆发,VGG、GoogleNet、DenseNet、ResNet、MobileNet、FPN、ResNeSt[25]和Transformer[26]等骨干网络结构相继提出并不断刷新相关领域的算法性能上限.然而,不同骨干网络模型的特征提取效率、拟合能力、收敛速度和功能特点互有差异[5,6].例如,VGG引进了层数更深的小卷积核、小池化核来提取各个尺度下的图像局部特征,提高了网络对自然场景纹理细节的非线性逼近能力,其对单一尺度下的特征分析能力较强,但不具备多尺度特征的融合分析能力;ResNet则更加关注所有尺度下的融合局部特征,引进跨层的直连边(shortcut connection)和自底向上的融合机制,提高了网络对最佳特征尺度及其加性组合的自适应能力和文本检测精度,也可有效缓解网络深度增加所导致的梯度消失等问题;FPN同样关注所有尺度下的融合局部特征,不同之处在于其采用一种自顶向下、横向连接的体系结构,可以实现不同尺度下的特征融合,并且避免了融合过程中的频率混叠和细节丢失现象,增强了网络对混合尺寸的文本实例对象的灵敏度以及检测效率.显然,骨干网络的特征提取思路及其对各尺度下图像特征的处理策略的不同,使得基于这些骨干网络的自然场景文本检测方法在下游检测机制、适用的场景和文本特点等方面均表现出明显差异.骨干网络的不同,意味着实现文本检测的关键技术思想和解决方案存在根本不同.

因此,根据不同的骨干网架构,本节将现有基于深度卷积网络的自然场景文本检测方法划分为3类,即基于VGG网络的检测方法、基于残差网络的检测方法、基于特征金字塔网络的检测方法.下文,将分别详细阐述各类方法的技术特色及其优缺点.

3.1 基于VGG网络的自然场景文本检测方法

文献[7]提出的VGG网络模型和文献[10]并称为ILSVRC-2014的双雄,其主要贡献在于验证了使用更深层的小尺寸卷积核的堆叠结构能够有效提升卷积神经网络的非线性拟合性能.相较于AlexNet等浅层网络,VGG的卷积核尺寸更小、深度更深,能够提取出待检测目标在更多尺度下的图像局部特征,捕获其细尺度的纹理细节和粗尺度的边缘轮廓,从而有利于更加准确地分析、定位文本目标.为此,VGG在目标检测领域中发挥了显著作用.

依据文本检测的核心技术特点,现有基于卷积神经网络的自然场景文本检测路线大致包括回归和分割:前者将场景文本视为通常的待检测目标,并将文本检测建模为边界框位置坐标的回归问题;后者则采用文本区域分割的方法,通过卷积网络提取图像的纹理、边缘、轮廓等特征图,再据此预测文本区域的分割结果,不过,该类方法大多需要复杂的后期处理.下面,本节主要介绍以VGG网络为骨干网的两类文本检测方法.

3.1.1 基于回归的自然场景文本检测方法

基于回归的自然场景文本检测方法包含直接回归和间接回归两类.基于直接边框的回归方法通过卷积神经网络提取文本区域与非文本区域在边缘、纹理特征方面的差异性特征,预测每个像素是否属于文本区域,再通过回归分析计算得到该位置所属文本框的参数信息;间接回归方法是预测某个边界框的真值框与候选框表征参数的偏移量.

大多数文本检测模型都假定文本实例形状服从线形分布,导致模型在检测不规则形状的文本时效果很差.为此,文献[27]提出了一种旋转敏感的场景文本检测方法来解决多方向文本检测问题.该方法在SSD(single shot multi-box detector)网络结构[28]基础上将传统卷积结构替换为定向响应卷积,并将SSD中用来实现多重特征融合的编码器替换为旋转敏感回归(rotation-sensitive regression,RSR)编码器,使得改进后的深度网络结构可以提取旋转敏感的卷积特征,从而对多方向文本行具有更优的检测性能.同时,为克服 SSD 网络对于小目标检测鲁棒性差的不足,文献[29]提出了一种端到端可训练的文本检测框架TextBoxes,通过调整候选框的默认长宽比、滤波器尺度等途径,提升了深度网络模型对于水平方向的长文本的检测效率.然而,对于间距较大、曝光程度较强的自然场景图像,该方法的文本检测性能仍然较差,且存在较为明显的方向依赖性.为了解决TextBoxes对非水平方向的文本检测效果不理想的问题,文献[30]将传统水平方向的候选框替换为带有方向信息的任意四边形候选框,并且对原方法中的损失函数进行了更具针对性的设计,融入了带有方向信息的回归损失,从而提出了一种面向文字区域检测的TextBoxes++模型,其网络结构如图1所示.然而,该方法对于文字的排布方式较为敏感,在字符间距较大、文字呈现曲线或垂直方向排列和图像分辨率较低等情况下,其文本检测性能会不可避免地出现一定程度的下降.

图1 TextBoxes++模型结构[28]Fig.1 Architecture of TextBoxes++[28]

为了充分利用图像的局部目标在整个图像中的上下文信息,文献[31]提出了一种基于垂直锚点机制的文本检测方法CTPN(connectionist text proposal network).该方法联合应用卷积神经网络和循环神经网络,提高了网络对上下文信息的感知能力,并利用垂直锚点机制预测每个候选区域的评分,进而获得最终的检测结果.由于发掘了丰富的图像上下文信息,CTPN能够检测自然场景图像中较模糊的文本,却对倾斜文本显得力不从心.鉴于此,文献[32]提出了一种基于片段连接的文本检测方法SegLink.它通过改进的SSD网络来预测每个分段与其他分段的连接关系,然后利用连接关系学习,从带有方向信息的候选框以及不同候选框之间的连接关系中得到各个候选框的连接置信度,再用后处理的方式完成候选框的连接,最终得到文本行的检测结果.然而,对于密集文本区域,SegLink方法的文本分段预测方式仍然会无法正确区分单独的文本实例[4].于是,文献[33]改进了SegLink的文本组件分组预测方式,并提出了一种文本实例感知的分组策略.它采用吸引系数建模同一文本区域内的文本块之间的正相关性,利用排斥系数刻画分属于不同文本区域的文本块之间的负相关性,再以分割质量和相关性系数的线性组合建立文本实例感知损失函数用于训练和自适应优化文本片段的分组结果,进而能够更加准确地区分紧凑排列的文本,尤其能更加有效地处理不规则的曲线文本.

通过预设候选框来回归预测文本框位置的方式具有一定的盲目性,且基于直接边框的回归方法在检测长文单词或者文本行时由于感受野的限制导致其定位准确率不高、文本框短边的回归误差较大[4].因此,文献[34]将直接边框回归转化成了一种对文本框边界进行学习的计算任务,从而得出候选框的边界概率图;在此基础上,利用较长边界的概率图确定文本的行坐标,再通过文本行所在区域的直接边框回归结果计算其短边界,最终得到目标文本的边框.

尽管基于回归的检测算法可以直接预测任意形状的文本,可是大多数回归算法均需要复杂的参数化来预测和适应文本边界.受到场景文本的任意方向和异常纵横比的限制,很难使候选框与真值框之间具备较好的匹配关系.而且,候选框的匹配预处理及采样操作导致检测速度较慢,缺少高效性和鲁棒性.

3.1.2 基于分割的自然场景文本检测方法

该类方法的核心思路是利用深层神经网络提取包含自然场景图像丰富信息的特征图,再充分利用特征图在明暗、细节纹理、边缘轮廓区域的可学习差异,将分属不同目标的像素进行分类并区分文本区域的特征,以此来预测文本目标的分割结果[35].大多数基于VGG网络的自然场景文本检测方法建立在自下而上的策略之上,而通过探索低级图像特征来检测笔划或字符的机制却缺乏足够的稳健性,很容易产生大量的非文本候选者.为此,现有工作主要从3种策略出发,即引入上下文信息、全局位置信息和区域—字符关系,达到提升局部特征的检测稳健性的目的.

首先,在上下文信息引入方面,文献[36]提出了用于直接文本区域估计的级联卷积文本网络CCTN(cascaded convolutional text network),通过用1×1卷积替换全连接层设计了一种高效的自上而下的管道,利用完全卷积运算在一定程度上保持图像的粗尺度空间特征,再以从粗到精的方式定位文本区域实现了完全卷积网络的语义分割.文献[37]则提出了一种基于实例分割思想的场景文本检测方法PixelLink.该方法通过深层神经网络实现像素级的文本判别预测及连接预测,得出当前像素的类别归属(文本类或者非文本类)以及不同像素与同一文本实例的关联关系,进而实现实例分割.与典型方法的策略不同,上述两种方法不仅考察了当前像素自身的特征,还通过进一步评估当前像素的上下文邻域的预测结果进行后处理,得到最终的候选框作为检测结果.可见,在局部特征的基础上结合一定的全局信息,有助于提高文本检测的精度.

其次,鉴于VGG网络对局部特征的分析能力强却无法有效获取全局特征的情况,文献[38]提出了一种融合局部信息及全局信息的全卷积多方向文本检测方法.该方法首先采用基于文本块的全卷积网络进行检测,得到显著性区域映射,再借助最大稳定极值区域的局部信息对文本块施加行提取操作,然后利用全卷积网络(Character-Centroid FCN)获取字符质心的显著性映射,进而根据质心信息去除非文本结果并利用非极大值抑制操作剔除重叠的框选区域.但是,该方法在低对比度、密集文本区域中的文本检测效果较差.文献[39]提出了一种角点定位和区域分割的多角度场景文本检测方法.该方法采用两个并行分支网络,第一分支使用局部边角点检测代替传统的目标检测来提取文本区域,第二分支用类似基于区域的全卷积网络(region-based fully convolutional network,RFCN)的网格划分思路实现融入了全局位置信息的位置敏感分割.这些改进能够更好地适应不同的文字方向、长宽比及字形尺度,但其局限性表现在当两个文本实例非常接近时,全局位置敏感分割可能失效,容易把两个文本行预测成为一个文本实例.

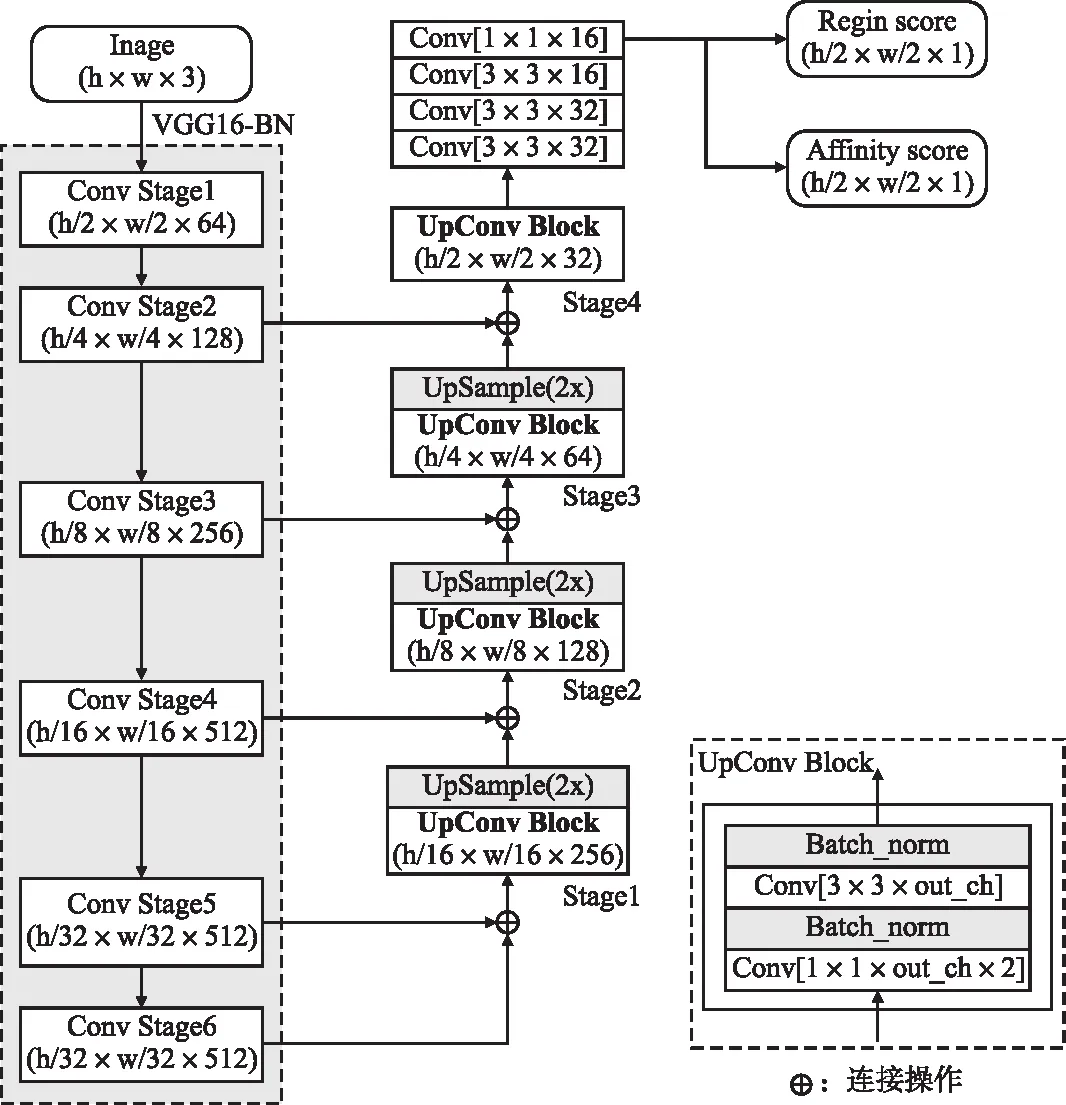

然后,在区域—字符关系方面,文献[40]提出了一种基于文本区域感知的文本检测方法CRAFT(character region awareness for text detection),用来解决较长文本行的检测问题,其网络结构如图2所示.该方法以字符级目标为检测对象,通过卷积神经网络预测字符区域和字符之间的亲和力,进而实现由字符到单词实例的组装.其不足之处在于,无法对存在笔划粘连或紧邻的文本区域进行有效检测,并且对弯曲文本行的处理效率也不高.而文献[41]提出的基于HED(holistically-nested edge detection)模型的自然场景图像文本检测方法,通过对整幅图像进行语义分割,并分别对文本区域、字符以及相邻字符的连接方向概率等属性进行评估来构建图模型,从而得到文本行信息.由于文本行包含了空间相似性信息和方向相似性信息,因此该方法具备一定的从图像中发现多方向甚至弯曲文本的能力.不过,该方法对于图像质量具有较高的敏感性,若待检测图像中存在严重模糊或高亮的退化区域,则无法获取有效的检测结果.针对场景文本的复杂背景问题,文献[42]提出了一种基于文本域的文本检测方法TextField,先学习得到一组由 2 维矢量表示的方向场,再通过方向场的编码实现文本区域与非文本区域的分离.同时,方向场对文本掩码、方向信息的编码及其后续的文本分组提供了有效依据.然而,当自然场景图像存在遮挡、字符间距较大、类文本区域混杂的情况时,上述方法的检测性能均不尽人意.

图2 CRAFT模型结构[38]Fig.2 Architecture of CRAFT[38]

虽然VGG网络在自然场景文本检测方面取得了一定效果,但是对于存在文本行弯曲、前景或背景复杂、文本长宽比不一等情况的自然场景图像,尚无法达到令人满意的检测精度.根本原因在于,在给定的VGG网络结构下,图像特征所对应的感受野和尺度也随之确定,不具备根据前景/背景及长宽比来自适应选取最佳尺度的能力.而且,经过多次卷积后的特征图具有较大感受野,对小尺寸的文本检测不利.此外,由于网络层数的限制,VGG网络无法提取更高层次的文本特征.

3.2 基于残差网络的自然场景文本检测方法

随着网络深度的增加,其预测准确度会出现梯度弥散现象,导致深度学习模型难以训练.为了解决这个问题,文献[8]提出了一种残差学习单元,通过跨层的直连边将浅层网络的输出和深层网络的输出进行叠加,旨在当前网络中的特征表示达到足够优良时,把深层网络转换为恒等映射.这种信息传递方式的优化有效提高了梯度的反向传播效率,使训练更深层的网络成为可能;更为关键的是,使卷积神经网络具备了对最佳特征尺度的自适应训练能力,从而将浅层信息和深层信息实现加性融合,达到检测不同尺度目标的目的.为此,残差网络在自然场景文本检测中取得了优于VGG网络的检测性能.因为文本行的宽度和高度往往差异较大且带有一定方向性,所以该类方法需在优化检测尺度的同时,确定恰当的感受野.于是,现有工作主要围绕3个方面展开深入研究,即引入矩形感受野、自上而下的检测策略以及检测—识别模块间的互补关系.

首先,文献[43]采用残差网络作为骨干网,提出了一种自然场景下的快速文本检测方法 EAST(Efficient and accurate scene text detector),该方法利用上采样操作融合不同层的特征得到预测特征图,并在确定候选区域时融入旋转角度信息生成文本四边形,再以0.3倍于预定义参考长度的比例对文本四边形进行收缩,从而排除非目标信息对检测结果的干扰,最终得到带有角度信息的文本区域候选框.遗憾的是,由于感受野尺度有限,该方法可能会导致部分文本区域被划分到候选框之外,其对长文本和垂直方向排布的文本检测效果尚不够理想.针对EAST不擅长检测长文本的问题,文献[44]提出了一种面向任意四边形候选框的文本检测网络.由于低层特征语义信息有利于在小尺度下提供精细的目标位置,而高层特征语义信息则可在大尺度下给出粗略的目标位置,因此该网络利用上采样操作融合不同尺度下的特征,进而得到预测特征图及其检测框.进一步地,文献[45]在 EAST 的基础上加入了空洞卷积结构来提高网络的感受野,并增加1×5以及5×1的对称卷积结构以提升网络对横竖排长文本的检测效果.文献[46]在EAST模型的特征融合阶段加入长短时记忆方法 LSTM来优化训练样本信息,提高了检测精度.文献[47]则引入了时序注意力机制,利用全连接网络的语义特征融合和多通道回归分析得到初始检测框,再引进联合时序注意力的卷积递归神经网络对初始预测结果进行文本/非文本区域的精细分类来剔除虚警文本区,进而提高文本检测的准确率.

其次,采用局部像素或组件以自下而上的方式对文本实例进行建模的稳健性尚有不足,细尺度下的局部特征通常会被噪声所污染,以致影响文本检测效率.鉴于此,自上而下的策略则有助于利用粗尺度下的、受噪声影响较少的特征来约束像素或字符组件的组装,从而增强文本检测结果对噪声的鲁棒性.针对这一问题,文献[48]提出了一种改进的任意形状场景文本检测方法.该方法利用自适应RPN网络得到初步建议目标,再通过局部正交文本感知模块分别建模水平方向和竖直方向的局部纹理特征,在利用点重计分算法对检测结果进行细化后,即可得到文字区域的最终候选框.为了加快轮廓的渐进演化速度,文献[49]提出了一种渐进轮廓回归(progressive contour regression,PCR)的场景文本框架.该方法将初始文本的生成过程转化为一种自上而下的文本轮廓演化过程,利用轮廓聚合操作计算任意形状的边缘高层语义并抑制轮廓噪声的影响,从而实现复杂文本区域的准确定位.借鉴实例分割的思想,文献[50]所提出的Mask TextSpotter模型采用残差网络作为骨干网以建立更高级的语义特征图,通过RPN分支实现候选区域推荐,并由Faster RCNN分支完成回归及分类任务,最终经过Mask分支得出全局文本实例分割和字符级分割结果,提高了任意形状文本检测的准确率和召回率.

最后,典型的网络体系结构大多将检测模块和识别模块整合到相互独立的分支中,然而它们都需要查找字符区域的位置,所以采用基于注意力的解码器和表示字符区域空间信息的检测器之间必然存在互信息.为了充分发掘检测模块与识别模块之间的互补关系,文献[51]提出了一种CRAFTS模型,将CRAFT的骨干网由VGG16替换成ResNet50,并引入链接表示和方向估计,再利用检测器的空间字符信息构建模块之间的互补关系.一方面,检测模块的输出特征能够为识别模块提供更准确的字符中心信息;另一方面,识别模块的输出又能进一步提高检测模块对于字符区域的定位精度及其稳健性.

尽管残差网络实现了明暗、纹理细节等浅层特征与主要边缘、整体轮廓等深层特征的加性融合,可是在自上而下地完成特征融合的过程中,浅层特征图必须经过下采样才能具有与深层特征图相同的空间分辨率,会不可避免地丢失一部分细节信息并导致频率混叠.在这种情况下,对于文本种类丰富、场景结构复杂、文字目标较小的自然图像,基于残差网络的自然场景文本检测方法的性能必将受到一定影响.

3.3 基于特征金字塔网络的自然场景文本检测方法

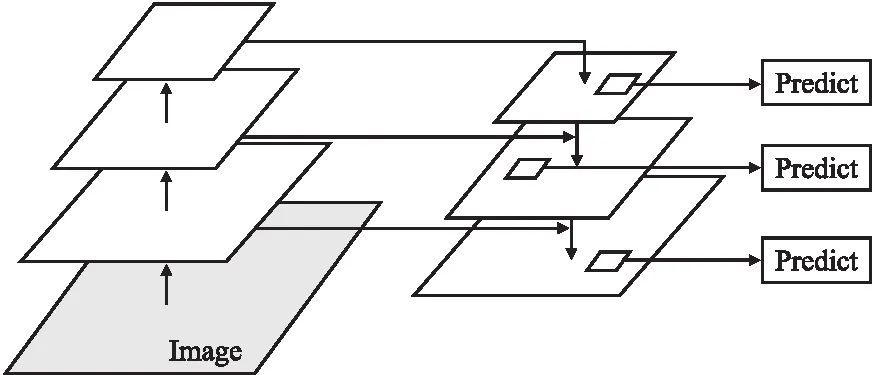

针对文本检测的尺度自适应问题,尤其是小目标检测中存在的卷积神经网络分辨率和语义化程度之间的矛盾,文献[9]提出了一种特征金字塔网络FPN结构.如图3所示,FPN具有横向连接的自顶向下体系结构,可以将上采样后的深层特征向下传递,进而将低分辨率语义信息特征图与空间信息丰富的高分辨率边缘局部信息特征图相结合,得到空间分辨率更高、通道数量更多、语义更强的多尺度融合特征图.因此,特征金字塔网络对于不同尺度的文本实例对象有较好的检测效果,特别有利于小目标和复杂文本目标的检测.

图3 FPN网络结构[7]Fig.3 FPN network structure[7]

不过,采用将两个不同尺度的特征图进行简单相加的传统融合方式往往导致特征融合不充分的问题.鉴于上述两个方面,研究人员主要围绕两个角度展开工作:1)优化多尺度特征的融合方式;2)充分利用多尺度融合特征提高自由文本的检测效率.

首先,在多尺度特征融合方面,文献[52]提出了一种多尺度特征融合模型TextFuseNet.不同于现有的基于有限特征表示的检测方法,它采用FPN+ResNet网络结构作为骨干网提取字符、单词和全局3个级别的特征,并在此基础上,使用多路径特征融合体系结构将3种层次的特征进行融合,得到更具代表性的特征表示,从而有助于实现更加鲁棒的任意文本检测.文献[53]提出了一种渐进式扩展网络PSENet(progressive scale expansion network)来解决相邻文本区域不易区分的问题.考虑到小尺度卷积核之间往往存在较为显著的边缘特征,该方法借助基准图像生成一系列不同大小的掩膜来实现特征融合与文本行预测,从而在很大程度上抑制了典型方法在处理行距较小的文本行时所出现的重叠识别现象.文献[54]提出一种基于可切换空洞卷积与注意力导向的特征金字塔网络,针对多尺度特征融合导致语义信息丢失的问题,采用特征增强融合模块加强模型对尺度、空间、任务的感知能力,取得了较好的检测结果,且召回率有明显的提升.文献[55]采用ResNext101改进了PSENet的骨干网,从最粗尺度下的文字实例特征图开始,利用广度优先算法和“先到先得”策略逐渐扩展每个文本中心区域,从而将粗尺度与细尺度的文本像素进行逐层地膨胀式融合,达到对文本图像中的文字进行精确定位的目的.

其次,受到检测框形状的限制,现有方法对线形分布的文本具有较好的检测效率,并能够利用水平矩形框、旋转矩形框或任意四边形框给出相应的定位结果.然而,面对自由形式的文本实例时,这些方法的表现却往往差强人意.为了解决这一问题,基于分割的文本检测算法都需设置固定的阈值计算二值图,旨在将分割生成的概率图转换为文本的包围框.为此,文献[56]提出一种可微分二值化的检测网络模型,解决了自适应阈值下的梯度微分问题,进而能够提供更加健壮的二值图来判别文本区域和背景区域,并分离那些笔划粘连或者紧邻排列的不同文本实例,提高文本检测的性能.文献[57]提出了一种灵活的场景文本表征方法TextSnake,该方法假设文本实例由一串具有不同半径和方向的、有序且重叠的圆形区域组成,其中,每个圆形区域的半径和方向分别取决于文本实例的宽度、排列方向,进而以水平、多方向和弯曲的形式来预测文本区域、中心线及其几何属性,最终得到文本实例的检测结果.文献[58]提出了一种基于深度关系推理图网络的文本检测方法,以带有FPN的VGG16作为骨干网络实现卷积特征提取,利用共享卷积特征分析文本组件的几何属性,供局部图模块建立组件间的连接关系,再通过关系推理网络的推断结果实现文本组件的组合,得到完整的文本实例.然而,上述基于区域的文本检测策略对高度弯曲文本的检测能力仍有不足,所生成的轮廓点序列无法有效逼近文本区域的理想轮廓.于是,文献[59]提出了自适应贝塞尔曲线网络ABCNet(adaptive Bezier-curve network),其最大亮点在于使用了贝塞尔曲线来构成文本框,进而支持任意形状文本的预测,而且不会过多增大参数量.此外,为了较好地获得文本区域,ABCNet采用BezierAlign技术对不规则形状的文本进行特征对齐和截取,从而移除造成干扰的背景区域.不过,该方法只能感知一次具有复杂几何布局的场景文本,会不可避免地产生不准确的定位结果.文献[60]提出了一种傅里叶轮廓嵌入技术,旨在有效逼近任意形状的、封闭的文本区域轮廓.与以往方法的不同之处在于,该方法首先预测文本实例的傅里叶特征向量,然后利用傅里叶反变换和非极大值抑制方法在图像空间域重构文本轮廓点序列,能够更加紧凑地表示任意形状的文本轮廓,在自然场景下的任意形状文本检测方面表现出良好的通用性和稳健性.

总体来看,特征金字塔网络有效缓解了局部目标在整幅图像中的上下文信息不足、细节信息失真和频率混叠等问题,在不同尺度下的自然场景文本检测方面显示出了明显的进步.不过,如何自适应地优化选取恰当的尺度数量以及不同尺度下的特征耦合方法,对于提高小尺寸文本和复杂自由文本的检测性能仍是值得进一步深入研究的问题.

4 自然场景文本检测方法的比较分析

为了便于自然场景文本检测方法的比较,本节将首先介绍用于自然场景文本检测的公共数据集,并在此基础上,对目前的代表性自然场景文本检测方法的客观性能进行对比分析.

4.1 自然场景文本检测数据集

表2给出了用于自然场景文本检测的公共数据集.其中,ICDAR2013[61]和ICDAR2015[62]是常用的线形文本检测数据集;Total-text[63]是弯曲文本检测的重要数据集;ICDAR MLT[64]和CTW-1500[65]是包含多种语言的自然场景文本检测数据集;CTW[66]是超大型的自然场景中文数据集;而VinText[67]则是自然场景下的越南语数据集.下文详细介绍这些公共数据集的具体内容及其特点.

表2 自然场景文本检测与识别的公共数据集Table 2 Common datasets of natural scene text detection and recognition

1)ICDAR2013:该数据集是2013年国际文档分析与识别会议设置的鲁棒阅读竞赛(robust reading competition,RRC)环节所公开的聚焦文本数据集,其中包含路标、书籍封面和广告牌等场景的、清晰的自然场景文本图像.

2)ICDAR2015:该数据集是2015年国际文档分析与识别会议在RRC的偶然场景文本(incidental scene text)阅读竞赛中所公开的公共数据集,其中,每幅图像都是采用谷歌眼镜在未聚焦的情况下进行随机拍摄获取的,主要反映街头、超市、商场等公共场所的场景,旨在帮助文本检测和识别模型提高泛化性能[4].

3)Total-Text:这是目前国际上规模最大的弯曲文本数据集之一,共包含1255张训练集图像和300张测试集图像,能够用于任意排列形状的文本的检测、识别与阅读任务的研究.

4)ICDAR MLT:该数据集由全场景图像所组成,其中,每幅图像包含来自阿拉伯语、孟加拉语(印度)、中文、英语、法语、德语、意大利语、日语和韩语9种不同语言中的一种或多种文本,代表6种不同的脚本.它包括7200幅训练样本图像、1800幅验证样本图像和9000幅自然场景测试图像,是国际上数据规模最大的场景文本检测数据集之一.

5)CTW-1500:这是华南理工大学所提供的一个专门数据集,主要面向曲线形状分布的自然场景文本检测任务.其中,每幅图像不仅至少包含1个曲线文本,也包含大量水平和多方向的文本[4].

6)CTW:该数据集是由清华大学与腾讯公司共同推出的一个反映自然街景的中文文本图像超大数据集,为训练高性能的深度学习模型奠定了坚实的数据基础.它包含25887幅训练图像和6398幅测试图像,共有1018402个字符实例和3850 种字符种类.

7)VinText:该数据集是含有越南语的自然场景文本检测的最大数据集之一,包含2000张完整注释的图像(1200 张训练图像、300张验证图像和500张测试图像)和56084个文本实例.其最大特点是包含多个类似字符,为从多个类似字符中辨别一个字符带来了新挑战.

8)LSVT[68]:该数据集是第一个带有部分标签的大规模自然街景文本数据集,由450000幅图像组成,包括20000个测试数据、30000个完整标注的训练数据和400000个弱标注的训练数据,其总体规模至少是现有RRC基准的14倍.

9)COCO-Text[69]:该数据集是基于MS COCO目标识别数据集建立起来的,由25887幅训练图像、10000幅测试图像和10000幅验证图像组成,共包含145859个字符实例,主要反映复杂背景的自然图像和生活场景图像,并且大部分图像中文本目标的尺度均较小,甚至会出现不清晰的文本内容[4],能够有效用于测试自然场景文本检测算法的健壮性和文本目标检测的精度.

10)MSRA-TD500[70]:该数据集是由300张训练图像和200张测试图像组成的数据集.它包含英文、中文2种语言的文本,且文本区域具有任意方向,并在句子级别进行了注释.

4.2 代表性文本检测方法的性能比较

考虑到大多数自然场景文本检测方法采用线形文本检测数据集ICDAR2013、ICDAR2015、COCO-Text和弯曲文本检测数据集CTW-1500、Total-Text、MSRA-TD500作为训练测试数据集,本节主要对目前具有代表性的自然场景文本检测方法在这两类数据集上的实验结果进行比较和讨论.

4.2.1 评价指标

文本检测常用的评价指标包括准确率(Precision)、召回率(Recall)、调和平均数(F-measure)以及帧率.为了更加客观地评价各种自然场景文本检测网络的性能,根据不同数据集的文本检测方法,其准确率和召回率也有不同的计算方式,主流的评价方法有ICDAR 2003(IC03),ICDAR 2013(IC13),ICDA 2015(IC15)3种形式,详见官方文档.其中,帧率用于评估文本检测的速度,其单位是FPS(frames per second),帧率越高,表明相应方法的文本检测速度越快;F-measure的计算方法如式(1)所示.

(1)

4.2.2 线形文本数据集上的比较

表3对18种代表性的自然场景文本检测方法在线形文本数据集ICDAR2013、ICDAR2015和COCO-Text上的性能表现进行了比较.从表3中不难看出:

1)由于VGG网络能够有效提取每个尺度下的图像纹理和边缘特征,因此基于VGG网络的典型文本检测方法在ICDAR2015数据集上的平均F-measure为0.7542.尽管该类方法达到了一定的检测精度,可是VGG网络结构不具备根据前景/背景及长宽比来自适应选取最佳尺度的能力.并且,为了保证网络的训练过程能够收敛,VGG的深度一般仅设置在19层以内,对应6个不同的尺度,否则深度过大将会导致梯度弥散或梯度爆炸.在这种情况下,VGG 无法提取更高层次、更多尺度的文本特征,其平均F-measure明显低于基于残差网络和FPN网络的检测方法.

2)考虑到残差网络能将浅层特征与主要边缘、整体轮廓等深层特征进行加性融合并实现更加准确的目标逼近,基于残差网络的典型文本检测方法在ICDAR2015数据集上的平均F-measure提高到了0.8364.总体上看,由于残差网络在非线性卷积层引进了跨层的直连边,其前馈机制提高了梯度信息的反向传播效率和网络训练的收敛效率,使得其在网络深度达到152层甚至更深层次时仍可顺利收敛[71],进而能够利用更多的卷积层提取更多尺度、更加丰富的图像特征.同时,多尺度融合特征的核心机制对于自然场景下的文本检测发挥了积极作用,使得基于残差网络的一类方法的预期效果优于基于VGG的一类检测方法.不过,由于融合过程中的下采样操作引起了频率混叠和细节信息丢失,基于残差网络的文本检测方法的性能仍然受到了一定影响.

3)基于FPN网络的文本检测方法既充分利用了多尺度融合特征,又通过自顶向下的融合机制避免了频率混叠和细节失真现象,得到了空间分辨率更高、通道数量更多、语义更强的多尺度融合特征图.而且,典型的FPN网络往往将残差网络作为其基础网络,从而继承了残差网络的优良的收敛效率.所以,该类方法在ICDAR2015数据集上的平均F-measure达到了0.8694,取得了最高的性能期望.

4)从总体的检测性能来看,基于VGG网络的典型文本检测方法在ICDAR2013上的平均F-measure为0.8651,在COCO-Text上的平均F-measure为0.4930,而在ICDAR2015上的平均F-measure则为0.7542,三者相差0.3721.然而,基于残差网络的典型文本检测方法在ICDAR2013、ICDAR2015和COCO-Text上的平均F-measure之差是0.369,基于FPN网络的典型文本检测方法在3个数据集上的平均F-measure之差却仅为0.294.可见,基于VGG网络的文本检测方法在泛化能力方面仍存在一定不足.相比之下,基于FPN网络的代表性文本检测方法表现出了最优的泛化性能.

5)从文本检测速度来看,基于VGG网络的典型文本检测方法的平均速度为6.71FPS,基于残差网络的典型文本检测方法的平均速度为10.57FPS,而基于FPN网络的典型文本检测方法的平均速度为3.00FPS.并且,以FPN+VGG为骨干网络的检测方法的速度也明显慢于以FPN+ResNet为骨干网络的检测方法.显然,采用残差网络为骨干网络的检测方法在检测速度方面具有明显优势.分析其原因在于,除最后一个池化层外,每当特征图的尺寸降低一倍,VGG网络模型就将相应卷积层的通道数量提高一倍,导致网络的卷积核数量和计算复杂度均较大,其每秒浮点运算次数高达196亿;在相同的特征图尺寸下,ResNet网络模型的通道数量至少比VGG降低一倍,其卷积核数量显著减少,并且即使是152层的残差网络,每秒需执行的浮点运算次数也只有113亿[8];FPN网络需要对多种尺度的特征图进行插值与融合,其每秒浮点运算次数达到了445亿[72].

6)对于具体的文本检测方法而言,CRAFT[40]、CRAFTS[51]、TextFuseNet[52]和Mask TextSpotter[50]在ICDAR2013和ICDAR2015数据集上均具有良好的检测效率.其中,CRAFT在两个数据集上的F-measure分别为0.953和0.916,表明它对图像的清晰度具有一定敏感性;TextFuseNet在ICDAR2013和ICDAR2015数据集上的F-measure则分别为0.943和0.921.同时,Mask TextSpotter在COCO-Text数据集上达到了更优良的性能.这些结果均说明多尺度融合特征能抑制图像清晰度的干扰,对于线形文本检测具有最佳的文本检测稳健性.

4.2.3 弯曲文本数据集上的比较

弯曲文本检测往往要面临比线形文本检测更多的挑战,不仅需检测水平或倾斜方向的文本区域,还要检测弯曲形状的文本区域.在这种情况下,曲线形的文本框能够更准确地拟合文本区域.

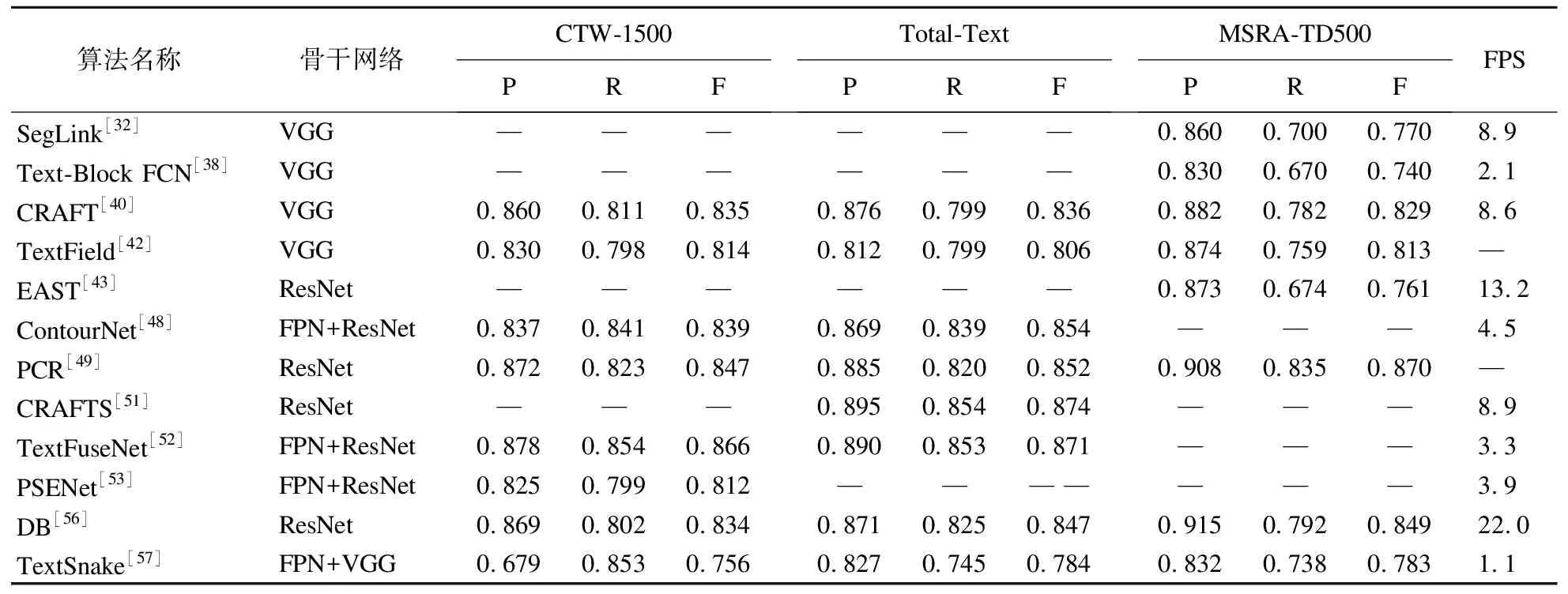

表4给出了典型的自然场景文本检测方法在弯曲文本数据集CTW-1500、Total-Text和MSRA-TD500上的性能比较结果.从表4中可以发现与表3一致的结论,即基于残差网络和FPN网络的文本检测方法的性能要优于VGG网络的文本检测方法;同时,基于FPN+ResNet混合网络结构的检测方法的客观评价结果也优于FPN+VGG混合网络结构的检测方法,其根本原因仍然在于不同网络结构对多尺度局部特征的处理机制的差异.可见,充分利用自然场景图像的多尺度特征,对于有效检测弯曲文本同样具有重要作用.

表4 文本检测方法在CTW-1500、Total-Text和MSRA-TD500上的实验结果对比Table 4 Comparison of experimental results of text detection methods on CTW-1500,Total-Text,and MSRA-TD500

从文本检测速度的角度来看,基于VGG网络的典型文本检测方法的平均速度为6.53FPS,基于残差网络的典型文本检测方法的平均速度为14.70FPS,而基于FPN网络的典型文本检测方法的平均速度为3.20FPS.因此,以残差网络为骨干网的文本检测方法依然占有检测速度的优势.

对于具体的文本检测方法而言,TextFuseNet[52]、CRAFT[40]、PCR[49]、ContourNet[48]在CTW-1500和Total-Text数据集上具有相对更佳的检测性能,而PCR和DB[56]则在MSRA-TD500数据集上具有相对更高的检测性能.TextFuseNet采用FPN+ResNet作为骨干网,并采用3个分支网络分别对字符、语义和全局3个层次的特征进行融合,在CTW-1500数据集上的表现最佳,其F-measure达到了0.866.考虑到CTW-1500数据集中的每幅图像既包含1个曲线文本,又含有水平和多方向的文本,TextFuseNet方法的客观评价结果表明它能够比其他的典型方法更加有效地处理自然场景下复合分布的文本检测问题.在Total-Text数据集上,CRAFTS方法取得了最高的文本检测精度,其F-measure为0.874,而TextFuseNet方法的性能评价结果仅与CRAFTS存在微小差距.由于PCR方法采用了与FPN网络相似的自上而下的检测策略,能够得到更加稳健的自然场景图像特征,它在MSRA-TD500数据集上获得了最佳的文本检测性能,其F-measure为0.870.

综合4.2.2节与4.2.3节的比较结果可知,首先,在3类自然场景文本检测方法中,基于FPN网络结构的检测方法往往具有较强的检测能力和稳健性,更加擅长线形文本和弯曲文本的自动检测;其次,就参与比较的18种代表性方法而言,TextFuseNet方法在检测精度、泛化能力以及处理复杂排列方向和文本行的稳健性等方面取得了最佳的总体性能.

5 总结与展望

本文从骨干网络的角度,回顾了基于深度卷积神经网络的自然场景文本检测方法的研究进展,讨论了基于VGG网络的文本检测方法、基于ResNet网络的文本检测方法和基于FPN网络的文本检测方法的主要思路,分析了不同方法的优势、不足和适用范围,进而对若干代表性的自然场景文本检测方法在标准数据集上的性能进行了客观比较.经过总结,发现基于FPN网络的自然场景文本检测方法预期具有优秀的检测能力、泛化能力和稳健性.

在此基础上,本节将总结基于深度卷积网络的自然场景文本检测领域的难点问题与发展趋势.

5.1 自然场景文本检测领域的难点

现有的基于深度学习的自然场景文本检测技术虽然已经日益完善,且取得了大量优秀的研究成果,但目前仍存在一些缺陷和不足未得到解决,技术框架也尚未完备.

首先,现有的基于深度卷积神经网络的文本检测技术大多来源于传统的目标检测模型,如Faster RCNN,YOLO[73],ResNet和Transformer等网络模型.并且,多数方法都以迁移学习的方式使用在大型图像数据集ImageNet上预先训练的模型.然而,这种解决方案忽略了文本内容与其他目标物体之间的特征差异性,可能达不到令人满意的文本检测性能.

其次,VGG网络、ResNet网络和FPN网络能够有效提取图像中的多尺度局部特征.然而,在自然场景图像中,背景区域与前景文本区域不仅具有明显的局部相关性,还存在视觉上下文信息的非局部特征的相关性.若忽略了非局部信息的跨邻域上下文建模能力,则会不可避免地影响文本检测方法对复杂背景、多样文本的检测精度和健壮性.

然后,东德出版的《语言学与语言交际手段指南》指出,目前世界上公认的独立语言有4200种,其中广泛使用的语言有19种.由于标注数据集需要耗费大量的人工成本,目前大多数的自然场景文本检测数据集只包含中文、英文、阿拉伯数字等单一语种.一方面,该领域尚非常缺乏多语种以及混合语种的大型文本图像数据集;另一方面,鲜见包含不同字体的文本或相似文本的大型文本图像数据集.

最后,模型的泛化能力始终是自然场景文本检测领域的难点问题.线形文本、弯曲文本和不规则形状文本的特征差异较大,目前尚未出现能够有效处理不同布局形状的通用的自然场景文本检测方法,这已成为提升网络模型的泛化能力的重要阻碍之一.而且,自然场景文本时常伴有复杂的背景遮挡、异常大小和不规则形状等现象,无疑进一步增大了自然场景文本检测的研究难度.

5.2 自然场景文本检测的研究展望

鉴于当前的研究现状,本文认为自然场景的文本检测技术将有望在以下4个方面取得进展.

1)建立符合自然场景文本图像特点的深度学习框架.虽然文本检测属于目标检测中的一个特例,但是现有的目标检测模型却能够为解决文本检测问题提供新的思路.不过,简单地把目标检测的深度学习框架直接应用于文本检测问题往往会忽略文字本身的特点.与其他场景目标不同,自然场景文本具有拓扑结构的特殊性和视觉上下文信息的相关性.因此,若能将文本上下文的局部特征和跨邻域非局部特征有效地融入深度学习框架,则有望提升自然场景文本检测模型的整体性能.

2)构建更完备的标准文本图像数据集.研究制定自然场景文本标注规范、评测标准和标准数据集的意义绝不亚于提出一种优秀文本检测方法的意义.同时,建设多语种、混合语种的大型文本数据集供广大学者开展自然场景下的泛语种文本检测研究,对于扩大自然场景文本检测的应用领域和应用场景具有重要价值.

3)引进更加有效的增强泛化能力的理论和方法.目前,多数方法在模型设计上主要采用了Dropout方法使模型节点随机失活,旨在减少神经元之间复杂的共适应关系,迫使网络去学习更加鲁棒的特征.若在模型设计过程中采取更宽的网络结构、更优的融合策略将多个维度、多个尺度的特征进行融合,则可得到关于纹理、边缘、轮廓、颜色、空间位置等特征的更加有效的表示,这是提高模型学习效果的改进思路之一.此外,在模型的损失函数中加入正则项可以防止参数过大和过度拟合,从而增强其泛化能力.

4)设计恰当的数据增广策略.通过较低的成本获得较大价值的标注数据,有助于进一步提高文本检测模型的学习精度.因此,采用数据增广的方式来扩充数据集,通过对同一张图片进行尺度放缩、比例改变、图像截取和旋转等操作去除图像尺寸变化这种无关因素对训练的影响,能够在一定程度上提高模型的泛化能力.