如何识别与判定人工智能教育应用伦理问题

[摘 要] 伦理问题的产生在人工智能教育应用中不可避免。如何识别与应对之,是当前研究的热点,对于人工智能与教育融合创新具有显著的伦理导向作用。已有研究多着力于对伦理风险的预警,在一定程度上忽视了对伦理问题的识别与判断,暴露出“泛伦理化”研究趋向,难以形成系统的伦理策略。实际上,只有辨别人工智能教育应用行为的伦理属性,通过伦理判断的分类指引,经由不同伦理分析框架的多样尝试,才能确定适切的伦理意图并形成可行的伦理方案。从人工智能教育应用行为的自知性、自愿性、社会性三个基本原则出发,提出“识别人工智能教育应用伦理问题”的一般方法,并基于目的论、义务论、美德论等规范伦理理论,确定“判断人工智能教育应用伦理问题是否合乎伦理规范”的方案依据,从而闡释人工智能教育应用伦理策略的形成过程,为积极回应“伦理问题识别意识薄弱”“伦理原则照搬难适应”等实践困境提供理论依据与实践路径。

[关键词] 人工智能教育应用; 伦理问题; 伦理识别; 伦理判断; 伦理策略

[中图分类号] G434 [文献标志码] A

[作者简介] 谢娟(1984—),女,山东枣庄人。副教授,博士,主要从事教育技术伦理研究。E-mail:xiejuansd@126.com。

一、引 言

随着我国《新一代人工智能伦理规范》的发布,教育领域人工智能伦理研究已成为热潮。什么是人工智能教育伦理问题、其判定依据是什么、规约这些问题的基本思想有哪些,是当前人工智能教育伦理研究的三个基础性问题[1]。本文从“人工智能教育应用”的角度切入,通过对应用行为的伦理分析,尝试探寻伦理策略的形成过程,以期为识别伦理问题提供方法指导、为作出伦理判断提供理论支撑、为确定伦理意图和开展伦理实践提供思路引领。

二、问题的提出

当前学界对“伦理问题”的警醒和对“伦理策略”的诉求等研究热情愈发高涨。一方面,学者们多维度辨识了人工智能教育应用引发的技术滥用、数据泄露等伦理困境[2],深刻意识到人被技术异化等伦理风险的隐蔽性和诱惑性[3],系统梳理了角色层面、技术层面和社会层面的伦理问题[4],并从主体规范缺失、伦理原则淡化、伦理形态嬗变等视角透视原因[5],使“人工智能教育应用伦理问题”成为讨论的焦点。另一方面,已有研究指出强人工智能与弱人工智能在伦理策略设计上的不同[6],主张通过实施人工智能伦理教育来应对伦理问题[7],倡导利用义务论和美德论等伦理方法来表达技术美德和提高道德决策的有效性[8],呼吁从家长监管、教育矫正等责任角度来提升伦理自觉[9],强调从个体和类群体两个层面制定应对措施[10],提出治理教育人工智能风险的责任伦理框架[11],从而突出了伦理策略研究的迫切性,也在一定程度上暴露出“伦理策略难以落地”的研究不足。不可否认,已有研究对伦理风险的多方位警觉,在凸显了人工智能教育应用伦理研究必要性的同时,也昭示了相应伦理策略缺失所引发的惶恐不安。

众所周知,并非所有与人工智能关涉的问题都是伦理问题。然而,学界明显的“泛伦理化”研究特点——习惯于把所有困境都归结为伦理问题、不对具体应用行为的伦理性加以识别与区分、忽视伦理辨识的重要性,在很大程度上模糊了伦理策略的针对性。甚至,有些研究对诸如人工智能操作失误、智能技术本身有待更新等非伦理性问题也进行伦理分析并试图提出伦理策略,迫使伦理研究陷于“无边界”境地。于是 “伦理原则照搬难适应”等研究困境不断出现。

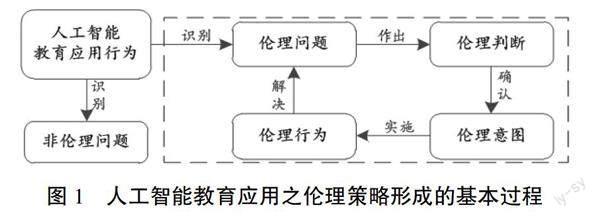

事实上,辨识伦理问题、明确伦理目标,是形成伦理策略的必要前提。所谓伦理策略,就是为解决伦理问题而制定的行动方案集合。它的前提是遭遇伦理问题并能够进行伦理分析,其目的在于明确伦理意图并做出伦理行动。著名的雷斯特道德行为模型理论(Rest's Model of Moral Behavior)认为伦理决策的四个阶段分别是伦理感知、伦理判断、伦理意图、伦理行为[12]。鉴于该模型的广泛影响力及其对伦理策略形成的重要指导作用,本文据此构建了人工智能教育应用伦理策略的形成过程,如图1所示。

可见,人工智能教育应用之伦理策略的形成要经历四个过程:一是识别伦理问题,即在教育情境中辨别出人工智能应用行为所引发的伦理问题和非伦理问题,其关键在于尽可能地明确界定人工智能教育应用行为的伦理性;二是作出伦理判断,即通过规范伦理学等理论维度对伦理问题进行分析,判断人工智能应用行为是否合乎伦理规范,其重点是借助多种伦理分析框架对应用行为进行道德判断;三是确认伦理意图,即根据教育的育人目的和人工智能的功能意愿决定是否做出某种伦理行为,指向针对所依据的伦理目的或伦理原则而作出的行为选择;四是实施伦理方案,即把前三步的分析结果,以合乎伦理规范的行为方式付诸实践,从而解决伦理问题。

总之,教育领域人工智能应用所引发的问题,只有具备伦理性,才能称之为伦理问题,进而才能对其进行伦理分析、寻求伦理策略。实际上,人工智能教育应用的伦理实践发轫于教育主体的伦理认知[13]。只有教育主体认识到人工智能应用中的伦理问题并进行伦理判断,才能开展伦理实践。因此,要想有效应对人工智能教育应用引发的伦理风险并形成系统的伦理策略,识别伦理问题是第一要务,作出伦理判断是关键环节。这两步直接决定了伦理意图与伦理行动方案的指向。

三、识别人工智能教育应用伦理问题的

基本原则

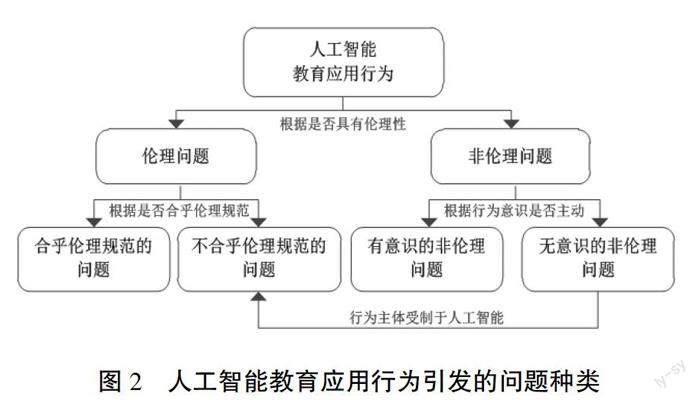

人工智能教育应用,归根结底是一种技术应用行为,即技术应用主体操作技术客体的行为。这种行为具有教育情境性,其后果与一般意义上的人工智能应用相异,强调对教育中“人”的影响。一般地,从伦理学的角度,人类行为可以划分为伦理行为和非伦理行为两种类型[14]。根据行为是否关涉伦理,人工智能教育应用行为引发的问题可以分成两大类:伦理问题和非伦理问题。根据“与伦理规范的合乎程度”,可以继续把伦理问题细化为“合乎伦理规范的问题”和“不合乎伦理规范的问题”。而非伦理问题被排除在伦理分析之外,无需对其进行伦理策略建构,但为了强调与伦理问题的区别,仍可根据行为主体是否具有应用的主动意识,将其划分为“有意识的非伦理问题”和“无意识的非伦理问题”。具体问题种类如图2所示。

需要说明的是,伦理是道德的上位概念,个体的道德性和群体的伦理性均称之为伦理性。伦理行为和非伦理行为的区别在于是否具有“伦理性”,即是否与伦理或道德关涉。所谓行为的“伦理性”是指行为受到一定的道德意识支配、主体自觉选择并涉及他人或社会利益,具有善或恶的意义,具体表现为自知性、自愿性、社会性的特点[15]。而与此相对立的行为,缺少了道德意识的支配、不涉及他人或社会利益、不具有善或恶的意义,就是非伦理的。只有具有伦理性的行为,其引发的问题才是伦理问题。识别教育情境中人工智能教育应用带来的问题是否具有伦理性,需要基于人工智能应用行为的自知性、自愿性、社会性三个基本原则进行判断。

第一,自知性原则是指行为主体对行为本身具有自觉的道德意识,能够意识到行为的本质、意义、价值和影响。也就是说,只有自觉意识到个体同他人、群体、社会之间的利益和义务关系,支配并付诸行动,才能构成伦理行为。例如,神志不清的教育者、无判别是非能力的学习者,在人工智能应用过程中即便在某些场合或某种程度上表现出有利或有害于他人、集体、社会的性质,但是此类行为不具有自知性的特点,故不属于伦理行为。

第二,自愿性原则是指行为主体依据自己的自由意志对道德行为进行自主选择。只有行为主体出于自愿,并依据必要的道德准则作出自主的行为选择,才负有道德责任,属于伦理行为。例如,在强制性要求或操作技能缺失的客观条件下,教师或学生只能被迫或有限应用人工智能部分功能进行教学,即使付出最大努力,也无法达到理想的教学效果。此类行为的发生并非出自行为主体的自主自愿,不符合自愿性原则,因而属于非伦理行为。

第三,社会性原则是指行为本身对他人、群体、社会产生影响并涉及利害或利益关系。事实上,一切无碍于利益的行为,都无所谓道德或不道德,即不具有伦理性,无法作出利害或善恶判断。例如,教师使用人工智能的行为,如果处于教学情境之外,并未涉及学生、他人及社会的利益,就不具有道德价值,不属于伦理行为;倘若超越了特定界限并进入教育情境,对教学活动产生影响,如促进或阻碍了学生的创造力发挥,增加或损害了师生利益,则变成了伦理行为。

通常,一种行为往往包含复杂的内容,带来伦理问题的同时,其他社会问题也会相伴产生。只要引发该问题的行为同时具备自知性、自愿性、社会性的特点,该问题就可以称之为伦理问题。实际上,自知性原则是前提,自愿性原则是保障,社会性原则是基础,不符合任何一个原则都难以准确厘定行为的伦理界限,也就不能认定其带来的问题是否为伦理问题。

诚然,人工智能教育应用无法与技术操作、教育管理等问题割裂开来,而把所有问题都等同于伦理问题无疑是不妥当的。其实,伦理与非伦理的界限虽然是确定的,但并非绝对。某些行为在特定意义上为非伦理行为,在广泛范围内往往又具有伦理意义[16]。正因如此,人工智能教育應用伦理问题才难以得到界定,导致学界出现“泛伦理化”的研究现象。所以,伦理辨识要审时度势,一方面不能把伦理问题与非伦理问题混为一谈,要坚决反对泛伦理主义;另一方面也要理性认识伦理问题与非伦理问题之间的联系,从发展和辩证的角度把握非伦理问题转化为伦理问题的必要条件。尤其是,如果行为主体处在“无意识”的被动使用人工智能的状态下,其行为容易被技术控制,极易导致由“非伦理问题”转化为“教育被人工智能异化”等不合乎伦理规范的问题。同时也要注意到,“有意识的非伦理问题”在一定条件下可以转化为“合乎伦理规范问题”的现实意义。

总之,理性认识伦理与非伦理、合乎伦理规范与不合乎伦理规范、无意识非伦理与不合乎规范伦理三组概念的相对性,有助于提升人们的伦理鉴别力,从而避免在“非此即彼”“非善即恶”的二元论道路上愈陷愈深。从这个意义上讲,人工智能引发的诸如师生关系异化、人文情感缺失、教学交往不足等具体教育问题,均可诉诸自知性、自愿性和社会性三个原则进行判断,确认其是否属于伦理问题以及能否进行伦理应对。唯有如此,伦理分析才有理可依、伦理方法才有据可循,伦理问题方能迎刃而解。另外,值得强调的是,在辨识过程中,还要注意非应用行为所引发的伦理问题,如人工智能对传统伦理观念的冲击、对教育伦理关系的改变等,这些问题也属于教育人工智能伦理研究的重要内容,同样值得深入探讨。

四、判断伦理问题是否合乎伦理规范的

主要方案

根据伦理策略形成过程,识别出人工智能教育应用中的伦理问题之后,就需要对其作出是否合乎伦理规范的判断。规范体现的是一种社会关系特性,是指人们共同遵守的社会约定或标准,主要有公共生活规则、职业或技术规范、法律规范、伦理规范等[17]。伦理规范是用来判断善与恶、正当与不正当、权利与义务等的道德准则。合乎伦理规范的行为就是正当的伦理行为,指向善;而不合乎伦理规范的行为就是不正当的伦理行为,指向恶。然而,这种善恶、应当与否的价值判断,因行为主体所处立场以及实际问题复杂程度的不同,涉及的理论依据也是综合的,需要从不同角度对行为的动机或目的,进行伦理原则、道德规范的综合比对与分析。这就需要规范伦理学为此提供理论阐释和方法指导。

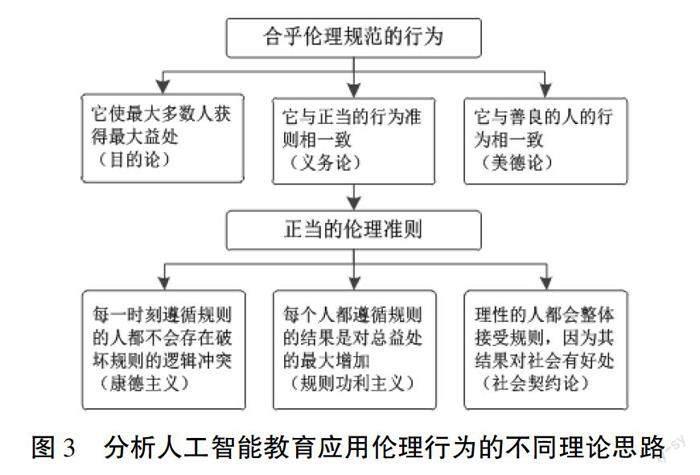

规范伦理学是研究行为准则、探讨道德规范的理论,旨在通过揭示善与恶、正当与不正当、应该与不应该之间的界限与标准,为社会成员指出通向道德完善的实践之路[18]。这种理论类型致力于说明行为本身应该遵从的道德标准及合理性原则,因而能够为人工智能教育应用的道德规范、伦理原则、责任体系、制度法规提供分析框架,有助于指导人们把人工智能的外在伦理规范和教育的内在价值标准结合起来,以他律和自律相结合的形式,解决“规范与价值和谐共生”的难题。一般而言,依据不同的道德规范和问题解决的方法,规范伦理学有目的论、义务论和美德论三大理论阵营[19]。本文梳理了典型的规范伦理理论及其联系(如图3所示),进而为判断人工智能教育应用伦理问题是否合乎伦理规范提供了三种方案。

第一种是目的论方案。目的论又称为效果论,是以行为所实现的目的和结果作为评判道德善恶的依据,具有感性主义的特点。目的论认为,如果行为的后果带来的好处超过坏处(使受影响对象获得最大益处),那么这种行为就是合乎伦理的行为。这种理论思路强调行为目的是为个体或群体带来幸福和避免不幸福。它通过考察每一种行为的可能后果,找出能够带来总益处最大净增加的方案,从而确认伦理意图并实施伦理行为。例如,当教育的需要与人工智能应用目的之间存在冲突时,需要目的论提供一种可操作的程序,用最大利益原则对行为进行轻重缓急的排序,形成利益优先级的方法,从而引导人们在教育活动或人工智能应用行为中作出选择,保障受影响对象获得最大益处。

第二种是义务论方案。义务论又称为准则论,强调评判道德善恶的依据在于动机,在于行为本身是否出于义务、应当和责任,是否遵从一定的道德原则和规范,具有理性主义的特点。康德主义、规则功利主义、社会契约论都是基于规则的伦理理论,其中,康德主义主张道德是一种普遍化的绝对命令,规则是人的意愿和行动理由,应当把人作为互相平等的道德主体来尊重,人是目的而非工具;规则功利主义强调“每个人都始终应当确立和遵循会给一切相关者带来最大好处的规则”[20];社会契约论认为“道德存在于规则之中,在大家都遵从这些规则的情况下,理性的人为了达到互惠互利的目的,也会接受这些规则”[21]。所以,该方案认为,只有遵循正当的道德规则的行为,才可以判定为合乎伦理的行为。

第三种是美德论方案。美德论又称为德性论,是以人应该具备怎样的品德以及如何完善道德修养等问题为中心,超越了行为的后果或动机,关注做人的标准,即“我应该成为什么样的人”。该理论主张道德行为的依据在于建立良好的品格并依据品格去行事,强调的是人自身所具有的良好德行[22]。它能够为个体提供道德的生活理念,培养个体的道德情感与道德人格,为道德教化提供理论指导[23]。可见,只要人工智能教育应用者具有良好的德性并在应用过程中体现出负责任、诚实、正直等美德,这种行为就是合乎伦理的行为。这种方案以良好品格为评判依据,强调教育主体的诚实、公正、守信、仁慈等美好品行,从而从自律的角度来应对现有法律无明确规定而传统道德又回答不了的问题。

事实上,规范伦理的目的论、义务论、美德论等理论都有其优缺点。目的论注重对行为后果的分析,强调“好的效果”,却可能忽略个体内在的道德品质;义务论把是否履行了某种义务作为善恶的主要评价依据,强调“做好事”,却忽视了道德价值的客观性;美德论注重德性或道德品质的形成,强调“做好人”,却难以实现对行为的具体明确的指导。它们各有所长,相互补充。目的论和义务论侧重于道德规范及原则的制定,属于他律策略;德性论则追求个体美德的形成,是自律的行为。因对同一种人工智能教育应用行为可以从不同的角度加以分析,所依據的理论框架也不同。所以,在进行伦理判断时,应尽可能避免一种理论的局限,根据不同的情况,将目的论、义务论、美德论三种理论综合起来,扬长避短,实现自律与他律的统一。比如,当强调人工智能应用行为的道德价值时,就需要目的论的辩护;当要维护人工智能与教育的和谐伦理秩序时,就需要义务论对行为进行明确具体的指导;当要塑造人工智能应用者的良好道德品质时,则离不开美德论的支持。只有将规范与美德统一起来,才能促进人工智能教育应用按照道德生活的内在必然性发展,实现技术与人文的统一,促进规范与价值的和谐共生。

五、人工智能教育应用伦理策略的形成

伦理问题经过识别和判定之后,就需要根据教育目的和人工智能应用意愿进行伦理意图的确认,为伦理行动的付诸实践作好铺垫。为详细阐述识别与判定人工智能教育应用伦理问题的过程与方法,本文以智能教学系统应用中的“算法滥用现象”为例,分析其伦理策略的形成。

首先,识别伦理问题。教师、学生在应用该智能系统时,都具备自知性、自愿性和社会性的特点,因而该教学智能体被应用所引发的问题属于伦理问题。由于此类应用行为存在“对所有学生行为的全面监控”等伦理失范现象,是典型的算法滥用,不符合我国《新一代人工智能伦理规范》中的提倡善意使用、避免误用滥用、禁止违规恶用、及时主动反馈、提高使用能力等伦理要求[24],是不合乎伦理规范的问题。

其次,选择伦理方案。为决定该行为的伦理意图,明确伦理目标,需要从多种伦理视角进行分析,尽可能达成共识并提出适当的行为方案,从他律和自律相结合的角度,把效果、准则与德性融合在一起,以促成伦理策略的最终形成。具体而言:(1)在明确人工智能教育应用伦理问题基础上,识别行为主体与利益相关者的关系,即该智能系统应用所涉及的学校管理者、教师、学生、家长等多方利益;(2)判断伦理问题的正当性:是否公平、有效、健康、规范地应用,即检验该智能系统应用在多大程度上与教育教学等相关伦理原则相一致,避免泛伦理化;(3)从目的论、义务论和美德论的角度分析伦理问题的效益性、规范性和品德性,最终确定以义务论方案为主,以目的论和美德论方案为辅,强调伦理策略对原则、规范的遵守和对责任、义务的担当;(4)将伦理解释与教育规范、人工智能规范进行比对,对伦理目标进行优先级排序,确定以保证师生教与学的自主权为基本伦理意图;(5)选定伦理方案,即从义务论的角度出发,严格遵循《新一代人工智能伦理规范》基本原则和使用规范,认真履行教育伦理规范,积极承担育人的责任,从而形成伦理策略并执行。

可见,在人工智能深度应用必然扩展教育伦理之约束边界的背景下,只有把教育伦理规范和人工智能伦理规范共同放置于伦理问题解决的实践中,才能确保人工智能教育应用在教育伦理规范和人工智能伦理规范的共同约束中发挥效力并承担育人职责。需要说明的是,本文无意区分多种伦理理论的异同,仅从伦理策略形成的一隅尝试对人工智能教育应用领域的一般伦理问题进行理论分析,以期引起更广泛讨论。

[参考文献]

[1] 張立国,刘晓琳,常家硕.人工智能教育伦理问题及其规约[J].电化教育研究,2021,42(8):5-11.

[2] 杜静,黄荣怀,李政璇,周伟,田阳.智能教育时代下人工智能伦理的内涵与建构原则[J].电化教育研究,2019,40(7):21-29.

[3] 王嘉毅,鲁子箫.规避伦理风险:智能时代教育回归原点的中国智慧[J].教育研究,2020,41(2):47-60.

[4] 邓国民,李梅.教育人工智能伦理问题与伦理原则探讨[J].电化教育研究,2020,41(6):39-45.

[5] 王东,张振.人工智能伦理风险的镜像、透视及其规避[J].伦理学研究,2021(1):109-115.

[6] 莫宏伟.强人工智能与弱人工智能的伦理问题思考[J].科学与社会,2018,8(1):14-24.

[7] 蔡连玉,韩倩倩.人工智能与教育的融合研究:一种纲领性探索[J].电化教育研究,2018,39(10):27-32.

[8] HAGENDORFF T. The ethics of AI ethics:an evaluation of guidelines[J]. Minds and machines,2020,30(1):99-120.

[9] 王前,曹昕怡.人工智能应用中的五种隐性伦理责任[J].自然辩证法研究,2021,37(7):39-45.

[10] 李梅敬.理论层次视域下人工智能发展风险的伦理应对[J].探索与争鸣,2021(8):167-176,180.

[11] 赵磊磊,吴小凡,赵可云.责任伦理:教育人工智能风险治理的时代诉求[J].电化教育研究,2022,43(6):32-38.

[12] 吴红梅,刘洪.西方伦理决策研究述评[J].外国经济与管理,2006(12):48-55.

[13] 李晓岩,张家年,王丹.人工智能教育应用伦理研究论纲[J].开放教育研究,2021,27(3):29-36.

[14] 徐少锦,温克勤.伦理百科辞典[M].北京:中国广播电视出版社,1999:441.

[15] 王敬华.新编伦理学简明教程[M].南京:东南大学出版社,2012:238-239.

[16] 郭广银.伦理学原理[M].南京:南京大学出版社,1995:310.

[17] 廖申白.伦理学概论[M].北京:北京师范大学出版社,2009:18.

[18] 余仕麟.伦理学要义[M].成都:巴蜀书社,2010:24.

[19] 高湘泽.一种可能作为比较纯正的规范伦理的原义“责任伦理”纲要[M].武汉:武汉大学出版社,2015:33.

[20] 雅克·蒂洛,基思·克拉斯曼. 伦理学与生活[M].程立显,刘建,译.成都:四川人民出版社,2020:44.

[21] 迈克尔J.奎因.互联网伦理:信息时代的道德重构[M].王益民,译.6版.北京:电子工业出版社,2016:51-62.

[22] 徐陶.当代哲学导论[M].长沙:湖南大学出版社,2014:57.

[23] 赵永刚.美德伦理学:作为一种道德类型的独立性[M].长沙:湖南师范大学出版社, 2011:216.

[24] 中华人民共和国科学技术部.《新一代人工智能伦理规范》发布[EB/OL]. [2021-10-12]. http://www.most.gov.cn/kjbgz/202109/t2021 0926_177063.html.

How to Identify and Determine Ethical Issues in Educational Application of Artificial Intelligence —Based on Formation of Ethical Strategies

XIE Juan

(School of Education and Psychology, University of Jinan, Ji'nan Shandong 250022)

[Abstract] Ethical issues are inevitable in educational application of artificial intelligence. How to identify and deal with them now is a hot topic, which plays a significant ethical guiding role in the integration and innovation of artificial intelligence and education. Most of existing researches focus on the early warning of ethical risks, and neglect the identification and judgment of ethical issues to a certain extent, thus exposing the trend of pan-ethicalization and making it difficult to form a systematic ethical strategy. In fact, only by distinguishing the ethical attributes of the application behavior, classifying guidance of ethical judgment, and by making various attempts in different ethical analysis frameworks, can appropriate ethical intentions be determined and feasible ethical schemes be formed. So this paper firstly puts forward a general method of identifying the ethical issues based on the three basic principles of self-knowledge, voluntariness and sociality, and then determines the basis of judging whether the ethical issues conform to ethical norms based on the normative ethical theories such as teleology, obligation theory and virtue. By explaining the formation process of the ethical strategies, it provides a theoretical basis and a practical path to actively respond to the practical dilemmas such as "weak awareness of identifying ethical issues" and "difficulty in copying ethical principles".

[Keywords] Educational Application of Artificial Intelligence; Ethical Issues; Ethical Identification; Ethical Judgment; Ethical Strategy