室内剔除行人特征点的视觉SLAM算法

龚云 徐昊天 吕鸣雨

摘 要:针对视觉SLAM系统在室内场景下易受行人干扰,导致定位精度和稳定性下降的问题,提出了一种室内剔除行人特征点的视觉SLAM算法,该算法在传统的ORB_SLAM2算法中集成了一个新的动态目标检测线程,此线程使用YOLOV5s目标检测算法识别并剔除行人动态信息。首先,系统对YOLOV5s引入坐标注意力机制,提取图像中与目标相关的特征;其次,将彩色图像同时输入到ORB_SLAM2算法和动态目标检测线程中,ORB_SLAM2算法实时估计相机位姿,动态目標检测线程识别和剔除行人动态目标,从而减少其对ORB_SLAM2算法的干扰;最后,将2个线程的输出融合至静态地图构建线程,生成无行人干扰的地图构建结果。针对文中算法,在不同数据集下开展试验验证。结果表明:相对于ORB_SLAM2算法,改进算法在TUM的高动态数据集中绝对轨迹精度提高了96.51%,相对轨迹精度提高了96.57%,相对轨迹误差的旋转精度提高了96.47%。室内剔除行人特征点的视觉SLAM算法充分过滤了行人特征点,提高了SLAM系统的精度,为室内导航、建图等领域提供了一种新的解决方案。

关键词:SLAM算法;动态场景;注意力机制;动态目标检测;目标剔除

中图分类号:TP 391.41;TP 242

文献标志码:

A

文章编号:1672-9315(2023)06-1195

-12

DOI:10.13800/j.cnki.xakjdxxb.2023.0618开放科学(资源服务)标识码(OSID):

Visual SLAM algorithm for pedestrian feature points exclusion indoors

GONG Yun,XU Haotian,LYU Mingyu

(College of Geomatics,Xian University of Science and Technology,Xian 710054,China)

Abstract:To address the issue of visual SLAM systems being susceptible to interference from pedestrians in indoor scenarios,resulting in decreased localization accuracy and stability,

this paper proposed a visual SLAM algorithm for removing pedestrian feature points indoors.This algorithm integrates a new dynamic object detection thread into the traditional ORB_SLAM2 algorithm,utilizing the YOLOv5s object detection algorithm to identify and remove dynamic objects such as pedestrians.Firstly,a coordinate attention mechanism was introduced to effectively extract image features relevant to the target.Secondly,both the color image and the dynamic object detection thread were simultaneously input into the ORB_SLAM2 algorithm.The ORB_SLAM2 algorithm is responsible for real-time camera pose estimation,while the dynamic object detection thread identifying and removing dynamic objects, thereby reducing its interference with the ORB_SLAM2 algorithm.

Finally,the outputs of these two threads were fused into a static map construction thread to generate a map construction result free from pedestrian interference.Experimental results on various datasets indicate that,compared with the original ORB_SLAM2 algorithm, the absolute trajectory accuracy of the improved algorithm in the high dynamic data set of TUM is increased by 96.51%,the relative trajectory accuracy is increased

by 96.57%,and the rotation accuracy of the relative trajectory error is increased by 96.47%.The visual SLAM algorithm

that eliminates pedestrian feature points indoors fully filters the pedestrian feature points,improves the accuracy of the SLAM system,and provides a new solution for indoor navigation,mapping and other fields.

Key words:SLAM algorithm;dynamic scenes;attention;dynamic object detection;object-removal

0 引 言近年来,随着智能化和自动化的不断推进,同时定位与建图(Simultaneous Localization and Mapping,SLAM)在室内导航、机器人控制等领域中得到了广泛的应用,解决了机器人在未知环境中“定位”与“建图”这2个关键问题[1]。根据机器人采集信息时使用的传感器不同,可将SLAM分为激光SLAM和视觉SLAM(Visual SLAM,VSLAM)。相对于激光SLAM,视觉SLAM使用了造价成本较低的相机并且其体型较小,容易与常规传感器互相搭配获取丰富的图像信息。视觉SLAM在大多数静态环境假设下,都有着不错的表现,然而在室内环境中,行人此类动态信息经常出现在机器人视野范围内,会对SLAM系统的特征点匹配和追踪造成干扰,并且会导致后期建图出现“重影”等问题,影响系统的精度和稳定性[2]。因此,为了让移动机器人在室内场景下更好地构建环境地图,如何在系统前端有效剔除行人此类动态特征点,成为了SLAM研究的热点议题[3]。目前,针对室内剔除行人特征点的视觉SLAM算法已经有一些研究,如通过几何约束检测物体的运动状态,利用极线约束估算出图像像素,沿着极线的界限以此来检测环境中运动的物体[4]。基于TSDF (Truncated Signed Distance Function)映射方法,通过在TSDF中的颜色信息估计传感器位姿,再利用体素哈希表示方法結合配准残差,空闲空间表示的算法过滤行人的特征点信息[5]。HE提出基于轮廓的行人分割算法,尝试通过提取行人的边界轮廓来剔除行人特征点[6]。在复杂的室内环境中,由于光照变化和背景干扰等因素,轮廓提取的效果可能并不理想,导致行人特征点的准确剔除存在困难;BEWLEY等提出的基于运动估计的行人追踪算法通过跟踪行人在连续帧中的运动来剔除其特征点[7]。由于室内环境中人流量大且行人运动频繁,传统的行人追踪算法往往容易在复杂场景中丢失目标。近年来SLAM在结合深度学习方面已经取得了显著的研究进展,BESCOS等提出的Dyna-SLAM,主要通过语义分割和MASK-RCNN进行动态信息分割,实现了对动态特征点的精准过滤[8];高兴波等提到,DS-SLAM,Dyna-SLAM是近年来针对剔除行人特征点的有效方法[9],其中DS-SLAM将SegNet通过语义分割网络与动态检测方法结合,减少了动态目标对系统的影响,2种方法耗时较为严重[10];KEHL等提出了Detect-SLAM系统,利用SSD目标检测网络通过训练好模型对动态目标进行检测,在视觉里程计中实现了对动态特征点的剔除[11];ZHANG等通过研究RGB-SLAM,也利用深度学习对动态物体进行精准分割,其分割精度较高,与DS-SLAM,Dyna-SLAM类似,同样存在实时性差等问题[12];WANG等提出了动态场景下的语义SLAM系统利用YOLOV3目标检测算法完成了系统对动态信息的识别与过滤[13]。为了剔除行人对SLAM系统的干扰,探讨了一种基于室内剔除行人特征点的视觉SLAM算法。该算法结合了目标检测、特征点匹配和追踪等技术,能够准确有效地剔除行人特征点,提高SLAM系统的精度和稳定性。具体研究内容包括:

1) YOLOV5s目标检测算法的改进,引入坐标注意力机制(Coordinate-Attention,CA)来提高算法检测行人的精度;

2) 利用改进后的目标检测算法对行人的运动轨迹进行追踪与识别;

3) 对SLAM系统中的特征点进行筛选,保留与定位相关的特征点,排除受行人运动干扰的特征点。利用过滤动态信息后得到的关键帧构建静态场景下的稠密点云地图。

1 SLAM算法特征点提取与匹配

1.1 ORB特征点算法当视觉感应器把获取图像传递到视觉里程计系统时,要通过传入图像判断相机动作,但因为图像本身是由亮度和颜色构成的矩阵,直接由矩阵角度来进行动作评估可能会存在问题。常见的办法是从图像中选取几个有代表性的特征点,并通过这些点来预测所需要的位姿信号。特征点获取与匹配则是视觉SLAM系统中十分关键的环节。ORB(Oriented FAST and Rotated BRIEF)算法是一种较为轻量级的特征点提取算法,适用于实时性要求较高的SLAM系统[14]。对于ORB特征点算法主要分为3个步骤:FAST特征点检测、BRIEF特征描述子生成和方向分配。其主要是对FAST方法的提升与改进,由于传统的FAST角点检测算法在方向性方面存在一些不可控性,所以ORB算法添加了尺度与旋转描述,以此来增加特征点的旋转不变性。

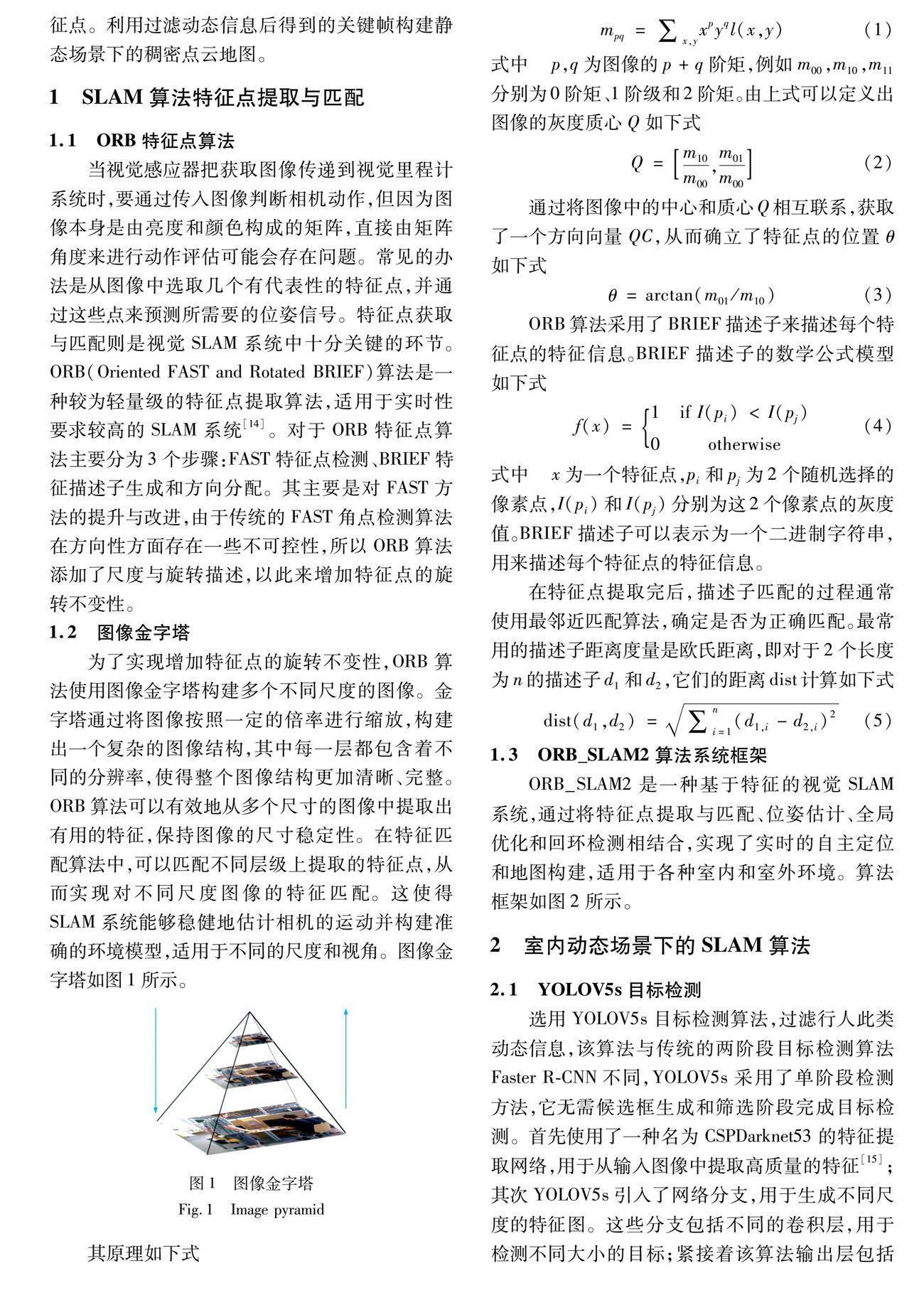

1.2 图像金字塔为了实现增加特征点的旋转不变性,ORB算法使用图像金字塔构建多个不同尺度的图像。金字塔通过将图像按照一定的倍率进行缩放,构建出一个复杂的图像结构,其中每一层都包含着不同的分辨率,使得整个图像结构更加清晰、完整。ORB算法可以有效地从多个尺寸的图像中提取出有用的特征,保持图像的尺寸稳定性。在特征匹配算法中,可以匹配不同层级上提取的特征点,从而实现对不同尺度图像的特征匹配。这使得SLAM系统能够稳健地估计相机的运动并构建准确的环境模型,

适用于不同的尺度和视角。图像金字塔如图1所示。

2 室内动态场景下的SLAM算法

2.1 YOLOV5s目标检测选用YOLOV5s目标检测算法,过滤行人此类动态信息,该算法与传统的两阶段目标检测算法Faster R-CNN不同,YOLOV5s采用了单阶段检测方法,它无需候选框生成和筛选阶段完成目标检测。首先使用了一种名为CSPDarknet53的特征提取网络,用于从输入图像中提取高质量的特征[15];其次YOLOV5s引入了网络分支,用于生成不同尺度的特征图。这些分支包括不同的卷积层,用于检测不同大小的目标;紧接着该算法输出层包括多个不同尺度的预测头部,每个头部负责不同尺度的目标检测,每个预测头部包括类别预测、边界框预测和置信度预测。类别预测使用Softmax函数[16]输出目标的类别概率,边界框预测用于确定目标的位置,而置信度预测用于筛选检测结果;最后为了减少重叠的边界框,YOLOV5s使用非极大值抑制(Non-Maximum Suppression,NMS)算法来筛选最终的检测结果[17]。其网络结构如图3所示。

2.2 改进后的YOLOV5s目标检测算法YOLOV5s算法无论是在速度、精度还是扩展性上都在实际项目中有着不错的表现,但在有些复 杂场景移动网络中还需对其网络结构、模块添加等方面加以改进,从而可以提升其性能。

对此将对算法添加一种新的注意力机制“坐标注意力机制”[18],也被称为CA,是一种轻量级的注意力机制,它主要关注通道之间的关系,包括一些简单的线性变换和非线性激活函数,而不是像“空间注意力机制”[19](Spatial Attention,SA)一样在空间维度上进行全局操作,大大降低了计算成本,相对于其他更复杂的注意力机制其可以有效地捕捉通道之间的相关性,有助于在卷积层之间更好地整合特征信息,使得YOLOV5s算法在资源受限的情况下仍能取得良好的性能。CA注意力机制将复杂的信息结构分解成2个独立的一维特征,从而实现在不同空间方向上的聚类和聚集。该机制旨在从一个角度捕捉远程相互依存的关系,同时又能够准确地记录双方的位置信息。通过将多个通道的注意力信息进行分析,可以构建一个一维的注意力图,该图可以捕捉到多个方向的信息,包括空间坐标信息,并且可以实现对位置的敏感性,这样可以大大提升模型在定位和识别任务中的准确性[20]。CA模块结构如图4所示,涉及以下2个步骤:Coordinate信息嵌入和Coordinate注意力机制输出。

首先,通过一维平均池化,将2个独立的方向感知特征图分别压缩,以便从中提取出特定方向的信息;

接着,将这些特征图编码成注意力图,并将相应的位置信息输入[21]。为了进一步提高位置信息的精确性,对全局池化进行分解操作,此步骤可以确保在编码过程中保留更多的位置信息,如下式

由表1可知改进后的目标检测算法在检测精度上有一定的提升,mAP增加了11.3%,验证了改进后算法的可行性。

2.3 动态SLAM系统算法框架算法框架的各线程主要工作内容如下:

1)跟踪线程:改进后彩色图像会被系统分别传入ORB_SLAM2算法与改进后的目标检测算法YOLOV5s中,经过YOLOV5s对动态特征点检测并剔除后的数据传回至ORB_SLAM2中,对目标区域进行后续的位姿估计与优化;

2)目标检测线程:为了识别与剔除动态信息而在跟踪线程中新添加的线程,通过改进后的目标检测算法,为后续跟踪线程与地图的构建过滤其中的动态信息[23];3)静态地图构建线程:通过利用动态信息过滤后的地图关键帧,生成静态点云地图或静态八叉树地图。算法的系统框架图5所示。

3 试验及其结果分析

3.1 所用数据集介绍选用TUM数据集来做对比试验[24]。每个原始数据中的rgb文件包含三通道格式为png的彩色图像,且depth文件下包含16位单通道png图像,groundturth.txt是获取到的真实轨迹数据;rgb.txt为彩图的时间戳以及其名称;depth.txt则是深度图的时间戳以及名称。文中对试验类别进行分类一种是前缀为“walking”开头的序列,代表了高动态数据集,在该数据集中人物运动幅度较大且丰富;一种是前缀为“sitting”的低动态数据集序列,其中人物运动幅度较小,大部分以坐姿为主,只有小范围活动。为了研究该算法的实用性,将在研究数据集的基础上针对实际环境,对其进行行人特征点过滤处理试验,试验场所设置在西安科技大学临潼校区的测绘楼,该场所相对宽敞,场景纹理较弱,特征物比较明显,

并且存在处于运动状态下的行人,为后续试验提供了较为真实的试验环境,真实环境如图6所示。

3.2 试验结果及分析

3.2.1 基于TUM数据集下的效果对比试验利用改进后的目标检测算法YOLOV5s对动态信息进行过滤处理,由于该算法会对所有目标进行识别标识,故必须让此算法通过对所需识别的数据进行数据集训练,在训练过程中改进加入CA注意力机制,如图7所示,从而达到对TUM数据集场景中动态信息的精准过滤,为SLAM前端提供语义信息。

当不进行动态信息过滤,经过相机采集特征提取得到结果后没有对行人特征点进行区分,使得特征点主要集中在人身上,如图8(a)所示,而且人一直有可能处于运动的状态,如果使用这类特征点进行后续位姿估计,将会直接导致结果精度大大降低,影响整个系统的可用性。所以根据目标检测算法识别完成后的结果,对其在ORB_SLAM2[25]系统中进行特征点提取,与传统算法不同的是,文中算法结果将剔除行人身上的特征点如图8(b)所示,降低其对整个SLAM系统的影响。

3.2.2 基于录制数据下的效果对比试验对于实际环境,在ORB-SLAM2系统前端中同样增加了目标检测模块,对来往行人进行识别,在深度相机获取到上述数据后,进行2个不同的步骤,一个分支对获取的RGB图像进行特征提取,另一个分支通过预先训练好的室内行人目标检测模型对每个特征点所在位置的局部图像进行检测,从而得到对应特征点所属的物体类别及其置信度。在获取了特征点的类别信息和置信度之后,将进一步对提取出来的特征点进行分类,将行人此类动态信息的特征点从静态物体部分的特征点中剔除,最终生成无行人干扰的稠密点云地图。系统框架如图9所示。

图10为真实室内环境下对行人进行目标检测试验,图10(a)为添加CA通道注意力机制前,模拟多人情况下,人物进行往返直线运动,运动过程尽量平稳。识别结果包含了除行人以外的物体。图10(b)则是经过改进后的YOLOV5s算法经过训练后对行人进行目标检测后的结果,结果既可以验证改进后目标检测算法的准确性,也可以为下文动态信息更準确的剔除提供有利条件。

经过上述目标检测后将对室内录制视频中的动态信息行人特征点进行剔除ORB_SLAM2原系统无法识别动态区域,可以发现在行人身上提取了大量的特征点,这种情况将会影响SLAM的定位精度;相对于图11(a)和图11(b)利用上文提到的改进后的YOLOV5s目标检测算法识别动态信息区域,并在SLAM系统中标记动态区域,剔除了行人此类动态信息的特征点。而图11(c)和图11(d)则为原始ORB_SLAM2系统算法与所提算法系统运行时的关键帧,可以发现左侧原ORB_SLAM2系统关键帧在同一条件下关键帧变化较为明显,而文中算法系统下则趋于直线运动。

3.2.3 基于TUM数据集下的精度对比为了验证改进算法后的可行性,以及直观看出改进后所提升的性能,将针对TUM数据集,对改进前后算法精度指标进行对比,计算在不同动态数

据集下的绝对轨迹误差(ATE)与相对轨迹误差

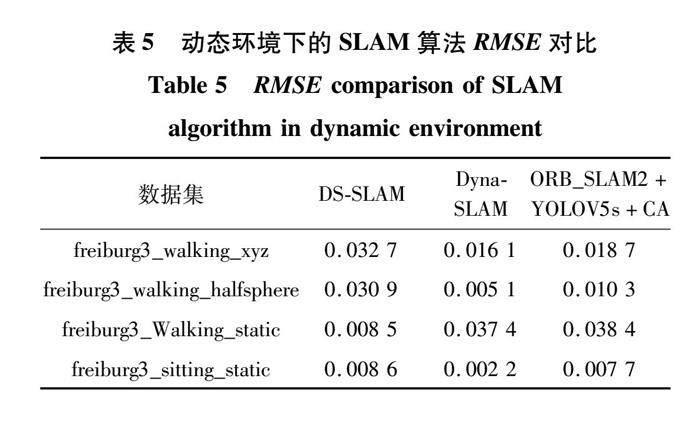

(15)表2~5分别为绝对轨迹误差、相对轨迹误差和相对轨迹误差的旋转误差对比结果,并且对比了DS-SLAM、Dyna-SLAM和文中算法在动态环境下SLAM的均方根误差。

由表2~4可知,ORB_SLAM2系统在行人处于频繁运动状态数据集freiburg3_walking组中,绝对轨迹误差与相对轨迹误差数值都偏高,且精度较低,而在运动频率较低的数据集freiburg3_sitting系列下,两个误差数值相差并不大,因为其自身能过滤少许动态特征点。由此表明原始ORB_SLAM2系统并不适用于高动态频率的场景,故需要结合改进后YOLOV5s目标检测技术对其中的高动态特征点进行识别并提出,结合表2~5可知,文中算法ATE精度提高了96.51%;RPE精度提升了96.57%;相对旋转误差精度提升96.47%,有效降低了动态信息对系统的影响。动态环境下的SLAM算法RMSE对比中,文中算法的RMSE值小于DS-SLAM,但稍大于Dyna-SLAM,这是由于Dyna-SLAM系统降低了实时性而提高了精度[30]。在探讨SLAM系统时研究速度也是重要的对比指标,表6对比了ORB_SLAM2算法与文中算法,Dyna-SLAM算法以及DS-SLAM算法的运行速度,由于文中算法添加了目标检测线程,所以运行时间略大于ORB_SLAM,但与DS-SLAM算法、Dyna-SLAM算法相比,具有明显优势。

图12(a)~(d)直观地表现出了原始ORB_SLAM2系统与文中算法在各类数据集下的ATE(上)以及RPE(下)可视化结果。

图12(a)~(d)分别为原始ORB_SLAM2(左)系统与文中算法(右)的运动轨迹与轨迹误差结果。在ATE中蓝色虚线为2种算法针对自身所估算出的相机位姿轨迹,而灰色实线是将真实轨迹与估算的轨迹对应连接,实线越短,则表示所对应2种误差值误差越小。而RPE图中表示2种算法的误差波动范围,波动越密集表明误差范围越小。

从图12可以看到,在ORB_SLAM2系统处于高动态数据集时,系统有着比较大的误差,是因为环境中人物大幅度的运动导致了该系统识别了动态信息的特征点,并且无法处理此类特征点,使得大量精度产生了偏差,这表明原始ORB_SLAM2系统并不适合此种场景。而将该系统与改进后的目标检测算法相结合后,无论是在运动轨迹还是在轨迹误差上都有一个比较良好的结果。在目标检测算法的支持下,系统精准地剔除了环境中

动态信息特征点,并消除了运动物体对相机定位的影响。

3.2.4 建图结果对文中算法与ORB_SLAM算法针对TUM数据集以及录制数据进行稠密点云建图试验。在ORB_SLAM算法中由于行人的干扰导致了建图过程出现“重影”,相机位姿估计出现误差,从而导致后期地图无法应用。结果如图13所示。

相比于ORB_SLAM2,文中算法利用目標检测线程,过滤了行人此类动态信息,在视觉里程计中剔除了其特征点,消除了行人对位姿估计的影响,利用静态地图构建线程,通过关键帧构建静态稠密点云地图,如图14所示。

4 结 论

1)通过对消融试验的比较,添加CA注意力机制的目标检测算法,在精度上提升了11.3%,也提高了对行人识别的准确率。

2)通过添加改进后YOLOV5s的动态目标检测线程,识别行人动态因素,并在跟踪线程的视觉里程计中将其特征点过滤。之后得到关键帧,并在静态地图构建线程中完成无“重影”的静态稠密点云地图。

3)通过对TUM数据集中的算法精度进行比较测试,所提算法的绝对轨迹精度提高了96.51%,相对轨迹精度提高了96.57%,相对轨迹误差的旋转精度提高了96.47%。

4)通过比较不同算法的处理速度,所提算法与Dyna-SLAM算法、DS-SLAM算法相比,具有一定优势。但由于添加线程原因,相较于ORB_SLAM算法略有不足。

参考文献(References):

[1] 吴皓,迟金鑫,田国会.基于视觉SLAM的物体实例识别与语义地图构建[J].华中科技大学学报(自然科学版),2019,47(9):48-54.

WU Hao,CHI Jinxin,TIAN Guohui.Object instance recognition and semantic map construction based on visual SLAM[J].Huazhong University of Science and Technology Journal(Natural Science Edition),2019,47(9):48-54.

[2] MUR-ARTAL R,TARDOS J D.Orb-slam2:an opensou-rce slam system for monocular,stereo,and rgbd c-ameras[J].IEEE Transactions on Robotics,2017,33(5):1255-1262.

[3]

张峻宁,苏群星,刘鹏远,等.一种自适应特征地图匹配的改进VSLAM算法[J].自动化学报,2019,45(3):553-565.

ZHANG Junning,SU Qunxing,LIU Pengyuan,et al.An

improved VSLAM algorithm based on adaptive feature map[J].Acta Automatica Sinica,2019,45(3):553-565.

[4] LABB M,MICHAUD F.RTAB-Map as an open-source lidar and visual simultaneous localization and mapping library for large-scale and long-term online operation[J].Journal of Field Robotics,2019,36(2):416-446.

[5]

PALAZZOLO E,BEHLEY J,LOTTES P,et al.ReFusion:3D reconstruction in dynamic environments for RGB-D cameras exploiting residuals[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems.Piscataway,USA:IEEE,2019:7855-7862.

[6] HE K,ZHANG X,REN S,et al.Spatial pyramid pooling in deep convolutional networks for visual re-cognition[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2015,37(9):1904-1916.

[7]

BEWLEY,ALEX,et al.Simple online and realtime trac-king with a deep association metric[J].Proceedings of the IEEE International Conference on Image Processing(ICIP),2016,40(8):433-456.[8]BESCOS B,FACIL J M,CIVERA J,et al.DynaSLAM:Tracking,mapping,and inpainting in dynamic scenes[J].IEEE Robotics and Automation Letters,2018,3(4):4076-4083.[9]

高興波,史旭华,葛群峰,等.面向动态物体场景的视觉SLAM综述[J].机器人,2021,43(6):733-750.

GAO Xingbo,SHI Xuhua,GE Qunfeng,et al.Overview of visual SLAM for dynamic object scene[J].Robot,2021,43(6):733-750.[10]

BADRINARAYANAN V,KENDALL A,CIPOLLA R.SegNet:A deep convolutional encoder-decoder architecture for image segmentation[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(12):2481-2495.[11]

KEHL W,MILLETARI F,TOMBARI F,et al.Deep learning of local RGB-

D patchesfor 3D object detection and 6D pose estimation[J].In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2017,39(12):2481-2495.

[12]ZHANG T W,ZHANG H Y,LI Y,et al.FlowFusion:Dynamic dense RGBD SLAM based on optical flow[C]//IEEE International Conference on Robotics and Automation.Piscataway,USA:IEEE,2020,10(9):7322-7328.[13]

WANG Z M,ZHANG Q,LI J S,et al.A computationally efficient semantic SLAM solution for dynamic scenes[J].Remote Sensing,2019,11(11):1363.[14]

RAN T,YUAN L,ZHANG J B,et al.RS-SL-AM:arobust semantic SLAM in dynamic environments based on RGBD sensor[J].IEEE Sensors Journal,2021,21(18):20657-20664.

[15]JADERBERG M,SIMONYAN K,ZISSERMAN A.Spatial transformer networks[J].Advances in Neural Information Processing Systems,2015,9(2):2017-2025.

[16]LI W,LIU K,ZHANG L,et al.Object detection based on an adaptive attention mechanism[J].Scientific Reports,2020,10(1):1-13.

[17]

JIA W,XU S Q,LIANG Z,et al.Real-timeautomatichelmet detection of motorcyclists in urban traffic usingimproved YOLOv5 detector[J].IET Image Processing,2021,15(14):3623-3637.[18]

GUO C,FAN B,ZHANG Q,et al.AugFPN:Improving multi-scale feature learning for object detection[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition,2020:12595-12604.[19]

LIU S,HUANG D,WANG Y.Adaptive NMS:Refining pedestrian detection in a crowd[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition,2019:6459-6468.[20]

REDMON J,FARHADI A.YOLO9000:better,faster,stronger[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2017:7263-7271.[21]

ZHU X,LYU S,WANG X,et al.TPH-YOLOv5:Improved YOLOv5 based on transformer prediction head for object detection on drone-captured scenarios[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision,2021:2778-2788.[22]

WANG X,GIRSHICK R,GUPTA A,et al.Nonlocal neural networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2018:7794-7803.[23]

薛旭升,張旭辉,毛清华,等.基于双目视觉的掘进机器人定位定向方法研究[J].西安科技大学学报,2020,40(5):781-789.

XUE Xusheng,ZHANG Xuhui,MAO Qinghua,et al.Localization and orientation method of roadheader robot basedon binocular vision[J].Journal of Xian University of Science and Technology,2020,40(5):781-789.

[24]STURM J,ENGELHARD N,ENDRES F,et al.A benchmark for the evaluation of RGB-D SLAM systems[J].2012 IEEE/RSJ International Conference on Intelligent Robots and Systems,Vilamoura,2012:573-580.

[25]

AI Y B,RUI T,YANG X Q,et al.Visual SLAM in dynamic environments based on object detection[J].Defence Technology,2021,17(5):1712-1721.[26]

房立金,刘博,万应才.基于深度学习的动态场景语义 SLAM[J].华中科技大学学报(自然科学版),2020,48(1):121-126.

FANG Lijin,LIU Bo,WAN Yingcai.Dynamic scene semantic SLAM based on deep learning[J].Journal of Huazhong University of Science and Technology(Natural Science Edition),2020,48(1):121-126.[27]

ZHONG F W,WANG S,HANG Z Q,et al.DetectS-LAM:Making object detection and SLAM mutually beneficial[C]//IEEE Winter Conference on Applications of Computer Vision.Piscataway,USA:IEEE,2018:1001-1010.[28]

WANG Z M,ZHANG Q,LI J S,et al.A computationally efficient semantic SLAM solution for dynamic scenes[J].Remote Sensing,2019,11(11):1363.

[29]VON GIOI R G,JAKUBOWICZ J,MOREL J M,et al.LSD:a fast line segment detector with a false detection control[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2008,32(4):722-732.

(责任编辑:高佳)