基于注意力机制的细粒度图像分类

朱丽 王新鹏 付海涛 冯宇轩 张竞吉

摘要: 针对细粒度图像分类中数据分布具有小型、 非均匀和不易察觉类间差异的特征,提出一种基于注意力机制的细粒度图像分类模型. 首先通过引入双路通道注意力与残差网络融合对图像进行初步特征提取,然后应用多头自注意力机制,达到提取深度特征数据之间细粒度关系的目的,再结合交叉熵损失和中心损失设计损失函数度量模型的训练. 实验结果表明,该模型在两个标准数据集102 Category Flower和CUB200-2011上的测试准确率分别达94.42%和89.43%,与其他主流分类模型相比分类效果更好.

关键词: 细粒度图像分类; 注意力机制; 残差网络

中图分类号: TP391.41 文献标志码: A 文章编号: 1671-5489(2023)02-0371-06

Fine-Grained Image Classification Based on Attention Mechanism

ZHU Li,WANG Xinpeng,FU Haitao,FENG Yuxuan,ZHANG Jingji

(College of Information Technology,Jilin Agricultural University,Changchun 130118,China)

Abstract: Aiming at the characteristics of subtle,uneven,imperceptible inter-class differences between classes and real-world data distribution

in fine-grained image classification,we proposed a fine-grained image classification model based on attention mechanism. Firstly,the preliminary feature extraction of

the image was carried out by introducing the fusion of a two-way channel attention and residual network. Secondly, the multi-head self-attention mechanism was applied to extract

fine-grained relationships between deep feature data. Thirdly,the training of loss function measurement system was designed by combining cross entropy loss and center loss.

The experimental results show that the test accuracy of the model on two standard datasets 102 Category Flower and CUB200-2011 is 94.42% and 89.43%,respectively.

Compared with other mainstream classification models,the classification effect is better.

Keywords: fine-grained image classification; attention mechanism; residual network

收稿日期: 2022-07-24.

第一作者簡介: 朱 丽(1973—),女,汉族,硕士,副教授,从事机器学习和智能农业的研究,E-mail: jolielang@163.com.

通信作者简介: 冯宇轩(1980—),男,汉族,博士,讲师,从事机器学习和智能规划的研究,E-mail: fengyuxuan.cn@163.com.

基金项目: 吉林省教育厅科学技术研究项目(批准号: JJKH20220331KJ; JJKH20220332KJ; JJKH20220

333KJ)和吉林省发展和改革委员会省预算内基本建设基金(批准号: 2020C037-7).

图像分类任务是根据图像中的特征对图像进行类别划分,而细粒度图像分类是在传统图像分类任务的基础上更进一步的工作,涉及更高层语义特征的学习和比较. 某些细粒度样本集合中存在类别间差异细微但类别内差异显著的特点,使细粒度分类问题变得更难. 如同属于同一个子类的鸟类图像可能有差异较大的背景或姿态,但两个子类别之间的鸟类图像如果在同一背景、 同一姿态下几乎无差异. 目前,部分前沿水平的细粒度分类方法主要根据手工标注图像的特征区域,再通过可学习的特征描述子表示图像的特征[1]. 这种通过精细标注做端到端的特征学习,可在目标域上显著提高分类效果,但成本较高.

细粒度图像分类的研究多基于经典分类方法,在使用更深的主干网络提取特征的同时存在更大的过拟合风险. 这类研究目前已有许多成果,例如: 结合了注意力机制抽取特征间关系的方法[2],该方法为降低计算复杂度,使用固定尺寸的注意力区域方法学习定位物体的多个局部区域,提取局部区域的细粒度特征用于分类,但该方法无法有效避免背景干扰,泛化性较差; 在卷积神经网上递归进行注意力学习的方法[3],该方法以循环的方式从粗到细迭代地生成区域注意力,可得到更好的结果,但如果前一阶段不能很好地检测,则进入的噪声将在后续阶段不断被放大; 在卷积神经网上执行通道注意力机制求解小样本分类问题的方法[4],利用特征图不同通道关注不同的视觉部位,但分类网络只能把目标的每个部位单独处理而忽略了局部特征与细粒度特征之间的相互关联.

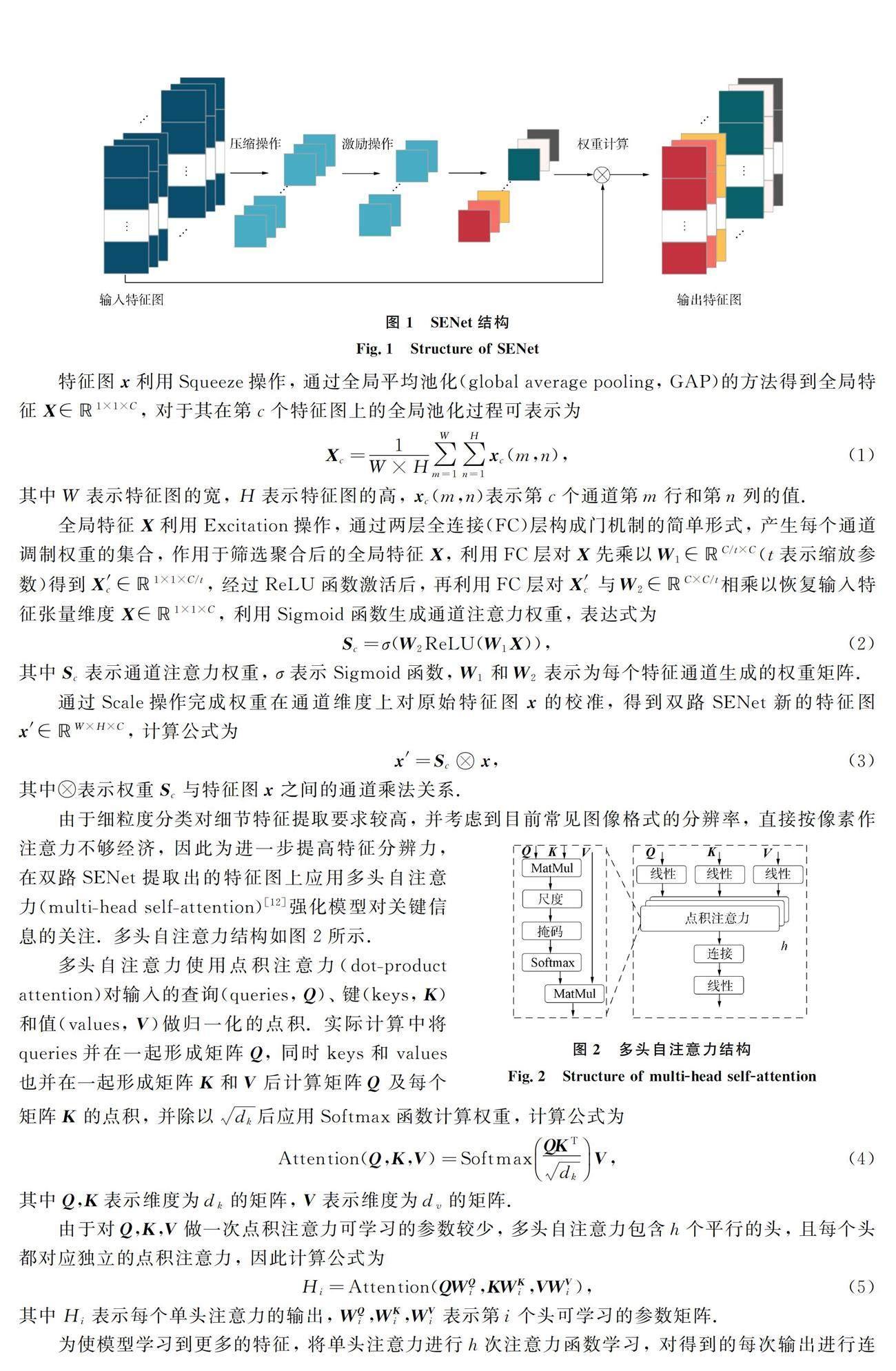

损失函数的设计和选择是决定卷积神经网络性能的关键,常用于衡量分类的交叉熵损失函数(coss entropy loss,CE-Loss)[5]收敛速度,会放大正确标签预测概率的准确性,但忽略了其他标签的差异,易拟合噪声,泛化能力较差; Liu等[6]提出的A-Softmax损失(angular Softmax loss)通过增加一个角度边界增大特征的类间差距,但训练时需要处理过多的超参数,反向传播计算较复杂,不易优化. 对于细粒度这种需要做精细分类的数据,通常希望数据在特征同类样本之间更紧凑,不同类样本之间更分散,能反应这种需求的损失函数显然更适合该类问题的求解.为更好地解决细粒度图像的分类问题,本文设计一种基于多头自注意力(multi-head self attention)和嵌入压缩激励网络(squeeze and excitation networks,SENet)的残差网络模型,用于细粒度图像的分类. 本文模型采用ResNet-50[7]作为基础网络,用于对输入图像进行初步的特征嵌入. 输入图像经过ResNet-50得到特征图后采用双路SENet做通道注意力特征权重校准[8]后,采用Transformer中的多头自注意力机制学习双路SENet输出的特征图中的空间关系. 在损失函数方面,考虑到CE-Loss学习到的特征比较离散,结合中心损失函数(center loss,C-Loss)能进一步减小同一类细粒度特征的类内距离,同时又能保持不同类别特征的可区分的特点,将CE-Loss与C-Loss进行组合实现对模型的训练. 实验结果表明,相比于当前主流的分类模型,本文模型对细粒度图像的分类效果更好.

1 预备知识

1.1 注意力机制

在神经网络中,注意力机制[9]的作用是给网络提供可供训练的权重参数,通过学习权重值,网络能学习到目标特征之间的关系,采用注意力机制对特征图进行按位的加权权重训练,可学习到特征之间的深层关系.

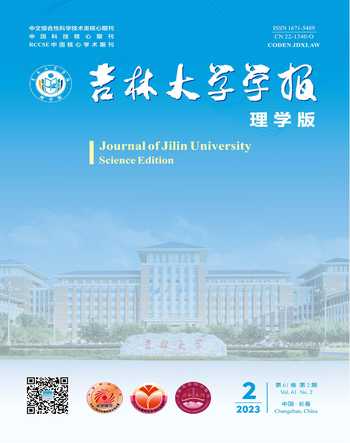

注意力机制可分为基于空间关系的注意力和基于通道数据的注意力. 基于空间关系的神经网络主要是将视觉信息视为一个大的区域,长度为n的注意力计算相当于一个面积为n的卷积核,通过将注意力的寻址目标放在寻找区域中可筛选出重要的特征,并降低无关背景信息的影响[10]. 而基于通道的注意力网络则是将检测目标视为单一个体,将注意力的寻址目标放在对单一个体部分特征的寻址上,综合该个体不同位置的特征信息,给出合理的预测结果. 本文引入SENet[11]的思想,先对每个输出通道赋予权重参数,再通过梯度更新使数据驱动参数更新,从而对每个通道进行加权参数的学习. 本质上,SENet是在通道维度上做注意力,這种注意力机制使模型可以更关注信息量最大的通道特征,而抑制那些不重要或者无效的通道特征训练模型以达到更好的效果. 并且SENet的网络结构相对简单,可方便地集成到各种神经网结构中,提升网络性能,其结构如图1所示.

参考文献

[1] 马瑶,智敏,殷雁君,等. CNN和Transformer在细粒度图像识别中的应用综述 [J]. 计算机工程与应用,2022,58(19): 53-63. (MA Y,ZHI M,

YIN Y J,et al. Review of Applications of CNN and Transformer in Fine-Grained Image Recognition [J]. Computer Engineering and Applications,2022,58(19): 53-63.)

[2] LIU X,XIA T,WANG J,et al. Fully Convolutional Attention Localization Networks: Efficient Attention Localization for Fine-Grained

Recognition [EB/OL]. (2016-05-22)[2022-05-01]. https://arxiv.org/abs/1603.06765.

[3] FU J L,ZHENG H L,MEI T. Look Closer to See Better: Recurrent Attention Convolutional Neural Network for Fine-Grained Image Recogni

tion [C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway,NJ: IEEE,2017: 4476-4484.

[4] ZHENG H,FU J,TAO M,et al. Learning Multi-attention Convolutional Neural Network for Fine-Grained Image Recognition [C]//

Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway,NJ: IEEE,2017: 5209-5217.

[5] GHOSH A,KUMAR H,SASTRY P S. Robust Loss Functions un

der Label Noise for Deep Neural Networks [J]. Proceedings of the AAAI Conference on Artificial Intelligence,2017,31(1): 1919-1925.

[6] LIU W Y,WEN Y D,YU Z D,et al. SphereFace: Deep Hypersphere Embedding for Face Recognition [C]//International Conferenc

e on Computer Vision and Pattern Recognition (CVPR). Piscataway,NJ: IEEE,2017: 6738-6746.

[7] HE K,ZHANG X,REN S Q,et al. Deep Residual Learning for Image Recognition [C]//Proceedings of International Confe

rence on Computer Vision and Pattern Recognition (CVPR). Piscataway,NJ: IEEE,2016: 770-778.

[8] SUN M,YUAN Y C,ZHOU F,et al. Multi-attention Multi-class Constraint for Fine-Grained Image Recognition [C]//Eur

opean Conference on Computer Vision (ECCV). Berlin: Springer,2018: 834-850.

[9] BAHDANAU D,CHO K,BENGIO Y. Neural Machine Translation by Jointly Learning to Align and Translate [EB/OL]. (2016-03-19)[2021-

03-10]. https://arxiv.org/abs/1409.0473.

[10] HE K M,GKIOXART G,DOLLAR P,et al. Mask R-CNN

[J]. IEEE Transactions on Pattern Analysis and Machine Intellgence,2017,42(2): 386-397.

[11] HU J,SHEN L,ALBANIE S. Squeeze-and-Excitation Network

s [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2020,42(8): 2011-2023.

[12] VASWANI A,SHAZEER N,PARMAR N,et al. Attention Is All You Need [C]//Proceedings of the 31st International

Conference on Neural Information Processing Systems. New York: ACM,2017: 6000-6010.

[13] WEN Y D,ZHANG K P,LI Z F,et al. A Discriminative Feature Learning Approach for Deep Face Recognition [C]//Proc

eedings of the European Conference on Computer Vision (ECCV). Berlin: Springer,2016: 499-515.

[14] NILSBACK M E,ZISSERMAN A. Automated Flower Classif

ication over a Large Number of Classes [C]//2008 6th Indian Conference on Computer Vision,Graphics & Image Processing (ICCV). Piscataway,NJ: IEEE,2008: 722-729.

[15] WAH C,BRANSON S,WELINDER P,et al. The Caltech-UCSD Birds 200-2011 Dataset [DB/OL].

(2011-07-01)[2022-03-01]. https://paperswithcode.com/dataset/cub-200-2011.

[16] KRIZHEVSKY A,SUTSKEVER I,HINTON G E. ImageNet Cla

ssification with Deep Convolutional Neural Networks [J]. Communications of the ACM,2017,60(6): 84-90.

[17] SIMONYAN K,ZISSERMAN A. Very Deep Convolutional Networks for Large-Scale Im

age Recognition [EB/OL]. (2015-04-10)[2021-02-01]. https: //arxiv.org/abs/1409.1556v4.

[18] 張潜,桑军,吴伟群,等. 基于Xception的细粒度图像分类 [J]. 重庆大学学报,2018,41(5): 85-91. (ZHANG Q,SANG J,WU W Q,

et al. Fine-Grained Image Classification Based on Xception [J]. Journal of Chongqing University,2018,41(5): 85-91.)

(责任编辑: 韩 啸)