皮肤疾病辅助诊断系统中的数据与方法

杨怡光,王钧程,谢凤英,刘 洁

1北京航空航天大学宇航学院图像中心,北京 100191 中国医学科学院北京协和医院 2皮肤科 国家皮肤与免疫疾病临床医学研究中心 3疑难重症及罕见病国家重点实验室, 北京 100730

皮肤疾病作为常见病、多发病,严重影响人们的身体健康和生活质量[1]。皮肤疾病种类包含数千种[2],预后存在明显差异[3],准确且及时诊断是皮肤病诊疗的关键。我国是皮肤疾病高发的国家,1990—2019年皮肤疾病发病率持续升高(由24.6%增至26.0%),诊治任务艰巨[4]。同时,我国面临患者群体庞大、基层与贫困地区医疗资源严重匮乏等问题,增加了皮肤疾病的诊疗难度。

近年来随着计算机技术的快速发展,高效稳定的计算机辅助诊断(computer-aided diagnosis, CAD)系统逐渐被应用于皮肤病的临床诊断(图1)。该系统可自动提取皮损特征进而识别病变类型,具有客观和可重复性的优势,不仅有助于降低医生的诊疗强度,且有助于皮肤科医生实现更为精准、高效的疾病管理,对皮肤科临床诊断的发展具有深远影响[5]。本文就目前常用的皮损数据类型、皮肤疾病的CAD技术(包括基于皮肤镜图像的单模态及多模态融合方法)的研究进展进行综述,为解决目前皮肤科医生所面临的诊疗困境提供新思路。

图1 皮肤疾病计算机辅助诊断系统

1 皮肤疾病CAD技术常用数据类型

目前常用的皮肤疾病CAD技术主要涉及3种数据类型,即无创影像数据、患者信息元数据和皮肤病理数据。

1.1 无创影像数据

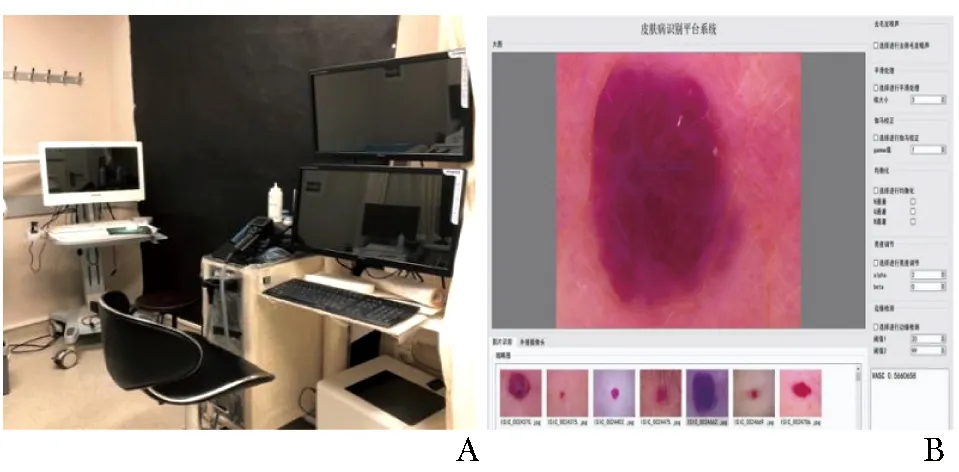

皮肤疾病以其可视特征作为诊断依据(占比>50%),与放射科、病理科成为远程医疗的“三大优势学科”。近年来皮肤影像技术迅速发展[6-7],该技术为激光、超声和电磁波等多种影像技术的总称,包括临床摄影、皮肤镜、皮肤高频超声、皮肤反射式共聚焦显微镜(reflectance confocal micros-copy, RCM)、光学相干层析成像(optical coherence tomography, OCT)、光声层析成像(photoacoustic tomography, PAT)等(图2)。

图2 皮肤影像技术图像

1.1.1 临床摄影

临床摄影,即通过光学相机拍摄采集皮肤临床图像的一类技术,用于描述患者皮损部位的颜色、形状等特征,是最接近肉眼尺度的观察视角,其作为皮肤疾病数据库的重要组成信息,可帮助医生回溯病例,同时为皮肤疾病的诊断和治疗提供参考依据。

1.1.2 皮肤镜

皮肤镜亦称皮表透光显微镜。作为一种无创性显微图像分析技术[8],其可将皮损区域放大数十倍,以辅助临床观察皮损表皮至真皮浅层的细微结构[9]。皮肤科医生通过将皮肤镜下观察到的结构特征,与“金标准”皮肤组织病理学的特征信息形成特殊而明确的对应关系,从而得出诊断结果[10]。目前,皮肤镜已大量应用于肿瘤性皮肤病、炎症性皮肤病、甲病、毛发疾病等的临床诊疗中,并发挥十分重要的作用。

1.1.3 皮肤高频超声

皮肤高频超声是传统超声技术的延伸,20~75 MHz的高频超声具有更高的分辨率和更适合皮肤组织的穿透深度,特别是对于各种良恶性皮肤肿瘤,高频超声图像可呈现肿瘤累及范围、浸润深度等信息,为治疗方案的选择提供依据,在皮肤疾病临床诊断中具有广阔应用前景[11]。

1.1.4 RCM

RCM俗称皮肤CT,其基于光学共聚焦原理,利用三维断层成像技术,作为一种快速、无痛、动态的非侵入性方法可直观、实时、动态且无创地观察皮损情况及皮肤疾病的发生发展,分辨率与组织病理学相似且有良好的对应关系,目前已被应用于肿瘤性疾病、色素性疾病、炎症性疾病、血管性疾病等皮肤疾病的诊断、鉴别及疗效监测中[12-13]。

由于皮肤镜技术较早确立并完善了一系列诊断标准,使临床诊断工作更加准确和系统化,因此应用范围更广;而其他类型的皮肤影像技术,受成像分辨率、设备价格、穿透深度、学习曲线较长等因素的限制,目前应用范围相对有限,但仍具有较好的应用前景[14]。

1.2 患者信息元数据

元数据是用以描述数据的数据,在临床诊断中其被定义为描述患者或病变的属性信息,包括年龄、性别、症状、诊断难度、病变部位、发病过程、处置方式、预后情况等。多数皮肤疾病存在高发年龄、好发部位等发病规律,如85%以上的基底细胞癌发生于颜面部,以眼眶周与颧颞部居多[15];恶性黑色素瘤好发于肢体末端[16];玫瑰痤疮多见于30~50岁女性[17]等。因此,患者信息元数据有助于指示特定的皮肤疾病,提高医生诊断的精确度,目前已被引入部分公开数据集中供研究学者们使用。

1.3 皮肤病理数据

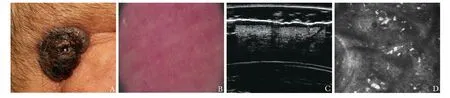

皮肤病理数据是在显微镜下观察皮肤组织病理切片,并对皮损的表皮、真皮及皮下组织改变等进行诊断,从而指导临床治疗及评估预后(图3),目前组织病理学检查仍是诊断的金标准,对于了解皮肤疾病的发生、发展和转归均有重要意义[18]。

图3 皮肤组织病理表现

可通过建立数学模型进行病理诊断,并实现病变细胞间质、细胞结构和细胞数量等一系列诊断信息的定量分析[19]。近年来,基于皮肤病理数据的深度学习系统逐渐被应用于皮肤肿瘤的诊断中,包括区分基底细胞癌与毛发上皮瘤的病理特征[20]、对恶性黑色素瘤的形态特征进行分级/分类[21]等。

2 皮肤疾病的CAD技术

模态是机器学习领域所涉及的重要概念,是人接受信息的特定方式,代表不同表现方式的数据类型,如皮肤镜图像、皮肤超声、患者临床数据等。在特定的医学任务中,并非所有模态均可有效提供特征性表现,可能存在信息冗余的情况,甚至会影响诊断准确率。多种模态间的特性既相互独立又相互补充。因此,多模态信息的融合是对实际诊断场景下皮损信息的还原和整合,具有十分重要的研究价值。以下从基于皮肤镜图像的单模态及多模态融合方法对皮肤疾病的CAD技术进行介绍。

2.1 基于单模态数据的CAD技术

在众多皮肤影像数据类型中,皮肤镜图像具有皮损特征明晰、诊断标准化程度高等特点,是当前皮肤疾病诊断中具有较高应用价值的数据类型[22]。既往研究主要集中于基于单模态数据的CAD技术,主要包括传统机器学习及卷积神经网络。

2.1.1 基于传统机器学习的CAD技术

该技术包括皮肤影像采集、图像预处理、图像分割、特征提取和分类识别五部分[23]。建库流程包括:首先对已确诊病例的皮肤镜图像进行预处理,以去除图像中影响后续步骤准确性的无用信息,如去噪、去毛发等;然后利用皮损分割技术,提取皮肤镜图像中的皮损区域;再针对皮损区域提取人工设计的特征,如颜色及纹理特征等,通过特征向量来描述皮肤镜图像;最终将特征输入自动分类器,输出诊断结果(图4)。

图4 基于传统机器学习的计算机辅助诊断流程图

恶性黑色素瘤是一种恶性程度高、易转移、危害性大的皮肤恶性肿瘤,在皮肤疾病中致死率最高,早期的皮肤镜图像CAD研究也主要集中于恶性黑色素瘤。皮肤镜图像的研究主要包括图像分割和皮损分类两方面:(1)图像分割:2008年Emre等[24]率先根据像素亮度值剔除图像周边的黑框,采用统计区域融合法得到分割结果;2013年Xie等[25]结合自生成神经网络与遗传算法对复杂的皮损图像进行分割;2016年Kasmi等[26]结合生物学信息对皮肤镜图像进行增强,然后采用测地线轮廓模型提取皮损目标边界;2017年Fan等[27]采用大津阈值与显著性信息相结合的方法实现了皮肤镜图像分割。(2)皮损分类:2007年Celebi等[28]选取437个颜色纹理形状特征,并筛选出18个重要特征,最后通过支持向量机(support vector machine, SVM)分类器进行图像分类,灵敏度与特异度分别为92.34%和93.33%。2011年Capdehourat等[29]基于皮损区域提取的颜色、纹理和形状信息并使用Adaboost法进行分类,特异度和灵敏度分别可达85%和90%。2015年Ferris等[30]提取对称性、离心率、颜色、纹理和边界梯度等54种特征,用于训练随机森林分类器,其特异度和灵敏度分别为44%和97%。2017年Xie等[31]提取颜色、纹理和边界特征,设计组合神经网络分类器并在白色人种和黄色人种数据库上分别获得了91.11%和94.17%的分类准确率。

传统机器学习CAD技术的优势是提取量化且可理解的皮损特征,能够在训练样本不大、疾病指征特异性强的场景下,辅助皮肤科医生完成疾病诊断。然而,该方法需对原始图像进行繁杂的预处理,需有经验的工程师手动设计特征提取器、选择合适的分类器进行分类,泛化能力不强,难以完成复杂的多分类任务[32]。随着大数据时代的到来和计算机硬件的发展,深度学习技术虽不能提供可理解的量化特征,但在海量训练样本的条件下,其内在特征和诊断结果更准确。因此逐渐成为CAD领域的发展方向。

2.1.2 基于深度学习的CAD技术

该方法采用卷积神经网络,作为端-端学习结构,其可忽略人工设计预处理和特征提取步骤,直接由图像自身得到分类结果(图5),减少了传统方法步骤间的累积误差,分类性能更加出色,因而在皮损复杂多变的临床场景中具有更高的实用价值。

图5 基于深度学习的计算机辅助诊断流程图

近年来,该方法主要用于鉴别皮肤肿瘤的良恶性方面。2016年Nasr-Esfahani等[33]对临床皮损图像进行光照校正后,基于卷积神经网络实现皮肤肿瘤的良恶性分类。2017年Yu等[34]使用残差网络结构分别训练皮肤镜图像的分割与分类模型,并根据分割结果重新裁切图像并输入模型,以提高分类效果。2019年Adegun等[35]提出一种基于多阶段多尺度的深度学习网络,通过跳跃连接的编码器和解码器子网络,提取病变图像的复杂视觉特征,实现恶性黑色素瘤的分级/分类。2021年Jojoa等[36]使用基于掩模和区域的卷积神经网络进行皮损区域裁剪,并通过深度残差网络(ResNet)将恶性黑色素瘤病变进行分级/分类,准确率达90.4%。

由于深度学习具有强大的特征提取能力,基于深度学习的皮肤疾病多分类成为目前研究的热点。2017年,Esteva等[37]在GoogLeNet Inception-V3网络上采用迁移学习技术对皮损图像进行端-端分类。在3种皮肤疾病和9种皮肤疾病的分类任务上分别获得了72.1%和55.4%的分类精度,该结果超过了两名专业医生的诊断水平。2019年Gessert等[38]提出一种基于块注意力机制的网络分类方法,用于高分辨率皮肤镜图像的分类诊断。2021年Yang等[39]提出一种基于EfficientNet的红斑鳞屑病皮损多分类方法,对比多种深度学习框架在五类红斑鳞屑性皮肤病中的分类表现,并引入加权交叉熵损失函数的学习策略,模型平均灵敏度达86.9%,较230名皮肤科医生的平均诊断水平高15.2%。

通过结合影像大数据与深度学习技术,AI技术可提取病例图像中模糊或非典型临床特征,有效提高诊断准确率。然而当前常用的网络模型,大多面向自然图像领域的分割、分类、检测等任务,仅依靠迁移学习直接应用于医学图像领域。由于缺少皮肤疾病临床特征的描述信息,泛化能力受限,且特征可解释性有待提升,导致模型对具有相似临床表现的皮肤疾病分类难以实现。因此,如何结合专业医生已有的诊断共识,针对皮肤疾病特点优化网络,从而构建细粒度高、泛化性强的AI诊断模型,仍是当前的一大难题。

2.2 基于多模态数据融合的CAD技术

根据融合位置的不同,可将融合多模态的方法分为输入级融合、层级融合和决策级融合:(1)输入级融合:多通道图像作为多通道输入进行逐通道融合,学习融合后的特征表示,用于训练网络。Wang等[40]提出一种多模态分割网络,利用BraTS数据集将脑肿瘤分成3个亚区,包括整个肿瘤、肿瘤核心和增强肿瘤核心。Zhou等[41]提出一种基于多模态融合的多任务分割网络,在输入空间中逐通道融合模态,学习融合后的特征表示;(2)层级融合:将两个或以上模态图像分别输入到单个网络,将这些学习到的个体特征表示融合到网络层中,最后将融合结果传递至决策层,得到最终输出结果,有效集成和充分利用多模态图像特征。Dolz等[42]提出一种基于DenseNets[43]的三维全卷积神经网络,将稠密连通性的定义扩展至多模态分割,后又提出了一种多模态MRI中的椎间盘定位和分割的体系结构,改进标准U-Net[44]模块,使用两个具有不同规模扩展卷积的卷积块协助处理多尺度信息[45]。层级融合网络中,不同层次之间的连接可以捕捉模态之间复杂的关系,充分利用了多模态图像的特征表示,通过将两个或以上模态图像分别输入到单个网络的方式,了解不同模态之间更为复杂的特征共性或差异,然后将这些学习到的特征表示融合到网络层中,将融合结果传递至决策层;(3)决策级融合:每个模态图像均输入独立的网络分支,且独立的分支均进行结果输出,最后综合多个网络的输出结果,得到最终结果。大多数决策是基于平均数和多数投票,Kamnitsas等[46]基于平均数分别训练3个网络,然后平均每个网络的置信度,最终通过赋予每个像素以最高的置信度进行分割;而对于多数投票策略,最终像素的标签取决于单个网络的大多数标签。

医生在实际诊断过程中需根据患者情况参考多种皮损数据,不同模态信息之间特征通常互为补充,难以相互取代。因此,分析并筛选多模态数据,将多模态信息融合并引入CAD系统,保留对疾病诊断预测起关键作用的数据信息,将会推进皮肤影像分析技术的进一步完善和成熟。

由于不同模态的皮肤影像之间图像尺度差异大,配准难度高,直接在输入级作通道级联效果不理想,所以皮损分类领域通常采用层级融合和决策级融合两种策略,在神经网络的中后端融合模态特征。根据多模态数据的标准化程度和纳入难度的不同,主要使用3种模态:临床图像、皮肤镜图像和患者信息,并将这3种模态进行融合。

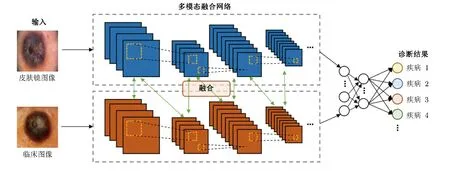

2.2.1 临床图像 + 皮肤镜图像

近年来,基于层级融合策略,使用这两类影像模态实现了皮肤疾病的智能辅助诊断(图6)。临床图像描绘了皮损形态、部位的宏观信息,而皮肤镜图像则反映了皮肤表皮与真皮层的亚宏观结构,二者基于不同的视角,在皮损诊断中共同发挥作用。2018年Yap等[47]将临床图像和皮肤镜图像同时输入ResNet,提高了5类肿瘤性疾病的分类准确率。2020年Bi等[48]提出一种超连接网络(HcCNN)用于融合临床图像和皮肤镜图像,采用多尺度注意块对两个模态的语义信息进行优先排序,实现良恶性肿瘤的皮损情况及病变表面血管、点和球等模式的预测分类,在七点数据集下的多标签分类任务中取得平均74.9%的准确率。

图6 双模态皮损影像融合网络框架

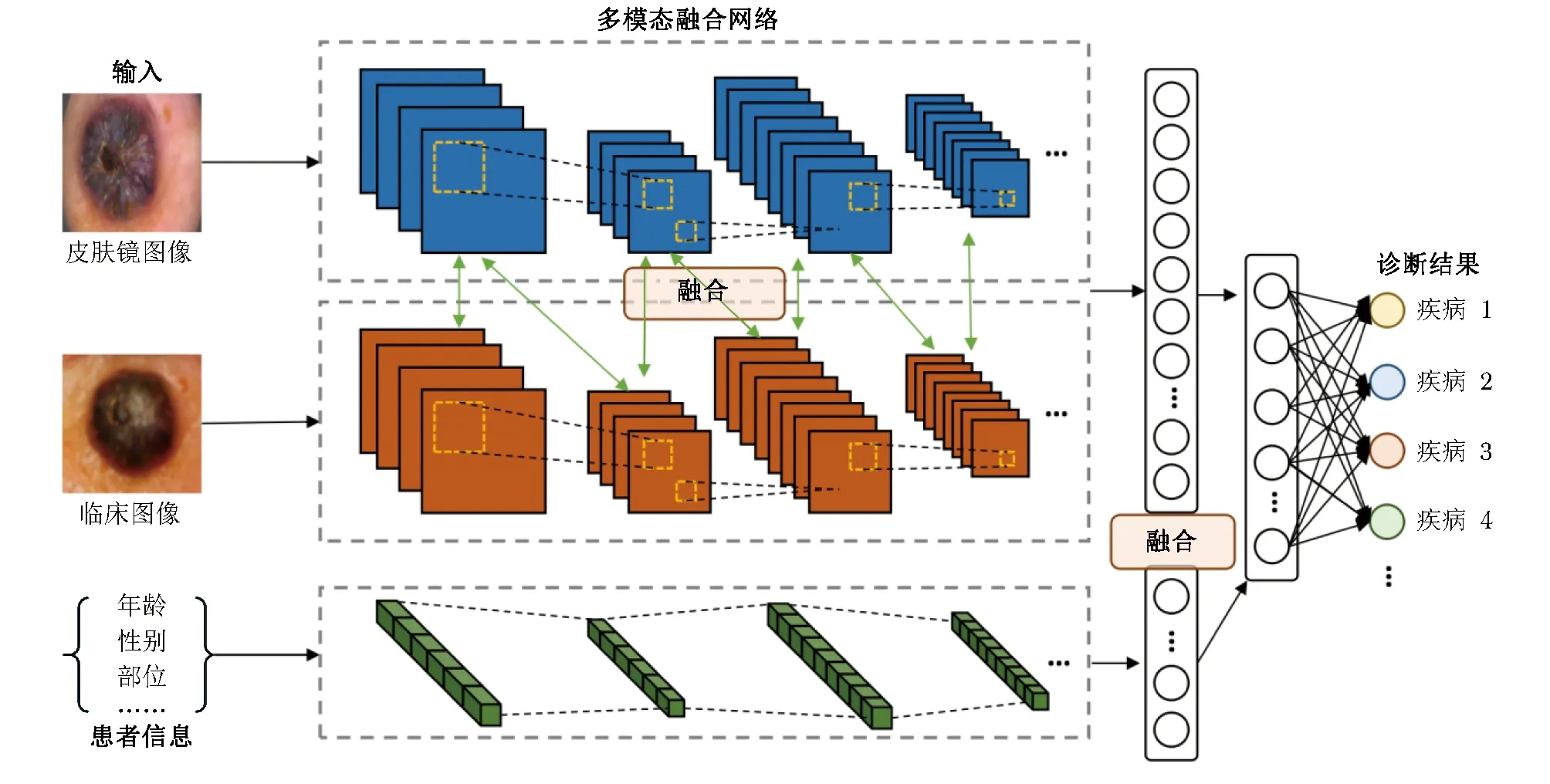

2.2.2 临床图像+皮肤镜图像+患者信息:

由于部分疾病存在高发人群、好发部位等发病规律,皮肤科医生在临床中不仅会观察皮损的临床特征、皮肤镜等图像信息,还会同时考虑患者的年龄、性别以及职业等信息,综合得出诊断结果。这些文本信息的应用为多模态融合研究提供了启示。

相关的研究成果综合了层级融合和决策级融合策略,将患者信息引入多模态网络,实现皮肤疾病的多分类任务(图7)。2018年Kawahara等[49]基于临床特征和皮肤镜图像数据采用Inception-V3模型对恶性黑色素瘤、色素痣、基底细胞癌等皮肤病进行分类,并将元数据引入网络,实现多模态皮肤数据的联合分析,提高了分类准确率。2022年Tang等[50]提出了一种用于多标签皮肤病分类的多模态算法(FusionM4Net),一阶段提取并整合临床和皮肤镜图像特征,二阶段整合患者信息元数据,同时在特征级和决策级融合上述模态,最终在七点数据集上取得78.5%的平均准确率。

图7 多模态皮损数据融合网络框架

基于多模态数据融合的CAD技术,符合临床场景下多维度、多模态信息的实际需要,不仅具有高效性、高重复性,且可获得比单一模态数据更高的诊断准确率[51-53]。然而,目前多模态融合方面的研究还比较少,可能原因:(1)当前研究成果未采用皮肤病理数据、实验室检查数据等模态信息,缺乏足量的标准化样本,残缺的模态数据可能降低神经网络的分类性能;(2)现存基于多模态融合的网络方法大多针对CT、MRI等三维医学影像,与皮肤疾病的模态数据存在较大差异,模型难以直接迁移应用于皮肤疾病的诊断。因此,基于深度学习的皮肤影像多模态融合技术,仍有待相关领域研究学者的进一步探索。

3 小结与展望

为解决皮肤疾病发病范围广、诊断难度高、医疗资源短缺等诸多问题,近年来皮肤病CAD技术已取得长足发展。皮肤疾病数据的种类丰富,特征相互补充,在临床诊断工作中发挥不同作用。基于皮肤镜图像的单模态CAD技术,解决了传统方法效率低、主观性强等问题,但仍不能充分利用实际临床场景下多模态数据的优势。多模态学习考虑多种信息类型的一致性和互补性,全面利用实际诊断场景中的临床数据,采取多模态融合策略,帮助AI模型学习更复杂全面的临床特征表达,从而辅助皮肤科医生进行更准确的诊断,对CAD技术的发展具有深远影响,为缓解皮肤疾病的诊断困境提供了新思路。

当前基于深度学习的多模态融合技术取得了不亚于专业医生的诊断准确性,其建构的CAD系统具有广阔的临床应用前景,但其计算出来的特征与医生的临床诊断标准之间缺乏直接的映射关系,无法提供可被临床理解的诊断依据。目前算法的“黑箱”特性一定程度上限制了AI技术在临床中的实用价值[54]。

因此,医学影像分析领域亟待新的学习方法产生,并将提取的特征与临床表现进行映射,增强神经网络的分类性能和可解释性。而本研究既能推进CAD技术的高效精确化发展,同时有望提高医生对疾病临床表现的理解程度,助力其诊断水平的提升。未来随着AI技术进一步显性化,有望形成一套人机共通互解的医学语言,经验知识共享并相互完善,实现真正意义上“人机协作”的诊疗模式。

作者贡献:杨怡光和王钧程负责查阅文献、论文撰写及修订;谢凤英和刘洁负责选题设计和论文审校。

利益冲突:所有作者均声明不存在利益冲突