采用改进U-Net网络的机收大豆质量在线检测

金诚谦,刘士坤,2,陈 满,杨腾祥,徐金山

采用改进U-Net网络的机收大豆质量在线检测

金诚谦1,刘士坤1,2,陈 满1,杨腾祥1,徐金山1

(1. 农业农村部南京农业机械化研究所,南京 210014;2. 安徽农业大学工学院,合肥 230036)

破碎率、含杂率是评价大豆联合收获机的重要作业性能指标,破碎率、含杂率实时数据是实现大豆联合收获机智能化调控的基础。为了实现大豆机械收获过程破碎率、含杂率的在线检测,该研究提出了基于改进U-Net网络的机收大豆破碎率、含杂率在线检测方法。以大豆联合收获机实时收获的大豆图像为对象,使用开源标注软件Labemel对数据集进行标注,构建基础数据集。针对大豆图像粘连、堆叠、语义信息复杂等问题,以U-Net为基础网络结构,结合VGG16网络并在各激活层(Rectified Linear Unit,ReLu)前引入批归一化层(Batch Normalization,BN)防止过拟合;在编码器中提取的特征图后面添加卷积块注意力模块(Convolutional Block Attention Module,CBAM)抑制无关区域的激活,减少冗余部分;采用最近邻插值法的上采样替换解码器中转置卷积,避免转置卷积引起的棋盘效应。试验结果表明:改进U-Net网络能有效地将图像中完整大豆籽粒、破碎籽粒和杂质进行识别分类,完整籽粒识别分类综合评价指标值为95.50%,破碎籽粒识别分类综合评价指标值为91.88%,杂质识别分类综合评价指标值为94.35%,平均交并比为86.83%。应用所设计的大豆籽粒破碎率和含杂率在线检测装置开展台架和田间试验。台架试验结果表明,本文方法的检测结果与人工检测结果的破碎率均值绝对误差为0.13个百分点,含杂率均值绝对误差为0.25个百分点;田间试验表明,本文方法检测结果与人工检测结果的破碎率均值绝对误差为0.18个百分点,含杂率均值绝对误差为0.10个百分点。所提检测方法能够准确在线估算机收大豆的破碎率和含杂率,可为大豆联合收获作业质量在线检测提供技术支持。

联合收获机;图像分割;大豆;U-Net网络;识别分类;破碎率;含杂率

0 引 言

大豆是重要的油料作物,在国家粮油安全体系中占有重要地位。机械化生产是提高大豆生产水平的基础[1],机械化收获是重中之重[2-4]。破碎率、含杂率[5]是评价大豆联合收获机作业性能的重要指标。现阶段,国内联合收获机作业过程中对破碎率、含杂率的检测,只能停机后依靠人工完成,误判率高、效率低下。

随着机器视觉和深度学习在各个领域广泛应用,国内外研究者将图像处理技术[6-9]应用到籽粒、谷物杂质识别上[10-12],如黏连籽粒图像分割[13]、玉米种子特征提取[14]与识别和大豆外观品质特征提取等[15-16]。CLAAS公司推出了一款“谷物质量摄像头”,在联合收获机作业过程中对非谷物成分和破碎籽粒含量进行分析,并在驾驶室操作面板上显示分析数据[17];Momi等采用机器视觉对大豆收获过程中破碎籽粒、病害籽粒、茎/豆荚进行识别[18];陈进等提出了基于机器视觉的水稻杂质及破碎籽粒在线识别方法并设计了在线采样装置,设计了基于U-Net模型的含杂水稻籽粒图像分割方法,水稻籽粒的分割综合评价指标值为99.42%,枝梗的分割综合评价指标值为88.56%,茎秆的分割综合评价指标值为86.84%[19-22]。上述研究在谷物籽粒、杂质识别分割已经取得不错效果,为机收大豆籽粒破碎率和含杂率在线检测提供了借鉴。

传统的图像分类识别多基于颜色阈值、纹理、形状等特征提取,采用聚类、分水岭分割等算法实现,需要人工提取浅层特征信息,算法效率低且通用性差。近年来,语义分割[23-24]成为机视觉领域的研究热点,它对图像的每一个像素点分配语义标签,在像素级对图像分类识别,实现端到端的像素级分割,能够获得更高的分割精度和效率。随着深度学习的快速发展,基于深度学习的语义分割广泛应用于医疗影像[25]、道路分割[26]、桥梁裂缝图像[27]和遥感影像[28]等的分割并取得较好效果分割。

针对复杂环境下大豆图像样本的快速有效识别和分类。本文提出基于U-Net网络的机收大豆籽粒破碎率和含杂率在线检测方法,设计机收大豆图像采集装置,研究基于改进U-Net网络的大豆图像识别分类算法,以实现机械化收获的大豆籽粒破碎率和含杂率在线检测。

1 在线检测装置整体结构与系统工作流程

1.1 整体结构

大豆籽粒破碎率和含杂率在线检测装置主要由笔记本电脑、动态图像采集装置、数据电源总线等部分组成,如图1所示。动态图像采集装置完成大豆机械化收获时出粮口大豆动态图像获取,主要包括工业摄像头、LED光源、直流舵机、电机驱动板、挡板、采样槽等部分,其中工业相机选用华锐视同科技有限公司的USB2.0工业摄像头(型号LRCP10230、速度30帧/s、镜头焦距12 mm),工业相机镜头距离透明有机玻璃105 mm。

1.笔记本电脑 2.232总线 3.USB2.0 4.直流舵机和电机驱动板 5.工业摄像头 6.图像动态采集装置 7.LED光源 8.联合收获机出粮口 9.采样槽 10.透明有机玻璃 11.大豆 12.挡板 13.滑块 14.偏振镜 15.支撑杆 16.拨杆 17.支撑座 18.集粮斗

笔记本电脑内置大豆破碎率含杂率在线检测软件系统,通过USB2.0连接图像动态采集装置内工业相机采集大豆图像,通过232总线控制图像动态采集装置内的直流舵机正反转,带动拨杆拖动挡板实现大豆样本的采样-弃样操作,从而实现大豆样本图像的周期性动态采样。

1.2 系统工作流程

大豆籽粒破碎率和含杂率在线检测系统的工作流程如图2所示,具体步骤如下:

1)系统上电后进行自检并初始化,拍照计数器清零;

2)检测232总线通信是否正常、舵机通信是否正常、工业摄像头是否正常,如果不正常输出相应的提示信息;正常则继续执行程序;

3)发送直流舵机控制指令,控制直流舵机带动伸缩板缩回,采样槽释放大豆样本,延时500 ms,更新采样槽内的大豆;发送直流舵机控制指令,控制直流舵机带动伸缩板伸出,采样槽装载大豆样本,延时500 ms,保证采样槽有机玻璃窗被大豆样本完全覆盖,实现采样槽内大豆样本的更新;

4)发送工业摄像头控制指令,透过采样槽有机玻璃窗拍摄静止状态的大豆样本图片,将拍到的图片保存在“田间试验”文件夹下,覆盖同名文件,拍照计数器加1;

5)判断拍摄样本图像的数量是否>5,如未达到,则顺序执行步骤3)~4);如符合要求,读取“田间试验”文件夹下的5张图像,对图像进行预处理,将1 280像素× 1 024像素的原始图像下采样为512像素×512像素的模型输入图像,调用U-Net预测模型,进行样本中完整大豆籽粒、破碎籽粒、杂质的识别分类,完成后将图像上采样为原有尺寸,获得大豆样本各成分像素数;调用破碎率和含杂率计算模型,计算出单幅样本图像的破碎率和含杂率数据及5张样本图像的破碎率和含杂率均值数据,将均值作为本次检测结果输出,并将所有计算结果写入数据记录文件,拍照计数器清零;

6)判断系统是否收到停止检测的信息,如未收到,则顺序执行步骤3)~6),进行新的检测任务;如是则结束任务。

图2 系统工作流程

2 改进的U-Net网络设计

2.1 数据集制作

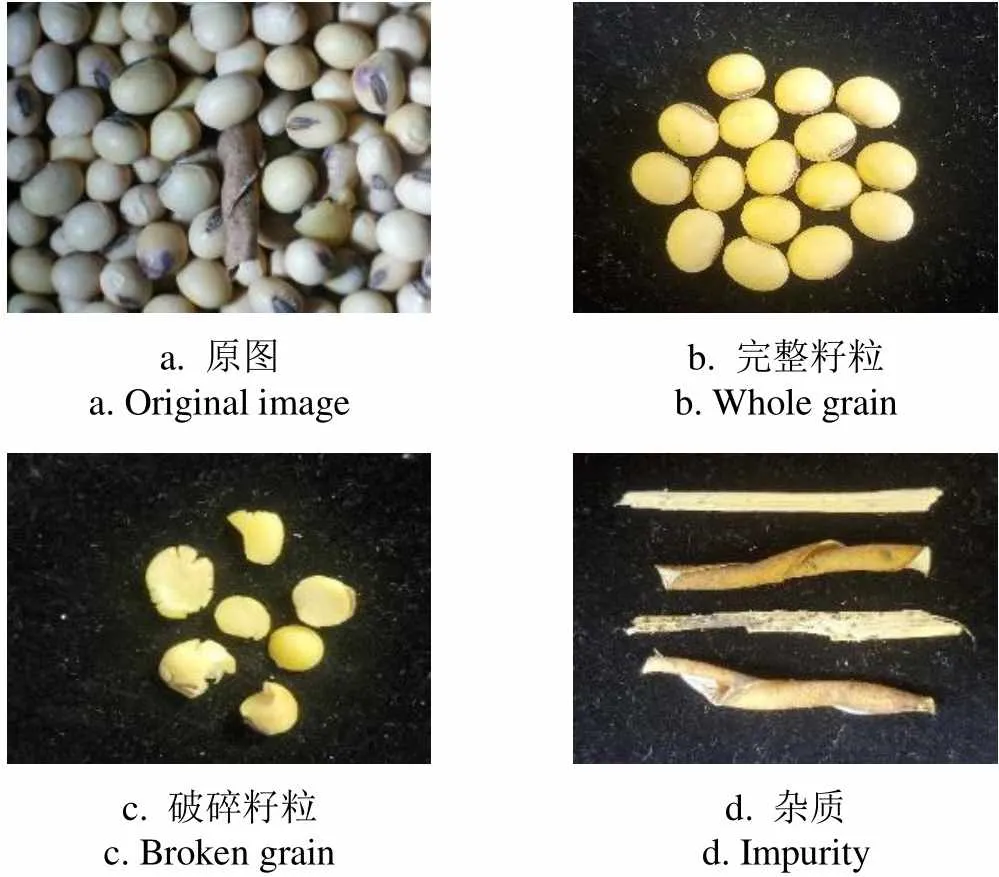

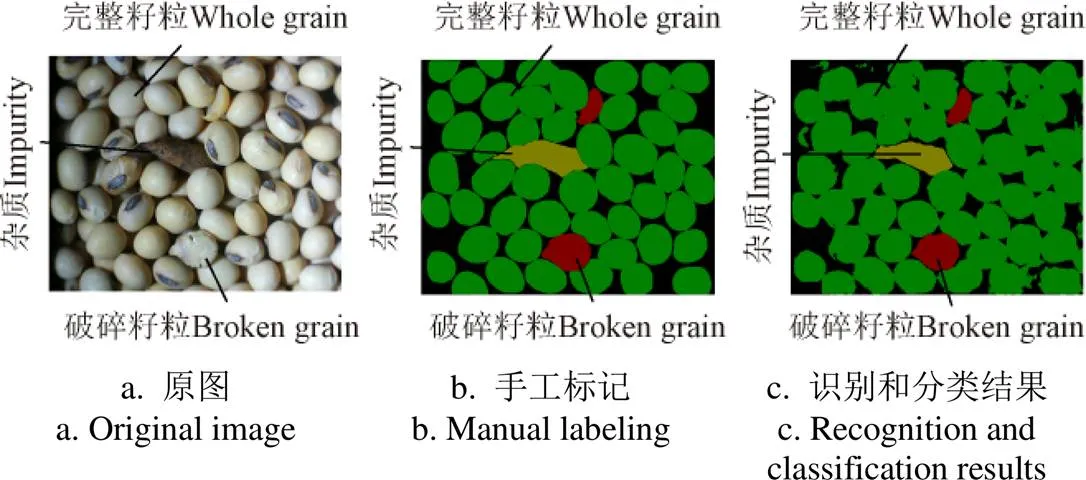

大豆样本图像采集于2020年10月15日山东省济宁市长沟镇大豆试验田的收获过程,将图像采集装置安装在4LZ-6型智能化大豆联合收获机输粮装置的出口下方,程序设定图像保存格式为.jpg。大豆品种为齐黄34,收获时含水率为12.6%,百粒质量为27.47 g。共采集图片118张,样本图像包含完整大豆籽粒(即没有机械损伤的大豆籽粒)、破碎籽粒(即由机械收获造成裂瓣和压扁籽粒)、杂质(即豆荚、茎秆等),如图3所示。霉变大豆和自然破皮大豆不属于机械损伤,算作完整籽粒。

使用开源标注软件Labelme 3.18.0手工标记完整籽粒、破碎籽粒和杂质边界,为了可视化对比,对包括背景在内的4种分类结果进行着色,如图4a所示。模型构建时采用如图4b所示的标签灰度图,对于标签而言,每个像素点的内容是一个数字,代表这个像素点所属的类别,像素点内容为0代表背景,像素点内容为1代表破碎大豆籽粒,像素点内容为2代表完整大豆籽粒,像素点内容为3代表杂质。

a. 原图a. Original imageb. 完整籽粒b. Whole grain c. 破碎籽粒c. Broken graind. 杂质d. Impurity

图4 样本标签图

随机选取图像集中的115张作为训练集,3张作为测试集。由于训练集数据量较少,通过图像增强,如图5所示,在原图像[0~768,0~512]像素区间内随机生成6个起始像素点,以起始像素点为起点,以512像素为步长,裁剪获得512像素×512像素的增强的图像,共得到690张图像,以9﹕1的比例随机分为训练集和验证集,其中621张作为训练集,69张作为验证集。以此数据集为基础,开展5轮模型训练,获取最优的训练模型。测试集数据通过下采样图像预处理后作为模型的输入,测试模型的精度。

2.2 改进的U-Net网络结构

2.2.1 网络结构概述

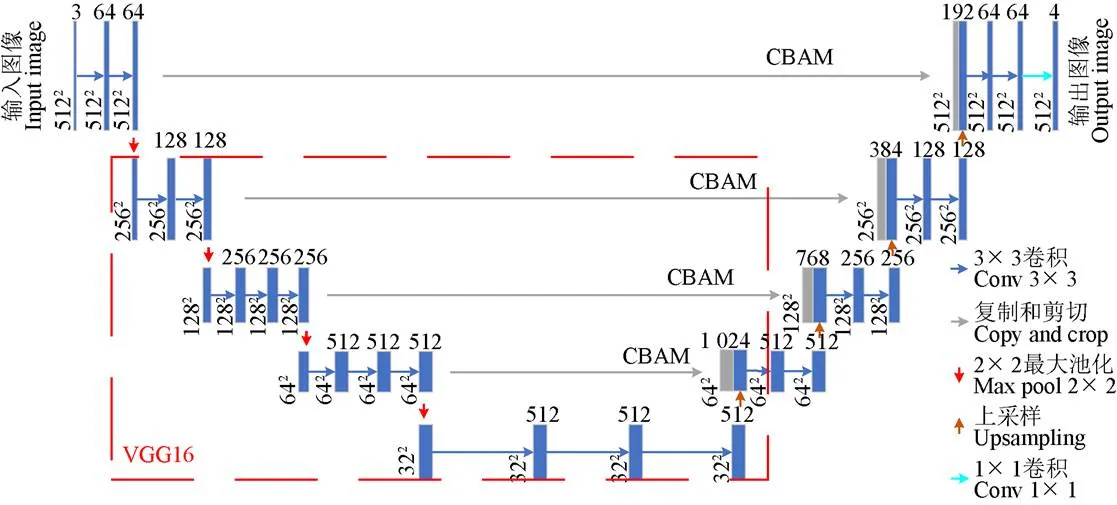

语义分割网络U-Net是一个经典的全卷积网络,由编-解码结构组成,整个网络结构呈现U型。适合处理小尺寸物体的分割。因此,本文基于U-Net网络提出改进能在复杂环境下对大豆图像快速识别和分类的网络,网络整体结构如图6所示,主要包括编码器和解码器。编码器是主干特征提取部分,用于信息提取,解码器将特征图尺寸恢复到原图大小并将编码器提取的特征图同解码器对应的特征层融合。

2.2.2 编码器

U-Net的编码器由卷积+最大池化组成,整体结构与VGG16类似。为方便使用Keras内置的VGG16模型在ImagNet验证集上的预训练权重,本文将VGG16网络模型与U-Net网络结构相结合,编码器部分包含13个3×3卷积、4个最大池化层,为防止过拟合,在各激活层(Rectified Linear Unit,ReLu)前引入批归一化层(Batch Normalization,BN)。

原图Original image起始像素点Starting pixel point增强图像Enhanced image

注:CBAM表示基于空间注意力和通道注意力子模块构造的卷积块注意力模块。

2.2.3 解码器

解码器包含8个3×3卷积、1个1×1卷积、4个特征融合部分和4个上采样。针对特征融合中编码器提取的特征图有很多的冗余信息,本文在编码器提取的特征图后面添加基于空间注意力和通道注意力子模块构造的卷积块注意力模块(CBAM,Convolutional Block Attention Module),减少冗余信息;同时为避免出现棋盘效应,上采样采用最近邻插值法,如图7所示。

在通道注意力子模块中输入特征图经过两个并行的最大值池化和平均池化将××(特征图的高×特征图的宽×特征通道数)的特征图变成1×1×大小,然后经一个Shard MLP,压缩通道数/(为压缩因子,=16),再扩张通道数至,得到2个激活的结果,将两者相加再接一个激活函数sigmoid最后再乘以最初的输入,特征图大小变回了××,完成通道注意力操作。通道注意力模块聚焦在图像中“什么”是有意义的,通道维度不变,压缩空间维度,减少冗余信息,提高分类精度。

注:H、W、C分别为特征图的高、特征图的宽、特征通道数。

在空间注意力子模块中将经过通道注意力操作后的特征图同样经过最大值池化和平均池化分成2张大小为××1的特征图,将2张特征图堆叠并通过卷积操作变为1张××1的特征图,经过一个激活函数sigmoid再乘上最初的特征图,完成空间注意力操作。空间注意力集中于“哪里”这一空间信息部分,空间维度不变,压缩通道维度,与通道注意力互补,提高边界的分类精度。

2.3 网络训练

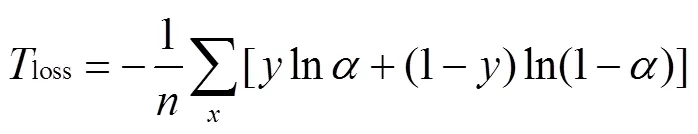

训练集损失函数使用基于多分类交叉熵损失,计算公式为

式中loss为多分类交叉熵损失;为样本数量,即batchsize;为预测向量维度;为此像素点的真实值;为此像素点预测的概率值,取值范围为0~1。

验证集采用Dice loss作为损失函数。其中,Dice系数是一种集合相似度度量函数,通常通用于计算两个样本的相似度,取值范围[0,1],Dice系数值越大表示预测结果和真实结果重合度越高,其计算公式如下:

式中f为Dice系数;为预测结果;为真实结果。

验证集的损失函数loss计算公式如下:

本文使用的笔记本电脑显卡型号GTX2060、内存6 GB、处理器型号AMD R7-4800H、频率2.90 GHz、运行内存16 GB,在笔记本电脑上安装Ubuntu20.04操作系统、python3.8编译环境、pycharm开发平台,使用深度学习框架 Tensorflow2进行网络构建、训练和预测,设定随机梯度下降为优化器,训练集通过深度学习框架Tensorflow2中的前向传播算法得到像素点预测值,利用损失函数得到预测值与真实值之间的差距,通过反向传播算法调整网络中相关参数缩小差距,直至差距无法缩小或完成迭代次数结束训练。设置初始学习率为0.000 1,迭代次数100次,重复训练5次。第一次训练模型加载VOC2007图像数据集预训练的模型权重,之后的每一次训练都加载前一次训练结果中最优模型的权重。将5组训练获得的最优模型作为改进U-Net网络预测模型,用于实现大豆样本图像信息的识别。

图8是其中1组模型训练过程训练损失和验证损失变化曲线。模型的训练分为2个阶段,分别为冻结阶段和解冻阶段,冻结阶段和解冻阶段的迭代次数都是50次。冻结阶段网络中主干网络被冻结,特征提取网络不发生改变,占用的显存较小,仅对网络进行微调;解冻阶段网络中主干网络不被冻结,特征提取网络会发生改变,占用的显存较大,网络所有的参数都会发生变化,从冻结阶段过渡到解冻阶段,网络所有参数都发生改变,重新进行训练,从而引起数据的波动。由图8可知,在解冻训练过程,由于模型的所有参数随机变化,易造成模型训练的不确定性,此时模型的损失率高于冻结阶段。因此,训练过程加载预训练权重,在此基础上进行参数的微调,有利于获得最优的网络参数。模型训练迭代100次后,将训练损失最优的模型作为本次训练的结果,作为下次训练的模型预训练权重。本次训练最优模型的损失率为0.150 2,验证损失为0.325 7。

图8 训练损失和验证损失曲线

2.4 改进U-Net网络的预测效果

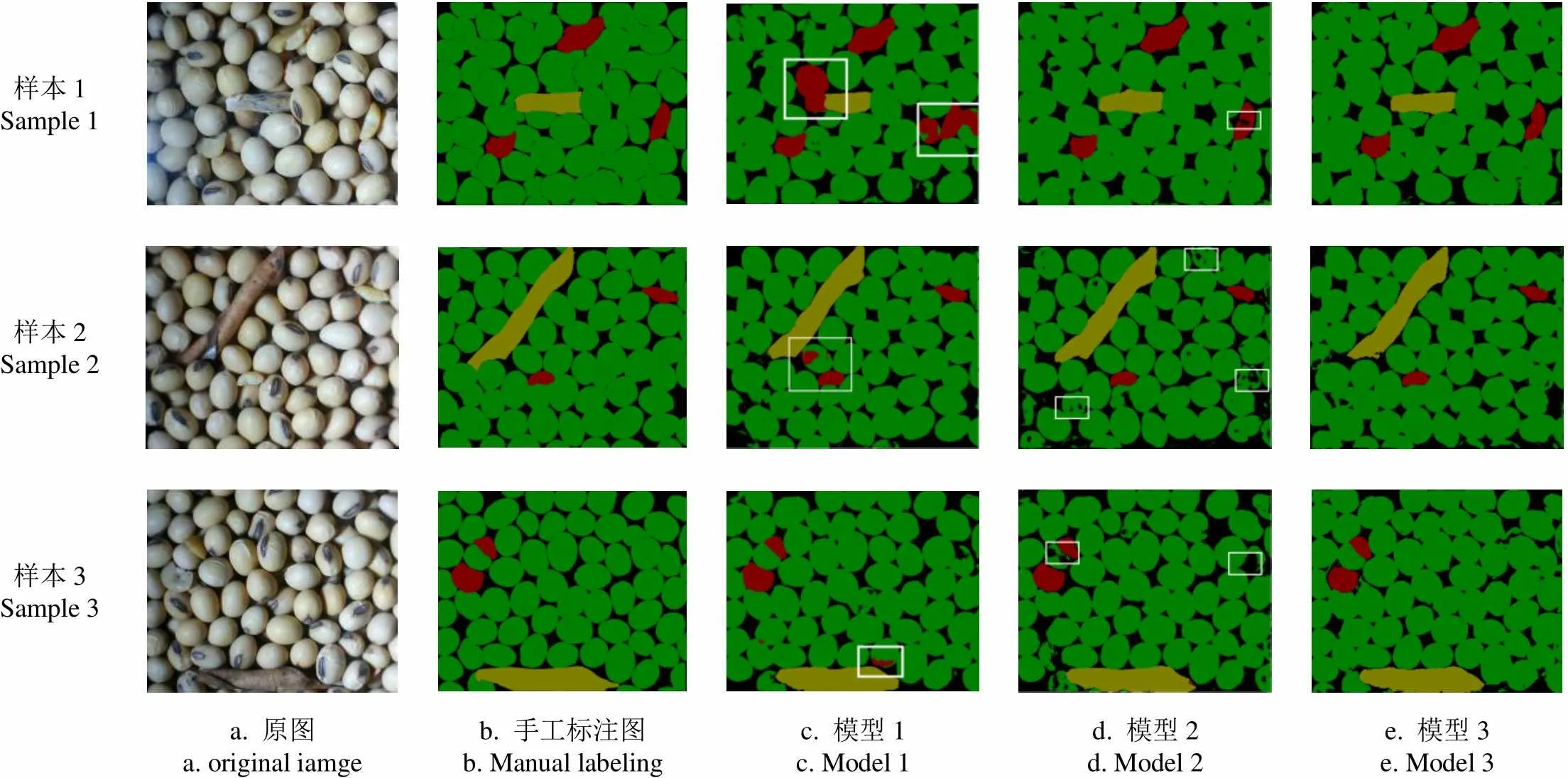

为了评估本文设计的改进U-Net网络的预测效果,开展了各个改进U-Net网络结构的预测效果对比试验。以原始U-Net为基础网络,逐步添加改进结构,构建3组不同的网络试验。模型1为原始U-Net网络;模型2是在模型1的基础上添加CBAM并将VGG16网络结构加进编码器部分;模型3(本文设计的改进U-Net模型)是在模型2的基础上将解码器部分的转置卷积换为采用最近邻插值法的上采样。将测试集中的图像用不同网络结构分别进行预测分类,预测结果如图9所示。从预测图中方框内部分可以看出,模型1对于破碎籽粒出现误判;模型2预测图片出现棋盘效应[29],对图像籽粒像素点分类出现漏分类;模型3采用最近邻插值法的上采样替换解码器部分的转置卷积后,棋盘效应消失。

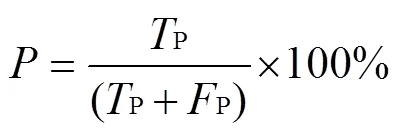

采用精确率、召回率、平均交并比MIOU作为图像识别分类结果的评价指标[30-31],并以综合评价指标1作为准确率和召回率的评估值,各指标计算公式如下:

样本1Sample 1 样本2Sample 2 样本3Sample 3 a. 原图a. original iamgeb. 手工标注图b. Manual labelingc. 模型1 c. Model 1d. 模型2d. Model 2e. 模型3 e. Model 3

式中为精确率,%;为召回率,%;1为综合评价指标,%;P为将正确分类像素点预测为正确分类像素点数量;P为将错误分类像素点预测为正确分类像素点数量;N为将正确分类像素点预测为错误分类像素点;为分类的类别数;IOU为交并比,%;MIOU为平均交并比,%。

分别统计不同模型识别分类的大豆破碎籽粒、完整籽粒、杂质的精确率、召回率、综合评价指标,结果如表1所示。模型3(本文提出的改进U-Net网络)预测识别结果统计中完整籽粒、破碎籽粒、杂质的综合评价指标1分别为95.50%、91.88%、94.34%,MIOU值为86.83%,要优于其他网络。手工标记图与原图对比会存在部分漏标现象,经研究表明手工标记图漏标情况,在预测时对预测精度影响较小。在样本图像预测识别时效性上,模型1所需的时间最短,模型2和模型3的时间上接近,模型3(本文提出的改进U-Net网络)的单幅图像解析时间为0.185 4 s。

由表2可知,改进U-Net网络预测图像中完整籽粒、完整籽粒、杂质的综合评价指标1都高于其他2种网络,其中完整籽粒的综合评价指标1比DeepLabV3+网络的高2.69个百分点,比文献[9]的高8.79个百分点;破碎籽粒的综合评价指标1比DeepLabV3+网络和文献[9]高7个百分点左右;杂质的综合评价指标1比DeepLabV3+网络的高8.16个百分点,比文献[9]的高9.92个百分点。改进U-Net网络识别分类效果提升明显,尤其对图像中破碎籽粒和杂质的识别分类。相较于其他算法,改进U-Net网络解析时间略高于DeepLabV3+网络,远低于文献[9],单幅图像解析时间为0.185 4 s,能够满足田间作业实时处理要求。

表1 不同U-Net网络的识别分类效果

表2 不同网络的识别分类效果

3 验证试验

3.1 大豆籽粒破碎率与含杂率的量化模型

现有的大豆联合收获机作业质量检测方法中含杂率是样品中籽粒质量与杂质质量的百分比;破碎率是样品中破碎籽粒质量与完整籽粒质量的百分比。根据现有的测定方法,制定了基于像素点的破碎率、含杂率量化模型,计算公式为

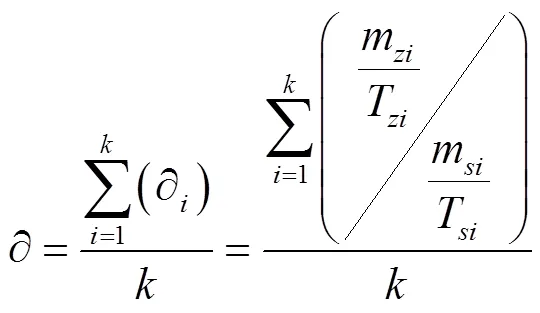

式中z为含杂率,%;为破碎率,%;为预测图像中完整籽粒像素点数;为预测图像中破碎籽粒像素点数;为预测图像中杂质像素点数;∂为预测图像中杂质平均像素质量与籽粒平均像素质量的比值。

∂作为杂质平均像素质量与籽粒平均像素质量的比值,其值会随着杂质种类的不同而改变,为了简化含杂率量化模型,在实验室内通过像素质量标定试验确定∂值,在标准容器内装载混合有杂质的大豆样本,拍摄其图像并称量,获得该样本中杂质像素点、大豆籽粒像素点、大豆杂质质量和大豆籽粒质量,重复50组试验,∂的计算公式如下:

式中为手工标定试验的重复次数,为常数50;为第次手工标定试验;∂为第次手工标定试验得到的待检测图像杂质平均像素质量与籽粒平均像素质量的比值;为第次手工标定试验样本中杂质的质量,mg;为第次手工标定试验样本中大豆籽粒的质量,mg;为第次手工标定试验样本图像中大豆籽粒的像素;为第次手工标定试验样本图像中大豆杂质的像素。

∂值人工标定结果如图10所示,∂值为0.115 5,杂质平均像素质量和籽粒平均像素质量的拟合度达到0.999 99。因此,标定试验得到的∂值能客观表征大豆样本图像中杂质平均像素质量与籽粒平均像素质量之间的对应关系。

图10 像素质量比值人工标定结果

3.2 台架试验

3.2.1 试验材料与方法

试验地点为农业农村部南京农业机械化研究所东区,试验时间为2020年12月3日。试验大豆样本来源于山东省济宁市长沟镇大豆试验田的收获过程,随机从粮箱中取样3批次,每批次样本质量30 kg,大豆品种为齐黄34,大豆籽粒平均含水率为11.9%,百籽质量为25.58 g。

试验台架由机架、粮箱、刮板升运器、电机和大豆样本采样装置组成,如图11所示,采用试验台架进行3组试验。台架工作时,电机带动搅龙转动,粮箱内的大豆被传送到刮板升运器上,升运器最上端连接一个出料斗,大豆从出料斗落入粮箱中,部分大豆从出料斗落入大豆样本采样装置中,大豆样本检测完成后,装置中大豆回落到粮箱内。

将大豆籽粒破碎率和含杂率检测装置安装于试验台架出料斗下方,连接好电源,调试设备;准备好3个批次大豆样品;将1个批次大豆样品倒入到试验台架粮箱,启动电机,开始自动检测,为了减少反复输送对大豆样本造成二次损伤,每个批次大豆样本检测10次;关闭电机,将粮箱内的大豆清除干净,进行第二批次大豆样本检测。记录试验数据,并与人工检测结果进行比较。

3.2.2 台架试验结果与分析

随机从台架试验采集的图像中选取一张图像,使用labelme对图像进行手工标注,分析改进U-Net的识别分类效果,如图12所示。预测杂质的精确率为99.02%、召回率为83.17%、综合评价指标1为90.40%;破碎籽粒的精确率为96.69%、召回率为95.10%、综合评价指标1为95.89%;完整籽粒的精确率为94.41%、召回率为92.70%、综合评价指标1为93.55%。由此可见,改进U-Net的识别分类效果良好,能够实现大豆样本各成分的有效识别分类,为样本破碎率含杂率的准确预测奠定基础。

图12 台架试验图像识别与分类结果

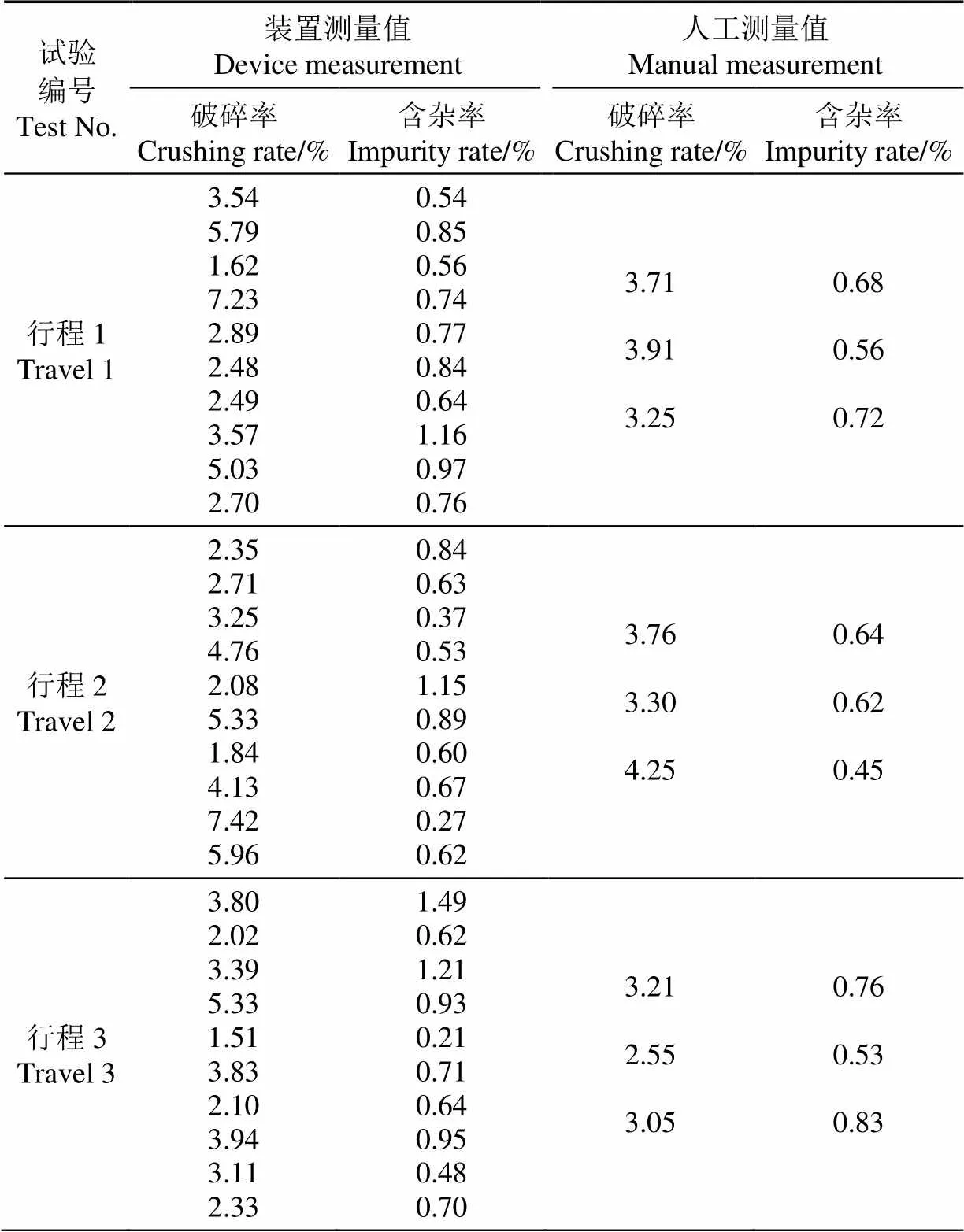

试验过程中,试验台和大豆籽粒破碎率和含杂率检测装置工作正常,可实现大豆籽粒破碎率与含杂率在线检测。台架试验数据统计结果如表3所示,含杂率检测最大值为1.40%,最小值为0.15%,均值为0.78%;破碎率最大值为5.33%,最小值为1.51%,均值为3.17%。分别对3个批次大豆随机均匀取3个样本点,参照NY/T738—2020《大豆联合收获机作业质量》人工检测样本的破碎率和含杂率。人工检测含杂率最大值为0.78%,最小值为0.28%,均值为0.53%;破碎率最大值为3.76%,最小值为2.48%,均值为3.04%。试验结果表明检测装置检测结果与人工检测结果的破碎率均值绝对误差为0.13个百分点,含杂率均值绝对误差为0.25个百分点。

3.3 田间试验

3.3.1 试验材料与试验地点

试验地点为山东省济宁市任城区后刘村大豆试验田,大豆品种为齐黄34,含水率为12.1%,千粒质量为246.5 g,试验时间为2021年10月18号,试验收获机具为4LZ-6型智能化大豆联合收获机。

3.3.2 田间试验步骤

共开展3个行程的重复试验,单行程作业长度200 m,作业速度为6 km/h,每个行程检测10次。试验现场如图 13所示。将检测装置安装到4LZ-6型智能化大豆联合收获机输粮装置的出口下方,并连接联合收获机车载电源,调试设备,启动联合收获机开始收获,大豆籽粒破碎率和含杂率检测装置自动在线检测作业效果。完成一个行程后,停机,在粮箱中随机均匀取3个样本,参照NY/T738—2020《大豆联合收获机作业质量》人工检测大豆籽粒破碎率和含杂率,取样完成后开机继续进行试验。

表3 台架试验大豆破碎率和含杂率统计结果

图13 田间试验现场

3.3.3 田间试验结果与分析

随机从田间试验采集的图像中选取1张图像,使用labelme对图像进行手工标注,分析田间试验过程中改进U-Net的识别与分类效果。如图14所示,检测结果的杂质精确率为81.75%、召回率为91.57%、综合评价指标1为86.38%;破碎籽粒的精确率为98.93%、召回率为83.12%、综合评价指标1为90.34%;完整籽粒的精确率为96.08%、召回率为93.01%、综合评价指标1为94.52%。结果表明,本文设计的检测装置田间应用效果良好,能够实现田间收获过程中大豆籽粒成分的有效识别与分类。

田间试验过程中,大豆破碎率含杂率检测装置工作正常。田间试验数据统计结果如表4所示,检测装置含杂率检测最大值为1.49%,最小值为0.21%,均值为0.74%;破碎率最大值为7.42%,最小值为1.51%,均值为3.62%。人工检测含杂率最大值为0.83%,最小值为0.45%,均值为0.64%;破碎率最大值为4.25%,最小值为2.55%,均值为3.44%。试验结果表明,使用本文研究的检测装置检测结果与人工检测结果的破碎率均值绝对误差为0.18个百分点,含杂率均值绝对误差为0.10个百分点,该大豆机收在线破碎率含杂率检测方法能够顺利完成联合收获机作业时大豆破碎率含杂率的在线检测。

图14 田间试验图像识别与分类结果

表4 田间试验大豆破碎率和含杂率统计结果

4 讨 论

基于改进U-Net网络的机收大豆质量在线检测是通过识别大豆样本图像中完整籽粒、破碎籽粒和杂质的像素信息计算实时的含杂率和破碎率。在图像成分信息识别阶段,改进U-Net网络输入图像尺寸过大,易造成网络的计算量大、系统硬件配置要求高、时效性差等问题。因此,本研究将1 280像素×1 024像素的原始图像下采样为512像素×512像素的改进U-Net网络输入图像,在保证图像语义信息满足网络训练、预测精度要求的前提下,有效的减少模型的计算量,提升网络的时效性。同时,改进U-Net网络是一个对称的网络,其输出是512像素× 512像素的图像。在样本含杂率和破碎率计算阶段,图像的像素信息越丰富,系统检测结果的准确性越高。因此,本研究将改进U-Net网络512像素×512像素的输出图像上采样为1 280像素×1 024像素,这样一方面可以保证样本含杂率和破碎率计算模型输入图像信息与原始图像信息的一致性,另一方面可以增加图像信息量,减少由于统计像素不足引起的检测误差。

U-Net作为一种语义分割的经典网络,在医学、农业等领域图像识别取得了巨大成功。陈进等[22]通过每次反卷积操作之后引入2×2卷积核增加U-Net网络深度并加入BN层,在小数据集上获得更丰富的语义信息,解决图像训练数据匮乏和训练过拟合问题,实现了水稻籽粒、茎秆和枝梗的识别。有别于上述研究,本研究针对机收大豆样本图像识别的要求,改进了U-Net网络。首先,以512像素×512像素图像作为网络的输入图像,保留充足的图像信息,同时有效地提升网络运行效率。其次,在U-Net网络编码部分,引入了VGG16主干特征网络提取网络,有效地提升了网络分类和定位性能。再者,在U-Net网络解码部分,直接采用了2倍上采样替代2×2卷积上采样,使得网络具有更好的通用性。最后,在U-Net网络特征融合部分,引进了基于空间注意力和通道注意力构造的卷积块注意力模块,有效的减少冗余信息,提升网络的适应性。试验表明,本研究改进的U-Net网络能够有效的实现大豆图像中各成分的精准识别分类。

基于改进U-Net网络的机收大豆质量在线检测主要应用于大豆机械化收获作业过程,实现大豆机收破碎率和含杂率的在线检测。因此,实时性是衡量该检测方法性能优劣的指标之一。该检测方法主要包括3个部分内容图像获取、图像成分识别、破碎含杂率计算并显示。在大豆标准收获过程中,该检测方法获取一张有效图像的时间大约为1.7 s,其中控制直流舵机控制挡板伸缩更新采样槽内大豆样本需要1 s,控制工业相机拍照大约需要0.2 s;运行改进U-Net网络完成图像成分识别所需的时间为0.185 4 s;在图像成分识别的基础上,统计各成分所占的像素,并计算出含杂率和破碎率的时间为0.316 4 s;因此,本研究的含杂率和破碎率检测周期为2.201 8 s。当大豆收获机以1.5 m/s速度作业时,大豆收获每作业3.3 m得到一组破碎率和含杂率的检测数据,本研究设计的改进U-Net网络的大豆机收破碎率、含杂率在线检测方法基本能够满足大豆收获预警的需求。

5 结 论

1)提出一种基于改进U-Net网络的机收大豆质量在线检测,该方法分为图像采集与图像处理两部分,图像采集部分包含工业摄像头、电机、挡板、LED光源等能够实时采集大豆样本图像,图像处理部分通过改进U-Net网络能够快速准确的识别分类大豆图像中的破碎籽粒、完整籽粒、杂质,并计算出联合收获机作业时的实时破碎率、含杂率。

2)采用改进U-Net网络预测大豆图像中完整籽粒、破碎籽粒、杂质,完整籽粒的综合评价指标1为95.50 %,破碎籽粒的综合评价指标1为91.88 %,杂质的综合评价指标1为94.34 %,平均交并比MIOU为86.83 %。田间试验表明,本文检测装置的检测结果与人工检测结果的破碎率均值绝对误差为0.18个百分点,含杂率均值绝对误差为0.10个百分点,该方法能够顺利完成联合收获机作业时大豆籽粒破碎率和含杂率的在线检测。

[1] 刘东,齐婉冬,冯燕,等. 大豆主要农艺性状的遗传解析[J].大豆科学,2018,37(2):165-172.

Liu Dong, Qi Wandong, Feng Yan, et al. Characterization of the genetic basis of main agronomic traits in soybean[J]. Soybean Science, 2018, 37(2): 165-172. (in Chinese with English abstract)

[2] 刘基,金诚谦,梁苏宁,等. 大豆机械收获损失的研究现状[J]. 农机化研究,2017,39(7):1-9,15.

Liu Ji, Jin Chengqian, Liang Suning, et al. The research of soybean harvested by machine[J]. Journal of Agricultural Mechanization Research, 2017, 39(7): 1-9, 15. (in Chinese with English abstract)

[3] 乔金友,张晓丹,王奕娇,等. 规模化大豆产区大豆联合收获机综合评价与优选[J]. 东北农业大学学报报,2014,45(8):124-128.

Qiao Jinyou, Zhang Xiaodan, Wang Yijiao, et al. Evaluation and selection on soybean combines in large-scale planting area[J]. Journal of Northeast Agricultural University, 2014, 45(8): 124-128. (in Chinese with English abstract)

[4] 梁苏宁,沐森林,金诚谦,等. 黄淮海地区大豆生产机械化现状与发展趋势[J]. 农机化研究,2015,37(1):261-264,268.

Liang Suning, Mu Senlin, Jin Chengqian, et al. Actualities and developing trend of production mechanization of soybean in huanghuaihai region[J]. Journal of Agricultural Mechanization Research, 2015, 37(1): 261-264, 268. (in Chinese with English abstract)

[5] 金诚谦,郭飞扬,徐金山,等. 大豆联合收获机作业参数优化[J]. 农业工程学报,2019,35(13):10-22.

Jin Chengqian, Guo Feiyang, Xu Jinshan, et al. Optimization of working parameters of soybean combine harvester[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(13): 10-22. (in Chinese with English abstract)

[6] 李云红,张秋铭,周小计,等. 基于形态学及区域合并的分水岭图像分割算法[J]. 计算机工程与应用,2020,56(2):190-195.

Li Yunhong, Zhang Qiuming, Zhou Xiaoji, et al. Watershed image segmentation algorithm based on morphology and region merging[J]. Computer Engineering and Applications, 2020, 56(2): 190-195. (in Chinese with English abstract)

[7] Bieniecki W. Oversegmentation avoidance in watershed-based algorithms for color images[C]// Las Vegas: Modern Problems of Radio Engineering, Telecommunications & Computer Science, International Conference. IEEE, 2004: 169-172.

[8] Li B, Xu D, Lang C. Moment invariants for color constant image description[J]. Chinese Journal of Electronics, 2010, 19(2): 283-287.

[9] Malik F, Baharudin B. Features analysis for content-based image retrieval based on color moments[J]. Research Journal of Applied Sciences, Engineering and Technology, 2012, 4(9): 1215-1224.

[10] 李秀昊,马旭,李泽华,等. 基于特征融合和SVM的稻谷品种识别[J]. 中国农机化学报,2019,40(7):97-102.

Li Xiuhao, Ma Xu, Li Zehua, et al. Identification of rice variety based on multi-feature fusion and SVM[J]. Journal of Chinese Agricultural Mechanization, 2019, 40(7): 97-102. (in Chinese with English abstract)

[11] Wallays C, Missotten B, Baerdemaeker J D, et al. Hyperspectral waveband selection for on-line measurement of grain cleanness[J]. Biosystems Engineering, 2009, 104(1): 1-7.

[12] Mahirah J, Yamamoto K, Miyamoto M, et al. Double lighting machine vision system to monitor harvested paddy grain quality during head-feeding combine harvester operation[J]. Machines, 2015(3): 352-363.

[13] 张新伟,易克传,刘向东,等. 玉米自动化考种过程的粘连籽粒图像分割[J]. 中国农业大学学报,2018,23(10):144-151.

Zhang Xinwei, Yi Kechuan, Liu Xiangdong, et al. Image segmentation of adhesive corn seeds during automatic seed test[J]. Journal of China Agricultural University, 2018, 23(10): 144-151. (in Chinese with English abstract)

[14] 杨蜀秦,宁纪锋,何东健. 基于Harris算子的籽粒尖端识别方法[J]. 农业机械学报,2011,42(3):166-169.

Yang Shuqin, Ning Jifeng, He Dongjian, et al. Identification of tipcap of agricultural kernel based on Harris algorithm[J]. Transactions of the Chinese Society for Agricultural Machinery, 2011, 42(3): 166-169. (in Chinese with English abstract)

[15] 陈满,倪有亮,金诚谦,等. 基于机器视觉的大豆机械化收获质量在线监测方法[J]. 农业机械学报,2021,52(1):91-98.

Chen Man, Ni Youliang, Jin Chengqian, et al. Online monitoring method of mechanized soybean harvest quality based on machine vision[J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 52(1): 91-98. (in Chinese with English abstract)

[16] 柴玉华,孙玮磷. 基于小波矩的大豆外观品质特征提取方法的研究[J]. 大豆科学,2016,35(4):679-682.

Chai Yuhua, Sun Weilin. Study on the method of extracting the appearance quality of soybean based on wavelet moment[J]. Soybean Science, 2016, 35(4): 679-682. (in Chinese with English abstract)

[17] 陈璇. 联合收获机谷物破碎率_含杂率监测方法及系统研究[D]. 镇江:江苏大学,2017.

Chen Xuan. Research on the Methods and Systems for Monitoring Grain’s Crushing Rate and Impurity Rate for Combine Harvester[D]. Zhenjiang: Jiangsu University, 2017. (in Chinese with English abstract)

[18] Momin M A, Yamamoto K, Miyamoto M, et al. Machine vision based soybean quality evaluation[J]. Computers and Electronics in Agriculture, 2017, 140(2): 452-460.

[19] 陈进,顾琰,练毅,等. 基于机器视觉的水稻杂质及破碎籽粒在线识别方法[J]. 农业工程学报,2018,34(13):187-194.

Chen Jin, Gu Yan, Lian Yi, et al. Online recognition method of impurities and broken paddy grains based on machine vision[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(13): 187-194. (in Chinese with English abstract)

[20] 韩梦娜. 基于U-Net网络的联合收获机籽粒含杂率、破碎率监测方法[D]. 镇江:江苏大学,2020.

Han Mengna. Monitoring Method for Grain Impurity Rate and Broken Rate of Combine Harvester Based on U-Net[D]. Zhenjiang: Jiangsu University, 2020. (in Chinese with English abstract)

[21] 陈进,练毅,李耀明,等. 联合收获机粮箱内稻谷含杂率传感器采样盒设计[J]. 农业工程学报,2019,35(5):18-25.

Chen Jin, Lian Yi, Li Yaoming, et al. Design of sampling device for rice grain impurity sensor in grain-bin of combine harvester[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(5): 18-25. (in English with Chinese abstract)

[22] 陈进,韩梦娜,练毅,等. 基于 U-Net模型的含杂水稻籽粒图像分割[J]. 农业工程学报,2020,36(10):174-180.

Chen Jin, Han Mengna, Lian Yi, et al. Segmentation of impurity rice grain images based on U-Net model[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(10): 174-180. (in Chinese with English abstract)

[23] Long J, Shelhamer E, Darrell T, et al. Fully convolutional networks for semantic segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 39(4), 640 – 651.

[24] Ronneberger O, Fischer P, Brox T. U-Net: convolutional networks for biomedical image segmentation[C]// The 18th International Conference on Medical Image Computing and Computer Assisted Interventions, MICCAI, 2015: 1505.

[25] 殷宁波,黄冕,刘利军,等. MS-UNet++:基于改进UNet++的视网膜血管分割[J]. 光电子·激光,2021,32(1):35-41.

Yin Ningbo, Huang Mian, Liu Lijun, et al. MS-UNet++: Retinal vessel segmentation method based on improved UNet++[J]. Journal of Optoelectronics Laser, 2021, 32(1): 35-41. (in Chinese with English abstract)

[26] 杨丽丽,陈炎,田伟泽,等. 田间道路改进UNet分割方法[J]. 农业工程学报,2021,37(9):185-191.

Yang Lili, Chen Yan, Tian Weize, et al. Field road segmentation method based on improved UNet[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(9): 185-191. (in Chinese with English abstract)

[27] 王艳,沈晓宇,丁文胜,等. 基于PCNN和遗传算法相结合的新型混凝土桥梁裂缝测方法[J]. 计算机应用研究,2017,34(10):3197-3200.

Wang Yan, Shen Xiaoyu, DingWensheng, et al. New crack detection method of concrete bridge based on PCNN and genetic algorithm[J]. Application Research of Computers, 2017, 34(10): 3197-3200. (in Chinese with English abstract)

[28] 赵静,曹佃龙,兰玉彬,等. 基于FCN的无人机玉米遥感图像垄中心线提取[J]. 农业工程学报,2021,37(9):72-80.

Zhao Jing, Cao Dianlong, Lan Yubin, et al. Extraction of maize field ridge centerline based on FCN with UAV remote sensing images[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(9): 72-80. (in Chinese with English abstract)

[29] Odena A, Dumoulin V, Olah C. Deconvolution and Checkerboard Artifacts[J]. Distill, 2016, 1(10): 1-9.

[30] 孟庆宽,杨晓霞,张漫,等. 基于语义分割的非结构化田间道路场景识别[J]. 农业工程学报,2021,37(22):152-160.

Meng Qingkuan, Yang Xiaoxia, Zhang Man, et al. Recognition of unstructured field road scene based on semantic segmentation model[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(22): 152-160. (in Chinese with English abstract)

[31] 王璨,武新慧,张燕青,等. 基于双注意力语义分割网络的田间苗期玉米识别与分割[J]. 农业工程学报,2021,37(9):211-221.

Wang Can, Wu Xinhui, Zhang Yanqing, et al. Recognition and segmentation of maize seedlings in field based on dual attention semantic segmentation network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(9): 211-221. (in Chinese with English abstract)

Online quality detection of machine-harvested soybean based on improved U-Net network

Jin Chengqian1, Liu Shikun1,2, Chen Man1, Yang Tengxiang1, Xu Jinshan1

(1.,,,210014,;2.,,,230036,)

Soybean is one of the most important oil crops in the national grain and oil security system. Mechanized harvesting can be the top priority to improve the level of soybean production. Among them, the crushing rate and impurity rate of soybean seeds are the important performance indexes to evaluate the soybean combine harvesters. The real-time data of crushing rate and impurity rate can greatly contribute to realizing the intelligent control of soybean combine harvesters. However, the current manual detection of soybean cannot fully meet the requirement in the process of combined harvester operation. Particularly, the manual operation was only made after shutdown, due to the high misjudgment rate and low efficiency. This study aims to realize the online detection of soybean grain for the crushing rate and impurity rate during mechanical harvesting of soybean using an improved U-net network. Taking the real-time soybean image harvested by a soybean combine harvester as the object, the open source annotation software Labemel was used to annotate and construct the basic data set. The U-net network structure was combined with the VGG16 network, Batch Normalization (BN) before each Rectified Linear Unit (ReLu). The overfitting was avoided, due to the soybean image adhesion, stacking and complex semantic information. The convolution block attention module (CBAM) was added to the feature map extracted from the encoder, in order to suppress the activation of the irrelevant region for the less redundant part. The up-sampling of the nearest neighbor interpolation was used to replace the decoder with the transpose convolution, where the checkerboard effect was caused by the transpose convolution. A comparative test was carried out to evaluate the prediction of the improved U-Net network. The precision, recalland average cross-ratioMIOUwere used as the evaluation indexes of image segmentation, and the comprehensive evaluation index1was used as the evaluation value of accuracy and recall rate. The experimental results show that the improved U-Net network effectively identified and classified the complete soybean grain, broken grain, and impurities in the image. The comprehensive evaluation index values of complete, broken grain, and impurity segmentation were 95.50%, 91.88%, and 94.34%, respectively. The average intersection and MIOU were 86.83%. Correspondingly, the grain and impurity quality in the sample were determined by the impurity rate in the existing quality detection of soybean combine harvester. The crushing rate was also the ratio of broken and intact grain quality in the sample. A quantitative model was established for the broken rate and impurity rate using pixels, according to the existing measurement. Bench and field experiments were carried out using the online detection device for the soybean grain crushing rate and impurity rate. The bench test results show that the mean absolute errors were 0.13 and 0.25 percentage points for the fragmentation and impurity rate between the test and the manual, respectively. The field experiment showed that the mean absolute errors were 0.18 and 0.10 percentage points for the fragmentation and impurity rate between the test and the manual, respectively. Therefore, the proposed detection can be expected to accurately online estimate the crushing rate and impurity rate of mechanically harvested soybean. The finding can provide technical support for the online detection of the quality of soybean combined harvesting.

combine harvester; image segmentation; soybean; U-Net network; recognition and classification; broken rate; impurity rate

10.11975/j.issn.1002-6819.2022.16.008

S147.2

A

1002-6819(2022)-16-0070-11

金诚谦,刘士坤,陈满,等. 采用改进U-Net网络的机收大豆质量在线检测[J]. 农业工程学报,2022,38(16):70-80.doi:10.11975/j.issn.1002-6819.2022.16.008 http://www.tcsae.org

Jin Chengqian, Liu Shikun, Chen Man, et al. Online quality detection of machine-harvested soybean based on improved U-Net network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(16): 70-80. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2022.16.008 http://www.tcsae.org

2022-04-07

2022-08-11

国家重点研发计划项目(2021YFD2000503);国家自然科学基金(32171911);江苏省自然科学基金(BK20221188);现代农业产业技术体系建设专项资金项目(CARS-04-PS26)

金诚谦,博士,研究员,博士生导师,研究方向为农业机械智能化技术。Email:412114402@qq.com