大学教师发展评估的内容与策略

——美国南达科他大学的启示

毕国涛 丁 凯

(1.中共中国海洋石油集团有限公司党校,北京 102209;2.中国人民大学 国家发展与战略研究院,北京 100872)

大学教师发展(Faculty Development, 简称FD)被视为是提高高等教育质量的有效举措。在针对FD的研究中,关于实施效果的关注较为匮乏。FD在多大程度上提升了教师表现、哪些项目有效以及教师对FD的评价如何等基本问题并未得到明确的回答。这在很大程度上阻碍了FD的深入实践和普遍推广。“大学教师发展需要提供有力的证据证明自己的价值和作用,以表明投资于此的努力具有丰厚的回报”[1]。这就需要调查和评价FD的过程与效果,即实施有效的大学教师发展评估(Faculty Development Evaluation, 简称FDE)。从国内情况来看,当下FD的主要目标是增加项目种类、扩大参与规模,而对项目效果的关注及相应的改进并不是重点,甚至根本未曾执行任何评估。反观国际经验,大学教师发展中心普遍重视FDE,不断调整评估模式,且将其视为革新和优化FD的关键机制。因此,非常有必要对FDE进行专门研究,从理论和实践角度构建FDE的有效框架。由此,首先从分析FD的基本属性入手,论证实施FDE的必要性依据;进而推导和总结FDE的主要内容构成;在结合案例分析基础上,归纳实施FDE的有效经验。

一、实施大学教师发展评估的必要性

FD具有管理、服务、学术和实践等四种基本属性,每一种属性都对评估提出了相应的要求,可以说,实施FDE是FD属性的本质要求。

第一,FD的管理属性决定必须实施FDE。FD已经成为高校体制机制的重要组成部分,高校普遍设有FD专门机构和FD专项经费;在FD视野下,教师在职业领域的发展不再仅是教师的个人事务,而是高校应对竞争与达成使命的重要措施。FD需要通过评估,向校方回馈资源使用的结果和效率,FD对学校问题的呼应和解决程度等信息,与此同时,扩大组织影响,争取更多组织资源。

第二,FD的服务属性决定了必须实施FDE。大学教师的职业属性决定了有效的FD不是强制灌输,而是提供具有辅助性、针对性的专业化服务。FD需要通过评估收集参与教师的体验,了解教师参与前后的变化,以及探寻和满足教师的多样需求。与此同时,评估本身也是“顾客导向”的服务属性体现。

第三,FD的学术属性决定了必须实施FDE。FD已经成为涵盖教育学、心理学、社会学和管理学等在内的综合性研究领域。有效FD项目的开发、实施和改进FD愈发依赖学术和理论支撑。FD需要通过评估,收集可靠数据,探寻教师的变化,研究FD干预同教师变化间的相关关系,而FD研究成果的发表,也可扩大学术共同体的关注。

第四,FD的实践属性决定了必须实施FDE。高校在类型、规模、目标等方面的多样性,教师在专业、职级和需求方面的差异性,决定了FD并无统一模式,而是依据具体情形进行灵活调整。FD需要进行评估,研判项目是否以及在多大程度上匹配组织的资源条件和使命目标,解决组织与教师的现实问题,满足各级各类教师的差异性需求等。

二、大学教师发展评估的主要内容

FD基本属性在很大程度上决定了FDE的主要内容。例如,管理属性下FDE关注资金使用的规模和效率、项目规划和实施情况、参与的规模和频率等;服务属性下FDE关注FD参与者需求的满足程度,对项目的感受和评价等;学术属性下关注施加FD作用后教师和组织发生的变化,以及其中的相关性;实践属性下关注项目在满足现实需求和解决实际问题方面的匹配性等。本节在此基础上结合相关研究,总结五种FDE的主要内容(见表1)。

(一)满意度

满意度评估关注参与者对项目的评价,关注其对自身需求被满足程度的感受。满意度评估既可以是对项目整体的评价,也可以是针对内容、形式和过程等方面的评价。在方法上,主要使用以李克特量表(Likert Scale)为代表的多级量表进行打分;除了调查问卷以外,部分评估还会通过访谈的形式,询问教师对项目的感受。在数据来源上,满意度评估所采用的数据带有强烈的主观性,但也有部分评估采用参与率和再次参与率等客观数据进行相关的佐证。满意度评估多在项目结束后进行,不同项目间的满意度得分可以进行横向比较,从而为FD项目的选择和评价提供依据。满意度评估适用面广,操作相对简易,是最为常见的FDE内容[2]。

(二)产出(output)

产出评估主要回答“做了什么”这一问题,关注FD以何种方式开展以及实施FD后产生的直接后果,具体包括资金的配置和使用、项目内容和种类、教师参与的规模和频率等。产出评估的主要目的在于反馈FD对资源的使用,为FD政策的调整提供依据。在方法上,主要使用文本分析法,搜集和整理项目实施方案、参与人数统计、阶段执行报告、财务报告、终期报告等文本中的相关信息。这些记录项目实施的文本是产出评估的主要信息来源,所以产出评估主要在项目结束后实施。

(三)成果(outcome)

成果评估主要回答“有何改变”这一问题,关注FD最终结果和深远影响,在探究实施FD后,教师、学生、管理者、组织制度和组织文化等在多个维度发生了何种切实的改变。成果评估在证明FD有效性方面最具说服力。成果的表现形式较为复杂,测量相对困难,受具体情境和个体差异影响较大,所以成果评估在方法选择上较为多样,通常使用多种评估方法综合性的描述FD成果,且定性评估更适用于探寻教师发生的深层次变化。从施加FD影响到发生变化通常具有一定的迟滞性,所以成果评估需要增加评估的次数,实践中的有效措施是在FD项目结束一段时间再次进行评估,有条件的高校还可以采用跟踪评估和对照组评估。

(四)效率

效率评估主要回答“哪个项目更划算”这一问题,是基于成本收益的考虑对项目“生产率”的关注。对项目产出和成果有了较为准确的把握后,衡量FD项目的效率成为可能。效率评估可以划分为:针对教师的效率评估,多采用定性评估,直接询问教师哪些项目对其而言在达成特定目标上更有效率;针对项目的效率评估,多将项目收益赋予一定货币价值,对比投入项目的资金、时间和其他成本,获得项目的“投资回报率”。效率评估不仅依赖其他评估的结果,还需要参与者和评估者对项目进行较为完善的审视,所以通常是在项目结束后进行。

(五)适用性

适用性评估关注两个方面内容:一是FD对教师的适用性,包括FD是否满足教师需求、解决教师困难、匹配教师的兴趣与能力等;二是FD对组织的适用性,包括FD在设计和实施过程中是否匹配组织资源条件、直面组织发展挑战、呼应组织使命目标等。适用性评估的结果通常超越了是或否的二元选择,而可视为对FD的总结性评价。一方面对数据信息的全面性要求较高,需要采用多种评估方式,使用包括前述四种内容在内的多种信息进行佐证;另一方面,要求评估者对组织的现状和使命、师资建设的挑战和目标等有较为深刻的把握,在实践中主要采用访谈法,获取高层管理者和相关专家的意见。

三、南达科他大学实施大学教师发展评估的经验

FDE既符合高等教育评估的普遍规律,也具有一定特殊性。在明确FDE的主要内容后,如何进行具体操作成为下一个问题。美国在20世纪70年代掀起大学教师发展运动,早在那时便已开始探索对大学教师发展进行评估[3]。近年来,南达科他大学(University of South Dakota)的教学和学习中心(Center for Teaching and Learning, 简称CTL)实施并逐步完善了本校的FDE框架,积累了较为丰富的实践经验。本节以该中心为例,并结合前文探讨实施FDE的经验。

(一)以产出评估为主的阶段

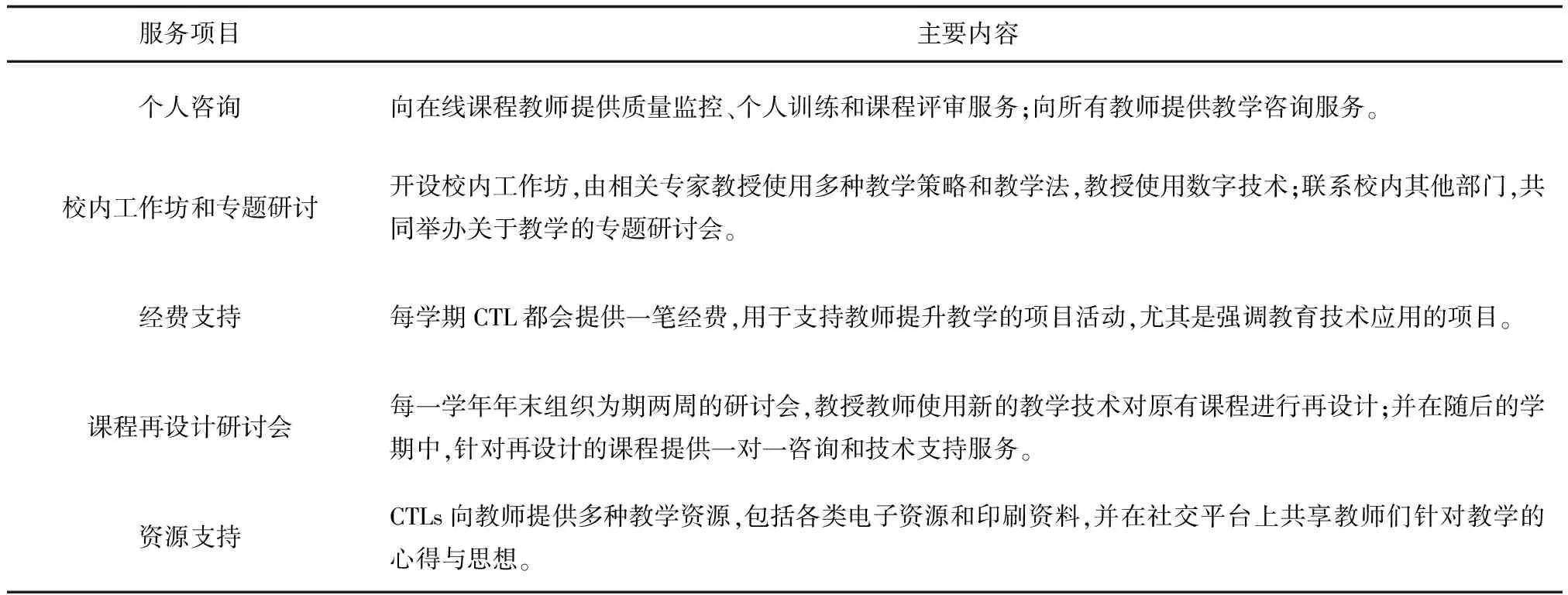

CTL面向教师提供个人咨询、校内工作坊和专题研讨、经费支持、课程再设计研讨会和资源支持等五种主要的服务项目;尤其强调通过教育技术来提升教师教学水平和学生学习成绩(见表1)。

表1 CTL主要大学教师发展项目类型和内容

CTL在成立初期便针对其开设的FD项目实施评估。早期的评估在形式上体现为年度报告,CTL主管会在报告中详细列举本年度中心开展FD项目的种类和内容、各项目的参与规模、参与人员对项目的满意度情况等。年度报告除了用于回馈学校管理层和进行宣传以外,还是CTL制订下一年工作计划的重要参考。CTL会将本年度数据同上年进行比较,如果出现某类项目参与人数下降、满意度下降等问题时,该类项目明年就有可能被裁撤。

可见,CTL采用的是一种以产出评估为主的评估形式(Output-Based Evaluation),以项目开展情况、参与情况和满意度为主要内容。该评估模式有利于掌握CTL项目的实施情况,初步形成了评估体系,但CTL逐渐发现,这种评估模式并不能提供FD是否有效的充分证据,未能反映项目实施的完整信息,也不利于FD的优化改进。于是自2010年起,CTL开始关注FD对教师产生的影响,关注教师参与FD后在态度、行为等方面发生的变化,并着手开发相应的评估框架。

(二)以成果评估为主的阶段

CTL对原有评估模式进行了两个方面的改进:第一,明确各FD项目的目标,将其细化为若干可度量、可实现的子目标,并用这些目标指引FDE的规划和实施;第二,引入“教学发展和有效性评估模型”(Instructional Development and Effectiveness Assessment, IDEA)①,将其作为主要的评估工具。在此基础上,CTL针对每一项目开发了基于成果的评估框架(Outcome-Based Evaluation)。此处以个人咨询和校内工作坊为例进行具体说明(见表2)。

表2 个人咨询和校内工作坊的评估框架

1. 个人咨询。CTL将该项目的目标确定为“教师在参与个人咨询项目后,会在参与咨询的学期或下一学期,表现出教学上的进步”。以此目标为指引,CTL确立了评估框架设计的两个重点:第一,教学上的进步不是单一维度的改变,需要从多个角度进行综合衡量,评估需要为此提供充足的数据支持;第二,从参与FD到教学水平的提升通常需要一段时间,评估需要延长测评区间,以确保教学提升的证据得以体现以及衡量教学提升的持续性。

依据目标和评估重点,CTL确立了具体的评估方法:首先,使用IDEA的四个评估模块,即“教学目标的改进”“杰出的教学者”“杰出的课程”“对教学的总体感受”,从多个评估角度进行打分,衡量教学和教师发生的变化;其次,将评估期间延长至四个学期,连续观测教师在教学方面发生的变化。根据上述评估框架,教师在四个评估模块上的得分,在连续的四个学期中呈现出增长的趋势,较为充分地证明了个人咨询项目的有效性。

2. 校内工作坊。CTL确立了该项目的两个目标:第一,参与教师会更加充分利用教育技术来促进学生的学习;第二,参与教师明确表示工作坊能够帮助其提升教学,并肯定工作坊的有效性。以此目标为指引,第一个目标的评估重点在于衡量行为的变化,即评估教学行为发生的具体改变;第二个目标的评估重点在于衡量项目对教师产生的积极影响。

针对行为的评估,CTL采用IEDA指标中的“教师使用教育技术来促进学习”模块对所有教师进行评估,并依据参与FD项目的次数将教师进行分组比较。针对影响的评估,CTL一方面通过李克特五级量表,调查参与教师对工作坊有效性的评价;另一方面,通过电话访谈,不仅询问教师在多大程度上愿意尝试在工作坊中学到的知识技能,还询问教师因为参与工作坊,在教学中发生了哪些具体的、可辨识的改变。

根据上述评估框架,CTL发现参与工作坊的教师与不参与的教师相比,在使用教育技术促进学生学习方面的得分明显要高,且参与工作坊的次数与得分之间成正比。在有效性评价方面,参与访谈的教师能够明确表达自己因为参与工作坊,在教学中发生的若干具体的变化。这与调查问卷的结果相一致,定量评估和定性评估共同证明了工作坊的有效性。

在不断完善基于成果的评估的同时,CTL下一步的目标是实现“基于过程的评估(Process-Based Evaluation)”,即在“基于设计的研究(Design-Based Research)”理念指导下,在实践情境中通过迭代循环与过程研究,完善相关理论、作用机制和实践操作,最终促进FD取得更好效果。

四、对中国实施大学教师发展评估的启示

提升大学教师发展组织建设的科学化,需要加强对组织绩效的问责,对资源投入及使用情况展开定期的评估[4]。从CTL的案例可见,评估框架需要不断革新,有效的FDE需要突破以产出和满意度评估为主的初级阶段,向以成果评估为主的综合性、系统性和科学性的评估模式发展。中国的FDE工作尚处于起步阶段,理论研究和实践探索均较为薄弱,CTL的经验为中国FDE今后的发展提供了有益的借鉴。

(一)提升大学教师发展评估的地位

大学教师发展中心成立初期通常采用扩大项目规模和参与规模,增加各类资源投入的“粗放式发展”方式,对FDE的认知水平和重视程度均较低。随着FD工作的深入,提高FD实施质量和效率成为新的目标。FDE在其中发挥了不可替代的作用:FDE是优化和改进现有项目的重要方法,是扩大学术影响力、吸引更多学者关注FD的有效途径,也是FD向“集约式发展”转变的根本路径。因此,必须重视FDE的关键作用,提升FDE的地位。具体表现为“在FD的规划中增加评估环节,在施行FDE时不断提高其科学性和严谨性,将FDE的结果作为制定和修改现有政策的重要依据,增强针对FDE的专项研究”等。

(二)以目标为指引规划和实施评估

FD在多大程度上达成预期目标是FDE需要回答的重要问题。很多评估并不以FD目标为导向,反而用尽可能详细的信息描述项目过程和产出,这既导致了评估在内容和方法选择上的混乱,也降低了评估结果的解释力。CTL对原有评估模式进行改进的第一步,就是确立、审视和细化FD的目标,并以此为导向开展评估活动。FDE的规划和实施应当以FD的目标为指引,具体表现在:第一,审视和细化FD目标,并将其转化为若干可实现、可度量的分目标;第二,明确完成各个目标的具体标准和时间期限;第三,依据目标确定评估的内容、方法和工具;第四,对比FD目标展现FDE结果。

(三)实行以成果评估为主的综合性评估

仅描述FD以何种方式实施并不能证明其效用,对参与教师喜好态度的反馈并不能表明FD所带来的转变,且“过于依赖教师的主观评价使数据存在偏见和夸大的风险”[5],因此,CTL才致力于开发基于成果评估的框架。有效的FDE应当一方面坚持以成果评估为主,探寻FD作用下高校组织、高校教学和高校教师等发生的改变,发掘FD的内在作用规律;另一方面,坚持综合性的评估模式,将多种评估内容有机结合起来。例如,以满意度评估和部分产出评估来佐证成果评估;在产出和成果评估后,进一步利用已有数据实施效率评估;从满意度、成果和效率等角度综合评估FD对组织的适用性等。

(四)提升大学教师发展评估的系统性和科学性

系统性要求FDE各要素通过合理的作用方式,共同构成一个有机的评估整体。具体包括:合理规划评估方案,明确评估的目标、重点和标准;关注评估内容之间、评估方法之间以及内容与方法之间的相互作用;形成性和总结性评估有机结合等。科学性要求FDE符合规范,采用专业化和学术化的评估方法,提升评估的解释力。具体包括:依据目标选择合理评估方法;定性与定量评估相结合,多种评估方法相结合;延长评估区间和增加评估频率;采用对照组评估;关注教师群体内部差异性等。

注释:

① IDEA模型由堪萨斯州立大学于1968年开发,1975年成立了独立的IDEA中心。IDEA由若干模块构成,以学生打分为主要方式。参见:Dan Li, Stephen L. Benton, etc. Analysis of IDEA Student Ratings of Instruction System 2015 Pilot Data (IDEA Technical Report No. 19). https://www.ideaedu.org/Portals/0/Uploads/Documents/Technical-Reports/IDEA_Technical_Report_No_19.pdf。