旋转区域提议网络的孪生神经网络跟踪算法

姜文涛,崔江磊

1.辽宁工程技术大学 软件学院,辽宁 葫芦岛 125105

2.辽宁工程技术大学 研究生院,辽宁 葫芦岛 125105

目标跟踪是计算机视觉领域内一项具有挑战性的任务,一般指通过运算设备在一段连续时间内的数字化图像或视频序列中,对单个或多个人为预设且具有明显语义特征的数字图像目标连续地进行位置检测。目前这项技术在自动驾驶[1-3]、智能监控[4]、手势识别[5-6]、军事侦查[7]以及智慧城市[8]等技术领域内均有重要应用。近年来,目标跟踪方向的发展迅速,技术迭代频繁,且融合了信号、深度学习等多个领域的相关方法[9-10]。但是,目标跟踪任务依然存在着诸如光照变化、目标遮挡、目标形变及旋转等一系列难点,如何在复杂情况下对目标进行稳定准确地跟踪仍是当前亟待解决的热点问题。

2016年以来,孪生神经网络以其优异的跟踪速度和较高的跟踪精度,获得了国内外研究人员的大量关注。全卷积孪生神经网络目标跟踪算法[11](SiamFC)首次将Siamese Net应用到目标跟踪领域,通过Siamese Like结构对模板与搜索区域进行相似度比较,在搜索区域中寻找目标的最大响应值,在速度和精准度上达到当年最优。受目标检测算法Faster-RCNN[12]的启发,高性能的孪生区域提议跟踪算法[13](SiamRPN)将区域提议网络(region proposal network,RPN)用于目标跟踪,先通过Siamese结构对模板区域与搜索区域进行特征提取,在两个区域的特征图进行互相关操作后,将相关特征图进行分组,分别进行分类和回归操作,最后根据两个分支做相似性度量,得到最终预测结果,该方法通过锚框对目标进行位置预测,省略掉图像金字塔的运算过程,在提高跟踪精度的同时,大大提高了跟踪速度。深度网络的孪生神经网络跟踪算法[14](SiamRPN++)将深层神经网络应用到孪生神经网络的目标跟踪中,对残差特征提取网络中多层特征进行融合,并在多个特征层分别使用SiamRPN方法,过滤掉简单样本,从而提升网络的判别能力,大大提高了网络的跟踪能力,但该方法受到RPN网络本身的限制,在物体发生旋转时,这种简单的预测框会产生较大的损失,导致跟踪网络对目标的覆盖效果不佳,跟踪性能下降。在线更新模型的孪生跟踪网络[15](Update Net)通过训练一个能够在线更新模型的孪生目标跟踪器,根据目标及当前状态之前的若干帧对被跟踪模型进行更新,提高了跟踪过程中的鲁棒性。同年,在线分割孪生神经网络跟踪方法[16](SiamMask)将目标分割的思想应用于目标跟踪中,在Siamese网络架构中额外增加Mask分支,在搜索区域中得到目标分割结果,通过最小外包矩形方法生成预测框。该方法虽然提高了预测精度,但由于Mask分支较为复杂,导致该网络的训练难度大,并且跟踪速度大幅下降,无法满足实时性。基于目标估计的高精度鲁棒性跟踪网络[17](SiamFC++)将目标物体与背景分离,对目标状态进行估计以得到更精确的预测框,同时引入分类得分分支,避免出现类似RPN假阳性样本,去除先验知识以提高泛化能力。RESiam Net[18]在跟踪之前对目标进行了8个方向的旋转,从而加强跟踪器对旋转目标的跟踪效果,但该方法对旋转的处理较为复杂,导致跟踪速度较慢,并且旋转样本较少,跟踪效果仍存在提高的空间。

上述方法都是通过平行于坐标轴的矩形预测框进行跟踪,但在实际跟踪过程中,这种预测框对目标的覆盖效果不佳,包含了过多的背景信息,导致跟踪效果下降。虽然Update Net通过不断对模板进行更新,SiamFC++对预测框进行质量检测,以削减跟踪时背景信息造成的影响,但由于平行坐标轴的矩形预测框在目标外观覆盖上存在根本性的缺陷,因此这些方法的效果仍存在很大的提升空间。针对上述问题,本文提出了一种基于孪生旋转区域提议神经网络的跟踪算法。(1)在骨干网络的不同阶段对目标位置进行预测,并进行融合,避免细节特征的丢失。(2)引入AO-RPN[19](arbitrary-oriented region proposal network)网络生成旋转锚框,增加对目标的覆盖率,抑制背景对目标产生的影响,提高目标旋转姿态的跟踪效果,充分挖掘覆盖精度上的信息。(3)根据跟踪任务对该网络进行有针对性的数据集处理,并对损失函数进行调整,将该网络有效引用在目标跟踪任务上。(4)采取多分支联合预测子网络对目标的最终位置进行判断,在提高跟踪器泛化能力的同时降低网络参数。在数据集OTB2015、VOT2016和VOT2018上评估本文算法,实验结果表明,与主流算法相比,本算法具有更好的跟踪效果,跟踪速度达到88.5 frame/s。

1 旋转区域提议孪生神经网络

1.1 旋转区域提议孪生神经网络框架

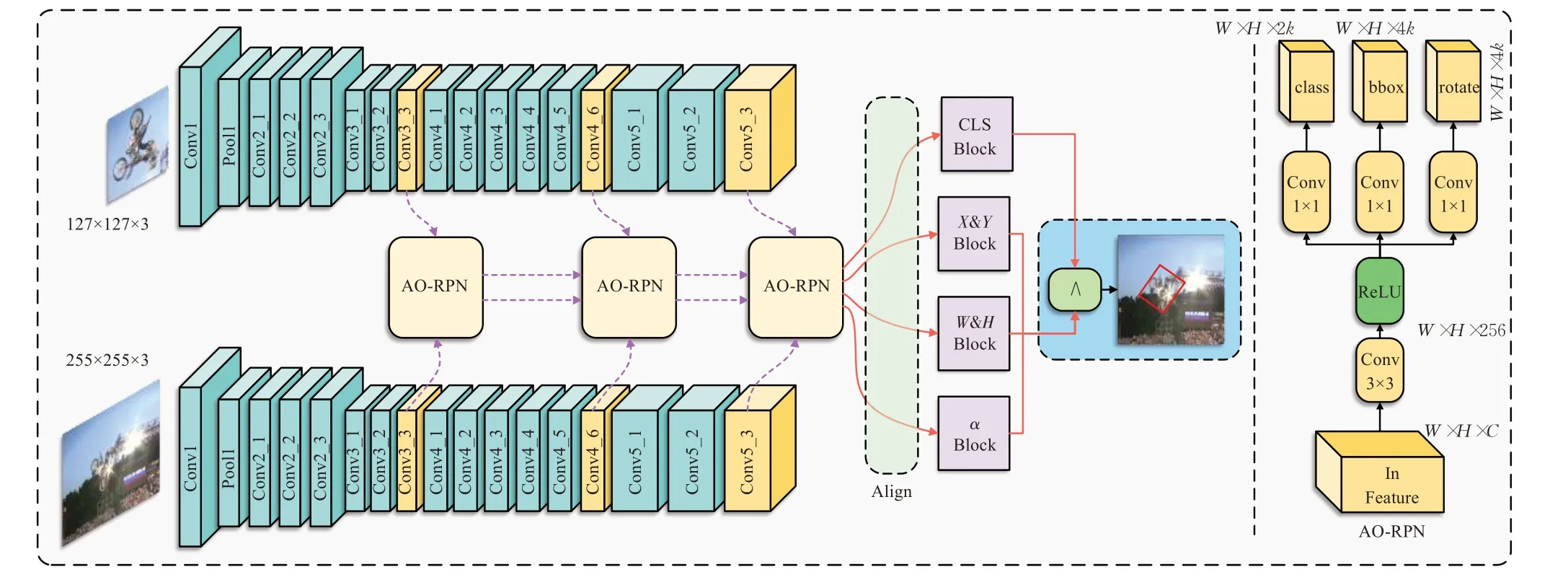

现有的目标跟踪算法通常使用浅层特征提取网络作为跟踪器骨干网络,对目标与搜索区域的特征提取能力较弱,本文将特征提取能力较强的ResNet-50作为本文方法的骨干网络,并将最后三个特征提取阶段的特征图输入进AO-RPN网络进行旋转区域提议,这种处理方式能够提取到更具有判别力的特征,并且能够保留特征提取中的部分细节,提高跟踪器在跟踪过程中的精确率。

同时,在目标旋转时,目标的深度特征将会产生一定变化,如果仅通过区域提议网络进行提议跟踪,则可能导致跟踪漂移,因此引入AO-RPN网络和旋转区域对齐操作将对待搜索区域进行旋转矫正,有效避免漂移产生,提高跟踪器在跟踪过程中的成功率。

最后,由于VOT2018等较新的数据集采用更符合人类直觉的最小外包矩形框对目标的位置进行标记,如果仅输出水平的外包矩形框将降低跟踪器在VOT2018等数据集中的性能,因此本文采用多分支联合预测网络对跟踪的最终结果进行预测,其中角度分支则参与预测目标最小外包矩形的旋转角度,从而有效提高跟踪过程中对目标的覆盖率。

因此,本文提出的旋转区域提议孪生神经网络结构如图1所示,将用于目标检测的任意方向区域提议网络(AO-RPN)与用于特征提取的残差孪生神经网络进行结合,同时在多个特征提取层使用AO-RPN网络进行提取,将候选区域融合后,通过Align操作对结果区域进行旋转对齐。最后通过分类预测分支、位置预测分支、尺寸预测分支和角度预测分支对目标位置进行预测,从而实现端到端的训练。

图1 旋转区域提议网络孪生神经网络图Fig.1 Siamese network tracing algorithm of rotating region proposal network

1.2 生成一阶区域提议锚框

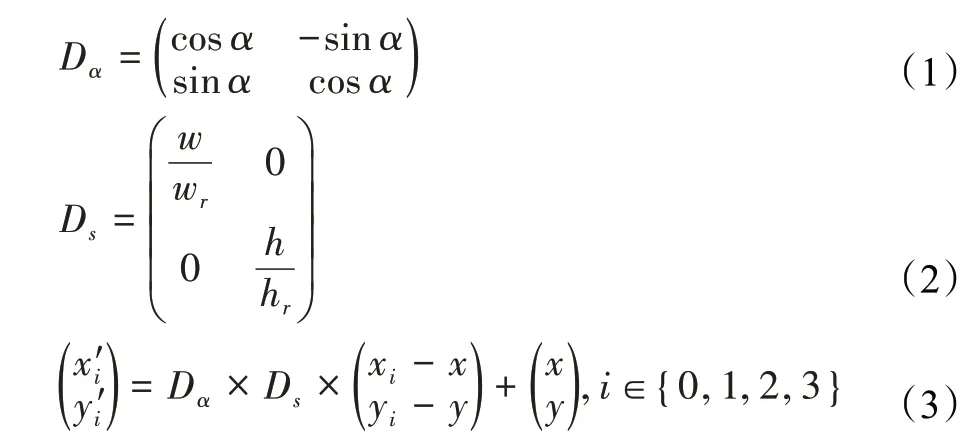

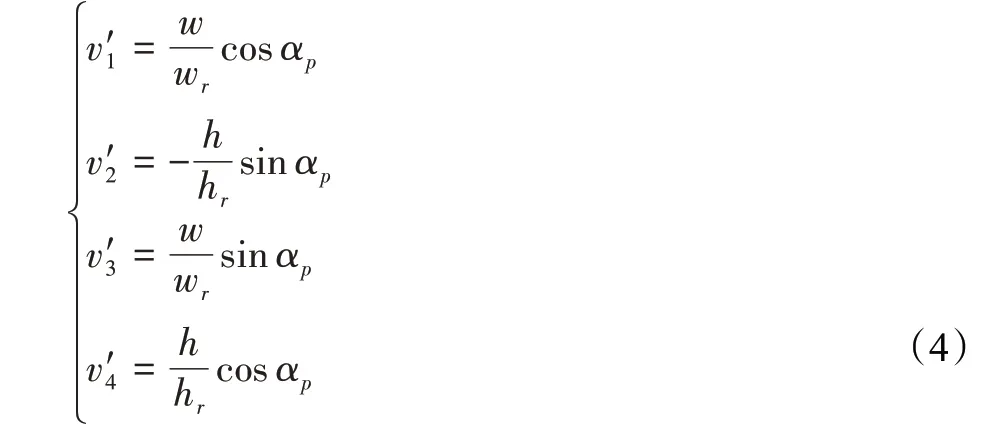

在特征提取网络上,本文将残差神经网络最后两个块的步长置为1,并增加空洞卷积,保证最后三个特征提取块输出的分辨率相同,以方便不同阶段提取特征的融合。传统的区域提议网络会生成一系列垂直于水平坐标轴的锚框,一般记为( x,y,w,h)以对目标位置进行标记。旋转区域提议孪生神经网络通过特征网络提取到特征后,通过AO-RPN网络目标进行区域提议,得到三个特征提议元组,其中class用以对正负样本进行区分,bbox和传统的锚框相同,包含( )x,y,w,h四个元素,分别代表旋转提议锚框的中心坐标和尺度。在旋转角度为α的情况下,由锚框和旋转分支得到的旋转区域表示为:

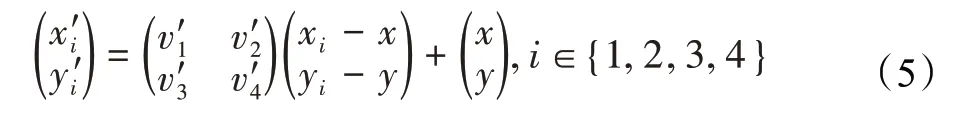

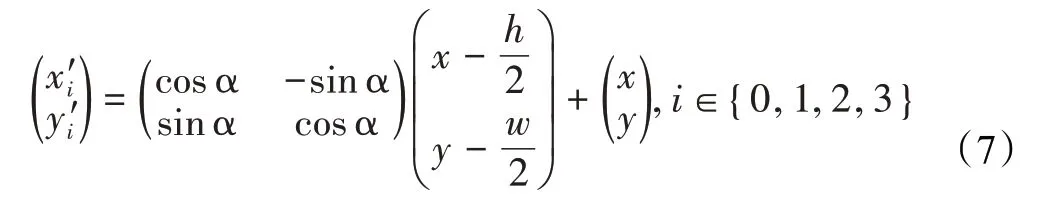

式中,(x,y)为水平锚框中心点坐标,w为旋转后锚框的宽度,h为旋转后锚框的高度,Dα为旋转锚框的旋转因子,Ds为旋转锚框的放缩因子,( )xi,yi,i∈{0,1,2,3}为bbox计算得到的四个顶点坐标,而( x'i,y'i),i∈{0,1,2,3}为旋转放缩处理后锚框的四个顶点坐标。而rotate为由4个旋转放缩因子( v'1,v'2,v'3,v'4)组成的元组,记为:

式(3)为旋转锚框的一般表示方法,式(4)为rotate分支产生的旋转放缩元组,将式(4)代入式(3)可以得到一阶旋转提议锚框的表示方法为:

1.3 特征图变换对齐融合

每个特征图通过AO-RPN网络后,可以得到1k数量一阶旋转提议锚框,由于本文算法从3个不同的特征提取层进行锚框预测,因此可以得到3k个锚框对应的特征区域。接下来需要将旋转锚框的映射在特征图上的特征矩阵通过Align操作,进行特征图和锚框的映射变换,将一个旋转锚框对应的特征矩阵转换成尺寸为W×H×C的特征图,以便在多分支联合预测子网络进行输入。

在多分支预测子网络中,输入特征的通道数C和特征提取网络提取的特征通道数保持一致,假设输入到多分支子网络的一个特称图的尺寸为W×H,没有经过映射变换的特征图记为Featureori,每个特征点对应的坐标为( xori,yori,cori),完成映射变换可以输入到多分支预测子网络的特征图记为Featurein,每个特征点对应的坐标记为( xin,yin,cin),可以得到映射变换公式:

由于在映射变换时,涉及到旋转和放缩处理,因此未被映射到的点通过高斯插值进行处理,经过映射变换后,可以得到3k个尺寸为W×H×C的特征图。Align层将对应特征提取网络特征,根据旋转锚框通过放缩变换进行对齐,将锚框对应特征图转化为与多分支预测网络输入结构相同的特征图。

1.4 多分支联合预测子网络跟踪预测

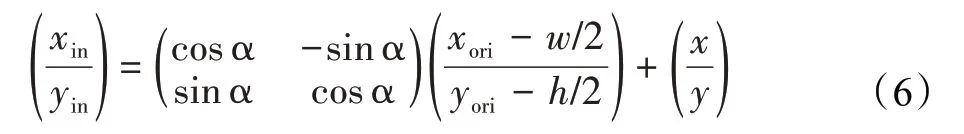

得到新的特征图集合后,对3k个特征图进行筛选后选择置信度高的512个特征图,将特征图集合作为Input输入到多分支预测网络即可得到预测结果。如图2所示,多分支预测网络可以被分为四个子网络,分别被用以预测分类情况、跟踪框中心坐标、跟踪框尺度和旋转角度。

图2 多分支预测头结构Fig.2 Multi-branch prediction head structure

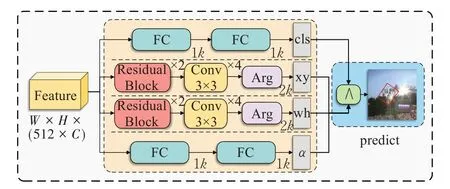

对于角度预测分支和分类分支,采用两个全连接层进行预测,对于中心目标和尺度则采用两个残差块、四个卷积层和均值池化层进行处理。先通过角度预测分支、中心点预测分支和尺度与预测分支对跟踪结果的最终位置进行预测,之后再通过分类分支对预测框进行筛选,并得到最终结果。如图3,残差神经块的结构由三个卷积层构成。

图3 残差神经网络块结构Fig.3 Residual network block structure

经过多分支预测结构后,可得到由一个五元组( x,y,w,h,α)构成的结果,再针对不同数据集对应的Benchmark,对输出结果进行调整,即可得到最终结果。

1.5 不同数据集上的跟踪结果变换

对于不同的数据集,由于数据集的目标和难度不同,结果的标注方式也有所差异,对于OTB2013、OTB2015、TC128、VOT2015~VOT2017等数据集,均采用( )

x,y,w,h

的结构对结果进行标记,而VOT从2018年之后,则采用最小外包矩形,通过给出矩形的4个顶点来对预测结果进行标记。

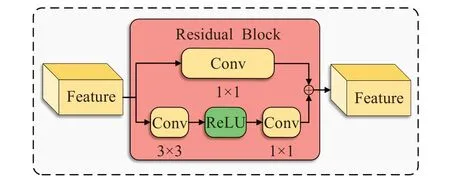

对于4顶点标记的最小覆盖矩形框的结果形式,在通过多分支预测网络得到( )x,y,w,h,α,可以得到旋转前的结果为

旋转后的结果矩形框记为( x'i,y'i),i∈{0,1,2,3},其中( x'i,y'i)的计算方式为:

对于( x,y,w,h)类型的标记结果,则需要在得到最小外包矩形后,将该矩形的水平外包矩形结果输出。

2 实验结果分析

2.1 实验环境及参数配置

本文算法使用Python3.7,深度学习框架PyTorch实现,实验环境为Ubuntu 16.08 LTS,处理器为Intel Core i9-9900,3.6 GHz,八核CPU,64 GB内存,显卡为NVIDIA Tesla V100 16 GB。本文使用GOT-10K、YoutubeBB、HRSC2016和ILSVRC-VID/DET数据集作为训练数据集。

本文算法使用SGD随机梯度下降法进行训练,其中设置权重衰减系数为4.5×1E-4,学习率以指数方式从1E-2衰减到1E-5,动量系数为0.92,输入模板尺度为127×127,搜索区域模板尺度为255×255,采集通道数为3。

2.2 评价标准

实验采用目标跟踪公开数据集OTB2015、VOT2016和VOT2018对本文提出的目标跟踪方法进行评估与分析,包括了光照变化、尺度放缩变化、遮挡、目标变形、出视野、低分辨率等11种不同类别的跟踪场景。采用一次通过评估的方式来计算跟踪器准确率和成功率,将准确率、成功率、鲁棒性、平均覆盖率以及跟踪速度作为跟踪器性能的评估依据,对比的基线算法为SiamRPN,并在围绕不同跟踪场景进行了性能分析,指标的计算方法如下。

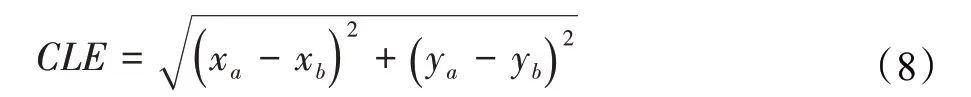

(1)跟踪精确率一般就是指中心位置误差(center location error,CLE),它是指预测的目标中心与真实的目标中心之间的欧式距离,其计算方法如公式(8)所示:

(2)跟踪成功率是用以判断跟踪器在整个视频序列中跟踪效果的衡量指标,一般当前帧的预测区域与真实区域的交并比指数超过0.5的时候,记为在当前帧下跟踪器跟踪成功。将一段视频序列中的成功帧数量记为M,该视频序列的总帧数记为N,则跟踪成功率的计算方法如公式(9)所示:

(3)跟踪鲁棒性是记录算法在相同视频序列下跟踪出现失败的次数的指标,在跟踪过程中,某一帧的精确率低于0.5时,认为算法跟踪失败。VOT官方定义视频的平均鲁棒性记为F()i,k,式中k为重复测量次数,可以得到视频的平均鲁棒性计算方法,如公式(10)所示:

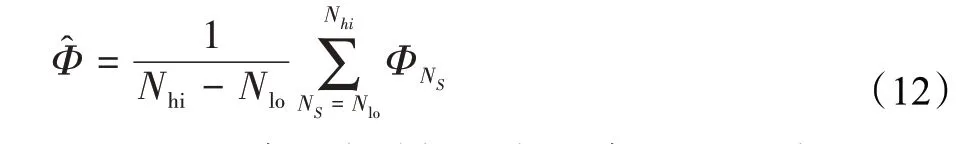

(4)平均覆盖率(expected average overlap,EAO)也是VOT竞赛中判定跟踪器跟踪性能的重要指标,定义视频序列中,第Ns帧的平均覆盖率为ΦNs,计算方法如公式(11)所示:

其中,Φi为预测框与真实框之间的精确率,一般随着视频帧数的增加,平均覆盖率也会有相应降低,因此Φi≤1,并可以计算得到EAO的表达式,如公式(12)所示:

(5)平均跟踪速度是算法在跟踪过程中,在不同视频序列中跟踪速度的平均值,设在第i个视频序列中的跟踪速度为Ρi,则该跟踪器的在数据集上的平均跟踪速度为:

2.3 消融实验

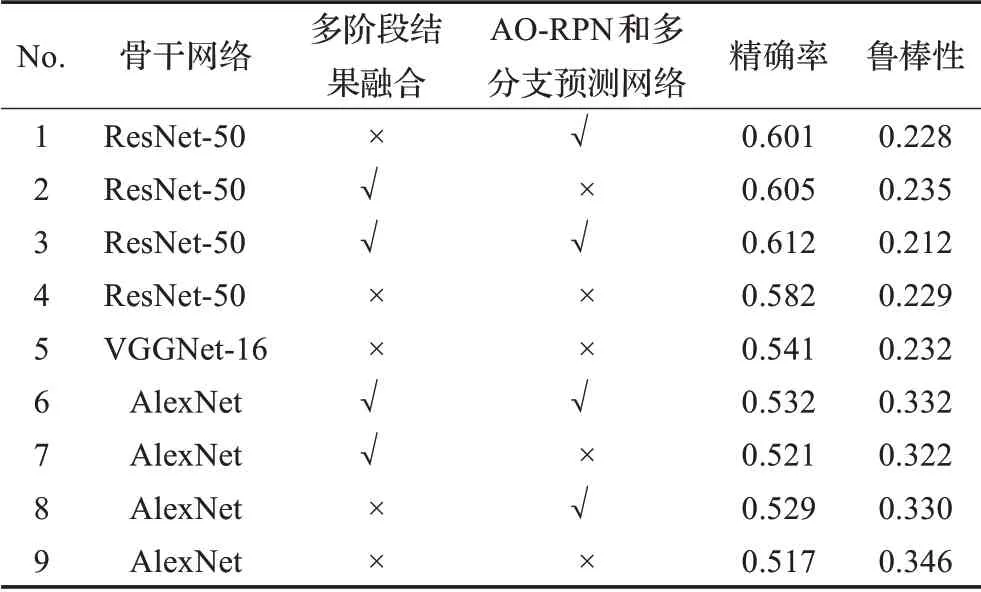

由于本文算法从特征提取网络、区域提议网络和特征融合三个角度对SiamRPN进行了改进,为了确定不同改进方法对跟踪性能的贡献,本文在VOT2018数据集上进行了消融实验。如表1所示,本文通过使用不同的特征提取网络,取消引入AO-RPN和多分支预测网络,取消在不同特征层之间进行特征融合共三个角度对跟踪模型进行了实验,结果显示对跟踪性能提升最明显的是引入AO-RPN和多分支预测网络,其次是使用深度特征提取网络和对多阶段的跟踪结果进行融合。在进行消融实验的过程中,由于SiamRPN的训练方法破坏了深层特征提取网络的平移不变性,学习到的特征会存在位置偏见。因此,本文算法在使用深层特征提取网络时,将正样本按照均匀分布的方法围绕中心点进行偏移,以缓解破坏平衡不变性对位置偏见产生的影响。

表1 消融实验结果Table 1 Results of ablation experiment

如表1所示,编号3为本文所提方法在VOT2018上的性能数据,引入了现代化特征提取网络、多阶段结果融合模块和AO-RPN与多分支预测网络。编号9为基线算法的性能数据,骨干网络为AlexNet,未引入多阶段结果融合模块和AO-RPN与多分支预测网络。

在表1中,将编号4、编号5和编号9的实验数据进行比较,可以发现不同的特征提取网络对跟踪器的影响不同,较深的ResNet-50和VGGNet-16能够有效提升跟踪器的精确率,这是由于增加骨干网络的深度可以提取到更具有判别力的特征,从而有效提升跟踪网络的跟踪性能。

将编号7和编号9的实验数据进行比较,可以看到以AlexNet为骨干网络,引入多阶段结果融合模块时,精确率提升了0.4个百分点,提升效果不大,这是由于AlexNet的层数较浅,提取到的特征差别不大,在此基础上进行特征融合并不能取得较好的效果。但是,将编号2和编号4的实验数据进行比较,可以发现以ResNet-50作为特征提取的骨干网络时,引入多阶段结果融合模块可以提升2.7个百分点,这是由于在深层特征提取网络中,引入多阶段结果融合模块可以保留目标的细节特征,提高跟踪器的跟踪效果。

将编号8和编号9的实验数据进行比较,可以看到在引入AO-RPN和预测网络后,虽然精确率有所增加,但是鲁棒性有所降低,这是由于AO-RPN对目标的预测框覆盖率较高,虽然在更新模板的时候会对减少背景的影响,但降低了跟踪器的泛化性,同时在出现相似目标的时候也很难根据背景信息进行判别,因此在引入AO-RPN和多分支预测网络时,本文方法的鲁棒性会略微下降。

通过消融实验可以得出,特征提取网络、区域提议网络和特征融合三个改进模块均能够有效提升跟踪器的跟踪效果。

2.4 对比实验及结果分析

为了客观并且有针对性地验证本文算法的有效性,本文在3个被广泛应用的跟踪基准数据集上对算法的性能和速度进行实验,并与其他的优秀算法进行了对比分析,最后在一些特殊场景的数据集上对算法的泛化能力进行了验证。

本文选择用于对比实验的算法有SiamFC,该方法继SINT后首次将孪生神经网络用于目标跟踪的算法模型,避免了深度学习领域在目标跟踪应用上精度高但速度慢的缺点,在极大提升算法性能的同时,保持着较高的跟踪速度,为后续深度学习在目标跟踪方向上的应用提供了思路。SiamRPN,该方法将区域提议网络用于目标跟踪,抛开传统图像金字塔式的匹配模式,在提高跟踪速度的同时提高了精准度。SiamRPN++,首次将深层特征提取网络用于目标跟踪,解决了平衡不变性对位置偏见的影响,同时提高了算法的跟踪性能。DaSiam‐RPN[20],引入了更多数据集来充实正样本数据,提高了算法的泛化能力,同时扩充了困难样本来提高算法的判别能力,设计了干扰物感知模型,通过减小跟踪器对干扰物的响应,从而提高跟踪器的准确率。SiamCAR[21]通过无锚框策略将回归分支转化为中心点及中心点到锚框的距离,再将结果分类得到最佳目标的中心点,之后提取锚框的坐标,从而实现跟踪。SiamSE[22]通过构造一个等比例变换的缩放模块,为SiamFC构造了一个改进模式,大大提高了跟踪性能与效率。

2.4.1 OTB2015数据集实验结果

OTB2015数据集是目标跟踪领域通用的经典数据集之一,包括了光照变化(illumination variation,IV)、尺度放缩变化(scale variation,SV)、遮挡(occlusion,OCC)、目标变形(deformation,DEF)、运动模糊(motion blur,MB)、快速移动(fast motion,FM)、平面内旋转(in-plane rotation,IPR)、平面外旋转(out-of-plane rotation,OPR)、离开视野(out-of-view,OV)、相似背景(background clutters,BC)、低分辨率(low resolution,LR)共11种不同类别的跟踪场景。在实验中,本文采用一次通过评估(one-pass evaluation,OPE)的方式来计算跟踪器准确率和成功率,将准确率、成功率以及跟踪速度作为评判跟踪器性能的评估依据。

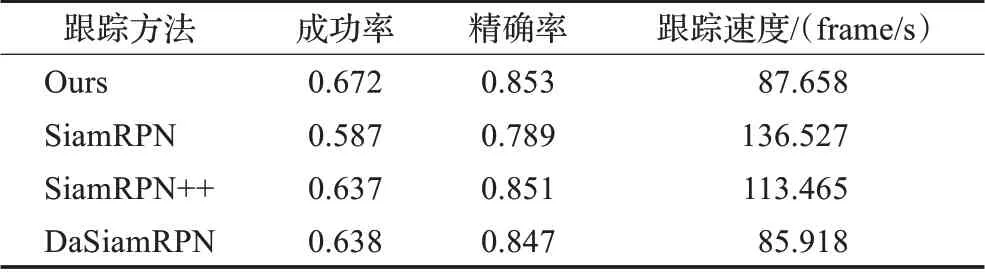

表2为本文算法与其他算法在OTB2015数据集中的实验结果对比,经过对比实验可知,在引入深度特征提取网络、多阶段融合和AO-RPN加多分支预测网络之后,本文方法相较于SiamRPN在OTB2015数据集上,成功率提高了8.5个百分点,准确率提高了6.4个百分点,同时在近年同类型方法中成功率和准确率都达到最优水平,同时跟踪速度超过了DaSiamRPN方法,满足跟踪方法对实时性的要求。

表2 OTB2015数据集的对比实验Table 2 Comparative experiment on OTB2015 dataset

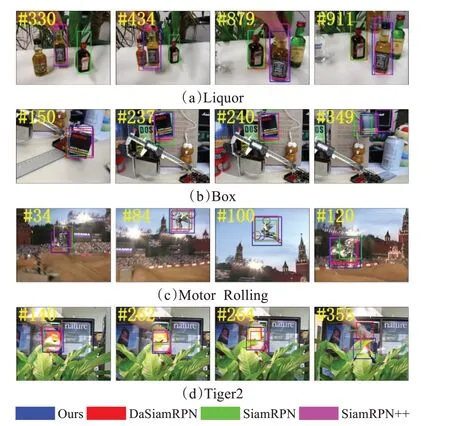

图4为本文算法在OTB2015数据集上与其他相关算法进行对比实验时,部分难度较高视频序列的跟踪情况。Motor Rolling是一个以旋转为主的目标跟踪视频序列,在34帧的时候,由于目标出现小幅度旋转,可以看到SiamRPN和SiamRPN++已经在跟踪时出现了偏移,而引入AO-RPN的网络对旋转的跟踪性能更好。在84和100帧时,可以发现其他三个跟踪器已经不能较好地对目标进行覆盖,而本文算法能够对目标进行非常好的覆盖,虽然这段时间目标发生了旋转和放缩变换,但由于本文方法用了多阶段结果的融合方法,对尺度变换和旋转变换有较高的鲁棒性,因此能在这个视频序列中取得较好的成绩。

图4 对比算法在OTB2015序列上的跟踪结果对比Fig.4 Comparison of tracking results of various algorithms on OTB2015

在Box序列中,可以看到在150帧虽然跟踪器对目标的覆盖效果都较好,但由于该视频中目标的形变和旋转较多,在237帧的时候,SiamRPN已经在跟踪时产生了偏移。在349帧的时候,光照、旋转和放缩变化同时发生,SiamRPN和SiamRPN++在跟踪中已经出现丢失目标的情况,但本文方法通过深度骨干网络和多分支预测网络提高了模型的泛化能力,能够在较为复杂的情况下保持跟踪状态。在Liquor和Tiger2序列中,部分遮挡和完全遮挡的情况非常多,可以看到Liquor的第879帧和Tiger2的264帧、355帧,由于遮挡导致目标的信息多少,DaSiamRPN和SiamRPN甚至已经出现了目标丢失的情况,但由于本文的特征提取网络较深,感受野较大,因此能够在复杂的情况下保持跟踪效果。

2.4.2 VOT2016数据集实验结果

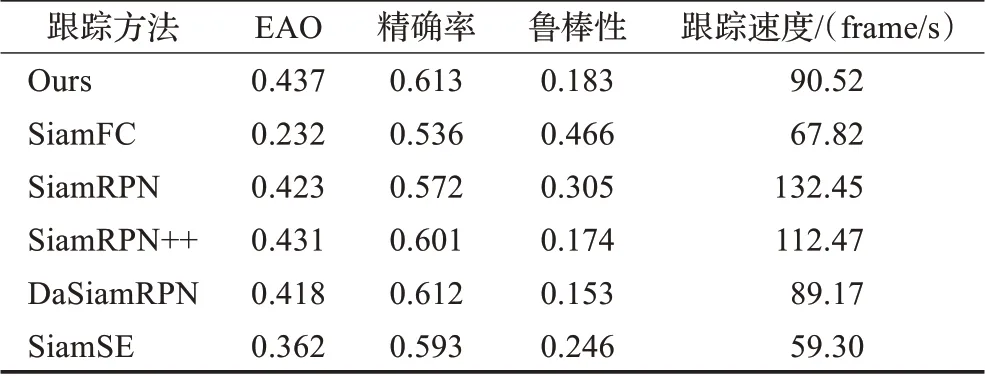

VOT2016数据集是由60个视频序列构成的基准数据集,相较于OTB2015,该数据集的视频序列难度更高,更具有挑战性。在该数据集上测试更能够体现算法在困难情况下的跟踪效果,因此在该数据集上,本文选择了SiamRPN、DaSiamRPN、SiamRPN++、SiamFC和SiamSE进行对比实验。

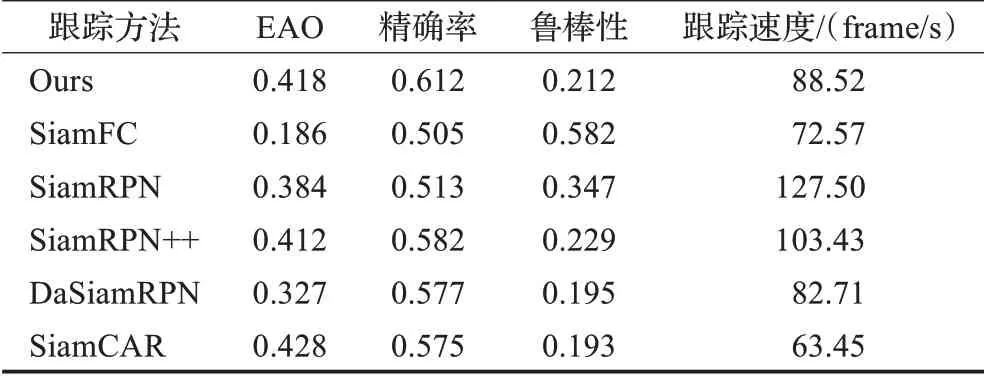

表3为本文算法与其他算法在VOT2016数据集中的实验结果对比,由实验可知,经过改进后,本文方法相较于SiamRPN在VOT2016上,EAO提高了1.4个百分点,精确率提高了4.1个百分点,并保持了较高的跟踪速度,同时在近年同类型方法中成功率和准确率都达到最优水平。

表3 VOT2016数据集的对比实验Table 3 Comparative experiment on VOT2016 dataset

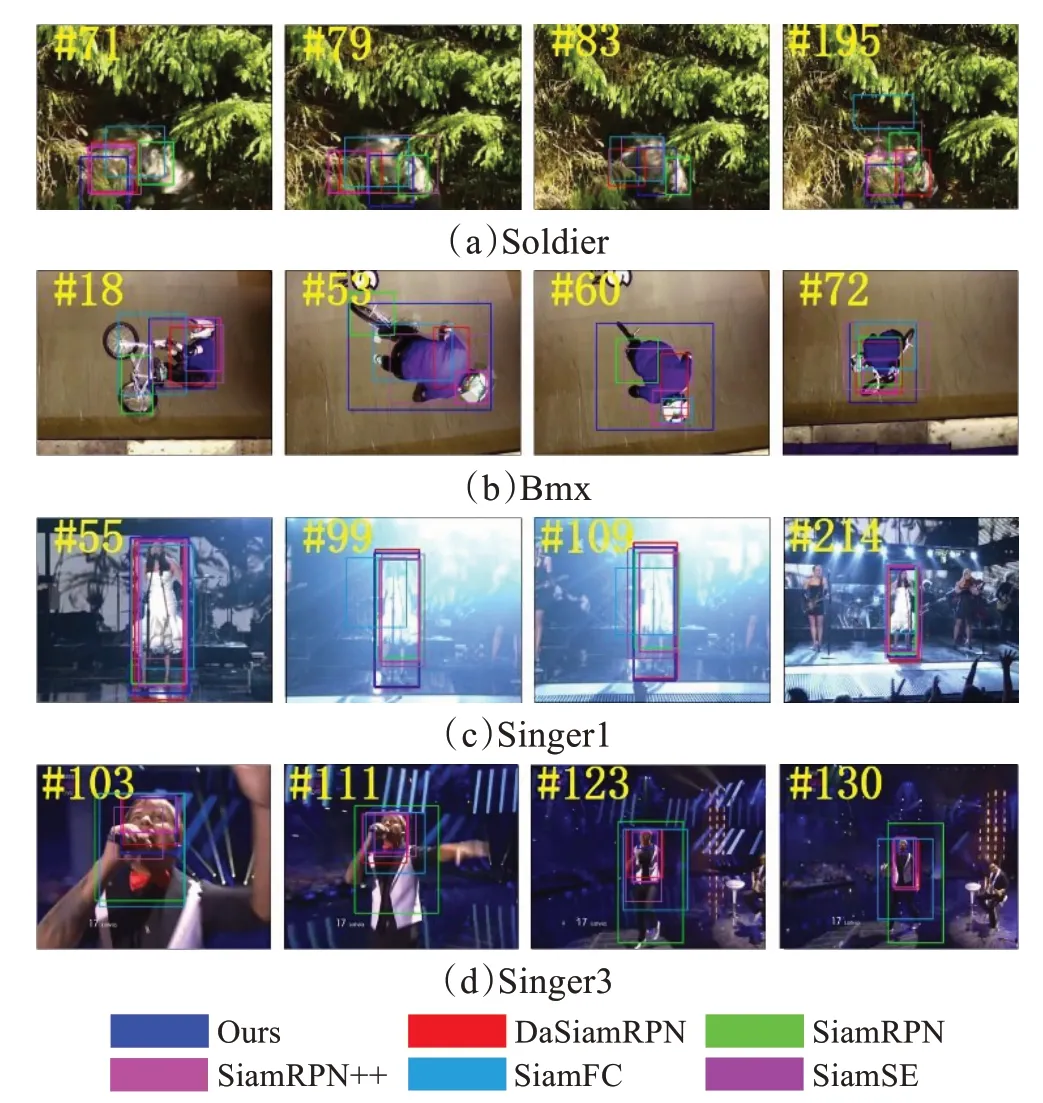

图5为本文算法在VOT数据集上与其他相关算法进行对比实验时,在部分视频序列上的跟踪情况。可以看到在Soldier这种复杂背景的视频序列中,深度特征提取网络能够发挥较好的效果,一方面能够对目标保持较好的覆盖率和跟踪准确度,另一方面不会出现目标丢失的情况,而SiamFC已经彻底丢失了目标。在Bmx这种旋转变换较多的视频序列,通过旋转区域提议网络,本文算法能够对目标产生非常好的覆盖效果,在53和60帧,本文算法能够对目标进行完整的覆盖,而SiamFC和SiamRPN在18帧已经开始出现了目标丢失的情况,而SiamSE则开始对目标的衣服进行跟踪。在光照的情况下,可以看到由于使用深度特征提取网络并对结果进行融合,能够有效提高覆盖率和准确率,相较于其他算法,本文的方法对目标的覆盖率更好。同样,在大尺度放缩变换时,本文方法的感受野更大,泛化能力更高,在103帧摄像机快速拉进的时候能够保持目标的跟踪,并在拉远时,跟踪器能够不丢失目标,在保持高准确率和覆盖率的情况下保持较高的跟踪速度,本对比实验能够体现改进方法的有效性。

图5 对比算法在VOT2016序列上的跟踪结果对比Fig.5 Comparison of tracking results of various algorithms on VOT2016

2.4.3 VOT2018数据集实验结果

VOT2018数据集是由60个视频序列构成的基准数据集,与OTB2015和VOT2016不同的是,该数据集改变了结果的标注方法,通过目标的最小外包矩形框来对结果进行标记,这种标记方法虽然更贴近真实跟踪场景,但大大提高了跟踪难度,本文在VOT2018数据集上将旋转区域提议网络的孪生神经网络跟踪算法与SiamFC、SiamRPN、SiamRPN++、DaSiamRPN和SiamCAR进行对比实验,EAO比SiamRPN算法提高了3.4个百分点,精确率提高了9.9个百分点,同时在对比实验中精确率达到最优水平,EAO达到次优水平。该对比实验能够验证,在改变数据集的标注形式下,由于本文使用旋转区域提议网络进行跟踪,精确率仍没有明显下降,覆盖率仅下降1.9个百分点,因此可以体现改进模块的有效性。

表4 VOT2018数据集的对比实验Table 4 Comparative experiment on VOT2018 dataset

2.4.4 旋转场景视频序列实验结果

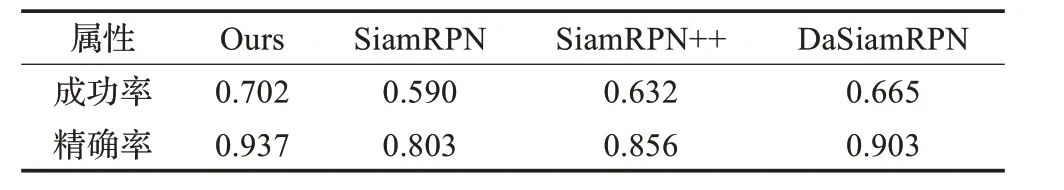

本文所提方法在SiamRPN系列方法的基础上,针对目标跟踪过程中的旋转问题,提出了AO-RPN方法,为了测试跟踪器在旋转场景下的跟踪性能,本文在OTB数据集中挑选了51个包含旋转因素的视频序列进行测试。如表5所示,在引入现代化深度特征提取网络、旋转区域提议网络以及多分支预测网络后,本文在包含旋转因素的视频测试序列中,成功率达到0.702,在基线算法的基础上提高了11.2个百分点,比第二名高出3.7个百分点。精确率达到0.937,在基线算法的基础上提高了13.4个百分点,比第二名高出3.4个百分点。可以看出本文方法在旋转场景下的性能指标较好,远高于基线算法对旋转目标的跟踪性能。同时,在SiamRPN系列方法中,本文对旋转场景的跟踪效果也处于较优水平,能够体现出本文所提模块对旋转场景跟踪效果提升的有效性。

表5 算法在旋转序列中的实验结果对比Table 5 Experimental results comparison of algorithms on rotation sequence

2.4.5 其他特殊场景视频序列实验结果

最后,作为通用型跟踪器,为了验证本文在一些特殊环境与情况下的跟踪效果与跟踪性能。本文将OTB和VOT中一些特殊场景的视频序列进行讨论,并与DaSiam、SiamRPN和SiamRPN++进行对比实验。

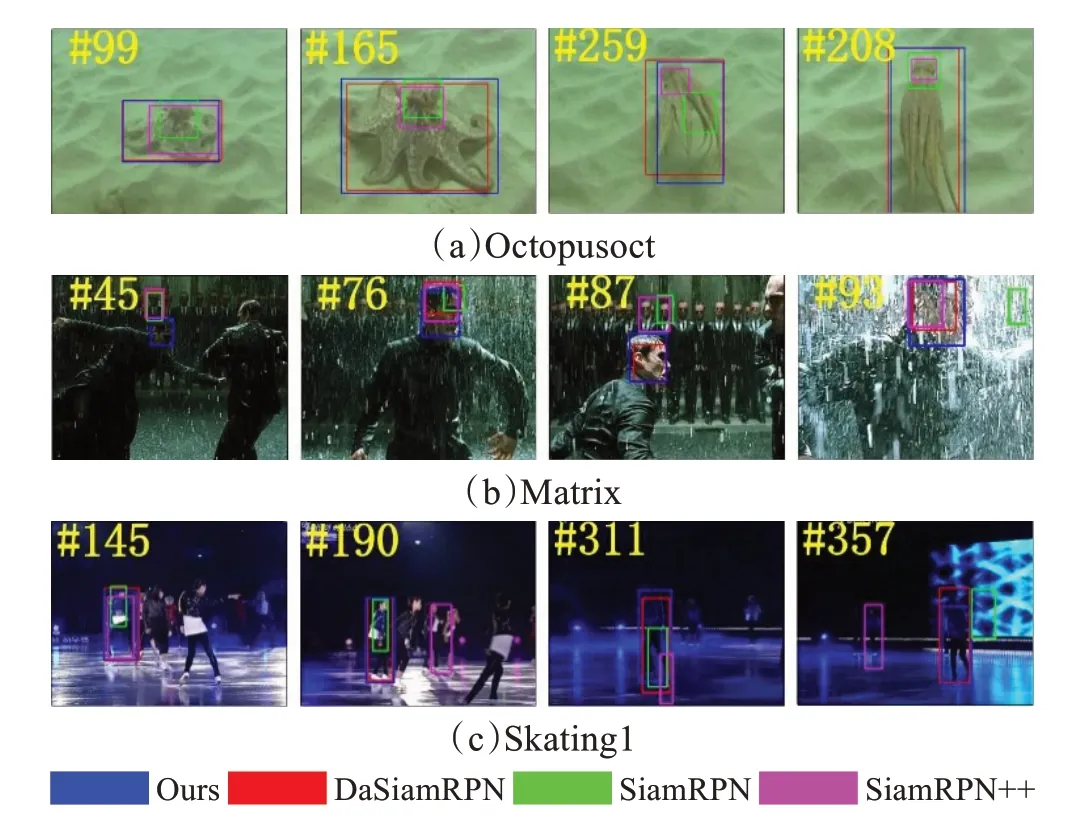

如图6,水下生物跟踪视频与演唱会的跟踪视频面临的挑战近似,水下跟踪往往由于亮度和折射原因,并且水下生物具有一定的保护色,因此水下跟踪是一个相似背景下的目标跟踪问题。在面临相似背景的目标跟踪时,提高感受野大小,并且加深特征提取网络可以在目标跟踪时有效地对目标进行信息提取,再加上多层特征结果融合。可以看到,由于SiamRPN仅使用了Alex作为特征提取网络,导致在跟踪过程中只能对响应最高处进行跟踪,对触须等细节位置覆盖率较差。而Siam‐RPN++虽然采用了深层特征提取网络,但是在训练过程中没有对充实正样本,提高跟踪器的泛化能力,因此跟踪效果较差,本文方法由于采取了深层网络,增加了多分支预测网络,因此对细节的提取程度更高,能够在相似背景下对目标进行更精准地覆盖与跟踪。

图6 对比算法在特殊序列上的跟踪结果Fig.6 Comparison of tracking results of various algorithms on special

Matrix是OTB2015中一个较难视频序列,其中复杂情况包含光照变化、快速运动、遮挡、形变、旋转等,并且多种情况在非常短的时间内共同作用于目标,可以看到由于采用了AO-RPN网络和多分支预测网络,本文提出的方法对目标的跟踪能力更强,同时加深特征提取网络,能够提取到更高层的特征,感受野更大,最后对选取多层特征进行预测,提取置信度最高的结果。因此,在93帧SiamRPN已经出现了目标丢失的情况,而DaSiam和SiamRPN++对目标的覆盖已经产生偏移,但本文的方法仍能精准地对目标进行覆盖。

在Skating1序列中,分别出现了相似背景、光照变换、尺度变换等复杂,在相似背景和光照变化的情况上,深度特征提取网络和多层特征结果融合能够有效地对这些情况进行处理,在目标旋转或形变的时候,AO-RPN和多分支预测网络对跟踪结果的帮助更大,因此可以看到在357和311帧的情况下,由于光照原因目标与背景极为相似,本文方法可以有效对目标进行跟踪,而SiamFC和SiamRPN++已经丢失了需要跟踪的目标。

3 结论

针对传统区域提议网络应用于目标跟踪时,目标旋转会对跟踪器的跟踪性能造成较大影响这一问题,本文提出了一种旋转区域提议孪生神经网络跟踪算法,先通过深层骨干网络提取目标与搜索区域的特征,再通过AO-RPN结构对旋转区域进行预测,最终通过旋转预测头对目标进行跟踪,这种跟踪方法能够在保持高跟踪速度的同时,大幅提高跟踪精度。通过在OTB2015、VOT2016和VOT2018公开数据集上进行实验,并与多种跟踪器进行比较分析。结果表明,本文所提出的旋转区域提议网络跟踪模型在遮挡、旋转、复杂背景、光照变化等场景的跟踪性能都优于目前综合性能较好的主流算法,并且跟踪速度快,满足实时性要求。虽然本方法的跟踪性能较好,但并没有对模板进行更新处理,如何在跟踪过程中更新并得到一个高置信度的跟踪模板,将是下一步的研究方向。