基于双目视觉的GIS异物分割和定位方法

马心全,钟羽中,佃松宜

(四川大学电气工程学院,四川成都 610065)

0 引言

GIS设备是高压输电线路必不可少的部件,其内部的异物在高压状态下会产生放电烧蚀现象,进而导致设备停摆,出现大面积停电事故,因此,开展GIS设备异物清理及检修工作具有十分重要的意义[1]。作为无接触检测和测量的技术手段,双目视觉已被广泛应用到目标检测[2-3]和定位[4]任务中。

常规GIS异物检测定位采用局部放电的形式,如超声波局放[5]、X射线数字成像[6]、图像处理[7]等。该类方法比较依赖高端外部设备,且未从量化的角度给出异物的具体位置,不具备机械臂定点清理功能。

GIS内存在空洞、支撑绝缘子等凹陷、突出的结构,其内部纹理整体偏弱,并存在一些白亮的宽条斑、细划痕状条纹以及小斑点等干扰情况,传统的图像处理算法在异物的识别上鲁棒性较差;传统的双目立体算法虽然速度较快,但由于匹配特征简单,在GIS这种弱纹理、高反光的环境下无法实现特征的精确匹配,不能很好地完成定位任务。

近年来,卷积神经网络(convolutional neural network,CNN)在目标检测分割[8]、定位[9]中发挥了极大的作用,展现出较强的特征提取能力。

融合传统立体匹配算法的快速性和CNN特征的丰富性,采用U-Net网络,本文提出了基于双目视觉的GIS异物分割定位方法。通过共用1个U-Net分割模型,同时完成分割和立体匹配2个任务。完成了1个模型,2个算法任务的应用创新。

1 GIS异物分割及定位系统硬件整体设计

系统主要包括机器人视觉采集平台和上位机显示平台2部分。机器人视觉平台负责采集、传输视频图像及接收异物坐标数据,执行抓取任务;上位机平台负责接收、处理(识别和定位)、显示图像,并将图像处理的异物坐标回传给机器人。两者通过无线局域网络进行数据通信,如图1所示。

图1 系统通信方式

双目视觉系统由2个单目相机组成,相机型号为索尼HBV-HPLCC,800万像素。首先完成双目标定,双目相机将采集的图像通过无线网络传输到上位机图像处理平台,上位机接收图像后,采用U-Net网络完成异物的分割,并将处理的结果以图像的形式显示出来,同时将异物的坐标回传到机器人;机器人在收到异物坐标后,由电机驱动柔性臂完成异物抓取。实验设备和系统结构流程如图2和图3所示。

图2 实验设备

图3 系统结构流程图

2 双目标定和双目定位原理

系统依据双目平行视觉[10-11]原理,首先对双目图像进行校正,使之满足双目立体匹配算法对图像的要求,而后根据双目定位原理,解算出异物的三维坐标,完成异物定位任务。

2.1 双目标定

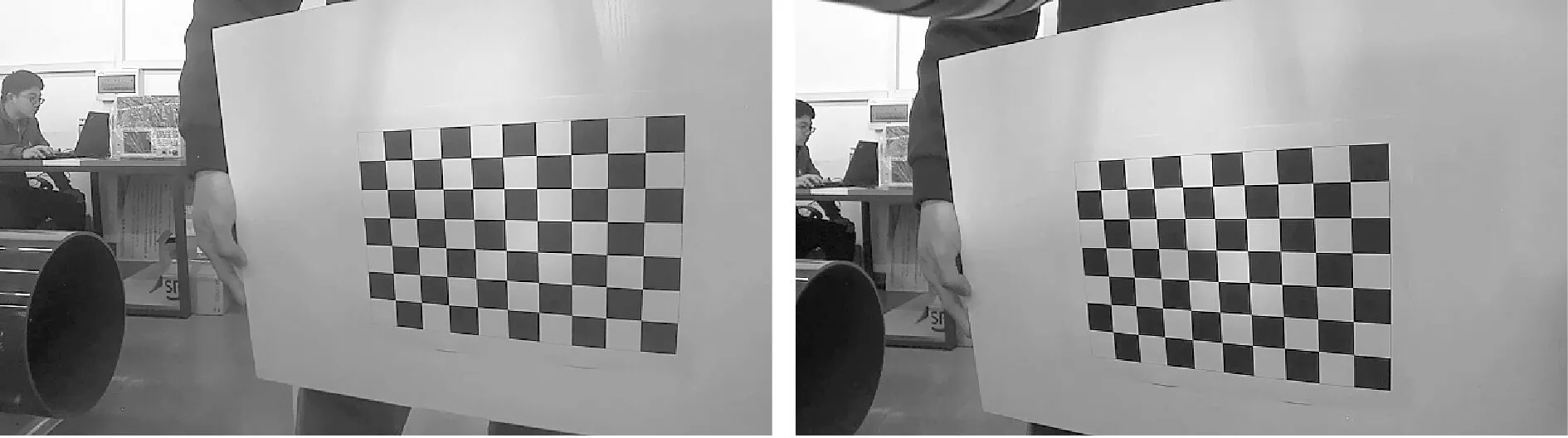

受生产和安装精度的影响,实际相机的成像存在畸变和位置倾斜问题,通过双目标定,可以求解单个相机成像模型的畸变参数,同时求解左右相机位置之间的旋转矩阵和平移矩阵参数。根据相机针孔成像模型,采集20组不同方位拍摄的双目图像对,采用张正友教授提出的棋盘格标定法[12]在Matlab软件中完成双目图像标定任务。标定后结果如图4所示。

(a)标定前

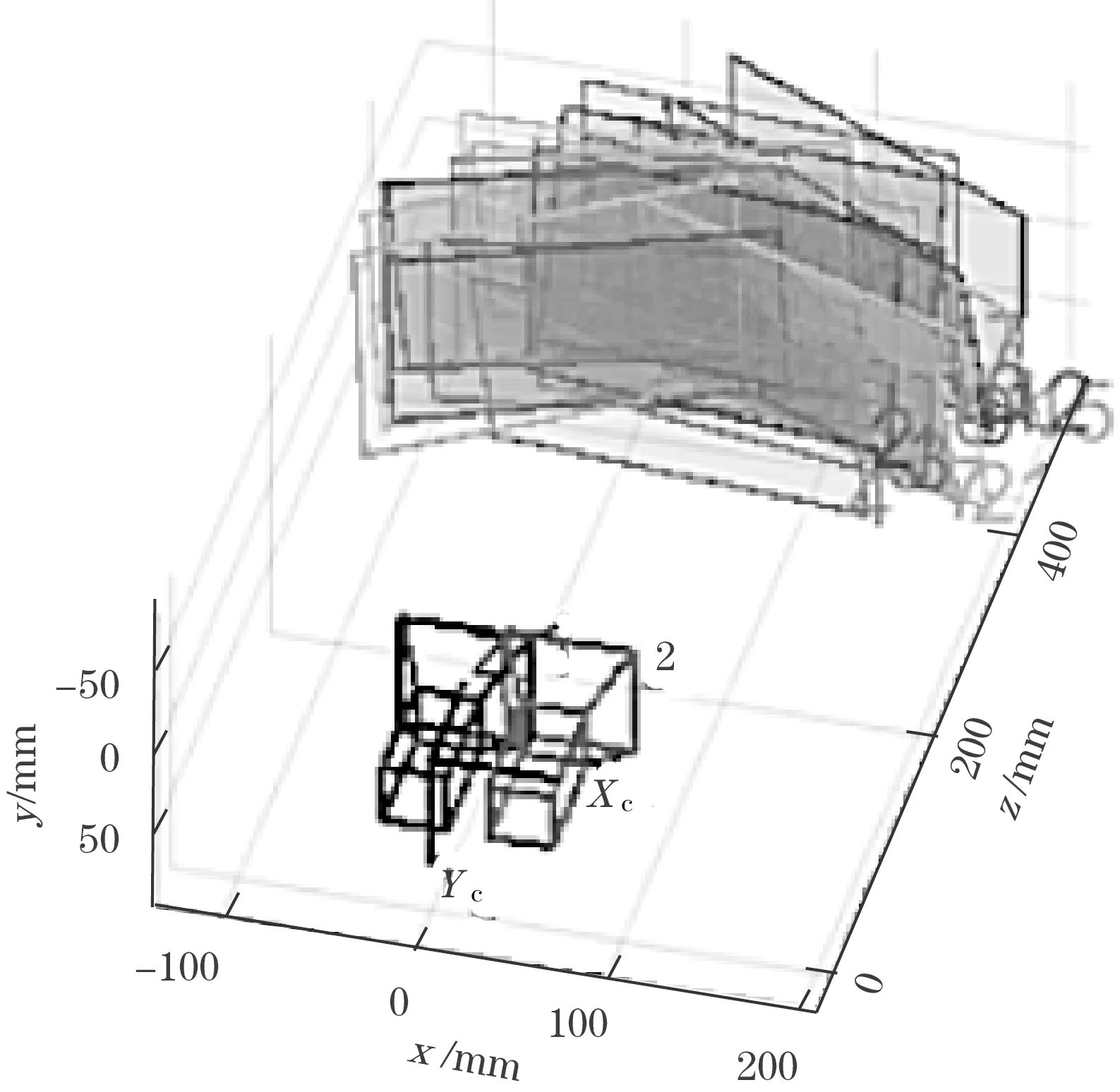

标定后,双目左右图像同名点在图像中处于同一水平线上,满足极线约束条件。双目标定误差结果如图5所示。其中,标定反投影平均误差约0.10像素,最大误差约0.11像素,低于双目标定反投影误差数据0.3像素,说明本次标定精度较高,满足应用要求。图6为双目相机与标定图像对之间的相对位置关系。

图5 双目标定误差

图6 标定图像与相机之间的相对位置关系

2.2 双目定位原理

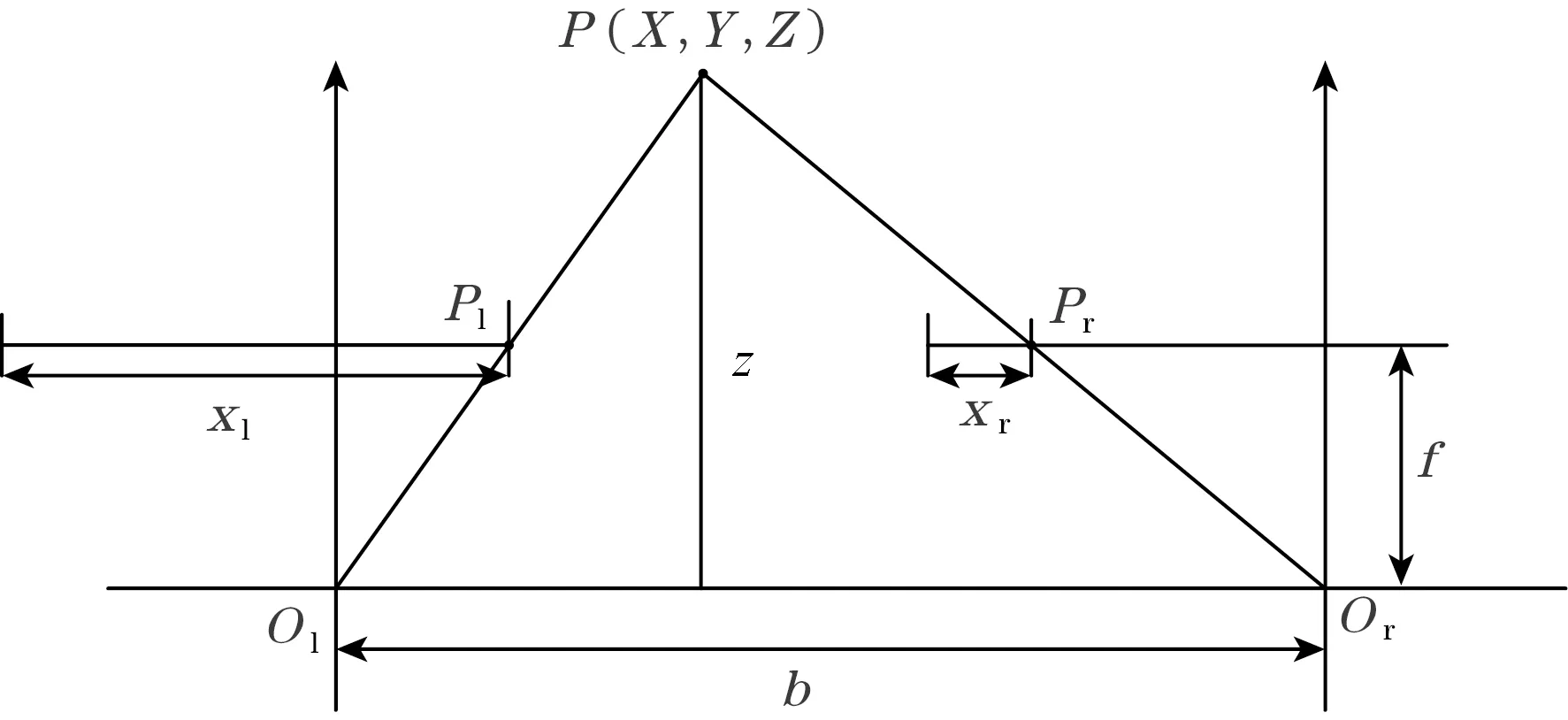

双目定位是基于左右图像中同名点的视差实现的。在标定后的双目图像中,采用立体匹配算法,依据同一目标点在左右图像中的视差值,结合平面三角形相似原理,可以解算出目标点相对于左相机的三维空间坐标,双目立体视觉几何模型如图7所示。

图7 双目立体视觉几何模型

目标点空间坐标为P(X,Y,Z),根据立体匹配结果得到目标点在左、右双目图像中的像素坐标分别为P1(ul,vl)和Pr(ur,vr),其对应图像坐标系下的物理坐标分别为Pl(xl,yl)和Pr(xr,yr),则视差d=|xl-xr|。图中f为相机物理焦距,b为左右相机基线距离,即左右相机光心之间的距离,dx和dy为每个像素点在相机CCD成像器件水平和竖直(分别用u、v表示)方向上的物理尺寸参数,ul、ur为Pl(X,Y,Z)、Pr(X,Y,Z)在双目图像中的以像素为单位的列坐标表示,u0、v0为左右相机光心Ol、Or的坐标表示。依据图7,根据三角形相似测量原理有:

(1)

获得目标点深度值后,可通过摄像头坐标系和图像坐标系之间的坐标转换关系求得目标点的X值和Y值,也即得到了目标点的三维空间坐标,结果如式(2)和式(3)所示。

(2)

(3)

3 基于双目视觉的GIS异物分割与定位系统

本文双目图像GIS异物分割与定位系统采用1个分割模型,可同时解决异物分割识别和立体匹配2个支路的任务,最终实现异物的定位,其具体流程如图8所示。

图8 系统算法整体示意图

通过训练获取异物分割模型,并以模型为干路支点,拓展延伸出异物分割和立体匹配2个支路的任务:

(1)左图像采用U-Net分割网络模型进行异物预测,获取异物分割区域及其质心坐标。

(2)左、右图像均采用分割模型获取卷积特征图,构建卷积特征描述子,采用本文所提算法,完成立体匹配,获取左图像视差图。

(3)结合左图像异物的质心坐标和视差图,通过双目定位原理,解算出异物的三维坐标,完成GIS异物的分割识别与定位任务。

3.1 异物分割U-Net网络简介

U-Net是基于全卷积的目标分割神经网络,主要包括左侧的编码网络(Encoder)和右侧的解码网络(Decoder)及跳步连接(Skip)结构,也称为Encoder-Decoder结构。图8(a)为其网络结构简图(黑色虚线上方)。

U-Net网络的左侧Encoder部分,主要负责特征提取,主要由5个卷积模块通过不断下采样组成。每个卷积模块的卷积通道数c和数量n设置为[(64,2),(128,2),(256,2),(512,2),(1 024,2)]。2个卷积层用于提取图像特征信息,其后紧跟一个Softmax非线性拟合函数,最后紧接一个下采样层缩小图像尺寸,完成网络由浅层向深层的特征提取。

Decoder网络部分和Encoder网络部分关于直线对称,区别之处在于Decoder网络由于要恢复图像尺寸,将下采样层替换为上采样层,网络的最后一层通过Softmax逐像素输出分割概率值,完成分割结果的输出。

跳步连接是U-Net网络的创新,将左侧Encoder网络的部分卷积层拼接到右侧Decoder网络中,而后再融合到Decoder网络中的办法,实现了多尺度语义信息的利用,提高了模型整体的分割性能。

3.2 基于Feature Map的卷积特征描述子立体匹配算法

局部立体匹配算法通常采用灰度值、色彩、梯度等手动设计的特征作为常用的匹配特征。由于特征信息单一,匹配计算简单,该类算法视差图效果较差,但运算速度很快。相反,CNN具有较强的图像特征表达能力,其卷积特征比较适合用于进行立体匹配。

结合局部立体匹配算法的快速性和深度学习立体匹配卷积特征信息的丰富性,本文提出一种基于Feature Map的卷积特征描述子立体匹配方法。通过分割网络模型获取双目图像的特征图,进而构建卷积特征描述子,完成立体匹配,获取视差。其计算流程如图9所示。

图9 卷积特征描述子立体匹配流程

U-Net网络初始卷积层的维度为64,将同一像素的64维卷积特征图对应位置的卷积结果按照顺序排列成一个向量,就得到了该像素点的64维卷积特征描述子。卷积特征描述子的形成如图10所示。

图10 卷积特征描述子的形成

得到卷积特征描述子以后,采用局部立体匹配算法的相似性度量函数,就可以实现双目图像的立体匹配,进而获取视差值。卷积特征描述子的立体匹配过程如图11所示。

图11 卷积特征描述子的匹配过程

得到图像的卷积特征描述子后,通过局部立体匹配算法SAD(sum of absolute difference)计算代价值,Il(u,v)、Ir(u,v)为左右图像中的像素,则其代价计算如式(4)所示,并采用WTA[13](winner takes all)策略筛选最佳匹配点,最后通过视差后处理完成视差结果的优化。

SAD(u,v)=Sum{|Il(u,v)-Ir(u,v)|}

(4)

4 实验结果与分析

遥控机器人在GIS内巡检,采集800张图像,利用Labelme标注工具制作异物分割标签,并随机选择其中600张作为训练集,100张作为验证集,100张作为测试集。采用随机反转、旋转、裁剪、亮度和饱和度随机调整等数据增强方法对图像数据集进行扩充。

实验环境为Windows10系统,Intel(R)Core(TM)i7-8700k CPU @ 3.70 Hz处理器,GPU为NVIDIA GeForce GTX 1080Ti,显存为8 GB;软件训练环境为Python3.6、Tensorflow1.14、Keras2.2.4。

4.1 GIS异物分割结果

对GIS中典型的3种异物(螺钉、扎带、螺母)进行分割测试,分割结果如图12所示。

图12 异物分割结果

由图12的分割结果可知,U-Net可以完成多种类型异物的分割,且分割效果良好,满足GIS异物识别的任务要求。

4.2 立体匹配实验结果与分析

为适应采集视频的图像尺寸,将U-Net网络输入尺寸修改为352像素×640像素。在KITTI立体视觉公开数据集上进行实验,验证所提算法的有效性。首先,训练KITTI数据集分割网络模型,而后,构建卷积特征描述子进行立体匹配,获取视差图。采用Good0.0、Good1.0、Good2.0、AvgGood评价指标对视差结果进行比较。其中:Good0.0代表视差值完全相同的准确率,Good1.0代表误差在1像素内的准确率,Good2.0代表误差在2像素内的准确率,AvgGood代表前3项的平均值。

采用传统局部立体匹配算法BM和全局立体匹配算法SGM进行对比试验,实验结果如图13、表1、图14、表2所示。

图13 KITTI编号000000_10的视差图

表1 000000_10视差图的准确率 %

图14 KITTI编号000167_10的视差图

表2 000167_10视差图的准确率 %

从图13(d)和图14(d)的视差结果可以看到,局部立体匹配BM算法视差图存在明显的黑色误匹配区域,效果较差。从图13(f)和图14(f)可知,本文算法具有较高的视差匹配度,视差图结果比较稠密且连续性更好。SGBM视差图结果较本文算法稠密,但匹配准确率却低于本文算法,原因在于SGBM算法视差图过于平滑,其视差值在区域范围内基本相同,缺乏视差连续性,导致与真值存在误差。从表1和表2的准确率数据可以发现,基于卷积特征描述子的本文算法在评价指标上均高于BM和SGBM算法,具有较高的视差匹配准确度。

由此,可以得出结论,本文提出的基于卷积特征描述子的立体匹配算法比传统的局部立体匹配算法可以更好地表达图像特征,得到稠密的、连续性更好的视差图。

4.3 系统整体实验结果及分析

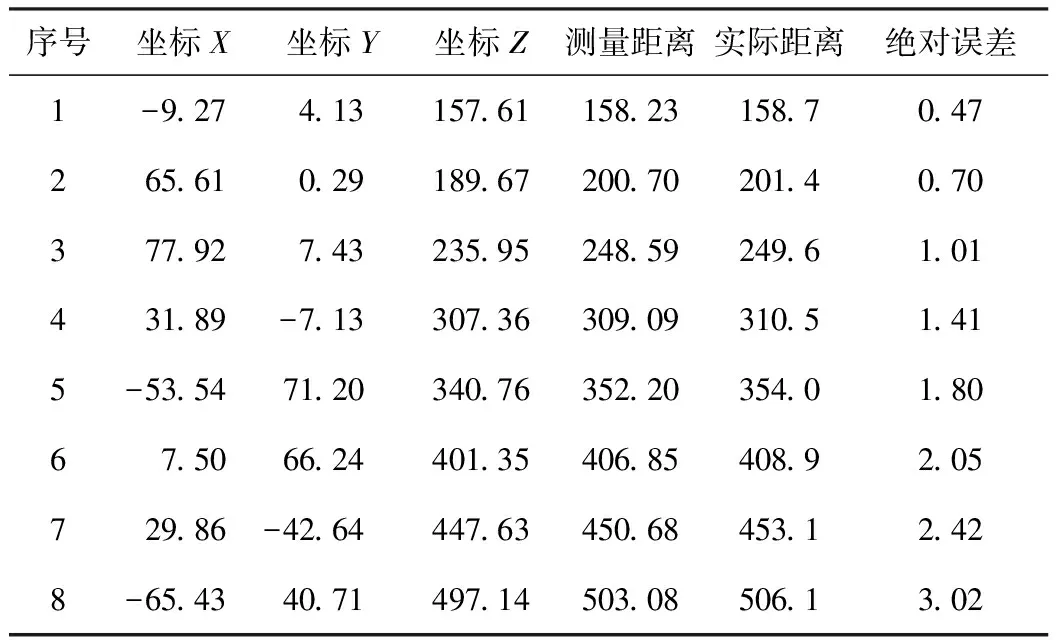

通过GIS智能车采集标定后的多组双目图像,并记录图像中异物在相机坐标系下的距离值。使用本文算法获取异物的质心坐标和视差图,解算出左相机坐标系下的三维坐标,并与记录的距离值进行对比。结果如图15所示。

图15 GIS异物定位结果图

在GIS中采集图像进行应用实验,验证立体匹配定位的精度,结果见表3。其中GIS机器人柔性臂长度为40 cm,测试间隔为5 cm,共计8个批次。在柔性臂最大伸展处定位误差达到最大值2.42 mm,满足柔性臂抓取的定位精度要求。

表3 GIS异物定位坐标及误差 mm

除精度之外,运行速度也是系统应用的重要考虑因素。在本文实验环境下,系统运行满足任务的实时应用要求。实时性分析数据见表4。

表4 系统定位性能分析 ms

5 结束语

针对GIS环境异物需要定位清理的任务,本文采用U-Net目标分割神经网络,实现了异物的分割识别;通过共享分割模型,本文提出了基于Feature Map的卷积特征描述子立体匹配方法,较好地解决了局部立体匹配特征简单而导致的视差误匹配问题。系统整体应用实验结果表明:本文提出的基于双目视觉的异物分割和定位系统可以有效完成GIS环境异物分割和定位的任务,具有较好的鲁棒性和实时性,且完成了1个模型、2个算法任务的系统应用创新,具有一定的参考意义。