基于贝叶斯 Q 学习的无人机集群抗干扰智能快跳频算法*

康雅洁 林 艳,2 张一晋

1.南京理工大学电子工程与光电技术学院,南京 210094

2.宇航智能控制技术国家级重点实验室,北京 100854

0 引言

随着航空及无线通信技术的飞速发展,无人机集群具有了体积小、成本低、环境适应性强、鲁棒性强且作业能力强大的特点,可利用规模优势解决单无人机抗毁性弱和覆盖范围有限的问题,因而具有极佳的任务完成能力。然而愈加复杂的电磁环境对无人机集群通信的可靠性提出了新的挑战。比如,无线电波在传播过程中不仅会受到场景中地形特征、天气条件、飞行姿态等因素的影响,还会面临恶意干扰信号[1],引起无人机通信性能的下降,严重时甚至造成整个无人机系统的瘫痪。因此,无人机集群通信亟待克服恶意干扰对无人机集群网络传输性能的影响,以确保无人机集群在复杂电磁环境下实现高可靠通信。

以跳频通信系统为代表的传统抗干扰通信技术主要通过提高跳频速率和增加跳频带宽来提高抗干扰能力,因而具有较高的避障性能和抗截获性能。但受制于频谱资源紧缺的现状,这种以牺牲频谱资源为代价的抗干扰策略能力愈发有限[2]。

近年来,研究者们开始尝试利用强化学习理论,研究设备如何基于对干扰环境的感知学习[3]调整抗干扰策略以完成对干扰的智能规避,避免扩宽频谱对频谱资源的浪费。比如,文献[4-5]利用无模型Q学习方法,对单用户场景下的认知无线电网络抗干扰决策问题进行研究,利用认知无线电的宽带频谱感知能力加快基于Q学习的干扰策略的学习速度,但尚未考虑多用户场景。文献[6]考虑了超密集物联网的多用户场景,将多智能体抗干扰决策问题建模为服务质量受限的Markov博弈,针对扫频干扰、动态干扰等干扰场景提出了一种基于平均场的抗干扰方法。然而该方法并未考虑通信设备之间的干扰。文献[7]针对无线网络设备通信采用马尔可夫博弈框架对抗干扰防御问题进行建模和分析,提出了一种多智能体协同抗干扰算法,以获得最优的抗干扰策略。但上述方案未考虑设备因频繁切换频道造成不必要的成本开销。

本文针对无人机集群通信网络研究如何学习干扰机的干扰策略并智能选择可用传输频道的抗干扰智能快跳频问题,联合考虑无人机集群传输速率和跳频开销,并利用贝叶斯Q学习可实现探索新策略和利用已知最优策略之间更优平衡的优势加快学习收敛速度,进而在实现有限频谱资源和训练开销下高可靠传输,同时降低无人机集群网络在复杂电磁环境下的跳频开销。

1 系统模型

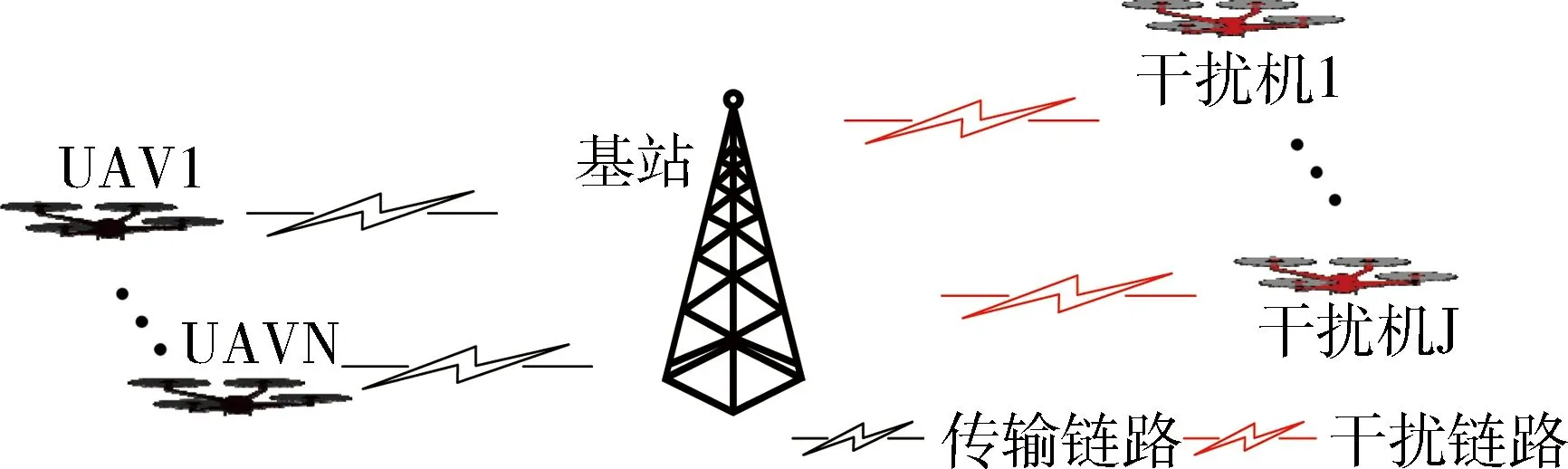

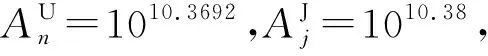

如图1所示,考虑有单个基站,N架无人机,J架干扰机的无人机集群网络。假设该网络预先分配了C个不同的正交频分复用子载波[8]以消除网络中通信链路之间的干扰。任意时隙内,每个无人机选择其中一子载波向基站传输数据,同时干扰机也选择其中一子载波向无人机发送干扰信号。

图1 无人机集群网络系统模型

(1)

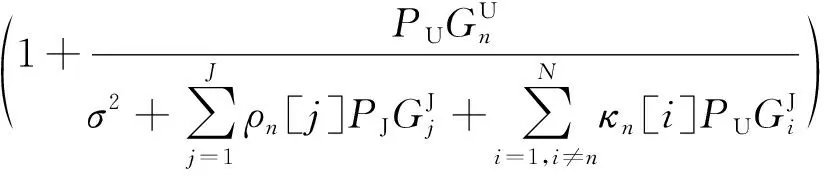

由于无人机与基站通信过程中同时存在敌意干扰攻击和其他无人机的同频干扰,则第n个无人机的信息传输速率为

(2)

其中,ρn[j]=1表示第n个无人机被第j个干扰机干扰,否则ρn[j]=0;κn[i]=1表示第n个无人机受到第i个无人机的干扰,否则κn[i]=0。此外σ2表示加性高斯白噪声的功率。

假设无人机和干扰机的移动性均遵循高斯马尔科夫模型[9]。记基站、无人机和干扰机高度分别为HB,HN和HJ。另外,假设基站水平位置固定在无人机集群移动区域范围的中心。根据文献[9],各无人机(干扰机)速度和方向的更新如下:

(3)

(4)

2 问题表述

无人机智能抗干扰通信过程如图2所示。假设无人机集群飞行过程可被划分为长度相等的若干个时隙。在每个时隙开始时,无人机及干扰机更新位置并完成跳频点选择,此后无人机先依据当前时隙已选择的跳频点进行数据传输,然后对当前时隙网络的所有频道进行频谱感知,并依据此信息进行下一时隙跳频点选择的学习。另外,需要说明的是,单个时隙内干扰机都会在某一频道上对无人机发送干扰信号,而到下一时隙干扰机会根据干扰模式切换干扰频道。

图2 无人机智能抗干扰通信过程

由上述过程可知,无人机自适应快跳频问题本质上是一个序列决策问题。为描述无人机集群网络选择跳频点和更新其选择策略的动态过程,现对无人机集群网络抗干扰通信系统自适应快跳频问题建立如下MDP模型:

1)动作at:时刻t无人机集群的跳频点选择,即at=[ut[0],ut[1],…,ut[N-1]]。其中t时刻第n个无人机所占用频道的序号用ut[n]∈{0,1,…,C-1}表示。

2)状态st:时刻t无人机集群的状态包括上一时刻t-1干扰机的干扰频道以及无人机选择的传输频道,即st=[It-1,at-1]。其中t-1时刻J个干扰机所占用频道序号用It-1=[jt-1[0],jt-1[1],…,jt-1[J-1]]表示,jt-1[i]表示t-1时刻第i个干扰机所占用频道序号,且满足jt-1[i]∈{0,1,…,C-1}。

3)奖励rt:为了最大化无人机集群通信系统信息传输速率与跳频开销的折中,定义t时刻的奖励rt包括无人机集群系统信息传输速率奖励与跳频开销惩罚两部分。记为第n个无人机的信息传输速率奖励,为第n个无人机的跳频开销。具体如下:

b)跳频开销惩罚:设λ为无人机单次跳频所需开销,则第n个无人机的跳频开销可表示为rλ[n]=-λδ[n]。其中当第n个无人机相较于上一时刻切换频道时,δ[n]=1,否则δ[n]=0。

c)折中奖励:令m1表示归一化信息传输速率奖励的权值,m2表示跳频开销的权值。则t时刻的信息传输速率奖励与跳频开销的折中奖励表示为

(5)

3 基于贝叶斯Q学习的自适应快跳频算法

强化学习需要解决的重要问题之一是如何在探索未知的动作以及利用已知的最优动作之间实现平衡。而贝叶斯强化学习将强化学习和贝叶斯学习进行了概率手段上的结合,使得无人机智能体能够基于已知的经验信息概率分布和所观测到的频道占用信息进行推理,通过计算探索和利用共同带来的收益做出实现累积奖励最大的跳频点选择策略,同时加快智能体学习收敛速度。基于以上贝叶斯强化学习的优势,本章基于贝叶斯Q学习提出了一种新的无人机集群抗干扰智能快跳频算法。

3.1 贝叶斯Q学习

Dearden等[10]在传统Q学习算法[11]的基础上提出贝叶斯Q学习算法,其基本思想是采用贝叶斯方法衡量智能体对当前各状态价值估计的不确定性,由此估计探索新动作可获得的信息价值,实现在探索新策略和利用已知最优策略之间的更优平衡。本节将利用贝叶斯Q学习算法设计无人机集群通信系统的抗干扰自适应快跳频方案。

为获得更优的动作选择策略,贝叶斯Q学习动作策略选择采取近期信息价值增益方法以及矩更新的先验分布更新方法,具体如下:

1)近期信息价值增益动作选择

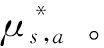

近期信息价值增益动作选择方法是指通过比较探索可获得的预期收益与采用已知最优动作可获得的预期收益来选择策略,其在每个状态下动作选择为

(6)

(7)

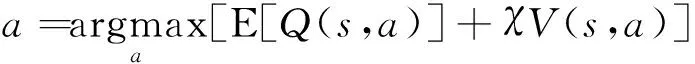

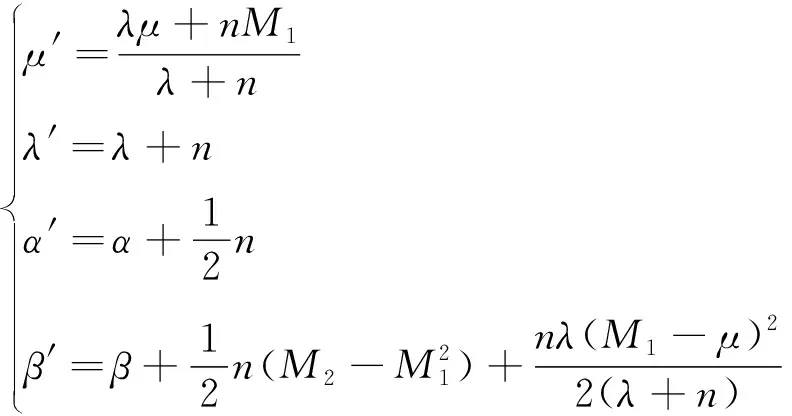

2)先验分布矩更新

高斯伽马分布的4个后验分布参数更新公式为

(8)

其中M1和M2分别是当前时刻t在状态s下执行动作a时的高斯随机变量Rst,at的一阶矩和二阶矩,n是抽样样本个数。

3.2 方案设计

假设无人机集群通信系统中存在一个无人机作为领导者,该无人机领导者能够获取所有其他无人机的频道占用情况,并通过频谱感知可获得系统中所有干扰状态。本文暂未考虑频谱感知的虚警漏警情况[12]。

本文所提出的基于贝叶斯Q 学习的抗干扰自适应快跳频算法如算法1所示。具体而言,算法先对MDP参数S,A,γ,α,r等进行初始化。另外,考虑每q个时隙为一个回合,且每个回合开始前频道状态刷新。对于每个回合重复以下步骤:

1)在每个时隙开始时,无人机智能体依据近期信息价值增益决策策略选择当前时隙跳频点,同时更新位置信息。

2)依据所选频道执行数据传输后,各无人机观测当前频道的占用情况,同时依据环境反馈的信息传输速率奖励和本无人机的跳频点切换记录计算折中奖励值;

3)无人机领导者先结合所有无人机的平均奖励,再运用矩更新方式更新所维护Q表中相应状态动作对所对应的Q值分布。

以上训练过程重复直到平均奖励值收敛。

图3 算法流程图

4 仿真

为了体现智能快跳频算法的优势,本文考虑基于Q学习的智能快跳频算法和随机快跳频算法两种比较方案,并设置每个回合时隙数q=100。

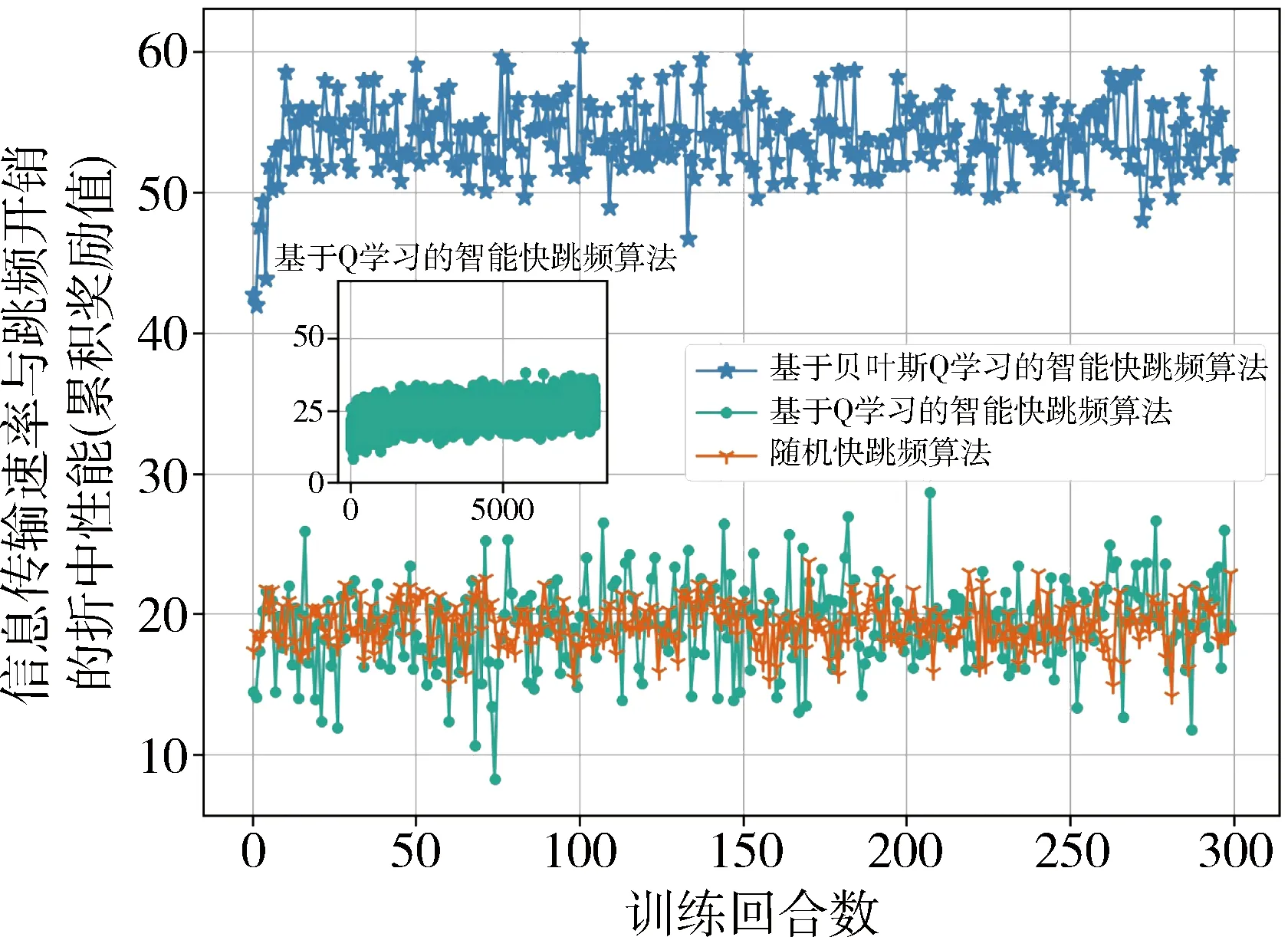

图4 单音随机干扰模式下收敛性能

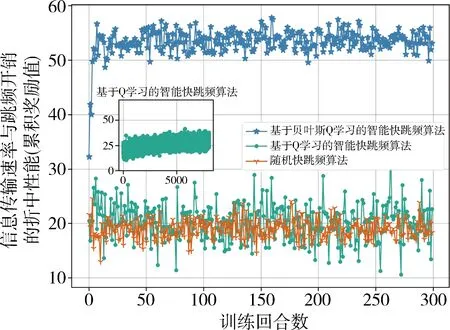

图5 多音扫频干扰模式下收敛性能

图6 马尔科夫干扰模式下收敛性能

仿真中考虑如下3种干扰模式:

1)单音随机干扰:设单个干扰机以0.9的概率保持与上一时隙相同的频道进行干扰,以0.1的概率随机选择其他任一频道进行干扰。

2)多音扫频:设干扰机以1MHz为扫频步长同时对2个频道进行扫描干扰。

3)马尔科夫干扰模式:设共有8个干扰状态,且每个干扰机各自干扰的频道不重复。干扰状态的转换遵循系统初始化得到的状态转移矩阵。

图4~6分别展示了在以上单音随机、多音扫频和马尔科夫干扰模式的环境中3种快跳频算法的折中奖励收敛性能。仿真结果显示,随机快跳频算法累积奖励值一直在20左右浮动;而基于Q学习的智能快跳频算法需要数量级为103的回合训练次数才能收敛,且其收敛值仅为25左右。本文所提基于贝叶斯Q学习的智能快跳频算法仅需要数量级为101的回合训练次数实现收敛,且收敛值均大于50,远高于前2种对比算法。这是因为贝叶斯方法能够衡量智能体对当前各状态价值估计的不确定性,从而利用近期信息价值增益选择动作使得无人机集群能够更快地探索到更优的快跳频策略。

5 结论

为提高无人机集群学习智能快跳频策略的训练速度,本文利用贝叶斯方法可衡量不确定性的优势,设计了一种基于贝叶斯Q学习的智能快跳频算法,以同时提高传输可靠性和降低跳频开销。仿真结果表明,所提算法能够加快无人机集群学习最优快跳频策略的速度,使得无人机集群网络在有限训练开销下实现具有更优的传输速率与跳频开销性能的抗干扰通信。下一步工作将考虑如何利用多智能体贝叶斯Q学习的优势实现无人机集群分布式抗干扰快跳频技术。