基于语言计算方法的语言认知实验综述

王少楠,张家俊,宗成庆,3

(1.中国科学院 自动化研究所 模式识别国家重点实验室,北京 100190;2. 中国科学院大学 人工智能学院,北京 100049; 3. 中国科学院脑科学与智能技术卓越创新中心,北京100190)

0 研究背景

本文中所提的语言认知指人脑对语言的理解,泛指个体在接受语音、文本等信息时,从听觉、视觉等感知觉信息中提取抽象的符号信息的过程,重点关注语言的认知神经科学研究,没有涉及语言的行为实验。语言认知是一个复杂的过程,不同层次和不同单位的语言结构,以及不同类型的语言信息的加工机制各有不同,所依赖的脑网络也非常复杂,比如语音理解过程中需要听觉系统对语音的基本声学特征进行编码,随后涉及词汇识别、语法语义分析等多个步骤,最终才可以实现语言理解。

目前的语言认知研究主要围绕“语言认知的单元和维度”“定位不同类型语言信息的脑网络”“语言信息加工的时间进程和控制”“语言信息的神经编码形式和计算机制”四个研究问题展开。首先,语言中有不同大小的单元,如果研究人脑对语言的加工,应当以对哪种语言单元的加工作为切入点呢?大脑在加工语言的过程中,是否也是以某种单元作为最核心的加工单元呢?另一方面,大脑的信息加工过程非常复杂。不同类型的信息往往是由不同的脑区加工的,而且加工次序有先有后。那么不同脑区在语言加工时的作用是什么?加工的时间进程又是怎样的呢?最后,无论是对脑区还是对加工时序的观测都还只是对大脑语言加工进行现象上的描述,这些现象背后蕴含着哪些认知、计算机制呢?

为了探索上述问题,以往的大多数研究采取假设驱动的语言认知实验范式——研究人员在实验前会明确实验所要验证的假设,并且明确怎样的实验结果与假设的预期一致。比如,研究人员想要验证的假设是: 听觉皮层不仅编码了语音的声学特征,还编码了音位特征。根据这个假设,研究人员要设计实验来区分声学特征与音位特征,然后分析后者是不是影响了听觉皮层的响应[1]。

这类方法实验目的明确,所以较为容易获得稳定的结果。但是,这类方法采用严格控制的实验设计,针对特定的,甚至是非常细节的语言现象展开研究。由于要严格控制实验变量,所以实验中的语料往往趋于一致,因此实验结论很可能只适用于实验中所涉及的高度一致的语料。另外,严格控制的实验导致研究趋于碎片化,一项研究只关心一种特定的语言现象。如果每项研究关注一种语言现象,而语言中只包含有限的几种语言现象, 那么就可以通过整合不同的局部研究得到一个总体结论。但是,由于语言过于复杂,无法统一地划分为若干基本现象,而且实验手段过于多样,导致各种研究结论之间的整合非常困难。

与假设驱动的研究相对的是数据驱动的研究。数据驱动的研究是探索性的,它不先提出假设,而是通过收集实验数据来探索有怎样可能的结果。数据驱动的研究往往使用自然文本作为实验刺激,克服了假设驱动研究中使用人工设计实验材料带来的局限,可以进行更具全局性的高生态效度的研究。但是,使用自然文本采集的人脑活动数据中会包含大量的实验变量,增加了后续数据分析的难度,也会给分析结果带来更多不确定性。

随着以深度学习为代表的通用人工智能技术的出现,语言计算领域迎来了新一轮技术变革。目前,计算机完成语言处理任务的性能大幅度超过传统方法,基于神经网络方法的语言计算模型在实际场景中得到了大规模应用[2-6]。语言计算模型的快速发展也重新引起了认知科学领域的关注,利用计算模型进行数据驱动的语言认知实验也得到了快速发展,积累了大量高水平研究工作[7-9]。如图1所示,这类方法采集被试在阅读或收听自然文本时的神经活动数据,然后使用语言计算模型编码实验刺激,最后利用编码后的刺激研究大脑语言理解的问题。利用计算方法的语言认知实验,为建立精确到词的神经表征模型提供了极大的便利,在分析自然语言加工数据时展现了巨大的潜力。

图1 基于语言计算方法的语言认知实验范式

综上所述,语言计算模型的快速发展为语言认知研究带来了新的机遇和发展,结合两者开展跨学科交叉研究已经成为新的研究趋势。为了给后续利用计算模型进行语言认知实验的研究提供借鉴,本文对典型的相关工作进行总结和展望。下文首先介绍语言计算方法应用在语言认知问题上的相关研究工作(第1~4节); 接着总结已有开源的人脑活动数据(第5节);然后分析已有研究的局限性,并且重点对未来的研究方向进行展望(第6节);最后对全文进行总结(第7节)。

1 语言认知的单元和维度

语言信息非常复杂,语言学中定义了大量不同粒度、不同类型的语言单元,如音位、音节、语素、词、词组、语句等。语言认知研究中关心的一个关键问题是: 这些语言单元只是语言学家便于研究提出的一些概念,还是确实是大脑进行语言理解所依赖的加工单元?大脑在加工这些语言单元时是否激活了细分维度?这些加工维度是什么?这些都是语言认知研究所关注的内容。

由于语言使用者对词、词组、句子等不同粒度的语言信息都敏感[10],因此在语言理解过程中,大脑可能会对多种单元的信息进行加工。研究大脑语言加工单元的一个经典工作是Ding等人[11]提出的稳态范式——设计一组音频实验材料,语音中每秒出现4个音节构成的语句,其中每两个音节可以合成一个词组。利用这种范式,他们研究了大脑编码语言的单元是什么、是否可以同时编码多个层级的语言单元等问题。他们的研究假设是: 如果大脑同时编码了音节、词组和语句单元,而且编码某个语言单元的神经活动应当在时间上与这个语言单元同步,那么大脑编码这些不同大小的语言单元的神经活动将具有不同的更新速率。实验发现: 在听语音的过程中,人脑的MEG/EEG 响应确实包含4Hz、2Hz和1Hz的成分,对应于假设的音节、词组、语句的神经响应,这证明了大脑在理解语言时会同时加工音节、词组和语句单元。

为了研究语言加工的维度,Fernandino 等研究了颜色、形状、感觉运动、声音和操作(manipulation)这5种属性在大脑中的表征[12]。他们选择了900个词,标注了每种特征对词义的贡献程度,并采集了被试阅读每个词时的fMRI数据。通过对每种特征的标注值和各脑区激活程度之间的联系,他们发现这5种属性均在大脑中表征。Binder 等进一步扩展了这项工作,按照大脑的功能划分提出了65个语义属性,包括感觉、运动、空间、时间等[13]。

为了在同一个实验中研究更加全面的语言加工单元及其细分维度,研究人员提出利用计算模型分析词汇或自然文本下采集的人脑活动数据的实验范式。一个典型工作是关于大脑语义编码的维度的研究,Mitchell 等人[14]结合词汇表示方法探讨了大脑表征名词概念的模式,他们采集了被试阅读60 个名词刺激(图片+词汇文本)时的 fMRI 数据,在包含万亿字符的语料库中分别计算这60 个名词和25 个感觉运动相关的代表性动词(如看、听、说、吃等)的共现频率,并当作名词的25 维表示向量;然后利用交叉验证的方法训练这些表示向量预测fMRI数据的回归模型,每次交叉验证都会预测两个测试词汇的fMRI 数据,并和真实的fMRI数据进行对比,计算测试准确率。结果表明,他们采用的语言计算方法建立的回归模型对fMRI数据中名词所诱发的脑激活模式具有显著大于随机值的分类准确率,提示了词表示模型和fMRI数据之间存在直接的可预测的关系,并且表明了大脑表征名词语义时显著依赖感觉运动属性,即大脑表征名词语义的维度包括多种感觉运动属性。不同于上述研究具体概念表征的工作,Wang等人[16]利用语言计算的方法研究了大脑是如何表征抽象词汇概念的,他们采集了被试在理解360个抽象词汇时的fMRI数据,使用Word2Vec方法计算每个词汇的语言表示向量,采用人工评价方法收集了每个词汇的13个语义属性,构造了13维语义表示向量;然后采用表征相似性分析的方法分别研究了抽象词汇的语言属性和语义属性在大脑中的表征。结果表明语言属性编码在语言相关的脑区,而语义属性在大脑中是分布式编码的。为了研究更多的语义信息在大脑中的表征维度,Huth 等人[15]采集了被试收听故事时的fMRI数据,在语料库中选择了985个描述不同主题的基本词汇作为不同的语义属性,接着通过统计共现频率的方式构造了每个词汇的985维向量表示。最后他们训练岭回归模型,使得985维词汇向量预测fMRI数据中的每个体素,同时提取模型中的“985×体素个数”大小的参数矩阵作为985个语义属性的大脑表征。结果表明,不同语义特征在特定的脑区中进行编码,说明了大脑语义表征的维度十分丰富。

Wehbe等人[17]将上述词汇表征维度工作拓展到篇章级别,研究了大脑处理篇章信息时的细分维度。他们使用快速阅读范式采集了被试在阅读自然文本时的fMRI数据,并且对实验刺激材料标注了195个语言属性,包括表层特征(如字母个数等)、句法特征(词性、位置、依存关系等)、语义特征(100维词向量)和篇章特征(某个故事角色等)。他们采用回归预测和交叉验证的方法进行了实验,发现上述语言属性会显著激活某些脑区,说明上述语言属性属于篇章加工的细分维度。

此外,类似的研究工作还有文献[18-23]。此类工作尤其是探讨语言加工维度的,往往也涉及下一节中讨论的脑网络的定位,也可作为下一节的的参考工作。

2 定位不同类型语言信息的脑网络

语言是大脑的功能,但是这项功能到底依赖于大脑的哪些部分呢?这也是语言认知研究所关注的重要问题。神经科学研究发现大脑可以从结构和功能上进行分区,而最早的关于大脑功能分区的证据就来自于失语症研究。失语症研究以及现代神经影像学研究都发现语言不是单一功能,而是包含许多功能模块,因此当前语言认知研究更加关注定位具体功能模块所涉及的脑网络。

关于定位大脑语言理解依赖的脑网络的问题,以往研究大多数采用对比分析的方法[24-34]。如研究句子加工对应的脑区,则设计两组实验变量——一组为正常句子,另一组为一串相同长度的假词序列;然后收集与两组实验刺激对应的大脑激活数据,句子加工对应的脑区就是那些正常句子激活了但是控制材料没有激活的脑区。

不同于上述研究思路,使用计算模型可以研究比人工设计材料更加广泛的语言功能,如细粒度的句法结构、语义组合、语义关系等[14-17,35-44]。下面介绍典型的研究工作。

Reddy等人[35]提出一种新的句法编码方法,用于探究人脑编码句法结构所涉及的脑网络。不同于传统的利用一个数值来编码词汇在某一时刻的句法复杂度/结构的方法,他们提出的方法可以编码每一个时刻词汇更复杂的句法信息,包括层级结构和句法解析规则等。他们使用被试在阅读自然文本时的大脑活动数据,利用提出的句法编码方法计算实验刺激中的每个词汇的句法结构向量,然后使用岭回归方法计算句法结构向量预测大脑不同体素活动数据的准确性。如果句法结构向量可以显著预测某个脑区的人脑活动数据,则说明这个脑区编码了句法结构信息。他们发现: 相比传统方法,他们提出的句法结构向量更显著地预测了大脑语言处理系统的多个脑区,说明了大脑在理解语言时编码了句法结构信息,且使用了大脑语言网络中的多个与语义处理相同的脑区。

类似的还有Wang等人[36]的工作,利用计算模型分别编码句子的语义和语法属性,进而研究了句子语义和语法属性在大脑中的表征。他们使用被试在阅读句子时采集的fMRI数据,并将数据根据Gordon分区模板划分为333个脑区,如此可以得到333个脑区的fMRI向量。他们提出了一种解纠缠的特征表示模型,将句子编码为100维的语义向量和100维的语法向量,然后利用表征相似性分析的方法分别将语义向量和语法向量与333个脑区的fMRI向量进行回归预测,不同脑区的相关性结果为语义和语法属性在这个脑区的编码强度。实验结果表明,相比语法属性,语义属性激活了更多脑区,且两者激活的脑区有部分重叠。

为了定位语义组合操作对应的脑区,Toneva等人[37]提出可以利用计算模型来区分词汇语义和语义组合。具体来说,他们利用ELMo模型对句子进行编码,然后提取每个时刻的词汇表示和隐层表示;接着他们训练了一个线性回归模型,使得当前时刻及之前的词汇表示作为输入来预测当前时刻的隐层表示。由于隐层表示中同时包含了词汇表示和语义组合信息,因此,实际的隐层表示和预测的隐层表示的差值就是语义组合;最后,用神经编码模型就可以计算词汇表示和语义组合操作对应的脑区。他们发现已有研究认为的负责词汇语义表征的脑区也在同时负责加工语义组合,表明了词汇语义表征和组合语义具有共同的神经基础。

借助语言计算方法,Zhang等人[38]定位了语义关系在大脑中的表征。他们采集了不同被试收听故事时的fMRI数据,使用Word2Vec方法计算每个故事词汇的300维词向量,然后训练岭回归模型使300维词向量预测fMRI数据中的每个体素;然后利用词汇间词向量的差值计算词汇间的语义关系,如“手—手指”反映“整体—局部”关系,接着利用岭回归模型中词向量空间到fMRI数据空间的映射关系,将语义关系向量映射到大脑皮层(fMRI数据)空间中,这样就可以研究不同语义关系在大脑中的表征模式。结果表明: 词汇语义表征和语义关系在大脑中都是分布式表征且在空间上是重叠的;相比抽象的语义关系,具象的语义关系会更多地激活额顶页注意网络,更少地激活默认网络。

3 语言信息加工的时间进程和控制

在大脑进行语言加工的过程中,不同模块的加工次序是怎样的?比如大脑是不是会先解析语法结构,然后再理解语义?每个步骤的加工大约需要多少时间?比如大脑经过多长时间可以识别一个词汇中的不同特征?大脑加工语言的步骤和次序是自动化发生的、一成不变的过程,还是受注意力、工作记忆等认知功能的影响和调节?这些也是语言认知研究所关注的内容。

同语言认知的其他研究问题类似,以往的工作多采用人工设计实验材料和对比分析的方法来研究语言加工的时间进程[45-59]。一个例子是,Pylkkänen等人[60]设计两组实验材料——一组为形容词加名词短语(如“read boat”),另一组为非词加名词短语(如“xtp boat”),通过对比两组实验材料在第二个词汇出现时引发的脑激活,就可以找到语义组合操作发生的时间。

利用计算模型研究语言加工的时间进程和控制过程主要有以下两种思路: 一种是利用模型计算语言的表征,例如,Lyu等人[61]利用LDA模型编码词汇语义,进而研究了大脑语义组合过程在何时何处发生及其计算机制。他们首先构造了360个句式为“名词短语+动词+名词”的句子(如“the elderly man ate the apple”),采集了被试在收听这些句子时的MEG信号;然后利用LDA模型计算了名词和动词的主题表示向量,并将两者相乘得到在特定动词限制下的名词的主题表示向量;最后用表征相似性分析方法分别计算了上下文无关的名词主题向量和受到上文动词限制的名词主题向量与相应名词出现600毫秒内MEG信号的相关性。结果发现: 受到动词约束的名词主题向量,在名词出现后198~244毫秒区间内与左侧颞叶和左额下回脑区的活动数据显著相关。这说明在单词出现的早期,大脑只激活了受到上文约束的单词语义子集。后续功能连接分析发现在关键语言脑区出现了自上而下和自下而上的信息流动,这些均说明大脑在进行语义组合的加工。

又如,已有研究发现皮层电信号可以追踪大脑动态处理语音的过程,而且验证了使用人工构造的语句(如句子中包含一个与上文不一致的词汇)作为实验刺激时,大脑处理词汇信息的能力会受到上文的影响。为了探究人在自然语音理解时的大脑处理机制,Broderick等人[62]采集了多个被试在收听自然语音及其反转语音时的EEG数据,然后利用Word2Vec方法计算语音中每个词汇的语义表示向量,接着计算句子中每个词汇向量与上文向量(上文词汇向量的平均值)的余弦相似度,用1减去相似度来模拟词汇在句子中的不一致程度。最后,用词汇的不一致度得分与对应的EEG数据做回归分析。他们通过实验发现: 在200~600毫秒的时间窗内出现了类似传统实验发现的N400效应,且只有在被试理解了语音刺激时(收听自然语音时)才会出现这种效应。这表明人脑在理解自然语音时,会在一个特定的时间处理上文对于词汇理解的影响。相关研究工作还有文献[63-65]。

另一种思路是利用语言计算模型的内部表征。一个代表性的例子是Wehbe等人[66]提出的将循环神经网络语言模型(Recurrent Neural Network Language Model,RNNLM)和大脑在阅读时的工作机制进行类比。他们使用快速阅读范式采集被试阅读故事时的MEG数据,并用训练好的RNNLM模型在这些故事材料上进行预测,如此得到文本对齐的MEG数据和模型预测数据;然后他们取出每个词汇语言模型预测的三种模型向量:①编码历史信息的隐层向量; ②编码当前时刻词汇信息的词向量; ③当前时刻模型输出的概率分布向量。用这三种模型向量来分别解码MEG数据,进而通过对比三种模型向量对特定脑区MEG数据的预测准确率来提示该脑区在特定时刻编码了哪种类型的信息。结果表明: 在看到一个新词汇之前,第一种模型向量就可以准确预测这个词汇的MEG数据,且当看到这个词汇并整合为新的上文之后,第一种模型向量的预测准确率下降;第二种模型向量可以准确预测当前词的MEG数据,而且预测准确率最高的脑区随着时间推进会由视觉皮层移动到负责更高级认知活动的脑区上;第三种模型向量可以准确预测当前词与历史信息整合时的MEG数据。上述结果说明,人脑语言理解过程是首先根据历史信息进行预测,然后理解当前词汇,最后整合历史和当前词汇信息。相关研究工作还有文献[67]。

4 语言信息的神经编码形式和计算机制

对脑区和加工进程的研究主要是在现象上描述语言加工。这些现象到底是如何产生的呢?从计算的角度来说,大脑中进行计算的“数据结构”是什么呢?又是通过什么算法来操作这些数据结构的呢?对加工机制的研究势必涉及数学模型,研究难度也很大。

由于涉及到底层计算机制,因此计算模型在这个问题上具有很大的优势,也得到了成功的应用[68-76]。其中典型的工作有,Li 等人[77]利用多种语言认知模型和神经网络模型来研究大脑理解代词指代关系时的神经机制。他们采集了被试在收听完整故事时的fMRI数据,然后计算与代词解析相关的脑区。结果表明: 理解代词指代关系时会显著激活左前颞中回、左后颞中回前和角回脑区。为了进一步探究大脑解析指代关系时的计算机制,他们首先构造了 5 种针对代词指代消解问题的计算模型,分别是基于句法理论的Hobbs 模型、基于篇章理论的Centering 模型、基于记忆理论的ACT-R 模型、基于神经网络ELMo 结构和BERT 结构的指代消解模型。随后检测了上述模型在解析故事中指代关系的有效性,并将上述模型中计算的代词指代概率与fMRI 数据做相关分析。结果表明,只有基于记忆理论的ACT-R 模型可以显著预测中英文实验材料对应的神经激活数据,表明了大脑在解析代词指代关系时采取了记忆检索策略。

另一项工作是Hale等人[78]使用循环神经网络语法解析(RNNG)模型中产生的语法组合指标研究人脑句法的解析过程。他们采集被试收听故事时的EEG数据,然后使用一部分故事文本训练RNNG模型,并且用训练好的模型解析另一部分故事的文本,最后从中提取每个词的句法组合数据作为回归因子,和EEG数据进行回归分析。结果表明RNNG中提取的句法组合数据引发了EEG早期的句法组合效应和类似P600的效应,在其他没有显式使用句法规则的语法解析器上没有发现类似效应,说明RNNG模型的工作原理在一定程度上可以解释人脑在理解语言时的句法解析过程。

类似的,Martin等人[79]发现一种符号连结模型(symbolic-connectionist)——DORA,在编码句子语义信息时,模型结点会产生与大脑皮层对相同刺激反应时非常类似的振荡激活模式[11]。在使用控制实验材料或者RNN模型处理相同句子时,却没有发现这种激活模式。因此,他们认为DORA模型提供了一种可能性,用于说明大脑如何将感知特征转换为跨越多个时间尺度的分层表示,并且将语言和大脑计算机制相关联。同时,这种使用时间对分层网络中的层次进行编码的计算机制,可以实现组合性,满足语言和其他认知功能的计算要求。结果还表明,大脑皮层的振荡机制可能是人理解语言的计算基础。

另外有研究提出新的语言计算模型来研究大脑语言计算机制。Chien等人[80]通过分析两组被试在不同背景下(先收听一个不同的语音片段)收听相同句子时的fMRI数据发现,两组被试的神经活动最初不同,但是会逐渐趋于一致,而且在脑皮层上呈现出层级结构——感知觉皮层信号最快对齐;其次是中间的脑区,高级皮层的脑区会在10秒后才对齐。另外,他们通过分析两组被试在相同背景下收听不同句子时的数据时,还发现了与传统线性整合模型预测的不同,高级皮层整合信息较慢但是遗忘信息却很快。为了探究这种层级结构背后的计算机制,他们提出一种层级线性整合模型(Hierarchical Linear Integrator),该模型通过非线性整合和上文门控机制,可以灵活整合上文信息,如在新的事件开始时,模型会生成少量依赖上文的响应,并且该模型产生的响应与实际观测的fMRI信号相吻合。这表明了大脑皮层的层级结构在每个时刻都会保留上几个时刻的信息,而且会不断将过去的信息和现在的信息进行整合,在收到不一致的输入时状态也会进行重置。

5 开源数据集

研究大脑语言认知离不开大脑活动数据的采集,尤其是利用计算方法研究语言认知问题更加依赖高质量、大规模、不同类型的大脑活动数据集。本节总结了与语言相关的常用开源神经活动数据集。

(1) Mitchell等人[14]开源的60个实体名词的fMRI数据(1)http://www.cs.cmu.edu/~tom/science2008/。

(2) Wehbe等人[17]开源的被试在阅读包括5 176个词的哈利波特与魔法石第九章的fMRI数据(2)http://www.cs.cmu.edu/~fmri/plosone/。

(3) Pereira等人[81]开源的阅读不同主题的180个词汇和637个句子的fMRI数据(3)https://osf.io/crwz7/。

(4) Zhang等人[38]开源的不同被试听51个故事包括47 356 个词汇的fMRI数据(4)https://osf.io/eq2ba/。

(5) Brennan等人[70,82,83]开源的被试收听《爱丽丝梦游仙境》第一章包括2 169个词汇的fMRI(5)https://openneuro.org/datasets/ds002322/versions/1.0.1和EEG数据(6)https://deepblue.lib.umich.edu/data/concern/data_sets/bg257f92t。

(6) Nastase等人[84]开源的345个不同被试收听27个3~56min故事时的fMRI数据(7)http://datasets.datalad.org/?dir=/labs/hasson/narratives。

(7) Li等人[85]开源的英文、中文、法语母语者在分别收听英文版、中文版、法语版《小王子》时的多语言fMRI数据(8)https://openneuro.org/datasets/ds003643/versions/1.0.2。

(8)Schoffelen等人[86]开源的204个荷兰语母语被试阅读360个正常和对应打乱顺序的句子时的fMRI和MEG数据(9)https://data.donders.ru.nl/collections/di/dccn/DSC_3011020.09_236?0。

(9) Hanke等人[87]开源的20位被试收听电影ForrestGump时的fMRI数据(10)http://openfmri.org/dataset/ds000113。

(10) Ayyash等人[88]开源的共86个被试收听45种母语版《爱丽丝梦游仙境》片段的fMRI数据(11)https://osf.io/cw89s/?view_only=49981c407d784d2e88e bf6087e12fb3a(平均每种语言两个被试)。

6 分析与讨论

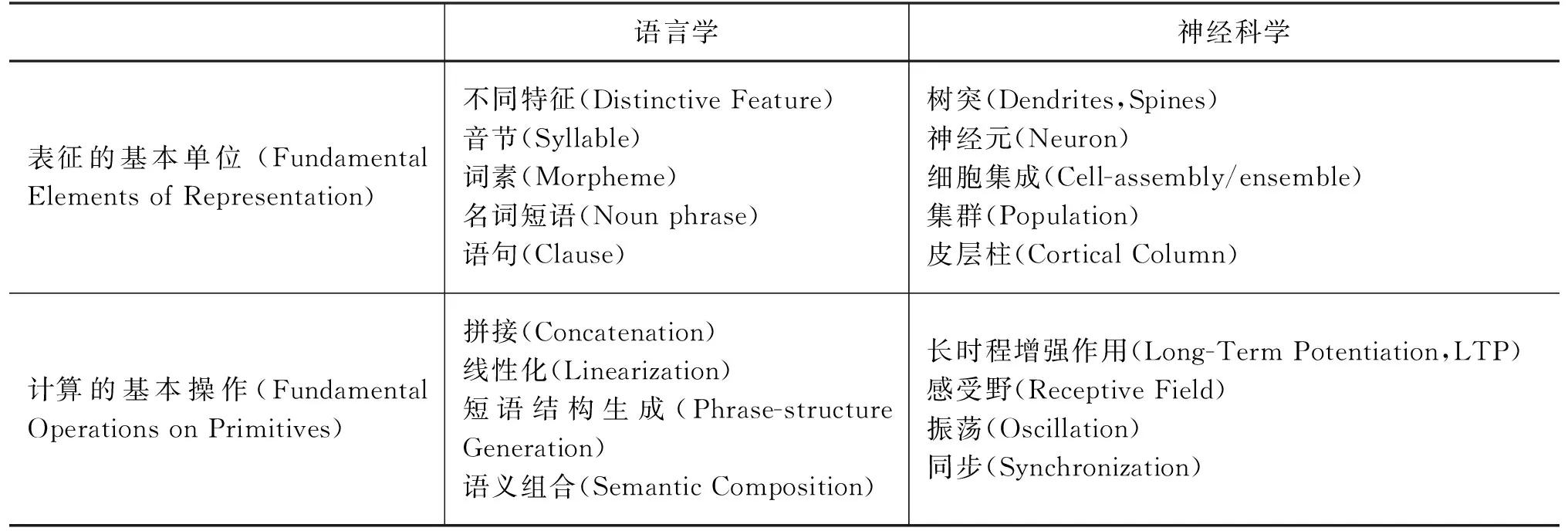

语言认知研究初步揭示了人脑语言理解的部分规律,但是距离真正解析人脑语言理解机理还有很大差距。即使利用语言计算模型的大部分工作也局限于局部问题上的定性解释,缺乏对定量机制的探讨。另外,研究大脑语言认知的底层工作机理,一个重要的思路是将语言认知与更加底层的神经活动进行结合。比如2005年Poeppel 与 Embick 提出的语言认知与底层神经机制研究的对应关系[89]。如表1所示,目前语言认知的研究和神经科学的研究之间存在不匹配的问题,绝大部分语言认知研究仅考虑了语言学理论而忽略了其与神经科学之间的联系。因此,笔者认为,未来在研究人的语言理解问题上,结合计算模型进行语言认知实验大有可为,具体有以下四个重要研究方向。

表1 语言学和神经科学研究间的映射问题(the mapping problem)

(1) 收集多语言多模态神经活动数据。已有的语言认知研究大多局限于使用单一数据采集方式(如仅使用fMRI或MEG)来研究某一种语言的特定语言现象,往往导致得出的结论鲁棒性低和可重复性差的问题。因此,未来的语言认知研究一定是要在多种语言和多种类型的数据上进行多重验证。尤其对于结合计算模型的研究来说,数据的规模和质量直接决定了结果的可靠性,因此利用侵入式和非侵入式的多种工具针对不同语种采集大规模高质量的神经活动数据十分重要。同时,数据的开放和共享也在逐渐成为语言认知研究的趋势,这将会极大地促进语言认知的研究。

(2) 启发新的认知机制假设。语言计算模型的运行过程在一定程度上是透明的、全局的,其计算过程也是可见的,即模型学习到的词汇表示、将词汇表示组合成短语和句子表示的计算方式、预测推理出某一结果的计算步骤都是可观测的。从计算机制层面上解释大脑的工作原理是认知科学的重要任务,笔者认为未来可以深入探索计算模型中的表征和计算模块是否确实可以解释一些脑区在语言加工过程中的神经活动。如果一个脑区的神经活动可以被某种计算模型所解释,那么可以认为这个脑区进行了模型中清晰可见的计算功能。换而言之,我们可以把不同语言计算模型中的各个模块当作大脑计算机制的假设,用认知科学实验进行验证。

(3) 关联多种语言变量和认知功能。语言理解的过程十分复杂,不仅涉及多种语言变量的加工,如词法、句法、语义等,同时也与多个认知功能密切相关,如执行控制、注意力、记忆等。以往的研究往往通过严格控制实验变量来消除其他语言变量和认知功能的影响,在一个实验中只研究某一个语言变量或某种认知功能的作用。笔者认为,结合计算模型进行语言认知实验可以消除上述研究限制。例如,利用计算模型的方法可以分离不同实验变量,在自然文本采集的神经活动数据基础上,研究不同语言变量和认知功能的作用。随着基于神经网络方法的语言计算方法性能不断提升,使得用模型分离不同语言特征越来越准确,从而使得在同一批数据上计算出大脑不同区域在视听觉感知、多模态信息融合和语言理解中的其他功能机制成为可能。

(4) 解析大脑语言理解的底层计算机制。已有的语言认知研究大多基于语言学理论,而语言学与神经科学研究的问题之间存在很大差距,如对于大脑如何操纵最基础的语言单元,语言学主要研究短语结构和语义组合,而神经科学主要关注神经震荡和同步。这就导致了目前语言认知的研究缺乏神经基础,无法匹配神经科学发现的结论。随着脉冲神经网络(Spike Neural Network)和震荡神经网络(Oscillatory Neural Network)的不断发展,未来的计算模型可以尝试融合神经科学的结论来模拟底层神经元的工作模式,同时也可以根据语言学理论对语言单元进行操作从而完成语言理解的任务,这样就为关联语言学和神经科学的研究提供一种新的解决方案。

7 结束语

语言认知的研究是认知科学和脑科学的核心问题之一,不仅对揭示人类语言智能的基础、揭示大脑工作原理的奥秘有重要意义,也有助于推动脑启发的语言智能技术的发展。语言计算模型的快速发展为语言认知的研究注入了新的活力,未来的语言认知实验会更多地利用语言计算方法,这方面的交叉研究的前景非常值得期待。