融合注意力机制和上下文信息的微光图像增强

赵兴运,孙帮勇,2*

1.西安理工大学印刷包装与数字媒体学院,西安 710048;2.中国科学院西安光学精密机械研究所光谱成像技术重点实验室,西安 710119

0 引 言

微光条件下成像时进入镜头的光子数量较少,所形成的图像亮度低,难以分辨颜色和目标结构等信息。尽管通过延长曝光时间可一定程度提高图像亮度,但光学传感器易产生大量噪声。因此,直接获取的微光图像多存在对比度低、噪声大、颜色失真及细节模糊等退化问题。微光图像视觉感受质量差,同时也会影响后续的图像处理任务,如图像分割、目标识别和视频监控等。微光图像增强技术,能够基于一系列数学方法将直接获取的微光图像恢复至正常光照水平,在提升视觉感受质量的同时,也极大提高了后续图像处理任务的精度,因此成为图像处理领域的研究热点之一。

近年来,研究人员针对微光图像增强方法进行了大量研究,也提出了多种有效算法。传统微光图像增强算法主要是基于直方图均衡化(histogram equalization,HE)理论和视网膜(Retinex)理论提出的。HE理论算法通过修改图像直方图达到近似均匀分布,从而增强图像对比度,代表算法有Kim等人(2012)、Celik(2014)方法等,该类方法操作简单、效率高,但生成的图像易受伪影影响、真实感不强。基于Retinex理论的算法利用Retinex理论将图像分解为照明分量和反射分量,其中照明分量只包含图像的光照信息,反射分量包含图像细节信息,然后分别对照明分量和反射分量进行增强处理,最后将处理过的照明分量和反射分量结合以达到增强图像目的。主要代表算法有SSR(single-scale Retinex)(Jobson等,1997a),MSR(multi-scale Retinex)(Jobson等,1997b), 视觉适应性Retinex算法(李权合 等,2010),NPE(naturalness preserved enhancement)(Wang等,2013)和Robust Retinex(Li等,2018)。SSR方法将高斯函数和图像卷积近似表示反射分量,MSR是SSR的改进方法,其采用不同尺度的高斯滤波,对滤波结果进行加权平均来估计照明图像。视觉适应性Retinex算法是在Retinex方法基础上加入视觉适应性。NPE方法利用Retinex理论和log双边转换使光照分量映射更加接近自然色,Robust Retinex方法加入了一个噪声项来处理弱光图像增强。以上方法在照明调节和小噪声消除方面有一定效果,但是,模型中的参数需人工设定,无法自适应处理图像的多样性,并且针对较高噪声的图像处理效果较差,存在局部细节曝光不足或曝光过度等情况。

伴随着人工智能理论的快速发展,基于深度学习的微光图像增强算法陆续提出,Lore等人(2017)提出了一种深度自动编码器网络LLNet(low-light image enhancement network),用于增强对比度和消除噪声。Wei等人(2018)基于Retinex理论,提出RetinexNet(Retinex decomposition for low-light enhancement network),采用两个子网络对原始图像进行分解,并对光照分量进行调整。类似地,Zhang等人(2019)提出的KinD(kindling the darkness)网络,在基于RetinexNet算法分解和重建结构上进行优化,通过添加一个恢复网络来去除噪声。Chen等人(2018)提出了SID(learning to see in the dark)网络,直接从原始数据进行微光图像增强。Wang等人(2019)提出了DeepUPE(underexposed photo enhancement using deep illumination estimation)网络,学习图像—光照映射来预测平滑的光照映射。黄鐄等人(2019)提出了一种条件生成对抗网络的低照度图像增强方法。Jiang等人(2021)提出了一种EnlightenGAN(enlighten generative adversarial network)网络,利用全局—局部鉴别器和自正则注意力机制,实现了网络架构不需要成对图像数据集训练,能够适应真实世界的图像状态,应用领域更加广泛。尽管基于深度学习的方法一定程度上弥补了传统方法的不足,对某一类图像集取得较好的增强效果,但是大多数深度学习微光增强方法严重依赖于数据集质量,且多假定暗光区域没有噪声,或者不考虑噪声在不同照明区域的分布。实际上,以上先验知识与真实图像存在偏差,且完备的现实图像数据集获取难度大,这些都导致现有深度学习模型不能有效地抑制真实图像噪声,难以产生令人满意的视觉质量。

通过对微光图像增强的传统模型和深度学习模型的研究,发现增强真实微光图像主要存在两个挑战性问题,一是独立于空间的图像低照度问题;二是非均匀噪声问题。统计发现,真实微光图像的空间特征分布复杂,不同空间位置进入镜头的光子数量差异很大,造成图像空间中的照度变化性强。现有部分深度学习方法往往在人工生成数据集中能有效提升照度特征,但针对独立于空间分布的低照度问题,在图像整体可视性和曝光不足区域的增强效果都不理想。另外,针对图像采集中引入的非均匀噪声特征,传统模型无法较好解决,而深度学习模型通过简单级联降噪也无法达到理想效果。例如,在图像增强前进行去噪会丢失部分图像细节,高噪声像素信息重建困难,而增强后去噪易导致图像模糊。因此,如何有效地抑制噪声,恢复隐藏在黑暗中的信息,是当前微光增强模型中的另一个挑战。

针对以上提出的两个微光图像增强关键问题,建立了一种融合注意力机制和上下文信息的微光图像增强网络。对于图像噪声位置的不确定性问题,由于不同照明区域存在不同程度的噪声水平,并且部分通道颜色信息对于图像恢复存在干扰因素,本文设计了一个轻量级混合注意力块(mixed attention block,MAB),利用空间位置权重对图像噪声水平较大的区域给予更大的注意,同时利用通道权重强调强相关的颜色信息通道,排除了弱相关信息的干扰,从而更有效地抑制噪声、恢复图像颜色。此外,为了缓解深层网络在提取较高语义特征时丢失部分信息的问题,引入了跨尺度上下文模块,在解码器子网络上聚合不同语义尺度特征,使网络的解码部分仍然能够有效提取浅层特征信息。

本文主要贡献:1)设计了一个混合注意力块用来引导主干网络,提取与微光图像增强任务有关的特征信息,利于网络模型抑制噪声、恢复颜色;2)提出跨尺度上下文模块,有效融合了不同语义尺度的特征信息,综合利用不同特征的信息优势,显著提高了网络的微光增强效果。

1 基本原理

1.1 微光条件下的图像退化模型

图像在形成、记录、处理和传输过程中,由于成像系统、记录设备、传输介质和处理方法的不完善,导致图像质量的下降。微光条件下所获取的图像亮度较低,与正常光照图像相比,微光图像可视为正常图像的退化结果。因此,如图1所示,微光图像退化模型和噪声特征是研究微光图像增强的关键因素(图1中,⨁表示加法运算)。

图1 退化模型流程图

图1中,f(x,y)代表正常光照图像,g(x,y)代表退化后的微光图像,退化过程分为退化函数h(x,y)和加载在图像上的噪声η(x,y),整个图像退化的数学模型为

g(x,y)=f(x,y)*h(x,y)+η(x,y)

(1)

数学上,微光图像退化可解释为正常光照图像经过了一次未知的退化函数卷积,并存在加性噪声η(x,y)的影响。相应地,微光图像增强本质上是利用微光图像来求解正常光照图像的逆问题。然而,受光照条件的不确定性和噪声非均匀性等约束,微光图像退化的拟模型难以准确求解,特别是针对真实微光图像,通过直接求逆所获得的微光图像增强效果不够理想。因此,基于深度学习方法,重点学习微光图像中的空间复杂低照度特征和噪声不均匀特征,建立针对真实微光图像的增强网络。

1.2 基于深度学习的微光图像增强模型

由于微光图像形成中受光源、空间分布、拍摄条件及目标特征等多因素影响,建立完善的低照度退化模型或者准确求解退化的逆过程都存在较大难度,其本质问题是难以通过简单建模获得大量准确的退化描述参数。由于深度学习方法具有利用海量数据处理非线性关系的优势,本文提出一种融合注意力机制和上下文信息的微光图像增强网络,来解决微光图像到高质量无噪声彩色图像的增强重建问题。对于给定的微光图像Ii,假定正常照度的无噪声彩色图像为Ih,则微光图像增强过程可定义为

Ih=F(Ii,σ)

(2)

式中,F代表微光增强网络,σ代表网络中的参数。

因此,基于深度学习方法处理微光增强问题的关键是如何建立能准确重建图像颜色和结构细节的端到端增强网络,以及如何高效地求解出网络参数。本文构建的微光图像增强网络,为有效获取更多图像特征,采用了混合注意力机制并增加了跨尺度的上下文信息融合模块。

1.3 混合注意力机制

在人类的信息获取和分析机制中,视觉系统倾向于关注图像中有助于信息判断的内容,并忽略掉不相关的信息。注意力机制类似人类视觉机制,所建立的模型在优化求解中更多关注有助于执行当前任务的输入特征,给予信息含量高的目标信息较大关注度,从而在有限参数条件下抑制了其他干扰信息。本文微光图像增强网络拟采用的注意力机制,本质是通过网络自主学习获得一组权重系数,并以“动态加权”的方式来强调所感兴趣的区域同时抑制不相关背景区域的机制。

1.3.1 通道注意力模块

图像通道可视为成像空间中具有特定颜色特征的独立信息,但是并非每类颜色信息对于图像增强任务都提供相同的贡献量。为解决该问题,提出的通道注意力机制就是提取更有用的颜色信息,以高权重的形式对有用的颜色信息通道赋予更大关注度。在计算各通道权重时,对于输入图像特征X∈RH×W×C,分别通过挤压函数、激励函数和尺度函数,再训练学习每个通道的最优权重。

首先挤压函数对输入图像特征全局均值求解,计算出每个通道的特征均值作为代表值,计算为

(3)

式中,zc代表第C通道的特征均值,Fsq代表挤压函数,Xc代表第C通道特征,H和W分别代表特征的高度和宽度。

激励函数训练和学习权重,得到一个1维的激励权重来激活每一层通道。

s=Fex(z,W)=σ(f(z,W))=σ(W2δ(W1,z))

(4)

式中,s代表学习到的通道权重,Fex代表激励函数,δ代表ReLU激活函数,σ代表Sigmoid激活函数,W1和W2代表权重,维度分别(C/r)×C是和C×(C/r),W代表权重。

最后利用尺度函数将不同通道的值与计算出的权重相乘,获得增强后的通道信息,即

(5)

1.3.2 空间注意力模块

研究发现,图像中不同空间位置对任务的贡献也不同,因此需要对与任务高相关的区域赋予较大权重。建立空间注意力机制的目的是获取不同位置权重,将图像空间信息通过空间转换模型变换到另一个空间中提取关键信息,为每个位置生成权重掩码加权输出,从而将图片数据中关键的特征标识出来,为图像增强任务提供更有效的信息支持。

空间注意力模块训练中,对于输入特征X∈RH×W×C,空间转换器将输入特征中的空间域信息进行变换,从而提取出较为关键的位置信息。

(6)

式中,Xj代表输入特征图,Di代表卷积生成新的图像特征图,sji代表位置i对位置j的影响,α代表每个位置的权重。

1.4 上下文信息融合机制

不同区域特征对图像增强任务的贡献量不同,上下文信息聚合机制通过综合所有位置信息来提高全局上下文信息的利用率,发挥特征互补优势,弥补特征信息的单一性不足。但现有的上下文融合机制常采用单层或最后一层卷积层的上下文特征,可能会导致所提取的上下文语义信息不足。为防止信息丢失并提高对上下文信息的利用,本文通过跳跃连接将不同尺度、不同分辨率的上下文特征进行融合,从而获取更丰富的特征信息。

2 网络模型

2.1 网络结构

本文提出的微光图像增强网络以U型结构网络为基础框架,主要包含通道注意力模块、编码器、解码器、跨尺度上下文模块以及特征融合模块几部分。如图2所示,所建立的增强网络是一种端到端结构,网络主要由混合注意力块(MAB)为基础,输入为待增强的微光图像,输出为同尺寸增强后的高质量无噪声彩色图像。

图2 网络结构图

建立的微光增强网络在提取原始微光图像浅层特征后,首先利用通道注意力模块学习每个通道的权重,为有用的颜色信息通道赋予更大的权重,以提取更多有效的图像颜色特征。然后,通道权重与原始微光图像一起作为编码器的输入,由MAB模块提取图像的语义特征。MAB分别在空间信息和通道信息对输入特征进行特征提取,通过聚焦图像中噪声位置和不同通道颜色特征,从而有助于恢复图像的亮度、颜色信息并抑制噪声。在解码器部分,采用反卷积将MAB提取的语义特征恢复高分辨率图像。另外,本文网络使用了跨尺度上下文模块,在常规的编码、解码对应尺度特征进行跳跃连接基础上,又加入了跨尺度跳跃连接,将图像的深层特征与浅层特征进行聚合,使网络具有更加全面的特征信息,有利于生成高质量无噪声增强图像。

2.1.1 混合注意力块

混合注意力块(MAB)通过将空间注意力与通道注意力混合,弥补了空间注意力和通道注意力的各自缺陷,在得到空间权重的同时保证了通道之间的信息交互,有效帮助网络模型抑制微光图像噪声并恢复颜色。在该注意力模块下,对于输入特征图,首先利用空间注意力模块获取不同位置权重,为每个位置生成权重掩码并加权输出;然后将得到的这些空间信息权重输入至通道注意力模块,进行颜色特征的提取。最后将包含图像空间和颜色信息的特征通过卷积操作筛选出重要特征,去除冗余特征。该过程可表示为

Af=Ac(As(x))

(7)

式中,Af代表混合注意力块,Ac代表通道注意力模块,As代表空间注意力模块,x代表输入特征图。

通道注意力模块结构如图3所示,对于输入图像,首先利用空间维度卷积对图像各通道进行全局池化操作,得到每个通道的代表值。然后使用两个卷积层和激活函数学习通道之间的关系。其中第1个卷积层后面是ReLU激活函数,第2个卷积层后面是Sigmoid激活函数,以学习有效的颜色信息。

图3 通道注意力结构图

空间注意力模型结构如图4所示,首先对输入特征图进行全局平均池化操作,来增大感受野以便获取更多信息,然后通过卷积操作来获取3个代表不同信息的特征图,将其中两个特征进行融合并经过Softmax激活函数,再与第1个特征图进行卷积得到最后的空间信息权重。

图4 空间注意力结构图

2.1.2 跨尺度上下文和融合模块

传统的跳跃连接只在编码器和解码器子网的相同尺度的特征映射上进行聚合,易造成部分全局信息的丢失等问题。因此,重新设计跳跃连接,在解码器子网络上聚合不同语义尺度的特征,形成高度灵活的特征融合方案,使得网络解码部分依然具有网络的浅层特征信息。设计的跨尺度上下文模块,利用反卷积将所有编码层特征上采样至原始微光图像大小,并将得到的这些同尺度的深层特征和浅层特征在维度上通过串联合并在一起,并将合并后的特征图作为融合模块输入。

本文融合模块主要为融合跨尺度上下文模块提取大量深层特征和浅层特征,并在卷积后进行输出。特征融合模块本质是更好地整合跨尺度上下文模块提取的重要特征信息,更好地恢复图像的纹理以及颜色一致性。融合模块结构如图2中对应部分所示,输入为跨尺度上下文模块的输出特征图,首先利用MAB混合注意力块对输入特征图进行特征提取,提取出重要的深层与浅层特征,以便于更好地进行图像恢复。然后再次利用MAB混合注意力块将重要的深层与浅层特征进行特征信息的融合交会。最后利用2维卷积以及ReLU激活函数对特征图进行通道压缩,输出增强图像。

2.2 损失函数

为了获得更高的视觉质量,本文应用3个损失函数来训练网络的输出,即

Ltotal=(1-λs-λp)L1+λsLssim+λpLperc

(8)

式中,L1代表像素级别的L1范数损失,Lssim代表结构相似性损失,Lperc代表感知损失,λs、λp是相对应的网络系数。为了平衡各种损失函数,在实验中相继引入了不同的超参,以便获得与每个损失函数相对应的满意系数。经过大量的对比实验,最终设置λs=0.2,λp=0.1。

1)L1损失。为了测量预测图像和真实图像之间的差异,使用L1损失函数(Lai等,2019),L1损失可以很好地处理异常值,提高模型性能。具体为

(9)

式中,Igt代表真实图像,Ih代表预测图像,=10-6。

(10)

式中,μ和σ2分别代表图像像素平均值和方差,C1、C2为常量。

3)感知损失。为了保持感知和细节的保真度,使用结构感知损失(Johnson等,2016)来约束真实图像和预测图像之间的差异。感知损失用于测量真实图像和预测图像之间的高级差异,以保持感知和语义保真度。计算为

(11)

式中,Hj和Wj分别代表第j特征图的高度和宽度,Cj代表通道,φ()代表在预先训练的VGG16(Visual Geometry Group layer 16)模型中获得的特征图。

3 实验结果与分析

3.1 数据集及实验设置

实验使用Wei等人(2018)提供的LOL(low-light dataset)数据集,数据集中的图像分为室内和室外两种场景,为微光环境下真实拍摄获取的微光图像。取LOL数据集中前689对图像作为训练集,后100对图像作为测试集。另外,为了使模型具有更好的泛化性能,训练集中又加入900幅合成图像用于训练网络。除LOL测试集以外,实验还在MEF(multi-exposure image fusion)(Ma等,2015)、LIME(low-light image enhancement via illumination map estimation)(Guo等,2017)、DICM(different images collected from multiple cameras)(Lee等,2013)、VV(vassilios vonikakis)(Vonikakis等,2008)和NPE(naturalness preserved enhancement)(Wang等,2013)等方法的标准数据集上评估本文方法性能。

实验环境采用Windows 10系统,通过Nvidia GTX 2080Ti显卡对网络进行加速训练,应用Python编程语言和Pytorch框架来实现网络搭建。网络参数中,批处理大小为4,epoch为2 000次,使用ADAM优化器进行优化,前1 000轮次生成模型的学习率为0.000 1,后1 000轮次生成模型的学习率每隔500轮次缩小为原来的0.5倍。

为定量评价不同方法的微光图像增强性能,采用3个不同的有参考客观评价指标:峰值信噪比(peak signal-to-noise ratio, PSNR)、结构相似性(SSIM)和图像感知相似度指标(perceptual image patch similarity,LPIPS)(Zhang等,2018)。PSNR是基于对应像素点间的误差,即基于误差敏感的图像质量评价,测量图像之间的保真度。SSIM更多地考虑图像结构。LPIPS评价图像特征之间的感知距离。越高意味着越不同,越低意味着越相似。LPIPS计算为

(12)

3.2 实验结果

为了验证本文方法的有效性,将本文方法和MBLLEN(multi-branch low-light image/video enhancement network)(Lyu等,2018)、RetinexNet(Wei等,2018)、GLADNet(global lighting and detail protection network)(Wang等,2018)、SIE(self-supervised image enhancement)(Zhang等,2020)、Zero-DCE(zero-reference deep curve estimation)(Guo等,2020)等现有主流方法进行性能比较。为了公平对比,实验中使用这些方法提供的公开可用的代码和所推荐参数设置。

3.2.1 主观评价结果

首先在LOL测试集上,将本文增强后的微光图像视觉效果与对比方法进行比较。如图5所示,实验选取了LOL测试集上具有代表性图像的可视化结果,其中微光图像增强噪声干扰和颜色失真是最常见的问题。可以看出,RetinexNet和Zero-DCE方法可视化结果最差,Zero-DCE方法不能充分提升图像亮度,增强结果还存在部分区域亮度不足情况,RetinexNet方法虽然在图像亮度提升方面优于Zero-DCE方法,但增强图像放大了噪声,严重影响了图像质量。GLADNet、SIE和MBLLEN方法增强效果较前两种方法明显提升,都能够正确地提高图像的亮度,同时没有出现噪声放大现象。但在细节方面,GLADNet、SIE和MBLLEN方法都存在颜色失真情况,GLADNet方法增强结果整体偏黄,图像整体看起来不自然。SIE和MBLLEN方法的增强结果虽然在图像颜色方面优于前者,但图像颜色过饱和,出现了与参考图像颜色不一致现象。通过观察本文方法增强的微光图像,其整体对比度略高于参考图像,但在颜色细节和噪声抑制方面优于其他所有对比方法。在大部分图像应用场景下本文算法都能够做到图像细节和纹理信息的精确还原,但在针对草地、树木以及绿色植被等这类图像时,本文方法的增强结果同样存在颜色失真现象,其主要原因是这类图像整体图像颜色较为单一,图像整体通常显现为暗绿色,图像细节之间层次不分明,导致MAB块无法强调重要的颜色信息。

图5 LOL数据集上不同方法处理的可视化结果

实验还在MEF、LIME、DICM、VV和NPE 这5种公共数据集进行了主观评价,分别选取每个数据集上具有代表性图像可视化结果如图6所示。这5种数据集与LOL数据集有很大的差别,主要是原始微光图像都具有一定亮度,并非在极度黑暗条件下拍摄所得,存在主要缺陷是图像局部区域曝光不足。可以看出,MBLLEN和GLADNet方法在提升图像亮度方面存在缺陷,如图6(b)(d)所示,增强结果依然存在曝光不足区域,但基本上能够正确地恢复图像颜色。RetinexNet和SIE方法在提升图像亮度方面要明显好于前两者,但是放大了图像噪声,颜色方面也存在颜色失真,图像看起来不自然。RetinexNet的增强结果视觉效果最差,图像的结构与纹理过于突出。SIE的增强结果还存在部分区域曝光过度,如图像的天空区域。Zero-DCE和本文方法在图像亮度提升、颜色恢复以及噪声抑制都有很好的效果,不过Zero-DCE在亮度提升方面略低于本文方法,如图6(d)(e)所示。综上所述,本文方法效果无论在LOL数据集还是在MEF、LIME、DICM、VV和NPE公共数据集都取得了较好的视觉效果,表明了本文方法在图像亮度提升、噪声抑制、颜色恢复以及保持图像结构纹理方面的优势。

图6 不同公共数据集上不同方法处理的可视化结果

3.2.2 客观评价结果

除了主观评价分析本文方法的图像增强效果外,实验还进行了定量比较。在100对LOL数据集上选用有参考图像质量评价指标PSNR、SSIM和LPIPS进行定量评估,评价指标结果如表1所示。可以看出,本文方法在PSNR、SSIM和LPIPS都取得了更好的结果,比其他方法的最优值分别提高了0.74 dB、0.153和0.172。表明本文方法的网络在图像亮度提升、噪声抑制、图像纹理结构和颜色一致性方面的优势。

表1 不同方法在LOL测试数据集上客观评价指标

另外,从网络模型总参数量方面分别和对比算法进行了定量比较。MBLLEN、RetinexNet、GLADNet、SIE、Zero-DCE算法模型的总参数量分别为450 171、4 443、931 523、485 604、79 416,本文方法模型的总参数量为2 861 187,本文方法与对比方法相比,参数量高于对比方法,但与同类别的注意力机制算法相比,例如Swin-Unet(Cao等,2021)模型的参数总量是本文方法参数总量的10倍左右。本文方法在注意力机制领域属于轻量级算法,对于单幅图像处理仅需0.015 s。

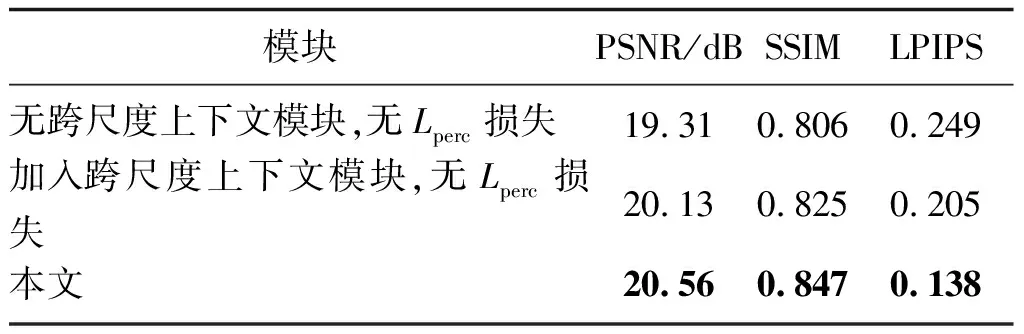

3.3 消融实验

为了验证所提出网络中跨尺度上下文模块和感知损失函数的有效性,进行消融实验。表2量化了跨尺度上下文模块和感知损失函数的有效性。通过主观评价和客观指标对比可以看出,加入跨尺度上下文模块与Lperc损失能够有效提高增强结果与参考图像的一致性,并在PSNR、SSIM和LPIPS评价指标都有较大的提升。消融实验中部分代表性测试图像的视觉效果如图7所示。

表2 不同模块在LOL测试数据集上客观评价指标

图7 跨尺度上下文模块和感知损失函数消融实验结果比较

从图7中可以看出,没有加入跨尺度上下文模块和Lperc损失时,增强后的图像出现颜色恢复不一致,并存在轻微噪声,但能够正确提升图像的亮度。加入跨尺度上下文模块后,增强的图像在颜色一致性方面有很大的提升,能够正确恢复图像颜色,但在图像纹理方面还存在缺陷。加入Lperc损失后,增强图像在颜色恢复、噪声去除以及结构纹理方面都有很好的视觉效果,并基本与参考图像一致。消融实验表明本文提出的跨尺度上下文模块与Lperc损失的有效性,可以很好地提高输出图像质量,增加了图像的对比度,能够正确地保留图像的颜色的一致性,并在一定程度上消除噪声。

4 结 论

本文旨在解决微光图像中存在的曝光不足、噪声干扰和颜色不一致等问题,提出一种融合注意力机制和上下文信息的微光图像增强方法。首先基于注意力机制,构建一个混合注意力块,以聚焦曝光不足区域的噪声,同时学习了图像颜色特征帮助恢复图像颜色信息,有效地抑制了图像噪声、恢复颜色。另外,构建跨尺度上下文模块,重新设计跳跃连接,在解码器子网络上聚合不同语义尺度的特征,形成高度灵活的特征融合方案。在网络的解码部分依然具有网络的浅层特征信息,显著提高网络增强性能。在网络训练中加入感知损失,使网络更加注重图像感知细节的恢复,使模型获得更佳的处理低照度图像的能力。最后通过实验,主观和客观地比较了本文方法与现有方法对低照度图像的处理效果,结果表明本文方法具有更好的低照度图像增强效果。

本文方法一定程度解决了微光图像存在的曝光不足、噪声干扰和颜色不一致等问题,但针对草地、树木等颜色较为单一或结构层次不明显的图像时,本文方法较难精确重建颜色信息,仍存在一定的改进空间。后续工作中,如何结合新提出的深度学习理论和网络模型,有效降低颜色失真程度,提高微光图像重建模型的泛化能力,是重要的研究方向。

参考文献(References)

Cao H, Wang Y Y, Chen J, Jiang D S, Zhang X P, Tian Q and Wang M N.2021.Swin-Unet: unet-like pure transformer for medical image segmentation[EB/OL].[2021-06-27].https://arxiv.org/pdf/2105.05537.pdf

Celik T.2014.Spatial entropy-based global and local image contrast enhancement.IEEE Transactions on Image Processing, 23(12): 5298-5308[DOI: 10.1109/TIP.2014.2364537]

Chen C, Chen Q F, Xu J and Koltun V.2018.Learning to see in the dark//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Salt Lake City, USA: IEEE: 3291-3300[DOI: 10.1109/CVPR.2018.00347]

Guo C L, Li C Y, Guo J C, Loy C C, Hou J H, Kwong S and Cong R M.2020.Zero-reference deep curve estimation for low-light image enhancement//Proceedings of 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Seattle, USA: IEEE: 1777-1786[DOI: 10.1109/CVPR42600.2020.00185]

Guo X J, Li Y and Ling H B.2017.LIME: low-light image enhancement via illumination map estimation.IEEE Transactions on Image Processing, 26(2): 982-993[DOI: 10.1109/TIP.2016.2639450]

Huang H, Tao H J and Wang H F.2019.Low-illumination image enhancement using a conditional generative adversarial network.Journal of Image and Graphics, 24(12): 2149-2158(黄鐄,陶海军,王海峰.2019.条件生成对抗网络的低照度图像增强方法.中国图象图形学报,24(12): 2149-2158)[DOI: 10.11834/jig.190145]

Jiang Y F, Gong X Y, Liu D, Cheng Y, Fang C, Shen X H, Yang J C, Zhou P and Wang Z Y.2021.EnlightenGAN: deep light enhancement without paired supervision.IEEE Transactions on Image Processing, 30: 2340-2349[DOI: 10.1109/TIP.2021.305 1462]

Jobson D J, Rahman Z and Woodell G A.1997a.Properties and performance of a center/surround retinex.IEEE Transactions on Image Processing, 6(3): 451-462[DOI: 10.1109/83.557356]

Jobson D J, Rahman Z and Woodell G A.1997b.A multiscale retinex for bridging the gap between color images and the human observation of scenes.IEEE Transactions on Image Processing, 6(7): 965-976[DOI: 10.1109/83.597272]

Johnson J, Alahi A and Li F F.2016.Perceptual losses for real-time style transfer and super-resolution//Proceedings of the 14th European Conference on Computer Vision.Amsterdam, the Netherlands: Springer: 694-711[DOI: 10.1007/978-3-319-464 75-6_43]

Kim W, Jeong J and You J.2012.Contrast enhancement using histogram equalization based on logarithmic mapping.Optical Engineering, 51(6): #067002[DOI: 10.1117/1.OE.51.6.067002]

Lai W S, Huang J B, Ahuja N and Yang M H.2019.Fast and accurate image super-resolution with deep laplacian pyramid networks.IEEE Transactions on Pattern Analysis and Machine Intelligence, 41(11): 2599-2613[DOI: 10.1109/TPAMI.2018.2865304]

Lee C, Lee C and Kim C S.2013.Contrast enhancement based on layered difference representation of 2D histograms.IEEE Transactions on Image Processing, 22(12): 5372-5384[DOI: 10.1109/TIP.2013.2284059]

Li Q H, Bi D Y, Ma S P and He Y B.2010.Image enhancement based on Retinex and vision adaptability.Journal of Image and Graphics, 15(12): 1728-1732(李权合,毕笃彦,马时平,何宜宝.2010.基于Retinex和视觉适应性的图像增强.中国图象图形学报,15(12): 1728-1732)[DOI: 10.11834/jig.20101221]

Li M D, Liu J Y, Yang W H, Sun X Y and Guo Z M.2018.Structure-revealing low-light image enhancement via robust retinex model.IEEE Transactions on Image Processing, 27(6): 2828-2841[DOI: 10.1109/TIP.2018.2810539]

Lore K G, Akintayo A and Sarkar S.2017.LLNet: a deep autoencoder approach to natural low-light image enhancement.Pattern Recognition, 61: 650-662[DOI: 10.1016/j.patcog.2016.06.008]

Lyu F F, Lu F, Wu J H and Lim C.2018.MBLLEN: low-light image/video enhancement using CNNs//Proceedings of the 29th British Machine Vision Conference 2018.Newcastle, UK: BMVA Press: 1-13

Ma K D, Zeng K and Wang Z.2015.Perceptual quality assessment for multi-exposure image fusion.IEEE Transactions on Image Processing, 24(11): 3345-3356[DOI: 10.1109/TIP.2015.2442920]

Vonikakis V, Andreadis I and Gasteratos A.2008.Fast centre-surround contrast modification.IET Image Processing, 2(1): 19-34[DOI: 10.1049/IET-IPR:20070012]

Wang R X, Zhang Q, Fu C W, Shen X Y, Zheng W S and Jia J Y.2019.Underexposed photo enhancement using deep illumination estimation//Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Long Beach, USA: IEEE: 6842-6850[DOI: 10.1109/CVPR.2019.00701]

Wang S H, Zheng J, Hu H M and Li B.2013.Naturalness preserved enhancement algorithm for non-uniform illumination images.IEEE Transactions on Image Processing, 22(9): 3538-3548[DOI: 10.1109/TIP.2013.2261309]

Wang W J, Wei C, Yang W H and Liu J Y.2018.GLADNet: low-light enhancement network with global awareness//Proceedings of the 13th IEEE International Conference on Automatic Face and Gesture Recognition(FG 2018).Xi′an, China: IEEE: 751-755[DOI: 10.1109/FG.2018.00118]

Wang Z, Bovik A C, Sheikh H R and Simoncelli E P.2004.Image quality assessment: from error visibility to structural similarity.IEEE Transactions on Image Processing, 13(4): 600-612[DOI: 10.1109/TIP.2003.819861]

Wei C, Wang W J, Yang W H and Liu J Y.2018.Deep retinex decomposition for low-light enhancement//Proceedings of the 29th British Machine Vision Conference 2018.Newcastle, UK: BMVA Press: 1-12

Zhang R, Isola P, Efros A A, Shechtman E and Wang O.2018.The unreasonable effectiveness of deep features as a perceptual metric//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Salt Lake City, USA: IEEE: 586-595[DOI: 10.1109/CVPR.2018.00068]

Zhang Y, Di X G, Zhang B and Wang C H.2020.Self-supervised image enhancement network: training with low light images only[EB/OL].[2021-06-27].https://arxiv.org/pdf/2002.11300.pdf

Zhang Y H, Zhang J W and Guo X J.2019.Kindling the darkness: a practical low-light image enhancer//Proceedings of the 27th ACM International Conference on Multimedia.Nice, France: ACM Press: 1632-1640[DOI: 10.1145/3343031.3350926]