基于语义自适应编码的汉-越伪平行句对抽取方法

郭军军,田应飞,余正涛,高盛祥,闫婉莹

(1. 昆明理工大学 信息工程与自动化学院,云南 昆明 650500;2. 昆明理工大学 云南省人工智能重点实验室,云南 昆明 650500)

0 引言

平行语料库的规模和质量对机器翻译的性能存在重要的影响。但平行语料库的构建成本很高,因为其需要相关领域人员的专业知识,在面对低投资语言时,平行语料的稀缺性问题显得更加严重,其中,汉语到越南语就属于低资源语言。通过大量的文本研究发现,在汉语和越南语之间存在着丰富的汉-越段落级可比语料库,这里可比语料库指的是主题对齐但非句子对齐的多语言文本的集合。如表1所示,汉语和越南语段落级的可比语料库中存在语义非常接近的句子对。伪平行句对抽取的目的就是从这些大量的可比语料库中挖掘出语义更加接近、质量更高的句子,以增加数据的数量和所覆盖域的范围。

表1 汉-越可比语料库中存在语义非常相似的句子

传统的解决思路是利用词嵌入的方式对齐句子中的短语,然后提取平行句子。例如,Benjamin[1]等提出了一种无须依赖任何文档级信息即可从一对大型单语语料库中提取伪平行句子的新方法,该方法首先利用词嵌入有效评估了数万亿个候选句子对,然后使用分类器进行查找,提升了神经机器翻译的性能;Minh Thang Loung[2]等使用双语单词嵌入模型学习单词表示后,使用相似矩阵上的卷积神经网络对一对句子是否对齐进行分类,从而提取平行句子;Sanjika[3]等探索了三种短语对齐方法来检测词嵌入在可比较句子中的并行短语对,当出现大量短语对候选时,可检测平行短语对。虽然这些方法取得了一定的性能,但传统的神经网络构建的深度学习体系结构不能够充分学习单词语义之间的依赖关系,导致句子表征能力不足,语义信息不充分,提取到的句子噪声较大,质量不高。

本文针对上述问题,并结合汉-越句子特性,受Zhang[4]等人思想的启发,提出了一个基于语义自适应编码的伪平行句提取系统,在编码端设置了一个思考模块,根据句子中单词表征难易的不确定性,引导模型使用更深层次的计算,进一步对源语言和目标语言进行句子上下文特征提取,深度挖掘句子中不同单词的语义信息,精炼每个时间步长的表示,并将深度表征的句子向量映射到统一的公共语义空间中,最大化表示句子之间的语义相似性。在本文方法中,我们针对的是汉语到越南语两种语言,由于汉语到越南语没有公开的数据集,所以我们把从维基百科文章中抽取的汉-越段落语料以及收集的汉-越段落语料添加到一个语料库中,以训练模型的性能。

1 相关工作

从可比语料库中提取伪平行句子并构建平行语料库提升机器翻译性能,对于低资源语言来说是行之有效的一种方法,最理想的方法是手工进行抽取,但是这样的成本比较高。利用统计机器翻译和神经机器翻译两种方法从可比语料库中抽取句子是比较有效的方法,也分别有学者进行了研究。在统计机器翻译方法中,Rauf[5]等人提出了用统计机器翻译的方法翻译可比语料库的源语言部分,并将这些翻译作为查询,从可比语料库的目标语言方面进行信息检索生成平行语料库,提高了统计机器翻译的性能;而Rauf[6]等的工作是翻译可比语料库的源语言,然后与目标句子比较,以在目标语言找到候选句子;Alberto Barron Cedeno[7]等提出了一种从维基百科自动提取域内可比语料库的模型,可以自动提取单语和可比较的文章集,并按需为语言对和领域提供一键式生成并行语料库,改善了机器翻译质量,并将其应用于特定领域的语料库。虽然上述方法取得了一定的成就,但是需要在翻译模型性能比较好的基础上才能进行,同时在信息检索技术中存在词语语义信息不足的问题。

而在神经机器翻译方法中,Chehui Chu[8]等提出了一种基于深度学习架构的平行句对抽取模型,该模型包括一个候选平行句对筛选器和一个平行句对判别器。基于维基百科数据的实验结果表明,本文所提方法在平行句对抽取的准确性和统计机器翻译性能上均优于已有基线模型。而Francis Gregoire[9]等是基于双向递归神经网络分别对源语言和目标语言进行编码,然后经过分类器区分源句子和候选目标句子是否平行;Cristina Espana Bonet[10]等通过测量翻译之间的相似度以及语义相关和语义不相关的句子对来评估语言对的质量和有效性,然后结合上下文向量和相似性度量在可比语料库中识别平行句子,达到了预期的效果;Juryong Cheon[11]等提出了一种基于语言资源查找相似句子的方法,用于从维基百科构建英语和韩语之间的平行语料库;Resnik[12]等提出了一种基于HTML从Web中提取相似文档的方法;Talvensaari[13]等提出了一种利用主关键词从源语言到目标语言的翻译词找到相似文档的方法。综上所述,这些方法都是从句子级扩充训练数据,然后构建高质量的平行语料库。虽然他们的方法都能很好地抽取伪平行句子,改善机器翻译的性能,但都是针对资源丰富语言(如英语-法语),而在低资源语言(如汉语-越南语)上性能则较差,同时提取到的句子噪声较大。本文在神经网络模型的基础上,引入了语义自适应编码的方法,更深层次地挖掘汉语和越南语的语义特征,然后比较它们之间的语义相似度,从而提取更高质量的汉-越伪平行句子,提升低资源下汉-越神经机器翻译的性能。

2 基于语义自适应编码的伪平行句对抽取模型

针对汉-越伪平行数据抽取的问题,本文在语言模型中增加语义自适应编程模块,提升模型对句子的语义表征能力,进而提高伪平行句对抽取的性能,最终提升机器翻译的性能。本文方法主要包括双语同步编码器,分别对源语言和目标语言进行编码,设x={x1,x2,…,xm}表示源语言句子,m为源语言句子的长度,y={y1,y2,…,yn}表示目标语言句子,n为目标语言句子的长度。其中,编码器是堆叠的两层长短期记忆网络(lony short-term memory,LSTM),思考模块由竖向LSTM组成,同时对源语言和目标语言深度挖掘语义信息,以改善单词表示与句子上下文连接之间的文本信息,然后将深度表征的文本信息映射到统一的公共语义空间中,最大化表示句子之间的相似性。

2.1 语义自适应编码模型

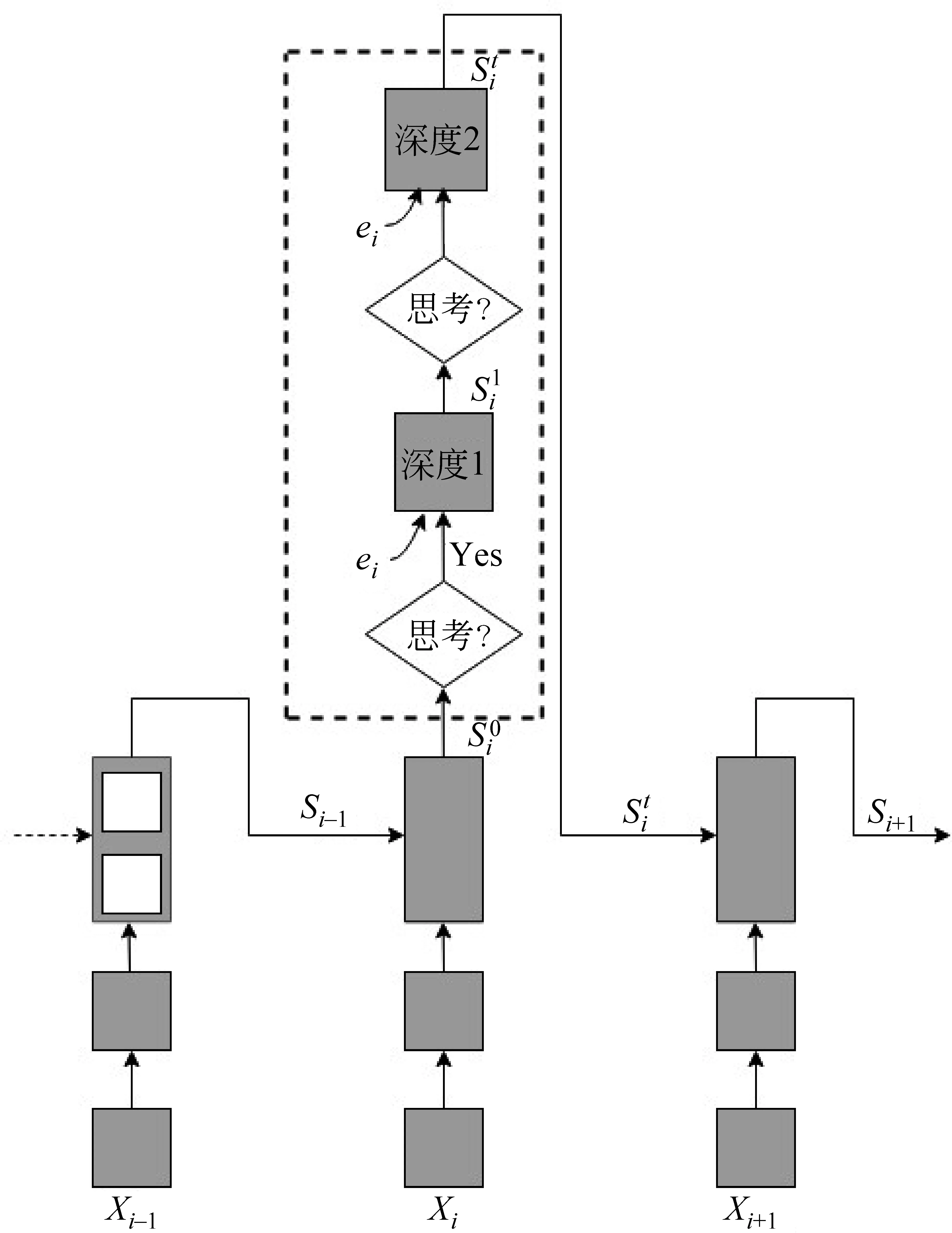

本节首先介绍语义自适应编码模型,该模型结构由编码器、思考模块和预测模块组成。模型结构体系如图1所示。

图1 语义自适应编码结构体系

2.1.1 编码器

其中,E表示单词嵌入,φ(·)是LSTM模块。

2.1.2 思考模块

(1) 深度语义自适应思考模块

在语义自适应思考模型中,根据句子最大长度定义竖向LSTM思考模块,每个输入单词分别对应每一竖向LSTM思考模块,在竖向LSTM思考模块中,进行竖向的信息交流,当要更新状态si时,用上一时刻的状态si-1根据式(5)进行计算,模型进入思考模式,如图2所示,该模型的关键特征就是在预测标记前自适应地选择思考模块的深度。

图2 语义自适应思考模块为简洁起见,仅显示si的思考模式以及前面两个思考深度, 最大思考深度为t=3。

si=fLSTM([ei;hi;ci;flag],si-1)

(5)

其中,ei是每个单词的词嵌入向量;hi是每个时刻的隐藏状态;s0初始化为h0;flag是我们连接到输入嵌入的标记,取1或0,其中0表示停止思考,1表示继续进行思考。[·,·]表示向量的拼接。ci是上下文向量,由式(6)进行计算:

(6)

其中,αi是全局注意力向量,hi是每个时刻的隐藏状态。为了表示清晰,我们只列出了源句子的思考状态si,对于目标句子的思考状态tj也采用同样的方式进行计算。

(2) 语义相似性度量模块

为了评估每个词在句子中的语义相似度,状态si进一步发送到语义相似性度量模块,借鉴Zhang[4]等人的处理思路,本文使用方差来表征模型的不确定性Un(si)=Var(q),语义相似度计算模块如式(7)、式(8)所示。

Un(si)=min(γ,Var(q))/γ

(7)

(8)

其中,p是根据思考状态si预测下一个词yi+1的概率,θi是第i个前向传递中受Dropout影响的所有扰动参数的集合,F为思考次数,在本文中参数γ=0.15。模型连续地从动作空间A={Ponder,Stop}中做出决策,每次选择a∈A。如果方差大于或等于规定的决策阈值,模型就停止思考,如式(9)所示。

(9)

如果方差小于规定的决策阈值,模型重新进入思考,再次使用式(5)进行状态更新,同时对输入使用相同的词嵌入ei,如式(10)所示。

(10)

2.2 预测模块

预测模块由一个带sigmoid的前馈神经网络组成,首先把思考模块的每个时刻的输出状态进行拼接,得到源句和目标句的最终表示形式,将最终表示形式输入到前馈神经网络,该神经网络计算它们平行的概率,如式(11)、式(12)所示。

其中,si和tj分别表示源句子和目标句子的最终表示形式,σ(·)是sigmoid激活函数,W(1)∈Rdf×dh,W(2)∈Rdf×dh,v∈Rdf,b∈Rdfb分别是模型参数,df是前馈神经网络中隐含层的大小。对于预测,如果句子对的概率大于或等于设置的决策阈值ρ,则将其分类为平行;如果小于决策阈值ρ,则将其分类为不平行。

(13)

3 实验和结果

为了评估本文方法从可比语料库中抽取伪平行句子的有效性,我们进行了多次实验比较。在3.1节中,将介绍进行实验的数据集;3.2节介绍实验设置;3.3节中介绍了实验的结果并分析模型在提取汉-越伪平行句子方面的性能;3.3.4节中将提取到的汉-越伪平行句子作为训练数据,评估机器翻译系统的性能。

3.1 数据集

由于在汉语到越南语低资源语言上,目前尚未找到用于训练的公开数据集,所以我们利用汉-越平行词典从汉语到越南语段落级可比语料库中预筛选了20万对的汉语到越南语候选句子以及从维基百科中随机抽取了10万对的汉语到越南语候选句子,组成了训练数据集。表2列出了训练数据的规模。

表2 实验数据集

3.2 实验设置

本文模型利用PyTorch编写实现, 单词嵌入维度和隐藏单元数均为512,批处理大小设置为64,最大思考步数设置为3,学习率设置为0.000 3,采用指数级的学习率衰减策略,Droupt设置为0.3,使用Adam优化器。为了评估模型的性能,本文分别用精度、召回率和F1得分进行评估。精度是所有提取的句子对中真正平行句子对的比例;召回率是测试集中所有平行句子对中真正平行提取的句子对的比例;F1得分是精度和召回率的调和平均值。

3.3 实验结果

3.3.1 语义自适应编码模型的实验结果及分析

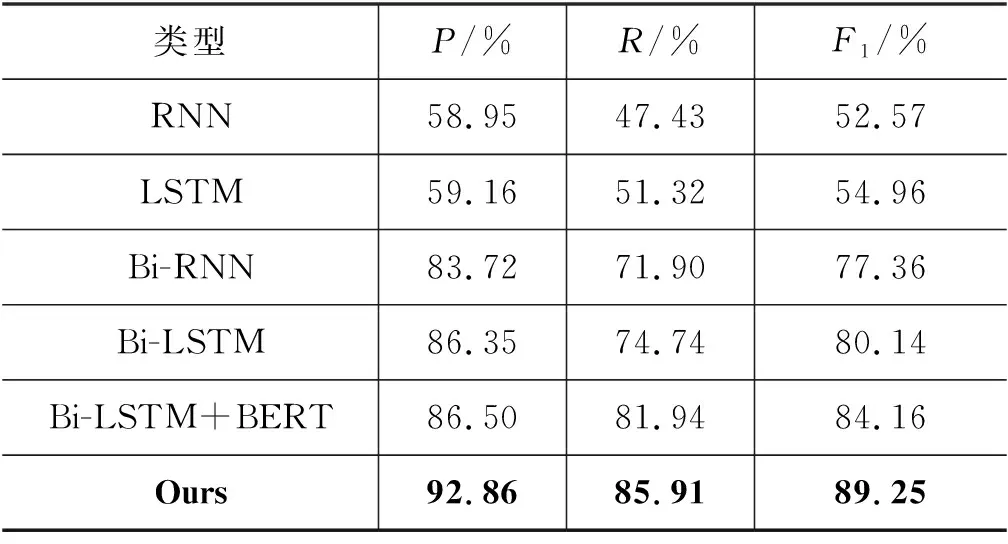

为了验证模型的性能,分别在精度、召回率和F1得分上与基线模型进行了实验比较。表3列出了本文模型以及基线模型的实验结果,其中,BiLSTM是基线模型,+Pondering是本文方法,表示在基线模型的基础上引入了语义自适应思考模块。

表3 模型在汉语到越南语数据集上的精度(P)、召回率(R)和F1分数

实验结果表明,在汉-越数据集上,本文模型的得分优于基线模型。由于BiRNN和BiLSTM神经网络模型能够对句子进行双向编码,进一步提取上下文特征信息,所以在平行句对提取中得分比RNN和LSTM高;其中,Bi-LSTM+BERT是利用BERT模型分别对源语言和目标语言进行预训练得到词向量作为模型的输入,所以相比其他基线模型性能有所提升。而本文模型在Bi-LSTM神经网络模型的基础上引入了语义自适应思考模块,所以与传统的神经网络模型相比,在基线模型的基础上分别在精度上提升6.36%,召回率上提升3.97%,F1得分上提升5.09%,均优于原论文中的模型。 由于在基线模型的基础上引入了语义自适应思考模块,所以相比之下会增加一部分额外的计算和参数量,但能有效地提升模型提取伪平行句对的性能。

3.3.2 模型提取到的汉-越伪平行句子

本文的最终目的是从可比语料库中提取高质量的汉语到越南语的伪平行句子,从而提升汉-越神经机器翻译的性能。表4显示了模型提取到的汉-越伪平行句子对。

表4 提取到的汉-越伪平行句子示例

可以看出,从可比语料库中提取到的汉-越伪平行句子意思更加相近,在语义上也更相关。由于模型中的思考模块能够更深层次地挖掘句子中的语义信息,最大化表示句子之间的相似性,所以提取到的句子质量更高。

3.3.3 单词思考次数分析

由于不同单词在句子中的语义表征的难易程度不一样,导致句子的语义信息不充分,所以需要进行多次思考,充分提取单词的上下文语义信息。图3展示了表4中第2个示例句子中每个单词的不同思考次数(最大思考次数为3)。

图3 不同单词的思考次数

从图中可以看出,单词“越南”“企业”等在句子中比较容易进行上下文语义表征,所以只需进行一次思考;而像单词“不得不”在句子中对其进行上下文语义表征就比较困难,需要进行多次思考,深度挖掘语义信息,才能达到规定的阈值。

3.3.4 机器翻译比较

(1) 数据集

为了验证模型提取到的句子对机器翻译性能的影响,本文将提取到的句子对作为训练数据集,其中,训练集大小为20万对汉语-越南语句子,测试集和验证集大小均为2 000。每个句子的最大长度设置为80,我们使用BLEU值进行评分。

(2) 机器翻译系统评估

本文选择了目前比较主流的神经网络模型Seq2Seq+Attention[14]作为机器翻译模型,分别将基线模型和本文模型提取到的句子对作为训练数据集,编码器和解码器的单词嵌入和循环状态的维度都设置为512,训练20个周期,其中,句子对的批量大小为64。同时根据概率分数按降序对系统提取的句子对进行排序,分别以{10万,15万,20万}不同数量的句子对进行训练。表5为基线模型和本文模型方法提取到的汉-越伪平行句子训练的机器翻译系统获得的BLEU分数。

表5 本文模型和基线模型提取到的不同数量的汉-越伪平行句对在神经机器翻译模型上获得的BLEU分数

续表

实验结果表明,在训练集中添加系统提取到的句子对子集会带来显著的收益,分别通过BiLSTM+Pondering模型和基线模型提取到的句子对数量为10万时,翻译系统的BLEU得分分别为15.57和15.23,提高了0.34,优于基线模型;而当两个模型提取的句子对数量增加到20万时,翻译系统的BLEU得分分别为17.92和15.94,比基线模型提高了1.98。这些结果证实,本文模型提取到的句子对的质量较高,表明可比语料库中存在语义高度相似的伪平行句子。同时可以降低决策阈值ρ,以便提取更大尺寸的语料库。

4 总结与未来工作

本文提出了一种基于语义自适应编码的双向循环神经网络模型,从可比语料库中提取汉-越伪平行句子,构建新的平行语料库。该模型是在神经网络模型的基础上增加语义自适应编码模块,能够根据阈值信息进一步选择思考的深度,同时深度挖掘句子的语义信息,尽可能地比较文本集合中句子的相似性,提高伪平行句子的质量,然后改善低资源下的神经机器翻译性能。实验结果表明,本文的方法优于基线模型,并且提取到的汉-越平行句子语义更加相近,噪声更小。

在这项工作中,该文主要针对汉语到越南语低资源语言来进行的,我们发现从相似文本集合中提取平行句子扩充语料库是比较有效的途径之一。由于可用于训练的汉语到越南语的数据目前相对比较少,因此在未来的工作中,我们会进一步增加训练集的数据,提高模型的性能,同时将会从多模态的角度去考虑,即将图像信息集成到文本中,使得模型能同时关注文本和图像,提取更高质量的平行数据,改善低资源下机器翻译的性能。