基于改进CornerNet的水稻灯诱飞虱自动检测方法构建与验证

姚 青,吴叔珍,蒯乃阳,杨保军,唐 健,冯 晋,朱旭华,朱先敏

基于改进CornerNet的水稻灯诱飞虱自动检测方法构建与验证

姚 青1,吴叔珍1,蒯乃阳1,杨保军2※,唐 健2,冯 晋3,朱旭华3,朱先敏4

(1. 浙江理工大学信息学院,杭州 310018;2. 中国水稻研究所稻作技术研究与发展中心,杭州 311401;3. 浙江省托普云农科技股份有限公司,杭州 310015;4. 江苏省植物保护植物检疫站,南京 210036)

针对水稻灯诱昆虫图像中稻飞虱自动检测存在严重误检和漏检问题,提出一种基于改进CornerNet的水稻灯诱飞虱自动检测方法。由于稻飞虱个体在灯诱昆虫图像中所占区域比例极小,利用重叠滑动窗方法提高飞虱在图像检测区域中所占比例,提高2种稻飞虱(白背飞虱和褐飞虱)的检测率和避免滑动窗边界造成的目标漏检。针对CornerNet存在角点匹配不准确导致检测框冗余问题,利用检测框抑制方法去除冗余检测框。对灯诱昆虫图像进行稻飞虱检测,结果表明,该研究提出的基于改进CornerNet的水稻灯诱飞虱自动检测方法对2种稻飞虱检测的平均精确率和召回率分别为95.53%和95.50%,有效地提高了灯诱昆虫图像中稻飞虱的检测效果,可用于智能虫情测报灯的灯诱昆虫图像中白背飞虱和褐飞虱的智能测报。

图像识别;害虫检测;水稻灯诱昆虫图像;稻飞虱;CornerNet模型;目标检测;重叠滑动窗

0 引 言

水稻在生长过程中会遭受多种害虫危害,严重影响水稻产量,每年给中国造成巨大的经济损失[1]。其中,在中国南方稻区稻飞虱频发、重发,因此需要实时、准确地监测稻飞虱田间种群。目前,稻飞虱田间种群监测方法或设备主要依靠人工田间调查和虫情测报灯[2-3],仍需要人工识别与计数飞虱。随着基层测报人员的流失,依靠人工识别与计数飞虱存在监测任务重、效率低、客观性差和非实时性等问题。

为了减轻基层测报人员的劳动强度,提高稻飞虱测报的实时性和准确率,许多学者研究了基于图像的稻飞虱自动识别方法。邹修国等[4]搭建了稻飞虱图像采集系统,利用灯光诱集稻飞虱至幕布上,然后拍摄飞虱图像,利用了传统模式识别方法识别飞虱种类与数量,获得了较好的飞虱识别效果;但该系统建立在无线移动小车上,稻田环境复杂,影响该系统的推广应用。Yao等[5]和俞佩仕等[6]利用可伸缩的手持式稻田飞虱图像采集仪采集水稻茎基部飞虱图像,并利用深度学习方法来计数飞虱数量,取得较好的结果,但该方法仍需要测报人员下田采集稻飞虱图像。Yao等[7]针对智能虫情测报灯采集了水稻灯诱昆虫图像,利用传统的图像处理方法对灯诱昆虫图像进行背景分割和粘连昆虫分割,然后利用深度学习模型ResNet识别白背飞虱()和褐飞虱()。由于稻飞虱体型较小,仅仅3~5 mm,利用分割方法难以将复杂背景下的飞虱准确地分割出来,从而影响2种稻飞虱的识别率。

智能虫情测报灯[7]采集的灯诱昆虫图像中昆虫种类多、虫量大,且存在很多微小昆虫与稻飞虱体型相似,利用深度学习中常用的目标检测模型[8-13]检测灯诱昆虫图像中的稻飞虱,存在严重的误检和漏检问题。针对该问题,本研究提出基于改进CornerNet[14]的水稻灯诱飞虱自动检测方法,利用重叠滑动窗和检测框抑制方法,提高灯诱昆虫图像中2种飞虱检测的精确率和召回率,减少飞虱的误检和漏检。

1 材料与方法

1.1 图像采集与数据集建立

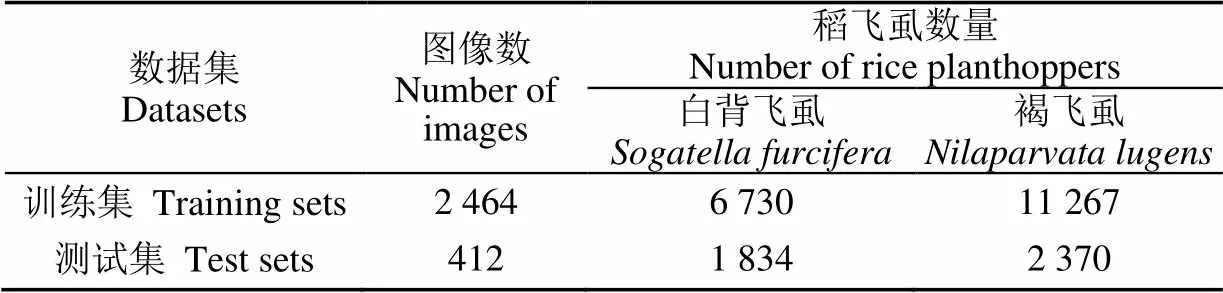

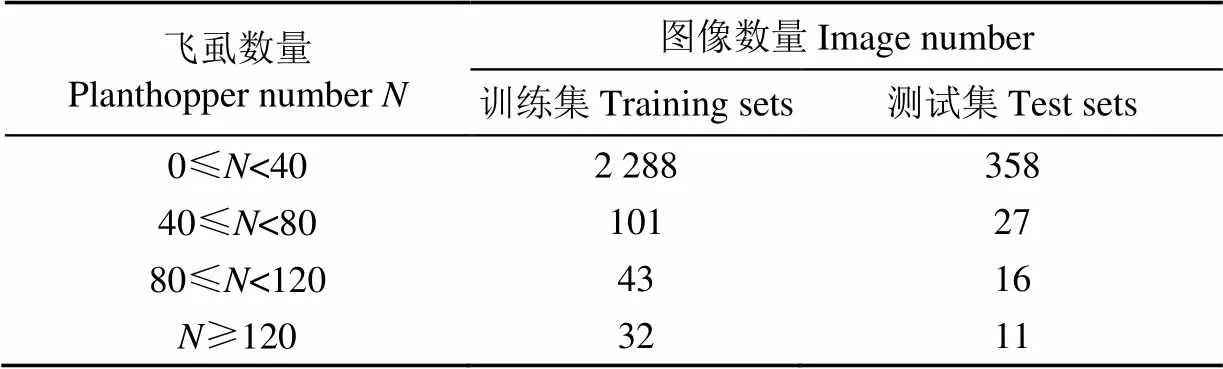

利用智能虫情测报灯的图像采集系统采集灯诱昆虫图像,图像大小为4 000×3 000像素,将图像分成训练集和测试集,图像及2种飞虱数量信息见表1。根据每幅图像中所含飞虱数量的差异,对图像数进行了统计,见表2。智能虫情测报灯具有昆虫抖动分散和传输功能,可以将诱杀的昆虫分散开来,同时根据图像中检测到昆虫数量及面积自动调整传输带和图像采集的速度,避免灯诱昆虫发生堆积情况[7]。采集的图像中每幅图像包含的飞虱数量一般集中在0~40头,高峰期则可能超过40头。由于水稻灯诱昆虫图像中存在大量的非目标昆虫,为了从图像中准确检测出白背飞虱和褐飞虱,利用目标标注工具LabelImage对训练集图像中的白背飞虱和褐飞虱进行标记,得到PASCAL VOC[15]格式的数据集,然后将其转换为COCO[16]数据集的格式用于训练。

表1 水稻灯诱昆虫图像数据信息

表2 单幅图像中不同飞虱数量的图像数

1.2 图像数据增强

为了提高模型的泛化能力和鲁棒性,采用水平镜像翻转、高斯模糊和增加亮度与对比度3种方法[17]对训练集中的图像进行数据扩充(图1),最终获得原来4倍数量的训练样本。

1.3 水稻灯诱飞虱自动检测方法

1.3.1 基于改进CornerNet的水稻飞虱检测模型网络框架

CornerNet[14]检测模型包括主干网络和角点预测模块。主干网络负责提取特征和生成关键点,2个角点预测模块分别对左上角和右下角的角点进行判定和匹配。CornerNet将目标检测问题转化为关键点检测问题,通过检测目标框左上角和右下角2个关键点来确定预测框的位置,是一种无锚点算法。检测时,由主干网络输出的特征图经过角点池化后生成2组热图作为候选角点;同时,网络在2个分支为每个角点预测了嵌入向量用来判断左上角和右下角角点是否匹配。为了使2个角点确定的边界框的位置更加准确,使用偏移量微调左上角和右下角角点的位置。

直接将CornerNet模型用于检测水稻灯诱昆虫图像时,除了存在一些飞虱目标的漏检,还出现角点匹配不准确和检测框冗余的问题。针对漏检问题,采用重叠滑动窗选取图像的部分区域进行检测,提高单个飞虱在图像区域中的比例,滑动窗在滑动方向上的重叠保证了所有目标的完整个体至少被检测一次,能够有效提高飞虱的查全率。滑动窗选取的区域送入特征提取网络Hourglass Network[14]中提取特征,然后进行角点匹配和检测框调整初步生成目标检测框,再通过类间类内非极大值抑制、阈值过滤和完整性检测等检测框抑制方法去除因角点匹配错误和滑动窗重叠引入的冗余检测框,提高了模型检测的精确率。改进后的水稻灯诱飞虱CornerNet检测模型网络框架如图2所示。

1.3.2 重叠滑动窗方法

灯诱昆虫图像大小为4 000×3 000,实际飞虱长度仅为3~5 mm,在整幅图像中的面积占比约为1/1 200。本文利用滑动窗扫描图像,每次选取固定大小的区域进行特征提取和目标检测,提高目标在图像中的占比,从而降低检测飞虱的难度。

为了保证每个飞虱目标在所有滑动窗选取的区域中至少存在一个完整虫体,本文根据灯诱昆虫图像中昆虫大多集中在中间区域这一先验知识,提出一种重叠滑动窗方法。如图3所示,一幅4 000×3 000的灯诱图像,固定滑动窗的长宽分别为1 120和870个像素,由于图像中飞虱的最小外接矩形长宽不超过120个像素,滑动窗从四周向中心滑动时,在滑动方向上重叠的像素大小为120。位置①处的滑动窗分别滑动到②和③,并经由③滑动到位置④。由于重叠区域的面积大于飞虱在图像中的最大面积,因此,任意一个飞虱虫体至少完整地存在于一个滑动窗内。但是有些飞虱正好位于某个滑动窗的边界上,导致滑动窗内出现了飞虱的部分虫体,有可能被检测框检出,后续通过目标检测框抑制方法解决此问题。

1.3.3 特征提取网络

特征提取是目标检测中重要的环节,目标检测框的数量、分类准确率、效率等直接受到特征提取网络的影响。目前比较常用的特征提取网络有VGGNet[18]、ResNet系列算法[19-21]和YOLO系列[22-25]使用的darknet等,这些网络主要用于需要确定候选框的目标检测模型。

CornerNet利用Hourglass Network[14]提取特征,得到目标关键点用于后期角点匹配生成检测框,其网络结构如图4所示。Hourglass Network的基本网络单元为Residual Module[26],其结构如图4左下角所示,上通路为卷积路,采用3×3卷积和1×1卷积提取特征,步长为1只改变特征图的通道数,不改变特征图的大小。下通路经过1×1卷积改变通道数后与上通路跨级连接。在利用卷积路提取较高层次特征的同时,通过跨级连接保留了原有信息,而且输入和输出尺寸相同,只对深度进行变更,可以适应任意大小的输入图像。多个Residual Module以跨级连接的方式构成Hourglass子网络,子网络堆叠组成最终的Hourglas Network。CornerNet使用的主干网络由4级子网络构成,子网络采用与Residual Module相同的结构,堆叠时利用子网络替换结构中的一个Residual Module构成嵌套,具有对称的网络拓扑结构,采用跨层连接的方式保留各个尺度的信息,最终输出原图大小的特征图,可以做出像素级别的预测,体现了层级化的设计思想。

注:①、②、③、④为滑动窗检测区域的编号。

Note: ①, ②, ③, ④are the detection region numbers of sliding window.

图3 重叠滑动窗方法

Fig.3 Overlapping sliding window method

1.3.4 目标检测框抑制

由于角点匹配不准确、飞虱类间差异小和滑动窗的重叠策略,CornerNet检测出的结果往往存在检测框冗余的问题。冗余的检测框存在4种情况:1)由于角点匹配不准确,一个检测框中包括多个目标,造成部分目标漏检。2)同一个目标被多次检测为同一类而被标记多次;3)同一个目标被同时检测为多类而被标记多次;4)目标被滑动窗截断,且在其他窗口中存在完整的目标,同一目标的不同部位被分别标记多次;针对这些情况,本文提出了去除冗余检测框的解决方法。针对情况1),根据灯诱昆虫图像中飞虱面积、外接矩形的长度与宽度范围确定这一先验知识,通过它们的阈值对匹配得到的检测框进行约束,去除大小与飞虱不符合的检测框,既可以提高准确率,又减少了检测时间。针对情况2),在同类目标间执行非极大值抑制[27],取概率最大的检测框作为最终结果,去除了冗余检测框的同时,提高了检测框内目标的分类准确率;针对情况3),在所有检测框间执行非极大值抑制,最终结果为各类中得分最高的检测框;针对情况4),在去除了情况1)、2)、3)中的冗余检测框后,计算滑动窗重叠区域附近的检测框与检测框集合中各个检测框c(c∈)的交并比,设定阈值为0.2,如果交并比大于这个阈值,则表明检测框包含c或者c包含,进一步比较与c的面积,若的面积小于c,则将剔除。通过以上四种方法,能有效抑制冗余的不合格的检测框,结果对比如图5。

注:①、②、③、④为1.3.4节中检测框冗余的4种情况。

Note: ①, ②, ③, ④are four cases of detection box redundancy in section 1.3.4.

图5 目标检测框抑制前后结果对比

Fig.5 Comparison of results before and after detection box suppression

1.4 模型评价方法

为了验证本文提出的改进CornerNet的水稻灯诱飞虱检测方法的有效性,选取了YOLOV4[25]算法和Cascade-RCNN[28]算法进行比较,同时对它们也采用重叠滑动窗和目标检测框抑制方法,比较不同模型对同一测试集的飞虱检测效果。其中,YOLOV4采用darknet-53特征提取网络,Cascade-RCNN采用Resnet101特征提取网络。

为了评估不同模型对飞虱的检测效果,选择精确率(Precision),召回率(Recall)和1分数[29]作为评价标准。精确率和召回率的计算见式(1)和(2),1分数为精确率和召回率的调和平均,最大值为1,最小值为0,其计算公式见(3)。在精确率和召回率占比相同的前提下,1可以综合精确率和召回率衡量一个模型的好坏。

式中TP表示将飞虱正确预测为飞虱的检测框数量,FP表示把非飞虱昆虫错误的预测为飞虱的检测框数量,FN表示把飞虱错误的预测为非飞虱昆虫的数量。

1.5 模型训练环境与方法

所有模型都运行在相同硬件环境下,操作系统为ubuntu 18.04,CPU型号为Intel(R) Core(TM) i7-9800X CPU @ 3.80GHz,共有4块GPU,GPU显存为11GB,型号为GeForce GTX 1080 Ti。

为了降低计算量,减少训练时间,降低模型训练难度,提高模型的泛化能力,本文采用迁移学习方法[30-32],在大型基准数据集获得的预训练模型基础上训练灯诱飞虱检测模型。其中,Cascade-RCNN采用resnet_v1_101预训练模型,YOLOV4采用yolov4.conv.137预训练模型,CornerNet采用CornerNet_500000.pkl预训练模型。

2 结果与分析

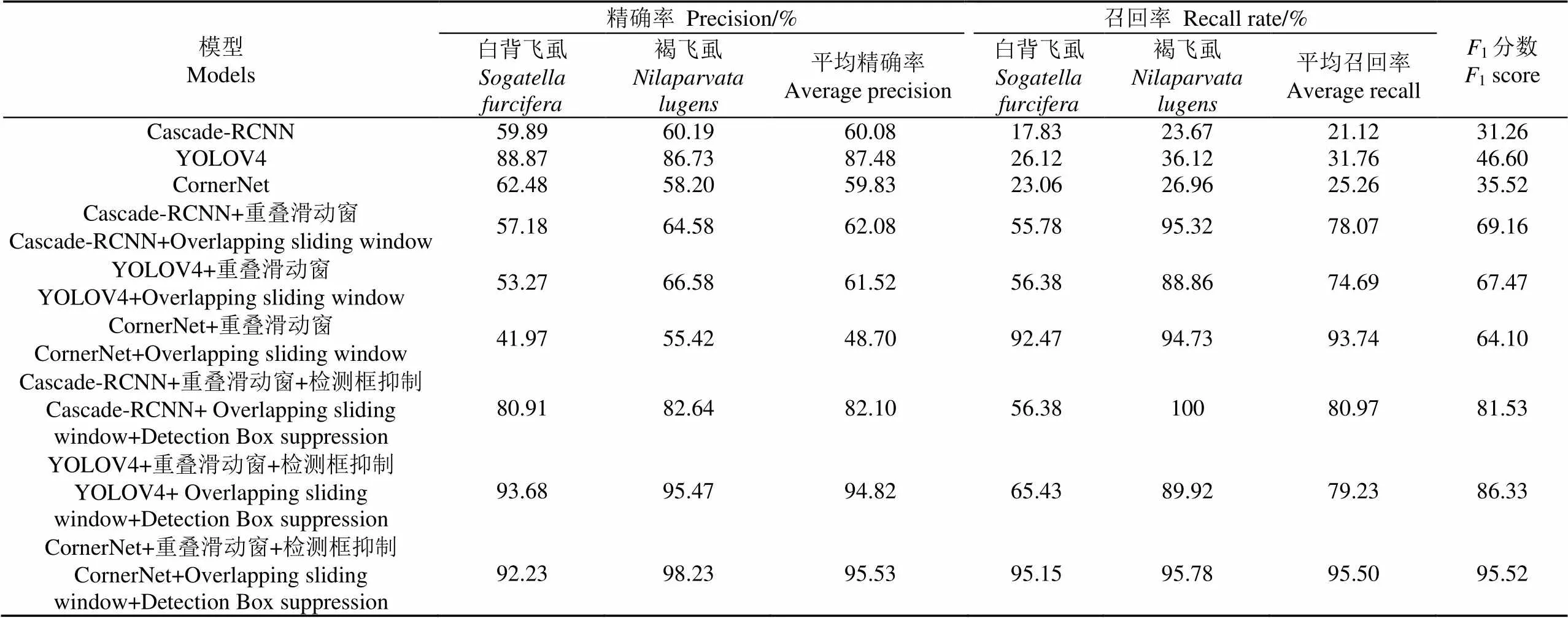

利用Cascade-RCNN、YOLOV4和CornerNet三个模型及其改进的模型分别在同一测试集上测试,结果见表3。从表3中可知,在模型未经过任何改进时,YOLOV4的精确率最高,CornerNet由于关键点匹配不准确产生的冗余检测框降低了飞虱的精确率,但3个模型的漏检都十分严重。使用重叠滑动窗可以有效的提高3个模型的召回率,Cascade-RCNN、YOLOV4和CornerNet的平均召回率分别提升了56.95%、42.93%和68.48%,其中滑动窗方法对CornerNet检测结果影响最大,白背飞虱和褐飞虱的召回率分别提高了69.41%和67.77%。使用滑动窗增大了目标在图像中的占比,有利于改善模型的漏检问题,但由于检测目标数增加,滑动窗的重叠区域被多次检测,导致3个模型的精确率有不同程度的降低,如果不进行后续处理,会对模型的精确率有所影响。本文引入检测框抑制方法,去除检测框边界线上错误的检测框,同时解决由于目标形态相似引起的重复检测问题。从表中可以看出,对使用重叠滑动窗后训练的3个模型进行检测框抑制,3种模型的平均精确率分别提高了20.02%、33.3%和46.83%。从各模型的1可以看出,改进的CornerNet模型对稻飞虱检测的效果最好。

3种模型使用重叠滑动窗方法和目标检测框抑制方法进行优化后得到最终模型,由表3可知,改进的Cascade-RCNN模型检测稻飞虱漏检和误检相对较多,精度和召回率分别为82.10%和80.97%;改进的YOLOV4和CornerNet的精确率均达到了90%以上,可见二者的特征提取网络能够很好的提取稻飞虱的特征,但由于YOLOV4对图像进行划分确定目标中心点时往往会忽略小目标,导致检测的召回率较低,仅为79.23%。CornerNet采用左上角和右下角的点代替传统目标检测的候选框,精简了检测框的表达,同时保证了检测的查全率,其平均精确率和召回率分别达到了95.53%和95.50%,对白背飞虱和褐飞虱检测的准确率相较于文献[7]提高了4.13%和11.43%。由此可见,本文提出的CornerNet+重叠滑动窗+检测框抑制的改进算法可以有效地提升水稻灯诱昆虫图像中稻飞虱检测的精确率和召回率。

图6给出了单幅图像中不同飞虱数量情况下,利用本文提出的改进的CornerNet模型检测灯诱昆虫图像中2种飞虱的结果图。图6a到图6d中飞虱数量不等。其中,图6a检测出白背飞虱31头和褐飞虱3头,未发生误检和漏检;图6b共检测出白背飞虱14头和褐飞虱58头,白背飞虱和褐飞虱分别漏检0头和2头,分别误检0头和1头;图6c共检测出白背飞虱38头和褐飞虱59头,白背飞虱和褐飞虱分别漏检1头和3头,分别误检0头和2头;图6d共检测出白背飞虱168头和褐飞虱8头,白背飞虱和褐飞虱分别漏检4头和0头,分别误检2头和0头。随着一幅图像中所含飞虱数量增多,存在粘连情况或被非目标昆虫遮挡,容易造成漏检和误检。但本文基于改进CornerNet的水稻灯诱飞虱自动检测模型能正确检测出绝大部分飞虱,准确反映出2种飞虱发生量的变化,可应用于智能虫情测报灯对飞虱的监测和测报。

表3 同一测试集不同模型稻飞虱的检测结果

3 结 论

本研究提出了一种基于改进CornerNet的水稻灯诱飞虱自动检测算法,提高了白背飞虱和褐飞虱检测的精准率和召回率,可用于智能虫情测报灯中2种稻飞虱的测报。

1)针对稻飞虱在灯诱昆虫图像中所占区域比例小而导致其召回率低的问题,采用重叠滑动窗方法提高图像中飞虱区域所占比例。将重叠滑动窗方法应用于Cascade-RCNN、YOLOV4和CornerNet三种模型,白背飞虱和褐飞虱的平均召回率分别提升了56.95%、42.93%和68.48%。重叠滑动窗方法大大提高了稻飞虱的检测率。

2)为了进一步提高模型对2种飞虱检测的精确率,采用检测框抑制方法去除冗余检测框。改进的Cascade-RCNN、YOLOV4和CornerNet三种模型的精确率分别提升了20.02%、33.3%和46.83%。其中,改进的CornerNet模型对2种稻飞虱检测获得了最好的检测效果,平均检测精确率和召回率分别为95.53%和95.50%。

本文提出的稻飞虱检测算法可直接应用于智能虫情测报灯,大大提高了稻飞虱测报的效率和精度。但在昆虫发生高峰时,容易造成堆积和粘连,影响算法对目标害虫的检测效果,因此智能虫情测报灯需要具备有效的昆虫分散机构。

[1] 刘万才,陆明红,黄冲,等. 水稻重大病虫害跨境跨区域监测预警体系的构建与应用[J].植物保护,2020,46(1):87-92,100.

Liu Wancai, Lu Minghong, Huang Chong, et al. Construction and application of cross border and cross regional monitoring and early warning system for major rice diseases and insect pests[J]. Plant Protection, 2020, 46(1): 87-92, 100. (in Chinese with English abstract)

[2] 杨荣明,朱先敏,朱凤. 我国农作物病虫害测报调查工具研发应用历程与发展建议[J]. 中国植保导刊,2017,37(1):51-55.

Yang Rongming, Zhu Xianmin, Zhu Feng. Development and application of crop pest forecasting and investigation tools in China[J]. China Plant Protection, 2017, 37(1): 51-55. (in Chinese with English abstract)

[3] 王瑞林,陆明红,韩兰芝,等. 稻飞虱种群发生的调查与取样技术[J]. 应用昆虫学报,2014,51(3):842-847.

Wang Ruilin, Lu Minghong, Han Lanzhi, et al. Methods and technologies for surveying and sampling the riceplanthoppers, Nilaparvata lugens, Sogatella furcifera and Laodelphax striatellus[J]. Chinese Journal of Applied Entomology, 2014, 51(3): 842-847. (in Chinese with English abstract)

[4] 邹修国,丁为民,刘德营,等. 基于改进Hu矩和遗传神经网络的稻飞虱识别系统[J]. 农业机械学报,2013,44(6):222-226.

Zou Xiuguo, Ding Weimin, Liu Deying, et al. Recognition system of rice planthopper based on improved hu moment and genetic algorithm optimized BP neural network[J]. Transactions of the Chinese Society for Agricultural Machinery, 2013, 44(6): 222-226. (in Chinese with English abstract)

[5] Yao Q, Chen G, Wang Z, et al. Automated detection and identification of white-backed planthoppers in paddy fields using image processing[J]. Journal of Integrative Agriculture, 2017, 16(7): 1547-1557.

[6] 俞佩仕,张晨光,段德康,等. 基于移动终端的稻田飞虱调查方法[J]. 昆虫学报,2019,62(5):615-623.

Yu Peishi, Zhang Chenguang, Duan Dekang, et al. A survey method based on mobile terminal for rice planthoppers in paddy fields[J]. Acta Entomologica Sinica, 2019, 62(5): 615-623. (in Chinese with English abstract)

[7] Yao Q, Feng G, Tang J, et al. Development of an automatic monitoring system for rice light-trap pests based on machine vision[J]. Journal of Integrative Agriculture, 2020, 19(10): 2500-2513.

[8] Liu W, Anguelov D, Erhan D, et al. Ssd: Single shot multibox detector[C]//European conference on computer vision. Springer, Cham, 2016: 21-37.

[9] Ren S, He K, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[J]. IEEE transactions on pattern analysis and machine intelligence, 2016, 39(6): 1137-1149.

[10] Dai J, Li Y, He K, et al. R-fcn: Object detection via region-based fully convolutional networks[J]. arXiv preprint arXiv: 1605.06409, 2016.

[11] Lin T Y, Goyal P, Girshick R, et al. Focal loss for dense object detection[C]//Proceedings of the IEEE international conference on computer vision, 2017: 2980-2988.

[12] Duan K, Bai S, Xie L, et al. Centernet: Keypoint triplets for object detection[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision, 2019: 6569-6578.

[13] Du H, Li L, Liu B, et al. SPOT: Selective point cloud voting for better proposal in point cloud object detection[C]//European Conference on Computer Vision. Springer, Cham, 2020: 230-247.

[14] Law H, Deng J. Cornernet: Detecting objects as paired keypoints[C]//Proceedings of the European Conference on Computer Vision (ECCV), 2018: 734-750.

[15] Everingham M, Van Gool L, Williams C K I, et al. The pascal visual object classes (voc) challenge[J]. International Journal of Computer Vision, 2010, 88(2): 303-338.

[16] Lin T, Maire M, Belongie S, et al. Microsoft coco: Common objects in context[C]//European conference on computer vision. Springer, Cham, 2014: 740-755.

[17] Ogawa R, Kido T, Mochizuki T. Effect of augmented datasets on deep convolutional neural networks applied to chest radiographs[J]. Clinical Radiology, 2019, 74(9): 697-701.

[18] Liu X, Chi M, Zhang Y, et al. Classifying high resolution remote sensing images by fine-tuned VGG deep networks[C]//IGARSS 2018-2018 IEEE International Geoscience and Remote Sensing Symposium. IEEE, 2018: 7137-7140.

[19] He K, Zhang X, Ren S, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE conference on computer vision and pattern recognition, 2016: 770-778.

[20] Xie S, Girshick R, Dollár P, et al. Aggregated residual transformations for deep neural networks[C]//Proceedings of the IEEE conference on computer vision and pattern recognition, 2017: 1492-1500.

[21] Hu J, Shen L, Sun G. Squeeze-and-excitation networks[C]// Proceedings of the IEEE conference on computer vision and pattern recognition. 2018: 7132-7141.

[22] Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection[C] //Proceedings of the IEEE conference on computer vision and pattern recognition, 2016: 779-788.

[23] Redmon J, Farhadi A. YOLO9000: Better, faster, stronger[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. 2017: 7263-7271.

[24] Ju M, Luo H, Wang Z, et al. The application of improved YOLO V3 in multi-scale target detection[J]. Applied Sciences, 2019, 9(18): 3775-3768.

[25] Zhu Q, Zheng H, Wang Y, et al. Study on the evaluation method of sound phase cloud maps based on an improved YOLOv4 Algorithm[J]. Sensors, 2010, 20(15): 4313-4330.

[26] Veit A, Wilber M, Belongie S. Residual networks behave like ensembles of relatively shallow networks[J]. arXiv preprint arXiv:1605.06431, 2016.

[27] Neubeck A, Van Gool L. Efficient non-maximum suppression[C]//18th International Conference on Pattern Recognition (ICPR'06). IEEE, 2006, 3: 850-855.

[28] Cai Z, Vasconcelos N. Cascade r-cnn: Delving into high quality object detection[C]//Proceedings of the IEEE conference on computer vision and pattern recognition, 2018: 6154-6162.

[29] Huang H, Xu H, Wang X, et al. Maximum F1-score discriminative training criterion for automatic mispronunciation detection[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2015, 23(4): 787-797.

[30] 刘洋,战荫伟. 基于深度学习的小目标检测算法综述[J].计算机工程与应用,2021,57(2):37-48.

Liu Yang, Zhan Yinwei. Survey of small object detection algorithms based on deep learning[J]. Computer Engineering and Applications, 2021, 57(2): 37-48. (in Chinese with English abstract)

[31] 王金鹏,高凯,姜洪喆,等. 基于改进的轻量化卷积神经网络火龙果检测方法[J]. 农业工程学报,2020,36(20):218-225.

Wang Jinpeng, Gao Kai, Jiang Hongzhe, et al. Method for detecting dragon fruit based on improved lightweight convolutional neural network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(20): 218-225. (in Chinese with English abstract)

[32] 寇大磊,权冀川,张仲伟. 基于深度学习的目标检测框架进展研究[J]. 计算机工程与应用,2019,55(11):25-34.

Kou Dalei, Quan Jichuan, Zhang Zhongwei. Research on progress of object detection framework based on deep learning[J]. Computer Engineering and Applications, 2019, 55(11): 25-34. (in Chinese with English abstract)

Automatic detection of rice planthoppers through light-trap insect images using improved CornerNet

Yao Qing1, Wu Shuzhen1, Kuai Naiyang1, Yang Baojun2※, Tang Jian2, Feng Jin3, Zhu Xuhua3, Zhu Xianmin4

(1.,310018,; 2.311401,; 3.310015,; 4.210036,)

Many species of pests have posed a serious threat to the yield and quality of rice and ,thereby, caused huge economic losses every year in the world. Accurate, real-time forecast of rice pests is highly demanding to take controlling measures in time. Since the commonly-used light-traps in China can automatically trap and kill the trapped insects, the subsequent procedure is still labor-intensive and time-consuming with low efficiency and less objectivity, causing a delay in the artificial identification and counting of rice pests. The reason is that the trapped insects in a day are often collected in one insect bag, and then the insect bags were taken back to the pest identification. Although deep learning has widely been used in pest identification, high accuracy is still lacking in the detection of rice planthopper, due to the small area proportion of planthoppers in the whole image. Moreover, great similarities of various rice planthoppers have made it much more difficult to detect light-trapped rice planthoppers in the complicated field environment. In this study, an improved automatic detection was proposed using CornerNet for higher precision and recall rate of rice planthoppers on light-trap insect images. 12 megapixel images were also captured for object detection. Data enhancement was first employed to expand the training set, further improving the generalization ability of the model. Next, an overlapping sliding window was applied to select fixed size regions by scanning the overlapped in the sliding direction from the edge to the center of one image. Subsequently, these size-fixed areas were fed into a cross-layer connected hourglass network with a high symmetry for the extraction of features. The area proportion of planthoppers on one image increased in sliding window selection for the improved detection rate. A large number of candidate boxes were obtained after the corner matching and coordinate correction in the prediction module. Four approaches were also developed for the detection box suppression to remove redundant detection boxes. Finally, the detection boxes with the highest score were selected as the detection data in the overlapping candidate boxes. The same image sets from the light traps were used to verify three detection models and their improved ones. The results demonstrated a higher accuracy detection of rice planthoppers was achieved under the overlapping sliding window and the detection box suppression in the different improved models. The improved CornerNet model presented an excellent performance with an average precision of 95.50% and a recall rate of 95.53% for the two species of rice planthoppers. This work can be applied in smart light traps to enhance the forecasting accuracy of rice planthoppers.

image recognition; pest detection; rice light-trap insect image; rice planthopper; CornerNet model; object detection; overlapping sliding window

2020-10-15

2021-03-16

国家”863”计划项目(2013AA102402);浙江省公益性项目(LGN18C140007);浙江省自然科学基金(LY20C140008)

姚青,教授,研究方向为农业病虫害图像处理与智能诊断。Email:q-yao@zstu.edu.cn

杨保军,博士,助理研究员,研究方向为农业病虫害测报技术。Email:yangbjy@126.com

10.11975/j.issn.1002-6819.2021.07.022

TP391

A

1002-6819(2021)-07-0183-07

姚青,吴叔珍,蒯乃阳,等. 基于改进CornerNet的水稻灯诱飞虱自动检测方法构建与验证[J]. 农业工程学报,2021,37(7):183-189. doi:10.11975/j.issn.1002-6819.2021.07.022 http://www.tcsae.org

Yao Qing, Wu Shuzhen, Kuai Naiyang, et al. Automatic detection of rice planthoppers through light-trap insect images using improved CornerNet[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(7): 183-189. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2021.07.022 http://www.tcsae.org