密集用户场景下802.11ax WiFi网络的干扰控制优化

王冰颖,方旭明

(西南交通大学 信息科学与技术学院,成都 611756)

0 引 言

近年来,随着用户日益增长的服务需求,无线局域网(wireless local area network, WLAN)终端设备不断增加,无线环境变得越来越复杂,环境的变化对无线保真(wireless fidelity, WiFi)设备的干扰影响是无法准确度量的,给干扰分析和干扰抑制带来了难度。而无线网络的干扰管理研究主要依靠干扰协调和协同传输,干扰消除或者干扰对齐一般难以实现。IEEE802.11ax协议为解决密集场景下的覆盖问题,提出了多项多用户介质访问控制(multi user medium access control, MU-MAC)增强技术[1],为协调干扰、协同传输以及提高并发能力提供了新的解决思路,相关文献对此进行了大量研究。在干扰协调方面,802.11ax打破了传统的802.11协议使用固定载波侦听门限(carrier sense threshold, CST)的惯例,并且为频谱资源的丰富和资源块(resource unit, RU)划分提供了更多的调度可能。在协同传输方面,一般需要共享数据资源,协同波束的传输更需要大量天线和信道探测开销。而对于WiFi功率控制,802.11标准中对具体实现并没有明确规定,属于开放问题。我们认为,其中的关键问题是如何利用设备的功率协调干扰,同时尽可能简化传递的信息和算法。

功率协调的本质可以抽象为一个搜索优化问题,而通过启发式算法协调功率提升系统性能的研究也并不少见。文献[2]利用一种启发式算法解决基站操作关联,但只涉及简单的基站开闭。文献[3-5]在其他无线网络中研究使用启发式算法改善系统能效,但在已知范围内少有将WiFi网络干扰管理和启发式算法两者结合在一起的。实际上,我们可以将无线网络的优化问题建模为马尔可夫决策过程(Markov decision process, MDP),以描述系统的状态转换。但是,由于MDP具有许多变量,求解较为困难,因此,我们探索用强化学习方法来求解。

无论是启发式算法还是强化学习都需要一个计算中心,现有的无线局域网主要使用分布式网络架构,使得无线资源的管理效率很低,而中心控制式的网络架构可以使用全局信息来对接入点(access point, AP)和用户设备(user equipment, UE) 进行统一管理,对无线资源的管理效率更高[6-7]。因此,本文针对802.11ax基于中心的架构,假设本文研究对象密集WiFi网络至少有一个控制中心器可以执行网络控制算法。

本文针对WiFi密集用户网络场景的干扰管理进行研究,考虑场景中存在一个可以计算和暂时控制周围接入点的中心接入点,把多接入点的干扰管理问题抽象成一个多目标的资源分配问题,根据提出的优化目标和约束条件,通过改进遗传算法(genetic algorithm,GA)和强化学习(reinforcement learning, RL)协调功率来控制干扰,在保证用户服务质量前提下,通过感知系统容量的上升实现干扰最小化。

1 问题场景与建模

1.1 密集用户网络场景

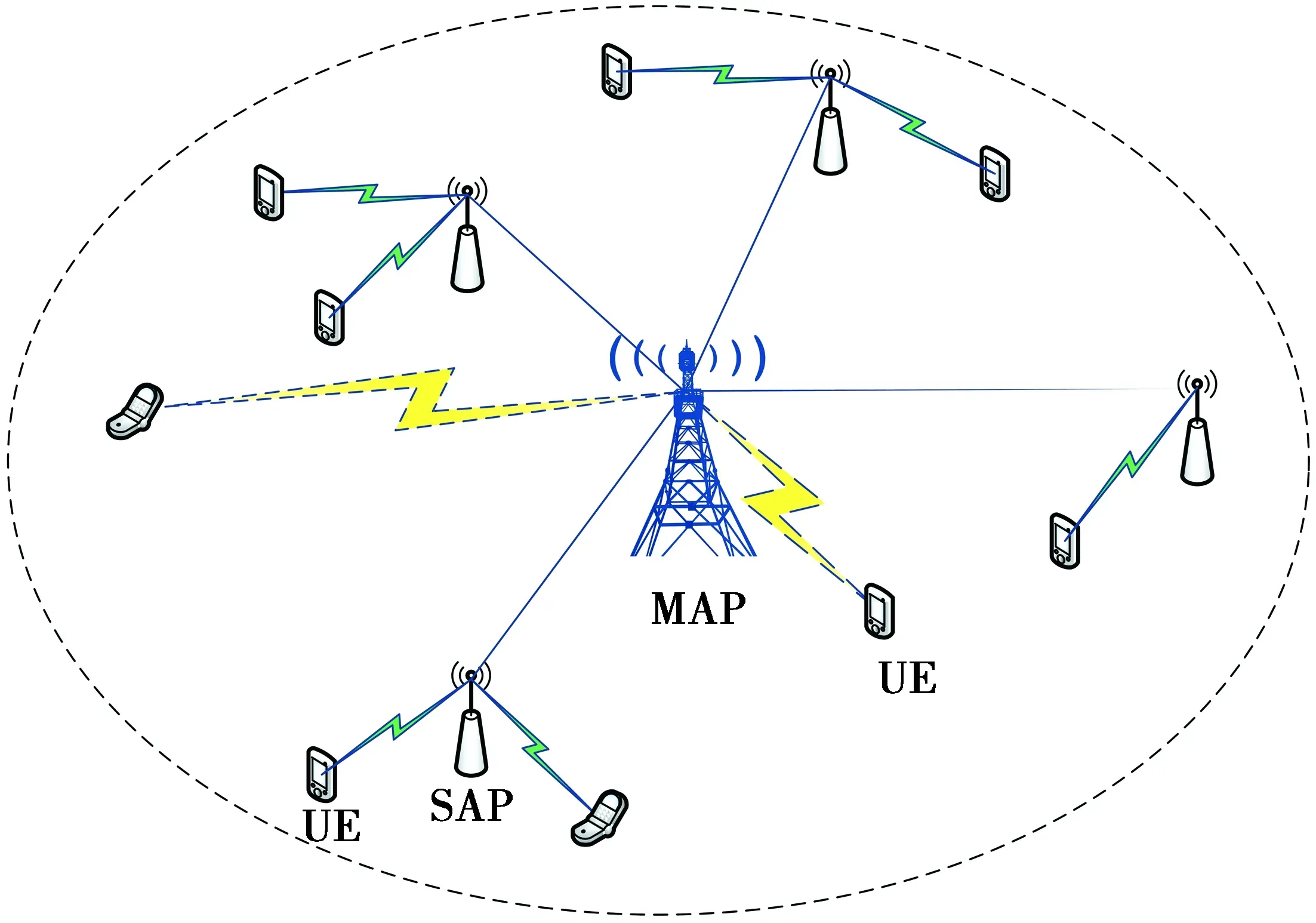

下一代IEEE中有提案提到将AP分为主从AP,本文主要将主控接入点(master access point,MAP)作为控制中心,服务访问点(slave access point,SAP)作为主要服务用户的AP,在一个WiFi网络中有多个AP同时工作,工作在5 GHz频段,用户随机均匀分布,移动性较低,用户分布如图1。

图1 密集用户场景示意图Fig.1 Dense user scenario diagram

假设网络由若干AP和若干用户组成,AP共享频谱,其中单个AP服务N个UE。用户受到的同频干扰主要来自于其他AP的能量泄露。所以,对应的UE的信噪比为

SINRij=

(1)

(1)式中:Pt,ij是第j个UE对应的第i个AP的发射功率;Gt,ij是第j个UE对应的AP的发射天线增益;Gr,ij是第j个UE的接收天线增益;Gh,ij是第i个UE与提供服务的AP之间的信道增益,包括大尺度衰落和小尺度衰落;Pt,ab→ij·Gt,ab→ij·Gr,ab→ij·Gh,ab→ij代表其他APa与用户b之间的通信链路对APi与用户j通信链路产生的干扰。为了简化方便,本文只考虑下行链路的吞吐率为

(2)

(2)式中:C表示当前整个网络的吞吐率;Rij表示第i个AP第j个UE对应的吞吐率;Bij是第j个UE对应的第i个AP的带宽。

1.2 干扰优化目标

本文关注的是降低WiFi网络间的同频干扰,同频干扰的优化实质上是提高用户服务满意度,而对于用户来说,AP发射功率在满足传输需要的同时尽可能少地受到来自其他AP的干扰。但用户需要的服务速率越高,往往要求的发射信号强度越高,AP的发射功率都增加时干扰也会增强,且用户使用设备也需要低功耗来维持长时间的使用,则在提升容量性能和缩小功耗的问题上,可能是一种博弈。由于干扰信号较小且难以测量,干扰优化的目的主要是提升系统吞吐性能,将系统吞吐率提升设为干扰优化的主要目标。

由于802.11ax的物理层是基于正交频分复用技术 (orthogonal frequency division multiplexing, OFDM)实现的,同时考虑到无线硬件是线性功率放大器件,长期处于极值的状态可能会加大损耗,降低使用寿命或导致信号失真[8],为可持续地使用功率放大器件,需要使其稳定在线性区间内,因此,对平均功率作出如下约束

(3)

为系统性能平滑,一般对于单个AP,每次功率调整的步长不宜太大。若P0为调整前的功率值,则最小功率调整步长为

(4)

综上,为了在系统总功耗最小的情况下实现最大的用户满意度,得到最优的系统能效,建立优化模型表示为

(5)

(5)式中:Pt,i是第i个AP的发射功率;P0,i是第i个AP调整前的发射功率;Pt,max是AP发射功率最大值。

2 干扰优化算法

2.1 基于改进的遗传算法的干扰优化

根据优化模型,不难看出干扰优化被抽象成有关发射功率的寻优问题,根据信噪比公式可知在带宽、天线增益等参数固定的情况下,发射功率和吞吐率完全是正相关的,但理想的优化目标也希望发射功率尽可能小。本文采用遗传算法综合考虑系统的干扰情况和业务满足能力,参考小生境算法的思想[9],在遗传过程中同时并行搜索结果,使其合成精英种群,加强全局搜索能力,以AP的随机发射功率作为遗传算法的初始解,每次迭代后在种群中选择一定比例优秀的结果,然后,同时让他们迭代若干次,记录每一次的最优结果,直到解集趋于稳定。

遗传算法的核心是其目标函数,从(5)式可以看出,约束C1和C2会和核心目标最大化吞吐率有一定冲突,同时约束C1和C2待优化的目标也是发射功率,求最小值也相当于求负的最大值,因此,将目标函数定义为适应度f(Sl),表示为

(6)

(6)式中:CSl为基因Sl对应的系统吞吐率;Cmax为802.11ax协议下系统的吞吐率最大值。

可以根据对目标的期盼程度对影响权重参数α,β,γ进行调整。α主要表征吞吐率影响,α越大表示对算法推算的吞吐率期望高,必要时可以牺牲一定的功率代价;β,γ分别表征对系统平滑过渡和平均功率的期望。期望f(Sl)>0,同时,由于吞吐率为核心目标,经过我们反复分析和验证,发现当α=0.4,β=0.6,γ=0.6;α=1,β=0.6,γ=0.4;α=1,β=0.4,γ=0.6等设定参数时,系统的吞吐率提升不足1%,而只有当参数α∈(0.5,1],β∈[0,0.5],γ∈[0,0.5],α>β+γ时,系统性能处于较为理想的范围。一组AP的发射功率构成基因Sl,表示为

Sl={Pt,1,…,Pt,M}s.t.Pt,i∈[0,Pt,max]

(7)

基于当前场景,优化目标的改进遗传算法步骤如下。

步骤1随机化生成一组AP发射功率作为初始解S0,1~N_SS个包含初始解的种群大小为Nind的子种群SS,子种群合并为S,设置最大迭代次数genMax,精英比例Px等参数;

步骤2对每个子SS执行遗传算法,计算种群SS中每个个体的适应度值f(Sl);

步骤3降序排列适应度值f(Sl),选择数量为genMax·Px的优异个体放入集合SG;

步骤5重复步骤2,步骤3,直到迭代得到S中最优解Sl-best。

2.2 基于强化学习算法的干扰优化

强化学习已被证明是通信和计算系统中资源分配的有效解决方案之一。通过与环境交互的即时奖励反馈,RL代理可以相应地生成(接近)最佳控制动作[10]。Q学习[11](Q-learning, QL)是一种典型的强化学习方法,同遗传算法相比,学习算法更加简单,不存在种群的概念,仅根据反馈调整单个目标。根据遗传算法的设置,发射功率的状态是离散的,调整发射功率的动作也是离散的,并且状态执行动作时会不连续地更改。因此,本文将QL用于当前场景干扰优化,假设:①当前的环境状态S:网络内AP的发射功率的设定值,S={S0,…Sl,…},其中,Sl是本次观测的初始状态推测出的转移状态,与遗传算法中的个体相同;②动作空间A:一次对于发射功率的调整,由于这种调整的可能性比较多,且随着AP数目变化,将其定为数目为K的随机动作α,其中,α∈A,α与Sl规模相同,α中元素有0,±δ这3种值,δ为调整步长;③反馈信号rt:由适应值f(Sl)与上一次的差值决定,可直观的体现本次策略调整相比于上一次的好坏,保证了策略更新的优化。其中策略更新的规则为

Qt+1(Sl,a)=(1-σ)Qt(Sl,a)+

(8)

(8)式中:Qt+1(Sl,a)是下一次Q值表中对应状态Sl;Sl’是当前观察到的状态;α’是观察时选择的动作;σ∈(0,1]为学习率,σ=1/(1+Nα(x)),Nα(x)是迭代x次后选择动作的次数,随着迭代次数趋于无穷,若Q值经历无数多次更新,最终收敛于最优策略;τ∈(0,1)为时间折现因子,是一个常数,它体现了未来回报相对当前回报的重要性,τ值越高表示当前回报越高。

基于当前场景优化目标的学习算法步骤如下。

步骤1随机化生成一组AP发射功率作为初始状态S0,1~K个随机产生的动作集A;

步骤2获取当前状态下的Qmax值,根据Qmax值选择行为a;

步骤3计算执行行为a后的适应值f(Sl);

步骤4根据适应值f(Sl)与上一次的差值判断干扰改善情况,决定反馈值rt;

2)预加载结束后开始正式加载至试件破坏,加载过程时间不少于15 min,因此加载速度定在80 kN/min;

步骤5根据(8)式更新Q值表;

步骤6重复步骤2—5,直到得到S中最优状态Sl-best。

由于期望状态是吞吐率和发射功率的一个折中,算法期望通过采取合适的行为将初始状态转移到一个更好的状态,因此,在有限的迭代中找到最好的折衷态即可。

3 仿真结果与分析

使用MATLAB对所提的干扰管理方案进行仿真验证。根据1.1节设置的网络场景,以及对1.2节优化目标使用所提算法对系统干扰进行优化,在适应度函数中对一些条件进行约束,根据适应度函数对优势基因进行选择,得到随迭代次数变化的情况,本文的仿真结果也与其他应用于无线场景中的启发式算法[12-13]进行了对比。仿真依据802.11ax协议,假设无干扰情况下满足最大调制编码策略(modulation and coding scheme, MCS)的速率对应的功率为最大发射功率,满足MCS7的功率为平均发射功率,工程上可按经验值进行设置,其他相关参数[14-15]如表1。

表1 仿真参数Tab.1 Simulation parameter values

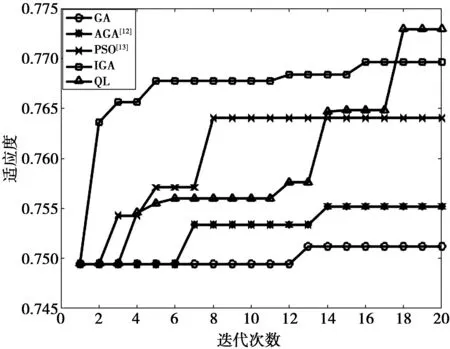

图2对比了固定AP数和UE数时使用遗传算法,自适应调整概率的遗传算法(adaptive genetic algorithm ,AGA),改进遗传算法(improved genetic algorithm ,IGA),粒子群算法(particle swarm optimization ,PSO),强化学习算法情况下随着迭代次数变化的平均吞吐率仿真,仿真中的平均吞吐率是包含了一定的通信和计算开销,反映了各算法执行的吞吐率水平。从图 2中可知,优化算法的迭代次数和系统平均吞吐率基本成正比,QL得到的吞吐率在迭代会有一定的波动,总体呈上升趋势,且在第14次反超改进遗传算法,第18次迭代时达到吞吐率峰值,相比遗传算法、自适应遗传算法、PSO、改进遗传算法分别提升约3%,2%,2%,1‰。相比于其他论文中应用的启发式算法可以看出,改进的遗传算法可以更加快速地反应,吞吐率在第2次迭代时有明显提升,之后又下降是因为搜索到的发射功率值太高,虽然吞吐率明显提升,但适应度并不高,之后被其他搜索结果取代,搜索第5次后基本趋于稳定,随着迭代次数的增加,其提升效果趋于稳定,如果迭代次数足够大,可能结果与其他启发式算法趋同。

图2 用户平均吞吐率对比Fig.2 User average throughput comparison

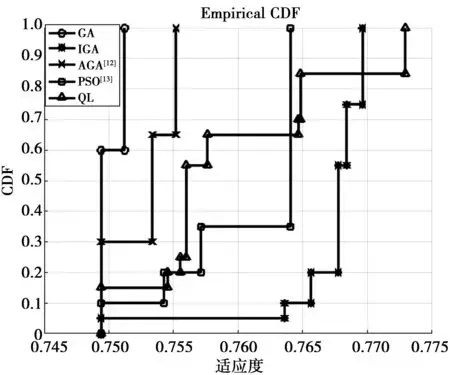

图3和图4分别是不同算法下随着迭代次数变化的适应度值趋势和适应度的累计分布函数(cumulative distribution function,CDF),从图3可以看出,应用QL算法和改进遗传算法整体提高了适应度,即在提升吞吐的情况下尽可能满足了减小发射功率稳定平均功率的限制,综合考虑了使用情况,结果趋向于收敛,反映了对单次功率调整能力要求较小,便于硬件的保护,延长使用寿命。图 4对不同的适应度CDF进行了对比,可以看出,应用QL算法调整基站发射功率能够比较快速地提升适应度,满足系统期望的目的,而改进遗传算法前期反应速度比较快,且搜索比较全面,但结果与其他优化算法差别不大,总的来说,所提算法保证了用户的通信质量且易于实现。

图3 不同算法适应度对比Fig.3 Fitness comparison under different algorithms

图4 适应度累积分布函数对比Fig.4 Cumulative distribution functions of fitness

4 结束语

本文针对密集用户场景下802.11ax网络,同频设备功率损耗大并且相互之间干扰严重的情况,基于本文中的网络结构,提出了一种干扰协调方案。仿真结果表明,一定条件下额外的开销是值得的,强化学习算法和改进遗传算法在考虑了基站对功率的调节能力和持久服务能力下能提升系统吞吐率,达到期望目的。值得一提的是,所提方案需要动态地协调干扰,基站之间需要交互彼此的发射功率信息和协调调度用户,无疑增加了信令开销和计算开销。