基于生成对抗网络的空间卫星低照度图像增强

陈榆琅,高晶敏,*,张科备,张洋

1. 北京信息科技大学 自动化学院,北京 100192

2. 北京控制工程研究所,北京 100190

空间光照条件的不断变化、成像载荷的抖动、成像系统像质退化等因素,导致空间光学成像下图像质量严重退化的问题,比如图像对比度过低、细节损失大和噪声污染严重,这不仅会干扰对卫星图像的人工判别,也会影响后续特征信息提取、图像识别和图像分割等图像处理技术的效果[1-6]。对空间环境下的低照度图像进行增强预处理,能够为基于计算机视觉的空间任务提供更高质量的图像信息。

低照度图像增强方法主要分为基于直方图均衡化(histogram equalization,HE)的方法、基于Retinex理论的方法及基于深度学习的方法。HE是一种常用的灰度增强算法,其原理是通过拉伸图像的动态范围来增加对比度。文献[7]为解决增强亮度不均匀、不自然的问题,基于HE提出了一种全局亮度和局部对比度自适应增强方法。文献[8]提出了改进的HE用于图像对比度的增强。以上基于HE的方法,其增强结果总是存在着明显的细节模糊、色彩失真等问题[9]。Retinex是Edwin Land提出的一种有效理论,通过模拟人类视觉系统实现色彩恒定和动态范围压缩[10]。Retinex的基本原理是假设一幅图像是由入射光分量和反射光分量组成,只需去除照射图的影响即可得到物体本来的样子,完成图像增强[10]。基于Retinex原理的方法主要包括SRIE[11]、LIME[12]和BIMEF[13]等, 这些方法的关键是通过人工设计以及参数微调实现照射图的估算[9],然而通过深度学习方法,不仅可避免这些复杂繁琐的人工设计及整体优化问题,还可获得更好的泛化能力及增强效果。

在基于深度学习的图像增强方法中,文献[14]和文献[15]分别构建短曝光图像及配对的长曝光图像数据集,旨在利用深度神经网络获得更好的图像增强效果。基于Retinex的思想,文献[16]与文献[17]均结合卷积神经网络(convolution neural networks,CNN)提出了端到端的图像增强网络。文献[18]融合多种基础图像增强技术提出深度融合网络(deeply-fused nets,DFN),无需通过估算反射图实现低照度图像增强。以上基于深度学习的方法主要利用配对样本进行训练学习,而配对样本训练方式不适用于卫星低照度图像增强,主要原因有两点:首先,难以对同一个视觉场景下的低照度图像和正常照度图像实现样本配对。其次,即使通过利用正常照度图像合成低照度图像实现样本配对,但合成的图像不够自然真实,导致训练后的模型对真实图像进行图像增强时会出现明显伪影。针对以上问题,文献[19]提出了EnlightenGAN(EG)方法,在非配对训练条件下,利用生成对抗网络(generative adversarial network,GAN)实现低照度图像增强,同时还设计了双鉴别器对增强图像的全局及局部进行真伪鉴别,以平衡全局和局部的增强效果。但该方法增强的图像亮度偏低,卫星的边缘轮廓仍存在明显的模糊,增强后的色彩也存在失真的问题。

基于以上分析,本文设计了一种密集连接的生成器,加强了网络中的信息传递及特征融合,并将其引入EG中,提出了一种基于生成对抗网络的空间卫星图像增强方法,并在非配对样本条件下进行网络模型训练。试验结果表明,该方法较LIME及EG具有更好的增强效果,能够在对比度、亮度以及色彩方面显著提升图像质量,为基于计算机视觉技术的空间任务提供充分有效的图像信息。

1 EnlightenGAN

EG将非配对训练引入到基于深度学习的低照度增强方法中,除去对配对样本的依赖,并可用大量来自不同领域的图像进行训练[19]。其生成器采用了传统的U-Net[20]结构,如图1所示,左侧路径是逐层下采样,提取多层特征信息,每个卷积结构(即,C1-C5)都由两个串联连接的卷积层组成。右侧是逐层上采样,同时,通过跳跃连接结构融合多层次特征[20]。

图1 EG的生成器结构

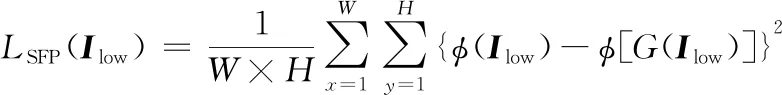

EG设计了全局-局部辨别器结构,避免生成的伪图像在局部区域出现过度曝光或曝光不足问题[19]。由于非配对训练方式缺少配对训练方式中的强监督,EG设计了特征保留损失函数,以加强对生成器的监督训练以及自正则化的效果[19],该损失函数定义如下所示:

(1)

式中:Ilow表示输入的低照度图像;G(Ilow)表示由生成器G输出的增强图像;φ(·)表示特征提取,W和H分别表示特征图的宽和高。

2 算法原理

本文基于GAN的原理实现空间卫星低照度图像增强,其核心思想是训练一对相互对抗竞争的神经网络,即生成器G与辨别器D在训练过程中相互对抗以不断优化各自的网络参数。G的优化目标是生成外观上更接近正常照度图像Inormal的增强图像G(Ilow),即最小化G(Ilow)与Inormal的差异,混淆辨别器对图像真伪的判断。D的优化目标是能更准确地辨别出Inormal与G(Ilow)。这两个相斥的优化目标即产生了相互对抗竞争,在该过程中,G的图像增强能力以及D的真伪辨别能力均在不断提高,促使G(Ilow)在外观上逐渐接近Inormal,即实现了对低照度图像的增强处理。

本文方法流程如图2所示,首先构建非配对样本的训练集,分为Ilow以及Inormal两部分;将训练集中的样本输入到G与D中进行模型训练,在相互对抗过程中不断优化各自的网络参数;训练结束后,得到本文的低照度增强生成器G*,即可利用该生成器实现卫星低照度图像增强。

图2 本文方法流程

本文的训练流程如图3所示,具体步骤如下:

图3 训练流程

1)将Ilow输入G中,生成增强后的卫星图像G(Ilow),即伪图像Ifake;

2)将Ifake与真实图像Ireal(即Inormal)输入D中,对输入图像的真伪进行辨别,输出结果如下式所示。

其中,True与False分别代表辨别结果真与伪。

3)将辨别结果D(I)与对应的样本标签Y输入到G与D的对抗损失函数中,分别输出误差值LG以及LD。

4)固定G的网络参数,将误差值LD进行BP反向传播,更新优化D的网络参数,进而在下一轮迭代中更准确地辨别出真实图像与伪图像。

5)重复步骤2~4,固定D的网络参数,将误差值LG进行反向传播,更新优化G的网络参数,进而在下一轮迭代中缩小Ifake与Ireal的差距。

6)迭代优化次数Niter大于N(迭代次数阈值)时结束训练,得到生成器G*。

2.1 信息传输加强生成器设计

基于常规编码-解码(encode-decode)结构的生成器,通过对输入图像进行编码处理以获得细长的特征向量,而压缩后的特征向量往往会丢失空间关联信息等有效信息。在U-Net结构的基础上,本文设计了如图4所示的密集连接生成器,加强了各特征提取层之间的信息传递,保留更丰富的特征信息。本文的生成器分为左侧四阶段的特征提取部分以及右侧三阶段的图像增强部分,左侧部分是逐阶段下采样,右侧部分是逐阶段上采样,从左至右每个阶段分别记为Stage1~Stage7,共计7个阶段。

图4 本文的生成器结构

记Ci,j(x)为第i阶段中,第j个卷积核尺寸为3×3的卷积层(Conv3×3)的输出,即:

Ci,j(xi,j)=BN[δ(ki,j⊗xi,j+bi,j)]

式中:xi,j是输入的特征图;k为卷积核;b为偏置项;⊗为卷积运算;δ(·)为带泄露修正线性单元函数(Leaky ReLu);BN(·)为批量正则化函数。对于Stage1和Stage2,各阶段的输出Si,是下一阶段的输入xi+1,1,其定义如下:

xi+1,1=Si=Maxpooling

{Conv1×1,n/2[Concat(Ci,1(xi,1),Ci,2(xi,2)]},

i=1,2

式中:Maxpooling是2×2最大池化层;Conv1×1,n/2表示卷积核尺寸为1×1的卷积层;输出通道数为输入通道数n的1/2;其目的是逐像素融合多通道间的特征,压缩图像特征维度。Concat是在通道维度上进行连接。本文在Stage1及Stage2的特征提取中引入了密集连接的思想,加强信息传递,将更多的浅层特征传输到深层特征中[21]。

本文在Stage3中引入了残差连接的结构,避免了因网络深度的增加而引起的梯度消失等问题[22]。Stage3的输出定义如下:

S3=x4,1=Maxpooling[C3,1(x3,1)+C3,3(x3,3)]

本文引入了注意力机制,将输入的RGB图像正则化(Norm)到[0,1]区间,并求取对应的灰度图像,最后通过求反运算得到注意力图A1。对其进行多级最大池化运算,获得多种尺寸的注意力图,以匹配多个阶段输出的特征图,具体计算过程如下:

A1=1-0.299×Norm(r)-0.587×Norm(g)-

0.114×Norm(b)

Ai+1=Maxpooling(Ai),i=1,2,3

式中:r,g和b分别表示图像在R,G和B三个通道上的特征图。注意力图可突出原始图像中的低照度部分,将其与各阶段输出的特征图逐像素相乘,得到注意力增强特征图F,其可引导生成器关注更需增强处理的区域。F定义如下:

Fi=Si×Ai,i=1,2,3,4

在图像增强阶段,特征图F与前一阶段上采样(Upsample)后的特征图进行连接,输出定义如下:

xi+1,1=Concat{F7-i,Conv3×3,n/2[Upsample(Si)]},

i=4,5,6

式中:Upsample是2×2线性上采样。在最后阶段,Stage7输出的特征图S7与注意力图A1逐像素相乘,进一步突出特征图中的待增强区域,经过Conv3×3,n=3卷积运算后,与低照度图像Ilow逐像素相加,输出增强后的卫星图像,其定义如下:

G(Ilow)=Ilow+Conv3×3,n=3(S7×A1)

2.2 辨别器及损失函数

本文采用了全局-局部双辨别器结构[19],在提高图像整体亮度的同时,自适应地提高局部区域的亮度,避免了局部区域过度曝光及曝光不足的问题。如下式(2)和(3)所示,本文采用相对鉴别器结构[1][23]构建辨别器,估计真实图像比伪图像更真实的概率,辨别器在对抗竞争过程中会不断提高该概率,进而提高了生成器的损失值LG,以此加强生成器的网络参数优化[1][23]。

DRl(Ireal,Ifake)=

σ{D(Ireal)-ΕIfake~Pfake[D(Ifake)]}

(2)

DRl(Ifake,Ireal)=

σ{D(Ifake)-ΕIreal~Preal[D(Ireal)]}

(3)

式中:ΕIreal~Preal表示对来源于真实数据的样本求期望;σ(·)表示sigmoid函数。

全局鉴别器以及生成器的损失函数均使用最小二乘损失函数(LSGAN)进行计算。对于全局辨别器,理想的ΕIfake~Pfake[D(Ifake)]和ΕIreal~Preal[D(Ireal)]应分别接近于0和1,期望的辨别结果为D(Ireal)=1,D(Ifake)=0。由式(2)和(3)可知,DRl(Ireal,Ifake)及DRl(Ifake,Ireal)的回归目标分别为1和0。

对于生成器,理想的生成器是生成更真实的伪图像,尽可能混淆辨别器对图像真伪的判断,与辨别器的回归目标相反,DRl(Ireal,Ifake)及DRl(Ifake,Ireal)的回归目标为0和1。因此,全局辨别器以及生成器的对抗损失函数定义如下:

局部辨别器采用LSGAN作为对抗损失函数:

本文同样设置了特征保持损失函数,将Stage4输出的特征图S4输入到该损失函数中进行特征误差计算。特征保留损失函数定义如式(1)所示。最后,总损失函数定义如下:

3 试验结果与分析

为了验证本文算法的有效性,我们将LIME、EG与本文方法在构建的测试集上进行对比试验,利用自然图像质量评价方法(NIQE)[24]对这三种增强方法的性能进行评价。NIQE是一种著名的无参考图像的质量评估方法,在无真实值的情况下,对图像复原的效果进行评价,NIQE数值越低代表图像拥有更好的视觉质量。本文的所有试验均在同一试验环境下进行,试验平台环境为 CUDA v10.1,cuDNN v7.5 以及Pytorch,并在NVIDIA T4 GPU上进行模型的训练及测试。

3.1 数据集构建

本文从Satellite Tool Kit(STK)软件中采集卫星图像,以此构建训练集和测试集。训练集包括低照度及正常照度卫星图像两部分,如图5(a)所示为星空背景下的低照度图像示例,图5(b)是以地球表面为背景的低照度图像,图5(c)为正常照度卫星图像。在卫星低照度图像中,图像质量受损严重,不易观测出卫星的整体轮廓,更不易获取卫星各构件的边缘、纹理及颜色等细节信息。而在正常照度图像中,可清晰观测出卫星的轮廓、纹理及颜色等细节信息。

图5 数据集示例

数据集的具体信息如表1所示,训练集中的低照度图像样本数量(Nlow)为129,正常照度图像样本数量(Nnormal)为183,测试集中共包含30张低照度图像,其中Star与Earth分别表示以星空以及地球为背景的图像。

表1 数据集样本分布

3.2 模型训练

为了进一步提升本文图像增强方法的泛化能力及增强性能,本文采用数据增强方法对模型进行训练,将输入的训练样本进行随机的尺寸调整,定义如下:

(W,H)=[400×Random(λ),600×Random(λ)],

λ∈[1,1.5]

式中:λ是缩放因子,其在区间[1,1.5]中被随机选取(Random),然后以400×600为基数进行图像缩放。同时,还对样本进行随机的垂直和水平翻转,从而达到更优的训练效果。为了有效验证本文方法的性能,我们将本文方法与EG在同样的训练策略下进行模型训练,均以在ImageNet数据集中预训练的VGG[25]网络参数作为生成器的初始参数,辨别器的初始参数与EG一致。本文将Batchsize设置为32,并采用Adam优化器。在训练的过程中,先以0.000 1作为固定的初始学习率训练100个epochs,然后再变化学习率训练100个epochs,期间将学习率从初始值线性递减到0。

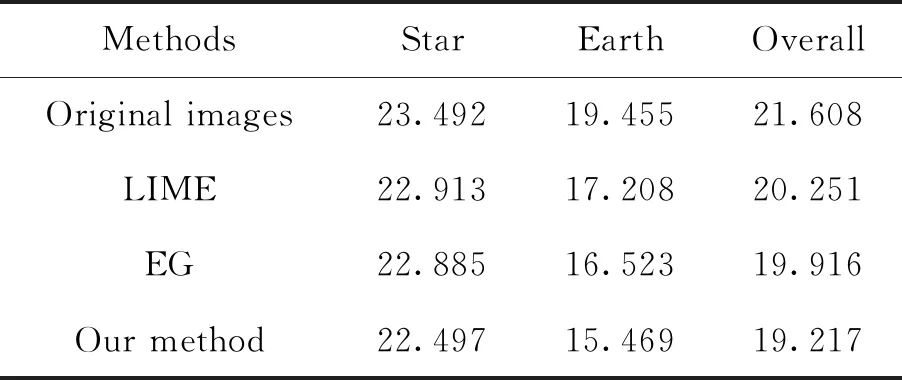

3.3 性能客观评价

我们将LIME、EG以及本文方法对测试集中星空背景以及地球背景的卫星低照度图像进行增强处理,然后以NIQE为标准对各自增强结果进行评价,评价结果如下表所示。

表2 评价指标对比

在客观评价指标NIQE下,本文方法对星空背景以及地球背景的卫星低照度图像的增强效果均优于其他两种方法,图像质量有了明显的提升,较原始图像在总体NIQE指标上降低了2.391。本文方法在以地球表面为背景的低照度图像中的性能表现明显优于其他方法,较LIME及EG在总体的NIQE指标上分别降低了1.034和0.699,达到了19.217。试验结果示例如图6所示,

图6 不同算法的试验结果对比

在图6(a)的低照度图像中,虽然仍可观测出卫星的轮廓,但卫星各构件的颜色及纹理等特征信息严重缺失。在图6(b)的低照度图像中,图像对比度较低,难以判别卫星的整体轮廓,无法提取太阳翼等卫星构件信息,这种低照度图像难以为后续基于图像处理技术的空间任务提供有效的图像信息。

在图6中,本文方法与EG的增强图像在整体亮度上明显高于LIME的增强结果。由图6(a)及(b)中可看出,在LIME的增强结果中存在着明显的颜色失真、构件边缘模糊及清晰度低的问题,EG的增强效果虽然优于LIME,但仍然存在较明显的边缘模糊及色彩失真的问题,尤其在星空背景下,增强后的图像在整体亮度以及清晰度上仍然偏低。相对于LIME和EG两种方法,本文提出的算法能够更好地保留图像的细节信息,大幅提升了图像对比度,提高了空间背景下卫星整体和局部的清晰度,具有更优的图像增强效果。

4 结束语

为解决空间低照度成像条件下的卫星光学图像质量低导致图像信息受损严重的问题,本文提出了一种基于生成对抗网络的空间卫星低照度图像增强方法。设计了一种信息密集连接的生成器,减少了特征信息的损失;通过非配对样本的训练方式,避免了配对样本的获取问题及训练效果差的问题,实现了对生成对抗网络的训练优化,得出本文的低照度图像增强方法。并通过试验证明本文方法较LIME及EnlighenGAN在NIQE指标下分别降低了1.034及0.699,能够更好地保持卫星原始色彩和恢复卫星的轮廓及纹理等细节信息,增强结果拥有更高的对比度及清晰度。通过本文方法,可为后续目标识别等基于图像信息的空间任务提供更丰富的数据信息。在试验中,我们也发现本文方法虽然取得了更优的增强效果,在客观指标以及主观视觉上都有明显的提升,但增强后的部分图像仍然存在噪点,今后的研究方向可在噪点消除方面展开。