基于远红外成像技术的车载夜间行人检测方法

林浩,马可可,牛阿云,庄家俊

(仲恺农业工程学院计算科学学院,广州510225)

0 引言

夜间行车仅约占行车总量的25%,但却有超过50%的交通事故发生于夜间,给行人等脆性目标带来了严重的威胁[1]。得益于恶劣环境适应性强的优点,红外成像特别适合于在能见度差的夜间场景中执行行人检测任务[2]。基于红外成像的行人检测方法通常包含感兴趣区域(Regions of Interest,RoIs)提取和行人识别两个主要环节。刘琼等人[3]提出一种融合行人区域显著性的双阈值图像分割算法,实现了多尺度红外行人分割,但该算法包含较多的模型参数。Dollar 等人[4]提出描述行人目标的聚合通道特征(Aggregated Channel Feature,ACF),结合集成学习方法,提高了光学图像中的行人检测准确性,但由于色彩信息的缺失,ACF 算子无法直接应用于红外行人检测。崔少华等人[5]采用包含若干个卷积层和池化层的LeNet-7 框架,提出了一种基于卷积神经网络的红外行人检测方法;许茗等人[6]在频率域中生成红外行人区域的显著性热图,以行人目标概率图为期望输出,提出了一种全卷积网络行人检测方法;上述基于深度学习的行人检测方法虽能显著提高红外行人识别准确性,但依赖于专属GPU 硬件设备。笔者结合远红外行人目标的成像特性,提出一种基于远红外图像序列的行人检测方法,结合全局和局部图像分割策略快速准确定位潜在目标区域,在AdaBoost 集成学习框架下引入多目标跟踪机制,以提高夜间行人检测系统的鲁棒性。

1 实验数据

在长城小轿车上搭载了一颗热像仪(广州飒特红外股份有限公司NV-628),于广州大学城和广州大道上采集了6 段远红外视频,视频采集时间段为晚上7-8点之间,轿车行驶速度范围为20-60 km/h,视频采集帧率为25 f/s、分辨率为352 像素×288 像素;通过间隔2帧的数据采样方式从6 段视频中提取了6087 幅远红外图像,并随机将其分成训练数据集和测试数据集两个部分(各包含3 段视频),其分别包含2934 和3153幅图像;将训练数据集中从包含行人目标的图像(共2493 幅)中提取了10804 个行人目标区域,对于部分行人目标经过镜像得到额外的4079 个行人目标,共14883 个行人目标区域组成正训练样本,图1 给出了正训练样本宽高比分布图,将剩余仅包含背景目标的图像(共441 幅)作为负训练样本的筛选来源;以最小外接矩形的方式标注了测试数据集中所有的行人目标区域(共4463 个行人),以作为算法验证的客观标准。

图1 行人目标成像尺度分布图

2 远红外行人检测方法

提出的远红外行人检测方法包含感兴趣区域(RoIs)提取、行人特征表达与识别和行人跟踪三个主要部分。

2.1 RoIs提取

设计一种基于改进双阈值分割策略的RoIs 提取算法,分别从全局和局部图像阈值分割两个层面获取潜在的远红外人体区域,并通过区域合并机制抑制图像过分割效应,以产生更精确的RoIs,具体步骤如下:

(1)图像全局阈值分割

如图2 所示,远红外人体区域表现出成像灰度值普遍高于周围多数背景目标的特点,鉴于全局阈值分割通常具有处理速度快的优点,首先通过公式(1)获取能有效滤除大多数背景区域的全局图像分割阈值TG

其中,μ和σ分别为输入图像的灰度平均值和标准差,λ为扰动参数。图3(b)给出了一幅远红外图像的全局阈值分割效果。由分割结果可以看出,全局阈值化后已得到大部分前景,但仍有部分较亮的背景区域也被分割出来,易导致干扰背景与行人区域产生粘连现象,故以此为基础,进一步采用局部阈值分割滤除与行人相互粘连的背景区域。

图2 远红外行人区域灰度分布拓扑图

图3 远红外图像全局阈值分割

(2)图像局部阈值分割

远红外图像中目标的成像灰度值与其散发的热辐射有较大的关联,道路交通场景中可能存在一定数量的干扰热源,使得其难以在全局阈值图像分割环节中被有效滤除,为避免干扰热源对图像全局阈值分割效果的影响,采用局部阈值图像分割获取局部人体区域。

鉴于站立人体的图像区域一般呈现宽高比数值较低的特性,通过指定尺度的矩形窗口限制图像的局部区域,据此计算对应的局部分割阈值。由图1 所示行人训练样本的宽高比分布于1:3 前后,且样本集中行人目标成像尺度面积约为400 像素,故采用大小为13 像素×41 像素、步长为1 像素的滑动窗口进行潜在行人目标区域的局部遍历,并通过公式(2)获取图像局部分割阈值:

其中,I 为输入图像,h 和w 分别表示局部区域中像素点的纵坐标为(20+j)的横坐标范围以及横坐标为(6+i)的纵坐标范围,γ是局部分割阈值扰动系数。进一步,采用公式(3)所示的决策规则实现图像局部阈值分割,图3(c)给出图3(a)所示图像的局部阈值分割效果。

相比于图像的全局滑窗法,以全局阈值分割结果为基础进行前景区域的局部滑窗扫描方式可有效降低RoIs 提取环节的计算开销。此外,由图3 可以看出,从全局和局部两个层面进行前景区域分割,还能获得更高的分割准确率。

(3)区域合并与RoIs 生成

图4(a)给出了基于图3(c)所示阈值化分割图像的RoIs 生成结果,可以看出,部分人体区域存在一定程度的过分割效应,导致独立人体区域被划分成若干子区域,为提高RoIs 生成结果的精确度,结合区域合并策略将临近的两个子区域(如上下或左右毗邻)重组成一个完整区域,要求临近两个子区域在欧氏空间中的距离小于阈值5 像素(该参数通过训练样本集确定),图4(b)给出了基于区域合并策略的RoIs 生成结果。

图4 RoIs生成

2.2 行人特征表达与识别

(1)行人特征表达

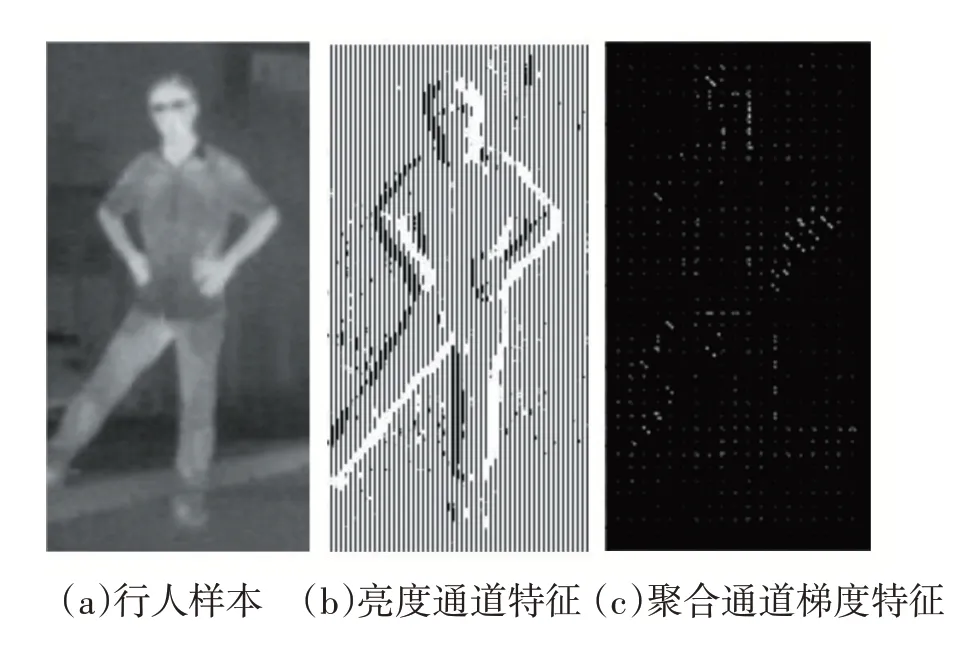

虽然远红外图像缺乏目标的色彩信息,但行人区域与其余背景目标区域在亮度、纹理和形状等外观表征方面仍存在较为显著的差异性,而聚合通道特征(Aggregate Channels Feature,ACF)[4]有利于从多种不同特征通道中提取出表征人体不同外观特性的描述特征,故通过LUV 色彩空间转换后分离出独立于色彩信息的亮度分量,以此为基础采用ACF 算子提取具有7个特征通道的行人描述特征,图5 给出了一幅远红外行人图像的聚合通道梯度特征提取效果。

图5 远红外行人目标的ACF特征表达

(2)行人识别

ACF 特征中仍可能存在一定的冗余性,而通过集成学习方法有利于从中训练针对性的鲁棒行人识别模型。故采用AdaBoost 算法对提取所得的ACF 特征进行训练,其中基础分类器的数量设为2048 个,而训练基础分类器的算法为分类与回归树CART;由于行人检测属于“稀有事件”检测问题[7],为提高后层基础分类器的鲁棒性、同时避免类别偏斜问题,将集成学习过程中的每层正负训练样本数量比例设置为1:5。

2.3 行人跟踪

基于静态/单帧图像的检测方式容易产生较多的目标漏识别现象,为进一步提高行人识别结果的准确性,采用尺度自适应跟踪算法(Discriminative Scale Space Tracker,DSST)[8]在连续多帧的动态图像序列中跟踪已识别到的行人目标,以滤除行人识别环节中错误检测的大量干扰背景。DSST 算法可通过相关滤波器预测目标尺度,适合于多尺度目标跟踪任务,此处结合训练数据集设置相关滤波器的维数为33,以行人识别环节判定结果的区域质心为基准,获取了33 个不同尺度的目标图像,并提取对应目标的梯度累计特征(源自ACF特征),从而形成一个33 维的空间域特征金字塔。在预测过程中,将空间域特征金字塔的第t 维特征归一化成1×t 大小的特征向量(t≤33),结合一维离散傅里叶正反变换在频率域中对第t 维特征(共33 维)进行相关运算并映射回空间域,其中具有最大响应值所对应的尺度即为预测的目标尺度,具体跟踪流程如图6 所示。

图6 基于DSST的行人跟踪流程图

2.4 评估指标

采用漏检率(Miss Rate,MR)和误检率(Error-detection Rate,ER)来评估行人检测结果的准确性,其定义分别见公式(4)和(5),式中TP 为真阳性样本数量,FN 为假阴性样本数量,FP 为假阳性样本数量。

3 实验结果与讨论

在配备Intel Core i5 6300HQ CPU(2.3GHz)、8GB RAM 和NVIDIA GTX 1050 GPU(2GB)的MATLAB R2019a 平台上开展行人检测算法的验证与分析。

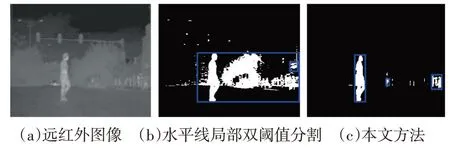

3.1 RoIs提取结果分析

为了评估所提算法的前景分割性能,图7 给出了不同RoIs 提取算法对潜在远红外行人目标的提取效果示例。由图7(b)可以看出,文献[9]采用的水平线局部双阈值分割策略未能很好地过滤更多的干扰背景区域,而本文算法能获得更精确的中近景潜在目标提取结果(如图7(c)所示),有利于减少后续行人识别与跟踪结果中由干扰背景引入的误差;此外,文献[9]的方法需要遍历远红外图像中的所有像素,具有较高的计算时间复杂度,而本文方法事先通过全局阈值分割策略滤除了大部分背景像素点,在随后选取局部分割阈值时,只需要遍历全局阈值化结果中潜在前景区域的像素点,有利于提高RoIs 提取环节的计算效率。

图7 RoIs提取效果对比

3.2 行人识别与跟踪结果分析

由于数据集中的行人尺寸差异较大,在行人识别环节,根据行人样本区域面积大小分布,将行人分为远景、中景和近景目标,分别为每一类目标训练一个Ada-Boost 分类器;远景分类器尺寸为138 像素×44 像素、中景分类器尺寸为110 像素×36 像素、近景目标尺寸为70 像素×24 像素。在441 幅仅包含背景目标的图像中通过Bootstrap 策略共富集了40625 个负训练样本。采用针对红外目标表达的ACF 描述子和AdaBoost 训练策略,在测试数据集上的MR 和ER 分别为25.49%和13.91%。结合具有尺度估计的DSST 多目标跟踪模块后,在测试数据集上的MR 和ER 分别降低为11.63%和3.34%,可以看出,多目标跟踪算法的引入有利于进一步提高行人检测结果的准确性,这是因为常规的行人识别仅针对单帧图像中的目标检测问题,而无法获取目标在连续多帧图像中的运动参数信息,部分误检的干扰背景容易在单帧图像中出现,但一般难以在连续若干帧图像中持续出现,其运动参数(如轨迹)显著有别于行人目标,一定程度上可被多目标跟踪滤波器滤除,从而达到提高行人检测结果鲁棒性的目的。

图8 给出了不同道路场景中的部分行人识别结果,其中黄色矩形标识正确识别的行人目标、品红色矩形标识被误检的干扰背景目标(如图8(e)所示)、红色矩形标识被漏检的行人目标(如图8(f)所示)。值得指出的是,在测试数据集上出现的漏检行人绝大多数是被标注为远景目标的一类测试数据,然而,远红外图像中的多数远景目标通常表现为模糊小目标,这类目标甚至难以通过人工方式准确标注,往往这类目标被评估为歧义性目标,而随着汽车的前向运动,这类歧义性目标将逐渐成为信息量更丰富的中近景目标,故中近景行人是汽车驾驶辅助系统中更为关注的运动目标[10]。

图8 部分行人检测结果示例

4 结语

提出一种基于远红外成像技术的车载夜间行人检测方法,主要结论如下:

(1)通过全局阈值分割可滤除大量明显不包含远红外行人目标的图像子区域,提高RoIs 区域提取的计算效率,以此为基准结合局部阈值分割和区域合并机制能抑制潜在目标区域的过分割,提高RoIs 提取结果的精确度;

(2)从远红外图像亮度分量中提取的ACF 特征能有效表达行人目标的局部形状和边缘轮廓,结合Ada-Boost 学习算法和训练样本数量约束策略有利于缓解“稀有事件”检测对行人识别准确性的影响;

(3)通过DSST 多目标跟踪策略过滤大量基于单帧图像的错误行人识别结果,可提高行人检测结果的鲁棒性。