学习分析四种范式:论范式融合的重要性

[美]赖安·S.贝克 [澳]德拉甘·伽瑟维克 [澳]沙姆亚·卡伦拜亚

【摘 要】

与初期相比,学习分析已经有了长足发展。这个领域从研究成果发表渠道看声誉提高得很快,已经形成一个富有活力的共同体,对政策和实践的影响越来越大。然而,很多研究者仍在厘清这个领域的范围以把学习分析的贡献与其他同样基于教育数据领域的贡献区分开来。我们认为,应该重视协作和了解相关领域的研究成果,才能保证学习分析领域健康发展,而不是强调它们的不同。具体讲,本文提出一个旨在分析当今聚焦教育数据研究的相关领域如何影响学习分析领域发展的框架。该框架的着眼点是这些领域各自所采用的主要方法范式,即本质论、实体论/还原论、本体论/辩证论和存在论。本文使用这个框架分析学习分析领域(本体论范式)如何在方法上受到教育数据挖掘(实体论范式)、量化民族志(存在论范式)和大规模学习(本质论范式)等领域新近发展的影响。本文根据分析结果归纳文献中存在的、有待今后填补的研究空白。

【关键词】 学习分析;教育人工智能;量化民族志;大规模学习;机器学习;研究范式

【中图分类号】 G420 【文献标识码】 B 【文章编号】 1009-458x(2021)12-0038-15

导读:在今天的教育技术领域,学习分析(learning analytics)是一个高频词,也是一个大热门研究领域。这是因为学习分析几乎涉及教育的方方面面,从教师的教和学生的学到机构管理和决策,都可见学习分析的应用。如果以2011年首届国际学习分析与知识大会(LAK)为学习分析领域的起点,其在过去短短十年间的发展可以说是全方位的,包括举办自己的学术会议(LAK)、创办自己的学术期刊《学习分析期刊》(Journal of Learning Analytics)、成立自己的学术团体学习分析研究学会(Society for Learning Analytics Research,SoLAR)等,实践者和研究者队伍不断壮大,教育机构管理层和决策层对学习分析应用也越来越感兴趣。学习分析的教育能供性的确十分诱人,虽然从现状看一定程度上仍然停留在“言辞”阶段,尤其是在促进微观层面教与学方面尚缺乏严谨、可复制、可推广应用的实证研究成果。从某种意义上讲,学习分析现在似乎处于一个停滞(plateau)阶段,比如研究范式单一,方法雷同,混淆变量之间的关联(correlation)与因果(causation)关系,把前者等同于后者。凡此种种,不一而足,都说明学习分析的研究范式必须有新突破,才有可能走出停滞阶段。本文倡导的正是这样一个新发展方向。

本文选择一个新视角,即研究“学习分析与采用不同方法论范式的其他相关领域的关系以及相互影响”,“进一步了解学习分析作为一个领域正在受到哪些方法论范式(methodological paradigm)的影响”。文章首先指出作为一种实践的学习分析吸收了组织研究、变革管理、信息系统、法律和伦理等领域的成果以及受到设计科学和人机交互的影响,并简要阐述两种实践模型:突出学习分析关键维度和问题的模型和强调实施过程的模型。

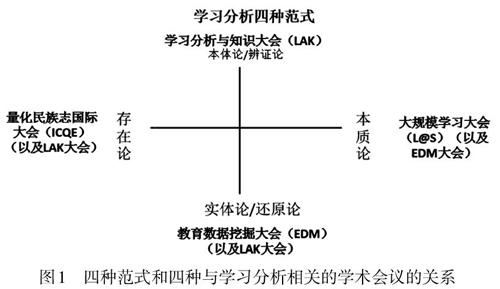

文章认为“学习分析不是一个孤立的领域,它离不开同样致力研究数据教育应用的其他相关领域的发展”,因此,不能一味强调它们的不同,而是应该研究如何取各家之长补各家之短。正是基于这种认识,文章基于20世纪哲学家理查德·麦基翁(Richard McKeon)提出的四种哲学思想流派,即实体论(entitative)/还原论(reductionism)/原子论(atomist)(把现象分解成为其组成部分进行理解,分析组成部分之间的关系)、本体论(ontological)/辩证论(dialectic)(把现象作为一个整体进行理解,认为只有理解整体才能理解其组成部分)、存在论(existentialist)(现实从根本上是个人建构的,因此对现象的理解应该是现实参与者自己的理解)和本质论(essentialist)(天地万物皆有意义,因此只需对现实直接建模,不必说明为什么),建构了一个分析框架,文章认为与数据教育应用相关的四种主要学术会议和这四种范式存在一定对应关系(虽然不是严格意义上的对应关系,详见原文图1)。具体说,四种范式与四种学术会议(或四个相关领域)的对应关系是:LAK大会/学习分析——本体论/辩证论范式、教育数据挖掘大会(Educational Data Mining,EDM)/教育数据挖掘——实体论/还原论/原子论范式、量化民族志国际大会(International Conference on Quantitative Ethnography,ICQE)/量化民族志——存在论范式和美国计算机协会大规模学习大会(ACM Conference on Learning @ Scale,L@S)/大规模学习——本质论范式。文章在这个基础上进一步分析这四种范式在学习分析研究中的体现,提出跨范式研究(inter-paradigmatic)的主张并探讨可能的研究问题(方向)(详见“各种范式在学习分析实践中的主要位置”一节)。

我们不妨把文中提出的跨范式研究问题或方向作为学习分析未来发展的新起点。作者之所以提出跨范式研究的主张,原因是学习分析给我们带来的挑战非常复杂,“非任何一种范式能解决的”。而要实现跨范式的转变,我们每一个人首先必须了解自己对研究和实践所持的哲学观,清楚这种哲学观对我们认识世界的方式的影响,同时我们还要了解相关领域同行的这种哲学观,所谓“他山之石可以攻玉”,不能因为自己的无知而排除“异己之见”。从这个意义上讲,跨范式研究同样应该成为其他研究领域的发展方向。

本文原文发表于《计算机与教育:人工智能》(Computers and Education:Artificial Intelligence)期刊(2021年第2卷)。第一作者美国宾夕法尼亚大学(University of Pennsylvania)的赖安·S.贝克(Ryan S. Baker)博士和第二作者澳大利亚莫纳什大学(Monash University)的德拉甘·伽瑟维克(Dragan Gaševi )博士均是学界颇有影响的学者,分别来自教育数据挖掘和学习分析的专业背景,第三作者沙姆亚·卡伦拜亚(Shamya Karumbaiah)是美国宾夕法尼亚大学学习分析中心博士生(學位论文撰写阶段),具有计算机科学背景,因此他们对于跨范式研究应该有更加深刻的见地。

经三位作者授权,本文得以翻译成中文并在本刊“国际论坛”发表。衷心感谢他们对本刊的支持和信任!

一、引言

2011年举行的首届国际学习分析与知识大会(International Conference on Learning Analytics and Knowledge,LAK)标志着学习分析正式成为一个领域(Long, et al., 2011),因此,2020年迎来了这个领域建成的十周年。“大数据”(big data)的出现给教育带来越来越多的机会,举办LAK大会的初衷就是为了回应这些机会(Siemens & Baker, 2012)。举办LAK大会的另一个目的是给研究者和实践者提供一个交流机会,因为虽然他们都是从事与教育大数据相关的工作但是却没有一个共同社区可以在一起交流、讨论和开展研究(Siemens, 2014)。首届LAK大会组委会把学习分析(learning analytics)定义为“测量、收集、分析和报告有关学习者及其背景的数据以了解和优化学习以及学习发生的环境”(Long, et al., 2011)。这个定义迄今仍然经常被用于界定学习分析,也得到学习分析研究学会(Society for Learning Analytics Research,SoLAR)的正式认可。这个定义强调利用数据促进全面了解和提升教育的各个系统。

与初期相比,学习分析领域已经有了长足发展。LAK大会论文集是教育技术领域被引率最高的出版物之一(Google Scholar, 2020)。提交LAK大会的论文数量和参会人数稳步增加,因此,LAK大会已经成为一个主要学术会议。学习分析社区在全球各地举办LAK博士联盟(Doctoral Consortium)系列活动和学习分析暑期学院(Learning Analytics Summer Institutes)以及多种形式的在线讲座系列活动,致力于培养下一代研究者、实践者和领袖。《学习分析期刊》(Journal of Learning Analytics)已被各主要期刊数据库索引(比如Scopus 和Emerging Sources Citation Index)。《学习分析手册》(Handbook of Learning Analytics)第一版获得成功(Lang, et al., 2017),第二版正在紧锣密鼓进行中。SoLAR建设了一个由个人会员和机构会员组成的网络,并与教育技术行业建立紧密联系。SoLAR还启动几项计划以促进学习分析领域建设,比如组建一些特殊兴趣小组、开展网络研讨会和播客系列活动、出版简报和发布招聘信息。

目前学习分析仍然有很多不确定的挑战需要解决,其中有一些直接关乎这个领域的定位。比如,对于学习分析论文应该具备什么特点目前学界仍然没有达成共识。有人提出LAK大会不能接受没有干预措施的研究论文,也有人认为LAK大会不能发表不是数据科学的论文。如何处理诸如此类问题直接关系到这个领域的健康发展,即培养学科和范式的多样性。具体说,我们有必要进一步了解学习分析作为一个领域正在受到哪些方法论范式(methodological paradigm)的影响。目前对学习分析领域研究文献的综述主要涉及这个领域自身的研究主题和方法(Dawson, et al., 2014; Dawson, et al., 2019; Ferguson, 2012)或某些具体分支(比如仪表盘)(Bodily & Verbert, 2017; Bodily, et al., 2018; Matcha, et al., 2020)、采用情况(Viberg, et al., 2018)和在高等教育的应用(Tsai & Gaševi , 2017)等。还有一些则提出主要旨在促进学习分析与其他领域实践结合的模型(Chatti, et al., 2012; Gaševi , et al., 2017; Greller & Drachsler, 2012; Siemens, 2013)。虽然这些综述和模型对于学习分析未来发展很有意义,但是几乎没有研究关注学习分析与采用不同方法论范式的其他相关领域的关系以及相互影响。因此,本研究是对现有文献的补充。

学习分析不是一个孤立的领域,它离不开同样致力研究数据教育应用的其他相关领域的发展。总体上看,数据挖掘和分析已经发展成为教育技术研究的一个核心主题和领域(Chen, Zou, et al., 2020)。自从新千年以来已经出现了一些相关领域,它们有自己的共同体,所采用的研究方式也有所不同。最先出现的是教育数据挖掘(Educational Data Mining,EDM)这个领域,历史比学习分析悠久,2000年以来在一些主要学术会议上举行一系列工作坊,在此基础上2008年举行了首届EDM大会,2009年创办了《教育数据挖掘期刊》(Journal of Educational Data Mining)。EDM大会和期刊均由国际教育数据挖掘学会(International Educational Data Mining Society,IEDMS)主办,该组织架起了研究者与教育技术行业和很多利益相关者组织之间的桥梁。另外两个比较关注数据在教育中的应用的共同体则分别围绕美国计算机协会大规模学习大会(ACM Conference on Learning @ Scale,L@S)(2014年举行首届大会)和量化民族志国际大会(International Conference on Quantitative Ethnography,ICQE)(2019年举办首届大会)建立起来的。尽管如此,除了西蒙斯和贝克(Siemens & Baker, 2012)以及陈等(Chen, Rolim, et al., 2020)之外,目前鲜见构建系统分析这些相关领域相互影响的框架的研究。西蒙斯和贝克(Siemens & Baker, 2012)阐述了把相关领域联系起来的重要性,而陈等(Chen, Rolim, et al., 2020)则比较了LAK大会和EDM大会的主题、文献计量情况以及參加者身份。然而,有必要系统研究相关领域当前的发展,进一步了解它们正在对学习分析产生的影响。

本文提出了一个分析框架,旨在揭示教育数据相关领域是如何影响学习分析研究趋势的。这个框架聚焦这些领域各自主要采用的方法论范式。具体讲,本文使用这个框架分析学习分析领域(本体论[ontological]范式)是如何在方法上受到教育数据(实体论[entitative]范式)、量化民族志(存在论[existentialist]范式)和大规模学习(本质论[essentialist]范式)等领域新近发展的影响的。本文根据分析结果归纳文献中存在的、有待今后填补的研究空白。

二、作为一种实践的学习分析

学习分析从一开始便既是一个研究领域又是一个实践领域。之所以强调实践,主要是因为政治和经济因素的变化(Buckingham Shum & Luckin, 2019; Ferguson, 2012; Siemens, 2013)。教育发展受制于政治和经济因素,全球均如此。很多国家高等教育拨款模式在很大程度上受到顺利获得学位的学生人数的影响。所以,学校高层管理者(比如副校长、院长和教务长)和决策者看到学习分析通过预测建模和早期预警系统降低学生流失率方面的潜能(Siemens, 2013)。同样,使用预测分析提高K-12毕业率也越来越引起研究者的兴趣(Bowers, et al., 2012; Singh, 2018)。学习分析可用于支持学生继续就读(减少流失)以及学校其他需要优先考虑的事情,由此形成了学校事务分析(academic analytics)(Campbell, et al., 2007)。学校事务分析对学习分析影响很大,并由此促使从事学习分析的人和高等教育学校信息技术负责人这两个群体建立紧密关系。后者通常参加EDUCAUSE举办的活动。

学习分析的另一个重要实践是评价和提高数字技术的教育应用效果。与过去相比,学界目前对这方面更感兴趣。高等教育对使用学习管理系统尤其感兴趣(Ferguson, 2012),因此很多研究者在探索如何使用学习管理系统记录的日志数据和开发报告系统(现在被称为“仪表盘”),这些系统采用信息可视化和相对简单的数据分析技术(Jovanovi , et al., 2008; Rienties, et al., 2018)。学习分析在这方面的应用不但能给教师提供相关的解决方案,而且也引起诸如教学/教育设计者和教育/学习技术人员的兴趣(Weller, 2020)。

除了学习管理系统外,学界对基于计算机学习环境的使用和进一步完善也有比较大的兴趣,比如自适应学习系统、智能辅导系统和慕课(Essa, 2016)。目前K-12越来越重视标准化考试,学校也需要证明学生考试成绩的提高以获得拨款,因此这是基于计算机学习环境在K-12发展的主要驱动因素之一。这种现象始于英美,但现在已经席卷全球(Lingard & Lewis, 2016)。至于高等教育,虽然没有这样的驱动因素,但是师生同样热衷于使用这些学习技术。诸如ALEKS、Cognitive Tutor、Khan Academy、edX和Coursera这些大平台的用户多达数十万或数百万。学习分析研究者试图利用这些数据使这些平台更有效,进一步完善知识考核以改进课程学习顺序(Ritter, et al., 2016),通过各种人类记忆模型更好地安排各阶段复习(Settles & Meeder, 2016),把复杂的考核任务融入教学干预策略中(Li, et al., 2018),以及研究针对不同学生和不同环境的不同干预措施(Sales, et al., 2018)。如同学习管理系统一样,学界在这方面也很热衷于通过报告和可视化手段向教师提供反馈信息,便于他们据此与学生交流和做出相应干预(An, et al., 2019; Holstein, et al., 2019)。

正因为学习分析强调实际应用,很多学习技术销售商从这个领域形成之初便积极参加学习分析的活动,赞助LAK大会和EDM大会并发表论文。的确,今天的LAK大会设置有实践者参加的分主题,而EDM大会则设置有业界参加的分主题。

(一)影响学习分析实践的领域

文献一直强调学习分析的社会——技术本質(Dawson, et al., 2019; Siemens, 2013)。这一点在SoLAR所采用的学习分析定义中便得到体现,即学习分析使用学习发生环境的数据(Long, et al., 2011),也体现在和2019年国际电子组件与材料研讨会(International Electron Devices and Materials Symposium,IEDMS)所采用的教育数据挖掘定义中,即教育数据挖掘的目标是“更好地了解学生以及他们的学习环境”。学习分析领域一些著名作者指出学习分析应用于组织环境中,而在这样的环境里社会、政治、隐私和伦理因素的作用至少与任何技术解决方案同等重要(Colvin, et al., 2015; Dawson, et al, 2018, 2019; Gaševi , et al., 2017; Lynch, 2017; Macfadyen, et al., 2014; Siemens, 2013)。正因如此,学习分析的很多研究集中在制订实践准则、政策和策略框架等方面,而这些东西已经影响到很多机构和系统对学习分析的采用(Sclater & Bailey, 2015; Tsai, et al., 2018)。作为一个实践领域,学习分析在很大程度上得益于组织研究、变革管理、信息系统、法律和伦理等领域的成果。

因为意识到学习分析实践是在复杂教育系统中开展的,因此研究者更加重视借鉴复杂性科学和理论(Jacobson, et al., 2016)。研究者强调必须把学习分析置于复杂教育系统中开展才能使之发挥最大的实际作用(Dawson, et al., 2019)。有研究者认为学习分析的成功变革管理要建立在对复杂自适应系统理解的基础上(Macfadyen, et al., 2014)。复杂性领导力包含运作、开创新局面和使能三个方面,因此被视为扩大学习分析应用规模促进教育创新所必不可少的(Tsai, et al., 2019)。

要使学习分析在实践中得到广泛应用,必须重视其设计和充分考虑人的因素(Buckingham Shum, et al., 2019; Gaševi , et al., 2017)。不同学习分析工具(主要是指仪表盘)曾经受到热捧,但是有一些研究发现这种工具的实际应用率经常相对较低,也可能造成一些不理想后果,比如如果缺乏有效设计(Bodily & Verbert, 2017; Corrin & de Barba, 2014)会导致大学本科生的掌握导向(mastery orientation)表现下降(Lonn, et al., 2015)和平均积分点(GPA)下降(Chaturapruek, et al., 2018)。因此,近年来研究者提出一些旨在指导学习分析系统设计和理解意义建构的方法(Holstein, et al., 2019; Wise & Jung, 2019)。白金汉·岑等(Buckingham Shum, et al., 2019)更进一步提出要充分考虑学习分析中人的因素。这个方向的研究清楚强调学习分析实践越来越受到设计科学和人机交互的影响。

(二)学习分析实践模型

有几种学习分析模型能够指导实践、承认学习分析领域复杂性和体现来自其他方面的影响。这些模型通常被分为两类:一类体现这个领域必须考虑的关键维度和问题,另一类则强调学习分析的实施过程。沙提等(Chatti, et al., 2012)提出一个学习分析参考模型,该模型包含四个维度,以分别回答四个方面问题:数据、环境和背景之类统称为“什么”(What)的问题;目标之类统称为“为什么”(Why)的问题;方法之类统称为“如何”(How)的问题;利益相关者之类统称为“谁”(Who)的问题。格雷勒和德拉克斯勒(Greller & Drachsler, 2012)提出的学习分析通用框架也包括类似四个维度的內容,但是他们所用的名称和各个维度的范围与沙提等稍有不同。格雷勒和德拉克斯勒的模型还增加了自身局限(能力和接受程度)和外部制约(规范和惯例)内容。

研究者提出了一些学习分析的过程模型,均把学习分析视为一个循环。克洛(Clow, 2012)的学习分析循环始于产生数据的学习者,这些数据的测量和分析结果用作采取干预措施的依据。其他过程模型更加细致,包括学习分析循环的其他活动。斯坦纳等(Steiner, et al., 2014)提出的学习分析交互过程模型包含数据选择、数据捕捉、数据报告、预测、根据结果采取行动和进一步完善。西蒙斯(Siemens, 2013)的数据循环也包含类似阶段,但主要增加了辨识数据循环各阶段与学习分析目的、数据源、利益相关者、分析技术和行动类型之间的关系。换言之,西蒙斯认为学习分析是一个跨学科的研究和实践领域,得益于很多类型利益相关者的贡献。

三、学习分析的四种思维范式

(一)四种范式

不管学习分析被视为一种实践还是一门科学,作为一个年轻的领域,学习分析的成分相当复杂——这一点是不可否认的。目前有三个与之相关的重要会议:EDM大会(始于2008年)、LAK大会(始于2011年)和L@S大会(始于2014年)。还有一个会议是ICQE大会(始于2019年),其范围不只涉及学习和教育方面,但是第一届和第二届大会的绝大多数内容都是属于学习和教育方面的。另外还有一个会议的历史更加悠久,在学习分析成为一个研究领域之前就出现了,即教育人工智能大会(Artificial Intelligence and Education,简称“AIED大会”,始于1989年)。AIED原先的涉及面广泛,包括人工智能在教育领域的各种应用,早期的工作主要是设计用于教育的智能系统和为这些系统开发学生模型。EDM可能是AIED的一个分支,AIED大会与EDM大会一样发表大量教育数据挖掘的研究成果。

其他一些会议也发表很多学习分析研究成果。一直以来,智能辅导系统(Intelligent Tutoring Systems,ITS)大会发表与AIED大会相似的研究,多年来这两个大会隔年举行。首届EDM大会事实上和ITS大会一样都是2008年在蒙特利尔举行的。其他发表学习分析研究成果的会议包括学习科学国际会议(International Conference on Learning Sciences)(早期从AIED发展出来的一个分支)和计算机支持协作学习会议(Computer-Supported Collaborative Learning,CSCL),它们涵盖的范围更广(因为包括其他形式的研究)但同时又更窄(关注的现象更具体)。此外,有一些机构,比如学习分析暑期学院(Learning Analytics Summer Institute)和西蒙项目暑期学校(Simon Initiative Summer School)(这些主要是举办培训,不是发表成果)以及地区性会议和各国全国性会议也跟学习分析有关系。

在已经有EDM大会的情况下还举办LAK大会,可能是因为这两个会议的发起者彼此不认识。在组织首届LAK大会时EDM大会和LAK大会的发起者中几乎没有互相认识者。这的确是一件怪事。然而,我们认为这些分支并不只是当时同一个领域研究者的社交网络不畅所致的偶然结果,而是因为不同研究者在如何理解科学,甚至是现实的本质方面,存在的深层差异所致的。这些深层次的不同促使早期很多教育数据挖掘研究者研究智能辅导系统和游戏以及供学习者个体使用的技术,而早期很多学习分析与知识研究者则重视研究协作性和基于讨论的学习环境,尤其是在大学层次。因为选择不同研究方向,很多研究者无缘相识,这或许是学习分析研究者举办自己的会议而不是参加EDM会议的原因,也可能是教育数据挖掘研究者(比如本文第一作者)大多没有听说过首届LAK大公组织者的原因。

但是,为什么学习分析研究者和教育数据挖掘研究者(大多数)思维不一样?一种可能的解释要追溯到公元前4世纪,也就是说即使是本领域最资深的研究者开始从事这方面研究之前这些不同就已经存在了。

理查德·麦基翁(Richard McKeon)是20世纪著名哲学家,虽然很多人看不懂他的哲学。他曾经阐述四种可以追溯到柏拉图(Plato)和亚里士多德(Aristotle)的哲学思想流派(McKeon, 1966):实体论(原子论[atomist]/德谟克里特斯[Democritus])、本体论(柏拉图)、存在论(诡辩论[sophist]/普罗泰戈拉[Protagoras)和本质论(亚里士多德)四种思想流派。沃森(Watson, 1994)和里克(Rich, 2018)对麦基翁的观点进一步扩展和阐释,方便读者理解。这些思想流派有各自喜欢使用的“方法”(鉴于本文目的,不妨视为元方法[mets-method]或有关方法的思维方式)。

简而言之,还原论(reductionism)是实体学派的主要方法。还原论在理解现象时把现象分解成为它们的组成部分,然后进一步分析这些组成部分之间的关系。虽然一直以来还原论没有受到哲学家的青睐(德谟克里特斯的名声远不及柏拉图和亚里士多德),但是还原论已经发展成为很多学科的核心元方法。这里有必要提醒读者注意,还原论主张所有现象都可以被简化为物理过程(Sachse, 2013),但是我们采用还原论这种方法时不必接受这种激进观点。

辩证法(Dialectic)是本体论学派的主要方法。这个学派认为要把现象作为一个整体进行理解或者把系统理解为系统,只有理解整个系统才能理解其组成部分。这种理解常常通过以下过程得以实现:分析看似矛盾的不同观点以逐步更好地理解某一现象或系统,同时使抽象和不完整的理解具体化和更加完整。

麦基翁用于表述另外两种方法的术语(运算[operational]和疑难[problematic])较少为人所知,但是它们所代表的思想流派却是学界所熟知的。存在论把现实视为从根本上是个人建构的,因此认为对现象的理解应该是现实参与者自己的理解而且這些理解具有不可简化的合理性(诸如“哲学建构主义”[philosophical constructionism]和“现象理解”[phenomenological understanding]这些术语时有所见)。存在论经常使用本质上是描述性的方法,而且拒绝采用通用目的措施(Strohecker, 1991)。

与之相反的本质论认为天地万物皆有意义,因此认为“数据的作用难以讲清楚”,并将其当成拒绝可解释的建模方法的理由(Halevy, et al., 2009)。换言之,对现实进行直接建模就足够了,不必说明理论依据或解释(这甚至是不足取的)。

我们对这些问题的理解也得益于另外一个理查德——20世纪和21世纪设计领域一个主要思想家理查德(“迪克”)·布坎南(Richard “Dick” Buchanan)。大约有十年的时间,布坎南在卡内基梅隆大学(Carnegie Mellon University)的设计专题研讨班上从交互设计方法的角度讨论以上四种哲学思想流派。虽然笔者不知道布坎南的这些观点是否正式成文,但是我们知道因特网上有一些听课笔记①。布坎南认为设计从实体论角度看是人与物品之间的关系,从本体论角度看是人与宇宙之间的关系,从存在论角度看是人与人之间的关系,而从本质论角度讲则是人与环境之间的关系。

布坎南在讲课中提到的一个主要主题是大多数设计师更喜欢从其中一种或两种范式的角度进行设计,并经常觉得其他范式似乎令人费解,甚至可能是认为故意不想让人理解,因此不予认可。格里诺(Greeno, 1997)和安德森等(Anderson, et al., 1997)之间的辩论便是一个很好的例子。格里诺主张从本体论的“情景主义”(situationalist)角度看认知科学,而安德森等则主张采用实体论。安德森等最后把格里诺的范式称为“形式”,而他们自己的范式才是“实质”,格里诺的文章被视为“情景噪音”(situa-babel)。格里诺则把安德森等的文章称为“回答错误问题的主张”。由此可见,双方视角不同,重点考虑的问题也不同。

(二)四种范式在学习分析中的体现

西蒙斯和贝克(Siemens & Baker, 2012)最早尝试把麦基翁和布坎南等的观点与学习分析联系在一起,他们认为教育数据挖掘的大部分研究“更加强调把现象还原为组成部分并分析各个组成部分以及它们之间的关系”(体现实体论/还原论),而大部分学习分析研究则“更加强调把系统视为整体理解并全面理解其复杂性”(本体论/辩证论)(p.253)。的确,学习分析早期的研究认为采用还原论从根本上讲意味着意义的丢失(Atkisson & Wiley, 2011),西蒙斯和贝克在撰写续篇时对有关问题的讨论也反映了布坎南的观点(采用不同范式的不同研究者对其他范式的态度)(2012年4月25日电子邮件),比如西蒙斯问道:“你在发言中提到教育数据挖掘强调还原论。这是你要传递的信息吗?还原论通常包含贬义,至少在人文学科和社会科学领域是如此。我认为给教育数据挖掘贴上还原论标签可能会使其陷入它不想要的处境中!(我相信你很清楚还原论的观点,但我想我还是要提出这个问题,或许你想修改一下措辞。)”我在这里引用西蒙斯的这段话,不是为了批评他(他本人对其他范式持开放态度),而是为了说明某个人用于表述自己所采用的范式的语言在另一个领域的人看来可能是包含贬义。再如,有些统计学家用“数据挖掘”这个术语指没有原则的劣质研究(Jensen, 2000)。

根据西蒙斯和贝克的文章以及两人的讨论,我们或许有理由认为学习分析(从一开始)主要采用本体论/辩证论范式,而教育数据挖掘(从一开始)主要采用实体论/还原论范式。图1展示了四种范式与相关领域研究者之间的关系。

早期EDM大会研究成果中体现实体论/还原论的一些例子包括:

· 把各个知识领域的结构简化为一套技能,这些技能对应相应项目(Barnes, 2005),并进一步研究具体项目中某一项技能能否弥补另一项技能(Pardos, et al., 2008);

· 研究智能辅导系统哪一种方法最能有效预测学生未来表现(Baker, et al., 2008; Pavlik, et al., 2009);

· 通过分析辅助性资源的使用情况和对学习表现的直接促进作用评价辅助性资源的质量(Chang, et al., 2006)。

提交首届LAK大会的研究成果中体现本体论/辩证论的一些例子:

· 提出分布式学习多层次分析的本体论(Suthers & Rosen, 2011);

· 可视化呈现随着时间推移学习者之间交互模式的变化(Bakharia & Dawson, 2011);

· 从社会文化角度分析会议参加者之间各种形式的对话(Ferguson & Shum, 2011)。

更加体现本质论范式的研究在早年EDM和LAK大会上相对不受青睐,因为审稿人不看好在不理解现象的情况下对现象进行预测的研究。贝克(Baker, 2012)一书收录了一项研究,作者试图根据全部作业和考试的成绩预测一门课程的最终成绩。这确实有点出乎意料(因为该书的主题是教育大数据)。然而,L@S大会的举办为本质论范式研究提供了一个交流舞台,早期一些例子包括:

· 全面调查慕课学习者何时停止观看课程视频和何时交互更加频繁(Kim, et al., 2014);

· 分析发帖量更大的学生特点,包括他们的人口统计信息、年级、注册学习的课程数量和发帖的内容和背景(Huang, et al., 2014);

· 对学生在学习一种非正式编程语言过程所呈现的模式进行聚类,量化分析非正式学习(Yang, et al., 2014)。

并非提交L@S大会的所有论文都采用这种范式,第二届大会(原先明确不鼓励提交涉及智能辅导系统数据的论文,但第二届放弃执行这个政策)收到不少通常参加EDM大会的作者提交的论文。但是,L@S大会为对本质论范式感兴趣的研究者提供了一个交流舞台。随着L@S大会的成功举办以及机器学习领域热衷研究高深莫测的算法,即深度学习(LeCun, et al., 2015),研究不理解情况下的预测成为EDM大会论文的一种趋势,即上文提到的“数据的作用难以讲清楚”(Halevy, et al., 2009),包括使用深度学习对学生知识(Khajah, et al., 2016)和学生情感(Botelho, et al., 2018)进行建模的算法和给简答题评分的算法(Zhang, et al., 2016)。

LAK大会也出现与这种趋势相对应的情况,很多原来向AIED或EDM大会提交论文的研究者开始在LAK大会发表他们的研究成果。比如:

· 研究在慕课学习中对不同社会经济地位(能力)的态度和意见的不同程度如何影响同伴反馈并对此进行建模(Choi, et al., 2019);

· 研究学习游戏设计的变化如何对学习者的选择和表现产生实际影响(Harpstead, et al., 2019);

· 分析未能完成作业现象和这种现象与学生自信的关系(Botello, et al., 2019)。

存在论范式总体看较少见。采用这种范式的研究偶尔散见于学习分析领域,包括利用学习分析和数据揭示开放式、自我指导任务的学习情况(Blikstein, 2011; Worsley & Blikstein, 2015)、研究不同学习者解决问题的各种不同方法(Martin, et al., 2015)、采用诸如聚类的方法了解不同学习者的更深层次差异(Amershi & Conati, 2009),以及对学习相同课程的大学生和高中生的话语模式的差别进行认知网络分析(Shaffer & Ruis, 2017)。至此,存在论范式研究者还没有在学习分析相关的各种会议找到一个“可靠的家”,比如伯兰、贝克和博利施泰因(Berland, Baker, & Blikstein, 2014)的学习分析在建构主义(constructionist)的应用宣言发表于《技术、知识与学习》(Technology, Knowledge, and Learning)期刊,而不是主流的学习分析出版物/场合。伯兰和博利施泰因早期的几篇文章发表在学习分析出版物/场合之后,近年已经另辟蹊径发表他们的研究成果。

相比之下,量化民族志研究者创办自己的学术会议——ICQE大会,以弥补学习分析领域没有向他们提供相应舞台的缺陷(虽然认知网络分析在计算机支持协作学习大会获得成功)。ICQE大会的范围不仅包括学习或教育,举办这个大会的部分目的是扩大研究领域和研究方法,虽然首届大会的正式论文中78%涉及学习或教育方面的研究。

提交首届ICEQ大会的论文包括:

· 分析职前教师诊断性推论上的差别(Bauer, et al., 2019)。

· 采用认知网络分析呈现一个在线游戏社区资深成员随着时间推移身份的变化(Barany & Foster, 2019);

· 了解学生面对动机或理解方面问题时在如何调节协作学习方面的不同(Melzner, et al., 2019)。

有趣的是,虽然首届ICEQ大会举办地麦迪逊是建构主义学习分析研究的中心,但是提交首届大会的论文没有涉及建构主义学习环境的研究。这在某种程度上讲可能是因量化民族志所采用的主要方法所致的,即认知网络分析以及相关方法体现的是采用存在论范式处理大规模教育数据,当然这不是唯一的方法。雖然一些建构主义学习分析使用了网络分析方法(比如:Martin, et al., 2015),但是很多研究也同时使用其他方法。建构学习分析研究者未来将在何处“安家”目前尚不清楚。

近来出现了一个变化,即存在论范式研究在学习分析会议和期刊占有更大的份额,比如《学习分析期刊》最近出版“以人为中心的学习分析”主题专刊,其前言提出学习分析研究要“承认对现实的理解因环境而异……必须从学习分析主要重视量化,向有助于详细阐述说为什么和如何使用学习分析以及为什么学习分析可能被误用或被忽视的转变”(Buckingham Shum, et al., 2019, p. 6)。与之相呼应的是2020年LAK大会出现了一大批采用认知网络分析方法的论文(比如:Chen, Rolim, et al., 2020; Ferreira, et al., 2020; Saint, et al., 2020; Swiecki & Shaffer, 2020; Uzir, et al., 2020; Whitelock-Wainwright, et al., 2020)。

总的来看,上述四种范式分别主要在四个与学习分析相关学术会议“安家”:实体论/还原论是EDM大会,本体论/辩证论是LAK大会,本质论是L@S大会,存在论是ICEQ大会。近来,EDM大会扩大范围,也接受本质论范式研究,LAK大会也一样,接受实体论/还原论和存在论范式研究。这些对应关系还在继续变化,因此现在难以断言以这些会议为中心而形成的不同研究者共同体最终将采用什么范式。

四、各种范式在学习分析实践中的主要位置

正如库恩(Kuhn, 1962)的经典论著《科学革命的结构》(The Structure of Scientific Revolutions)所指出的,当一个科学领域存在一种以上相互竞争的思维范式时,经常会出现这种情况:其中一种范式会争取在竞争中“胜出”并独霸整个领域。虽然库恩明确指出他的理论不适用于社会科学,但是以心理学为例,过去几十年对库恩的理论有过很多讨论(Coleman & Salamon, 1988)。当然,上文提到的安德森等(Anderson, et al., 1997)和格里诺(Greeno, 1997)之间的辩论也证明不同范式阵营的人对何种范式才是“正确的”范式意见甚为相左。从广义的学习分析领域衍生出来的专业性更强的学术会议也证明,研究者都希望能找到一个与自己认识世界的方式相配的“知识家园”,而同样的情况还有上文提到的相关学术会议范围的扩大变化,比如本来提交EDM大会的一些研究(实体论范式)转而投给(主要接受本体论/辩证论范式研究的)LAK大会,另一方面EDM大会开始接受本质论范式研究等。

并非所有研究者和实践者都采用相同范式,因此我们认为不同范式的存在很自然,也是好事,有益于学习分析的发展。学习分析给我们这些研究者和实践者带来复杂挑战(参见:Baker, 2019; Pelánek, 2020),这些挑战如此艰巨,非任何一种范式能解决。学习分析给教育界带来非常重要的机会,不能因为教育内部的“派别之争”而浪费这些机会。

然而,我们认为各种会议“各行其道”这种“不相往来”的态度不足取(幸运的是,如上所述,现在没有出现这种情况)。符合规律的做法是某一个会议和社区选择与自身对知识的认识相适应的研究问题,聚焦这些问题。EDM大会或许是这种做法的一个好例子。EDM大会特别关注预测问题的准确性和(或)知识的推断,2019年的大会一共收到28篇这个主题的论文!

我们认为不同思维范式阵营的研究者必须加强协作,除了保持本领域跨学科特点外,朝着“跨范式”研究方向发展。帕夫利克和托特(Pavlik & Toth, 2010)在谈到智能辅导系统实践社区存在的不同观点时指出:“从根本上讲,虽然这些观点可能有所不同……但是在这种情况下它们能互为补充和相互加强。”(p. 105)

正因如此,我们认为一种范式的方法在解决另一种范式的短板问题上可能发挥非常有效的作用。下面我们拟提出一些可能的做法。

第一种做法其实已经存在。基于本质论范式、更加适合使用数据的高深莫测模型正在为教育数据挖掘领域所接受,因为在很多情况下更好的预测本身是一件好事。虽然预测准确性不是一个模型的唯一目标,但是我们有充分理由选择AUC ROC值0.75的模型,而不选择AUC ROC值0.65 的模型。高深莫测、预测能力强的模型对我们日常生活产生变革性影响,比如在语音识别方面。关键是必须明确哪些情况需要更高的预测准确率并且有解决效度问题的好办法,因为准确率的优化可能带来其他效度问题,因此既要能够发现这些问题又要能够减少这些因素的影响。比如,杨和杨(Yeung & Yeung, 2018)提出了一个学生知识估测深度学习模型,发现一些效度问题,然后通过正则化(regularization)在不降低模型预测准确率的情况下解决这些问题。把本质论范式在预测准确率方面的优势与实体论范式重视效度的优势相结合,这可能有助于解决实体论范式和辩证论范式学习分析实践者所希望解决的问题。

基于本质论范式的强大预测力与基于实体论范式逐一考虑各组成部分的效度相结合对其他范式的研究可能大有裨益。教育数据挖掘研究采用实体论范式已经证明有助于各种“模型发现”(discovery with models)分析(某种现象的模型被用于更深入理解这种现象,甚至是其他现象)(Baker & Yacef, 2009)。多年来,模型发现是教育数据挖掘研究采用的一种重要方法,比如贝克和亚瑟夫(Baker & Yacef, 2009)的文献综述中19%的论文以及2019年EDM大会18%正式论文均采用模型发现方法。LAK在系统方面的研究中经常依靠相对简单的构念(比如投入),导致在制订其测评指标的时候困难重重(Kovanovic, et al., 2016)。如果在这些分析中采用预测能力更强、经过更加全面验证的模型,则有可能获得更丰富、更可信的结果。同样,量化民族志的很多研究给复杂的认知网络分析输入相对简单的测评指标,或者是依靠人工穷尽编码或使用正则表达式匹配(regular expression matching)生成数据输入认知网络分析(比如:Cai, et al., 2019)。如果在认知网络分析中采用預测能力更强、经过更加全面验证的模型,则可能做到深层次考虑教育数据挖掘和大规模学习领域现在能够测量的不同复杂类型构念之间的关系(比如对语篇的自动编码[Ferreira, et al., 2020])。

实体论范式发现复杂构念的能力有益于其他范式的研究。很多存在论范式研究涉及对具体案例进行质性深度分析——这是一个非常费力的过程(Sherin, et al., 2018)。虽然可视化能提高分析过程的速度(Shaffer & Ruis, 2017; Sherin, et al., 2018),但是收集质性数据经常可能是一个深入而又耗时的过程,因此使用自动化模型加快质性数据的收集和分析的速度可能大有裨益。如果我们能够确定我们特别感兴趣的案例,我们便能集中分析这些案例。更值得称道的是,如果我们能够确定对哪些正在发生的案例感兴趣,我们便能够集中收集它们的质性数据,如访谈和观察。比如,观察到学生情绪变化时马上向現场质性研究者发出提醒,研究者便能够在这种情绪变化的一分钟之内对该学生进行访谈(Baker, in preparation)。

存在论范式可能在几个方面支持其他范式的研究。量化民族志和其他存在论范式方法很可能有助于更好地理解其他范式机器学习模型所研究的现象。比较现象可见和现象不可见在行为上的关系(比较认知网络)可能有助于我们更好地了解这种现象发生的原因(比如:Karumbaiah, et al., 2019),构建发现这种现象的更有效特征工程(feature engineering)。从现象学的角度了解编码者发现一个构念的推理过程也可能更好地发现这个构念。比如帕克特等(Paquette, et al., 2014)采用知识工程方法研究编码者是如何发现“钻空子”现象的,并把结果用于发现其他学习系统相同现象且无须重新训练模型(Paquette & Baker, 2019)。

民族志和其他存在论范式在学习分析研究中可能还有一个重要用途,不是在建模阶段,而是在使用这些模型的阶段。如上所述,民族志方法在设计干预方面可能发挥重要作用,不管是报告还是自动干预,教师、学生和其他利益相关者都可能发现它们有用、实用和可取(参见:Buckingham Shum, et al., 2019; Holstein, et al., 2019)。虽然这方面的研究一般可能以辩证论或实体论范式学习分析与人机交互实践者或传统民族志研究者之间相互协作的形式进行,但是量化民族志能够开发更加符合利益相关者的思维,因而他们觉得更为可取的模型。用户常常对模型如何工作以及是否有作用产生怀疑(Rientes, et al., 2018),因此,如果模型更符合人类思维方式,这可能有助于克服目前学习分析推广应用的障碍。

从另一个方面看,学习分析能够使量化民族志实现系统层面的理解。民族志是一种存在论范式方法,能够使我们全面深入了解深深植根于具体环境的个人经历。虽然它能为构建符合利益相关者思维方式的模型和工具提供宝贵见解,但是这种方法很难考虑更加宽泛的系统层面问题。相比之下,主要采用本体论范式的学习分析则能够提供系统层面的理解。未来一个富有成效的研究方向是研究如何采用民族志方法全面揭示利益相关者对学习分析的期望和使用经验(Pontual Falcão, et al., 2020),并把这个结果融入能模拟相关政策和策略的系统影响的模型中(Dawson, et al., 2019)。另一个相关的例子是社会认知网络标记(Social and Epistemic Network Signature,SENS)(Gaševi , et al., 2019; Swiecki & Shaffer, 2020),这种方法把社会网络分析(本体论范式)和认知网络分析(存在论范式)相结合,用于分析网络和协作学习的社会和认知维度。

五、结束语

本文讨论了对大数据和数据科学教育用途感兴趣的四个共同体(学习分析、教育数据挖掘、大规模学习和量化民族志)之间的关系和最主要的不同之处。

我们认为这四个共同体所开展的不同工作在很大程度上可以从四种哲学范式的角度进行解释。这四种范式追溯到古希腊哲学的起源,而本文采用理查德·麦基翁和理查德·布坎南提出的框架并做适当修改。虽然上述四个共同体各自举办的四种学术会议与这四种范式不存在严格的对应关系,但是这些范式与四个共同体各自的研究存在惊人的对应程度。

我们希望每一个人都更好地了解自己的哲学观对研究和实践的影响。通过了解自己,我们便能够更加深入地了解我们做出具体选择的原因并从遵循这种哲学传统的其他研究中寻找类似的东西。通过了解更大学术领域同行对他们的研究和实践所持的哲学观,我们便能够更好地了解他们做出具体选择的原因以及这些选择与(有时是不可言传的)深层哲学理念的关系,明白他们不是因为无知、懒惰或愚蠢才做出这些选择的。

或许更重要的是,通过了解我们同行的哲学观,我们可能能够更好地理解他们看问题的视角(我们原先做不到,因为不了解他们的哲学观),更好地向他们学习。我们因此更可能能够设计充分利用各自优势的研究课题,为本领域做出贡献,也能服务好我们的学生。本文阐述了不同共同体的合作可能带来的新关系和研究课题。当然,各方加强彼此联系和协作的机会并不限于本文所述,还有很多可能性是我们现在还想象不到的。一言以蔽之,我们这个领域希望解决的挑战不可能通过某一种方法或一套工具得以解决。我们必须共同面对,一起解决。

【利益冲突声明】笔者声明不存在可能影响本研究的已知经济利益冲突或个人问题。

[参考文献]

Amershi, S., & Conati, C. (2009). Combining unsupervised and supervised classification to build user models for exploratory learning environments. Journal of Educational Data Mining, 1(1), 18-71.

An, P., Bakker, S., Ordanovski, S., Taconis, R., Paffen, C. L., & Eggen, B. (2019). Unobtrusively enhancing reflection-in-action of teachers through spatially distributed ambient information. In Proceedings of the 2019 CHI conference on human factors in computing systems (paper no. 91). Association for Computing Machinery.

Anderson, J. R., Reder, L. M., & Simon, H. A. (1997). Situative versus cognitive perspectives: Form versus substance. Educational Researcher, 26(1), 18-21.

Atkisson, M., & Wiley, D. (2011). Learning analytics as interpretive practice: Applying westerman to educational intervention. In Proceedings of the 1st international conference on learning analytics and knowledge (pp. 117-121). Association for Computing Machinery.

Baker, R. S. (2012). Big data and education (1st ed.). Columbia University. Teachers College.

Baker, R. S. (2019). Challenges for the future of educational data mining: The Baker learning analytics prizes. Journal of Educational Data Mining, 11(1), 1-17.

Baker, R. S. J.d., Corbett, A. T., & Aleven, V. (2008). Improving contextual models of guessing and slipping with a truncated training set. In R. de Baker, T. Barnes, & J. Beck (Eds.), Proceedings of the 1st international conference on educational data mining (pp. 67-76). International Educational Data Mining Society.

Baker, R. S. J. d., & Yacef, K. (2009). The state of educational data mining in 2009: A review and future visions. Journal of Educational Data Mining, 1(1), 3-17.

Bakharia, A., & Dawson, S. (2011). SNAPP: A bird’s-eye view of temporal participant interaction. In Proceedings of the 1st international Conference on learning Analytics and knowledge (pp. 168- 173). Association for Computing Machinery.

Barany, A., & Foster, A. (2019). Examining identity exploration in a video game participatory culture. In B. Eagan, M. Misfeldt, & A. Siebert-Evenstone (Eds.), Advances in quantitative ethnography (pp. 3-13). Springer.

Barnes, T. (2005). The Q-matrix method: Mining student response data for knowledge. In J. E. Beck (Ed.), Proceedings of AAAI 2005 educational data mining workshop (pp. 39-46). Association for the Advancement of Artificial Intelligence.

Bauer, E., Sailer, M., Kiesewetter, J., Schulz, C., Pfeiffer, J., Gurevych, I., Fischer, M., & Fischer, F. (2019). Using ENA to analyze pre-service teachers’ diagnostic argumentations: A conceptual framework and initial applications. In B. Eagan, M. Misfeldt, & A. Siebert-Evenstone (Eds.), Advances in quantitative ethnography (pp. 14-25). Springer.

Berland, M., Baker, R. S., & Blikstein, P. (2014). Educational data mining and learning analytics: Applications to constructionist research. Technology, Knowledge and Learning, 19, 205-220.

Blikstein, P. (2011). Using learning analytics to assess students’ behavior in open-ended programming tasks. In Proceedings of the 1st international conference on learning analytics and knowledge (pp. 110-116). Association for Computing Machinery.

Bodily, R., Kay, J., Aleven, V., Jivet, I., Davis, D., Xhakaj, F., & Verbert, K. (2018, March). Open learner models and learning analytics dashboards: a systematic review. In Proceedings of the 8th international conference on learning analytics and knowledge (pp. 41-50).

Bodily, R., & Verbert, K. (2017). Review of research on student-facing learning analytics dashboards and educational recommender systems. IEEE Transactions on Learning Technologies, 10(4), 405-418.

Botelho, A. F., Baker, R., Ocumpaugh, J., & Heffernan, N. (2018). Studying affect dynamics and chronometry using sensor-free detectors. In K. E. Boyer, & M. Yudelson (Eds.), Proceedings of the 11th international conference on educational data mining (pp. 157-166). International Educational Data Mining Society.

Botelho, A. F., Varatharaj, A., Inwegen, E. G. V., & Heffernan, N. T. (2019). Refusing to try: Characterizing early stopout on student assignments. In Proceedings of the 9th international conference on learning analytics & knowledge (pp. 391-400). Association for Computing Machinery.

Bowers, A. J., Sprott, R., & Taff, S. A. (2012). Do we know who will drop out? A review of the predictors of dropping out of high school: Precision, sensitivity, and specificity. High School Journal, 96(2), 77-100.

Buckingham Shum, S., Ferguson, R., & Martinez-Maldonado, R. (2019). Human-centred learning analytics. Journal of Learning Analytics, 6(2), 1-9.

Buckingham Shum, S., & Luckin, R. (2019). Learning analytics and AI: Politics, pedagogy and practices. British Journal of Educational Technology, 50(6), 2785-2793.

Cai, Z., Siebert-Evenstone, A., Eagan, B., Shaffer, D. W., Hu, X., & Graesser, A. C. (2019). nCoder+: A semantic tool for improving recall of nCoder coding. In B. Eagan, M. Misfeldt, & A. Siebert-Evenstone (Eds.), Advances in quantitative ethnography (pp. 41-54). Springer.

Campbell, J. P., DeBlois, P. B., & Oblinger, D. (2007). Academic analytics: A new tool for a new era. Educause Review, 42(4), 40-57.

Chang, K. M., Beck, J. E., Mostow, J., & Corbett, A. (2006). Does help help? A Bayes net approach to modeling tutor interventions. In Proceedings of the 21st annual Meeting of the American Association for artificial intelligence (pp. 41-46). American Association for Artificial Intelligence.

Chatti, M. A., Dyckhoff, A. L., Schroeder, U., & Thüs, H. (2012). A reference model for learning analytics. International Journal of Technology Enhanced Learning, 4(5-6), 318-331.

Chaturapruek, S., Dee, T. S., Johari, R., Kizilcec, R. F., & Stevens, M. L. (2018). How a data-driven course planning tool affects college students’ GPA: Evidence from two field experiments. In Proceedings of the fifth annual ACM conference on learning at scale (p. 63). Association for Computing Machinery.

Chen, G., Rolim, V., Mello, R. F., & Gaševi , D. (2020). Let’s shine together! A comparative study between learning analytics and educational data mining. In Proceedings of the tenth international conference on learning analytics & knowledge (pp. 544-553). Association for Computing Machinery.

Chen, X., Zou, D., Cheng, G., & Xie, H. (2020). Detecting latent topics and trends in educational technologies over four decades using structural topic modeling: A retrospective of all volumes of computers & education. Computers & Education, 151, 103855.

Choi, H., Dowell, N., Brooks, C., & Teasley, S. (2019). Social comparison in MOOCs: Perceived SES, opinion, and message formality. In Proceedings of the 9th international conference on learning analytics & knowledge (pp. 160-169). Association for Computing Machinery.

Clow, D. (2012). The learning analytics cycle: Closing the loop effectively. In Proceedings of the 2nd international conference on learning analytics and knowledge (pp. 134-138). Association for Computing Machinery.

Coleman, S. R., & Salamon, R. (1988). Kuhn’s Structure of scientific revolutions in the psychological journal literature, 1969-1983: A descriptive study. The Journal of Mind and Behavior, 9(4), 415-446.

Colvin, C., Rogers, T., Wade, A., Dawson, S., Gaševi , D., Buckingham Shum, S., Nelson, K., Alexander, S., Lockyer, L., Kennedy, G., Corrin, L., & Fisher, J. (2015). Student retention and learning analytics: A snapshot of Australian practices and a framework for advancement. Office of Learning and Teaching, Australian Government. Retrieved from http://he-analytics.com/wp-content/uploads/SP13-3249_-Master17Aug2015-web.pdf

Corrin, L., & de Barba, P. (2014). Exploring students’ interpretation of feedback delivered through learning analytics dashboards. In Proceedings of the ASCILITE 2014 conference (pp. 629-633). Australasian Society for Computers in Learning in Tertiary Education.

Dawson, S., Gaševi , D., Siemens, G., & Joksimovic, S. (2014, March). Current state and future trends: A citation network analysis of the learning analytics field. In Proceedings of the fourth international conference on learning analytics and knowledge (pp. 231-240).

Dawson, S., Joksimovic, S., Poquet, O., & Siemens, G. (2019). Increasing the impact of learning analytics. In Proceedings of the 9th international conference on learning analytics & knowledge (pp. 446-455). Association for Computing Machinery.

Dawson, S., Poquet, O., Colvin, C., Rogers, T., Pardo, A., & Gaševi , D. (2018). Rethinking learning analytics adoption through complexity leadership theory. In Proceedings of the 8th international conference on learning analytics and knowledge (pp. 236-244). Association for Computing Machinery.

Essa, A. (2016). A possible future for next generation adaptive learning systems. Smart Learning Environments, 3(16), 1-24.

Ferguson, R. (2012). Learning analytics: Drivers, developments and challenges. International Journal of Technology Enhanced Learning, 4(5), 304-317.

Ferguson, R., & Shum, S. B. (2011). Learning analytics to identify exploratory dialogue within synchronous text chat. In Proceedings of the 1st international conference on learning analytics and knowledge (pp. 99-103). Association for Computing Machinery.

Ferreira, M., Rolim, V., Mello, R. F., Lins, R. D., Chen, G., & Gaševi , D. (2020). Towards automatic content analysis of social presence in transcripts of online discussions. In Proceedings of the tenth international conference on learning analytics & knowledge (pp. 141-150). Association for Computing Machinery.

Gaševi , D., Joksimovi , S., Eagan, B. R., & Shaffer, D. W. (2019). SENS: Network analytics to combine social and cognitive perspectives of collaborative learning. Computers in Human Behavior, 92, 562-577.

Gaševi , D., Kovanovi , V., & Joksimovi , S. (2017). Piecing the learning analytics puzzle: A consolidated model of a field of research and practice. Learning: Research and Practice, 3(1), 63-78.

Google Scholar. (2020). Educational technology [Citation count]. Retrieved from https://scholar.google.ca/citations?view_op=top_venues&hl=en& vq=soc_educationaltechnology

Greeno, J. G. (1997). On claims that answer the wrong questions. Educational Researcher, 26(1), 5-17.

Greller, W., & Drachsler, H. (2012). Translating learning into numbers: A genericframework for learning analytics. Journal of Educational Technology & Society, 15(3), 42-57.

Halevy, A., Norvig, P., & Pereira, F. (2009). The unreasonable effectiveness of data. IEEE Intelligent Systems, 24(2), 8-12.

Harpstead, E., Richey, J. E., Nguyen, H., & McLaren, B. M. (2019). Exploring the subtleties of agency and indirect control in digital learning games. In Proceedings of the 9th international conference on learning analytics & knowledge (pp. 121-129). Association for Computing Machinery.

Holstein, K., McLaren, B. M., & Aleven, V. (2019). Co-designing a real-time classroom orchestration tool to support teacher-AI complementarity. Journal of Learning Analytics, 6(2), 27-52.

Huang, J., Dasgupta, A., Ghosh, A., Manning, J., & Sanders, M. (2014). Superposter behavior in MOOC forums. In Proceedings of the first ACM conference on learning @scale conference (pp. 117-126). Association for Computing Machinery.

Jacobson, M. J., Kapur, M., & Reimann, P. (2016). Conceptualizing debates in learning and educational research: Toward a complex systems conceptual framework of learning. Educational Psychologist, 51(2), 210-218.

Jensen, D. (2000). Data snooping, dredging and fishing: The dark side of data mining a SIGKDD99 panel report. SIGKDD Explorations, 1(2), 52-54.

Jovanovi , J., Gaševi , D., Brooks, C., Devedzic, V., Hatala, M., Eap, T., & Richards, G. (2008). LOCO-Analyst: Semantic web technologies in learning content usage analysis. International Journal of Continuing Engineering Education and Life Long Learning, 18(1), 54-76.

Karumbaiah, S., Baker, R. S., Barany, A., & Shute, V. (2019). Using epistemic networks with automated codes to understand why players quit levels in a learning game. In B. Eagan, M. Misfeldt, & A. Siebert-Evenstone (Eds.), Advances in quantitative ethnography (pp. 106-116). Springer.

Khajah, M., Lindsey, R. V., & Mozer, M. C. (2016). How deep is knowledge tracing? In T. Barnes, M. Chi, & M. Feng (Eds.), Proceedings of the 9th international conference on educational data mining (pp. 94-101). International Educational Data Mining Society.

Kim, J., Guo, P. J., Seaton, D. T., Mitros, P., Gajos, K. Z., & Miller, R. C. (2014). Understanding in-video dropouts and interaction peaks in online lecture videos. In Proceedings of the first ACM

Kovanovic, V., Gaševi , D., Dawson, S., Joksimovic, S., Baker, R. S., & Hatala, M. (2016). Does time-on-task estimation matter? Implications on validity of learning analytics findings. Journal of Learning Analytics, 2(3), 81-110.

Kuhn, T. S. (1962). The structure of scientific revolutions (1st ed.). University of Chicago Press.

Lang, C., Siemens, G., Wise, A., & Gaševi , D. (2017). Handbook of learning analytics (1st ed.). Society for Learning Analytics and Research. https://doi.org/10.18608/hla17.

LeCun, Y., Bengio, Y., & Hinton, G. (2015). Deep learning. Nature, 521(7553), 436-444.

Li, H., Gobert, J., Dickler, R., & Moussavi, R. (2018). The impact of multiple real-time scaffolding experiences on science inquiry practices. In R. Nkambou, R. Azevedo, & J. Vassileva (Eds.), Intelligent tutoring systems: 14th international conference proceedings (pp. 99-109). Springer.

Lingard, B., & Lewis, S. (2016). Globalisation of the Anglo-American approach to topdown, test-based educational accountability. In G. T. L. Brown, & L. R. Harris (Eds.), Handbook of human and social conditions in assessment (1st ed.) (pp. 387-403). Routledge.

Long, P. D., Siemens, G., Conole, G., & Gaševi , D. (Eds.). (2011). LAK’11: Proceedings of the 1st international conference on learning analytics and knowledge. Association for Computing Machinery.

Lonn, S., Aguilar, S. J., & Teasley, S. D. (2015). Investigating student motivation in the context of a learning analytics intervention during a summer bridge program. Computers in Human Behavior, 47, 90-97.

Lynch, C. F. (2017). Who prophets from big data in education? New insights and new challenges. Theory and Research in Education, 15(3), 249-271.

Macfadyen, L. P., Dawson, S., Pardo, A., & Gaševi , D. (2014). Embracing big data in complex educational systems: The learning analytics imperative and the policy challenge. Research & Practice in Assessment, 9(Winter), 17-28.

Martin, T., Petrick Smith, C., Forsgren, N., Aghababyan, A., Janisiewicz, P., & Baker, S. (2015). Learning fractions by splitting: Using learning analytics to illuminate the development of mathematical understanding. The Journal of the Learning Sciences, 24 (4), 593-637.

Matcha, W., Ahmad Uzir, N., Gaševi , D., & Pardo, A. (2020). A systematic review of empirical studies on learning analytics dashboards: A self-regulated learning perspective. IEEE Transactions on Learning Technologies, 13(2), 226-245.

McKeon, R. (1966). Philosophic semantics and philosophic inquiry. In Z. K. Mckeon (Ed.), Freedom and history and other essays: An introduction to the thought of Richard McKeon (pp. 242-256). The University of Chicago Press.

Melzner, N., Greisel, M., Dresel, M., & Kollar, I. (2019). Using process mining (PM) and epistemic network analysis (ENA) for comparing processes of collaborative problem regulation. In B. Eagan, M. Misfeldt, & A. Siebert-Evenstone (Eds.), Advances in quantitative ethnography (pp. 154-164). Springer.

Paquette, L., & Baker, R. S. (2019). Comparing machine learning to knowledge engineering for student behavior modeling: A case study in gaming the system. Interactive Learning Environments, 27(5-6), 585-597.

Paquette, L., de Carvalho, A. M. J. A., & Baker, R. S. (2014). Towards understanding expert coding of student disengagement in online learning. In Proceedings of the 36th annual cognitive science conference (pp. 1126-1131). Cognitive Science Society.

Pardos, Z., Heffernan, N., Ruiz, C., & Beck, J. (2008). The composition effect: Conjuntive or compensatory? An analysis of multi-skill math questions in ITS. In R. S. J. d. Baker, T. Barnes, & J. E. Beck (Eds.), Proceedings of the 1st international conference on educational data mining (pp. 147-156). International Educational Data Mining Society.

Pavlik, P. I., Jr., Cen, H., & Koedinger, K. R. (2009). Learning factors transfer analysis: Using learning curve analysis to automatically generate domain models. In T. Barnes, M. Desmararis, C. Romero, & S. Ventura (Eds.), Proceedings of the 2nd international conference on educational data mining (pp. 121-130). International Educational Data Mining Society.

Pavlik, P., & Toth, J. (2010). How to build bridges between intelligent tutoring system subfields of research. In V. Aleven, J. Kay, & J. Mostow (Eds.), Intelligent tutoring systems: 10th international conference, proceedings Part II (pp. 103-112). Springer.

Pelánek, R. (2020). Learning analytics challenges: Trade-offs, methodology, scalability. In Proceedings of the tenth international conference on learning analytics & knowledge (pp. 554-558). Association for Computing Machinery.

Pontual Falcão, T., Ferreira Mello, R., Rodrigues, R. L., Diniz, J. R. B., Tsai, Y. S., & Gaševi , D. (2020). Perceptions and expectations about learning analytics from a Brazilian higher education institution. In Proceedings of the tenth international conference on learning analytics & knowledge (pp. 240-249).

Rich, M. H. (2018). McKeon's semantics of communication: A pragmatic exploration of the communicative arts. Empedocles: European Journal for the Philosophy of Communication, 9(1), 5-24.

Rienties, B., Herodotou, C., Olney, T., Schencks, M., & Boroowa, A. (2018). Making sense of learning analytics dashboards: A technology acceptance perspective of 95 teachers. International Review of Research in Open and Distance Learning, 19(5), 186-202.

Ritter, S., Yudelson, M., Fancsali, S. E., & Berman, S. R. (2016). How mastery learning works at scale. In Proceedings of the third ACM conference on learning @ scale (pp. 71-79). Association for Computing Machinery.

Sachse, C. (2013). Reductionism in the philosophy of science (Vol. 11). Walter de Gruyter.

Saint, J., Gaševi , D., Matcha, W., Uzir, N. A. A., & Pardo, A. (2020). Combining analytic methods to unlock sequential and temporal patterns of self-regulated learning. In Proceedings of the tenth international conference on learning analytics & knowledge (pp. 402-411).

Sales, A., Botelho, A. F., Patikorn, T., & Heffernan, N. T. (2018). Using big data to sharpen design-based inference in A/B tests. In K. E. Boyer, & M. Yudelson (Eds.), Proceedings of the 11th international conference on educational data mining (pp. 479-485). International Educational Data Mining Society.

Sclater, N., & Bailey, P. (2015). Code of practice for learning analytics. Jisc. Retrieved from https://www.jisc.ac.uk/guides/code-of-practice- for-learning-analytics

Settles, B., & Meeder, B. (2016). A trainable spaced repetition model for language learning. In K. Erk, & N. A. Smith (Eds.), Proceedings of the 54th annual meeting of the association for computational linguistics (Vol. 1, pp. 1848-1858). Long papers.

Shaffer, D., & Ruis, A. (2017). Epistemic network analysis: A worked example of theory-based learning analytics. In C. Lang, G. Siemens, A. Wise, & D. Gaševi (Eds.), Handbook of learning analytics (pp. 175-187). SoLAR.

Sherin, B., Kersting, N., & Berland, M. (2018). Learning analytics in support of qualitative analysis. In J. Kay, & R. Luckin (Eds.), Proceedings of the 13th international conference of the learning sciences (pp. 464-471). International Society of the Learning Sciences.

Siemens, G., & Baker, R. S. D. (2012). Learning analytics and educational data mining: towards communication and collaboration. In Proceedings of the 2nd international conference on learning analytics and knowledge (pp. 252-254).

Siemens, G. (2013). Learning analytics: the emergence of a discipline. American Behavioral Scientist, 57(10), 1380-1400.

Siemens, G. (2014). The journal of learning analytics: Supporting and promoting learning analytics research. Journal of Learning Analytics, 1(1), 3-5.

Singh, R. P. (2018). Learning analytics: Potential, protection, and privacy in the educational system. In M. K. Singh, Z. Zerihun, & N. Singh (Eds.), Impact of learning analytics on curriculum design and student performance (pp. 1-18). IGI Global.

Steiner, C., Kickmeier-Rust, M., & Türker, M. A. (2014). Deliverable D3.1 review article about LA and EDM approaches. European Commission LEA’s Box Project. Retrieved from http://css-kmi.tugraz.at/mkrwww/leas-box/downloads/D3.1.pdf

Strohecker, C. (1991). Elucidating styles of thinking about topology through thinking about knots. In I. Harel, & S. Papert (Eds.), Constructionism (pp. 215-234). Ablex.

Suthers, D., & Rosen, D. (2011). A unified framework for multi-level analysis of distributed learning. In Proceedings of the 1st international conference on learning analytics and knowledge (pp. 64-74). Association for Computing Machinery.

Swiecki, Z., & Shaffer, D. W. (2020). iSENS: an integrated approach to combining epistemic and social network analyses. In Proceedings of the tenth international conference on learning analytics & knowledge (pp. 305-313). Association for Computing Machinery.

Tsai, V., & Gasevic, D. (2017, March). Learning analytics in higher education—challenges and policies: a review of eight learning analytics policies. In Proceedings of the seventh international learning analytics & knowledge conference (pp. 233-242).

Tsai, Y.-S., Gaševi , D., Whitelock-Wainwright, A., Muñoz-Merino, P. J., Moreno-Marcos, P. M., Rubio Fernández, A., Delgado Kloos, C., Scheffel, M., Jivet, I., Drachsler, H., Tammets, K., Ruiz Calleja, A., & Kollom, K. (2018). Sheila: Supporting higher education to integrate learning analytics. The University of Edinburgh.

Tsai, Y.-S., Poquet, O., Gaševi , D., Dawson, S., & Pardo, A. (2019). Complexity leadership in learning analytics: Drivers, challenges and opportunities. British Journal of Educational Technology, 50(6), 2839- 2854.

Uzir, N. A. A., Gaševi , D., Jovanovi , J., Matcha, W., Lim, L. A., & Fudge, A. (2020). Analytics of time management and learning strategies for effective online learning in blended environments. In Proceedings of the tenth international conference on learning analytics & knowledge (pp. 392-401). Association for Computing Machinery.

Viberg, O., Hatakka, M., B¨alter, O., & Mavroudi, A. (2018). The current landscape of learning analytics in higher education. Computers in Human Behavior, 89, 98-110.

Watson, W. (1994). McKeon’s semantic schema. Philosophy and Rhetoric, 27(2), 85-103.

Weller, M. (2020). 25 years of ed tech. Athabasca University Press.

Whitelock-Wainwright, A., Tsai, Y. S., Lyons, K., Kaliff, S., Bryant, M., Ryan, K., & Gaševi , D. (2020). Disciplinary differences in blended learning design: A network analytic study. In Proceedings of the tenth international conference on learning analytics & knowledge (pp. 579- 588).

Wise, A., & Jung, Y. (2019). Teaching with analytics: Towards a situated model of instructional decision-making. Journal of Learning Analytics, 6(2), 53-69

Worsley, M., & Blikstein, P. (2015). Leveraging multimodal learning analytics to differentiate student learning strategies. In Proceedings of the fifth international conference on learning analytics and knowledge (pp. 360-367). Association for Computing Machinery.

Yang, S., Domeniconi, C., Revelle, M., Sweeney, M., Gelman, B. U., Beckley, C., & Johri, A. (2015). Uncovering trajectories of informal learning in large online communities of creators. In Proceedings of the second ACM conference on learning @scale (pp. 131-140). Association for Computing Machinery.

Yeung, C. K., & Yeung, D. Y. (2018). Addressing two problems in deep knowledge tracing via prediction-consistent regularization. In Proceedings of the fifth annual ACM conference on learning at scale (pp. 1-10). Association for Computing Machinery.

Zhang, Y., Shah, R., & Chi, M. (2016). Deep learning+ student modeling+ clustering: A recipe for effective automatic short answer grading. In T. Barnes, M. Chi, & M. Feng (Eds.), Proceedings of the 9th international conference on educational data mining (pp. 562-567). International Educational Data Mining Society.

收稿日期:2021-06-23

定稿日期:2021-06-23

作者簡介:赖安·S.贝克(Ryan S. Baker)博士,美国宾夕法尼亚大学(University of Pennsylvania)副教授,学习分析中心主任;国际教育数据挖掘学会(International Educational Data Mining Society)创会主席,《基于计算机的情景学习》(Computer-Based Learning in Context)期刊主编,《教育数据挖掘期刊》(Journal of Educational Data Mining)副主编,慕课复制框架(MOOC Replication Framework, MORF)联执总监;曾担任匹兹堡学习科学中心(Pittsburgh Science of Learning Center)DataShop技术总监。

德拉甘·伽瑟维克(Dragan Gaševi )博士,澳大利亚莫纳什大学(Monash University)信息技术学部学习分析教授和学习分析中心总监;学习分析研究学会(SoLAR)创会主席。在亚洲、澳大利亚、欧洲和北美等多国获得各种荣誉称号,包括学习技术协会(Association for Learning Technology)最佳年度研究课题奖(2019)。

沙姆亚·卡伦拜亚(Shamya Karumbaiah),美国宾夕法尼亚大学学习分析中心博士生(学位论文撰写阶段)。

译者简介:肖俊洪,汕头开放大学教授,Distance Education (《远程教育》)(Taylor & Francis) 期刊副主编,SpringerBriefs in Open and Distance Education(《远程开放教育SpringerBriefs系列丛书》)联执主编。<C:\Users\DELL\Desktop\202112翁4改\Image\yxccfl2.tif>https://orcid.org/0000-0002-5316-2957

责任编辑 韩世梅