降低OFDM立方度量的最优限幅滤波算法及神经网络实现*

袁 田,朱红亮,周 娟,朱晓东

(1.中国电子科技集团公司第十研究所,四川 成都 610036;2.电子科技大学信息与通信工程学院,四川 成都 611731;3.成都信息工程大学通信工程学院,四川 成都 610225)

1 引言

正交频分复用OFDM(Orthogonal Frequency Division Multiplexing)作为一种多载波调制技术,以其高频谱效率和对多径效应的鲁棒性而备受关注,并在4G等现代通信系统中得到了广泛应用。然而,OFDM的一个主要缺点是信号包络波动较大[1]。峰均功率比PAPR(Peak to Average Power Ratio)和立方度量CM(Cubic Metric)是衡量OFDM信号包络波动的2个指标。虽然PAPR更为常用,但是近期的研究表明,它其实并不能准确反映功率放大器对OFDM信号的非线性影响,因为PAPR只考虑了OFDM信号的峰值功率。相比之下,利用CM描述多载波信号的波动大小以及功率放大器对信号的影响更加准确[2,3]。CM考虑了功率放大器的三阶非线性互调干扰对信号的影响,而三阶互调干扰是引起信号失真的主要因素,因此,第3代合作伙伴计划3GPP(Third Generation Partnership Project)规范认为利用CM来确定功率放大器在多载波信号输入情况下的回退量更加合适[4]。

降低信号波动通常是通过减小PAPR或CM来实现的。为降低多载波信号的PAPR,科研人员已提出不少技术,文献[1]对这些技术进行了综合性分析。一般来说,这些技术主要可以分为2类:对信号有失真的技术和无失真的技术。有失真技术主要包括限幅滤波[5]和压扩技术[6,7]等。无失真技术的典型应用包括部分传输序列(Partial Transmit Sequence)[8,9]算法和选择传输SLM(SeLected Mapping)[10,11]算法。而在另外一方面,对于降低CM技术的研究目前还处于起步阶段。在文献[12]中,作者提出了一种称为下降限幅的方案。该方案考虑了PAPR和CM在定义上的差异,因此在降低CM时表现出了比传统限幅更高的效率。在文献[13]中,作者引入了凸优化技术,可以在CM抑制和信号失真之间达到很好的折衷。

在PAPR和CM的各种抑制技术中,限幅滤波是最简单的方法。在该方法中,限幅操作能够明显降低信号波动,但它是一种非线性的操作,给信号引入了畸变,造成接收端误比特率的上升,降低了系统的可靠性[5]。此外,限幅还导致了信号频谱的扩展,因此需要借助滤波来消除频谱扩展。在传统的限幅滤波方案中,滤波操作采用了简单的滤波器来实现,该滤波器仅仅将信号带外频谱滤除,而带内部分保持不变。这种滤波器虽然易于实现,但存在峰值再生的情况,而且该滤波器也没有考虑带内信号失真的影响。本文研究降低OFDM信号CM时的限幅滤波方案,主要贡献包括:

(1)提出了基于最优滤波器设计的降低CM的限幅滤波算法。与传统滤波不同,本文提出的滤波设计充分考虑了滤波对CM、带内失真、带外频谱的影响,并将这些影响建模为一个优化问题,优化变量是滤波器取值,优化目标是在满足给定CM指标和带外频谱要求下使得信号失真达到最小。基于这种滤波设计的限幅滤波算法,我们称为最优限幅滤波算法。由于所建立的滤波优化问题是非凸的,因此很难得到全局最优解。但分析表明,通过使用简单的转换,可以将原始的优化问题近似转换为凸问题,然后通过内点法IPM(Interior Point Method)[14]或利用现有的软件(如CVX)[15]来求解。

(2)提出了基于深度学习技术的最优限幅滤波实现方案。根据神经网络能够模拟函数输入输出关系的特性,构造出深度神经网络,并利用最优限幅滤波算法对其进行训练。训练之后得到的神经网络具有与最优限幅滤波算法相近的性能,而算法复杂度和算法执行时间却得到了大幅降低,有希望满足实际通信系统对实时性的要求。

仿真结果表明,本文提出的最优限幅滤波算法及其神经网络实现方案与其它常用的方案相比,具有更好的CM抑制性能。

2 研究背景

在本节中,首先回顾度量OFDM信号包络波动的2个指标,即PAPR和CM,然后介绍传统的限幅滤波方案。

2.1 信号包络波动的度量

(1)

其中,L为过采样因子。

PAPR和CM是用来描述多载波信号包络波动的2个指标。PAPR被定义为一帧OFDM信号功率峰值与平均功率之比,即:

(2)

从式(2)可以看出,PAPR实际上只考虑信号的峰值功率,因此当它被用于确定功率放大器输出信号的畸变时,经常会出现偏差。具体来说,当一个具有较大PAPR的信号通过功率放大器时,其输出信号其实并不一定表现出更严重的失真[2]。

后来,科研人员从功率放大器输入输出关系的角度进一步研究了信号波动度量的问题。功率放大器的输入信号和输出信号的关系可以近似表示为[1]:

y(n)≈G1·x(n)+G3·[x(n)]3

(3)

其中,G1和G3分别是放大器的线性增益和非线性增益,其取值大小取决于放大器的设计,与信号无关。当输入信号x(n)是多载波信号时,[x(n)]3会产生多种频率的组合,有的组合频率会接近有用信号的频率,从而对有用信号造成干扰,称为三阶非线性互调干扰,而信号失真主要是由功率放大器的三阶非线性互调干扰引起的[2,3]。三阶互调干扰会引起有用信号误码率性能的下降,也会落入相邻信道的频带,引起大的相邻信道泄漏比ACLR(Adjacent Channel Leakage Ratio)。

信号的立方项[x(n)]3直接影响了系统性能,基于这一结果,科研人员提出了一种被称为CM的指标来度量信号波动的大小,其定义表达式为[2]:

(4)

其中,rms[x(n)]为当n∈[0,LN-1]时信号x(n)的均方根值,分子的第1项代表对x(n)进行归一化后所得信号的立方项,称为RCM(Raw Cubic Metric),而RCMref代表的是参考信号立方项的值,分母Q是一个经验因子。对于特定系统来说,RCMref和Q都是常数,所以在比较信号的包络波动大小时,可以只考虑信号RCM的大小。为了简单起见,本文将CM和RCM等同看待。实际上,经过简单的转换后,RCM可以等价地表示为:

(5)

信号波动的大小常用来确定信号输入功率放大器时所需的功率回退量,使得信号动态范围不会超出放大器的线性区域。PAPR和CM都可以用来描述信号幅度波动的大小,因此两者都可以用于确定功率回退的多少,但研究表明,在确定功率回退时,CM的准确性要优于PAPR,因此CM被3GPP认为是更好的度量信号波动的指标[3,4]。

2.2 传统的限幅滤波算法

限幅滤波算法是一种简单有效的减少OFDM信号包络波动的方法。在该算法中,包络波动较大的OFDM信号首先被限幅到一个预先设定的阈值之内,这个过程可以表示为:

(6)

其中,λ>0表示预先设定的阈值,θ(n)表示信号x(n)的相位,即x(n)=|x(n)|ejθ(n)。

虽然限幅操作减少了包络的波动,但它直接导致了信号的频谱扩展,也就是说,限幅后的信号在k∈[N,LN-1]时的频谱不再为零。频谱扩展可能会干扰其他用户的通信,所以在限幅之后需要进行滤波操作。在传统的限幅滤波算法中,滤波器的设计非常简单:只去除带外频率分量,同时保持带内分量不变,即滤波器可表示为:

(7)

从式(7)可以看出,传统算法中的滤波器实现起来非常方便,但是它存在如下2个缺点:

首先,传统滤波器会导致峰值再生。具体来说,限幅操作使得信号的峰值不会超过阈值λ,但限幅后的信号在经过滤波之后,信号峰值会重新超过λ[16],即滤波后信号比限幅后信号的包络波动更大,这种现象被称为峰值再生。峰值再生意味着传统算法中的滤波使得信号的PAPR和CM出现恶化。

其次,限幅使得信号的带内分量产生了失真,而传统算法中的滤波器仅仅维持信号带内分量不变,所以传统滤波并不能有效抑制限幅操作带来的信号失真。

3 降低CM的最优限幅滤波算法

本节主要介绍基于最优滤波器设计的降低CM的限幅滤波算法。

3.1 降低CM的最优滤波器设计

限幅操作可以有效减小包络波动,从而达到降低CM的目标,然而付出的代价是信号失真和频谱扩展。为了避免这些缺点,本文提出了一种最优滤波器的设计方法,其基本特性满足:(1)完全去除带外分量;(2)滤波后信号的CM值不能超过给定的阈值;(3)带内失真应尽可能小。换言之,所提出的滤波器的最优性体现在带外频谱、CM满足要求的条件下滤波器能够实现带内失真的最小化。

本文使用误差向量幅度EVM(Error Vector Magnitude)来衡量带内失真的程度,其表达式为[13]:

(8)

(9)

(10)

则问题(9)可改写为如下的优化问题:

(11)

优化问题(11)是一个凸优化问题,可以通过使用内点法或通用的优化软件(如CVX)来有效求解。在限幅滤波算法的每次迭代中,都可以依据优化问题(11)解出相应的最优滤波器,并用它来处理限幅后的信号,从而得到一个性能最优的信号。

3.2 最优限幅滤波算法

最优限幅滤波算法和传统限幅滤波算法的主要区别在于滤波器的设计,传统限幅滤波算法使用的滤波器只是简单地处理带外泄露的频谱部分,并没有考虑滤波之后,峰值再生以及带内信号失真等问题。而最优限幅滤波算法对滤波器重新进行了设计,使得限幅滤波后的信号没有带外频谱扩展、不会产生峰值再生,同时带内失真实现了最小化,因而具有更优的性能。本文提出的最优限幅滤波算法的详细过程如算法1所示。

算法1OFDM系统中利用最优滤波器降低CM的算法

步骤1给定RCM阈值和最大迭代次数M。

4 基于深度学习的最优限幅滤波算法

从上一节可以看出,最优限幅滤波算法在每一次迭代都需要求解优化问题(11),无论是采用内点法还是采用CVX求解,都具有较高的计算复杂度,算法执行需要耗费大量时间,难以满足实际通信系统对于实时性的要求。近年来,人工智能技术在通信中的应用受到了越来越多的关注[17,18]。众所周知,神经网络可以用作各种非线性函数关系的模拟器,并且具有很高的计算效率[19],这提示我们可以利用神经网络来对最优限幅滤波算法进行学习,以提升算法的效率。本节提出基于深度学习的最优限幅滤波方案,介绍利用最优限幅滤波算法对深度神经网络进行训练和测试的过程。

4.1 深度神经网络

(1)基本架构。

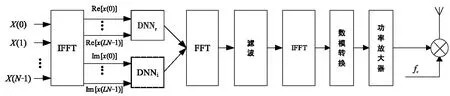

图1显示的是基于深度神经网络降低OFDM信号CM的系统框图。一帧OFDM信号X首先进行LN点的IFFT变换得到相应的时域信号。然后,将时域信号的实部(用Re[]表示)和虚部(用Im[]表示)分离成2个数据集合,分别输入到2个神经网络DNNr和DNNi中进行处理,处理的目标是使得DNNr和DNNi的输出能够非常逼近利用优化问题(11)求解得到的OFDM信号的实部和虚部。由于神经网络输出的信号可能存在带外频谱扩展,因此要利用FFT将其(即实部与虚部相加得到的信号)变换到频域,将带外频谱滤除,滤波之后的信号再通过IFFT变换、数模转换、功率放大发射出去。

Figure 1 System diagram of reducing OFDM signal CM based on deep neural network图1 基于深度神经网络降低OFDM信号CM的系统框图

本文采用的是全连接神经网络模型。DNNr和DNNi的输入层和输出层均包含LN个神经元,输入分别是OFDM信号的实部数据和虚部数据,输出层也都包含LN个神经元,输出是处理后的LN点OFDM信号的实部数据和虚部数据。输入层和输出层之间是多个隐含层。在本文的模型设计中,隐含层和输出层均采用了双曲正切函数(tanh)作为激活函数,该函数使得标准化输出得到的远大于或远小于0的数值变成和信号输入同样量级的值。tanh函数表示为:

(12)

基于深度学习的CM抑制方案通过训练不断调整神经网络模型中的权重参数和偏置参数,使得模型的输入、输出关系能够模拟优化问题(11)确定的OFDM信号在最优限幅滤波前后的关系。

(2)样本产生。

(3)训练过程。

令DNNr输入为{Re[x(n)],n=0,1,…,LN-1}时对应的输出为{Re[x*(n)],n=0,1,…,LN-1},令DNNi输入为{Im[x(n)],n=0,1,…,LN-1}时对应的输出为{lm[x*(n)],n=0,1,…,LN-1}。本文的目标是让神经网络能够模拟最优限幅滤波算法输入输出之间的关系。为了达到这个目标,采用误差函数来作为损失函数,即DNNr和DNNi的损失函数分别由以下2式给出:

(13)

(14)

若要让神经网络尽可能地近似最优滤波算法的处理效果,需要将损失函数最小化,采取的方式是利用TensorFlow中的Adadelta优化函数不断训练来优化神经网络参数,从而降低损失函数的值。

(4)测试阶段。

神经网络模型的训练过程可以在线下进行,训练完成后可得到深度学习神经网络模型的全部参数。然后,就可以利用学习得到的神经网络对新输入的信号进行在线处理,即进行测试。

4.2 实现方案

本文提出的利用深度神经网络学习最优限幅滤波来降低OFDM系统CM的主要步骤归纳如下:

(1)构造模型:设定深度神经网络的层数、每层神经元的数目,建立深度神经网络模型。

(2)产生样本:通过最优限幅滤波算法得到大量的训练样本。

(3)训练:利用样本以及TensorFlow中的优化函数对深度神经网络模型进行训练。

(4)测试:根据训练得到的模型,对新输入的OFDM信号进行CM抑制。

5 性能分析

5.1 复杂度分析

最优限幅滤波算法需要求解优化问题(11),该问题是一个凸优化问题,可以由标准的内点法解决。使用内点法解决凸优化问题的时候,其复杂度在最坏的情况下是O(N3)[20]。本文提出的最优限幅滤波算法在第1次迭代中计算复杂度为O(N3+2LNlog2(LN)),在余下的迭代中,因为OFDM时域信号可以直接由式(11)的最后1项计算出来,所以复杂度可以减小到O(N3+LNlog2(LN))。当总共迭代次数为M时,本文提出的最优限幅滤波的算法复杂度最终为O(MN3+(M+1)LNlog2(LN)),而且在每次迭代求解时都要进行LN点的傅里叶变换以及矩阵梯度的计算,因此具有较高的计算复杂度。

基于深度学习的最优限幅滤波算法在神经网络训练完成后,对新输入的OFDM信号进行处理仅涉及矩阵乘法、加法运算以及激活函数计算。神经网络的输入层、输出层有LN个神经元,此外还有3个隐含层,假设每层具有的神经元数目分别为Q1、Q2和Q3,那么神经网络的计算过程包括了4次矩阵乘法和加法计算。进行乘法计算的矩阵维度分别是Q1×LN,LN×1,Q2×Q1,Q3×Q2和LN×Q3,而加法计算仅涉及矢量相加。因此,与基于凸优化的最优限幅滤波算法相比,基于深度学习的方案具有低得多的计算复杂度。

5.2 仿真结果分析

5.2.1 仿真参数

仿真采用的软件为Python 3.6.5以及TensorFlow 1.8.0。仿真考虑的是一个包含N=128子载波的OFDM系统,假定信号采用的是QPSK(Quadrature Phase Shift Keying)调制,过采样因子选择为L=4,限幅操作中的限幅率设置为γ=2.5 dB。DDNr和DDNi神经网络模型均采用了3个隐含层,其中第1层采用了512个神经元,第2层采用了4 096个神经元,第3层采用了512个神经元。隐含层和输出层的激活函数为tanh函数,训练使用的损失函数分别由式(13)和式(14)给出,优化器为Adadelta,参数Batchsize大小设置为10,epoch次数为20。训练样本根据随机产生的104帧OFDM信号生成。

5.2.2 仿真结果

本节提供仿真结果来评估所提出的2种CM抑制方案的性能,这2种方案分别是基于优化问题求解的最优限幅滤波算法和基于深度神经网络的实现方案,其中最优限幅滤波算法中的优化问题采用CVX软件进行求解。为了能对所提方案的性能做出全面的评估,还提供了2种已有的限幅滤波类方案的仿真结果作为对比,这2种方案分别是文献[5]的迭代限幅滤波ICF(Iterative Clipping and Filtering)方案和文献[21]的简化最优迭代限幅滤波SOICF(Simplified Optimized Iterative Clipping and Filtering)方案。

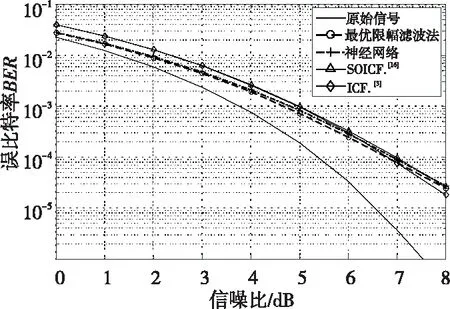

众所周知,限幅滤波算法可以有效减少OFDM信号的包络波动,但代价是误比特率会增加,所以将从这2个方面来评估算法的性能。图2给出了本文提出的最优限幅滤波算法及其基于神经网络的实现方案的误比特率BER(Bit Error Rate)对比,可以看出两者的误比特率BER性能非常接近。同时,图2也给出了文献[5,21]所提方案的仿真结果,在仿真时,对2种方案的限幅率进行调整,使得它们的BER性能与本文所提的最优限幅滤波算法及其神经网络实现方案的性能相近,由此可以对这4种方案的CM抑制性能进行公平的比较。

Figure 2 Bit error rate performance of different schemes图2 各方案的误比特率性能

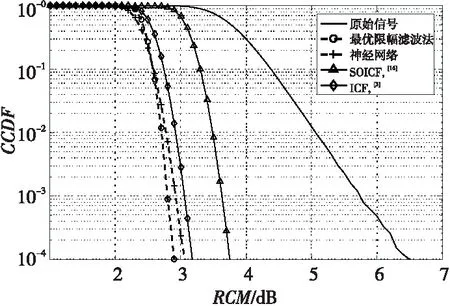

图3显示的是在BER性能相近的情况下各种方案降低OFDM信号CM的能力。图3中使用了互补累积分布函数CCDF(Complementary Cumulative Distribution Function)来描述RCM降低的性能,CCDF表示的是RCM超过某个阈值的概率。如图3所示,最优限幅滤波算法具有最好的CM抑制性能,在CCDF=10-4时,与原始信号相比,RCM的大小减少了3.6 dB,基于神经网络的方案性能与之相比约有0.2 dB的降级。而文献[5]和文献[21]的方案性能要劣于本文提出的2种方案,其原因在于这2种方案在进行滤波时并未采用最优的滤波器设计。

Figure 3 Performance comparison of CM reduction schemes图3 各方案降低CM性能比较

从图2和图3可以看出,最优限幅滤波算法与其基于深度学习的实现方案具有相近的性能。但是,最优限幅滤波算法涉及优化问题的求解,具有较高的计算复杂度。而基于深度学习的实现方案可以在线下对神经网络进行学习训练,训练之后的网络仅涉及简单的代数运算,计算复杂度大大降低。

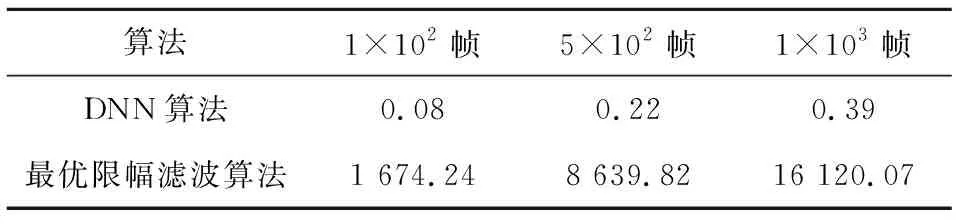

表1比较了最优限幅滤波算法及其神经网络实现方案在上述仿真条件下处理不同数量OFDM信号的时间。用于仿真的计算机CPU为AMD RYZEN7 1700,内存为16 GB 2 400 MHz。可以看出,神经网络方案的处理时间明显小于最优限幅滤波算法的执行时间,神经网络方案更有希望适用于实际通信系统。

Table 1 Execution time comparison of two proposed algorithms in case of different number of signal frames表1 2种算法处理不同帧数量信号的执行时间对比 s

6 结束语

为了降低OFDM信号包络的波动程度,本文提出了利用限幅滤波技术降低CM的方案。通过设计最优的滤波器,本文首先提出了一种最优限幅滤波算法,随后又提出了利用神经网络模拟该算法的基于深度学习的实现方案。仿真结果表明,最优限幅滤波算法及其神经网络实现方案性能接近,但后者的计算复杂度及其执行时间远远低于前者。与其它已有的限幅滤波方案相比,本文提出的算法及其神经网络的实现方案都具有明显的性能优势。