改进的CBOW情感信息获取研究

曹军博,叶 霞,许飞翔,尹列东

火箭军工程大学 作战保障学院,西安710025

1 引言

随着4G 时代的到来,人们逐渐习惯于使用移动网络在互联网上购物,这有力促进了淘宝、京东、大众点评等电子商务网站的发展。这些网站特别关注用户的购物倾向,为获取不同用户的需求,他们开发了对商品需求的网络评价系统,并且提供全面的在线评论功能。商家可以从这些评论信息中获取传统交易中不易获取的消费者对于所购商品的反馈信息,根据消费者的需求改进商品,以提高市场占有率;同时后续消费者也可以根据这些评论信息,做出购买决策。因此,如何从海量数据中自动获取用户情感倾向的情感分析技术成为当下研究的热点问题。

情感分析属于自然语言处理领域的一个重要分支。采用情感分析技术,在商品评论应用中,可以识别用户对商品评论文本的情感信息,帮助商家精准了解市场需求,帮助消费者快速做出购买决策;在舆情监控中,政府可以及时了解民众对突发事件、社会现象的态度,为引导舆论提供决策支持;在问答系统(QA)[1]中,用户在回答中表达自己对问题的看法见解时,可使答案与问题更相关,回答更容易被采纳;在自动翻译系统中[2],对输入文本进行情感倾向判断,有助于提高对带有正面或负面同义词的翻译准确率。因此,情感分析研究吸引着越来越多的科研工作者投身于该领域。

2 相关研究

Pang 和Turney 等[3-4]对电影评论进行情感倾向性研究,取得了较好的分类效果,由此引起大家对评论文本情感倾向分析的关注。Pang 等[5]根据传统自然语言处理中的文本分类技术,使用朴素贝叶斯、支持向量机(SVM)和最大熵等模型进行情感倾向性研究,其中,SVM 模型在电影评论中研究效果明显。罗毅等[6]构建两级情感词典,对情感词进行情感增强,并且采用N-Gram 方法,获取微博文本的情感信息,实验结果与传统方法相比,准确率和召回率都有一定的提高。百度深度学习研究院的徐伟[7]提出用神经网络构建二元语言模型,可以从上下文中提取更多的词语来获取文本的信息,实验结果表明,利用神经网络学习的语言模型,比传统的统计方法性能更好,这为后续语言模型的发展提供了不错的思路。之后,Bengio 等[8]提出一个三层神经网络来构建语言模型,将词向量映射到固定维数的空间,通过计算词与词之间的距离或余弦值来度量其相似性,实验表明能够有效改进N-gram 模型,且在获取较长的上下文语义中也有一定的优势。Mnih 等[9]提出层析Log-Bilinear 模型,使用一种快速的分层语言模型和一种简单的基于特征的算法,从数据中自动构造单词树,此模型在实验中比非层次神经网络模型效果较好。Mikolov等[10]借鉴Log-Bilinear模型的思想,提出word2vec模型,并实现了CBOW(Continuous Bag-of-Word model)和Skip-gram(Continuous Skip-gram model)两种框架,由此词向量被广泛应用到自然语言处理等多个领域。梁军等[11]运用深度学习思想,采用无监督方法,根据句子中词语前后的关联性引入情感极性转移模型,可达到与传统有监督方法同样的效果,并且能够节省大量人工标注的时间。张巍[12]采用基于CBOW 半监督方法将情感信息语义与情感信息融合,在新的评论数据集上进行验证实验,取得了良好的效果,能够精确地对情感信息进行分类。Huang 等[13]认为只利用一个词的上下几个词生成词向量并不能很好挖掘语义,因此在全局模型中,使用词的逆文档频率(Inverse Document Frequen‐cy,IDF)值加权词向量,将文章中所有词的词向量求加权平均,作为文章的语义,局部采用C&W[14]给固定窗口打分的模型,利用全局信息来辅助局部词向量的生成方法,在一个新的数据集上对该模型进行评估,结果表明该模型要优于其他神经网络语言模型。黄发良等[15]提出一种基于多特征融合的微博主题情感挖掘模型TSSMMF(Topic Sentiment Model based on Multi-fea‐ture Fusion),能够同步推导微博主题和情感信息。何炎祥等[16]将基于表情符号的情感空间映射与深度学习模型MCNN(Multi-channel Convolution Neural Network)结合,使MCNN 捕捉情感语义的能力有效增强。Qian等[17]提出了一个简单的句子级的标注训练模型,通过模型化语言资源的正则化因子来使语言连贯表示,实验结果表明,该模型能够有效地捕捉情感信息,同时能够保证模型的简单性。Vo 等[18]将CNN(Convolution Neural Network)和LSTM(Long Short-Term Memory)模型的优点结合,提出一种有效的算法,对越南语商业网络评论进行评估,实验结果良好,性能优于SVM、LSTM 和CNN。AI-Smadi 等[19]使用基于字符级双向LSTM 和基于方面的LSTM,实现对阿拉伯酒店评论的基于方面级的情感分析,在参考数据集上进行实验验证,结果表明,该模型情感分类效果优于单个LSTM。

3 模型与方法

3.1 基础理论

3.1.1 TF-IDF模型

TF-IDF(Term Frequency-Inverse Document Fre‐quency)的主要思想是[20],如果某个词或短语在一篇文章中出现的频率较高,而在其他文章中很少出现,则认为该词或者短语具有很好的类别区分能力,适合用来分类。本文利用TF-IDF 模型建立一个情感词汇表,通过该模型减弱语义信息而增强具有较强分类效果的情感信息。实际上,TF-IDF 是TF×IDF,TF 词频(Term Fre‐quency)表示该词在文档D 中出现的频率,如公式(1)所示:

IDF 逆文档频率表示该词出现在其他文档中的概率,如公式(2)所示:

词汇ti的TF-IDF权重值如公式(3)所示:

3.1.2 CBOW模型

Google 的word2vec 是性能优良的开源词向量工具,由Mikolov 等[10]提出,它有两个重要的模型分别是CBOW 模型和Skip-gram 模型[21],前者使用词的上下文生成当前词,后者使用当前词生成它的上下文,极大化语言生成概率得到词的向量表示,如图1所示。

图1 CBOW神经网络模型

已知语料C 中一段文本,样本(context(w),w)是指context(w)由w前后各c个词构成,如图1所示。

输出层,对应一棵二叉树,它是以语料中出现过的词当叶子节点,各词在语料中出现的频率做权重值构造的Huffman 树,通过不断在树上进行二分类得到对应的词向量。

3.2 改进情感词向量获取方法

3.2.1 TF-IDF适应性改进

TF-IDF 模型对每一句话都会生成对应权重值矩阵,即词w 出现在文档i 中,就会在文档i 中生成该句的TF-IDF 权重值。如果一个词对应多个权重值,则不能适应后期构建Huffman 树与聚类分析。本文对TF-IDF模型进行适应性改进,采用取均值的方式得到唯一的TF-IDF权重值,即计算wtf_idf的权重值为公式(4):

其中,{ j:w ∈dj} 表示包含词w 的文档数,ti表示词在文档i中的TF-IDF权重值。

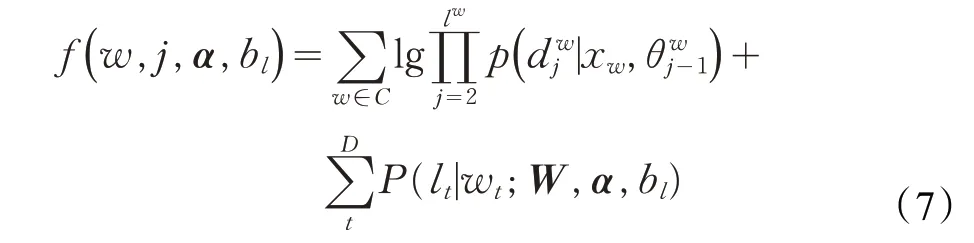

3.2.2 改进的CBOW情感词向量提取

利用改进的TF-IDF 模型得到词的权重值wtf_idf,构建Huffman 树,并将每个词的权重值保存在对应的节点内,然后将该树嵌入到CBOW 模型中,加入情感词词典进行词向量的迭代,生成情感词向量。总体过程如图2所示。

图2 改进的CBOW算法

采用层级分类(Hierarchical Softmax)[22],任意词w对应一个词向量θw,路径上每一个节点保存一个向量来辅助计算θs,每个词对应一个情感标签pt。本文引入预测函数来预测情感标签pt。

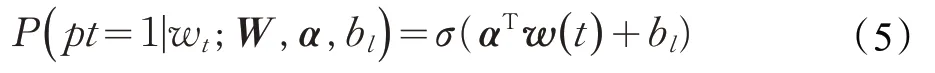

预测函数用来判断词语情感极性,属于二分类的问题。令pt=1表示积极,pt=0表示消极,可以选择合适的函数将w(t)映射到{0,1}。本文采用逻辑回归分类器,获得词语情感信息,如公式(5)所示:

其中,σ 是sigmoid 函数,α是逻辑回归权重向量,W 是词向量矩阵,w(t)是词语wt的向量表示,bl是偏置分量。逻辑回归会在词向量空间中形成一个超平面,词语的极性取决于与超平面的相对位置。

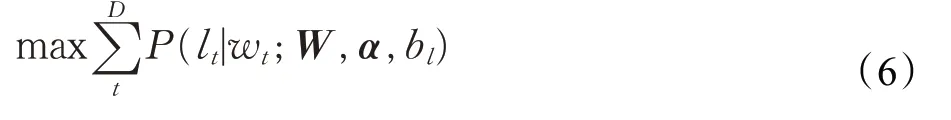

给定一个情感词典D,lt是词语wt的情感标签,假定词与词之间是独立分布,通过最大化函数可得最大化词语情感标签概率,如公式(6)所示:

通过学习标签,使情感相似的词有更近的距离。

为使CBOW 中的词向量具有情感信息,情感相似的词向量具有相近的距离,结合监督学习的方法,利用上述情感标签信息,得到目标函数,如公式(7)所示:

采用随机梯度上升法对目标函数f 求偏导,如公式(8)所示:

η表示学习率,一般取0.5,表示对每个词加入对应上下文中的权重值。

研究表明[5,15],SVM 在情感分类的性能上表现良好。本文实验选用SVM 作为分类工具,分类时采用默认参数。

为了保证数据的原始性,在数据预处理阶段,本文去除的停用词主要包括英文字符、数字、数学符号、表情、标点符号以及使用次数小于5 的单词。较高频率的单词,TF-IDF 模型会给出一个相当低的权重值,因此没有设置上限来去除。

4 实验过程

4.1 评价标准

本文情感分析的评价指标采用精确度(Precision)、召回率(Recall)、F1-score。表1 所示为二分类分类器的混淆矩阵(Confusion Matrix),其中,TP(True Positive)表示实际为正类、预测也为正类的文本数量;FN(True Negative)表示实际为正类、预测为反类的文本数量;FP(False Positive)表示实际为反类、预测为正类的文本数量;TN(True Negative)表示实际为反类、预测也为反类的文本数量。

表1 混淆矩阵

精确率定义为:

召回率定义为:

在实际应用中,通常使用两者的调和平均数作为一个综合的评价指标,即F1-score值,如公式(13)所示:

4.2 情感分析实验

4.2.1 数据预处理

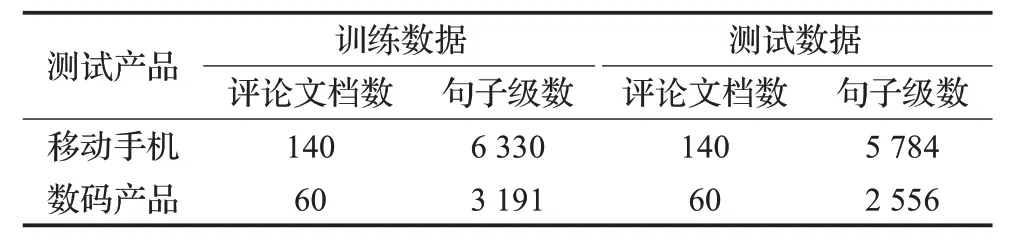

实验使用的训练数据与测试数据是SemEval-2016 Task5中的中文评论数据。具体数据见表2所示。

情感词典由台湾大学情感词典和知网情感词典两者取并集组成,其中,积极词汇3 987个,消极词汇3 772个。

表2 实验数据构成

利用Python中jieba工具对语料库分词后,去除里面的符号。然后,将分词结果与情感词典和停用词典取交集,得到情感词汇表sm共420个,停用词汇表sp共655个。

4.2.2 运用TF-IDF模型计算权重值

运用TF-IDF 模型对处理后的训练数据进行训练,计算每个词的TF 值与IDF 值,得到每一个词的权重值并取均值。利用K-means 聚类,依据实验的情感词汇表sm 和停用词表sp,统计每个类别中的个数,并用公式(14)计算聚类后类别的权重值。

图3 采用TF分类实验结果

从实验数据可以得出,在聚类数小于7 时,类别中词的数量很大,情感词和停用词的数量差距也很大。在聚类数为7 至11 的实验结果中,前段分类均衡,中段起伏较大,尾部趋于收敛;聚类数为12 之后,尾部收敛值趋于一致。

引入IDF 值来观察小部分数据的变化,采用公式(15)计算权重值。结果如图4所示。

图4 采用IDF分类实验结果

图4 中,从不同聚类数的实验结果中均可看出中间部分的差值被放大。聚类中心在0.3 附近时,所有分类的权重值都比较大,说明这个中心情感信息的含量超过停用词的含量,具有很强的情感判别能力。

图5 聚类数12的实验结果

以聚类数12为例,如图5所示。

停用词和情感词都采用除以该类别的总词数进行归一化。通过图5 得出,聚类中心小于0.1 时,聚类数为5之前的类别中,词数共占总词数的86%,且停用词和情感词的数量总体呈下降趋势,其中停用词在聚类中心0.3左右减少到0,情感词在聚类中心0.4左右减少到0。

同时,通过多组实验研究了不同聚类数下停用词和情感词的占比趋势。实验结果显示,随着聚类数的增多,停用词在聚类中心0.24 以后就不再出现,情感词在聚类中心0.36以后不再出现。观察语料库发现,该类别语料是一些手机型号的评论语句,如G21、p1000、p6200、黑莓等。通过程序自动删除该类别之后的词语,可以达到代替停用词表的效果。在聚类数过高时,类别中词数将会很少,同时,删除部分情感词,可以在适当降低精度的情况下换来更高的运算速度。因此,本文选取聚类中心阈值为0.16,聚类成14类。实验中一共删除词230个,通过检查发现情感词共10个。

4.2.3 情感词向量处理

本文实验选取了CBOW 模型中两组词:{赞扬,批评}、{提高,降低}所对应的词在向量空间内最相近的前6个词,如表3所示。

表3 情感词调整表

从表3 可以看出,在词类“降低”的基础词向量中,出现了情感极性相反的词语,如“超低”、“过高”均为描述某物体性能的情感词。因为CBOW 的无监督特性以及两个词语的语义距离十分接近,可以相互替换,所以情感极性也会随之替换。

实验对CBOW 选取的两对共24个情感词进行了手动调整,在词类相同的情况下,保留相同极性的词,去掉相反极性的词。用调整后的情感词表来计算词向量,避免了极性相反的情感词对词向量的影响,因此用来判断语料库中词语的情感倾向是合理的。

4.2.4 确定词向量维度

词向量的维度反映的是获取的特征量的大小,维度越小获取的特征量就少,对应的训练时间也会减少。但是,特征量太少,就不能完整反映该单词的含义;特征量过多,训练时间会越长,实用性不高。因此,通过实验找到最为合适的词向量维数。实验结果如图6所示。

图6 不同维度下的准确率

实验结果表明,当维度较小时,提升维度可以大幅提升准确率,但是一定维度之后,如本实验的150维,准确率将趋于平稳。因此,本实验选择150维作为词向量的维度。

4.2.5 实验结果

将训练得到的词向量作为特征向量,采用SVM 情感分类预测,对已标注的情感数据进行情感分类,并与基于原生的IF-IDF模型和word2vec的CBOW 模型方法分类进行结果对比,如表4所示。

表4 实验结果

从实验结果可以看出,本文提出的方法取得了较好的分类效果。TF-IDF 模型只考虑了词汇的重要程度,CBOW 模型的分布式词向量能够克服评论文本的特征稀疏问题,但是无法得到每个单词对情感分类的贡献程度。同时可以得出,在一定程度上得到词汇重要程度比语义信息来表达情感能力较弱,但也能筛选出一定的信息。本文结合两种模型得到更好的分类效果,在精确率、召回率、F1值和整体的正确率上都有所提高。

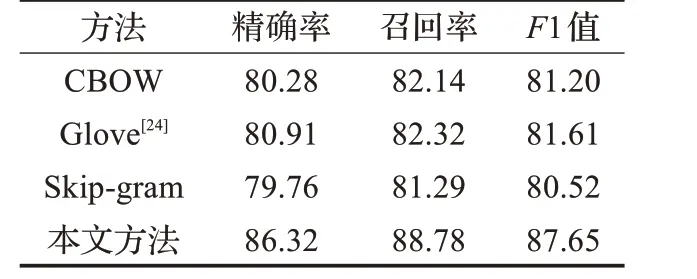

同时,根据4.2.3 小节情感词向量处理,使用多种词向量方法在单词级别上进行情感分类实验,实验结果如表5所示。

表5 单词级别实验结果%

实验结果表明,本文方法在分类结果中取得了良好的效果,明显高于传统的词向量方法。相比没有融合情感信息的CBOW模型,分类效果得到了5%左右的提升,同时也证明了该模型确实将情感信息融入到了词向量中。

5 结束语

本文首先改进TF-IDF 模型构建一个替代性的停用词表,并且利用结果生成Huffman树作为改进的CBOW模型的输入,同时在单词级别上进行了情感分类实验。实验结果表明,本文方法有效提升了分类效果,在各个指标上都优于传统模型,词向量中也确实融入了情感信息。本文方法虽然减少了部分特征工程量,但是仍然有依赖于情感的特征工程,情感标签训练的结果直接影响着情感的表达。同时,网络用语的随意性,使利用词典得到所有情感词比较困难,下一步考虑利用神经网络来同步进行训练与扩充词典,增强情感词对词向量的影响。