基于机器视觉的淡水鱼去鳞损伤无损检测识别方法

闫朋涛,王昆伦,孙家亮,张学雨,王碧尧,王慧慧*

1. 大连工业大学机械工程与自动化学院(大连 116034);2. 国家海洋食品工程技术研究中心(大连 116034)

随着人们生活水平的提高,对于高品质鱼蛋白的需求量在逐年增加,淡水鱼类含有丰富的蛋白质,其产量在鱼类总产量中约占73%[1-2]。2017年渔业年鉴显示,2016年全国淡水鱼类养殖量达约3 179.3万 t,比2015年增长约100.5万 t,随着淡水鱼需求量的逐年增长,淡水鱼产量与前处理过程的不匹配状态已严重制约相关行业的发展,提高淡水鱼加工自动化、智能化水平显得尤为重要。淡水鱼前处理加工过程的关键工序主要包括去鳞、去脏、去头。其中,去鳞损伤是影响产品外观品质、减少货架期的重要因素,目前对去鳞损伤的检测还主要依赖人工完成,是制约淡水鱼加工装备自动化、智能化主要原因之一。

近年来伴随着人工智能的崛起,机器学习和深度学习得到了极大的发展。计算机技术和相关硬件设备的进步为机器学习和深度学习的应用提供了硬件基础。计算机视觉作为一种新兴的技术,依托计算机高速运算的优势和相关图像采集设备性能的提高,在食品加工与产品品质检测方面有着广泛的应用。同时,与机器视觉相关的设备正朝着快速、无损、高精度、高自动化等方向发展[11,13-14]。目前已经在蔬菜、水果等无损检测中得到了越来越多的研究和应用[12,16,20]。王树文等[3]利用图像采集设备将采集的图像利用图像处理的方法得到番茄缺陷的特征参数,建立BP神经网络模型,最终实现了对番茄损伤的自动检测和分类;李顺琴等[4]基于计算机视觉提取橙子的大小颜色和表面特征,通过建立RBF神经网络模型,实现对橙子的自动化检测和分级也取得了不错的效果;李锦卫等[5]通过计算机视觉技术,利用灰度截留分割和十色模型对马铃薯的表面缺陷和有芽进行了研究,通过计算机视觉技术建立的该检测方法可以快速有效的检测出马铃薯的表面缺陷。

研究面向机械式去鳞过程,基于机器视觉和图像处理技术建立淡水鱼去鳞损伤自动识别算法模型,实现了淡水鱼去鳞损伤的快速、无损检测。

1 材料与方法

1.1 试验材料

研究以鲤鱼为例展开相关试验。试验用鲤鱼购置于大连长兴水产市场,挑选的为鳞片无损伤的鲜活鲤鱼,经过去头、去脏后放入带冰的保温箱中迅速运回实验室。使用刮板式去鳞机进行样品的去鳞操作试验,随机选取带有去鳞损伤的鲤鱼进行图像采集,为后续的处理提供数据支持。

1.2 仪器设备与图像数据的采集

利用机器视觉系统装置采集每个样本相应的图像数据,该系统装置主要由工业相机、卤素灯光源、工控装置等组成,曝光时间为10 ms,物距50 cm,所采图像分辨率为960×1 400 pixel2,图像的位深度为24,图像格式为BMP。

针对具有去鳞损伤的图像,在损伤图像处选取30×25 pixel2大小的矩形区域作为损伤的感兴趣区域(ROI),在正常鱼体图像处选取30×25 pixel2大小的矩形区域作为无损伤ROI区域。

1.3 图像处理与模型搭建

1.3.1 图像颜色模型的选择和预处理

为获取图像中ROI的特征,计算机对彩色图像的处理需要根据应用目的的不同选用不同的彩色模型,研究采用应用较为普遍的RGB颜色模型[9-10]。

对数字图像进行多分辨率分析时,小波变换能够在空间频率域进行局部化分析,通过伸缩平移等运算操作对图像的像素信号函数进行细化,能够实现空间频率信号的自动分析。方法具有低熵、多分辨率性、去相关性,基数选择灵活等特点,对尖峰和突变信号具有良好的保护作用。因此,研究采用阈值小波变换进行图像去除噪声处理,并与原始图像处理效果进行对比分析。

1.3.2 神经网络建模

广义神经网络(GRNN)是一种建立于非线性回归分析基础之上的径向基神经网络[6-7],其具有较强的非线性映射能力和全局收敛性,具有较简单的网络结构,较强的鲁棒性和容错性;径向基函数神经网络(RBF)是一种基于高斯函数的非线性映射的神经网络,该网络将数据转化到高维空间,实现高维空间线性可分,网络训练时间较短,不易产生局部最优解[8]。GRNN、RBF网络已广泛应用于食品品质的分级预测[7,18]。研究建立基于GRNN和RBF网络的鱼加工损伤预测模型,并针对预测的准确率、建模时间进行对比分析。模型输入层神经元由所采集样品的图像特征构成,输出层神经元由0、1构成,分别代表完好鱼体表面和损伤鱼体表面。选择100个30×25 pixel2图像来构建预测模型,其中50个为完好鱼体表面图像,50个为损伤鱼体表面图像,标记好后,分层按比例选取这100个图像中的60个图像用于模型的训练,40个图像用于模型的验证。

1.3.3 损伤区域识别验证与可视化

利用上述模型实现完好鱼体区域与损伤鱼体区域的预测,在此基础上对图像进行图像二值化处理,其中完好鱼体的图像部分赋值为0,损伤鱼体的图像部分赋值为1,通过形态学图像处理区域联通和小区域去除[9-10]的方法降低消除预测过程中产生的误差。在此基础上,利用二值图像数据特点,通过预测图像与原始样本图像的乘法运算,实现损伤区域的可视化。利用预测损伤区域与实际损伤区域面积相对误差比验证模型精确度,比值公式如式1所示,其结果值越接近100%说明模型预测越准确。

式中:p1为预测所得损伤区域的图像面积,p2为原图像实际损伤区域的面积,P为鲤鱼的预测损伤区域与实际损伤区域的接近程度百分比即准确率。

1.3.4 数据处理

研究利用Matlab 2011a(The Math Works Inc.,美国)软件,进行识别模型的建立和损伤区域图像仿真等相关运算和操作。

2 结果与讨论

2.1 图像去噪分析

图1为预处理图像,其中图1(a)为原始图像,(b)为经小波去噪处理后图像,比较两图像效果,去噪图与原图差别不大,说明由于暗箱和光源的设置较为合理,消除了大量的光照和噪声的影响,为减少图像处理的时间,提高分析检测的速度,故选择原始图像直接进行后续分析与建模等相关运算。

图1 预处理图像

2.2 图像区域的划分与分析

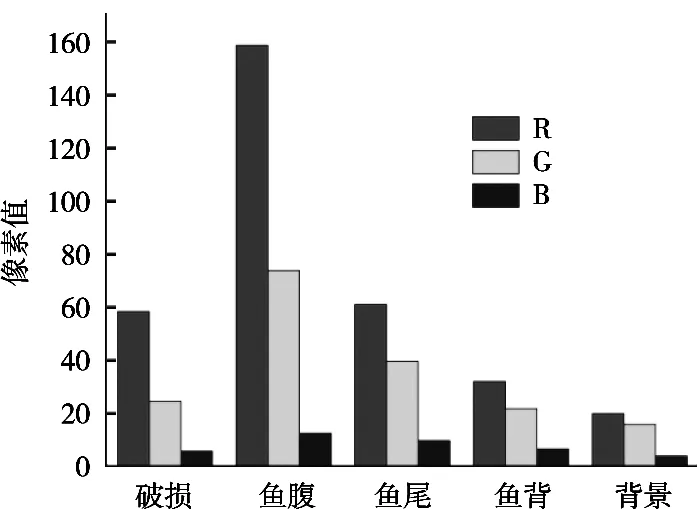

从原始图像中可以看出,图像主要由背景、正常鱼体区域、损伤鱼体的区域构成,背景、正常鱼体部分、损伤鱼体部分颜色差别较大,如图2所示,鱼体的正常区域不同部位颜色值存在差别。为了消除这种影响,根据观察和分析可将鱼分割成三个部分,分别研究其颜色值变化情况。如图3所示,鱼体图像包含背景、鱼腹、鱼背、鱼尾、损伤区域五部分,分别在五部分内选取30×25 pixel2大小的图像块,计算其R、G、B平均值(图4),鱼腹、鱼尾、鱼背、背景区域的R、G、B平均值逐渐降低,损伤区域的R平均值与鱼尾相似,G平均值与鱼尾背相似,B平均值与鱼背相似。说明破损区域颜色值与其它区域颜色值存在差异,可以此为特征进行破损区域识别的研究。

图2 鱼体分割图像

图3 ROI区域

图4 R、G、B平均值

2.3 预测模型的搭建及分析

在15条鲤鱼图像中随机选取鱼背、鱼腹、鱼尾共计50个图像块,损伤区域50图像块,分别进行R、G、B平均值的计算,以此作为输入建立鱼加工损伤预测模型,并分别选择GRNN和RBF网络构建此模型。

GRNN网络的输入层神经元个数为3,对应所选图像块的R、G、B平均值。隐层神经元的个数由训练样本通过自适应练习确定。在扩展常数的选取方面,针对100个图像块的GRNN网络扩展常数展开试验,当该网络的扩展常数越大时,所得拟合函数越平滑,但需要大量神经元用以适应其快速的变化,反之,选择较小的扩展常数,也需要较大数量得神经元适应缓慢变化的函数,通过上述100个图像块进行试验发现,扩展常数取3时,基于GRNN网络的鱼加工损伤预测模型分级效果最好,预测速度最快。该网络的输出神经元为2个,分别对应正常鱼体图像和损伤区域。

RBF网络的输入层神经元个数为3,同样对应所选图像块的R、G、B平均值。隐层神经元由自适应确定。针对100个图像块的RBF网络扩展常数展开试验,当RBF网络扩展常数选择17.5时,网络预测效果最好、速度最快。RBF网络输出层同GRNN网络。

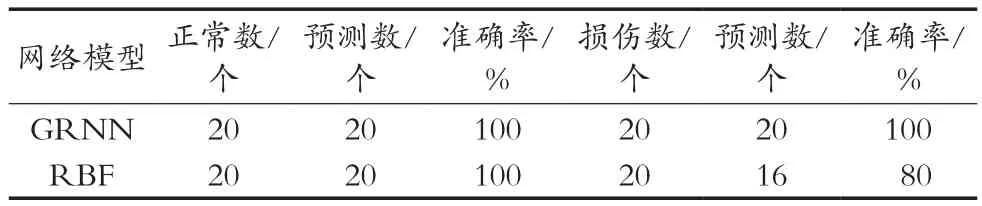

针对前述GRNN和RBF网络,选择60个图像块进行网络训练,其中30个为正常鱼体图像,30个为损伤鱼体图像;选择40个图像块进行网络预测,其中20个为正常鱼体图像,20个为损伤鱼体图像,预测结果如表1所示。预测结果表明,上述两种网络预测鱼损伤区域都有较高的准确率,其中GRNN和RBF网络识别正常区域都是100%,针对损伤区域的预测,GRNN网络预测准确率为100%,RBF网络预测准确率相对较差(80%)。

表1 GRNN网络和RBF网络识别正常与损伤结果

为验证鱼加工损伤预测模型的应用效果,选取十五幅具有机械损伤的鱼体图像,通过图像处理中的特征提取[11],计算出相应部分所占像素点的多少作为面积,进一步通过p值的计算结果作为损伤识别的准确率。如表2所示,基于GRNN网络的p值平均值为0.941;基于RBF网络的p值平均值为0.836。说明两种神经网络都可以较好实现鱼损伤区域的自动识别,其中GRNN网络模型识别效果更优。光照不均匀、损伤多样性等因素可能是造成识别误差的主要原因[8]。区域可视化结果,其中a1和b1分别是GRNN和RBF网络模型识别出鱼体损伤的区域,a2和b2分别是GRNN和RBF网络模型经过图像处理中区域联通和小区域去除得到的相关二值图像,a3和b3分别是GRNN和RBF网络模型获得的鱼体状况可视化效果图,可视化的结果同样证明了GRNN和RBF网络模型可以很好的识别出损伤区域,但是GRNN网络模型预测出的损伤区域通过对比则更接近实际损伤区域。

表2 GRNN和 RBF网络识别仿真损伤区域与实际损伤区域面积比值

图5 基于GRNN网络和RBF网络识别损伤区域可视化

3 结论

研究针对面向淡水鱼加工过程中的去鳞损伤检测问题,展开有关鱼去鳞损伤自动识别的关键技术研究,建立了基于计算机视觉技术的鱼去鳞损伤无损检测方法。根据鱼正常区域与损伤区域颜色差异性,将鱼样本图像划分为鱼腹、鱼背、鱼尾、损伤和背景五部分,提取不同区域的ROI,针对鱼体颜色RGB值的变化进行相关的统计学分析[15,17,19]。利用样本图像R、G、B值的差异等特点建立基于GRNN和RBF网络的鱼损伤区域预测模型,实现了鱼的正常与损伤区域的识别,识别模型准确率分别为98%和80%。为验证上述模型的可行性,进行了损伤区域可视化研究,计算预测损伤区域与实际损伤区域的相对面积比的准确率值(p),最终,基于GRNN网络的p值平均值为0.941,基于RBF网络的p值平均值为0.836,结果表明GRNN网络识别效果较好且优于RBF网络。上述研究为开发鱼损伤区域快速检测设备提供了数据支持和可行的检测方法。