图像级别和像素级别的显著图像的融合*

陈 蕾,吴建国,刘政怡+

1.安徽大学 计算智能与信号处理教育部重点实验室,合肥 230601

2.安徽大学 计算机科学与技术学院,合肥 230601

3.安徽大学 信息保障技术协同创新中心,合肥 230601

1 引言

计算机视觉领域的图像显著性检测工作越来越受到学者的关注和重视,它可以被广泛应用到众多视觉任务中,如目标识别[1]、图像分割[2]、视频跟踪[3]以及目标重定位[4]等。

顾名思义,显著图融合工作,即融合由N种图像显著性检测方法生成的显著图以得到最终显著图。已有很多学者在该领域做过大量研究工作,并可以证明融合工作确实可以取得明显成效。这些融合思路从不同的角度出发,方法各异,值得总结和学习。

一些传统的显著图融合方法大多仅是对多幅显著图进行简单的线性加和平均或者是相乘取平均。这种融合方式将多种显著图同等对待,通常在实际中是不合理的。Jiang等人在文献[5]中设计了质量指标来定量评估不同方法生成的显著图的优劣,然后通过将该质量指标作为权重加权平均较优显著图和滤除较差显著图来构造融合框架。该方法通过计算显著图的质量指标作为融合权重,可以区别对待单个初始显著图,而不是简单地相加平均,这样可以降低效果较差的显著图对整个融合结果的影响。在文献[6]中,Cao等人提出了一种通用的可以自适应地融合多种显著性检测结果的框架,通过计算多种显著性检测结果的自适应权值,再用该权值对多幅显著性结果进行线性加权来实现融合过程。在文献[7]中,Mai等人提出了一种基于条件随机场(conditional random field,CRF)框架的数据驱动的显著性聚合方法来融合多幅显著图。该方法不仅考虑到不同显著性方法之间的性能差异,而且模拟了相邻像素之间的相互作用,使得融合效果明显优于单个初始显著图。然而,这种方法计算速度太慢。在文献[8]中,Tao 等人对Dempster-Shafer(D-S)证据理论进行改进,并首次将其应用到显著图的融合工作上,该算法新颖创新,但运行时间较长。在文献[9]中,Lu等人将初始的每一幅显著性图作为一层元胞自动机,并提出了基于贝叶斯理论的多层元胞自动机用于融合多幅显著性图并得到一个更优的结果,这种方法高效可行,但是其召回率较低。

2 方法

为了更有效更全面地融合显著图,本文主要从两个层面对显著图进行融合,主要贡献有以下三点:

(1)对RGB-D图像显著图进行融合,即在融合显著图的过程中,利用深度图进行影响。

(2)分别在图像级别和像素级别两个层面上融合显著图。在图像级别上,设计了一种简单且有效的RGB-D 显著图质量评估的特征——分割质量,并用该特征作为显著图的权重,在图像级别上进行线性融合。

(3)在像素级别上,考虑单个像素在不同显著图中的显著值差异,针对单个像素计算其显著相似性,将其作为该像素的权重,在像素级别上进行融合。

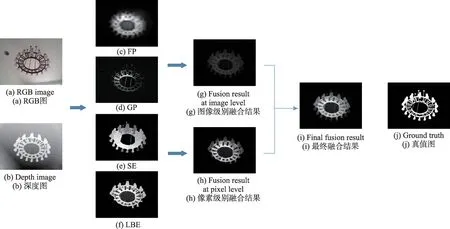

本文算法流程图如图1所示。图1(a)和图1(b)分别为输入的RGB图像和深度图像。本文首先对图1(a)和图1(b)分别使用四种RGB-D显著性检测方法:FP(fusion and propagation)[10]、GP(global priors)[11]、SE(saliency evolution)[12]、LBE(local background enclosure)[13],相应地得出显著图图1(c)、图1(d)、图1(e)、图1(f),以此作为融合过程的初始显著图。其次,一方面分别对这四种初始显著图计算其质量评估值——分割质量值,并将其作为图像级别线性融合的权重,得到图像级别融合结果如图1(g)所示。另一方面,针对单个像素在四种初始显著图之间的显著性显示差异,计算每个像素的显著一致性,并将其作为像素级别线性融合的权重,得到像素级别融合结果如图1(h)所示。最后,再将这两个级别的结果按比例融合,得到最终融合结果图1(i)。从图1示例中吊灯的左下方小灯泡可以看出,像素级别的融合可以弥补图像级别融合的细节缺失部分,促使整个融合过程优势互补,得以生成最终较好的融合结果。图1(j)为该示例的真值图。

符号标记:对于RGB图像I,其对应的深度图为D,用n种RGB-D显著性检测算法生成n幅初始显著图,记为M1,M2,…,Mn。

2.1 图像级别的融合

为了解决图像级别的显著图融合问题,本文设计了一种RGB-D显著图像的质量评估特征——分割质量,用来衡量显著图中目标和背景的分割准确度。

对于第i张显著图Mi,首先计算该图中所有像素的平均显著值t,用该值作为阈值二值化Mi为显著区域St和背景区域Bt,即:

其中,Mi(p)为显著图Mi中像素p的显著值,值为1则表示像素p属于显著区域St,反之属于背景区域Bt。

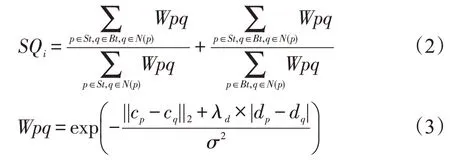

由文献[14]可知,一个好的分割结果应该呈现出区域内相似性最大化而区域间相似性最小化,则显著图Mi的分割质量特征定义如下:

其中,N(p)表示像素p的邻居像素集合,在这里定义为p的八邻域。Wpq为相邻像素p和q之间的颜色和深度相似性。cp和cq分别为像素p和像素q的L*a*b*颜色值,dp和dq分别为像素p和像素q的深度值。||·||2为二范数,计算像素之间颜色值的欧式距离。σ2=0.01为控制参数。

Fig.1 Algorithm flow chart图1 算法流程图

由于质量较差的深度图可能会影响像素之间的深度相似性的计算结果,故引入深度置信度λd[15]来衡量深度信息的质量,定义为:

在该式中,md为整个深度图的平均深度值,CV表示差异系数,H为深度频率熵,表示深度分布的随机性。λd值越大则表明深度图中的深度信息越可靠。

分析式(2)可知,分割质量特征值越大表明当前显著图的质量越优。

按照式(2)对每张显著图计算出其分割质量,并用该特征值作为权重进行线性加权融合,可得图像级别的融合显著图Sal1:

其中,Norm(·)为归一化函数。

2.2 像素级别的融合

为了获取显著图中更为细节化的信息,本文考虑像素在不同显著图中的显著一致性并提出像素级别的融合方法。对于像素p,其在初始显著性图M1,M2,…,Mn中的显著值分别表示为M1(p),M2(p),…,Mn(p),定义像素p在任意两张显著图像i和j中的显著性差异为:

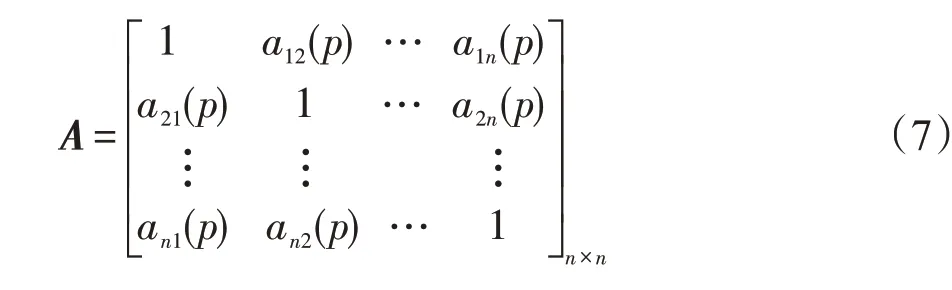

则n幅显著图对应的像素p的相似矩阵如式(7)所示,分析可知,A具有对称性:

综上可得,像素p在第i幅显著图与其他显著图的显著值的一致性测度计算为:

用该值作为像素p在显著图i中的权重,可得像素级别的融合结果为Sal2:

2.3 最终融合结果

最后,融合图像级别的显著图和像素级别的显著图,可得最终的融合结果为:

为了平衡图像级别的显著图和像素级别的显著图对最终融合结果的贡献程度,且经过实验证明,设置参数∂1=0.6,∂2=0.4可使得实验效果最优。

2.4 算法伪代码

本文显著图像融合算法的伪代码如下:

算法图像级别和像素级别的显著图像的融合

输入:RGB图像、深度图像、N张初始显著图。

输出:通过融合得到的最终的显著图像。

1.根据式(2)计算每张初始显著图的分割质量值SQi;

2.根据式(5)在图像级别上融合初始显著图,得到Sal1;

3.根据式(8)计算像素在初始显著图中的显著值一致性;

4.根据式(9)在像素级别上融合初始显著图,得到Sal2;

5.根据式(10)融合Sal1和Sal2,得到最终的融合显著图。

3 实验结果

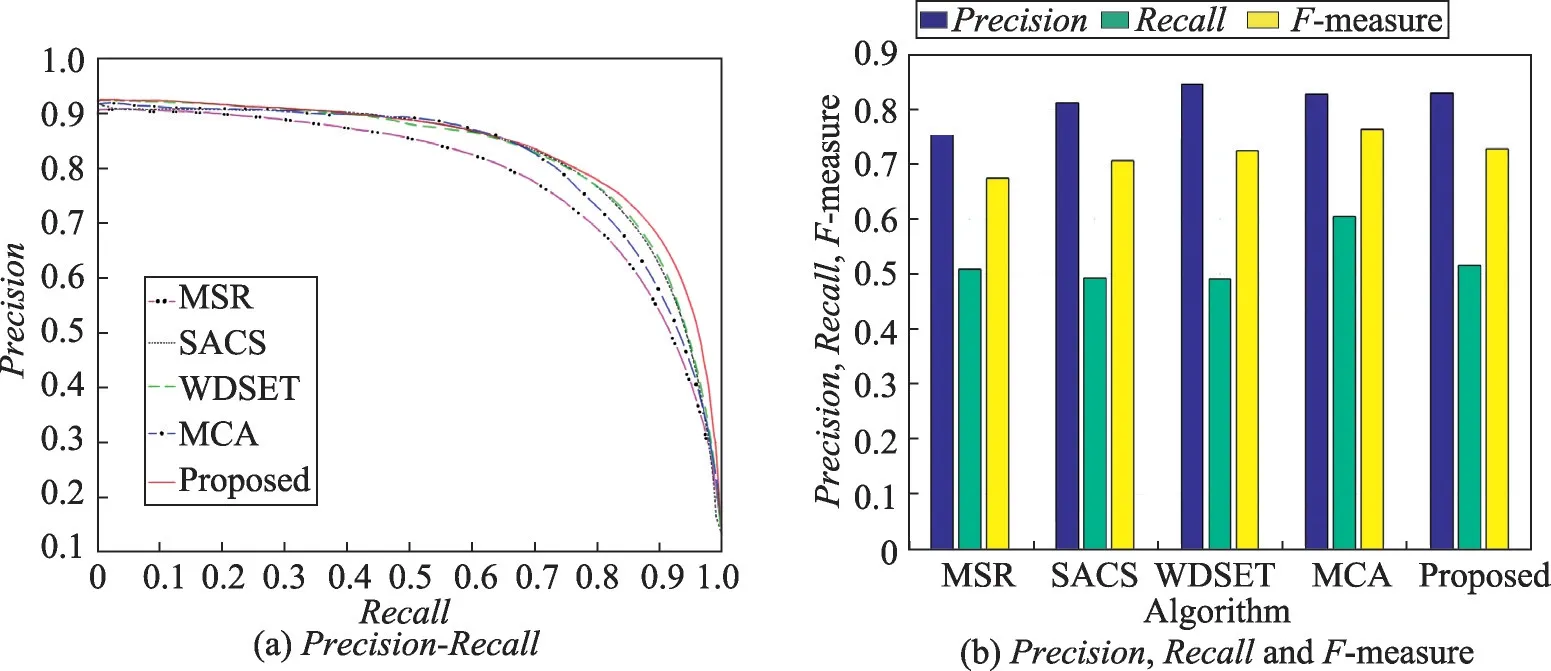

实验在RGB-D1000[16]基准数据集上,选定了4种经典的RGB-D 显著性检测算法对其进行显著性检测,获取初始显著图。选定的4种方法是FP[10]、GP[11]、SE[12]、LBE[13]。另外,将本文实验与4种先进的显著图融合算法,就准确率P(Precision)、召回率R(Recall)以及F-measure 这3个评估指标通过绘制精度-召回(Precision-Recall,PR)曲线图以及评估指标直方图作直观对比。对比的4种显著图融合算法包括MSR(mean saliency in covered window-spatial distribution of saliency map ratio)[5]、SACS(self-adaptively co-saliency)[6]、MCA(multilayer cellular automata)[9]、WDSET (weighted DS evidence theory)[8]。

实验平台:所有程序均在IntelCorei7CPU2.00GHz、内存4 GB的PC上实现。本文方法使用Matlab(R2016a),对比算法来自各引用论文作者提供的公开代码或实验结果集合。

3.1 实验参数及评估标准

跟很多现有研究工作一样,本文使用PR 曲线和F-measure值对所有的算法进行评估。

对于一张显著图,可以将其转换为二进制掩码M,并通过比较M和真值图(ground truth,GT)来计算精度和召回率。具体实现是将显著图量化至[0,255],然后为每5个值设置一个阈值。在该显著图中,如果当前像素的显著性值大于阈值,则指示该像素属于前景,否则该像素属于背景。在每个阈值上,计算出一对准确率/召回值,并最终将其组合成一条精度召回(PR)曲线来描述算法在不同情况下的性能。准确率和召回率可以通过以下公式计算:

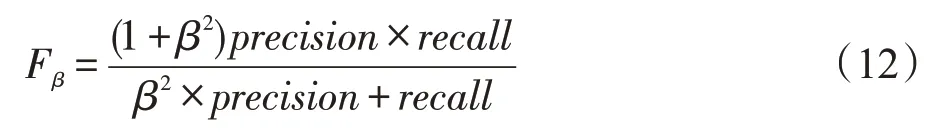

通常,无论是准确率还是召回率,都无法全面地评价显著图的质量。本文采用F-measure 作为整体性能评价,由文献[17]可知,具体计算方法为:

如果β2被设置为1,则F-measure 的结果即为准确率和召回率的调和均值。如果β2>1,则召回率将对F-measure 的结果影响更大。当β2<1时,则查全率对F-measure 结果的影响较大。正如大多数突出的目标检测工作所建议的那样,为了控制准确率和召回率的权值,将β2的值设为0.3。

3.2 实验结果及分析

图2为4种初始图像显著性检测算法及其融合结果对比图。图2(a)、图2(b)分别为这4种初始图像显著性检测算法及两个级别上的融合结果的PR曲线图和评估指标直方图。图2(a)PR 曲线显示,本文提出的基于图像级别(stage1)和像素级别(stage2)的显著图融合算法明显优于初始的图像显著性检测算法。图2(b)所示为基于准确率P(Precision)、召回率R(Recall)以及F-measure的3个指标的评估结果。该评估直方图表明在加入像素级别融合过程(stage2)后,最终融合结果(Proposed)的F-measure 值高于仅基于图像级别的融合结果(stage1),验证了像素级别融合过程的有效性。

图3为本文提出的融合算法与其他4种显著图像融合算法的对比结果。图3(a)、图3(b)分别为不同的显著图像融合算法的PR曲线图和评估指标直方图。图3(a)PR 曲线显示,本文提出的基于两个级别的融合算法整体优于其他4种显著图像融合方法。图3(b)所示为基于准确率P(Precision)、召回率R(Recall)以及F-measure 的3个指标的评估结果。该评估直方图表明,本文算法F-measure 值低于MCA[9]融合算法,但皆高于其他算法。

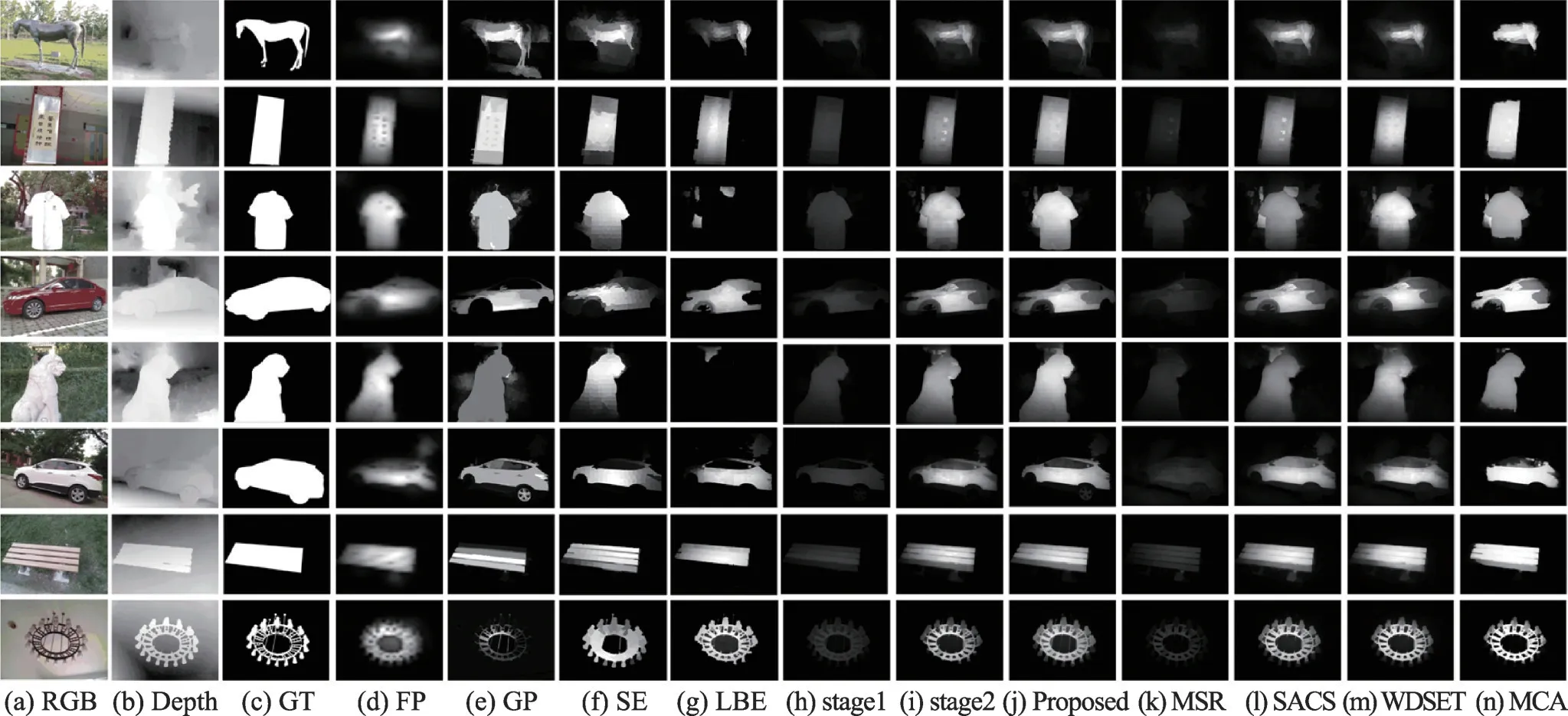

图4所示是本文提出的显著图像融合算法与其他显著图像融合算法的质量对比实验的部分示例。本文算法与其他显著图像检测算法相比,该算法不仅可以较好地凸显图像中的显著目标主体,而且显著目标的细节边缘部分也能得到更细致的处理。

Fig.2 Comparison of initial saliency detection algorithms and fusion results图2 初始显著检测算法及其融合结果对比

Fig.3 Experimental results of different algorithms for saliency map fusion图3 不同显著图融合算法的实验结果

Fig.4 Quality contrast examples图4 质量对比示例

表1为本文方法与其他显著图像融合算法在数据集上整体的运行时间对比结果。本文算法验证实验运行整体时间为1 232.631 s,运行时间相对偏高的原因是在图像级别的显著图融合过程中增加了对深度信息Depth的计算。

Table 1 Comparision of average running time表1 平均运行时间对比

4 结束语

本文在两个层面上对RGB-D 显著图进行融合,不仅量化计算了初始显著模型之间的优劣差异对最终融合结果的影响程度,还考虑了单个像素层面的显著相似性。实验结果显示本文所提出的融合方法得出的显著图明显优于初始显著图,且在与其他融合算法相比较时,该方法也具有一定的优势。在未来的学习和研究中,可以进一步考虑显著图中显著目标的特征,加入基于目标级别的显著图像融合,由此可以更全面地进行显著图像融合工作。

———占旭刚4