基于双目视觉的固定翼无人机自主着陆技术研究

马晓东,吕 昊,张 杰,高帅华

(中国飞行试验研究院,西安 710089)

近年来,基于视觉传感器的无人机自主着陆技术作为其智能化、自主化研究中的重要环节,受到广泛关注[1]。当前将视觉传感器运用于无人机自主着陆中的多是旋翼机。由于其可近距离飞行、慢速垂直起降,能获得清晰的图像,故多是利用合作地标,设计算法对其进行识别、跟踪及相对位姿解算用于着陆导航[2-4]。该方法实时性较强、导航精度较高,故研究与应用较为广泛。而固定翼无人机由于飞行速度较快、着陆位置较为固定(多为跑道)、且进入着陆状态是距离着陆点较远,多是通过检测和跟踪跑道、识别地平线等方法实现无人机自主着陆[5-6]。但该方案无法得到较为全面的导航信息,且实时性较差、精度较低,无法满足固定翼无人机自主着陆需求。

基于上述研究基础,结合旋翼机利用合作地标自主着陆的优势,利用由两个视觉传感器构成的双目视觉系统设计一套固定翼无人机自主着陆导航方法,通过对无人机着陆过程分析,设计地标形状并确定摆放方式,方便机载双目视觉系统对着陆地标进行检测识别与跟踪,并提取关键特征角点用于相对位姿估算,并进行双目融合以提高精度。

1 系统总览

1.1 合作地标设计

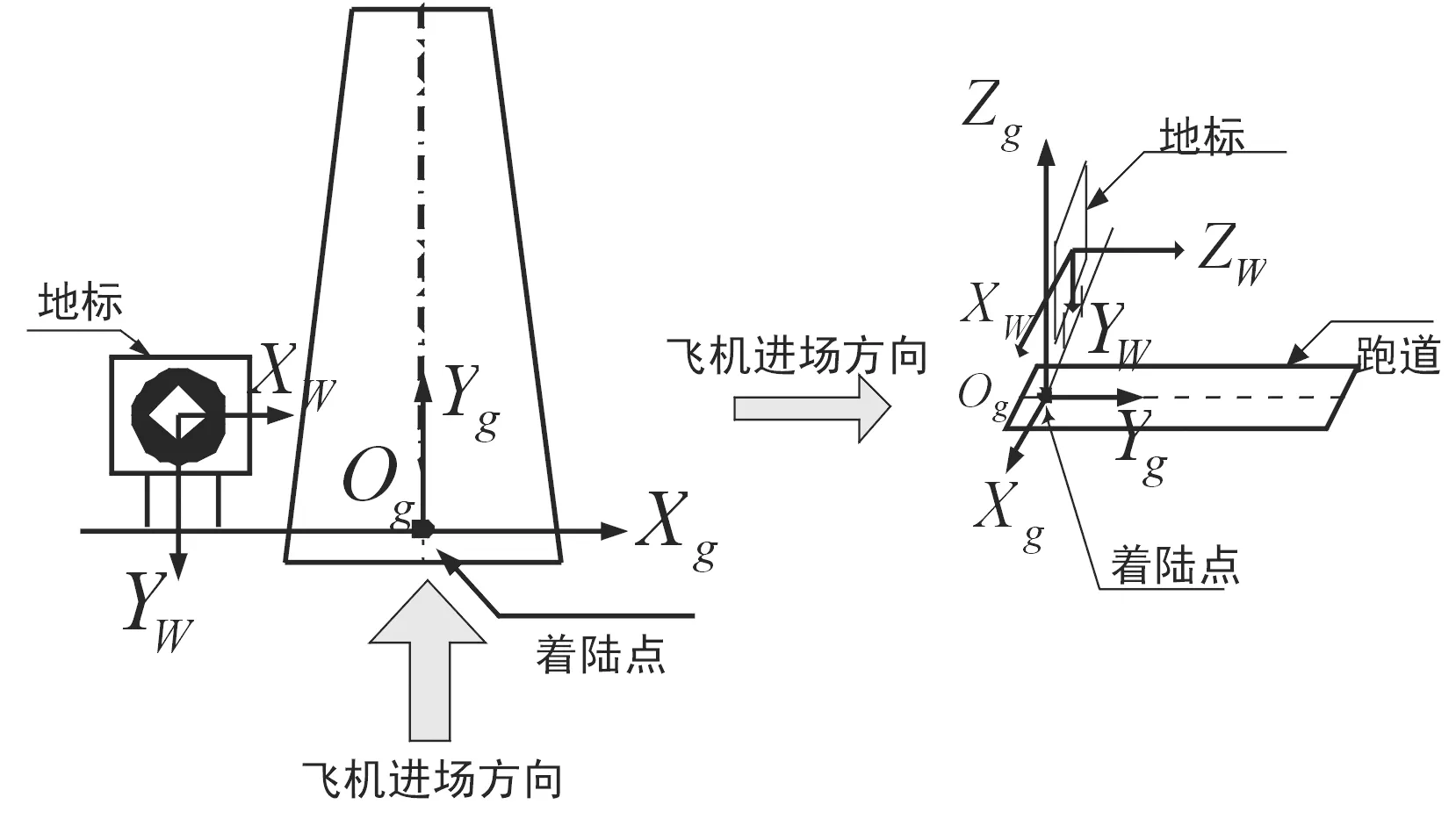

固定翼无人机降落过程分为:进场平飞→下滑→拉平→滑行[6],整个降落过程飞机对准跑道飞行,仅在高度方向变化快速,其他方向位移变化不大。基于此特点,确定合作目标形状及摆放方式如图1所示。地标垂直地面、面向无人机进场方向放置,保证着陆过程中地标始终在视场内,且仿射变换较小,从而方便无人机识别跟踪与三维信息解算。

图1 合作目标摆放方式示意图

1.2 着陆流程设计

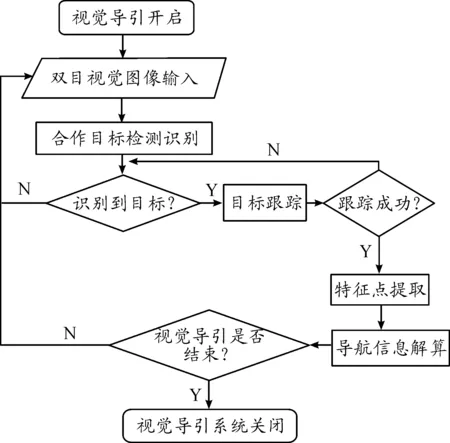

视觉导航算法的工作流程如图2所示,主要包括目标检测识别、目标跟踪以及相对位姿解算3部分。

2 合作地标检测识别

2.1 目标检测

目标检测主要包括两部分:图像预处理包括滤波、分割、边缘检测及轮廓提取,在去除噪声等干扰之外,提取包括目标的“疑似目标”轮廓集;基于合作地标图案外圆轮廓特点设置阈值条件进行初步筛选。如图3所示,圆形地标成像时由于拍摄角度的变化,会畸变为类椭圆形;用矩形边框逼近,会存在如下特点:椭圆在矩形框中所占面积较大,且椭圆中心与矩形中心距离较近。

图2 视觉导引自主着陆工作流程框图

图3 目标轮廓与其逼近矩形框关系示意图

基于上述特点,设计筛选阈值条件如式(1)所示:

(1)

式(1)中:SL、OL分别为闭合轮廓面积与中心,||OL-OB||表示两中心点的欧式距离,T1、T2则为所设阈值。

2.2 目标识别

2.2.1SURF-BoW特征提取

SURF是一种尺度、旋转不变的检测与描述方法,具备重复性、特异性及鲁棒性优点[7]。而BoW是文本信息检索与分类领域中常用描述方法,用于图像分类领域时,将二维像素信息映射为视觉词汇向量,在保持图像局部特征的同时对图像信息进行有效压缩[8]。结合两者优势,提取SURF-BoW特征用于分类器的训练。提取方法步骤如下:

步骤1:样本图像统一尺寸为256×256,并进行预处理;

步骤2:对预处理后的样本图像进行网格稠密采样,使用的网格采样间隔是32像素;

步骤3:在每个网格区域内计算SURF特征得到一个64维的特征向量,每幅样本图像可得到一个64×64的SURF特征向量集合;

步骤4:使用K-means均值聚类算法对训练图像集上所有的SURF特征进行聚类,每个聚类中心对应一个视觉单词,从而生成一个由n个视觉单词构成的视觉单词表;

步骤5:对样本图像提取出的特征进行向量化,即用网格采样点的SURF特征与视觉单词表中的每个视觉单词所对应的SURF特征进行比较,从而找出最相近的视觉单词来表示网格采样点周围区域;

步骤6:统计每一幅目标图像中各个视觉单词出现频率,并得到一个长度为视觉单词字典大小的词频向量,从而构建每幅目标图像的SURF-BoW特征。

2.2.2SVM分类器

f(x)=wTx+b

(2)

本文样本数据为非线性,对于只能对线性数据进行分类的SVM,需引入非线性核函数将低维线性数据转化到高维特征空间,使其线性可分。本文所用核函数为高斯核函数:

(3)

通过非线性高斯核函数转换,最终分类器定义函数表示为:

(4)

此次研究选取了1 200个正样本图像和1 396个负样本用于线下SVM分类器训练。其中正样本为不同角度、畸变、亮度、模糊等各种情况下的地标图像,负样本为具体场景下的周遭干扰目标识别的物体或环境图像。

3 合作地标跟踪

为提高跟踪实时性,本文以网格采样初始化后的跟踪点代替目标,利用跟踪器进行跟踪与性能检测和筛选,以筛选后的跟踪点所在最小矩形框区域为跟踪到的目标图像。目标跟踪点初始化与跟踪如图4所示。

图4 目标跟踪点初始化与跟踪示意图

3.1 改进的金字塔L-K光流法

金字塔L-K光流法是在L-K光流法[9]基础上改进而来,通过引入金字塔降采样空间,改善原算法对目标移动过快跟踪效果差的缺陷[10]。但其面对模糊、光照变化等情况,跟踪效果仍无法满足需求。本文采用前后跟踪误差与相邻帧局部区域图像相似性约束对其进行改进,并设计目标跟踪失败再搜索算法,保证跟踪系统的准确、稳定与连续。

3.1.1前后双向跟踪误差

图5 前后跟踪误差

3.1.2相邻帧局部图像相似性约束

本文以金字塔K-L光流法为核心对跟踪点进行跟踪,相邻帧之间由于时间间隔较短,局部区域图像应相似。基于此特性,分别以t时刻跟踪点xt与t+1时刻对应点xt+1为中心,截取10px×10px大小的区域图像,进行归一化相关系数匹配,其结果越大,表明两者越相似,该跟踪点跟踪性能越好。归一化相关系数法原理式:

其中T(x,y)、I(x,y)分别为图像T、I中点(x,y)的灰度。

基于该方法与3.1.1中的前后跟踪误差设置跟踪点跟踪性能约束条件如式(5)所示,当跟踪点满足式(5),则认为其跟踪性能较好,反之,则筛除。

(5)

式(5)中,i表示第i个跟踪点,FBT、NCCT皆为设定阈值。经多次试验,当FBT=5、NCCT=0.7算法效果最佳。

为了保证跟踪目标的准确性与完整性,在基于约束条件筛除跟踪性能较差的跟踪点,得到跟踪目标之后,以上帧目标为模板与本帧目标进行归一化相关系数匹配,得到匹配结果NCCL,若NCCL≥T,则认为跟踪成功,反之,则认为跟踪失败。经多次试验,T取0.7时,算法性能最好。

3.1.3跟踪失败后目标再搜索

跟踪失败后存在两种情况:目标不再视场内;目标仍在视场内。对于第2种情况,若直接采用SVM分类器进行目标识别,会增加算法的时间复杂度。故本文设计目标再搜索方法,从而在目标跟踪失败后仍能快速找到目标。

首先,利用相邻两帧间隔时间较短、目标位移尺度变化较小的特点,以上帧目标中心为本帧搜索区域中心,搜索区域长高为上帧目标长高的3倍,确定目标再搜索区域。之后在搜索区域内重新进行目标检测得到“疑似目标”图像集。最后,以上一帧目标图像为模板,与“疑似目标”图像集中所有图像统一尺度,并进行归一化相关系数匹配。取其中相关系数最大且大于0.7的“疑似目标”图像为本帧再搜索到的目标;若均小于0.7,则利用SVM分类器精确识别目标。

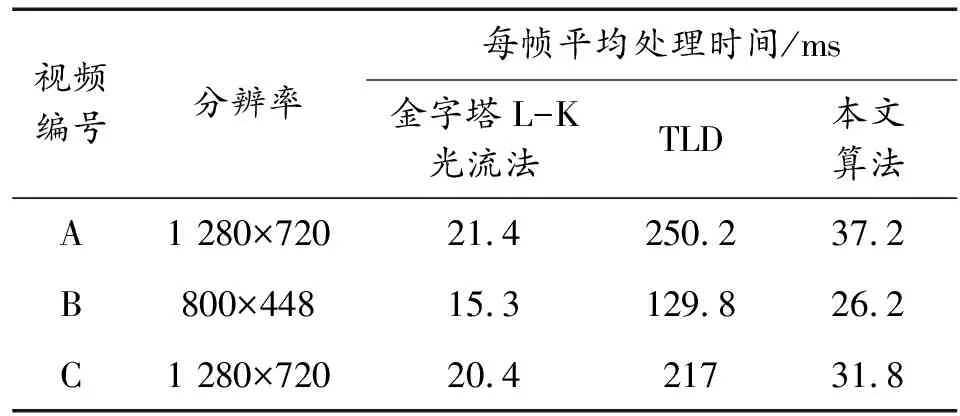

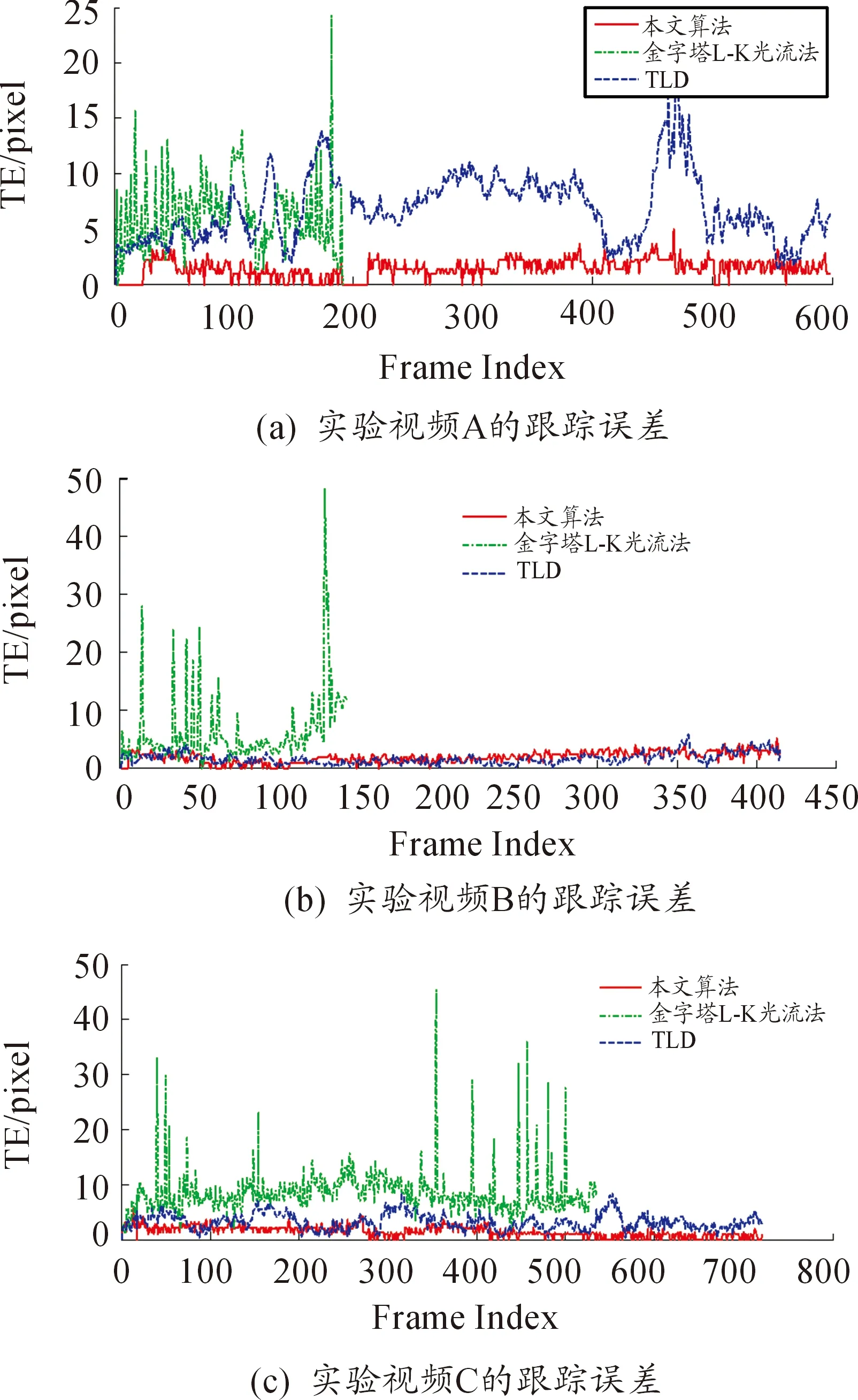

3.2 跟踪算法性能测试与结果分析

以本文跟踪算法与金字塔L-K光流法及以L-K光流法为核心的经典自学习实时跟踪算法TLD算法进行跟踪性能对比分析。测试视频有三组,并采用两种度量手段评估性能:一是每帧平均处理时间;二是跟踪误差,可用下式表示:

(Gx,Gy)与(Tx,Ty)分别为跟踪到的目标所在矩形框与真实目标所在矩形框中心坐标。

算法运行后,结果可见表1、图6与图7。经对比可得,本文跟踪算法实时性较好,可达30 fps;且其目标跟踪误差不超过5个像素,相比金字塔L-K光流法与TLD算法,目标跟踪准确性较好。而由图7可明显看出,本文所设计跟踪算法跟踪到的目标相对于TLD与金字塔L-K光流法来说,较为完整,且在光照较强、图像模糊时仍能跟踪到目标,表明本文跟踪算法稳定性、连续性较好。

表1 每帧平均处理时间

图6 跟踪误差结果曲线

图7 部分跟踪结果示意图

4 无人机相对位姿估计

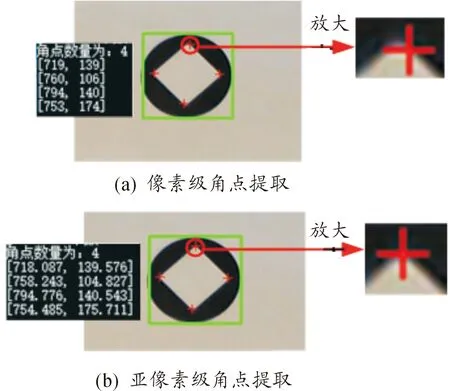

Shi-Tomasi算子作为Harris算子的改进算法,利用梯度矩阵的特征值进行强角点判定,可有效避免角点聚簇,故本文选取Shi-Tomasi算子来提取角点。但其提取到的角点为像素级角点,为提高角点检测精度,本文在利用Shi-Tomasi算子提取到角点后,对其进行亚像素级优化,以提高精度。如图8所示。

图8 角点亚像素级优化

4.1 基于透视投影理论的相对位姿估计

假设世界坐标系下某一点P(xWi,ywi,zwi)在像平面内对应点为p(ui,vi),基于透视投影成像原理,可得:

其中f、dx、dy、u0,、v0为摄像机内参,可由标定所得;Zc为点P与光心之间的距离;R、T分别为摄像机坐标系相对于世界坐标系的旋转矩阵与平移向量。T可表示为T=(tx,ty,tz)T,而R可用下式表示:

其中,摄像机坐标系绕OX轴的旋转角度为φ,绕OY轴的旋转角度为θ,绕OZ轴的的旋转角度为ψ。

给定4组共面的空间点世界坐标及其对应像点像素坐标,若摄像机参数已知,基于文献[11]中关于P4P问题求解方法可知,R、T可唯一确定。若已知目标标志中心世界坐标为(xo,yo,zo),可得摄像机在世界坐标系下的坐标为(xo+tx,yo+ty,zo+tz),相对姿态为:φ=-arcsin(r13),ψ=arcsin(r12/cosφ),θ=arcsin(r23/cosφ)。

(φ,ψ,θ)=((φl+φr)/2,(ψl+ψr)/2,(θl+θr)/2)

4.2 算法测试结果与分析

以Vega Prime、Creater视景仿真软件进行双目视景仿真,并利用仿真图像进行算法性能测试。仿真所用的双目摄像机模型如图9(a)所示,设置光心之间相距1 m,相机内参为fx=fy=618.038 672、u0=v0=256。仿真视景图像如图9(b)所示,分辨率均为512×512。图中4个特征角点世界坐标为(0, -2 828.427 12, 0),(2 828.427 12, 0, 0 ),(0, 2 828.427 12, 0),(-2 828.427 12, 0, 0),单位为mm。

图9 双目视景仿真图像

依据由近到远,即Z坐标(光轴方向上)从30~150 m,以5 m间隔选取25帧图像运行算法,结果如图10所示。

由图10可知,本文所用位姿估算方法相比于单目视觉位姿估算方法,精度有较大提升。在与目标相距30~150 m的距离内,光轴所在方向的位置估算精度在2 m以内,其他两轴的位置估计精度在120 mm以内,而姿态角的估计精度在1°以内,该精度满足固定翼无人机进近段自主着陆需求。

5 结论

提出了一种基于双目视觉的固定翼无人机自主着陆方法。通过对固定翼无人机自主着陆过程分析,基于易检测识别、易提取特征用于位姿解算等前提,设计合作地标形状并确定摆放方式。利用地标轮廓几何特征及SVM分类器,完成目标检测识别;并利用改进金字塔L-K光流法完成目标精确跟踪;提取亚像素关键角点特征,基于透视投影方法完成相对位姿估算,并利用双目均值融合以提高估算精度。本文算法实时性、稳定性好,可稳定准确的识别、跟踪目标,估算精度较高,可满足固定翼无人机自主着陆需求。