融合位置权重的基于注意力交叉注意力的长短期记忆方面情感分析模型

武婷 曹春萍

摘 要:针对传统的基于注意力机制的神经网络模型不能对方面特征和情感信息进行有效关注,以及不同距离或不同方向的上下文词对方面词的情感极性判断有不同的贡献等问题,提出一种融合位置权重的基于注意力交叉注意力的长短期记忆方面情感分析模型(LWAOA-LSTM)。首先,为词向量加入位置权重信息;然后,使用长短期记忆(LSTM)网络同时对方面和句子进行建模以生成方面表示和句子表示,同时通过注意力交叉注意力模块共同学习方面和句子的表示以获得方面到文本和文本到方面的交互关注,并自动关注句子中的重要部分;最后,在景点、餐饮、住宿不同主题数据集上进行实验,验证了该模型对方面情感分析的准确性。实验结果表明,所提模型在景点、餐饮、住宿主题数据集上的准确率分别达到78.3%、80.6%和82.1%,取得了比传统LSTM网络模型更好的效果。

关键词:深度学习;方面情感分析;位置加权词向量;注意力交叉注意力;长短期记忆网络

中图分类号: TP183; TP391.1

文献标志码:A

Aspect level sentiment classification model with location weight and long-short term memory based on attention-over-attention

WU Ting*, CAO Chunping

School of Optical-Electrical and Computer Engineering, University of Shanghai for Science and Technology, Shanghai 200082, China

Abstract:

The traditional attention-based neural network model can not effectively pay attention to aspect features and sentiment information, and context words of different distances or different directions have different contributions to the sentiment polarity assessment of aspect words. Aiming at these problems, Location Weight and Attention-Over-Attention Long-short Term Memory (LWAOA-LSTM) model was proposed. Firstly, the location weight information was added to the word vectors. Then Long-Short Term Memory (LSTM) network was used to simultaneously model aspects and sentences to generate aspect representation and sentence representation, and the aspect and sentence representations were learned simultaneously through attention-over-attention module to obtain the interactions

from the aspect to the text and from the text to the aspect, and the important part of the sentence was automatically paid attention to. Finally, the experiments were carried out on different thematic datasets of attractions, catering and accommodation, and the accuracy of the aspect level sentiment analysis by the model was verified. Experimental results show that the accuracy of the model on the datasets of attractions, catering and accommodation is 78.3%, 80.6% and 82.1% respectively, and LWAOA-LSTM has better performance than traditional LSTM network model.

Key words:

deep learning; aspect level sentiment classification; location-weighted word vector; attention-over-attention; Long-Short Term Memory (LSTM) network

0 引言

隨着互联网进入Web 2.0时代,人们越来越喜欢使用网络分享知识、经验、意见和感受等,这些评论性文本蕴含了大量的情感信息,如何从社交网络文本信息中挖掘用户的情感倾向已得到越来越多研究人员的关注。不像文档级情感分析[1],基于方面情感分析是一个更细粒度的分类任务,当一个句子中出现了多个方面时,基于方面情感分析克服了文档情感分析的一个局限性,能够针对文本中特定一方面来分析其情感极性(例如积极、消极、中立)。例如句子“这家饭店味 道不错,但服务不好”,“食物味道”方面的情感极性为积极,而“服务”方面的情感极性却是消极的。这个例子中涉及到两个方面,因为各个方面的情感极性不同,句子的整体情感判断是不准确的。如果忽略了方面信息,那么将很难获得特定方面的情感极性。这种错误普遍存在于情感分析任务中。在最近的一个研究中,Jiang等[2]手工评估了Twitter情感分类器,结果表明40%的情感分类错误都是因为没有考虑方面信息。因此,方面情感分析具有很大的研究价值。

目前,已经提出很多方法来处理基于方面情感分析问题。传统的基于规则和词典的方法,大多数依靠情感词典的建立,性能好坏与规则和人工干预密不可分[3]。基于机器学习的方法通过监督训练来构建机器学习分类器,但人工设计特征的分类器仍需要依赖复杂的人工规则和特征工程[4]。近年来,由于无需特征工程就可以从数据中学习表示,深度学习在自然语言处理任务中越来越受欢迎[5]。其中,长短期记忆(Long-Short Term Memory, LSTM)网络可以解决梯度爆炸或消失的问题,被广泛应用于方面级情感分析,如Target-Dependent LSTM(TD-LSTM)、Target-Connection LSTM(TC-LSTM)等。 同时,结合注意力机制的神经网络模型在自然语言处理任务中取得了比传统方法更好的效果,加入注意力机制不仅可以提高阅读理解力,而且能关注句子的特定方面[6-8]。但是对于中文评论尤其是长篇评论,其中会包含很多与方面情感判断无关的单词,会对方面情感分析的准确率产生影响。

近年来,方面级情感分析任务取得了很好的发展,从各种研究中可以发现研究方面情感分析的关键因素主要有三个:结合上下文后方面词的语义信息、方面词与上下文词之间的相关性和方面词在上下文中的位置信息。考虑到所有三个关键因素,可以获得更好的效果,然而,尚未有模型充分考虑上述三个因素。研究发现不同位置的单词对特定方面的情感极性判断有不同的贡献,并且关键词总是位于方面的一侧,综合考虑方面情感分析的三个关键因素,本文提出了

一种融合位置权重的基于注意力交叉注意力的长短期记忆方面情感分析模型

(Location-Weight and Attention-Over-Attention LSTM, LWAOA-LSTM)。该模型首先通过捕获位置信息为不同单词生成不同的位置权重,将此权重与词向量合并;然后,使用基于长短期记忆(LSTM)神经网络来解决方面情感分析,传统的基于LSTM的方法主要侧重于分别对方面和文本进行建模[6-7],而本文使用LSTM同時对各个方面和文本进行建模。此外,由LSTM生成的方面表示和文本表示通过注意力交叉注意力(Attention-Over-Attention, AOA)模型进行交互,AOA模型会自动产生方面到文本以及文本到方面之间的交互关注。经过研究分析发现,一个句子中只有几个词语会与方面情感分析相关,并且很多时候这些情感词汇都是与方面密切相关的。例如,“这家酒店环境不错,但价格有点贵”,根据人类阅读经验,消极词“贵”更可能描述“价格”而不是“环境”。类似地,对于方面的短语也应该关注最重要的对应的情感部分,因此本文选择AOA模型来处理方面和句子中最重要的部分。与传统基于LSTM神经网络模型相比,本文的模型能提高情感分类的准确率。

1 相关工作

1.1 情感分类

情感分类旨在检测文本的情感极性。针对这一研究问题提出了许多方法[9],大多数方法使用机器学习以监督的方式进行文本分类,例如大多使用朴素贝叶斯算法[10]以及支持向量机(Support Vector Machine, SVM)来解决此问题[11]。这些方法大多数依赖于n-gram特征或人工设计的特征,因此多种情感词典被建立[12-14]。但这些方法存在很多缺点,比如不可能存在一个词典包括所有的情感词汇,而规则制定也是需要专家大量的经验和耗费许多人力成本,并且还可能对某些特征考虑得不够全面。

近年来,神经网络的应用大大提高了情感分类的准确率与效率。基于神经网络的方法自动学习特征表示,而无需大量的特征工程。研究者提出了各种神经网络模型,Socher等[15]将递归神经网络用于情感树的构建,提高了分类的准确率;Tang等[16]采用循环神经网络建立篇章级循环神经网络模型,该模型相比标准的循环神经网络模型具有较高的优越性,在情感分类任务中取得了进步;Tai等[17]改进标准的LSTM模型,引入Tree-LSTM模型,该模型建立了树状LSTM的网络拓扑结构,在情感分类任务中有较好的表现。这些方法在情感分析上取得了令人满意的结果。

1.2 方面情感分析

方面级情感分析是情感分类的一个分支,其目标是识别句子中某个特定方面的情感极性。在过去的一些研究中,基于规则的模型被应用于解决方面情感分析[18]。Nasukawa等[19]首次提出对句子进行依赖句法分析,然后加入预先定义的规则从而判断某一方面的情感;Jiang等[2]提出目标依赖情感分析,通过基于句子的语法结构建立目标相关特征从而达到对特定目标的情感极性判断。这些与方面相关的特征与其他文本特征一起反馈到分类器(如SVM)中。

之后,多种基于神经网络的模型被应用于解决这类方面情感分析问题。典型模型是基于LSTM神经网络,如TD-LSTM[7]在模型中使用两个LSTM从而模拟特定方面的上下文,此模型使用两个LSTM最后的隐藏层预测情感。为了更好捕捉句子的重要部分,Wang等[6]使用方面嵌入来生成注意力向量,以此来关注句子的不同部分。在此基础上,Ma等[20]使用两个LSTM网络分别对句子和方面建模,并进一步使用由句子生成的隐藏状态,通过池化操作来计算方面目标的注意力,能够同时关注到句子的重要部分和方面信息。这种方法与本文提出的模型相似,但是,池化操作会忽略句子与方面之间的词对交互,并且实验表明本文提出的模型性能更优。

2 方面情感分析模型

2.1 问题定义

在方面情感分析问题中,本文定义句子s={w1,w2,…,wi,…,wj,…,wn},方面目标为t={wi,wi+1,…,wi+m-1}。 其中方面标签可以是一个单词也可以是一个长短语。模型的目标是分析出句子中某一方面的情感极性。

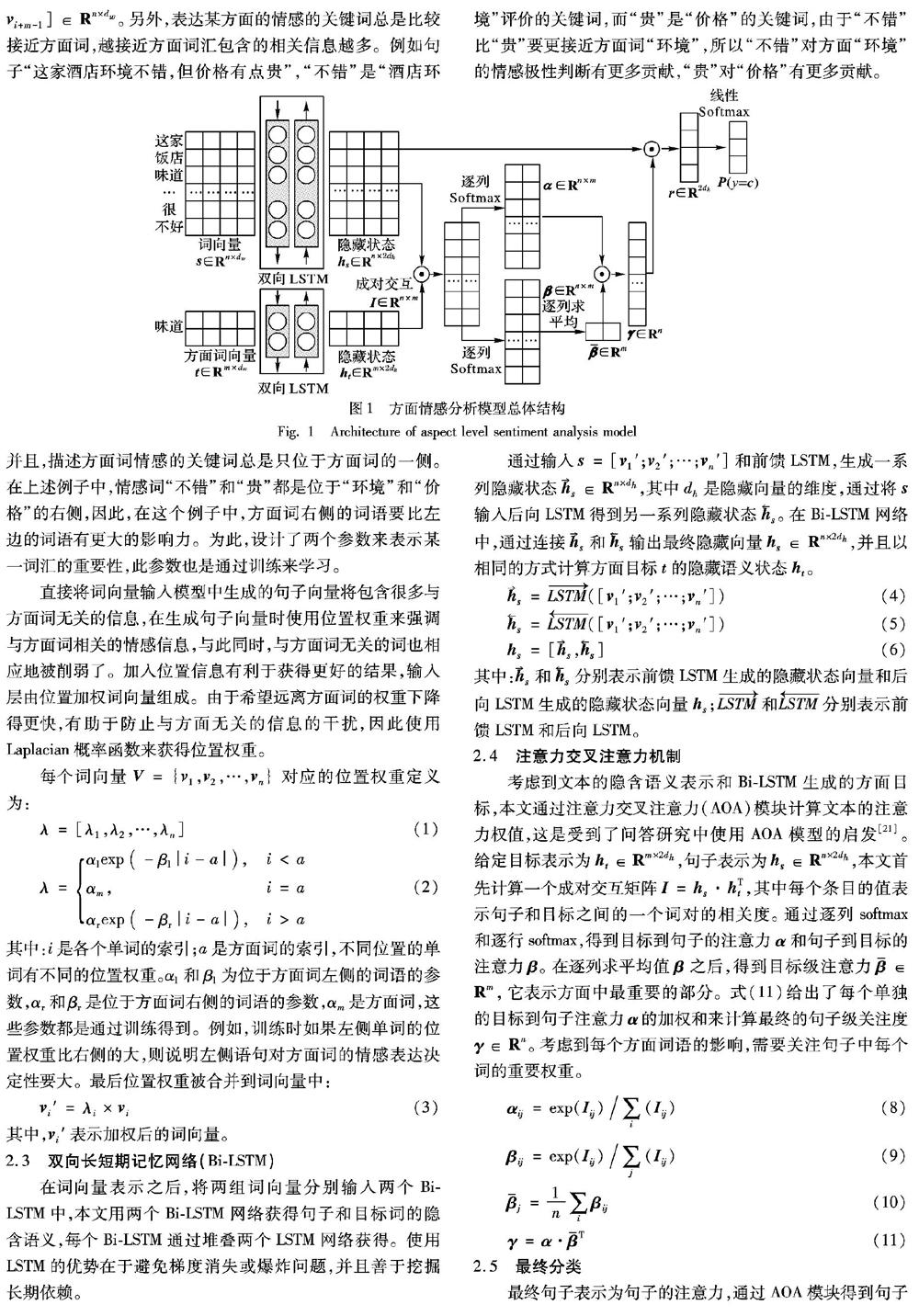

本文提出的总体结构如图1所示,主要由四部分组成:词向量、双向长短期记忆网络(Bi-directional LSTM, Bi-LSTM)、AOA模型和最终预测。

2.2 带有位置权重的词向量

长度为n的句子表示为s={w1,w2,…,wi,…, wj, …, wn},长度为m的方面词表示为t={wi,wi+1,…,wi+m-1},本文首先将每个单词映射为一个低维实值向量,称为词向量。对于每个单词wi,可以从MV×dw得到向量 v i, 其中 | V | 是词典大小,dw为向量维度。词向量处理之后得到两组词向量:句子向量[ v 1; v 2;…; v n]∈ R n×dw和方面向量[ v i; v i+1;…; v i+m-1]∈ R n×dw。 另外,表达某方面的情感的关键词总是比较接近方面词,越接近方面词汇包含的相关信息越多。例如句子“这家酒店环境不错,但价格有点贵”,“不错”是“酒店环境”评价的关键词,而“贵”是“价格”的关键词,由于“不错”比“贵”要更接近方面词“环境”,所以“不错”对方面“环境”的情感极性判断有更多贡献,“贵”对“价格”有更多贡献。

并且,描述方面词情感的关键词总是只位于方面词的一侧。在上述例子中,情感词“不错”和“贵”都是位于“环境”和“价格”的右侧,因此,在这个例子中,方面词右侧的词语要比左边的词语有更大的影响力。为此,设计了两个参数来表示某一词汇的重要性,此参数也是通过训练来学习。

直接将词向量输入模型中生成的句子向量将包含很多与方面词无关的信息,在生成句子向量时使用位置权重来强调与方面词相关的情感信息,与此同时,与方面词无关的词也相应地被削弱了。加入位置信息有利于获得更好的结果,输入层由位置加权词向量组成。由于希望远离方面词的权重下降得更快,有助于防止与方面无关的信息的干扰,因此使用Laplacian概率函数来获得位置权重。

每个词向量 V ={ v 1, v 2,…, v n} 对应的位置权重定义为:

λ=[λ1,λ2,…,λn]

(1)

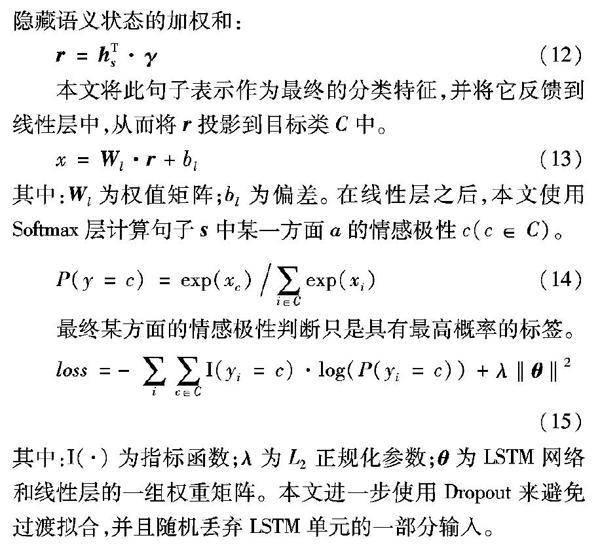

λ= αlexp ( -βl | i-a |) , i αm, i=a αrexp ( -βr | i-a |) , i>a (2) 其中:i是各个单词的索引;a是方面词的索引,不同位置的单词有不同的位置权重。αl和βl为位于方面词左侧的词语的参数,αr和βr是位于方面词右侧的词语的参数,αm是方面词,这些参数都是通过训练得到。例如,训练时如果左侧单词的位置权重比右侧的大,则说明左侧语句对方面词的情感表达决定性要大。最后位置权重被合并到词向量中: v i′=λi× v i (3) 其中, v i′表示加权后的词向量。 2.3 双向长短期记忆网络(Bi-LSTM) 在词向量表示之后,将两组词向量分别输入两个Bi-LSTM中,本文用两个Bi-LSTM网络获得句子和目标词的隐含语义,每个Bi-LSTM通过堆叠两个LSTM网络获得。使用LSTM的优势在于避免梯度消失或爆炸问题,并且善于挖掘长期依赖。 通过输入 s =[ v 1′; v 2′;…; v n′]和前馈LSTM,生成一系列隐藏状态 s ∈ R n×dh,其中dh是隐藏向量的维度,通过将 s 输入后向LSTM得到另一系列隐藏状态 s 。在Bi-LSTM网络中,通过连接 s 和 s 输出最终隐藏向量 h s ∈ R n×2dh,并且以相同的方式计算方面目标t的隐藏语义状态 h t 。 s =LSTM ([ v 1′; v 2′;…; v n′]) (4) s =LSTM ([ v 1′; v 2′;…; v n′]) (5) h s =[ s , s ] (6) 其中: s 和 s 分別表示前馈LSTM生成的隐藏状态向量和后向LSTM生成的隐藏状态向量 h s ;LSTM 和LSTM 分别表示前馈LSTM和后向LSTM。 2.4 注意力交叉注意力机制 考虑到文本的隐含语义表示和Bi-LSTM生成的方面目标,本文通过注意力交叉注意力(AOA)模块计算文本的注意力权值,这是受到了问答研究中使用AOA模型的启发[21]。给定目标表示为 h t ∈ R m×2dh,句子表示为 h s ∈ R n×2dh,本文首先计算一个成对交互矩阵 I = h s · h T t ,其中每个条目的值表示句子和目标之间的一个词对的相关度。通过逐列softmax和逐行softmax,得到目标到句子的注意力 α 和句子到目标的注意力 β 。 在逐列求平均值 β 之后,得到目标级注意力 ∈ R m,它表示方面中最重要的部分。式(11)给出了每个单独的目标到句子注意力 α 的加权和来计算最终的句子级关注度 γ ∈ R n。 考虑到每个方面词语的影响,需要关注句子中每个词的重要权重。 α ij=exp( I ij) / ∑ i ( I ij) (8) β ij=exp( I ij) / ∑ j ( I ij) (9) j= 1 n ∑ i β ij (10) γ = α · T (11) 2.5 最终分类 最终句子表示为句子的注意力,通过AOA模块得到句子隐藏语义状态的加权和: r = h T s · γ (12) 本文将此句子表示作为最终的分类特征,并将它反馈到线性层中,从而将 r 投影到目标类C中。 x= W l· r +bl (13) 其中: W l为权值矩阵;bl为偏差。在线性层之后,本文使用Softmax层计算句子 s 中某一方面a的情感极性c(c∈C)。 P(y=c)=exp(xc) / ∑ i∈C exp(xi) (14) 最终某方面的情感极性判断只是具有最高概率的标签。 loss=-∑ i ∑ c∈C I(yi=c)·log(P(yi=c))+λ‖ θ ‖2 (15) 其中:I(·)为指标函数;λ为L2正规化参数; θ 为LSTM网络和线性层的一组权重矩阵。本文进一步使用Dropout来避免过渡拟合,并且随机丢弃LSTM单元的一部分输入。 本文使用Adam[22]更新规则和小批量随机梯度下降,最后最小化模型中关于权矩阵和偏差项的损失函数。 3 实验及结果分析 3.1 数据集 本文通过网络爬虫软件在蚂蜂窝采集了关于上海的游记2000篇,然后经过多主题评论性长文本过滤模型后得到有关景点、住宿、餐饮的句子集。每条句子都包含一系列的评价方面以及和该方面相关的情感极性,其中景点主要包括{地文,水域风光,生物景观,气象景观,遗迹遗址,建筑,人文,门票价格}八个方面,住宿主要包括{价格,环境,服务}三个方面,餐饮主要包括{食物味道,服务,价格,环境}四个方面。本文实验数据统计如表1所示。 3.2 参数设置 在实验中,本文首先随机选择20%的训练数据作为验证集来调整超参数。所有权重矩阵从均匀分布U(-10-4,10-4)随机初始化,并且所有偏差项都设置为0。L2正则化系数设置为10-4,丢失保持率为0.2。词向量使用300维GloVe[23]词向量进行初始化,并在训练期间固定。 对于单词表外的词汇,从均匀分布U(-0.01,0.01)中随机初始化。LSTM隐藏层的维度设置为150,Adam优化器的初始学习率为0.01。如果训练损失在每三个时期之后没有下降,则将学习率降低一半,批量大小设置为25。 3.3 对比实验 本文分别对景点、住宿、饭店三个主题下的文本进行方面级情感分析训练和评估模型,使用准确度指标来衡量绩效。为了进一步验证模型的性能,将本文方法与以下几种方法进行对比: 1)SVM:是一种基本的机器学习的方法,它将训练集中最大的情感极性分配给测试集中的每一个样本。 2)LSTM:使用标准LSTM网络模型对句子建模,最后隐藏层用作最终分类的句子表示。 3) TD-LSTM。 文献[7]提出的TD-LSTM网络模型:它使用两个LSTM网络来模拟围绕方面术语的前后环境,这两个LSTM网络的最后隐藏层被连接起来以预测情感极性。 4) AT-LSTM。 文献[6]提出的基于注意力机制的LSTM网络模型AT-LSTM:它首先通过LSTM模型对句子进行建模,然后将LSTM网络生成的隐藏向量与方面词向量相结合生成注意力向量,最终的句子表示是隐藏层的加权和。 5) ATAE-LSTM: 文献[6]在第二部分进一步扩展AT-LSTM得到的ATAE-LSTM网络模型:它将方面词向量附加到每一个词向量中。 6) IAN。 文献[20]提出的结合交互式注意力机制的LSTM网络模型IAN:它使用两个LSTM分别对句子和方面术语进行建模,使用句子中的隐藏状态为目标生成注意力向量,最后基于这两个注意力向量输出一个句子表示和一个目标表示用于分类。 3.4 结果分析 3.4.1 不同模型对比实验结果分析 本文采用准确率来评估方面情感分析模型的效果,各个模型的准确率如表2所示。 从表2可以看出,本文提出的LWAOA-LSTM模型在3个不同的主题下都取得了不错的效果,其中在餐饮主题下进行方面情感分析效果最好,准确率达到82.1%,比IAN模型提高了4.45%,比ATAE-LSTM模型提升了6.35%,验证了本文提出方法的有效性。 没有加入注意力机制的LSTM模型和TD-LSTM模型的分類效果并不理想,在景点主题下的方面情感分析的准确率分别达到68.5%和69.7%,而加入注意力机制的AT-LSTM模型和ATAE-LSTM准确率达到71.9%和73.8%,比TD-LSTM分别提高了3.16%和5.88%。这是因为没有加入注意力机制的神经网络模型不能关注方面的特征信息,此类模型认为同一句子的不同方面有相同的情感。加入注意力机制后可以高度关注某一方面的情感特征,准确判断同一句子不同方面的情感极性。 另外,不仅加入注意力机制而且使用两个LSTM的IAN模型以及本文提出的LWAOA-LSTM模型能够对句子和方面进行分别建模,并且考虑到句子之间的相互联系,在各个主题下进行方面情感分析都取得了很好的效果,但IAN模型中的池化操作会忽略句子与目标之间的词对交互,而本文提出的模型在景点、住宿、餐饮三个主题下的方面情感分析与IAN模型相比分别提高了3.98%、4.81%和4.45%,说明本文提出的模型在方面情感分析中有较好的效果。 3.4.2 位置加权的词向量的影响 本文在处理单词的位置信息时使用了Laplacian概率函数来为词向量添加位置权重,与不考虑位置信息的AOA-LSTM模型及加入绝对位置信息权重的基于注意力机制的LSTM(Attention-Enabled and Location-Aware LSTM,AELA-LSTM)方面情感分析模型[24]进行对比,结果如表3所示。从表3可以看出,LWAOA-LSTM在所有数据集上都优于不带有位置信息的AOA-LSTM和带有绝对位置信息权重的AELA-LSTM,从中可以得出结论:具有位置权重的模型有利于对方面词的情感极性进行分类。AELA-LSTM中虽然考虑了位置信息,但只是使用绝对位置,没有考虑到不同方向上下文词语对方面词情感分类的影响,而且线性下降位置权重不能大幅降低远离方面词的词语的权重,因此该模型的情感分类效果不佳。 4 结语 在方面情感分析任务中,传统的方法不能对方面信息和情感信息进行有效判断,并且位置信息对情感分类结果具有很大影响,因此本文提出融合上下文词的位置信息生成位置加权词向量,然后利用注意力交叉注意力模块来学习方面和句子中的重要部分,从而生成句子的最终表示来进行方面情感判断。与传统的方法相比,本文提出的模型能有效地学习方面和句子中的词对信息。通过在不同主题的数据集上的对比实验结果表明,与传统的神经网络模型相比,本文模型的准确率和稳定性都有所提高。 但本文提出的模型无法有效处理以下情况:一种是复杂的情感表达;一种是不常见的习语,尤其是对景点主题进行方面情感分析时,使用大量四字词语而导致准确率较低,因此,在未来的工作中,将探索如何改进模型来解决此类问题。 参考文献 [1] RAO G, HUANG W, FENG Z, et al. LSTM with sentence representations for document-level sentiment classification [J]. Neurocomputing, 2018, 308: 49-57. [2] JIANG L, YU M, ZHOU M, et al. Target-dependent Twitter sentiment classification [C]// Proceedings of the 49th Meeting of the Association for Computational Linguistics. Stroudsburg, PA:Association for Computational Linguistics, 2012: 151-160. [3] 刘全,梁斌,徐进,等. 一种用于基于方面情感分析的深度分层网络模型[J]. 计算机学报,2018,41(12): 2637-2652. (LIU Q, LIANG B, XU J, et al. A deep hierarchical neural network model for aspect-based sentiment analysis [J]. Chinese Journal of Computers, 2018, 41(12): 2637-2652.) [4] KIRITCHENKO S, ZHU X, CHERRY C, et al. NRC-Canada-2014: detecting aspects and sentiment in customer reviews [C]// Proceedings of the 8th International Workshop on Semantic Evaluation. Stroudsburg, PA: Association for Computational Linguistics, 2014: 437-442. [5] TANG D, QIN B, LIU T. Aspect level sentiment classification with deep memory network [C]// Proceedings of the 2016 Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: Association for Computer Linguistics, 2016: 214-224. [6] WANG Y, HUANG M, ZHAP L, et al. Attention-based LSTM for aspect-level sentiment classification [C]// Proceedings of the 2016 Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2016: 606-615. [7] TANG D, QIN B, FENG X, et al. Effective LSTMs for target-dependent sentiment classification [C]// Proceedings of the 26th International Conference on Computational Linguistics. Stroudsburg, PA: Association for Computational Linguistics and Chinese Language Processing, 2016: 3298-3307. [8] 胡朝舉, 梁宁. 基于深层注意力的LSTM的特定主题情感分析[J/OL]. 计算机应用研究, 2019, 36(4): 1075-1079. (HU C J, LIANG N. Deeper attention-based LSTM for aspect sentiment analysis [J]. Application Research of Computers, 2019, 36(4): 1075-1079.) [9] MEDHAT W, HASSAN A, KORASHY H. Sentiment analysis algorithms and applications [J]. Ain Shams Engineering Journal, 2014, 5(4): 1093-1113. [10] LIU B, BLASCH E, CHEN Y, et al. Scalable sentiment classification for big data analysis using naive Bayes classifier [C]// Proceedings of the 2013 IEEE International Conference on Big Data. Piscataway, NJ: IEEE, 2013: 99-104. [11] WANG S, MANNING C D. Baselines and bigrams: simple, good sentiment and topic classification [C]// Proceedings of the 50th Annual Meeting of the Association for Computational Linguistics: Short Papers. Stroudsburg, PA: Association for Computational Linguistics, 2012: 90-94. [12] NEVIAROUSKAYA A, PRENDINGER H, ISHIZUKA M. SentiFul: generating a reliable lexicon for sentiment analysis [C]// Proceedings of the 3rd International Conference on Affective Computing & Intelligent Interaction & Workshops. Piscataway, NJ: IEEE, 2009: 1-6. [13] QIU G, LIU B, BU J, et al. Expanding domain sentiment lexicon through double propagation [C]// Proceedings of the 2009 International Joint Conference on Artificial Intelligence. San Francisco, CA: Morgan Kaufmann Publishers Inc., 2009: 1199-1204 [14] TABOADA M, BROOKE J, TOFILOSKI M, et al. Lexicon-based methods for sentiment analysis [J]. Computational Linguistics, 2011, 37(2):267-307. [15] SOCHER R, PERELYGIN A, WU J Y, et al. Recursive deep models for semantic compositionality over a sentiment treebank [C]// Proceedings of the 2013 Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2013: 1631-1642. [16] TANG D, QIN B, LIU T. Document modeling with gated recurrent neural network for sentiment classification [C] // Proceedings of the 2015 Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2015: 1422-1432. [17] TAI K S, SOCHER R, MANNING C D. Improved semantic representations from tree-structured long short-term memory networks [C]// Proceedings of the 53rd Annual Meeting of the Association for Computational Linguistics and the 7rd International Joint Conference on Natural Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2015: 1556-1566. [18] DING X, LIU B. The utility of linguistic rules in opinion mining [C]// Proceedings of the 30th Annual International ACM SIGIR Conference on Research and Development in Information Retrieval. New York: ACM, 2007: 811-812. [19] NASUKAWA T, YI J. Sentiment analysis: Capturing favorability using natural language processing [C]// Proceedings of the 2nd International Conference on Knowledge Capture. New York: ACM, 2003: 70-77.