融合节点描述属性信息的网络表示学习算法

刘正铭 马宏 刘树新 李海涛 常圣

摘 要:为融合节点描述信息提升网络表示学习质量,针对社会网络中节点描述属性信息存在的语义信息分散和不完备性问题,提出一种融合节点描述属性的网络表示(NPA-NRL)学习算法。首先,对属性信息进行独热编码,并引入随机扰动的数据集增强策略解决属性信息不完备问题;然后,将属性编码和结构编码拼接作为深度神经网络输入,实现两方面信息的相互补充制约;最后,设计了基于网络同质性的属性相似性度量函数和基于SkipGram模型的结构相似性度量函数,通过联合训练实现融合语义信息挖掘。在GPLUS、OKLAHOMA和UNC三个真实网络数据集上的实验结果表明,和经典的DeepWalk、TADW(Text-Associated DeepWalk)、UPP-SNE(User Profile Preserving Social Network Embedding)和SNE(Social Network Embedding)算法相比,NPA-NRL算法的链路预测AUC(Area Under Curve of ROC)值平均提升2.75%,节点分类F1值平均提升7.10%。

关键词: 节点描述属性信息;信息融合;网络表示学习;深度学习;复杂网络

中图分类号:TP391.4

文献标志码:A

文章编号:1001-9081(2019)04-1012-09

Abstract: In order to enhance the network representation learning quality with node profile information, and focus on the problems of semantic information dispersion and incompleteness of node profile attribute information in social network,

a network representation learning algorithm incorporated with node profile information was proposed, namely NPA-NRL. Firstly, attribute information were encoded by one-hot encoding, and a data augmentation method of random perturbation was introduced to overcome the incompleteness of node profile attribute information. Then, attribute coding and structure coding were combined as the input of deep neural network to realize mutual complementation of the two types of information. Finally, an attribute similarity measure function based on network homogeneity and a structural similarity measure function based on SkipGram model were designed to mine fused semantic information through joint training. The experimental results on three real network datasets including GPLUS, OKLAHOMA and UNC demonstrate that, compared with the classic DeepWalk, Text-Associated DeepWalk (TADW), User Profile Preserving Social Network Embedding (UPP-SNE) and Social Network Embedding (SNE) algorithms, the proposed NPA-NRL algorithm has a 2.75% improvement in average Area Under Curve of ROC (AUC) value on link prediction task, and a 7.10% improvement in average F1 value on node classification task.

Key words: node profile attribute information; information fusion; network representation learning; deep learning; complex network

0 引言

隨着互联网技术的不断发展演化,诸如Facebook、Twitter、微信和微博等社交网络应用迅猛发展,社会网络数据逐渐呈现出规模复杂非线性和类型多样性等特点[1],给基于特征工程抽取节点特征的网络分析技术带来严峻挑战。

近年来,受表示学习方法启发,大量学者提出针对网络分析任务的网络表示学习算法,旨在利用机器学习算法实现网络节点的自动特征抽取,进而快速高效地应用于后续网络分析任务,如节点分类[2-4]和链路预测[4-6]等。

然而,大部分算法仅考虑网络结构信息进行表示学习[2-6],忽略了现实世界中网络节点包含的丰富节点描述属性信息,如性别、住址和毕业院校等。从社会心理学角度来看,节点之间的属性相似性对连边关系的形成具有重要影响[7],因而整个网络呈现出同质性的特点,即具有连边关系的节点通常具有相似的属性信息[8-9]。为验证上述观点,本文基于俄克拉何马州大学(University of Oklahoma, OKLAHOMA)和北卡罗来纳大学教堂山分校(University of North Carolina at Chapel Hill, UNC)两个真实Facebook高校网络数据集[10]进行统计分析。如图1所示,本文分析了具有连边关系的节点对中具有相同描述属性值的占比情况。从统计结果可看出,具有连边关系的节点对中具有相同描述属性信息的节点对平均占比37%,在部分描述属性信息上甚至超过90%(如图1中的节点状态标记属性)。该现象再次印证了结合节点描述属性信息进行网络表示学习的重要意义。

值得注意的是,已有一些算法考虑利用节点文本内容属性信息进行表示学习[11-13],如科学引文网络中节点的文本特征。然而,这类方法并不能有效利用社会网络中节点的描述属性信息。主要原因有以下两点:一是节点文本内容属性信息通常具有话题中心性,围绕某个中心内容而展开。如引文网络中的文章摘要、社交网络中的评论内容等。相比之下,节点描述属性信息包含多种不同类型的节点属性表示,语义信息相对分散。二是社会网络中的用户需要手动增加描述属性信息,出于用户个人保密以及平台隐私保护等原因导致采集到的用户描述属性信息存在不同程度缺失(在Facebook数据集[10]上的统计分析发现,属性信息平均缺失比例接近20%,单一属性信息缺失最高达到50%),描述属性信息的不完备性导致信息部分丢失,融合难度较大。

针对上述问题,本文提出了一种融合节点描述属性信息的网络表示(Network Representation Learning with Node Profile Attributes, NPA-NRL)学习算法。

首先,在数据编码阶段引入基于随机扰动的数据集增强策略迫使模型学习更加鲁棒的表示向量,解决属性信息不完备问题。

其次,采用将结构编码和属性编码拼接作为神经网络输入的优先融合策略,实现训练过程中两方面信息的相互补充与制约;同时,利用深度前馈神经网络的深度特征抽取能力,获得更加精准的特征表示。

最后,分别设计了基于结构相似性和属性相似性保留的优化损失函数,通过联合训练,实现两方面信息的融合表示学习,充分挖掘语义信息。通过在多个公开数据集上的链路预测和节点分类实验,验证了本文算法的有效性。

1 相关工作

DeepWalk算法[2]首次提出了随机游走思想:首先在基于网络结构的采样中得到随机游走序列,然后将其作为自然语言处理中SkipGram词向量模型[14]的输入来建模网络结构信息,最终得到节点表示向量。在此基础上,UPP-SNE(User Profile Preserving Social Network Embedding)算法[15]提出了融合节点描述属性信息进行表示学习的思路:首先通过K核映射[16]对节点描述属性信息进行非线性映射得到表示向量 f(v),然后利用DeepWalk框架将网络结构信息编码到f(v)中,实现结构和属性信息的相互约束補充。温雯等[17]提出了GeVI(Graph embedding by incorporating prior knowledge on Vertices Information)算法,通过重定义SkipGram模型中条件概率分布为已知节点属性特征向量和节点表示向量的内积,实现两方面信息的融合表示。

文献[18]将基于矩阵分解的方法概括为同一框架:1)构建节点间的关系矩阵;2)对该矩阵进行矩阵分解操作得到节点表示向量。Yang等[11]提出了TADW(Text-Associated DeepWalk)算法,证明了DeepWalk算法等价于将特定关系矩阵M∈RV*V分解为W∈Rd*V和H∈Rd*V。在此基础上,将节点文本内容属性信息矩阵T∈Rm*V嵌入到M的矩阵分解中,最终将W和T拼接得到节点的表示向量。Huang等[19]提出了AANE(Accelerated Attributed Network Embedding)算法:首先通过节点属性信息构造属性相似性矩阵,再对其进行矩阵分解得到节点的表示向量。最后,在损失函数增加了基于连接关系约束的正则项,使得连接关系紧密的节点具有相近的表示向量,实现两方面信息的融合学习。

近年来,深度学习在图像、文本和语音等领域取得较大进展,这主要得益于深度神经网络对复杂非线性关系的强大表示能力[20]。而大规模社会网络信息也具有复杂非线性的特点,因此出现了大量基于深度神经网络的表示学习算法[4,13,21-22]。SDNE(Structural Deep Network Embedding)算法[4]首次将深度自编码神经网络用于网络表示学习,将网络节点间一阶和二阶邻居关系分别作为自编码神经网络的有监督和无监督信息进行训练,有效实现了网络节点间的一、二阶相似性保留。DNGR(Deep Neural Networks for Graph Representations)算法[21]从保留网络全局信息的角度出发,提出使用随机冲浪模型生成的PPMI(Positive Pointwise Mutual Information)矩阵作为堆叠自编码神经网络的输入来进行表示学习,并从理论上分析了基于矩阵分解的方法是一种线性映射关系,难以有效挖掘网络的复杂非线性关系。SNE(Social Network Embedding)算法[22]考虑融合节点属性信息进行表示学习,将独热编码的节点ID(IDentifier)编码向量和节点属性信息编码向量作为神经网络输入,再通过多层感知机提取低维特征表示,最后以最大化原始网络节点邻居共现概率为优化目标训练得到最优的神经网络参数。

从表示学习模型上来看:上述基于网络结构或者融合节点属性的表示方法中,其核心模型可以归结为三类:词向量模型、矩阵分解模型和深度神经网络模型。词向量模型的优势在于训练过程只依赖于局部信息,便于在线处理,训练速度较快;然而由于词向量模型属于浅层模型,难以充分挖掘网络复杂非线性关系。矩阵分解模型已被证明属于线性映射过程,也不适合网络复杂非线性关系挖掘[21]。相比之下,深度神经网络作为一种有效的非线性特征提取手段,其主要优势有以下两点:一是基于参数共享的正则化策略。基于矩阵分解和随机游走的方法给每个节点独立映射为一个参数向量,而神经网络共享唯一一组参数,参数共享策略可以作为一种有效的正则化手段[23]。二是有效捕获网络复杂非线性关系。神经网络通过非线性激活函数可有效实现非线性映射。

从信息融合方式上来看:上述融合节点属性的表示方法中,除SNE算法外,均是采用先表示得到节点属性信息的表示向量,再考虑结构信息进行优化更新,这种先表示后融合的训练方式在后续实验中被验证是一种低效的融合方式,不能有效发挥节点结构信息和属性信息之间的相互补充与制约。相比之下,SNE算法提出的直接将两方面信息的原始表示拼接作为输入数据进行训练的先融合后表示的策略,能够更好实现两方面信息的融合表示。

2 结合节点描述属性信息的网络表示学习

2.1 相关定义

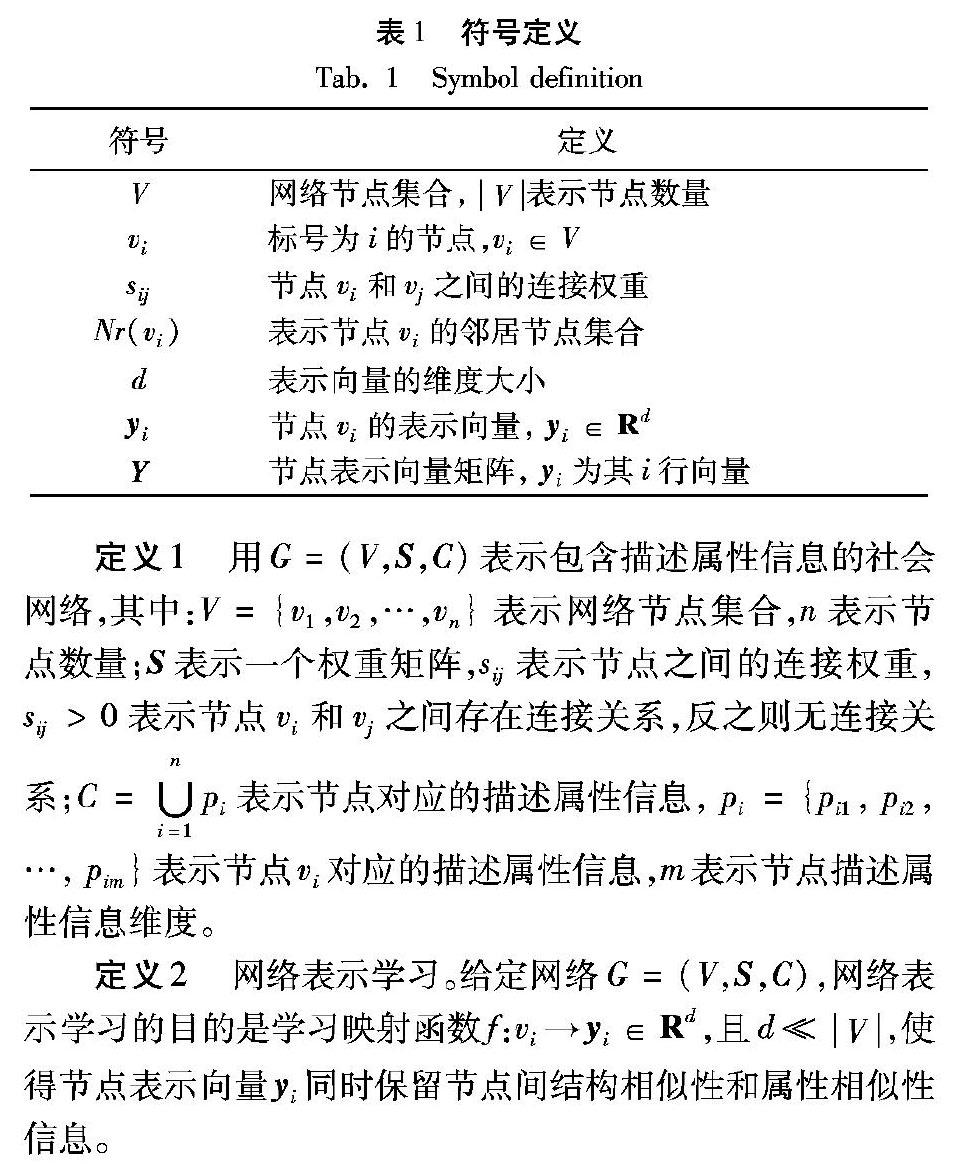

为更好地描述所提模型及其具体算法,首先给出相关定义及其主要符号表示如表1所示。

2.2 模型框架

本文的网络表示学习方法应当满足以下要求:一是能够应对节点描述属性信息存在的语义信息相对分散和不完备等问题,二是能够有效保留网络结构相似性和属性相似性信息。针对上述要求,本文提出了NPA-NRL算法,其模型框架如图2所示。下面分别从数据编码、特征提取和数据解码三个阶段详细描述。

2.2.1 数据编码

为方便进一步采用深度神经网络进行特征提取,首先分别对节点网络结构信息和描述属性信息分别进行编码表示。

结构信息编码:对于任意网络G,其邻接矩阵S编码了全部网络结构信息。因此,对于任意节点vi,将其在S中的对应列向量si作为其结构信息的编码向量,包含其所有的局部邻居结构信息。

属性信息编码:在实际网络中,节点描述属性信息通常是分类型数据,如性别只包含{男,女}两种情况。分类数据的主要特点是:数据模式较为复杂,各个属性之间无直接联系,属性值有限且没有明显的顺序和大小之分。因此,本文采用独热编码将属性分类数据编码为二值特征向量,例如,一个性别为男性的节点,该属性的表示向量为[1,0]。这样做的好处是能够保证在编码空间属性值的独立性,保证属性值的无序性。对于任意节点vi,考虑到各个属性之间的独立性,本文将各属性的表示向量拼接作为最终的节点属性信息编码向量ai。设aij为节点vi对应属性pij的编码向量,表示向量拼接,则

针对属性信息不完备问题,传统方法是利用统计学原理对缺失数据进行填补,如通过对数据集已有属性值取众数和平均值等手段赋予缺失属性一个缺省值。然而这种处理方法未有效结合网络结构信息,处理结果往往加剧了数据噪声。因此,本文设计了两个方面的措施应对该问题:一方面将结构编码和属性编码拼接作为神经网络输入,实现结构信息和属性信息的相互补充,这部分工作将在下一节中详细阐述;另一方面,受文献[24]启发,通过随机扰动策略实现数据集增强。

随机扰动策略的基本思想是:对于任意输入数据样本a,本文以概率ε对其添加随机扰动,ε为扰动概率。通过随机映射q(a)得到部分损坏的作为模型训练的输入向量。为贴合节点描述属性信息部分缺失的情况,本文将随机扰动设置为随机将部分属性置零作为输入向量。通过训练过程中数据变换,迫使神经网络挖掘更具区分性的特征表示。

2.2.2 特征提取

在得到节点结构编码向量和属性编码向量后,希望通过深度神经网络获得更加抽象的数据特征,挖掘更加准确的节点表示,应对存在的属性信息不完备问题。

一方面,在输入向量构造上,采用提前融合策略促进知识交互。如图2所示,本文直接将节点结构信息编码向量和节点描述属性信息编码向量拼接作为深度神经网络输入。这种提前融合策略在大量端到端的深度学习模型都取得了较好性能[12-22],能够有效实现两方面信息的相互补充制约。定義输入向量xi表示如下:xi=sii(2)

另一方面,在神经网络设计上,采用塔式结构的深度前馈网络提取数据的抽象特征表示。万能近似定理表明,深度前馈网络具有非常强大的数据拟合能力[25],在网络数据特征抽取中也表现出较好性能[4,22]。因此,如图2所示,将节点输入向量xi送入深度前馈网络,通过逐层减少隐藏层单元数量,获得更加抽象的节点特征表示。记隐层输出向量为y(1)i、 y(2)i、…、 y(K)i,具体定义如下:

2.2.3 数据解码

表示学习的目的在于有效保留原始网络信息,挖掘潜在特征表示,更好地服务于后续的数据挖掘任务[20]。为充分挖掘原始网络语义信息,本文算法得到的节点表示向量 y应当同时实现网络结构相似性保留和节点属性相似性保留。因此,分别设计相应的优化损失函数如下:结构相似性保留:文献[6]指出,节点邻居节点集合对于推理节点间的结构相似性关系具有重要作用。因此,类似于SkipGram词向量模型[14]中通过词向量来预测上下文词,可以将节点邻居节点看作一种“上下文”,通过最大化节点预测其邻居“上下文”节点的概率,实现网络结构相似性保留。定义结构优化损失函数Lstr如下:

属性相似性保留:网络同质性表明,具有连接关系的节点间通常具有相似的属性信息[7-9]。因此,本文提出了基于连接关系约束的属性相似性保留方法,使得具有连接关系的节点间的表示向量在表示空间距离相近,实现节点属性信息相似性保留。定义损失函数如下:

算法1在预处理阶段:一方面通过对网络边集随机采样划分训练集和验证集,训练集用于梯度计算及参数更新,验证集用于判断模型收敛情况;

另一方面,使用Xavier[26]初始化方法进行神经网络隐层参数θh初始化,作为“上下文”节点的辅助参数使用高斯分布进行初始化θc~N(0,1)。

在模型训练阶段,采用学习率自适应的Adam优化方法[27]计算参数更新,将动量并入梯度计算中,实现算法的快速收敛。

然而,片面追求最优解并非算法的最终目标,模型泛化能力才是关注重点,因此,采用提前终止策略防止模型过拟合。链路预测任务能够反映节点表示向量的网络重构能力,因此,本文中迭代停止条件设置为:验证集上的链路预测AUC指标值小于前10次的平均值。

2.4 算法时间复杂度分析

NPA-NRL算法训练过程包括数据编码和参数更新两部分,下面分别进行相应的时间复杂度分析。

在输入数据编码过程中,引入了随机噪声到数据编码中,时间复杂度为O(nd),其中:n为网络中的节点个数,d为迭代次数。该过程的复杂度与输入数据规模呈线性关系。

综上所述,由于r,nin(i),nout(i)n,NPA-NRL算法整体时间复杂度为O(n),与网络规模呈线性关系,适合大规模数据处理中的实际应用。

3 实验与结果分析

3.1 实验设定

3.1.1 实验数据集

本文在三个真实网络数据集上进行实验仿真,实验数据集统计指标如表2所示。数据集介绍如下:GPLUS(Google Plus)[28]:来自一个Google Plus用户的自中心网络,节点表示用户的“朋友”,连边表示有社交联系的用户。包含4450个节点和1473709条连边,每一个节点包含6个用户描述属性信息:性别、机构、职业、姓氏、地区、大学。本文使用性别作为类别标签。

OKLAHOMA、UNC[10]: 来自Traud等[10]以高校为单位采集的Facebook社交关系数据集中的两个。其中OKLAHOMA包含17425个节点和892528条连边,UNC包含18163个节点和766800条连边。每一个节点包含7个用户描述属性信息:学生/教师状态标记、性别、主修、辅修、住址、年级、高中。本文使用状态标记作为类别标签。

3.1.2 评价任务及其指标

本文通过现有文献中最为常见的链路预测和节点分类两个任务,来评测网络表示学习算法性能。链路预测任务用来评价节点表示的重构网络结构能力,节点分类任务用于评价节点表示能否有效应用到后续的网络分析任务。

1)链路预测。参考文献[4,22],随机选择10%网络连边作为测试集,另10%作为验证集用于超参数调节,剩余80%作为训练集。本文使用AUC指标[29]从整体上衡量算法的精确度。

在链路预测实验中,使用余弦相似性作为节点间具有连边的得分值。AUC可以理解为在测试集中边的得分值比随机选择一条不存在的边的分数值高的概率。独立比较n次,记测试集中边的分数值大于不存在的边的分数值的比较次数为n′,分数值相等的比较次数为n",则AUC定义为:

AUC=n′+0.5n"n(21)

2)节点分类。模型训练超参数设置与链路预测任务中参数设置保持一致。训练集中包含80%的网络连边和所有的节点描述属性信息(不包括类别标签)。然后,对于所有模型,使用LibLinear工具包[30]中的线性支持向量机(Support Vector Machine, SVM)构建分类器。为反映表示向量在所有节点上的分类性能综合评价,本文采用F1指标作为衡量表示向量在所有节点上的分类性能的综合评价指标。

3.1.3 对比算法及其参数设置

实验对比算法如下:DeepWalk[2]:基于截断随机游走和SkipGram模型获得节点表示向量。该算法仅利用了网络结构信息,作为其他融合算法的参考。

TADW[11]:基于矩阵分解形式的融合算法,结合节点属性信息矩阵进行联合矩阵分解,获得节点的融合表示向量。该算法作为基于矩阵分解的融合对比算法。

UPP-SNE[15]:在DeepWalk算法基础上,改进SkipGram模型,通过向量内积实现两方面信息的知识交互。该算法作为基于随机游走的融合对比算法。

SNE[22]:基于深度神经网络的融合算法,利用深度神经网络的非线性特征提取能力,挖掘节点间的复杂非线性关系,实现节点融合表示向量特征提取。该算法作为基于深度神经网络的融合对比算法。

NPA-NRL:本文提出的一种基于深度神经网络的融合算法。通过在训练过程引入基于网络同质性原理的属性相似性度量函数以及基于随机扰动的数据集增强策略,有效应对节点描述属性信息存在的语义信息分散和属性不完备问题。NPA-NRL(-)是该算法的退化算法,在训练过程中未加入随机扰动,作为对比算法验证增加属性相似性度量函数和数据集增强策略发挥的不同作用。

本文中对比算法的实验参数参考相应文献的推荐设置:所有算法的表示向量维度统一设置为128维,与文献[15]保持一致。除表示向量维度外,基于矩阵分解的SVD算法和UPP-SNE算法无其他参数。基于随机游走的DeepWalk算法和UPP-SNE算法按照文献[15]中提供参数进行设置,每个节点的随机游走次数r=40,随机游走长度l=40,窗口大小t=10,迭代次数d=40。基于深度神经网络的SNE算法按照[22]中提供的最优参数进行设置,对于新增数据集GPLUS,批量训练大小参数为bs=64,初始学习率为η=0.0001,输入属性串接权重λ=0.8。本文NPA-NRL算法的参数设置参考文献[22]思路,通过比较给定参数空间内验证集上的链路预测性能,得到最优参数设定如表3所示。

3.2 结果分析

3.2.1 链路预测实验分析

表4记录了NPA-NRL算法和其他对比算法在三个实验数据集上的链路预测AUC值。从实验结果可看出,相对于其他对比算法,本文算法性能提高了0.83%~6.30%,平均提升2.75%。融合算法(TADW、UPP-SNE、SNE和NPA-NRL)和仅考虑网络结构信息的DeepWalk算法相比,平均提高3.14%,这也验证了融合网络节点属性信息进行表示学习的重要意义。

3.2.2 节点分类实验分析

下面通过节点分类实验,进一步分析网络节点表示应用到后续网络分析任务中性能表现。通过设置不同比例的有标签数据训练分类器,评估各算法得到的表示向量的节点分类性能。每个训练率下,重复50次实验,记节点分类的平均F1值如表5~7所示(括号内为标准差),下面进行具体分析:首先,和链路预测结果一样,仅利用网络结构信息的DeepWalk算法性能最低,这再次验证节点属性信息对于更加精确的节点表示的重要作用。其次,本文算法与同样考虑两方面信息的TADW算法及UPP-SNE算法相比仍然具有优势。在训练数据较少的情况下,TADW算法在OKLAHOMA和UNC两个数据集上的节点分类性能甚至低于DeepWalk算法。这是因为TADW算法是基于线性映射的方式得到节点表示向量,难以有效应对节点描述属性信息中数据不完备问题。相比之下,UPP-SNE算法利用SkipGram模型有效實现两方面信息的融合,节点分类性能进一步提高。然而SkipGram模型这种浅层模型难以有效挖掘节点网络结构信息和描述属性信息之间的复杂非线性关系,因此性能并非最优。

最后,和同样采用深度神经网络进行融合表示学习的SNE算法相比,本文算法利用节点描述属性信息的能力上效果更显著:一方面,由于在训练过程中考虑基于连接关系约束的属性相似性保留优化损失函数,NPA-NRL(-)算法更加充分利用了节点属性同质性信息,在三个数据集上的节点分类性能平均提高2.28%;另一方面,通过在训练过程中引入对输入数据的随机扰动,使得NPA-NRL算法能够在节点属性信息不完备的情况下,获得具有鲁棒性的表示向量。

在训练率仅为2%的情况下,本文NPA-NRL算法和SNE算法相比,节点分类性能分别提高了6.05%(GPLUS)、6.13%(OKLAHOMA)和4.12%(UNC),表明NPA-NRL算法所得表示向量具有较强区分性。和对比算法相比,NPA-NRL算法在三个数据集上的节点分类性能平均提升7.10%。

3.3 参数敏感性分析

本节进一步分析超参数对NPA-NRL算法性能影响。如图3所示,测试了算法在不同参数选择下的节点分类性能指标F1值的变化趋势。在实验过程中,除测试参数外,其余参数设定为默认值,分类器训练数据比例设置为10%。

首先,从如图3(a)的对比实验中发现,随着表示向量维度增加,节点分类性能逐步提升,当表示向量增加到一定程度后,算法性能有轻微的增长且趋于稳定。同时发现:在OKLAHOMA和UNC两个相对稀疏的网络中,节点分类性能随着表示向量维度增加,节点分类性能提升较快。这是因为在稀疏网络中,节点结构特征相对分散,需要更多的维度来表示节点间的相似性和差异性。因此, 本文算法仿真中设置默认值为128,在保证较优性能的同时使用较少的特征维度。

其次,通过调整λ取值,进一步研究属性权重大小对节点分类性能的影响。当λ较小时,随着λ增加,节点分类性能逐渐提升。如图3(b)所示,当λ在0.3附近时在三个数据集中均取得较优性能。当λ较大时,節点分类性能逐渐下降,这是因为较大的λ使得所有节点表示向量趋于相同,减弱了节点间结构特征信息对表示向量的影响,导致分类性能下降。因此, 本文算法仿真中设置默认值为0.3。

最后,图3(c)给出了节点分类F1值随随机扰动概率的变化趋势。随着随机扰动概率增加,节点分类性能逐渐提升。当ε超过一定值时,节点分类性能逐渐下降,说明过量随机噪声引入导致节点属性的关键信息丢失。因此, 本文算法仿真中设置默认值为0.5。

4 结语

本文针对融合节点描述属性进行表示学习过程中面临的节点描述属性信息语义信息分散和信息不完备问题,分别提出了两项优化策略:一是设计了基于网络同质性原理的节点属性相似性度量函数和基于SkipGram模型的结构相似性度量函数,通过联合训练实现融合语义信息挖掘。二是设计了基于随机扰动的数据集增强策略,结合优先融合策略,有效实现网络结构信息和描述属性信息的相互补充制约,在属性信息不完备的情况下,能够获得较为鲁棒的节点表示。实验结果表明,本文算法能够有效提升节点表示向量在链路预测和节点分类任务中性能。然而,本文算法仅适用于同质信息网络的表示学习,网络同质性原理在异质信息网络中不再成立。后续将对此展开深入分析研究。

参考文献(References)

[1] 丁兆云, 贾焰, 周斌.微博数据挖掘研究综述[J]. 计算机研究与发展, 2014, 51(4): 691-706. (DING Z Y, JIA Y, ZHOU B. Survey of data mining for microblogs [J]. Journal of Computer Research and Development, 2014, 51(4): 691-706.)

[2] PEROZZI B, AL-RFOU R, SKIENA S. DeepWalk: online learning of social representations [C]// KDD 2014: Proceedings of the 20th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. New York: ACM, 2014: 701-710.

[3] TANG J, QU M, WANG M, et al. LINE: large-scale information network embedding [C]// WWW 2015: Proceedings of the 24th International Conference on World Wide Web. Geneva, Switzerland: International World Wide Web Conferences Steering Committee, 2015: 1067-1077.

[4] WANG D, CUI P, ZHU W. Structural deep network embedding [C]// KDD 2016: Proceedings of the 22nd ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. New York: ACM, 2016: 1225-1234.

[5] 李志宇, 梁循, 周小平, 等. 一种大规模网络中基于节点结构特征映射的链接预测方法[J]. 计算机学报, 2016, 39(10): 1947-1964. (LI Z Y, LIANG X, ZHOU X P, et al. A link prediction method for large-scale networks [J]. Chinese Journal of Computers, 2016, 39(10): 1947-1964.)

[6] WANG Z, CHEN C, LI W. Predictive network representation learning for link prediction [C]// SIGIR 2017: Proceedings of the 40th International ACM SIGIR Conference on Research and Development in Information Retrieval. New York: ACM, 2017: 969-972.

[7] YANG J, McAULEY J, LESKOVEC J. Community detection in networks with node attributes [C]// ICDM 2013: Proceedings of the 2013 IEEE 13th International Conference on Data Mining. Piscataway, NJ: IEEE, 2013: 1151-1156.

[8] McPHERSON M, SMITH-LOVIN L, COOK J M. Birds of a feather: homophily in social networks [J]. Annual Review of Sociology, 2001, 27(1): 415-444.

[9] AIELLO L M, BARRAT A, SCHIFANELLA R, et al. Friendship prediction and homophily in social media[J]. ACM Transactions on the Web, 2012, 6(2): 1-33.

[10] TRAUD A L, MUCHA P J, PORTER M A. Social structure of Facebook networks [J]. Physica A: Statistical Mechanics and its Applications, 2012, 391(16): 4165-4180.

[11] YANG C, LIU Z, ZHAO D, et al. Network representation learning with rich text information [C]// IJCAI 2015: Proceedings of the Twenty-Fourth International Joint Conference on Artificial Intelligence. Menlo Park, CA: AAAI Press, 2015: 2111-2117.

[12] ZHANG D, YIN J, ZHU X, et al. Homophily, structure, and content augmented network representation learning [C]// ICDM 2016: Proceedings of the 16th IEEE International Conference on Data Mining Series. Piscataway, NJ: IEEE, 2016: 609-618.

[13] LI H, WANG H, YANG Z, et al. Variation autoencoder based network representation learning for classification [C]// ACL 2017: Proceedings of the 55th Annual Meeting of the Association for Computational Linguistics. Stroudsburg, PA, USA: ACL, 2017: 56-61.

[14] MIKOLOV T, SUTSKEVER I, CHEN K, et al. Distributed representations of words and phrases and their compositionality [C]// NIPS 2013: Proceedings of the Twenty-Seventh Conference on Neural Information Processing Systems. Cambridge, MA: MIT Press, 2013: 3111-3119.

[15] ZHANG D, YIN J, ZHU X, et al. User profile preserving social network embedding [C]// IJCAI 2017: Proceedings of the 26th International Joint Conference on Artificial Intelligence. Menlo Park, CA: AAAI Press, 2017: 3378-3384.

[16] RAHIMI A, RECHT B. Random features for large-scale kernel machines [C]// NIPS 2008: Proceedings of the Twenty-Second Annual Conference on Neural Information Processing Systems. Cambridge, MA: MIT Press, 2008: 1177-1184.

[17] 溫雯, 黄家明, 蔡瑞初, 等. 一种融合节点先验信息的图表示学习方法[J]. 软件学报, 2018, 29(3): 786-798. (WEN W, HUANG J M, CAI R C, et al. Graph embedding by incorporating prior knowledge on vertex information[J]. Journal of Software, 2018, 29(3): 786-798.)

[18] YANG C, SUN M, LIU Z, et al. Fast network embedding enhancement via high order proximity approximation [C]// IJCAI 2017: Proceedings of the Twenty-Sixth International Joint Conference on Artificial Intelligence. Menlo Park, CA: AAAI Press, 2017: 19-25.

[19] HUANG X, LI J, HU X. Accelerated attributed network embedding [C]// SDM 2017: Proceedings of the 2017 SIAM International Conference on Data Mining. Philadelphia: SIAM, 2017: 633-641.

[20] LeCUN Y, BENGIO Y, HINTON G. Deep learning[J]. Nature, 2015, 521(7553): 436-444.

[21] CAO S, LU W, XU Q. Deep neural networks for learning graph representations [C]// AAAI 2016: Proceedings of the Thirtieth AAAI Conference on Artificial Intelligence. Menlo Park, CA: AAAI Press, 2016: 1145-1152.

[22] LIAO L, HE X, ZHANG H, et al. Attributed social network embedding[J]. IEEE Transactions on Knowledge and Data Engineering, 2018, 30(12): 2257-2270.

[23] HAMILTON W L, YING R, LESKOVEC J. Representation learning on graphs: methods and applications[EB/OL]. [2018-05-10]. https://arxiv.org/pdf/1709.05584.

[24] SIETSMA J, DOW R J F. Creating artificial neural networks that generalize[J]. Neural Networks, 1991, 4(1): 67-79.

[25] HORNIK K, STINCHCOMBE M, WHITE H. Multilayer feedforward networks are universal approximators[J]. Neural Networks, 1989, 2(5): 359-366.

[26] GLOROT X, BENGIO Y. Understanding the difficulty of training deep feedforward neural networks [C]// AISTATS 2010: Proceedings of the Thirteenth International Conference on Artificial Intelligence and Statistics. Cambridge, MA: MIT Press, 2010: 249-256.

[27] KINGMA D P, BA J. Adam: a method for stochastic optimization[EB/OL]. [2018-05-10]. https://arxiv.org/pdf/1412.6980.

[28] LESKOVEC J, MCAULEY J J. Learning to discover social circles in ego networks [C]// NIPS 2012: Proceedings of the Twenty-sixth Annual Conference on Neural Information Processing Systems. Cambridge, MA: MIT Press, 2012: 539-547.

[29] 呂琳媛. 复杂网络链路预测[J]. 电子科技大学学报, 2010, 39(5): 651-661. (LYU L Y. Link prediction on complex networks [J]. Journal of University of Electronic Science and Technology of China, 2010, 39(5): 651-661.)

[30] FAN R E, CHANG K W, HSIEH C J, et al. LIBLINEAR: a library for large linear classification[J]. Journal of Machine Learning Research, 2008, 9: 1871-1874.