基于广义典型相关分析融合和鲁棒概率协同表示的人脸指纹多模态识别

张 静, 刘欢喜, 丁德锐, 肖建力

(1. 上海理工大学 光电信息与计算机工程学院,上海 200093; 2. 上海交通大学 科学技术发展研究院,上海 200240)

目前,指纹、人脸等单模态生物特征识别系统已经取得了突破性的进展,但由于其自身的局限性如传感器噪声、类内变化、非普遍性(如特殊人群生物特征的缺失、损伤)和易欺骗伪造,使得它们在实际应用中仍困难重重[1]。为了解决上述单模态生物特征识别系统的缺陷,多模态生物特征识别系统被提出。该系统融合来自同一对象的多种生物特征信息,被认为具有更高的准确性和更强的安全性[2]。目前,许多科研工作者对这方面的研究产生了浓厚的兴趣。由于人脸和指纹是两种最自然、最直观的生物特征[3],为此本文研究了二者特征融合的多模态识别算法。首先回顾了多模态信息融合和稀疏表示分类器的相关知识,给出了多模态识别系统的总体框架,然后对广义典型相关分析(generalized canonical correlation analysis,GCCA)特征融合和鲁棒概率协同表示分类器分类进行了详细阐述,最后对提出的算法进行实验验证。实验结果表明,所提出的方法具有较高的准确性和较强的鲁棒性。

1 相关回顾

多模态生物特征识别的关键是不同信息之间的融合,主要包括传感器层、特征层、匹配层、决策层4种融合方式[4]。其中,特征层融合包含信息最丰富,对提高系统的识别性能最有利。然而,由于不同特征融合时存在不兼容性[5],使得多模态特征融合面临挑战。而且,多个特征向量进行融合时易出现“维数灾难”,如传统的串联[6]和并联[7]融合方法。文献[8]讨论了基于广义典型相关分析的融合方法,利用相关性分析从两组向量中抽取得到两组随机向量。抽取的向量之间具有最大相关性,而向量中的元素之间互不相关。融合这两组向量形成一个新的特征向量,既达到了信息融合的目的,又消除了不同特征之间的冗余信息。除此之外,构建一个正确适合的分类器模型对提高系统的识别性能也至关重要。

稀疏表示分类器是近年来模式识别领域中较为流行的一种方法。Wright等[9]提出了基于稀疏表示的人脸识别模型,该算法的基本思想是通过建立l1范数最小优化问题,寻求测试样本在所有训练样本上最稀疏表示系数,这样之后由每类训练样本和对应的表示系数进行样本重构,计算测试样本与每类重构样本之间的残差,从而对测试样本进行分类。文献[10]验证了稀疏表示分类的有效性,不仅提高了系统的准确性,而且对于光照变化、遮挡以及像素腐蚀有一定的鲁棒性。考虑到范数的计算复杂度问题,Zhang等[11]又进一步提出了基于范数最小优化问题的协同表示分类算法。在此基础上,研究者又提出了各种改进算法,譬如联合稀疏表示分类[12]、判别式低阶字典学习稀疏表示分类[13]等,并将这些方法成功应用于人脸识别和其他的视觉识别任务中。

基于以上分析,本文提出了基于广义典型相关分析融合和改进协同表示的人脸指纹多模态生物特征识别。

2 多模态生物特征融合

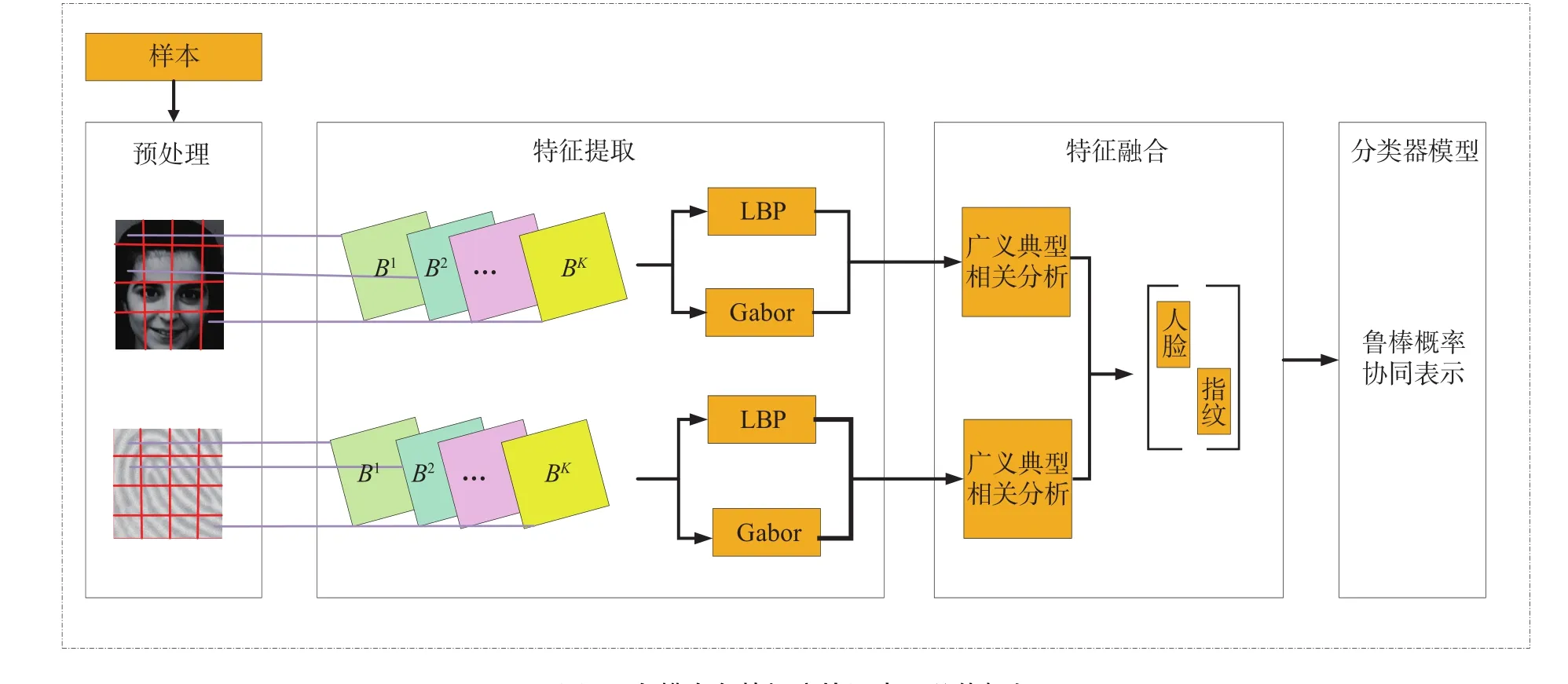

本文提出了多模态生物特征融合方法的框架,如图1所示,大致分为图像预处理、特征提取、特征融合以及鲁棒概率协同表示分类4个阶段。

2.1 图像预处理

图像预处理在自动识别过程中起着重要的作用,其主要目的是滤除噪声,消除冗余信息,提高识别系统的可靠性[14]。对于人脸图像,预处理过程包括图像增强、归一化[15];对于指纹图像,预处理过程包括归一化、滤波、感兴趣区域[16]的提取。

2.2 特征提取

特征提取阶段使用的是 LBP和Gabor特征提取算法。其中,LBP特征可以很好地描述图像的局部纹理特征,并对灰度变化和旋转变化不敏感[17];Gabor特征在频率域以及空间信息方面具有良好的特性,能够很好地描述图像的边缘信息,而且对于光照变化具有很好的适应性[18],因此提取融合这两种特征可以增强识别系统的鲁棒性。

图1 多模态鲁棒概率协同表示总体框架Fig.1 General framework of the multimodal recognition based on the robust probabilistic collaborative representation

假设人脸和指纹分别共有个样本,为样本类。首先将所有图像分为互不重叠的均匀小块,然后对第一块采用LBP算子进行特征提取得到特征向量,并以同样的方式计算其他块的特征向量,最后将所有的特征向量串联起来得到整幅图像的LBP特征向量。类似地求图像的Gabor特征。由于获取的特征向量维数太高,需要主成分分析[19]进行降维,以提取向量中主要特征的信息,经处理后的人脸和指纹的所有训练样本构成LBP特征矩阵,分别用表示,Gabor特征分别用表示,测试样本分别用

2.3 特征融合

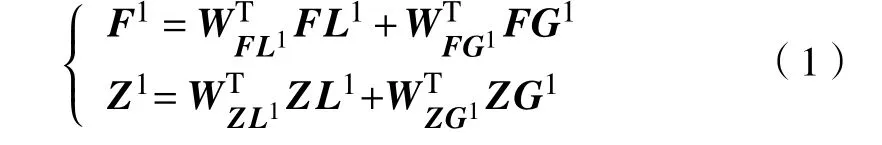

在这部分,第一阶段是基于GCCA的LBP,Gabor两特征之间的融合。该方法首先对两个特征集进行投影变换得到两个具有一定相关性的低维特征集,然后采用加法融合策略进行特征集之间的融合。这有利于消除不同特征之间的冗余信息,增加融合特征的判别性[20]。图2为基于GCCA的特征融合算法的流程图。

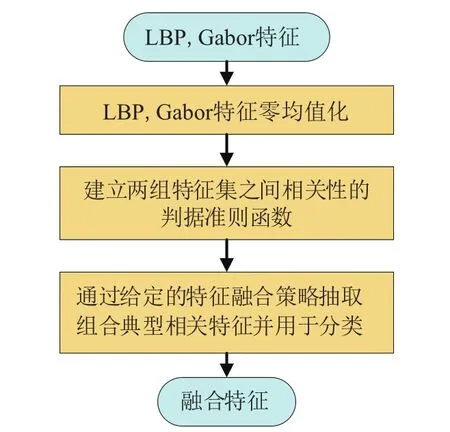

融合的人脸特征矩阵为

融合的指纹特征矩阵为

图2 基于GCCA的特征融合算法Fig.2 Feature fusion algorithm based on the generalized canonical correlation analysis

第二阶段是基于特征组合的人脸、指纹两模态之间的融合。该方法是将,作为对角元素融合到一个大的对角矩阵中,其目的是可以充分利用来自不同模态的内在结构信息。设是来自人脸和指纹测试样本的两个特征向量,则融合的人脸指纹特征表示为

式中: 是待识别样本向量; 是训练样本矩阵,其中,分别称为扩展的人脸、指纹特征矩阵。y A

3 多模态鲁棒概率协同表示

鲁棒概率协同表示是一种从概率角度进行个体识别分类的算法,由已知训练样本定义待识别测试样本属于每类样本空间的概率。随后,基于所有概率相乘建立优化函数,求解概率表示中的参数。基于求解的参数计算测试样本属于每类的概率,并将其分类到概率最大类。

3.1 鲁棒概率协同表示模型

令为中 样本组成的线性空间,则表示中第i 类样本组成的子空间,令为样本标签集。协同子空间中一数据点,表示为中所有样本线性组合的形式,即:, 其中称为表示向量或系数向量。事实上,如果的范数越小,表明样本越接近于空间的中心,从而越属于这些样本共同表示的类别;而如果的范数越大,表明样本越靠近空间的边界,从而越不属于这些类。假设定义为概率协同空间,则不同的有不同的概这儿引入了高斯函数,即然而对于一个待识别样本,它通常位于外。为了表示概率,采取的策略是首先在中找一点,然后计算概率和与属于相同

式中,为常数。式中前两项表示与中的一点具有相同类标签的概率,后一项表示与任意子空间中一点有相同类标签的概率,是在人脸、指纹的第i类子空间通过线性表示得到的数据点。

通过最大化式中的概率,可以求得一点。对于不同的i ,是不同的,这样会使分类不稳定并缺乏判别性。一个好的解决方案是联合最大化所有类的概率以得到一个公共点。假设间是相互独立的,则有

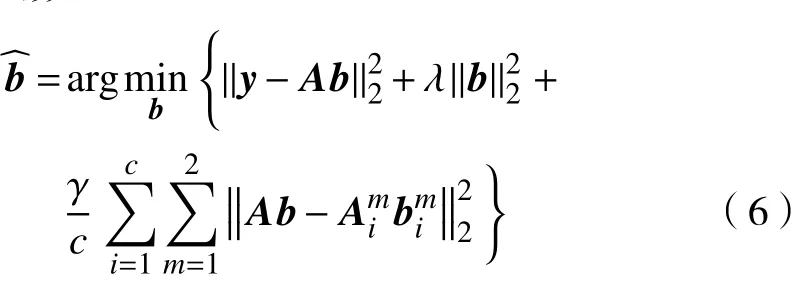

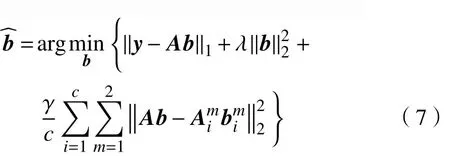

对式(5)取自然对数,去负号,等同于解下面的目标函数:

在实际分类问题中,图像样本经常会遭受部分腐蚀或遮挡,从而会降低分类器的准确性和鲁棒性。众所周知,用l1范数表征损失函数可以增加分类器的鲁棒性,函数被重新定义为

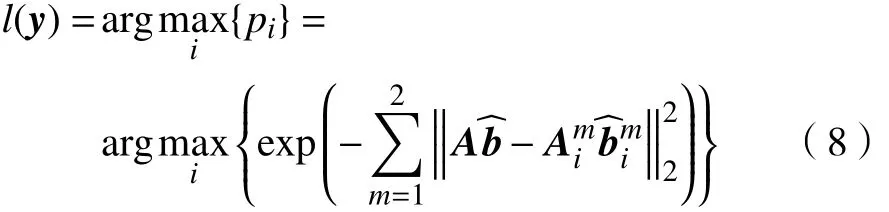

一旦求得,则待识别样本的类标签与最大概率相关联。根据式(4),很容(易计算属于每)个类的概率。对于所有类,由于是相同的,因此在计算中可以省略,有

3.2 解系数向量

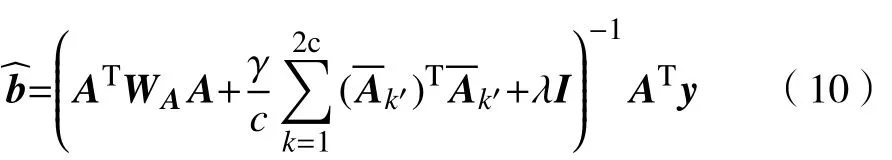

定义对角加权矩阵,其中对角元素为为的 第行 ,是的第个元素。式(7)可进一步被改写为

利用迭代加权最小二乘法(iterative reweighed least square, IRLS),可以得到系数向量的闭式解,的更新由式(10)计算得到。

式中:为单位矩阵;中的初值为式(6)的解。求解过程中,交替更新和,直到达到收敛条件或最大迭代次数为止。对于迭代的整个过程,见文献[9, 21]。整个多模态识别过程,如算法1所示。

算法1 基于鲁棒概率协同表示的多模态识别

a. 人脸、指纹图像预处理。

b. 特征提取。

4 实验结果

4.1 实验设计

为了比较单模态和多模态生物特征的识别性能,构建了包含人脸和指纹的多模态数据库。

a. 人脸单模态识别。人脸样本来自ORL和AR数据库。ORL数据库[22]由40个人的400张正面图像组成,包括光照、表情和面部细节变化,所有的图像均是灰度图像,图像大小为像素。AR数据库[23]包含4 000多张彩色图像,共126个人,每个人的多张图像分别对应不同表情、遮挡和光照条件下的人脸。

b. 指纹单模态识别。指纹样本来自FVC 2000数据库[24],该数据库包含了4个图像样本集,实验选用第一个,它是由光学传感器捕获的,图像大小为像素。

c. 人脸和指纹多模态识别。构建了ORL_FVC 2000和AR_FVC2000两个数据库,数据库ORL_FVC 2000是由ORL人脸数据库和在FVC2000中随机选择的40个人的指纹图像构成,其中每个人包含8张人脸图像和8张指纹图像。数据库AR_FVC 2000是包含80个人的1 600张图像,其中1/2来自AR数据库中的人脸图像,1/2来自FVC2000数据库中的指纹图像。

在实验中,经过预处理的图像为像素,对图像分块采用的方式,在分类器中,设置参数,。

4.2 性能比较

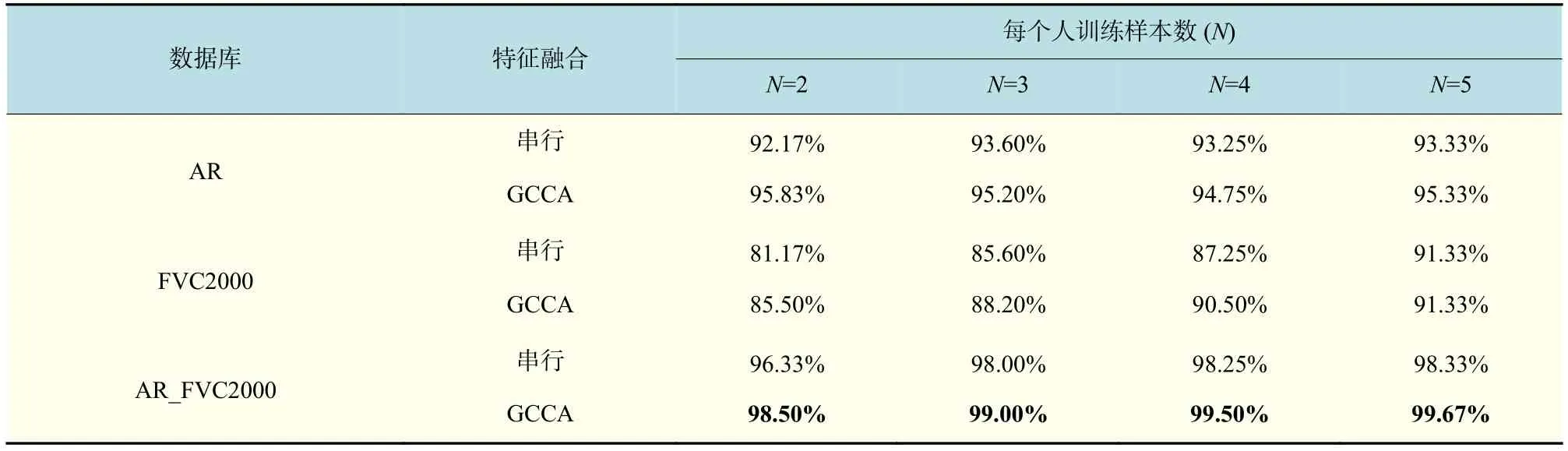

为测试多模态鲁棒概率协同表示算法的性能,一方面比较了基于ORL_FVC2000数据库的多模态和基于ORL人脸数据库、FVC2000(40%)(由FVC2000中随机选择的40个对象的样本组成)指纹数据库的单模态识别率。另一方面,也比较了基于AR_FVC2000数据库的多模态识别和基于AR人脸数据库、FVC2000指纹数据库的单模态识别率,此外还比较和分析了采用GCCA的融合方法与传统的串行融合方法的多模态鲁棒概率协同表示的准确性和鲁棒性,实验中通过改变每类训练样本的个数得到不同的识别率,实验结果如表1、表2和图3所示。

表1中,当N=5时,鲁棒概率协同表示对于单一的人脸、指纹的识别率分别是99.17%,95.83%,而对于ORL_FVC2000多模态数据库的识别是100.00%。表2中,鲁棒概率协同表示在AR人脸数据库上产生95.33%的识别率和在FVC2000指纹数据库上产生91.33%的识别率,在AR_FVC2000数据库上的识别率可以达到99.67%。图3中,可以很容易地观察到多模态数据库的测试识别率明显高于单模态。此外,表1、表2、图3的实验结果表明基于GCCA的LBP,Gabor特征融合明显优于基于串联方法的特征融合。

表1 ORL_FVC2000中的单模态和多模态的性能比较Tab.1 Performance comparisons between the methods of unimode and multimode on ORL_FVC2000 database

表2 AR_FVC2000中的单模态和多模态的性能比较Tab.2 Performance comparisons between the methods of unimode and multimode on AR_FVC2000 database

图3 基于特征融合的单模态和多模态性能比较Fig.3 Performance comparisons between the unimodal and multimodal biometrics

基于以上分析,实验结果表明:a. 多模态生物特征识别由于包含更多的信息资源,相比单模态生物特征识别识别率要高,鲁棒性要好。b. 针对两种特征融合方法,基于GCCA融合方式相比传统的融合方法对于提高识别率更有利,主要原因在于GCCA只关心两个特征之间的相关特征,不考虑两个特征之间的不相关特征。c. 提出的人脸指纹特征融合方法是成功的,融合的特征有助于分类器的识别分类。

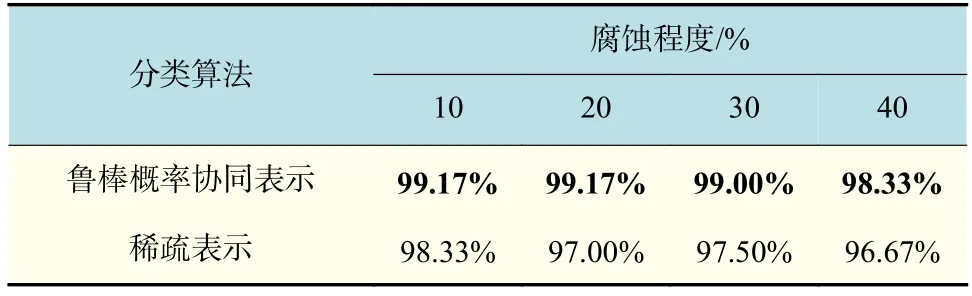

4.3 遮挡和腐蚀测试

这部分实验的主要目的是评估当人脸、指纹遮挡或是部分腐蚀的情况下鲁棒概率协同表示的识别效果。在实际的操作过程中,人脸和指纹图像不可避免地会遭受光照、腐蚀、遮挡以及其他变化的影响[25],因此,提高在此条件下的识别率是一个值得研究的课题。实验中,对合成的ORL_FVC2000和AR_FVC2000两个数据库进行像素腐蚀和块遮挡。对于像素腐蚀,用0~255的随机数替换图像像素的一部分;对于遮挡,用不相关的图像代替图像中的一块。本实验与传统的稀疏表示方法进行了比较,结果如表3和表4所示。通过本文实验发现,在图像受影响的情况下,鲁棒概率协同表示方法的多模态识别率均比传统方法的高。

表3 人脸指纹遮挡条件下的多模态识别率Tab.3 Multimodal recognition rate under the occlusion of face and fingerprint

表4 人脸指纹腐蚀条件下的多模态识别率Tab.4 Multimodal recognition rate under the random corruption of face and fingerprint

5 结 论

本文研究了一种基于特征层融合及鲁棒概率协同表示的多模态生物特征识别方法。特征融合分为两个阶段,首先是基于GCCA的人脸多特征融合、指纹多特征融合,然后将融合的人脸特征和指纹特征融入到一个统一的框架中。其中,基于GCCA的特征融合方法不仅提取了主要特征信息,而且消除了冗余特征信息。鲁棒概率协同表示是一种从概率的角度进行分类的分类器,与传统的稀疏表示器相比,提出的方法不仅提高了识别率,而且对于腐蚀、遮挡等具有一定的鲁棒性。在未来的研究中,可以从提取更具有判别性的特征(如深度特征),或是进一步提高分类模型在各种条件变化下的鲁棒性等方面改进现有的方法。

参考文献:

[1]张志坚. 多模态生物特征识别融合算法的研究[D]. 合肥:中国科学技术大学, 2008.

[2]CHEN Y R,YANG J C,WANG C,et al. Multimodal biometrics recognition based on local fusion visual features and variational Bayesian extreme learning machine[J].Expert Systems with Applications,2016,64: 93-103.

[3]王小雪, 杨会成. 融合指纹和人脸的生物特征身份认证方法[J]. 重庆理工大学学报: 自然科学版, 2013, 27(7):67-70.

[4]FAUNDEZ-ZANUY M. Data fusion in biometrics[J].IEEE Aerospace and Electronic Systems Magazine, 2005,20(1): 34-38.

[5]YANG J F, ZHANG X. Feature-level fusion of fingerprint and finger-vein for personal identification[J]. Pattern Recognition Letters, 2012, 33(5): 623-628.

[6]LIU C J, WECHSLER H. A shape- and texture-based enhanced Fisher classifier for face recognition[J]. IEEE Transactions on Image Processing, 2001, 10(4): 598-608.

[7]YANG J, YANG J Y. Generalized K-L transform based combined feature extraction[J]. Pattern Recognition, 2002,35(1): 295-297.

[8]HUANG Z X, LIU Y X, LI C, et al. A robust face and ear based multimodal biometric system using sparse representation[J]. Pattern Recognition, 2013, 46(8):2156-2168.

[9]WRIGHT J, YANG A Y, GANESH A, et al. Robust face recognition via sparse representation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2009, 31(2):210-227.

[10]DONOHO D L,TSAIG Y. Fast solution of l1 norm minimization problems when the solution may be sparse[J].IEEE Transactions on Information Theory, 2008, 54(11):4789-4812.

[11]ZHANG L, YANG M, FENG X C. Sparse representation or collaborative representation: which helps face recognition?[C]//Proceedings of 2011 IEEE International Conference on Computer Vision. Barcelona: IEEE, 2011:471-478.

[12]CHEN Y C, PATEL V M, SHEKHAR S, et al. Videobased face recognition via joint sparse representation[C]//Proceedings of the 2013 10th IEEE International Conference and Workshops on Automatic Face and Gesture Recognition. Shanghai: IEEE, 2013: 1-8.

[13]MA L, WANG C H, XIAO B H, et al. Sparse representation for face recognition based on discriminative low-rank dictionary learning[C]//Proceedings of 2012 IEEE Conference on Computer Vision and Pattern Recognition. RI:IEEE, 2012: 2586-2593.

[14]DHARAVATH K, TALUKDAR F A, LASKAR R H.Improving face recognition rate with image preprocessing[J]. Indian Journal of Science and Technology, 2014, 7(8): 1170-1175.

[15]REISFELD D, YESHURUN Y. Preprocessing of face images: Detection of features and pose normalization[J].Computer Vision and Image Understanding, 1998, 71(3):413-430.

[16]刘灵丽. 指纹图像预处理与特征提取[D]. 长沙: 湖南大学, 2005.

[17]MENG J, GAO Y, WANG X K, et al. Face recognition based on local binary patterns with threshold[C]//Proceedings of 2010 IEEE International Conference on Granular Computing. San Jose:IEEE, 2010: 352-356.

[18]YANG M, ZHANG L. Gabor feature based sparse representation for face recognition with gabor occlusion dictionary[M]//DANIILIDIS K, MARAGOS P,PARAGIOS N.Computer Vision-ECCV 2010,Heidelberg:Springer,2010: 448-461.

[19]BRO R, SMILDE A K. Principal component analysis[J].Analytical Methods, 2014, 6(9): 2812-2831.

[20]ABDI H, GUILLEMOT V, ESLAMI A, et al. Canonical correlation analysis[M]//ALHAJJ R, ROKNE J.Encyclopedia of Social Network Analysis and Mining,New York: Springer,2017: 1-16.

[21]CAI S J, ZHANG L, ZUO W M, et al. A probabilistic collaborative representation based approach for pattern classification[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition.Las Vegas:IEEE,2016: 2950-2959.

[22]GUMUS E, KILIC N, SERTBAS A, et al. Evaluation of face recognition techniques using PCA, wavelets and SVM[J]. Expert Systems with Applications, 2010, 37(9):6404-6408.

[23]SAGONAS C, ANTONAKOS E, TZIMIROPOULOS G,et al. 300 faces in-the-wild challenge: database and results[J]. Image and Vision Computing, 2016, 47: 3-18.

[24]CAPPELLI R, FERRARA M, MALTONI D. Fingerprint indexing based on minutia cylinder-code[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2011, 33(5): 1051-1057.

[25]MANDAL B. Face recognition: perspectives from the real world[C]//Proceedings of 2016 14th International Conference on Control, Automation, Robotics and Vision.Phuket: IEEE, 2016: 1-5.