面向装配机器人的零件视觉识别与定位方法

范 荻,金守峰,陈 蓉,高 磊

(西安工程大学 机电工程学院,陕西 西安 710048)

0 引 言

装配机器人[1]是柔性自动化生产系统中的核心,零件的识别与定位[2]是装配中必不可少的一步,因为装配机器人的普遍应用,精度问题受到了越来越多的关注,如果目标工件或者工作环境发生改变,机器人将无法及时适应这些变化,导致目标工件的抓取失败,在很大程度上降低了装配机器人的灵活性和生产率.随着视觉传感器及计算机视觉理论的发展,具有视觉感知的工业装配机器人成为高端制造装备的核心,是引领制造方式变革的重要手段[3-4].Connolly提出了机器视觉的先进性以及在生产装配系统中的应用方式[5-6];张建中等将视觉定位技术应用到机器人装配系统中,以便于解决机器人装配的自动定位问题[7];Golnabi等在关于如何构建基于机器视觉的系统中取得了一定的成果[8];张小洁等通过机器视觉实现了对零件图像的颜色识别[9]; Sinkar[10]等结合人工神经网络、SIFT算法和欧氏距离完成了对作业目标的识别;惠记庄等采用SURF算法提取特征点,通过BRISK 算法进行描述并计算其相似度,再利用MSAC 算法进行二次精匹配来识别作业目标工件[11].

由于装配的作业过程复杂,工业现场的光照变化、复杂的背景,装配工件的尺寸、形状多样性等因素对作业目标的识别、定位造成的干扰是工业装配机器人进一步发展的瓶颈.因此,本文给出一种基于SURF算法的作业目标识别定位方法,该方法采用SURF算法提取作业目标的特征点,通过具有旋转不变性的FREAK描述子对提取的特征点进行特征描述,采用最近邻的汉明距离得到初次匹配.针对汉明距离在粗匹配过程中由于噪声等外界影响所造成的伪匹配,采用RANSAC算法进行二次精匹配.根据最佳匹配特征点确定作业目标的质心坐标,利用系统标定关系求解出作业目标的实际位置.实现装配机器人对作业目标的快速、鲁棒性识别与定位.

1 作业目标的识别算法

1.1 特征点提取

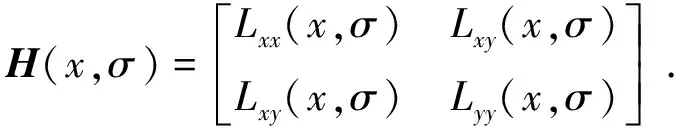

SURF算法将图像与高斯二阶微分模板的滤波转化为对积分图像的加减运算,选取图像I中的一个点(x,y),则定义该点σ尺度的Hessian矩阵为

(1)

式中:Lxx(x,σ)是高斯函数二阶偏导数与图像中像素点灰度值的二维卷积;Lxy(x,σ)与Lyy(x,σ)的意义与之相似.

将9×9设置为最小尺度空间值对图像进行滤波处理,检测σ=1.2的高斯二阶微分滤波和斑点,可将矩阵的行列式简化为

Det(Happrox)=DxxDyy=(0.9Dxy)2.

(2)

式中:Dxx,Dxy和Dyy为模板与图像进行卷积后的结果;Det(Happrox)表示点x周围区域的盒子滤波的响应值.

1.2 尺度空间的建立

SURF算法针对不同尺寸盒子滤波模板与积分图像计算Hessian矩阵行列式的响应图像,再对响应图像采用3D邻域非极大值抑制,由此构建出金字塔模型,从而获得不同尺度的斑点.比较Hessian 矩阵的特征点与该点为中心的3D尺度空间的其他26个值,再利用插值计算尺度空间及图像空间,即可得到稳定的特征点位置和尺度值.

1.3 FREAK描述特征点

对提取的特征点采用FREAK描述子进行描述,FREAK描述符是模拟人类视网膜的结构提出的一种算法,采用更接近人眼视觉系统的采样模型来接收图像信息,其描述子由采样点对的强度比较结果级联组成,形成二进制位串描述子[12].定义F为提取的某个特征点的FREAK描述符,则:

(3)

(4)

为保证FREAK描述子具有旋转不变性,需要对提取的特征点增加方向信息,采用45个距离较长且对称的采样点计算其梯度,定义特征点方向为

(5)

1.4 特征点匹配

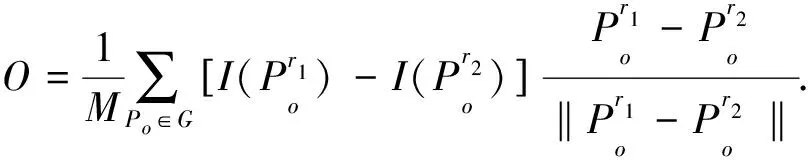

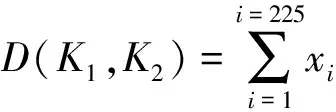

计算2个关键点之间的汉明距离,采用最近邻汉明距离进行相似性度量[13].则2个特征描述子之间的汉明距离为

(6)

K1=x0x1…x225,K2=y0y1…y225.

(7)

式中:K1,K2是2个特征点描述子;x与y的值为0或1;⨁表示异或逻辑运算.D(K1,K2)越大,说明2个特征描述子相似程度越低.

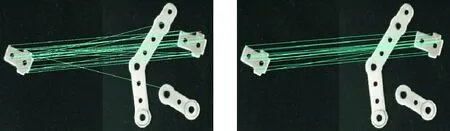

作业目标的模板如图1所示,对如图2所示的装配机器人获取的现场图进行目标识别,匹配的结果如图3所示.

图 1 模板 图 2 作业目标图 Fig.1 Template Fig.2 Job goal map

1.5 RANSAC算法的二次精匹配

由图3可知,汉明距离在粗匹配过程中因为噪声等外界干扰造成的伪匹配引起误差,降低了匹配精度.因此通过RANSAC算法进行二次精匹配,RANSAC 算法通过对样本的初始数据集构建模型,从而对全部数据进行正确的筛选,具有较强的鲁棒性,能够很好地去除误匹配,获得正确的匹配点对集.二次精匹配的结果如图4所示.

图 3 匹配结果 图 4 二次精匹配结果 Fig.3 Matching results Fig.4 Secondary fine matching results

图 5 装配机器人及各坐标系的关系Fig. 5 Relationship between the robot and the coordinate system

2 装配机器人与视觉系统标定

2.1 装配机器人

具有视觉感知的装配机器人如图5所示,装配机器人为平面关节式的四自由度SCARA机器人,负载为3 kg,驱动方式为步进、伺服电机混合驱动,执行机构为气动手抓;视觉系统为AVT-GE1050相机,分辨率为1 024×1 024,配有25mm光学镜头,光源为LED白色环形光,将相机安装在机器人手臂末端,与执行机构互不干涉;作业目标的传送装置为步进电机加谐波减速器驱动的360°旋转的工作台.系统采用PC机作为上位机控制端与相机相连,将采集的作业目标图像进行处理.下位机为开源开发板Arduino mega 2560R3,用来控制机器手臂完成对作业目标的动作.

2.2 视觉系统标定

本文采用单目手眼视觉系统,如图5所示.其中x-y-z为机器人基坐标系,xe-ye-ze为末端执行器坐标系,xc-yc-zc为相机坐标系,xw-yw-zw为标定板坐标系.各坐标系之间的相对位姿可由T4,X,Tc3个转换矩阵来表达,通过机器人控制器获取末端相对基坐标系的转换矩阵T4;通过手眼标定获取相机坐标系相对于末端坐标系的转换矩阵X;通过图像像素坐标计算标定板坐标系相对相机坐标系的转换矩阵Tc,由此作业目标的位姿为

T=T4·X·Tc.

(8)

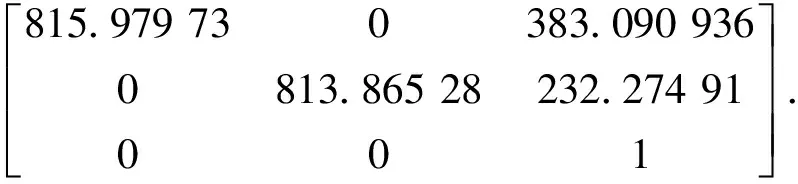

以小孔成像为相机的基本模型,采集不同方向的10×10黑白棋盘格图像作为平面标定模板,通过Matlab标定工具箱标定,得到相机的内参数矩阵为

(9)

同时得到径向畸变系数为kx=-0.044 1,ky=0.029 0.

由于相机的外部参数是对应于不同方向的标定模板在相机坐标系中的位置描述,通过手眼标定基本方程式AX=XB得到机器人视觉系统的手眼关系为

(10)

3 作业目标的定位算法

3.1 作业目标模板的质心坐标

作业目标定位是在识别基础上判定目标的准确坐标位置,一般采用目标的质心坐标来表征其位置信息[14].对如图1所示的目标模板图像进行图像预处理,采用Canny算子得到目标的边缘轮廓信息,在运用形态学算法进行背景填充与标签运算,最后得到模板图像的质心坐标,如图6所示.

(a) 图像增强 (b) 边缘检测 (c) 背景填充 (d) 目标定位图 6 模板定位Fig. 6 Template positioning

3.2 仿射模型参数计算

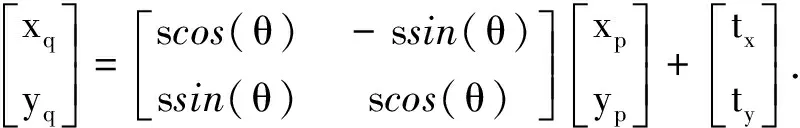

根据模板图像与目标图像之间的关系,本文采用四参数仿射模型计算仿射变换参数, 其变换矩阵为

(11)

式中:s为尺度变化参数;tx为x方向的平移量;ty为y方向的平移量;θ为旋转角度.

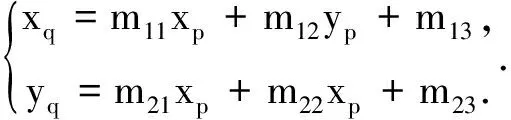

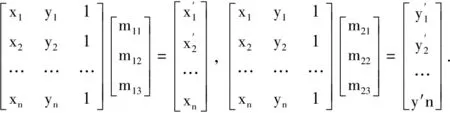

模板图像上点(xp,yp)与目标图像上点(xp,yp)之间的映射关系为

(12)

设m11=m22=scosθ,m13=tx,m12=-m21=ssinθ,m23=ty则有

(13)

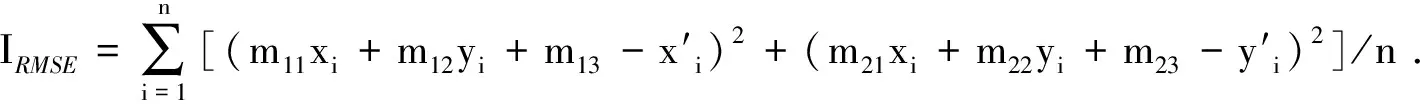

由式(15)可知,对6个位置数进行求解,[m11,m12,m13,m21,m22,m23]至少需要3对匹配点,假设模板图像与作业目标图像所提取的特征点集P和Q相对应的匹配点分别为(pi,pj)和(qa,qb),则拟合最小二乘法得到仿射变换中6个最佳参数[15].

(14)

定义的均方差IRMSE为

(15)

3.3 目标图像的质心坐标

根据得到的模板图像的质心坐标位置,结合仿射变换模型参数带入式(13)中计算目标图像中作业目标的质心坐标位置,如图7所示.

4 实验分析

另取一组如图8所示模板图像进行定位实验,结果如图9所示.在获得作业目标质心图像坐标后,根据2.2节的标定关系,代入到式(8)中计算得到作业目标质心的世界坐标,与装配机器人示教得到的实际坐标值进行比较,各坐标如表1所示.由表1可知,计算的作业目标质心的世界坐标误差控制在1.0 mm以内,消耗的时间控制在0.3 s以内.

图 7 作业目标的质心坐标 图 8 模板图像 图 9 定位结果 Fig.7 Center-of -mass coordinate of the job target Fig.8 Template image Fig. 9 Positioning results

组数质心图像坐标xy世界坐标的计算值/mmxyz世界坐标的实际值/mmxyz第一组27836387324743-2106318752-2104第二组23586604288816-2106283808-2103

5 结 论

(1) 以四自由度SCARA机器人与AVT-GE1050工业相机构建了具有视觉感知的装配机器人系统,给出了一种将SURF算法、FREAK算法、汉明距离以及仿射变换相结合的匹配识别与定位方法,解决工业复杂环境下作业目标图像的识别与定位问题,该方法在忽略几何畸变的情况下,对作业目标具有较好的识别和定位精度.

(2) 通过SURF算法提取特征点以及FREAK特征描述子,利用汉明距离度量相似性,对最近邻的汉明距离存在伪匹配特征点采用RANSAC算法进行二次精匹配,在一定程度上提高了特征点的速度和匹配精度.

(3) 通过模板图像与目标图像之间变换关系,建立四参数仿射变换模型,根据模板图像的质心坐标与仿射变换参数获得目标的质心坐标,结合机器人视觉系统的标定参数得到目标质心的位姿,定位误差不超过1.0 mm,为机器人的抓取、装配提供目标的位置信息.

参考文献(References):

[1] 黄文明,吕智.装配机器人视觉定位系统的研究[J].机电技术,2015(2):19-22.

HUANG W M,LYU Z.Research on the vision system of assembly robot[J].Electromechanical Technology,2015(2):19-22.

[2] 张嘉易,刘扬,郝永平,等.面向微装配的零件识别定位方法研究[J].制造业自动化,2015,37 (7):38-40.

ZHANG J Y,LIU Y,HAO Y P,et al.Study on the method of parts identification for micro-assembly[J].Manufacturing Automation,2015,37 (7):38-40.

[3] STIPANCIC T,JERBIC B,CURKOVIC P.A context-aware approach in realization of socially intelligent industrial robots[J].Robotics and Computer-Integrated Manufacturing,2016,37(C):79-89.

[4] 刘明周,马靖,张淼,等.基于机器视觉的机械产品装配系统在线作业方法[J].计算机集成制造系统,2015,21(9):2343-2353.

LIU M Z,MA J,ZHANG M,et al.Online operation method for assembly system of mechanical products based on machine vision[J].Computer Integrated Manufacturing System,2015,21(9):2343-2353.

[5] CONNOLLY C.Using machine vision in assembly applications[J].Assembly Automation,2003,23(3):233-239.

[6] CONNOLLY C.Machine vision advances and applications[J].Assembly Automation,2009,29(2):106-111.

[7] 张建中,何永义,李军.机器人装配视觉定位应用研究[J].机电工程,2011,28(8):934-937.

ZHANG J Z,HE Y Y,LI J.Application research of vision-location in robotic assembly equipment[J].Journal of Mechanical & Electrical Engineering,2011,28(8):934-937.

[8] GOLNABI H,ASADPOUR A.Design and application of industrial machine vision systems[J].Robotics and Computer-Integrated Manufacturing,2007,23(6):630-637.

[9] 张小洁,张文新.基于机器视觉的零件颜色识别系统[J].西安工程大学学报,2012,26(4):490-493.

ZHANG X J,ZHANG W X.Components color recognition system based on machine vision[J].Journal of Xi′an Polytechnic University,2012,26(4):490-493.

[10] SINKAR S V,DESHPANDA A M.Object recognition with plain background by using ANN and SIFT based features[C]//International Conference on Information Processing.Pune:IEEE,2016:575-580.

[11] 惠记庄,罗丽,杨永奎,等.基于SURF-BRISK的目标识别匹配与定位方法研究[J].长安大学学报(自然科学版),2016,36(3):93-101.

HUI J Z,LUO L,YANG Y K,et al.Research on location algorithm and target recognition matching based on SURF-BRISK[J].Journal of Chang′an University (Natural Science Edition),2016,36(3):93-101.

[12] 叶志坚,王福龙.基于FREAK和RANSAC算法改进的图像特征点匹配[J].广东工业大学学报,2017,34(6):37-42.

YE Z J,WANG F L.Feature points matching in images based on improved FREAK and RANSAC[J].Journal of Guangdong University of Technology,2017,34(6):37-42.

[13] 戴雪梅,郎朗,陈孟元.基于改进ORB的图像特征点匹配研究[J].电子测量与仪器学报,2016,30(02):233-240.

DAI X M,LANG L,CHEN M Y.Research on image feature point matching based on improved ORB algorithm[J].Journal of Electronic Measurement and Instruments,2016,30(2):233-240.

[14] 李鹏飞,朱鹏飞,张蕾,等.基于HALCON和VC++的双目机器人织物抓取系统设计[J].西安工程大学学报,2016,30(6):772-777.

LI P F,ZHU P F,ZHANG L,et al.Fabric garbbing robot of binocular vision system design based on HALCON and VC++mixed programming[J].Journal of Xi′an Polytechnic University,2016,30(6):772-777.

[15] 杨镠,郭宝龙,李雷达,等.基于图像几何特征点的仿射参数估计算法研究[J].计算机科学,2009,36(6):279-281.

YANG L,GUO B L,LI L D,et al.Research on evaluation of affine estimation using image feature points[J].Computer Science,2009,36(6):279-281.