基于人眼跟踪的立体内容融合显示技术研究*

黄金盆,黄开成,王元庆*,李鸣皋,周必业,曹利群

(1.南京大学电子科学与工程学院,南京 210023;2.海军总医院全军航海航空医学中心,北京 100048)

基于人眼跟踪的立体内容融合显示技术研究*

黄金盆1,黄开成1,王元庆1*,李鸣皋2,周必业2,曹利群2

(1.南京大学电子科学与工程学院,南京 210023;2.海军总医院全军航海航空医学中心,北京 100048)

传统自由立体显示器观看区域不连续制约了它的发展。当观看者头部移动时,会观看到严重“伪立体”。为解决这个问题,使用人眼跟踪技术配合图像融合程序调整图像模式,使得立体观看区域跟随人眼移动,达到连续、扩大视域的立体显示效果。基于这个方法利用OpenCV和QT构建了一个立体内容实时融合系统,实现了在立体显示器可视范围内任意位置观看立体效果,有效地解决了“伪立体”问题,并且图像模式调整的时候图像亮度变化率小于3.3%。

自由立体显示;伪立体;人眼跟踪;图像融合;图像模式

近几年立体显示技术火热发展,使得立体电视成为电视技术发展的必然趋势[1-2],在3D广告、游戏、教育、医疗等民用领域以及军用电子地图、军事仿真、航空航天等军事领域都发挥了巨大作用[3]。自由立体显示是指无须任何辅助设备便可观看到立体图像的显示方式,主要分为视差立体、体立体和全息立体。视差立体主要原理是使观看者的左右眼看到两个不同视角的图像。

一般来说,自由立体显示技术形成的相邻视点图像在空间中的分布是固定不变的。当观看者的头部移动之后,可能导致左眼看到右图像,右眼看到左图像,出现“伪立体”现象,让观看者产生眩晕、恶心等症状[4]。本文提出基于人眼跟踪[5-6]动态调整图像模式,使得立体图像出瞳跟随人眼移动的方法,该方法实现了连续、实时的立体观看效果。同时也提出一种立体图像出瞳位置与其在摄像头中像素位置对应关系的测量方法。对应关系是调整立体图像出瞳的重要依据,摄像头检测人眼位置之后,根据对应关系计算出人眼位置对应的图像模式,从而动态调整融合图像出瞳。

1 立体图像融合

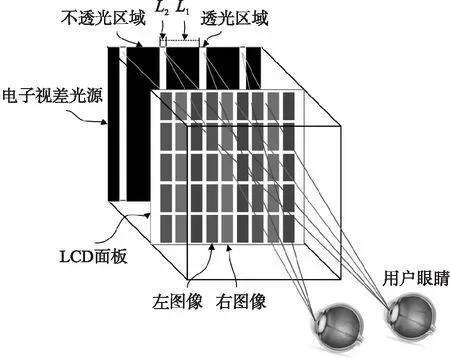

为在立体显示器上观看立体图像,需要将左右视点图像按照一定规则融合在一起,经过立体显示器,使得左右眼同时观看到不同角度的图像,从而获得立体感[7-10]。本文设计的狭缝照明式立体显示结构如图1,整体结构由电子视差光源、LCD面板组成。L1代表电子视差光源的不透光区域宽度,L2代表透光区域宽度。LCD面板显示的是融合图像,左图像像素与右图像像素按列交错排布。电子视差光源产生一系列等效的点光源,点光源光线向不同方向传播透过LCD面板,在空间中形成固定的左右图像出瞳。

图1 立体图像融合示意图

根据图1,本文提出在“伪立体”的情况下,电子视差光源的透光区域往一个方向水平平移,同时保持L1与L2的宽度比不变,这样使得左右图像出瞳也往一个方向水平平移,使得原来位置上是左图像出瞳的变成了右图像出瞳,原来是右图像出瞳变成了左图像出瞳,此时左眼看到了左图像,右眼看到了右图像,“伪立体”现象消失。

这个解决方案带来的问题是出现“伪立体”之后再平移透光区域,观看者看到的立体图由“伪立体”变成正常的立体效果,过程中会有“跳跃”现象,立体效果不连续。基于这个问题,提出跟踪人眼的移动,人眼还没到达“伪立体”区域之前移动透光区域,使得每次透光区域平移距离减小,“跳跃”现象消失。为此,设计电子视差光源中L1、L2关系如式(1):

L2∶L1=1∶5

(1)

电子视差光源的透光区域每次平移L2长的距离,这样就使得融合图像的出瞳每次平移1/6的周期。

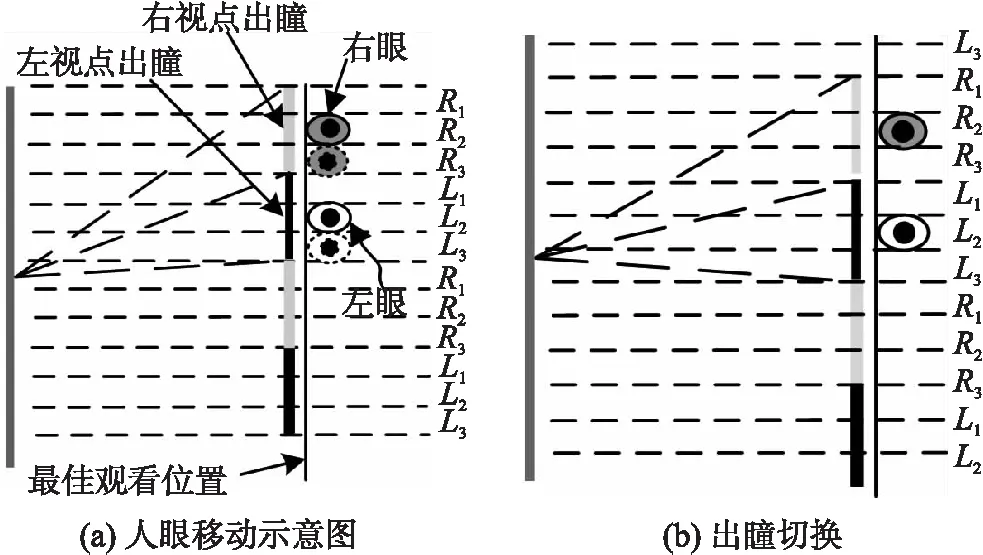

图2(a)中,灰色矩形区域代表右视点图像出瞳,等分为R1、R2、R3区域,且R2为右视点图像出瞳的中心区域;黑色矩形区域代表左视点图像出瞳,等分为L1、L2、L3,且L2为左视点图像出瞳的中心区域。黑色实线代表立体显示器的最佳观看位置。右眼在R区域,左眼在L区域,观看到正常的立体效果;右眼在L区域,左眼在R区域观看到“伪立体”效果。为防止“伪立体”效果出现,应该一直保持右眼在右图像出瞳中心区域,左眼在左视点图像出瞳中心区域。如图2(a)所示,当人眼移动到虚线位置时,人眼位置不在融合图像出瞳中心区域,此时移动电子视差光源的透光区域,使得融合图像出瞳平移1/6周期,如图2(b)所示,人眼又重新回到出瞳中心区域,观看到正常立体效果。并且由图2可知,如果想要融合图像出瞳中心覆盖任意区域,需要移动六次透光区域。我们将每次移动透光区域之后形成的融合图像出瞳称为一种“图像模式”,因此共有6种“图像模式”。

图2 出瞳切换示意图

2 对应关系测量及计算

为使人眼跟踪程序能够配合图像融合算法工作,关键技术是需要精确定位各种图像模式所对应出瞳区域在人眼检测所用摄像头中的像素位置。目前,流行的方法有使用双摄像头计算出人眼深度信息,据此利用几何关系推算出人眼移动对应亚像素的移动[11-12]。但是此方法的缺点首先是双摄像头计算出来的深度信息精度不够,无法达到实用需求;其次是需要确定一个初始位置,并找到该初始位置所对应的像素平移距离。本文提出一个人工测量方法,该方法只需使用一个摄像头就能测量最佳观看位置处图像模式的出瞳区域与其在摄像头中位置的对应关系。

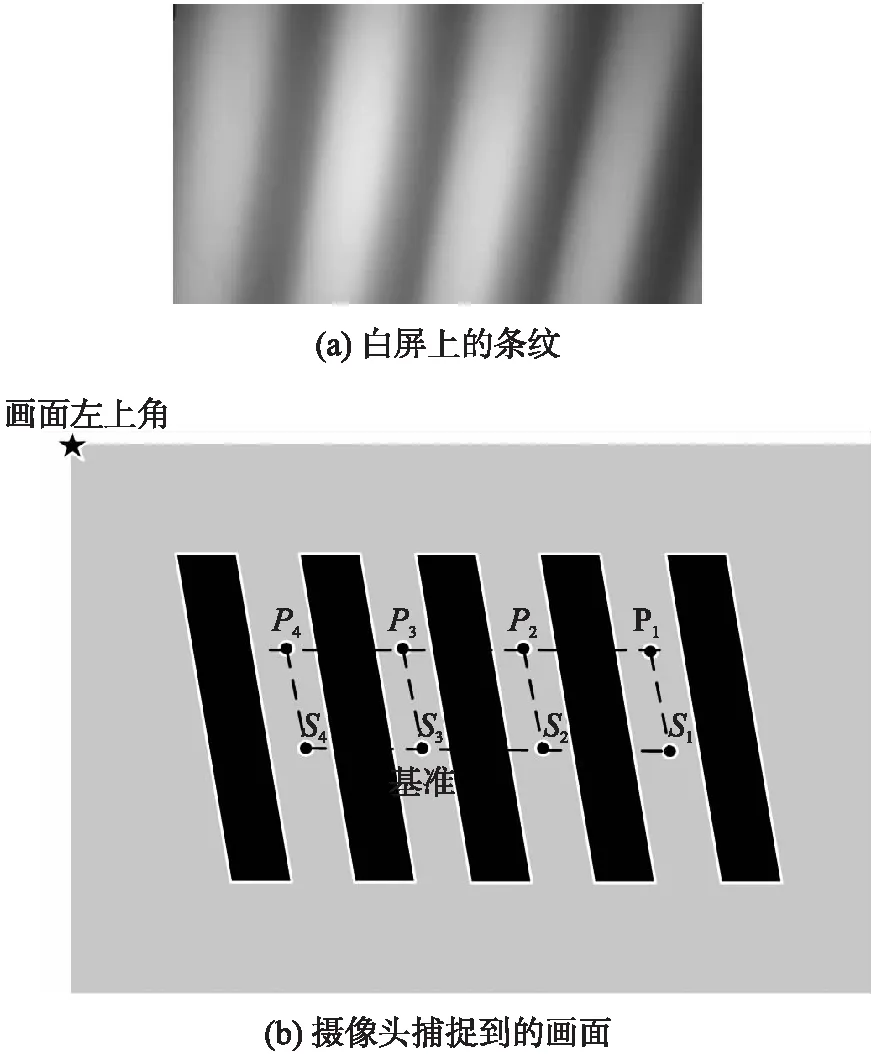

具体的测量方法如下。选择两种相邻图像模式进行测量,测试图左视点为白色,右视点为黑色。假如选取图像模式1和图像模式2来进行测量。首先播放图像模式1下的测试图,在最佳观看位置的白屏上会出现黑白相间的条纹,如图3(a)。在白屏上画两条平行线,分别标记白条纹的中心位置P1、P2、P3、P4、S1、S2、S3、S4。标记完以后,保持白屏位置不动,使用已经安装好的摄像头拍摄白屏,拍摄到的画面如图3(b)。由于经过摄像头的拍摄,从正面看过去,捕捉到画面中的条纹与实际条纹倾斜方向相反。

图3 出瞳示意图

此时,可以在图3(b)中获得P1、P2、P3、P4、S1、S2、S3、S4的像素坐标,设为P(x1,y1),P(x2,y2),P(x3,y3),P(x4,y4),S(x5,y5),S(x6,y6),S(x7,y7),S(x8,y8)。像素坐标是以图像左上角为原点,向右为x轴正方向,向下为y轴正方向。由此可以计算出该立体显示器的出瞳宽度对应的像素周期为T,见式(2):

(2)

一个周期由6种图像模式出瞳中心组成,所以每种出瞳中心所占宽度为t,见式(3):

t=T/6

(3)

设条纹的斜率为k,见式(4):

(4)

式中:dx代表x轴方向的平均像素差,dy代表y轴方向的平均像素差。

选定一个参考基准点,假设选择S3,那么以S3为中心,宽度为t的范围内是图像模式1所对应出瞳范围。

设置一个参数λ,表示沿着x轴方向,模式数是递增还是递减。播放图像模式2下的测试图,如果图像模式2的出瞳中心在图像模式1的右边则递增,设置λ=1,否则λ=-1。

综上,可以用一个向量表示对应关系X,见式(5):

X=(x,y,m,T,dx,dy,λ)

(5)

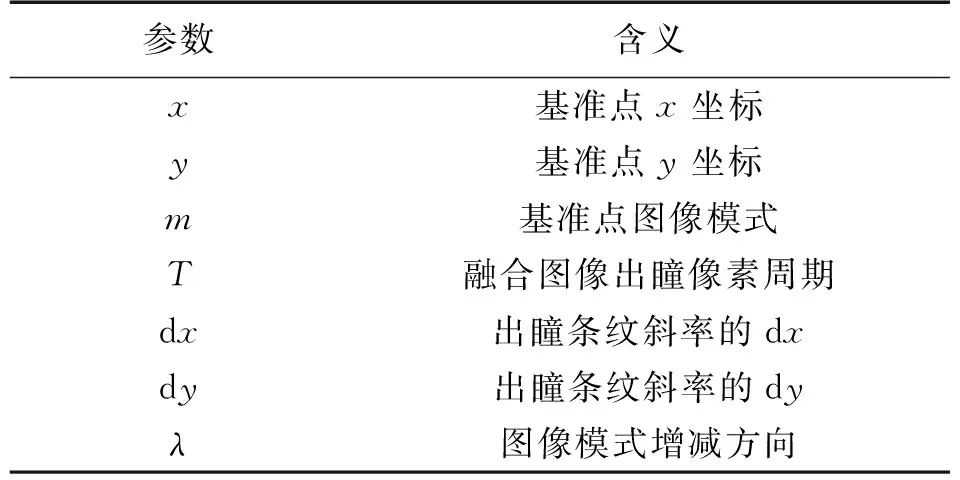

公式中各参数代表的含义如表1所示。

表1 对应关系参数含义对照表

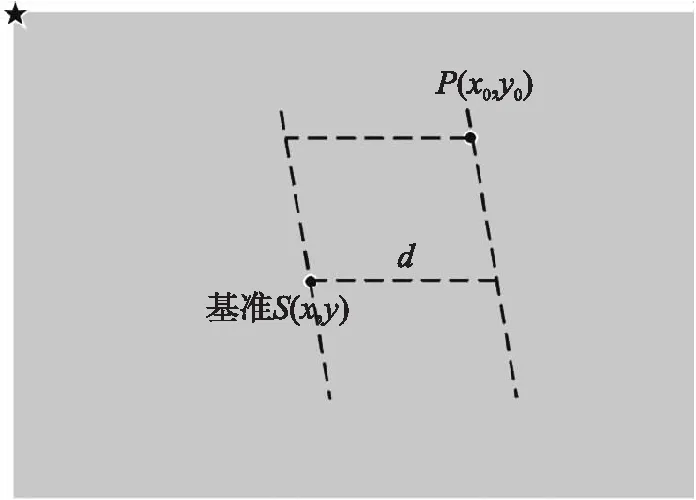

根据这个对应关系向量,可以算出摄像头画面中人眼位置所对应图像模式,如图4所示。

图4 计算图像模式示意图

设某点像素坐标为P(x0,y0),则P距离基准点的d由直线方程可知,见式(6):

(6)

由于出瞳宽度为T,且图像模式分布呈现周期性,故距离基准点d′的模式与d相同,其中d′见式(7):

d′=d%T

(7)

式中:%为求余运算。根据d′及λ可以计算出P与基准点相差的模式数dm,见式(8):

(8)

式中:⎣」为下取整,t与周期有关即t=T/6,且0≤dm≤5。则P点对应模式数为Pm,见式(9):

(9)

根据对应关系向量可以计算出摄像头中任意一点对应的图像模式,让该点落在图像模式出瞳的中心区域。

3 人眼跟踪及融合系统

3.1 人眼跟踪

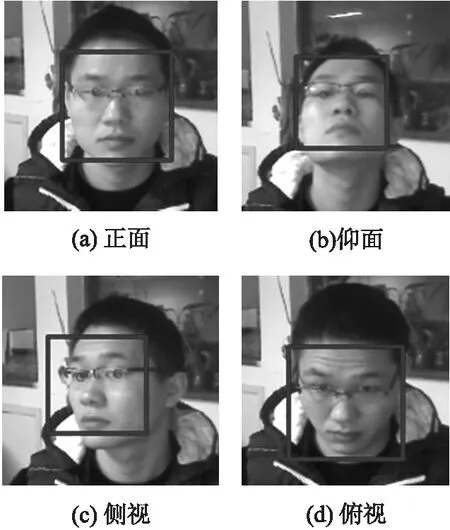

本文的人眼跟踪采用的是两层结构的方式,先检测人脸再检测人眼[13-14]。大致流程:待检图像利用肤色分割找出肤色区域;在肤色区域使用OpenCV内部datahaarcascades下的Haar人脸分类器检测人脸;使用ASM算法定位人眼位置。最终实验得出检测速度在34ms左右,帧率为29frame/s,满足实时性的要求;并且对于观看者不同的头部姿势,左右旋转、上下俯仰都有良好的鲁棒性,如图5。图5中蓝色方块表示检测到人脸区域,红色圆形表示检测到的人眼位置。

图5 不同头部姿态检测效果图

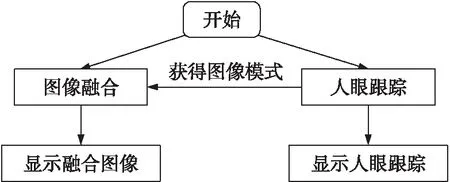

3.2 融合系统

本课题组使用了OpenCV平台配合QT开发了一套图形界面的立体图像融合播放系统,该系统输入两视点立体内容,立体内容可以是立体图片也可以是立体视频,在立体显示器上全屏显示融合图像,展现立体效果。系统流程图如图6所示。该软件系统内部包含两条线程,一条线程为人眼跟踪线程,负责跟踪人眼位置并计算图像模式,同时回显人眼跟踪结果;一条线程为图像融合线程,负责从人眼跟踪程序获得图像模式并调整电子视差光源的透光区域,同时全屏显示融合图像。

图6 融合播放系统流程图

3.3 实验结果

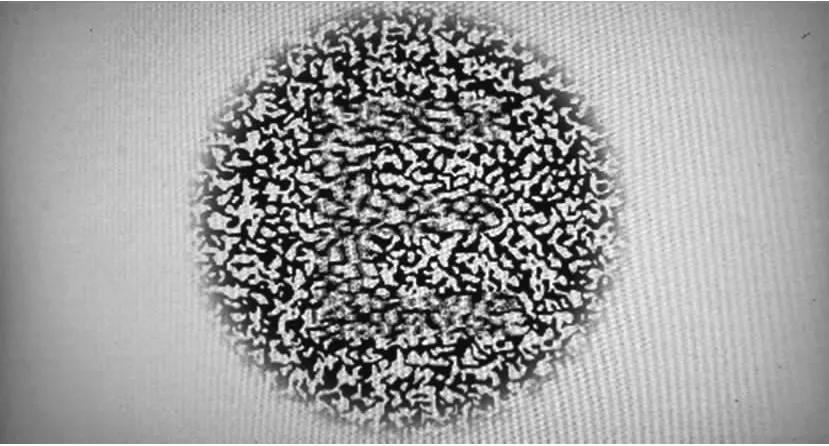

在已经加工好的立体显示器上进行实验,实验条件是基于电子视差光源式的立体显示器,主频为3.3GHz的IntelCPU,以及OpenCV、QT和VS2010的平台。在该实验中,主机运行融合播放程序,立体显示器显示立体图像及人眼跟踪结果。图7是随机点立体图片融合之后的全屏显示效果,该立体图展现的是一个“浮”出屏幕的字母E。

图7 系统融合播放效果图

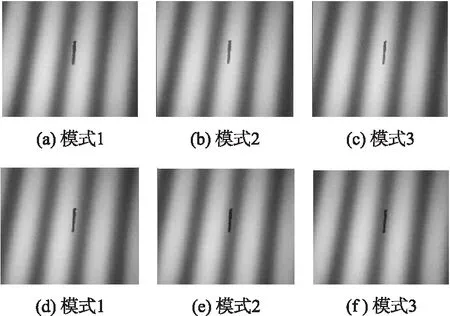

为了验证人眼跟踪配合图像模式调整的整体效果,采用一个两视点立体图片,左视点为全白,右视点为全黑,并在最佳观看位置处放置一个面板,面板上出现黑白相间的条纹。改变图像模式,黑白相间的条纹会随着模式改变而平移。具体如图8。图8中(a)~(f)分别为图像模式1~6的出瞳情况,中间的黑色短实线为参考线,保持不动。由图8可知,从图像模式1逐渐切换到图像模式6,出瞳的条纹恰好平移了一个周期,即黑条纹加白条纹的宽度。因此,每个图像模式出瞳中心宽度是周期的1/6,达到了设计目标。

由图8(b)和图8(c)可知,图像模式的出瞳区域有部分重叠。在黑色短实线位置,既能看到模式2的图像,也能看到模式3的图像,并且黑色短实线在白条纹中所处位置也不一样,切换模式必然导致观看者看到的图像亮度突变,出现画面“跳跃”现象,影响观看效果。

图8 模式切换对应的出瞳变化

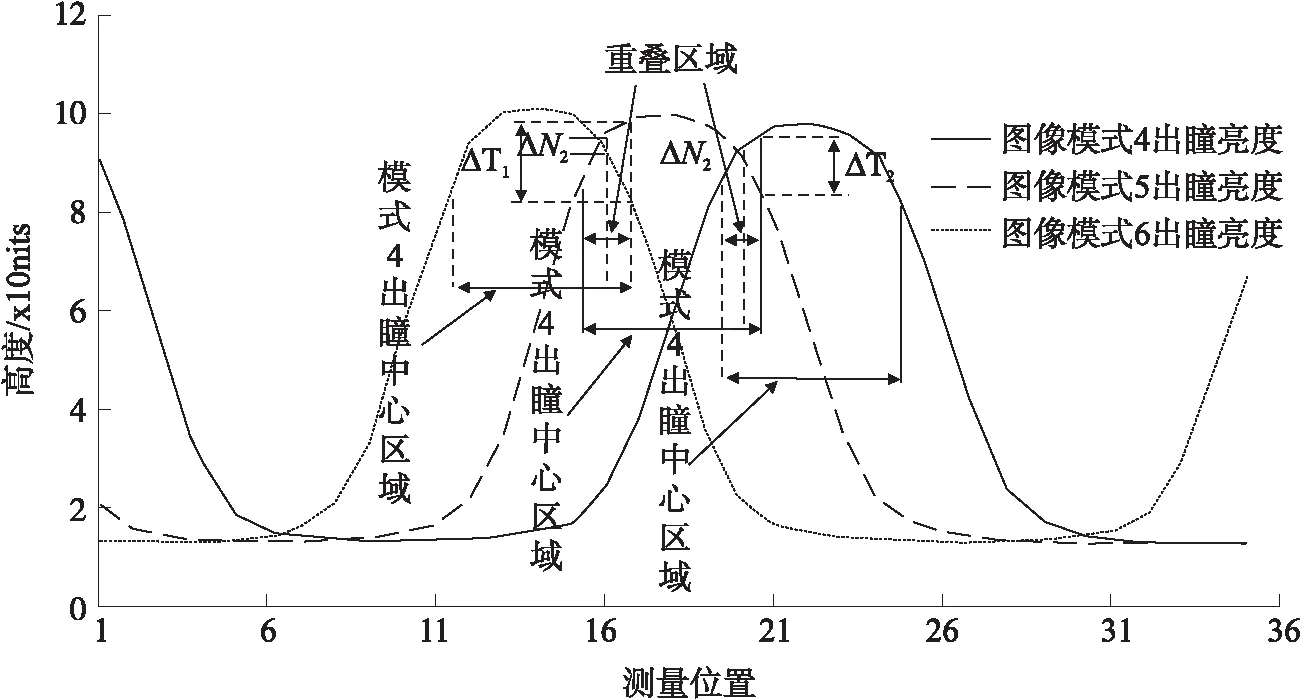

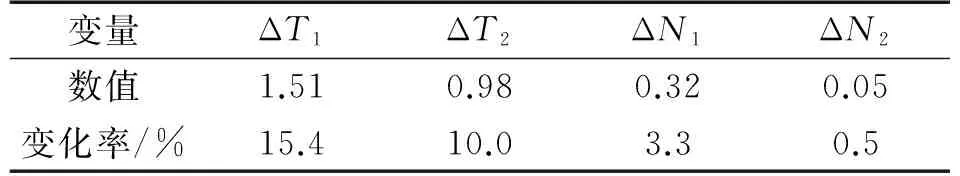

选择图像模式4~6进行实验,测试其出瞳的亮度分布曲线,实验结果如图9所示。

由图9可知,这3种图像模式的亮度分布基本一致,并且模式出瞳中心区域有一部分重叠。为了保证更好的连续立体效果,必须使得模式切换时亮度变化尽可能小。如图9,模式切换如果发生在模式出瞳中心区域的边缘,此时切换时亮度大小变化为ΔT;如果模式切换发生在重叠区域的中心位置,此时切换时亮度大小变化为ΔN。具体亮度大小变化数值如表2所示。

图9 出瞳亮度分布曲线

变量ΔT1ΔT2ΔN1ΔN2数值1.510.980.320.05变化率/%15.410.03.30.5

由图9可知,模式出瞳中心区域的亮度为S≈9.8,据此计算的亮度变化率如表2第3行。由表2数据可知,在出瞳中心区域边缘切换模式的亮度变化率大于重叠区域,在重叠区域切换视点亮度变化率小于3.3%,此时人眼基本无法觉察。因此,人眼跟踪程序计算图像模式时,应该在两相邻图像模式出瞳重叠区域的中间位置设置切换点,如果人眼位置越过这个切换点,就切换图像模式,这样就会使得“跳跃”现象减轻甚至消失。

另外,播放两视点立体视频时,同时启动人眼跟踪程序,不管观看者是站立不动还是移动头部,在任意位置都能观看到良好的立体效果,几乎没有“跳跃”,播放速度流畅,没有卡顿。

4 结论

本文设计了一套人眼跟踪技术辅助图像模式调整的实时立体内容显示系统,该系统基于OpenCV平台,借助QT构建UI操作界面,可同时处理图片的融合播放和立体视频的融合播放。并且对于立体视频可实时融合,播放流畅。该系统配合自由立体显示器很好地解决了“伪立体”的问题,使得立体显示器更符合正常的观看需求。

[1] 王元庆. 立体电视技术及其现状[J]. 南京大学学报(自然科学),2014,3:361-370.

[2] 汪洋,王元庆. 多用户自由立体显示技术[J]. 液晶与显示,2009,24(3):434.

[3] 胡素珍,姜立军,李哲林,等. 自由立体显示技术的研究综述[J]. 计算机系统应用,2014(12):1-8.

[4] 秦开怀,罗建利. 自由立体显示技术及其发展[J]. 中国图象图形学报,2009,10:1934-1941.

[5] 陈国龙. 人眼跟踪技术研究及其在裸眼3D下的应用[D]. 电子科技大学,2014.

[6] 夏光荣,李建军,万里,等. 自由立体显示中人眼跟踪算法的研究[J]. 光学与光电技术,2016,1:11-15.

[7] 王元庆. 基于LCD的自由立体显示技术[J]. 液晶与显示,2003(2):116-120.

[8] 彭熙淳. 用于自由立体显示的新型光栅设计[D]. 北京:北京邮电大学,2013.

[9] 王爱红,王琼华. 光栅式自由立体显示器概述[J]. 现代显示,2009,10:12-17.

[10] 况海斌. 基于柱状透镜的LCD自由立体图像融合算法研究[D]. 湖南大学,2010.

[11] 林岱昆,梁伟棠,梁浩文,等. 基于人脸跟踪的时空无缝裸眼3D显示技术研究[J]. 电视技术,2015(5):70-73,77.

[12] 金诗玮,杨青,李建军. 结合图像融合算法与人眼跟踪的立体视频[J]. 计算机系统应用,2014(9):112-117.

[13] 严超,王元庆,张兆扬. 基于AdaBoost和Kalman算法的人眼检测与跟踪[J]. 南京大学学报(自然科学版),2010,46(6):681-687.

[14] 王吉林,叶建隆,赵力,等. 基于曲线波隐马尔可夫模型的人脸检测[J]. 传感技术学报,2011,24(5):714-718.

StereoContentFusionDisplayTechnologyResearchBasedonEyeTracking*

HUANGJinpen1,HUANGKaicheng1,WANGYuanqing1*,LIMinggao2,ZHOUBiye2,CAOLiqun2

(1.School of Electronic Science and Engineering,Nanjing University,Nanjing 210023,China;2. Aviation and Diving Medical Center of Navy General Hospital,Beijing 100048,China)

Discontinuous viewing area has restricted the development of freedom stereoscopic display. The viewers would perceive a reverse stereo image when their head out of right viewing area,which come from discontinuous view area. To solve this problem,using eye tracking with image fusionprogram adjusting image mode makes the stereoscopic viewing area move following eye location to achieve continuous and wide stereo display. Using open CV and QT to construct a real time system of stereo content fusion based on this method. This system solves reverse stereo image and viewer can feel well stereo in display area whatever location. Image brightness rate of change is less than 3.3% when image mode has been adjusted.

freedom stereoscopic display;reverse stereo image;eye tracking;image fusion;image mode

10.3969/j.issn.1005-9490.2017.06.039

项目来源:国家重点基础研究规划基金项目(AHJ2011Z001)

2016-11-04修改日期2016-12-30

TP391.4

A

1005-9490(2017)06-1534-05

黄金盆(1991-),男,湖南邵阳人,汉族,硕士,现就读于南京大学电子科学与工程学院,主要研究方向为图像处理、模式识别以及立体显示技术,hjp_work@163.com;

王元庆(1963-),男,安徽芜湖人,汉族,博士,南京大学电子科学与工程学院博导,教授,主要研究方向为立体图像显示、立体图像获取、现代图像处理以及激光雷达等,yqwang@nju.edu.cn。