舰载指控系统多通道交互集成技术研究*

宁云晖 杨雪飞 徐建平 程 雄

(1.海军装备研究院 北京 100161)(2.武汉数字工程研究所 武汉 430205)

舰载指控系统多通道交互集成技术研究*

宁云晖1杨雪飞1徐建平1程 雄2

(1.海军装备研究院 北京 100161)(2.武汉数字工程研究所 武汉 430205)

人机交互友好性是影响指控系统作战效率的一个重要因素。在分析指控系统人机交互的需求基础上,提出一套适用于舰载指控系统的多通道人机交互框架,形成了多通道人机交互集成规范,可以提高交互的自然性和高效性。

指控系统; 人机交互; 多通道交互

1 引言

舰艇指控系统是发挥舰艇平台整体作战效能的核心装备,需要组织显示与作战过程相关的多种舰艇作战资源的作战状态、战场态势,因而显示的信息数量多,种类繁杂,实时变化快。同时指挥人员需要利用指控系统快速、准确地指挥、干预作战过程,因此如何高效地发挥指挥员的作战艺术,准确地反映指挥员的作战意图是指控系统研究中需要解决的重要问题[1~2]。

目前我军使用的指挥控制系统多数是基于图形用户界面,人机交互以键盘、跟踪球(或鼠标)、表页显示器等人机交互操作为主。这种交互方式的特征是以窗口管理系统为核心,使用的交互设备比较单一,难以表达和支持非空间性的抽象信息和交互。此外,在交互过程中极大的依赖于视觉和手动控制参与,对使用者的操作要求很高,难于满足复杂多变的战场条件快速下准确交互的操作需要,交互手段和方式造成了操控交互效率不高,严重影响了指挥决策的效率。

针对舰载指控系统中的人机自然交互的需求,本文基于多点触摸、语音交互、体感交互、移动PAD等多通道人机交互技术,提出一套适用于舰载指控系统的多通道人机交互框架,实现草图识别、语音识别、多点触摸、手写识别、PDA等人机交互技术的优化、集成及其工程化应用,从而从指挥员能利用多个通道以自然、并行、协作的方式进行人机对话,提高指挥决策的自然性和高效性[3]。

2 多通道交互技术概述

2.1 多通道交互技术

在传统的交互方式中,为了适应计算机的“习惯”,用户通常使用精确而非人性化的交互设备,如鼠标、键盘等。当前,得益于其他各相关计算机技术如语音识别、自然语言理解、手势识别、计算机视觉等多门技术的发展,人机交互的研究步入了一个新的领域——多通道人机交互(Multi-Modal Human-Computer Interaction)。所谓多通道交互,是指一种使用多种通道与计算机通信的人家交互方式,通道涵盖用户表达意图、执行动作或感知反馈信息的各种通信方法,如语言、手势、头动、唇动、触觉、味觉等[4]。

多通道系统允许用户通过多个不同的人体交互通道如语音、手势、姿势等与之通信,并能从中自动提取语义,识别出最终交互目的。多通道人机界面充分利用人的多个认知通道,利用语音识别、手势输入、视线跟踪、感觉反馈等新交互技术,以并行、非精确方式与计算机交互,旨在提高人机交互的自然性和高效性。现今多通道界面的研究已经成为人机交互领域的重要方向。多通道交互系统与传统的图形用户界面交互的最大的不同之处在于,多种交互设备的同时使用来自多个交互通道的信息的融合。它的目的是在人机工程学的背景下,通过研究人在信息交流中的习惯和行为模式,综合使用视线、语音、手势等新的交互通道、设备和交互技术,使用户可通过多个通道以自然、并行、协作的方式进行人机对话,融合来自不同通道的精确的和不精确的输入以捕捉用户的交互意图,提高人机交互的自然性和高效性,最终达到以人为中心的交互方式。

2.2 国内外研究现状

20世纪80年代后期以来,多通道人机交互成为崭新的研究领域,受到高度重视。北美、欧洲很多研究机构的研究内容涉及键盘、鼠标之外的语音、手势、手写和眼动等输入通道,使用户能利用多个通道以自然、并行、协作的方式进行人机会话,并且以具体系统为主。许多相关的研究计划纷纷启动。

卡内基梅隆大学在DARPA的资助下,对语音识别、手写识别、手势识别、自然用户接口等多模态人机交互技术进行了广泛研究,开发了基于Java的多模态交互工具箱(MMI)[5]。MIT的人工智能实验室从1996年开始了名为Intelligent Room[6]的研究项目,目的在于探索先进的人机交互和协作技术,其具体目标是建立一个智能房间,解释和增强其中发生的活动。麻省理工学院的软件智能体研究组在GANDALF项目中,将多模态交互与智能体结合起来,希望设计出一种拟人化的智能体,使用户可以用语音、表情、手势等方式与之自然交流。欧共体委员会CEC制定了一个欧洲信息技术战略计划ESPRIT[7],对人机界面进行了系统研究,其中包括语音识别、语音合成、声音的空间化、笔式输入和手写体识别等关键支撑技术的研究。美国Applied Minds公司的双手触摸交互系统TouchTable提供了高级的双手操作和可视化能力,能最大化地支持协作[8]。

近年来,国外已出现了一些智能多模态人机交互系统,国内也有单位开展智能多模人机交互的研究工作,如清华大学计算机系人机交互与媒体集成研究所正在研制的“智能教室”[9],其中的人机界面由投影显示、语音命令、话音合成、姿态识别、人物跟踪与识别等组成,准备通过多模态的人机接口技术实现,此外,该计划引入了智能环境及“无所不在的计算”的研究思路。北京交通大学信息所的基于Agent的多功能感知系统,该项研究提出了一个基于Agent的多模人机交互框架,并且进行了两种输入模态联合的实验[10]。

综观目前对于多通道技术的研究,主要集中在以下几个方面:

1) 单个通道技术的研究:如语音识别、自然语言理解、手写识别、视线跟踪、面部跟踪等,这类研究着重于对某一个通道的前沿技术的研究,旨在发展单个通道的技术。

2) 多个通道的整合技术;这类研究采用多学科交叉的研究方法,通过寻求多个通道间信息的共同表示,借鉴和分析人类多通道信息处理中的数据模型,寻求计算机软件系统中对映射到多个交互通道的信息的统一化表示。即模拟人类的方式对多个通道信息进行处理以实现交互。

3) 多通道系统的软件架构和系统模型;多通道界面的优势和灵活导致了许多设计问题上的复杂性,软件结构就是一个迫切需要解决的大问题,目前讨论比较多的是智能体模型。

4) 用户心理学、行为认知学等用户模型的研究;多通道人机交互的研究目的就是要实现类似人际的尽可能自然的交互,因此对用户的心理和行为分析将有助于多通道系统的模型分析和建立。

3 多通道交互集成方法

多通道交互集成要解决的关键问题就是如何将不同通道的输入信息有机地整合起来,得出用户的交互目的。人的交互意图是由大脑控制的,利用多个效应通道如手、语言、动作等,并行协作地表达出意图。就某一次交互来说,各个通道的输入之间都是存在着相同目的的联系。但是,对计算机而言,接收某个通道信息的设备不同,产生的信息格式也不同。要完成信息的整合,就必须将它们以一种统一的形式表达出来,由具体的设备信息到统一的格式表示,这就是多通道人机交互集成要解决的核心问题。

本文借鉴交互事件表示的分层整合模型的思想,针对多通道人机交互服务的特点和描述特性,在不同的层建立多通道人机交互消息的统一编码方法及数据与接口集成规范等,从技术参考模型、数据交互规范等方面为多通道人机交互应用提供集成规范,进而实现多通道信息的集成。

3.1 多通道集成框架

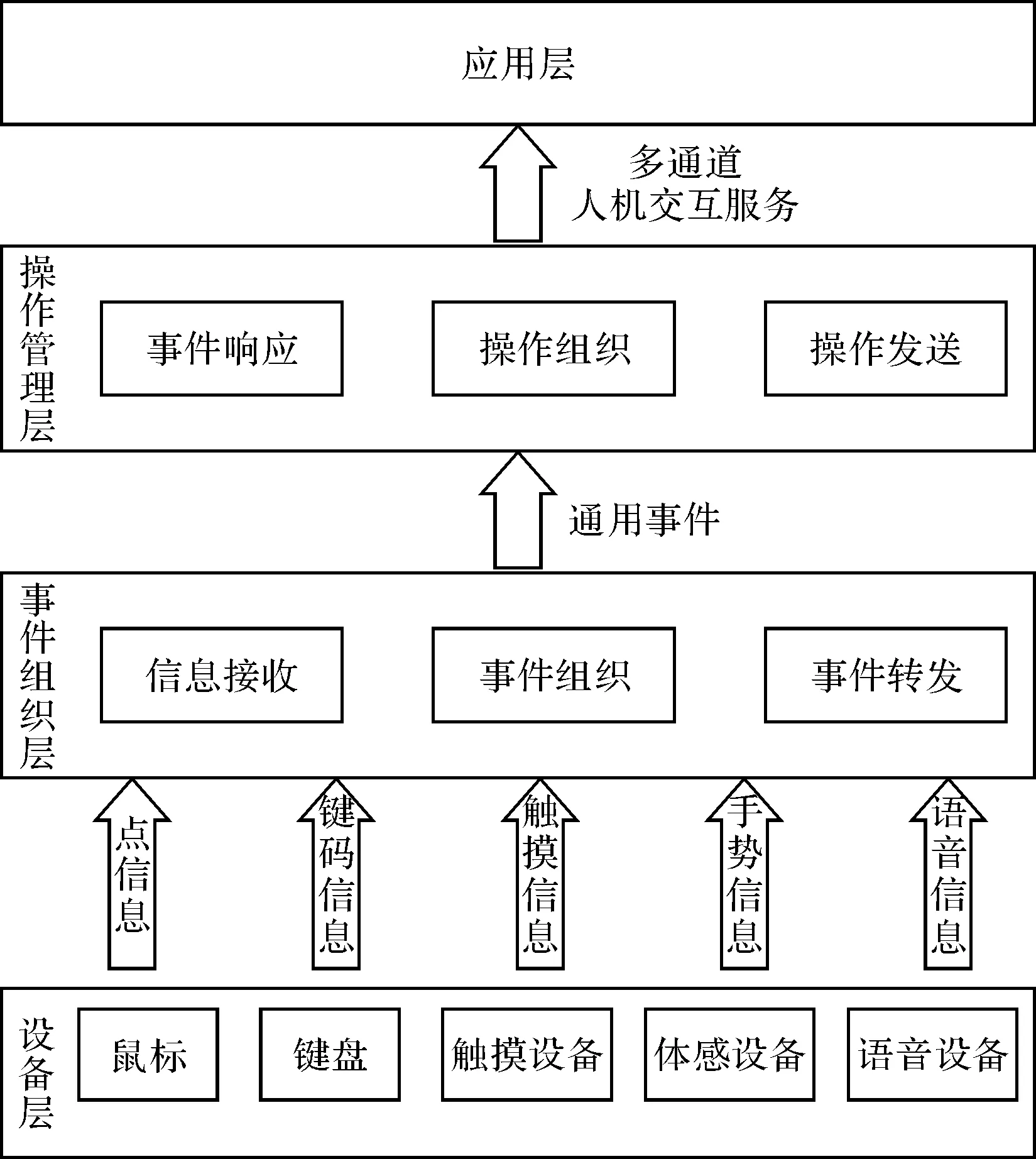

如何在舰载指控操作中合理地利用触摸、体感、语音等新式交互方式,实现多种交互通道优化集成,提高指控操作的效率是多通道集成必须突破的问题。多通道集成框架需要集成来自不同交互通道的人机交互信息,对多种交互信息提供统一的管理,为上层应用提供标准的接口,从系统与软件体系结构的角度为多通道交互集成奠定基础框架,实现硬件及平台的无关性。多通道交互集成框架由三层组成:设备层、事件组织层和操作管理层,具体的处理框架如图1所示。

图1 多通道交互集成框架

设备层实现对各类输入设备的驱动,将输入设备的交互信息发送到事件组织层。

事件组织层接收到不同交互通道的输入信息后,将不同类型的输入信息按统一的事件格式进行组织转换,并转发到操作处理层进行处理。通过事件组织层,实现对硬件平台的无关性。

操作管理层实时侦听并接收事件组织层发送的事件消息,综合考虑输入通道、事件类型等因素,将交互事件划分为操作对象、操作动作和操作参数信息,根据多通道集成算法,提取出包含对象、动作和属性等信息的操作,提供给应用层。

多通道人机交互集成框架通过事件组织层和操作管理层完成多种交互通道的优化集成,即是研究在事件组织层如何根据不同交互通道输入事件的特点对多通道输入的事件进行分析、标准化、形成通用交互事件,然后在操作管理层将事件组织层发送的通用事件多种交互通道信息流分解、重组和抽象的过程。

3.2 多通道交互事件规范及集成

基于交互事件的多通道集成通过对多通道的交互事件的规范表达,从而完成多通道交互整合。多通道交互事件规范根据不同交互通道输入信息的特点,将交互事件标准化表达,形成输入信息在系统中的统一表达方式。

对计算机而言,接收某个通道信息的设备不同,产生的信息格式也不同。要完成不用交互通道产生的交互信息的整合,就必须将它们以一种统一的形式表达出来,由具体的设备信息到统一的格式表示,即是多通道交互事件的规范表达。

基于多通道人机交互集成框架的设计,从事件组织层和操作管理层对不同通道的输入信息进行规范性研究,将交互集成分为物理层、词法层、语法层和应用层。由于应用层与应用密切相关,因此多通道人机交互集成规范从物理层、词法层和语法层三个不同的层次对多种不同通道的输入消息进行统一的信息整合规范。

图2 分层模型结构

物理层是与物理交互设备相关的,它将来自交互设备的交互信息经过设备驱动程序转化,形成系统可以处理的信息格式。不同的输入通道所表达的信息格式是不同的。比如,键盘和语音交互设备输入的信息在物理层表示是字符串,鼠标设备输入信息在物理层表示是坐标信息和点击信息等。物理层的规范主要研究交互设备的标准输入信息格式。

词法层统一不同通道的输入形式。多个通道虽然处理的过程不一样,但它们表达的内容是一样的。通过使用最小的数据单元—原语数据,表达不同通道的输入内容。词法层对物理层的交互信息进行抽象,把设备送来的信息转化成规范的形式,便于上层的信息处理。

物理层传递来的原始数据都对应着设备的一个输入事件,不同的输入设备输入事件也不相同。词法层对原始数据分两步进行规范整理,形成向下无关的最小逻辑单位。

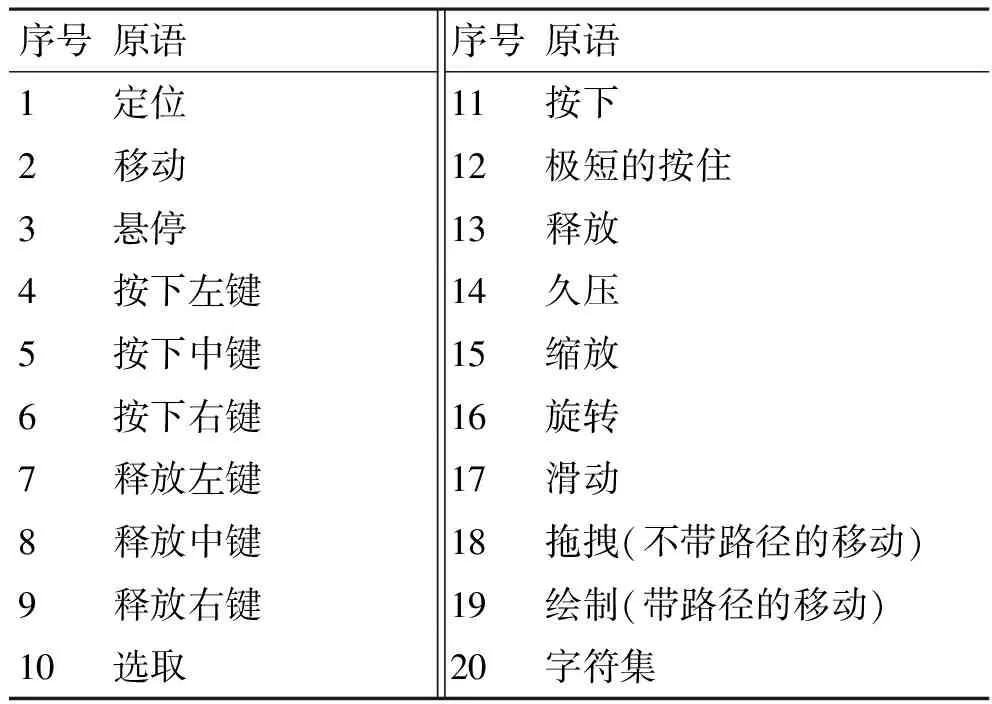

第一步,词法层对物理层的原始数据转化,形成系统可以处理的一致格式的数据,比如键盘和语音数据转化为计算机内存中的一段数字,鼠标、触摸和体感等转化为一系列事件。具体事件列表如表1所示。

表1 输入事件表

续表

第二步,词法层将事件信息进行抽象描述,形成交互语言的原语数据规范单元,将转换后的原语数据传递到上层语法层。本文对常用的输入设备和应用事件进行原语数据规范,内容见下表。

表2 原语表

对于不同的人机交互方式,适用的原语情景也有不同,本文对词法层原语数据规范对应的适用情景也进行了定义。例如鼠标适用于点击、拖拽情景,不适用绘制情景等。具体适用情景如图3。

图3 原语适用情景规范示意图

语法层把来自词法层的原语信息按照人机交互的语法规范分成表示命令的原语、表示对象的原语、表示对象属性的原语。语法层是对信息整合规则的一种描述,来自词法层的各种信息在语法的约束下进行分类和综合,并确定其语法意义,只有符合语法规则的信息才能进入应用层。语法层的规范主要研究各种原语组合标准与规范,用于确保原语组合的语法正确性。

语法层将原语按照命令、对象、属性的类别进行分类,在这里我们借鉴Apple公司关于桌面系统人机界面的一条规则进行任务分析:“Noun-Verb”规则,即一条命令可由一个名词和一个动词部分构成。例如,人们常常倾向于“新绘制一个军标”,而不是“军标绘制”这样的表达方式。另外,还需对名字进行修饰,例如“新绘制一个军方在距离10km,方位45°”。因此,我们将规则进行了修改:“Verb-Noun- Adjective”,即“操作-对象-属性”,命名为操作三元组。

以上形式化描述中,以输入原语为终结符。输入原语来自于词法层转换的从输入设备获取的信息。它来自不同通道的独立、最小、不可分割的操作。输入原语经过语法层组合成操作三元组后,将操作三元组传递至应用层,由应用层结合应用映射至具体的应用事件。

各层所处理的数据结构在该层内部是一致的,这样既保证了结构的清晰,也规范化了层与层之间的接口,屏蔽了层以下的信息差异,有利于系统交互通道的可扩展性。

多通道交互集成研究对标准的输入事件进行重组和抽象,形成具体的操作事件。在多通道交互集成过程中,事件组织层根据词法层定义的通用交互消息的原语集,将设备层发送的不同交互通道的信息按原语规范进行组织和整理,形成标准的原语事件发送到操作组织层。操作管理层侦听并接收事件组织层发送的输入原语,对输入原语的通道类型、事件类型,对输入的原语事件进行分析,依据语法层的操作三元组定义提取出对象、操作和属性,将整合后的操作三元组传递至应用层,由应用层结合应用映射至具体的应用事件。

针对舰载作战指挥控制系统的业务特点,结合人机交互设备的特点,提出了不同作战业务操作下适用的交互手段组合的建议。方面作战指挥时,建议采用“键盘+鼠标+语音”的多通道交互;作战方案拟制时,建议采用“触摸+语音”的多通道交互;文电拟制时,建议采用“键盘+鼠标+触摸”的多通道交互;大屏会商设备操控时,建议采用“触摸+体感”的多通道交互。

4 结语

多通道将是未来用户界面的技术特征,多通道输入信息的集成是实现多通道人机交互的一个关键技术。本文结合舰载作战指挥控制系统的应用背景,利用鼠标、键盘、语音、触摸、体感等人机交互方式,通过设计多通道集成框架,建立三层交互集成机制,定义通用交互消息原语集及操作三元组,形成多通道人机交互集成规范,并在此基础上,针对舰载指控系统应用背景,给出了在不同场景采用的交互方式的建议,为舰载指控系统中自然高效的人机交互提供技术支撑。

[1] Peter Frantis, Jan Hodicky. Human Machine Interfance in Command and Control System[C]//IEEE International Conference on Virtual Environments,2010:38-41.

[2] 王小非.美军指控系统发展及其对我海军舰艇指控系统建设的启示[J].舰船电子工程,2010,30(5):1-5.

[3] 董士海,王坚,戴国忠.人机交互与多通道用户界面[M].北京:科学出版社,1999.

[4] 董士海,陈敏等.多通道用户界面的模型、方法与实例[J].北京大学学报(自然科学版),2001,32(2 -3):231- 239.

[5] Eric Clayberg , Dan Rubel. Eclipse Building Commercial-Quality Plug-ins[M].北京:人民邮电出版社,2006.

[6] Coen M, et al. The future of human-computer interaction or how I learned to stop worrying and love my intelligent room[J]. IEEE Intelligent Systems, 1999, 14(2):8-10.

[7] 叶挺.基于任务分析的指挥空间多通道交互方法研究[D].长沙:国防科技大学,2009.

[8] 王鹏,黄广连等.一种红外多点触摸式双手交互技术[J]. 小型微型计算机系统,2009,30(7):1467-1472.

[9] 谷洪亮,史元春等.智能教室支持普适计算的无线网络方案的问题、挑战和解决探讨[J].小型微型计算机系统,2005,26(3):367-370.

[10] S.Clemens.et.al. Component Software [M]. 2nd edition, USA: AddisonWesley, 2002.

Multimodel Interaction Integration Technique in Shipborne Command and Control System

NING Yunhui1YANG Xuefei1XU Jianping1CHENG Xiong2

(1. Navy Academy of Armament, Beijing 100161)(2. Wuhan Digital Engineering Institute, Wuhan 430205)

Friendly human-computer interaction is one of the important factors affecting the operational efficiency. In this paper,the requirements of human-computer interaction in shipborne command and control system are analyzed,and the human-computer interaction framework suitable for shipborne command and control system is proposed, multimodel interaction specification is formed, the improvements of naturealness and efficient are proved.

command and control system, human-computer interaction, multimodel interaction

E92

2016年9月11日,

2016年10月27日

宁云晖,女,工程师,研究方向:舰艇作战系统,人机工程。杨雪飞,女,工程师,研究方向:舰艇作战系统,人机工程。徐建平,男,高级工程师,研究方向:舰艇作战系统。程雄,男,高级工程师,研究方向:人机交互。

E92

10.3969/j.issn.1672-9730.2017.03.007