基于单应性平面投影的高速车辆检测与定位方法*

元海文 肖长诗 修素朴 文元桥 周春辉 徐周华

(武汉理工大学航运学院1) 武汉 430063) (内河航运技术湖北省重点实验室2) 武汉 430063)

基于单应性平面投影的高速车辆检测与定位方法*

元海文1)肖长诗1,2)修素朴1)文元桥1,2)周春辉1,2)徐周华1)

(武汉理工大学航运学院1)武汉 430063) (内河航运技术湖北省重点实验室2)武汉 430063)

以高速道路上的车辆为分析对象,提出一种基于视觉单应性平面投影的车辆检测-定位方法.该方法能够从实际尺度上稳定地确定目标位置、速度大小和方向等参数.与一般的检测方法不同,文中采用背景建模与AdaBoost分类相结合的手段,从而实现车辆轮胎的可靠检测.通过区域色调分析,目标阴影得到较好地抑制,使得相毗邻的车辆目标分离开来;利用少量的轮胎样本的图像几何变换,快速建立以轮胎为目标的样本库.针对定位,利用高速路面上已知的标识信息确定高速道路平面与成像平面之间的单应性关系,并利用该关系重现车辆的实际位置、速度信息,现场相机的相对方位也可以通过矩阵分解获得.通过现场图像数据对该方法进行测试并证明其有效性.

车辆定位;投影变换;背景建模;目标检测;单应性

0 引 言

近年来,作为一种主要的交通监管手段,机器视觉可以代替人实现全天候、自动化作业,这在一定程度上提高了工作效率.与其它常用方式(如雷达、超声波等)相比,视觉监控不仅具备成本和功耗低的优势,而且获取信息更为丰富,因而被广泛应用.随着计算机与机器视觉技术的发展,大量的基于视觉的交通车辆监控或检测方法被提出并展开研究[1].

针对高速道路场景,一般用于车辆检测或定位的算法主要包括背景减除、光流、滤波跟踪、颜色直方图和图像匹配等.其中,魏武等[2]通过帧差法提取图像中的车辆与场景信息,并根据车道线信息实现车辆计数和速度估计.颜江峰等[3]主要采用帧差法分析车辆从运动到静止的特征提取值图,并根据车辆参数提出一种高速违规停车检测方法.Roya等[4]利用背景减除和Kalman滤波对运动前景区域提取和跟踪,以及形态学、形状分析及时间关联等方法在一定程度上减缓了遮挡影响.Yu等[5]利用一个高斯混合模型(GMM)同时对背景和前景建模,提高了两者之间的分割精度,具有较高的实用价值.虽然背景减除法有能力从连续的图像序列中提取运动目标,然而在运动的背景或复杂的场景中仍然存在着许多难以解决的问题,例如光照、阴影、无关运动、颜色相似等因素.粒子滤波和颜色直方图根据目标的外观属性对每一帧进行检测,主要用于前景目标的跟踪,在一定程度上可以解决短暂的遮挡.王相海等[6]提出一种基于Mean-Shift粒子滤波的多目标跟踪方法,通过构造基于最新观测信息的重要性密度函数,提高了在复杂背景情况下追踪部分遮挡及交叉车辆的准确性和鲁棒性.权义萍等[7]针对传统粒子滤波的非线性、非高斯性可能导致跟踪过程中的不准确性,提出一种基于Mean-Shift的卡尔曼粒子滤波算法.除此之外,考虑到单摄像机视野的有限和深度信息的缺失,基于多摄像机模型的交通监控算法被提出来进行研究.为解决高速道路中车辆阴影抑制、遮挡和夜间检测等情况,Akio等[8]采用2D联合车-阴影模型、多摄像机系统及后视技术改善了系统精度,然而在安装环境和设备需求方面存在较高约束.汤一平等[9]设计一种全方位视觉传感器(ODVS)和高速快球摄像机组合的智能监控系统,不仅能够实现大范围的车辆对象的自动检测和跟踪,也可以对非法停留目标抓拍进行车牌识别,充分发挥了不同类型摄像机的特点.张凤静等[10]将双目传感器安置于道路边,利用三角测量方法对过往车辆底部阴影部分位置估计.但是在实际应用中相比于普遍的单相机监控模式,双目视觉往往不便于获取,而且标定和同步等前期工作会增加其应用上的困难度.

通过上述讨论,大部分相关文献主要针对车辆目标检测或定位方面进行了深入研究,并取得不错的效果,然而所有的算法只是在图像尺度平面中完成的,没有考虑实际尺度问题,进而对车辆的行驶速度估计只能够依靠先验参数获取,同时对车辆目标的定位仅仅是通过整个目标区域轮廓的中心或质心确定,导致从不同角度观测结果具有较大的不稳定性.为了从实际的物理尺度上实现车辆的精确定位和速度估计,本文利用单个内参已知的相机提出了一种基于单应性平面投影的车辆检测和定位方法.该方法首先对IMBS算法的阴影抑制部分提出适当改进,用以对高速场景区域内所有的车辆目标实现图像层面的精确提取,然后利用基于AdaBoost的轮胎检测器对目标区域检测,近似得到车辆最接近地面的位置,为实现平面投影变换提供基础;定位方面,采用高速道路上特殊标识作为控制信息实现监控相机的外参数标定,得到图像平面与实际的道路平面之间的投影关系,即单应性矩阵,进而完成基于单应性平面投影的车辆定位及行驶速度估计.

1 方法介绍

1.1 车辆目标精确的坐标检测

针对高速场景的动态复杂性,基于背景建模的车辆检测算法面临一些问题:光照变化、相机震动及目标阴影都会影响到运动目标的提取.如何有效地建立和更新背景模型是背景减除算法的关键,本文采用独立多模态背景减除(independent multimodal background subtraction,IMBS)算法[11],一种在线聚类方法,创建一种离散化未知分布来描述场景特征,以此达到背景与前景运动车辆的有效分离.

在背景建立过程中,每一个背景像素被认为一组可变尺寸的容器,不需要做任何关于观测分布的先验假设,主要包括模型初始化,前景提取、背景更新和阴影抑制四个部分.为保证模型的准确性,IMBS算法初始化部分创建第一个背景需要R=NP时间长度.其中N为样本数量;P为采样间隔.每隔R/2时间长度,对背景模型进行重建,新的背景模型与之前的模型相互独立,既有利于快速动态变化的场景,又不影响缓慢改变的检测精度.同时,当前景二值图像中超过50%的像素属于前景时,N和P的值会被大大降低,以加快新背景模型的创建.

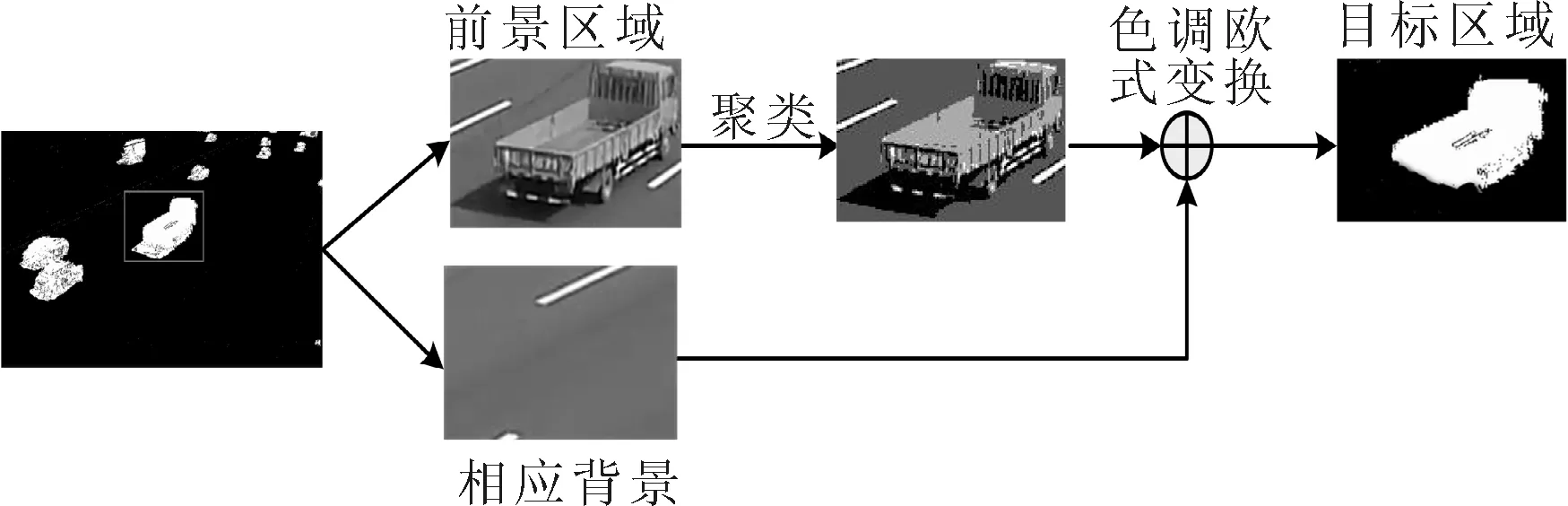

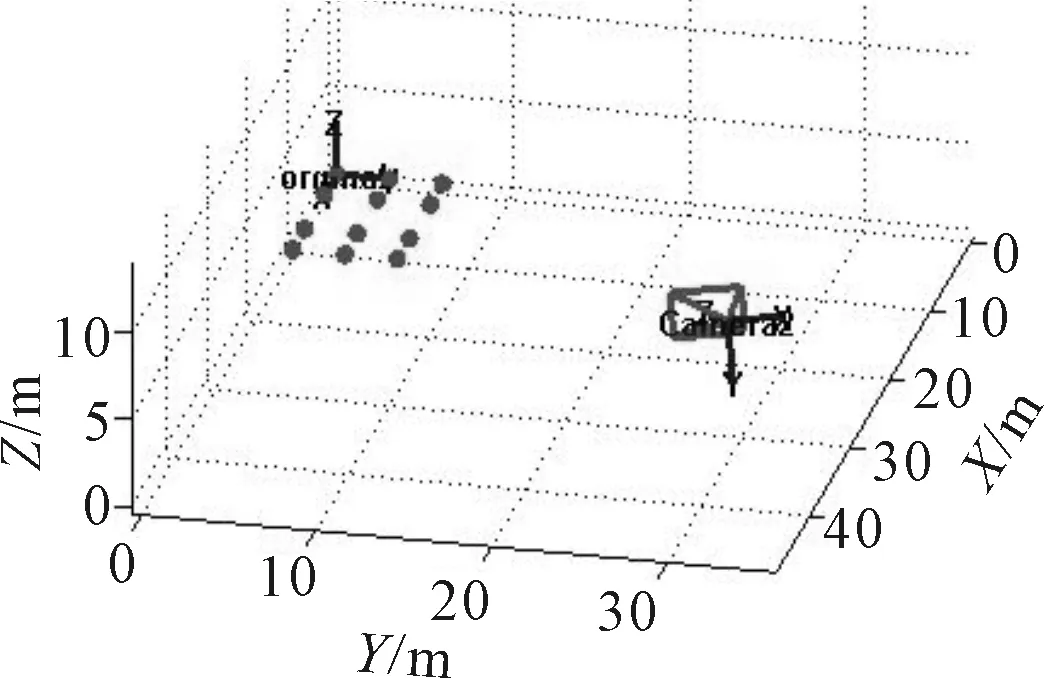

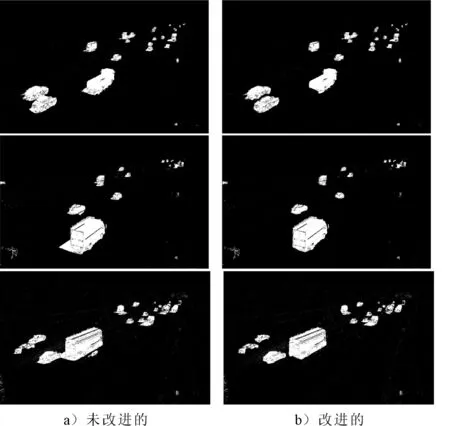

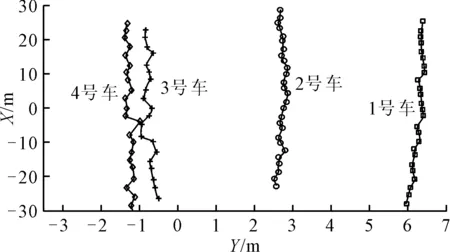

由于高速道路场景中不存在其他目标类型且比较结构化,影响车辆目标提取的主要因素来源于目标自身的阴影.通常地,当图像中某区域被阴影覆盖时,对应的颜色信息除了亮度以外不会发生较大变化.实际应用中,往往利用像素值与对应背景在HSV空间上的色差比率,来区分目标和其阴影.然而,在阴影抑制过程中,原来的算法是针对每一个像素点单独处理,而没有考虑以区域形式存在的阴影的整体性.为提高阴影检测的准确性,本文考虑其区域整体性,对原有的阴影抑制算法进行改进,具体流程见图1.首先,由于经过背景分离得到的前景区域主要由目标和对应的阴影组成,利用k聚类技术对其分割;然后将前景中每一个类与相邻背景进行色调欧式距离计算;经过比较,对应最小的或接近于0的类被认为是阴影区域,部分伪代码在下方给出.图1中,车辆目标区域经过聚类分割能够明显地将对应的阴影部分与主要的车辆目标区别开,之后与背景部分在色调空间上比较分析,从而实现阴影抑制的目的.

图1 改进的阴影抑制方法

改进的阴影抑制算法(部分伪代码)

Input: foreground blobi, blobs’ numberN, Background Hue valueB

Whilei clustering ← km eans(blobi,K); fork=1:K M(k) ← MeanHue(clustering(k)); D(k) ← Distance(M(k),B); ifk=1 Dm=D(k);m=k; elseifD(k) Dm=D(k);m=k; end then the shadow←clustering(m); next blobi=i+1; end 然而,依靠基于背景建模的车辆目标检测算法,得到的目标轮廓并不能为本文定位提供精确的图像位置.由于车辆的轮胎最接近于高速路面,满足平面投影变换的要求,文中采用AdaBoost级联分类器和方向梯度直方图(histograms of oriented gradient,HOG)特征算子[12]来检测或识别轮廓中的轮胎. 基于AdaBoost级联分类器的车辆轮胎检测的前提是对该分类器进行训练,也是该部分的主要工作.一般地,大量的轮胎的正样本和负样本图片被需要用于训练一个高精度的分类器,但是搜集如此数量巨大正负样本是一件繁琐耗时的工作.因此,文中采用OpenCV提供的库函数通过图片平移、旋转和叠加等操作生成对应的样本库. 图2 部分轮胎样本库 通过现场视频截取到40张比例大小一致的目标图片和800张非目标图片来构成基本的正、负样本,见图2.其中,大量正样本通过createsamples函数将有限的正样本与负样本融合得到的,而负样本是从场景图像中通过随机函数自动截取得到.该工作在一个小时内完成,极大程度上缩短了收集时间. 此外,选择一种合适的特征算子来提取车辆轮胎的特征向量也是非常关键的.文中利用HOG算子来计算样本特征和检测分析目标,该特征算子是根据光强梯度或边缘方向的分布描绘图像局部物体外貌和形状,能够抵抗一定的光照变化,具有较强的鲁棒性,适用于高速道路场景的应用.因为HOG算子是在图像的局部方格单元上操作,所以它对图像几何和光学形变都能保持很好的不变性;并且在粗的空域抽样、精细的方向抽样以及较强的局部光学归一化等条件下,只要目标结构不发生整体改变,可以容许其局部一些微小变动,且这些微弱变化可以被忽略而不影响检测效果. 最终,一个基于AdaBoost的车轮检测器利用该样本库和HOG特征算子进行训练得到. 1.2 基于单应性平面投影的车辆定位及相机位姿重现 利用单应性平面投影变换的方法确定高速道路地面与图像平面之间的转换关系,即通过图像平面上的目标位置计算其在地面上的实际位置.确定该转换关系,就是求单应性矩阵H.单应性矩阵是一种包含有相机内参数和外参数的特殊形式,假定相机为常用的针孔模型,m=[μ,ν,1]T表示齐次型的图像坐标(像素),M=[X,Y,Z,1]T表示齐次型的世界坐标(mm),世界坐标点与其对应投影图像坐标之间的关系为 (1) 式中:s是标量,为比例缩放因子;A为相机内参数矩阵,其采用四参数模型,包括相机焦距和中心点坐标信息,(R3×3,t3×1)为外参数,表示世界坐标系与相机坐标系之间的相对方位.设世界坐标系中地面为XY平面,旋转矩阵R3×3的每一列用ri表示,因为地面上所有点的Z值总是为0,则单应性矩阵H由式(2)计算得到. (2) 假定内参数已知,高速道路地面具有丰富的特殊标识,例如车道宽度、分隔线的长度和间隔,这些信息都能够作为控制点求取单应性矩阵.经过现场实际测量,设车道宽度为3.5m,分割线长度约6m,其间隔宽度为9m.文中利用这些控制点在道路平面上建立世界坐标系,见图3. H是一个3行3列的矩阵,能够在一个尺度因子s上确定.为了计算方便,规定H(3,3) = 1.一个非原点的地面控制点能够为计算单应性矩阵提供一组关系方程式,至少4个控制点能够线性求解单应性矩阵.然而,考虑图像噪声的干扰,已知n个空间共面点,单应性矩阵H的计算往往通过式(3)的最小化得到 (3) 图3 高速道路场景中的控制点信息及世界坐标系建立 图4 相机相对高速地面(世界坐标系)的方位 而相机相对高速地面(世界坐标系)的位姿也能够由求得的单应性矩阵分解获得:平移矢量[-0.886 0.313 54.435],旋转矢量[1.029 1.767 -1.415],单位分别为米和弧度,见图4. 2.1 轮廓提取与目标坐标检测结果与分析 从实际情形考虑,为排除其他场外因素对检测算法的影响,文中限定场景视野中的主干道部分为图像感兴趣区域(ROI),并在该区域内进行算法验证. 作为车辆定位算法的前提,稳定的检测直接决定其定位精度.为此,针对IMBS背景减除算法进行了改进——对部分阴影进行有效抑制,实现了基于高速场景建模的车辆轮廓提取,具体结果见图5.图5将原算法和改进后的进行比较,例如第一组中左下方的两辆汽车之间经过原算法处理之后存在连通区域,然而采用基于区域色调比对分析的改进方法,造成联通的阴影区域能够被有效消除掉.因此,在一定程度上改进的方法能够更好地分离目标和细化目标轮廓. 图5 基于高速场景建模的车辆提取及改进的 阴影抑制算法比较 对每一个提取到的轮廓采用AdaBoost分类的车辆轮胎进行检测,从而获取稳定的而又接近地面的轮胎位置作为车辆在路面上的图像坐标,见面图6,小矩形框为轮廓提取结果,大矩形框为AdaBoost分类结果,大矩形框为预先设定的ROI. 图6 车辆轮胎检测结果 2.2 定位与速度估计结果与分析 这里,文中对高速场景中的连续图像序列进行测试:利用ROI区域中的4辆汽车作为分析对象并依次进行编号,不断地检测和重建这些车辆目标在世界坐标系下的位置,即实际相对的空间位置.通常地,每一个车辆或者轮廓目标中能够获得不止一个轮胎检测结果,在经过视觉单应性平面投影变换后获得相应的空间坐标,不仅能够实现车辆目标的实际定位,同时也能够利用先验知识判断目标的车型尺寸、速度、与车道间的偏角等.在图7中,2,3,4号车经过前后轮位置之间计算,其前后轮的距离分别为2.542,2.874,2.951m,属于小型轿车,而1号目标的前后轮距离为4.533m,属于卡车类型.经过实际比对,算法判断正确. 图7 世界坐标系下车辆目标位置 连续地对该4辆汽车1~4号进行检测和定位,可得到车辆的行驶轨迹,见图8.同时,参考相机检测帧信息,将目标的前后位置和时间间隔相结合,估计1~4号车行驶过程中的平均运动速度量,分别为80.902,109.537,112.159,110.523km/h.除此之外,算法定义汽车与车道分隔线之间的夹角为其方向偏角,右偏为正,左偏为负,则其计算结果见图9.由于算法系统中存在的噪声干扰,4个车辆目标的方向偏角大致在5°范围以内波动,平均值为0°,对于车辆运动来讲,最大误差在5°以内可以认为噪声忽略.以此为依据,本文可以判断车辆目标在某时刻是否沿车道线正确行驶. 图8 车辆行驶轨迹 图9 车辆行驶的方向偏角 利用高速道路中一些特殊的情形,文中提出了一种基于视觉单应性平面投影的车辆检测-定位方法.其中,通过引进区域色调的聚类分析,改进了车辆目标轮廓提取的精度,紧接着利用Adaboost分类实现车辆在图像中坐标准确检测.最后,利用视觉单应性实现由图像坐标到实际地面的坐标尺度转换,重现了车辆目标在道路平面的位置、速度和方向偏角.本文收集现场图像数据并进行方法验证,结果表明所提方法具有一定稳定性、有效性.然而,作为未完成的工作,该方法在应用中尚存在许多不足之处,例如环境干扰、相互遮挡等,这些问题将在未来的工作中通过预测跟踪等算法进行改进. [1]SAYANAN S, MOHAN M T. Looking at vehicles on the road: a survey of vision-based vehicle detection, tracking, and behavior analysis[J]. IEEE Transactions on Intelligent Transportation Systems,2013,14(4):1773-1796. [2]魏武,张起森,王明俊,等.基于计算机视觉和图像处理的交通参数检测[J].信息与控制,2001,30(3):257-261. [3]颜江峰,毛恩荣.基于机器视觉的高速公路车辆停车检测[J].计算机工程与设计,2007,28(16):4025-4030. [4]ROYA R, MANSOUR J. Real time classification and tracking of multiple vehicles in highways[J]. Pattern Recognition Letters,2005,26:1597-1607. [5]YU T, ZHANG C, COHEN M, et al. Monocular video foreground/background segmentation by tracking spatial-color Gaussian mixture models[C]. Proceedings of the IEEE Workshop on Motion and Video Computing, Austin, TX,2007. [6]王相海,方玲玲,丛志环.基于MSPF的实时监控多目标跟踪算法的研究[J].自动化学报,2012,38(1):139-145. [7]权义萍,金鑫,张蕾,等.基于Mean-Shift的卡尔曼粒子滤波车辆跟踪算法研究[J].计算机应用与软件,2014,31(9):236-241. [8]AKIO Y, CHIA H Y, JAY K. Robust vehicle and traffic information extraction for highway surveillance[J]. Journal on Applied Signal Processing,2005,14:2305-2321. [9]汤一平,陈耀宇.基于计算机视觉的违章停车智能监控系统[J].计算机测量与控制,2009,17(8):1505-1508. [10]张凤静,夏伟杰.双目立体视觉测距系统目标车辆检测算法研究[J].重庆科技学院学报(自然科学版),2011,13(1):161-164. [11]DOMENICO D, BLOISI A, LUCA I. Background modeling in the maritime domain[J]. Machine Vision and Applications,2014,25(5):1257-1269. [12]DALAL N, TRIGGS B. Histograms of oriented gradients for human detection[C]. IEEE Computer Society Conference on Computer Vision and Pattern Recognition,2005(2):886-893. Highway Vehicle Detection-location Framework Based on Homography Planar Projection YUAN Haiwen1)XIAO Changshi1,2)XIU Supu1)WEN Yuanqiao1,2)ZHOU Chunhui1,2)XU Zhouhua1) (SchoolofNavigation,WuhanUniversityofTechnology,Wuhan430063,China)1)(HubeiKeyLaboratoryofInlandShippingTechnology,Wuhan430063,China)2) Considering vehicles in highway as surveillance object, this paper proposes a detection-location framework based on the homography planar projection. The proposed work allows vehicles’ parameters such as position, speed and direction to be steadily accessed in their practical scales. Different from the traditional detection method, the proposed detection method combines the background modeling and the detector trained by AdaBoost to extract the vehicle wheels from the scene. Thus, its results are precise enough. At the same time, the shadow suppression is improved by region analysis on hue, which reduces the shadow’s influence on the contour extraction such that the adjacent vehicles can be separated well. Besides, the homography relation between imaging plane and ground is determined by using some designated symbols in highway, which can be used to compute the real location of the detected vehicle wheel. In addition, some interesting information also can be estimated using the matrix decomposition method, such as the speed and direction of the vehicles. Finally, some experiments are done with filed image sequences to validate the effectiveness of the presented method. vehicle location; projective transformation; background modeling; detection; homography 2016-12-18 *国家自然科学基金项目(51579204)、湖北省交通运输厅科技项目基金(2014-721-4-2)、武汉理工大学研究生自主创新基金项目(2015-JL-014)资助 U491.2 10.3963/j.issn.2095-3844.2017.01.015 元海文(1988—):男,博士生,主要研究领域为机器视觉及其在交通信息工程中的应用

2 实验结果与分析

3 结 束 语