基于分块的多特征融合变尺度目标跟踪算法

李 凯,刘 颖,李 娜,戚秀真

(1.西安邮电大学 通信与信息工程学院,陕西 西安 710061;2.长安大学 信息工程学院,陕西 西安 710064)

基于分块的多特征融合变尺度目标跟踪算法

李 凯1,刘 颖1,李 娜1,戚秀真2

(1.西安邮电大学 通信与信息工程学院,陕西 西安 710061;2.长安大学 信息工程学院,陕西 西安 710064)

为了增强彩色视频中目标外观描述能力和解决跟踪过程中目标尺度变化的问题,提出一种基于分块的多特征融合变尺度目标跟踪算法。设计了一个能处理不同挑战因素下对目标的精确跟踪算法,首先提取HSV分块的颜色直方图特征和PCA-HOG特征并采用多通道线性核函数对两种特征进行融合构建训练样本,然后求解线性岭回归函数获得位置核相关滤波器模型,并以线性核函数来计算候选区域在7个尺度空间上与跟踪目标的响应值,最后利用尺度自适应模板更新模型参数。实验结果表明,提出的算法在彩色视频中不仅能较好地自适应目标尺度的变化,在复杂场景下也具有较强的鲁棒性。

目标跟踪;多特征融合;变尺度;线性核函数

1 目标跟踪

目标跟踪是计算机视觉研究的热点之一,在视频监控、人机交互、交通监控中都有广泛应用[1]。但由于各种目标本身和外界条件综合因素的影响,部分跟踪算法[2-3]并不能在各种复杂的变化情况下实现对目标的跟踪,因此复杂情况下实现对目标的精确跟踪仍然是目标跟踪领域内的难点问题。

目前,循环移位结构[4]理论和相关滤波器[5-9]被很多学者引入到目标跟踪的框架中,具有跟踪速度快和鲁棒性强等优点。基于核的循环移位结构的检测跟踪(Circulant Structure of Tracking-by-detection with Kernels,CSK)算法[4]采用循环移位的方法对目标区域和候选区域密集采样构造训练样本,并在频域内实现快速计算,此外还证明核函数的核矩阵具有循环移位结构,但CSK跟踪算法只选择数量有限的灰度特征样本,对目标外观的描述能力不足,且不能处理目标尺度变化。对于彩色视频序列,CSK算法[4]将其转化为灰度视频序列会造成目标特征信息的丢失,不能进行持续稳定的跟踪,对此提出核相关滤波器(Kernelized Correlation Filters, KCF)跟踪算法[8]将CSK算法[4]的灰度特征改进为多通道方向梯度直方图[10](Histogram of Oriented Gradient,HOG)特征,使训练所得的分类器对待检测目标的解释力更强,通过核矩阵构造目标区域和候选区域的循环移位样本来训练分类器,跟踪的精确性和实时性都较高。但KCF算法也存在缺点:第一,KCF跟踪算法采取固定大小的候选区域训练样本来训练分类器模型,不能对跟踪过程中出现的目标尺度变化进行有效的处理,跟踪结果会逐渐偏离目标的真实位置;第二,KCF跟踪算法只使用HOG特征,不能满足多种复杂情况下对目标的精确跟踪,如遇到遮挡时跟踪失败等。针对KCF跟踪算法的缺陷,相应的改进算法[11-14]被提出,文献[13]分别训练位置检测分类器和尺度检测分类器,虽然能较好自适应目标尺度变化,但提取单一的目标HOG特征容易受背景杂波等干扰信息的影响。颜色属性跟踪方法[14]利用11维颜色名(Color Name, CN)特征来描述目标外观并进行主成分分析(Principal Components Analysis, PCA)降维,与KCF算法相比跟踪性能大大提高,但CN特征易受背景中颜色相似物体的干扰,并且不能处理目标尺度变化。

针对KCF跟踪算法无法处理目标尺度变化和目标特征描述较少的问题,本文结合线性核函数(Linear Kernel Function,LKF)和尺度自适应方法对KCF跟踪算法进行改进,提出了一种基于分块的多特征融合变尺度目标跟踪算法,该算法提取区域的HSV分块的颜色直方图特征和PCA-HOG特征,通过LKF将HSV分块的颜色直方图特征和PCA-HOG特征进行融合构建出分类器的训练样本,然后对线性岭回归函数求解来构造训练分类器模型,使用LKF分别计算候选区域在7个尺度空间上与跟踪目标的相似程度,选择响应值最大时的尺度作为目标的尺度,并实时更新目标位置模型参数。

2 KCF跟踪算法

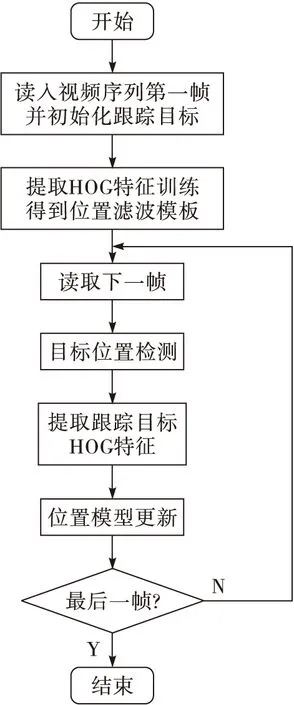

KCF跟踪算法是将特征样本进行循环移位来构建核相关位置滤波模板,利用高斯核函数来计算候选区域与跟踪目标的响应值大小确定新的跟踪目标,并在频域内进行滤波模板的构造和目标检测过程。KCF跟踪算法的流程图如图1所示。

图1 KCF跟踪算法流程图

KCF跟踪算法主要包括4个阶段:样本训练、分类器训练、目标位置检测与模型更新。

2.1 样本训练

(1)

2.2 分类器训练

(2)

(3)

式中:F(·)为傅里叶变换;样本形状标签y的元素为yi,且yi服从高斯函数分布。

2.3 目标位置检测

训练位置核相关滤波器来进行目标位置检测,位置检测过程具体描述如下:

(4)

式中:p为搜索区域内目标位置;p*为目标中心位置;σp为高斯函数标准差,转化到频域即F(yp)。位置滤波模板为

(5)

(6)

2.4 模型更新

在位置检测后,更新位置滤波模板和目标特征为

(7)

(8)

3 改进算法

针对KCF跟踪算法的不足,文中进行3点改进:1)提取目标HSV分块的颜色直方图特征和PCA-HOG特征;2)用LKF将HSV分块的颜色直方图特征和PCA-HOG特征两种特征融合,并将LKF运用到目标相似度计算中;3)对候选区域图像块进行7个尺度空间的缩放,分别求取7个尺度空间与目标区域的最大响应值,最大值区域即为跟踪目标区域。提出的基于分块的多特征融合变尺度目标跟踪算法的流程图如图2所示。

图2 改进算法流程图

3.1 PCA-HOG特征提取

HOG特征对图像几何和光学的形变都能保持不变性。改进的PCA-HOG特征的提取方法是将目标区域分成若干个4×4的细胞单元(cell),采用9个bin的直方图来统计这4×4个像素的梯度信息,即将cell的梯度方向360°分成9个方向块,然后采集细胞单元中各像素点的梯度或边缘的方向直方图,并利用PCA方法对提取出HOG特征进行降维,把直方图组合构成31维特征描述器。

3.2 HSV分块的颜色直方图特征提取

颜色特征对目标的旋转及姿态变化具有鲁棒性和持续性,此外HSV色彩空间模型能较好地解决因光照射、阴影等带来的物体表面颜色不均等问题。单一的特征描述目标外观会使跟踪过程不稳定,本节提取HSV非均匀量化分块颜色直方图,并与PCA-HOG特征融合增强目标外观描述能力。

3.2.1 色彩空间转换

RGB颜色空间到HSV颜色空间的转换公式[15]为

(9)

(10)

(11)

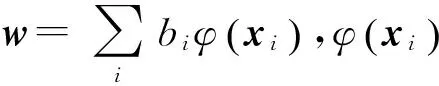

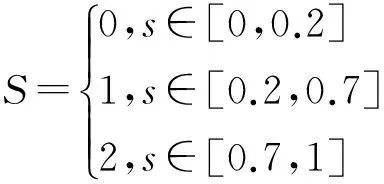

3.2.2 颜色特征提取与HSV量化

将HSV颜色模型的特性作如下处理[15]:

1)当v<15%时,令h=0,s=0,v=0(黑色区域);

2)当s<10%且v>80%时,令h=0,s=0,v=1(白色区域);

3)位于黑色区域和白色区域以外的颜色,其h,s,v值保持不变(彩色区域)。

将H,S,V非等间隔地量化可减少计算量,分别量化为8级、3级、3级,即取

(12)

(13)

(14)

按照非等间隔量化的量化级把各颜色分量合成一维特征矢量为

L=H×Qs×Qv+S×Qv+V

(15)

式中:Qs和Qv分别是分量S和V的量化级数,令Qs=3,Qv=3。式(15)改写为

L=9H+3S+V

(16)

3.2.3 颜色分块

颜色直方图具有计算简单和对平移和旋转不敏感的两大优点,但颜色的全局或局部的不同空间分布极大地影响对目标图像的相似性判定。因此在本文对目标外观描述的过程中,将目标图像分成4×4的细胞单元,对每个cell分别提取颜色直方图,实现一种基于固定分块的目标图像划分方法,即将目标图像划分为适当的子块以提取相应的局部HSV颜色直方图特征。

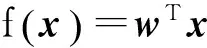

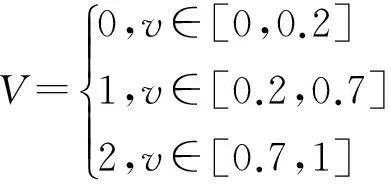

3.3 多特征融合

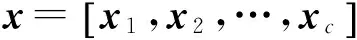

线性核相关函数只需要计算点积,因此在图像特征融合中运用线性核相关滤波器可以减少计算量,并且线性核相关函数还具有循环移位的特性。假如有一个多通道的数据组成向量x=[x1,x2,…,xl],xl表示第l通道特征构成的向量,其多通道线性核函数表示为

(17)

3.4 尺度估计方法

本节中提出变尺度目标跟踪策略,对候选区域的训练样本图像做i个尺度空间上的缩放,并在i个尺度空间上分别求取分类器响应的最大值。

(18)

式中:zti与tist是同样大小的采样块,并缩放大小为ST。利用LKF将采样块与上一帧目标区域在i个尺度空间进行相似度计算,获得i个不同的矩阵,在i个矩阵中寻找最大值作为第i个尺度空间的标量值,然后比较i个尺度空间上的标量值,响应值为最大值的区域即为目标的位置。

3.5 算法步骤

算法的具体步骤描述如下:

步骤2:提取搜索区域HSV分块的颜色直方图特征和PCA-HOG特征级联为xg,用式(17)计算kp=κ(xg,xgi),xgi是循环移位样本[8],满足xgi=Pixg,i=0,1,…,n-1,P是n×n的置换矩阵,并转换到频域即F(kp),由式(4)计算搜索区域内样本高斯形状标签yp,并转化到频域即F(yp),位置滤波模板Bp由式(5)计算得到。

步骤5:根据式(18)计算i个采样块的响应的最大值,得到新的目标的位置及大小,计算搜索模板的大小st。

步骤6:对获取的新目标的区域得到HSV分块的颜色直方图特征和PCA-HOG特征并级联为xg。

步骤8:判断是否为最后一帧,若是则结束,否则置g=g+1,返回步骤3。

4 实验结果与分析

为验证本文提出算法的跟踪结果,在MATLAB2012a软件平台上对其进行仿真实验。使用两个定量评价性能指标来比较不同的跟踪算法:一个是中心位置误差(Center Location Error, CLE)[16],CLE是指跟踪目标结果的中心坐标与目标真实坐标中心的欧氏距离。另一个是Pascal视觉对象类率(Pascal Visual Object Classes Rate, VOR)[16],表示式为VOR=area(BT∩BG)/area(BT∪BG),表示跟踪目标区域与真实目标区域重合率,其中BT是跟踪目标结果的区域,BG是真实标注的目标区域,一般选择重合率阈值为50%处的VOR值来计算跟踪成功率和失败率。

为了验证算法的有效性,在benchmark2013视频数据集[17]中选取不同复杂情况下的8个视频集进行比较,8个视频集包含光照变化、尺度变化、遮挡、形变和运动模糊等各种复杂的目标本身和外界条件的变化。与本文所提出的跟踪算法作对比的有CSK跟踪算法[4]、KCF跟踪算法[8]、基于特征融合尺度自适应核相关滤波器(SAMF)跟踪算法[9]和CN跟踪算法[14]。

4.1 定性分析

5种算法在8个测试视频的跟踪结果如图3所示。

由图3可以发现,本文提出的基于多特征融合变尺度的核相关目标跟踪算法的跟踪结果随着目标尺度的变化而改变跟踪框的大小,并能适应各类复杂条件下的目标准确跟踪。

4.2 定量分析

取VOR≥50%计算5种算法在8个测试视频集的成功率(SuccessRate,SR),如表1所示。

图3 5种算法在8个测试视频的跟踪结果

%

视频序列本文算法SAMFKCFCNCSKJogging97.496.722.522.522.5Trellis10099.684.266.871.2Woman96.393.093.128.828.8Deer10088.780.398.698.6Bird99.097.056.698.062.6Skating99.599.397.097.597.3CarScale55.659.963.4951.644.8David10099.695.896.282.2平均值93.591.774.170.063.5

注:加粗字体表示最优结果,斜体字体表示次优结果。

由表1可知,本文算法在8个测试视频集跟踪平均成功率为93.47%,较SAMF算法平均成功率提高1.74%,较KCF算法平均成功率提高19.35%,说明改进算法在5种算法中的VOR取值达到最大,在5种算法中达到最优的效果。

5种算法在8个测试视频的平均中心位置误差(Median Center Location Error, MCLE)值比较结果如表2所示。

由表2可知,本文算法在8个测试视频集跟踪MCLE值中是5种方法中最小的,并且取得最小的MCLE值为14 pixel,较SAMF算法的MCLE值降低6 pixel,较KCF算法的MCLE值降低18 pixel,说明本文算法与其他4种算法的跟踪结果相比,本文算法的跟踪结果更接近目标的真实位置。

表2 5种算法在8个测试视频的中心位置误差的平均值比较结果 pixel

视频序列本文算法SAMFKCFCNCSKJogging141588101135Trellis615192119Woman133243214207Deer822211514Bird1316212538Skating1516191818CarScale3626252783David314182817平均值1420325666

注:加粗字体表示最优结果,斜体字体表示次优结果。

对比SAMF跟踪算法、KCF跟踪算法、CN跟踪算法、CSK跟踪算法和本文算法的平均处理速度(Average Frames Per Second,FPS)如表3所示。

表3 5种算法的处理速度对比 f/s

算法本文算法SAMFKCFCNCSKFPS364645112

由表3可知,KCF跟踪算法和CN跟踪算法采用单一的特征来描述目标外观,处理速度分别达到46 f/s和45 f/s,CSK跟踪算法采用原始像素来描述目标外观,因此处理速度为最快,达到112 f/s。本文算法和SAMF跟踪算法都是采用多特征描述目标并进行融合,计算量大,因此速度较慢,本文算法采用分块的HSV颜色直方图和PCA-HOG特征融合来增强目标外观描述,处理速度最慢,为3 f/s。可见新算法取得较好的跟踪效果是以牺牲时间为代价的。

4.3 具体分析与评价

通过定性分析和定量分析,并从图3、表1和表2中可以看出,与其他4种算法相比,本文算法在跟踪性能上有很大的提高。下面具体分析不同视频在不同复杂场景下的跟踪情况。

4.3.1 遮挡、形变、旋转及快速运动实验结果

图3的Jogging、Woman、Bird及CarScale视频中目标均出现部分遮挡或全遮挡的情况。由图3a、3c、3e和3g可见,SAMF算法及本文算法都具有较强的抗遮挡能力,在遮挡后恢复有效的跟踪,其他方法发生遮挡时都比较敏感导致跟踪失败,结合表1和表2,本文算法在遮挡情况下具有最高SR值和最小MCLE值,实现了遮挡情况下的准确跟踪。Jogging、Woman、Bird及Skating视频中目标还存在旋转的情况,本文算法的跟踪结果相比其他4种算法较好。Bird视频中目标经历多次旋转变化,只有本文算法和SAMF算法可完成跟踪任务,但本文算法更接近目标的真实位置,其他方法偏差较大。Deer、Bird及CarScale视频中目标都存在快速运动的情况,其中CarScale视频中的车辆加速前进,由图3可见,本文算法能在目标快速运动的情况下取得最佳的结果,其SR值比其他算法都有很大提高。图3、表1和表2结果说明本文算法具有较强的抗遮挡能力,并且对于形变、旋转及快速运动等场景的跟踪结果较好。

4.3.2 尺度、光照、姿态变化及背景干扰情况的实验结果

图3所选择的视频集Woman和CarScale都存在较大的尺度变化,视频集Woman在第575帧后由于镜头的拉伸使目标尺度产生较大的变化,视频集CarScale在第200帧以后由于车辆的加速前进,目标尺度产生很大的变化。由图3、表1和表2可以看出,本文算法能根据目标尺度变化自适应调整跟踪框的大小,在尺度自适应方面也取得较好的效果,但由于CarScale视频中目标加速前进后帧间尺度变化较大,因此跟踪框会变小,本文算法在相邻两帧间尺度变化较大情况下跟踪效果稍差。视频集Skating1、Trellis和David存在多种复杂因素的影响,影响最大的是光照变化和背景干扰,视频集Skating1中目标快速从阴影处滑到红光的场景中,目标的光照急剧变化,同时目标的外观也产生姿态变化。本文算法的MCLE取得较小值且SR取得较大值,说明本文算法在光照变化的复杂场合下,能进行鲁棒有效的跟踪。Deer视频还存在背景杂波和低分辨率等情况,本文算法在复杂的背景干扰也取得最佳的效果。

综合以上实验结果分析可知,本文算法采用多种特征进行描述目标,运用LKF进行特征融合或快速计算相邻两帧目标相似度和目标尺度自适应策略,使得目标正确跟踪的SR平均值达到较高,MCLE值达到最低,跟踪效果达到最佳,虽然以牺牲时间来获取较高的鲁棒性,但在遮挡、目标形变、光照变化、背景杂波和尺度变化小等复杂场景中,跟踪效果优于其他算法,但对于两帧间尺度变化较大时,跟踪误差累积会导致跟踪失败,因此本文算法适用于跟踪要求精度高、处理速度要求不高的复杂场景下。

5 小结

本文提出一种基于多特征融合变尺度的核相关目标跟踪算法,将多通道HOG特征和HSV分块的颜色直方图特征通过LKF进行融合来训练样本增强分类器的性能,采用LKF函数计算候选区域在7个尺度方向与目标的最大响应值得到目标尺度信息,并使用新目标图像为训练样本更新目标的外观模型和尺度模型来跟踪运动目标。

实验结果表明,该算法利用目标本身丰富的颜色特征描述目标外观,增强目标外观描述能力,在多个尺度方向上获取尺度信息,解决出现的目标尺度变化问题。本文方法在复杂场景下具有较高的鲁棒性和跟踪精度,适用于跟踪要求精度高、处理速度要求不高的复杂场景下,但对相邻两帧间运动目标尺度变化较大的问题,有待于进一步研究。

[1] 高文,朱明,贺柏根,等.目标跟踪技术综述[J].中国光学,2014,7(3):365-373.

[2] 彭爽,彭晓明.基于高效多示例学习的目标跟踪[J].计算机应用,2015,35(2):466-469.

[3] 李宏波,郑世宝,周芹.一种改进的长时间压缩感知跟踪算法[J].电视技术,2016,40(4):22-26.

[4] HENRIQUES J, CASEIRO R, MARTINS P, et al. Exploiting the circulant structure of tracking-by-detection with kernels[C]//Proc. the 12th European Conference on Computer Vision, LNCS 7575. Berlin: Springer, 2012:702-715.

[5] BOLME D S, BEVERIDGE J R, DPAPER B A, et al. Visual object tracking using adaptive correlation filters[C]//Proc. 2010 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society,2010:2544-2550.

[6] GALOOGAHI H K, SIM T, LUCEY S. Multi-channel correlation filters[C]//Proc. 2013 IEEE International Conference on Computer Vision. Piscataway: IEEE,2013:3072-3079.

[7] HARE S, SAFFARI A, TORR P H S. Struck: structured output tracking with kernels[C]//Proc. 2011 IEEE International Conference on Computer Vision. Piscataway: IEEE,2011:263-270.

[8] HENRIQUES J, CASEIRO R, MARTINS P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE transactions on pattern analysis and machine intelligence, 2015, 37(3):583-596.

[9] LI Y, ZHU J K. A scale adaptive kernel correlation filters tracker with feature integration[C]//Proc. 2014 European Conference on Computer Vision-ECCV 2014 Workshops, LNCS 8926. Berlin: Springer,2014:254-265.

[10] FELZENSZWALB P F, GIRSHICK R B, MCALLESTER D, et al. Object detection with discriminatively trained part-based models[J]. IEEE transactions on pattern analysis and machine intelligence,2010,32(9): 1627-1645.

[11] 余礼杨,范春晓,明悦.改进的核相关滤波器目标跟踪算法[J].计算机应用,2015,35(12):3550-3554.

[12] 胡昭华,邢卫国,何军,等.多通道核相关滤波的实时跟踪方法[J].计算机应用,2015,35(12):3544-3549.

[13] 张雷,王延杰,孙宏海.采用核相关滤波器的自适应尺度目标跟踪[J].光学精密工程,2016,24(2):448-459.

[14] DANELLJAN M, KHAN F S, FELSBERG M, et al. Adaptive color attributes for real-time visual tracking[C]//Proc. 2014 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2014:1090-1097.

[15] 姜兰池,沈国强,张国煊.基于HSV分块颜色直方图的图像检索算法[J].机电工程,2009,26(11):54-57.

[16] EEVERINGHAM M, VAN G L, CHRISTOPHER K, et al. The pascal visual object classes (VOC) challenge[J]. International journal of computer vision,2010,88(2):303-338.

[17] WU Y, LIM J, YANG M H. Online object tracking: a benchmark[C]//Proc. 2013 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2013:2411-2418.

李 凯(1992— ),硕士生,主要研究方向为目标跟踪;

刘 颖(1972— ),女,博士,高级工程师,主要研究方向为图像检索;

李 娜(1981— ),女,硕士,讲师,主要研究方向为目标跟踪和机器学习;

戚秀真(1981— ),女,硕士,高级工程师,主要研究方向为图像处理。

责任编辑:薛 京

Object tracking algorithm based on blocking multiple feature integration and scale-variant

LI Kai1, LIU Ying1, LI Na1, QI Xiuzhen2

(1.SchoolofCommunicationandInformationEngineering,Xi’anUniversityofPostsandTelecommunications,Xi’an710061,China;2.SchoolofInformationEngineering,Chang’anUniversity,Xi’an710064,China)

To enhance description capability of objects appearance in color video and to solve the problem of object scale-variant during tracking process, object tracking algorithm based on blocking multiple feature integration and scale-variant is proposed. The object can be tracked accurately under different challenge factors by proposed algorithm. Firstly, HSV color histogram features and PCA-HOG features of object region block are extracted. After using linear kernel function fuses the two features, kernelized correlation filter models are obtained by linear ridge regression function. The degree of similarity between the tracking object and candidate region can be calculated by linear kernel function and the maximum response of the classifier on 7 scale spaces are obtained. Finally, the model parameters are updated with the scale adaptive template. The experimental results show that the algorithm can better adapt to object scale-variant in color video and remain high robustness in complex scenes.

object tracking; multiple feature integration; scale-variant; linear kernel function

李凯,刘颖,李娜,等.基于分块的多特征融合变尺度目标跟踪算法[J]. 电视技术,2017,41(1):6-13. LI K, LIU Y, LI N, et al.Object tracking algorithm based on blocking multiple feature integration and scale-variant[J]. Video engineering,2017,41(1):6-13.

TP391.4

A

10.16280/j.videoe.2017.01.002

公安部科技强警基础专项(2015GABJC5);陕西省国际科技合作计划资助项目(2015KW-014);陕西省教育厅专项科研计划资助项目(15JK166I);西安邮电大学研究生创新基金资助项目(CXL2015-22);西安市碑林区应用技术研发项目(GX1502)

2016-05-09