基于三维彩色点云的物体识别算法

吴婷璇,谢 刚,赵 婕

(太原理工大学 智能控制与智能信息处理实验室,山西 太原 030024)

基于三维彩色点云的物体识别算法

吴婷璇,谢刚,赵婕

(太原理工大学 智能控制与智能信息处理实验室,山西 太原030024)

随着新一代深度传感器的出现,使用三维(3-D)数据成为物体识别研究的热点,而且提出了很多点云特征描述子。针对传统的采用点云形状特征描述子在目标描述方面的不足,提出了一种基于三维彩色点云的物体识别算法。首先提取点云数据的视点特征直方图(VFH)和颜色直方图(CH),然后对提取的形状特征和颜色特征分别通过支持向量机(SVM)进行预分类,最后将上述2个识别结果进行决策级融合。提出的算法在Washington RGB-D数据集进行训练和测试。结果表明,该方法与传统的采用点云形状特征描述子相比,其物体的正确识别率有了显著的提高。

三维彩色点云;VFH;颜色直方图;特征融合;SVM

移动机器人对其工作环境的有效感知、辨识与认知,是其进行自主行为优化并可靠完成所承担任务的前提和基础。如何实现场景中物体的有效分类与识别是移动机器人场景认知的核心问题。目前物体识别的重点逐渐集中于物体特征提取的研究上。提取特征的好坏决定不同的目标对象在高维特征空间中分离程度,好的特征能够有效地降低识别算法后续步骤的复杂度,达到良好的效果。

随着近年来3D传感器的发展,价格也不像以前的3D传感器那么昂贵,使用三维(3-D)数据成为物体识别研究的热点,并提出很多点云特征描述子。常用的点云特征描述子可以分为两类:局部特征描述子和全局特征描述子[1]。局部特征描述子主要描述关键点的局部特征,主要应用于曲面匹配。全局特征描述子主要描述点云的全局几何信息。全局特征描述子较局部特征描述子更为复杂,主要用于目标识别和形状检索领域。常用的全局特征描述子有:PFH (Point Feature Histogram)[2],VFH(Viewpoint Feature Histogram)[3], CVFH(Clustered View-point Feature Histogram)[4], ESF (Ensemble Shape Functions)[5]。由于Kinect等深度传感器获得的点云数据含有大量的噪声,在全局特征描述子中,VFH对噪声有很强的鲁棒性[6],在其准确率、稳定性和计算复杂度能保持很好的折衷,在点云识别中得到了很好地应用。但目前点云特征描述子主要针对物体的几何形状,忽视了颜色特征也是物体识别的关键因素之一。本文针对传统的采用点云形状特征描述子在目标描述方面的不足,提出了一种基于三维彩色点云的物体识别算法。首先分别提取点云数据的视点特征直方图(VFH)和颜色直方图(CH),然后对提取的形状特征和颜色特征分别通过支持向量机(SVM)进行预分类,最后将上述2个识别结果进行决策级融合。本文提出的算法在Washington RGB-D[7]数据集进行训练和测试。试验结果表明,本文提出的方法与传统的采用点云形状特征描述子相比,其物体的正确识别率有了显著性的提高。

1 融合特征构建

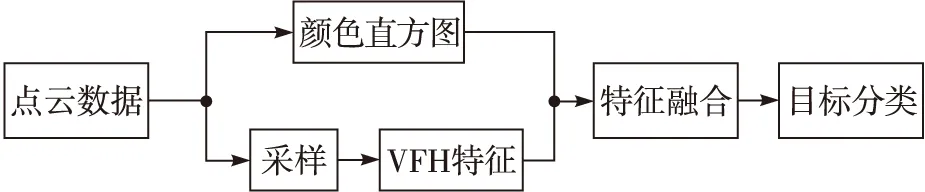

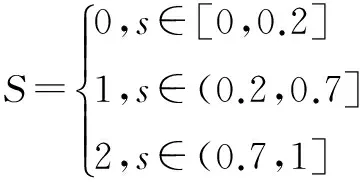

本文方法的流程如图1所示。图1中,融合特征由颜色直方图(Color Histogram, CH)和视点特征直方图(Viewpoint Feature Histogram, VFH)两种特征构成。

图1 本文方法的流程图

1.1视点特征直方图

视点特征直方图(View Feature Histogram,VFH)[8]是一种新型的特征表示方法,能够很好地进行点云识别。视点特征直方图在FPFH描述子的基础上,加入视点变量,使其构造的特征具有缩放不变性而且具有强大的识别力。它涉及3部分的特征分量:

1)对视点方向与每个法线之间角度进行统计,得到其直方图,来计算视点相关的特征分量。由于法线的视角在尺度变换下具有可变性,并不是计算每条法线的视角,而是将视点平移到查询点后计算其视点方向及其每条法线间的角度。并将其量化为128个区间。

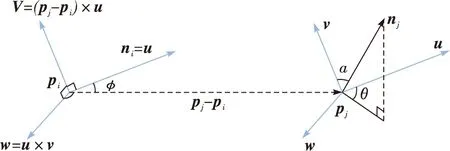

2)第二组特征分量是PFH中有涉及的3个角度α,φ,θ。如图2所示,pi和pj为点云上的两点,ni和nj为pi,pj对应的法向量,为了计算两点及其对应法线之间的相对偏差,在其中一个点上定义了一个固定的局部坐标系uvw(u=ni,v=(pj-pi)×u,w=u×v)。使用uvw坐标系,通过式(1)~(3)可以计算出α, φ, θ来表示两点及其对应法线之间的相对偏差。在VFH计算中,测量的是中心点的视点方向和每个点对应法线之间的角度。并将每一个角度量化为45个区间。

图2 定义一个固定的局部坐标系

α=v·nj

(1)

(2)

θ=arctan(w·nj,u·nj)

(3)

3)第三组特征分量是统计点云上所有点到其中心点的距离,并将其量化为45个区间。

最后形成的VFH是一个关于308维的特征向量。

计算VFH的步骤如下:

1)输入点云数据,对其以0.2 cm×0.2 cm×0.2 cm的体积元进行采样。

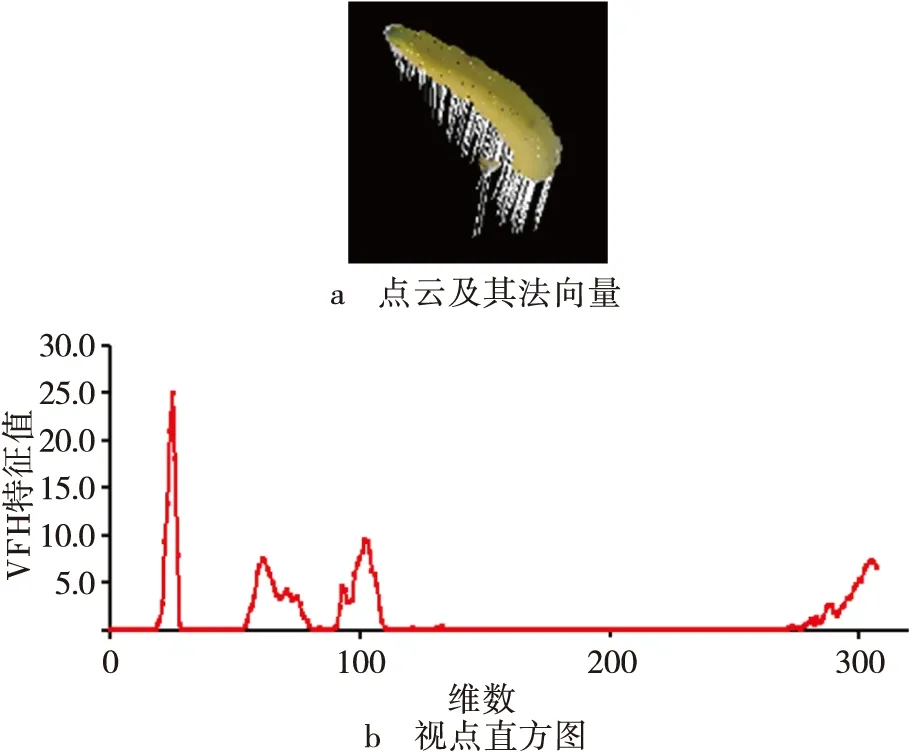

2)对采样后的点,估计其法向量。图3a为一个物体的点云及其法向量。

3)通过每个点的法向量,计算其VFH特征。如图3b对应的就是图3a的VFH特征。

图3 提取VFH特征

1.2颜色直方图

作为一种关键的图像特征,颜色特征值的大小取决于选取的颜色空间。目前常用的颜色空间有4种即RGB,HSV,Luv与YCrCb等。目前主要的提取方法有颜色直方图、颜色集、颜色矩等方法,其具有全局性。本文采用颜色直方图(ColorHistogtam,CH)来表征目标对象的特征。由于RGB颜色空间不能满足人类视觉特性需求,本文中采用HSV颜色直方图作为颜色特征。步骤如下:

1)将目标的每个点的颜色值由RGB颜色空间转变为HSV颜色空间。

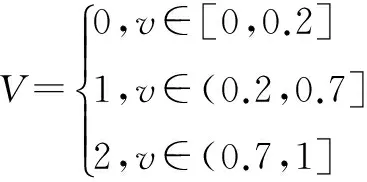

2)将H、S与V的空间分别设置为8级、3级与3级。即

(4)

(5)

(6)

3)构造出1维颜色特征向量

G=HQSQV+SQV+V

(7)

式中:QS是S的设置级数,QV是V的设置级数,QS=QV=3,即

G=9H+3S+V

(8)

由式(8)得到,G的取值范围为 [0,1,2,…,71],即整个点云的HSV空间被设置为72种颜色。通过计算得到72 bin的颜色直方图。图4为一个点云及其颜色直方图。

图4 提取颜色直方图

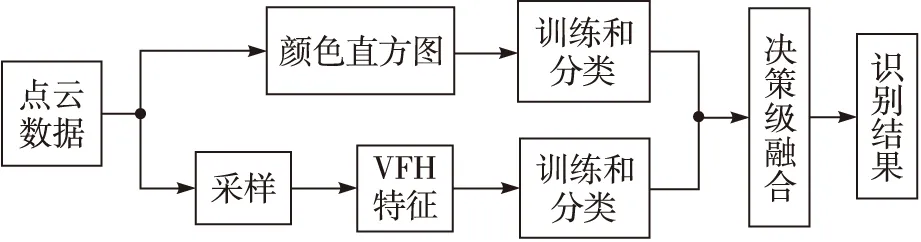

1.3特征融合

为了更有效地进行目标识别,对于获得的VFH特征和CH特征,采用决策级融合策略进行融合。其一般采用投票的方法,即当分类器输出结果不一致时,采用投票的方式来决定类别确定问题。先对不同特征进行训练,得到各特征所对应的分类器,然后将测试样本提取的特征用该特征所对应的分类器进行分类,得到属于每种类别的概率,由于各特征具有统计独立性,所以加法规则对属于每种类别的概率进行合并,从而得到识别结果。图5为本文采用的决策级融合流程图。

图5 决策级融合流程图

1.4模式分类

本文算法采用支持向量机(SVM)进行训练和分类。支持向量机是一种基于结构风险最小化原理、性能优良的机器学习方法。SVM的二分类方法通过寻找一个最优分类超平面,使得分类间隔(从这个超平面到两类样本中最近样本的距离之和)最大。多分类问题可以看作是多个二分类的组合,分别对每一个类别构建一个二分类器。

SVM的核类型及其相关参数的选择直接影响SVM分类器的分类效果。本文采用高斯核(RBF)的分类器。研究中,使用三折交叉验证,并使用GridSearch寻找最优的惩罚因子C和核参数gamma,对训练样本集进行分组,分为训练集和验证集。利用训练集对分类器进行训练,然后利用验证集来测试训练集得到的模型,根据验证集测试的结果来评价该分类器的性能指标,择取最优的惩罚因子和核参数。笔者设置C的取值集合为{1,2,…,210},gammar的取值集合为{2-10,2-9,…,1}。研究中,采用VFH特征进行识别时确定最优的惩罚因子和核参数分别为8和0.003 9,采用CH特征进行识别时确定的最优的惩罚因子和核参数分别为1 024和1。

2 实验结果与分析

2.1实验数据集

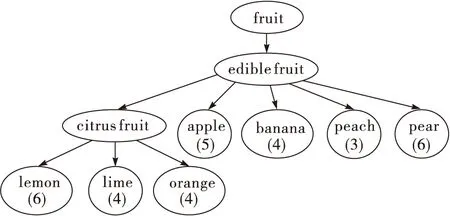

在这里采用华盛顿大学RGB-D数据集进行测试,这个数据集根据WordNet上义词/下义词的关系,形成一个分层的结构,包含50类300个不同的日常物品,一共有250 000个点云数据。将每个物体放在一个转盘上,使用一个Kinect类的3D摄像机记录该物体全角度的点云数据。这个数据集的每一个样本都包含有30°,45°,60°不同视角下的点云数据。为了验证本文算法的有效性,笔者在部分数据集上进行实验,所用的数据集的结构图如图6,图中括号内为每种类包含的例子的数目如图7中梨的例子,所采用的数据集所对应的部分样本如图8所示。算法测试在PC机上运行(配置:IntelCorei3CPU, 2.13GHz主频,内存2Gbyte)。

图6 所用数据集的分层结构

图7 梨的例子

图8 部分类别物体

2.2留一校验评价

留一校验(Leave-oneoutCrossValidation),其过程是随机从一组测定数据中抽取一部分数据来训练并建立模型,用其余的数据进行测试此模型。在本次实验中,从每一个类别中随机抽取一个例子进行测试,对其他例子的所有视角的点云数据进行训练。因为留一校验评价的随机性,笔者重复10次进行实验。

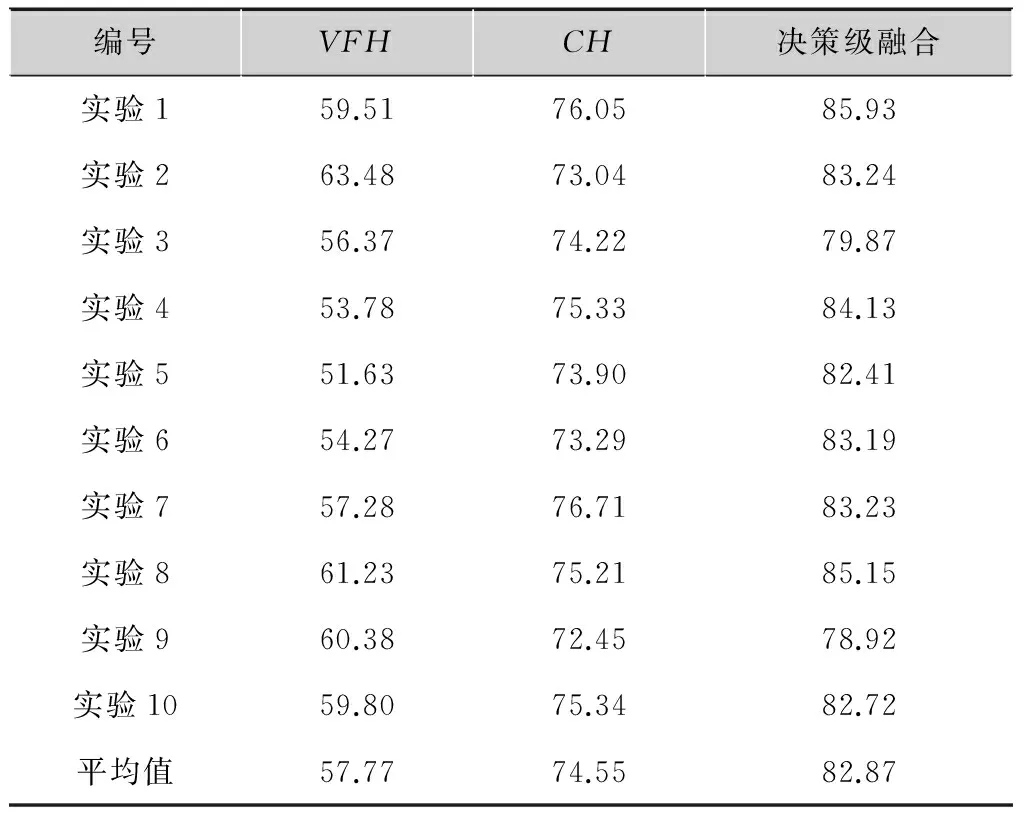

表1为10次实验的实验结果,评价整体的识别效果。从表1的10组实验结果来看,颜色特征在物体识别方面的效果比形状特征识别效果好。将两者特征进行决策级融合后,实现颜色信息和形状信息的互补,识别效果比单一特征识别效果有所提高。

表1训练识别结果

编号VFHCH决策级融合实验159.5176.0585.93实验263.4873.0483.24实验356.3774.2279.87实验453.7875.3384.13实验551.6373.9082.41实验654.2773.2983.19实验757.2876.7183.23实验861.2375.2185.15实验960.3872.4578.92实验1059.8075.3482.72平均值57.7774.5582.87

为了更好地分析实验结果,采用查准率(Precision)和查全率(Recall)对实验1中每一类别的实验结果进行进一步的分析。定义为

(9)

(10)

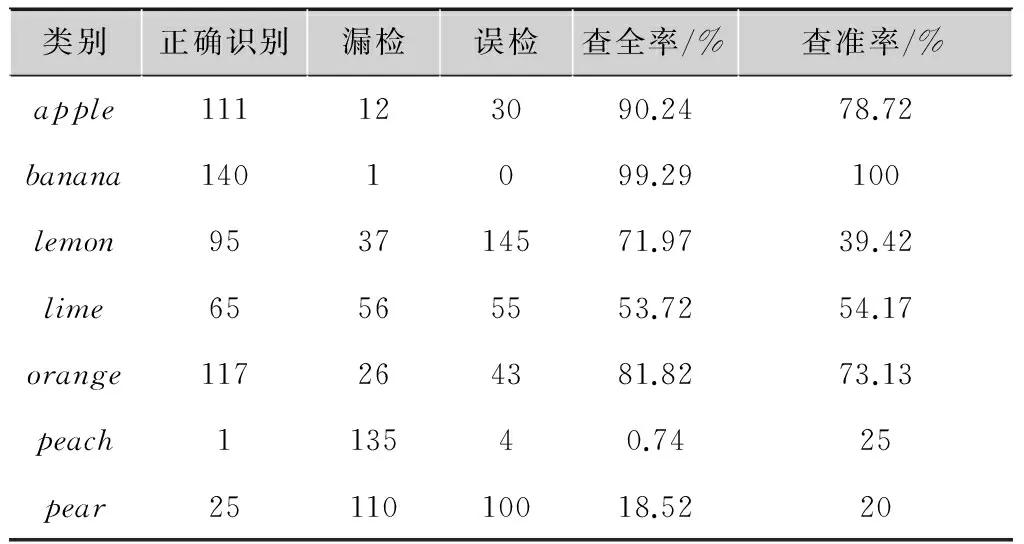

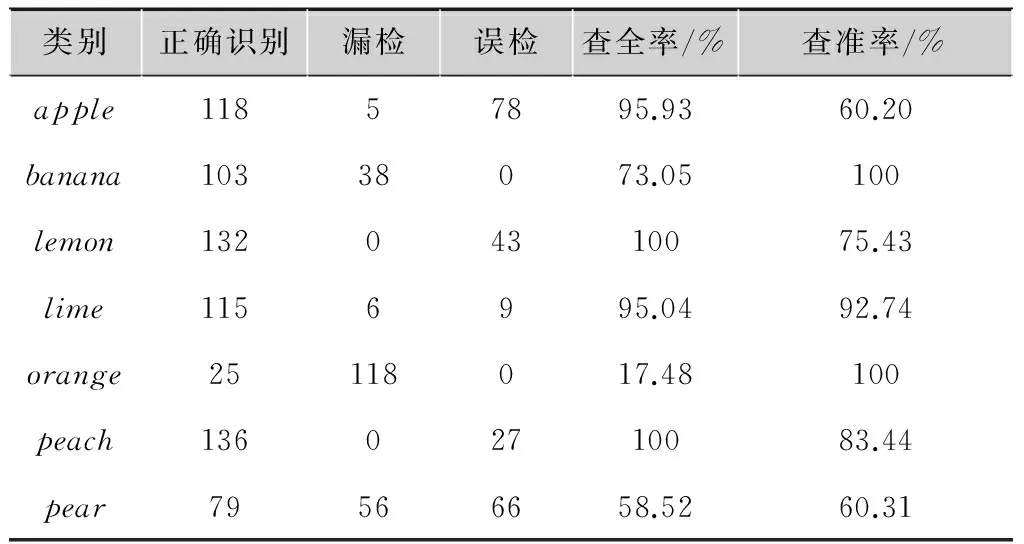

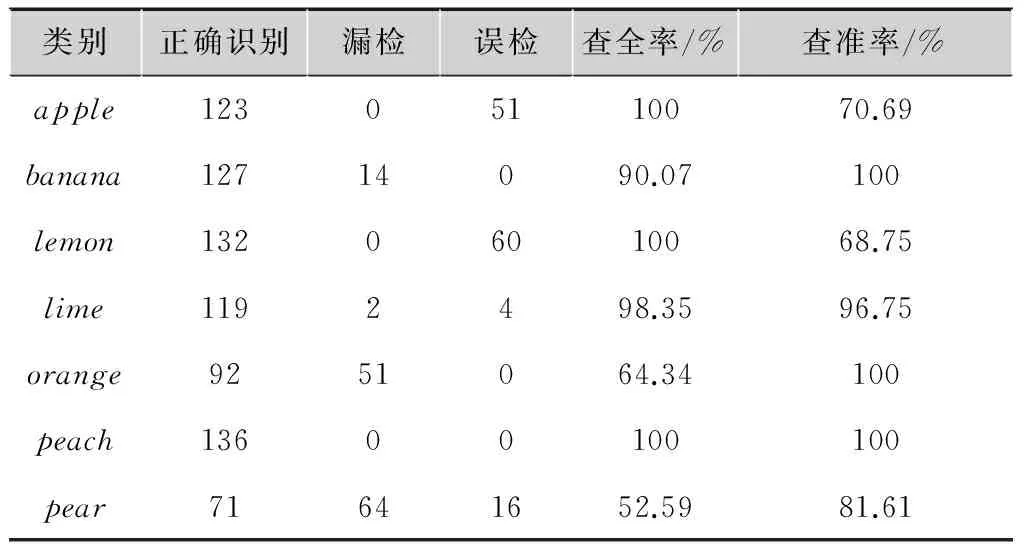

式中:C为查全率;Q为查准率;R为正确的识别结果数;O为漏检数;W为误检数。表2为采用VFH特征各类别的实验结果;表3为采用CH特征各类别的实验结果;表4为采用融合特征各类别的实验结果。

表2采用VFH特征各类别的实验结果

类别正确识别漏检误检查全率/%查准率/%apple111123090.2478.72banana1401099.29100lemon953714571.9739.42lime65565553.7254.17orange117264381.8273.13peach113540.7425pear2511010018.5220

表3采用CH特征各类别的实验结果

类别正确识别漏检误检查全率/%查准率/%apple11857895.9360.20banana10338073.05100lemon13204310075.43lime1156995.0492.74orange25118017.48100peach13602710083.44pear79566658.5260.31

表4采用融合特征各类别的实验结果

类别正确识别漏检误检查全率/%查准率/%apple12305110070.69banana12714090.07100lemon13206010068.75lime1192498.3596.75orange9251064.34100peach13600100100pear71641652.5981.61

从表2和表3各个类别的识别的查全率和查准率可以得出,对于apple类而言,由于其颜色形状在一定范围内的稳定性以及独特性,其在颜色和形状方面的识别率都很高。由于banana类在形状方面的特殊性,采用VFH形状特征进行识别,达到很好的识别效果。对于lemon、lime类而言,虽然在形状方面的识别效果不好,但是由于其颜色的独特性,使用颜色特征的识别效果较优于形状特征的识别效果。对于orange类而言,形状特征的识别结果较好于颜色特征的识别结果。由于peach类其形状的多样性,形状特征的识别效果不好,但是其颜色特征识别效果很好。对于pear类而言,形状和颜色的多样性使其VFH和CH的识别率都很低。颜色特征和形状特征在物体识别方面各有优势,对两种特征进行决策级的融合后,从整体上提高了各个类别的查全率和查准率,综合效果较好。

3 小结

本文针对传统的采用点云形状特征描述子在目标描述方面的不足,提出了一种基于三维彩色点云的物体识别算法,实现形状和颜色特征在决策级的互补。在WashingtonRGB-D数据库中进行的实验结果表明,本文方法取得了较高的查全率和查准率,综合效果较好,而且证明了简单特征的决策级融合能更好地进行物体识别。下一步工作可针对复杂场景中物体进行识别,并考虑其他方面的特征,进一步优化物体识别精度,取得更好的识别效果。

[1]ALDOMAA,MARTONZC,TOMBARIF,etal.Pointcloudlibrary[J].IEEErobotics&automationmagazine,2012,1070:9932.

[2]RUSURB,BLODOWN,MARTONZC,etal.Aligningpointcloudviewsusingpersistentfeaturehistograms[C]//Proc.IEEE/RSJInternationalConferenceonIntelligentRobotsandSystems. [S.l.]:IEEE, 2008:3384-3391.

[3]RUSURB,BRADSKIG,THIBAUXR,etal.Fast3Drecognitionandposeusingtheviewpointfeaturehistogram[C]//Proc. 2010IEEE/RSJInternationalConferenceonIntelligentRobotsandSystems(IROS). [S.l.]:IEEE,2010:2155-2162.

[4]ALDOMAA,TOMBARIF,RUSURB,etal.OUR-CVFH-oriented,uniqueandrepeatableclusteredviewpointfeaturehistogramforobjectrecognitionand6DOFposeestimation[M]//PatternRecognition.Berlin:Springer, 2012:113-122.

[5]WOHLKINGERW,VINCZEM.Ensembleofshapefunctionsfor3Dobjectclassification[C]//Proc.IEEEInternationalConferenceonRoboticsandBiomimetic. [S.l.]:IEEE,2011:2987-2992.

[6]SALIHY,MALIKAS,WALTERN,etal.Noiserobustnessanalysisofpointclouddescriptors[C]//Proc.AdvancedConceptsforIntelligentVisionSystems. [S.l.]:SpringerInternationalPublishing,2013:68-79.

[7]LaiK,BoL,RenX,etal.Alarge-scalehierarchicalmulti-viewRGB-Dobjectdataset[C]//Proc.IEEEInternationalConferenceonRoboticandAutomation.Shanhai:IEEE,2011:1-8.

[8]RUSURB,BLODOWN,BEETZM.Fastpointfeaturehistograms(FPFH)for3Dregistration[C]//Proc.IEEEInternationalConferenceonRoboticsandAutomation. [S.l.]:IEEE,2009:3212-3217.

吴婷璇(1991— ),女,硕士生,主研图像处理、人工智能;

谢刚(1972— ),博士生导师,主要研究方向为图像处理、模式识别、计算机视觉等;

赵婕(1978— ),女,博士生,主研图像处理、计算机视觉。

责任编辑:闫雯雯

Object recognition algorithm based on 3D color point-cloud

WU Tingxuan,XIE Gang,ZHAO Jie

(LaboratoryonIntelligentControlandIntelligentInformationProcessing,TaiyuanUniversityofTechnology,Taiyuan030024,China)

With the advent of new-generation depth sensors, the three-dimensional (3-D) data is used frequently on the object recognition, then a lot of point cloud feature descriptors are put forward. Based on the traditional using point cloud shape feature descriptors are insufficient, an object recognition algorithm based on the 3D color point cloud is proposed. First, the viewpoints histogram (VFH) and color histogram (CH) of a certain point cloud data is extracted. Then, the support vector machine is used to presort the extracted features respectively. Finally,the above two recognition results is fused using the decision level fusion. The proposed algorithm is tested on the Washington RGB-D dataset. Experiment results show that the algorithm can effectively improve the correct rate of object recognition.

3D point cloud;VFH;color histogram;feature fusion;SVM

TP391

A

10.16280/j.videoe.2016.09.025

太原市科技项目人才专项基金项目(120247-28);山西省研究生教育创新项目(2015BY23)

2015-11-17

文献引用格式:吴婷璇,谢刚,赵婕. 基于三维彩色点云的物体识别算法[J].电视技术,2016,40(9):122-126.

WU T X, XIE G, ZHAO J. Object recognition algorithm based on 3D color point-cloud[J]. Video engineering,2016,40(9):122-126.