基于非下采样双树复轮廓波变换和稀疏表示的红外和可见光图像融合

殷 明,段普宏,褚 标,梁翔宇

(合肥工业大学 数学学院,安徽 合肥 230009)

基于非下采样双树复轮廓波变换和稀疏表示的红外和可见光图像融合

殷明,段普宏*,褚标,梁翔宇

(合肥工业大学 数学学院,安徽 合肥 230009)

提出了一种基于非下采样双树复轮廓波变换(NSDTCT)和稀疏表示的红外和可见光图像融合方法,以改善传统的基于小波变换的图像融合方法的不足。该方法首先利用形态学变换处理源图像,利用NSDTCT变换进行图像分解得到低频子带系数和高频子带系数。根据高低频系数的不同特点,提出改进的稀疏表示(ISR)的融合规则用于低频子带;然后将改进的空间频率作为脉冲耦合神经网络的外部输入,提出基于自适应双通道脉冲耦合神经网络(2APCNN)的融合策略用于高频子带。最后通过NSDTCT逆变换获得融合后的图像。实验结果表明:本文方法在客观指标和视觉效果方面均优于传统图像融合的方法。与传统的NSCT-SR方法相比,实验的两组图像中4个客观指标:互信息(MI)、边缘信息保留量QAB/F,平均梯度 (AG)和标准差(SD)分别提高了9.89%、6.39%、104.64%、55.09%和9.53%、17.77%、95.66%、52.89%。

图像融合;红外图像;可见光图像;非下采样双树复轮廓波变换;稀疏表示;自适应双通道脉冲耦合神经网络;形态学变换

1 引 言

红外和可见光图像融合[1]就是将通过不同传感器获取的两幅图像整合成一幅质量更高的图像,其已广泛应用于计算机视觉、目标识别和军事等领域[2-3]。目前基于红外和可见光图像融合的算法主要在小波域中进行,但传统小波变换的方向性有限,不能高效地表示图像的纹理、轮廓和边缘等细节信息。为了有效地表示图像中的细节信息,人们提出了更好的多尺度分解工具,如Curvelet、Ridgelet和Contourlet等。但Contourlet变换[4]中进行了下采样操作,导致融合图像中出现伪吉布斯现象。为了解决这个问题,文献[5]提出了非下采样轮廓波变换(Non-subsampled Contourlet Transform, NSCT)方法,其克服了Contourlet变换的缺点,具有平移不变性,随后被应用于图像融合和去噪等[6-7]领域中,并取得了良好的视觉效果。针对NSCT计算复杂度较高的问题,学者们又提出了改进方法[8-9]。文献[8]将双树复小波(Dual-tree Complex Wavelet Transform, DTCWT)和NSCT中的非下采样方向滤波器组(Non-subsampled Directional Filter Banks, NSDFB)相结合,构造了非下采样双树复轮廓波变换(Non-subsampled Dual-tree Complex Contourlet Transform, NSDTCT)。文献[9]中,DTCWT的第一个尺度滤波器为“FSfarras”,其余尺度滤波器使用的是“dualfilt1”,而文献[10-11]已证明文献[8]构造的DTCWT中两棵树的频率反映有轻微的不同,且其结构不是完全对称的,鉴于此,本文首先考虑将文献[10]构造的Q-shift DTCWT和NSCT中的NSDFB结合提出一种改进的NSDTCT。由于其实现过程中没有进行下采样操作,因此具有平移不变性,而且还拥有高度的方向选择性和各向异性等优点。但文献[8]仅将NSDTCT应用在图像去噪中并取得了较好的效果,将NSDTCT应用在图像融合中还处于初始研究阶段。由于图像具有丰富的纹理信息和诸多的细节特征,因此本文将改进的NSDTCT作为图像的多尺度分解工具来实现红外和可见光图像融合。

然而,融合效果不仅依靠于图像的分解工具,还依靠于具体的融合规则。近年来,稀疏表示[12](Sparse Representation,SR)成为了一种新的信号处理工具,被人们应用于融合中。如:文献[13-14]将SR应用在多聚焦图像融合中,改善了融合图像的质量。但文献[13-14]都是利用SR直接对源图像进行融合,没有引入图像的多尺度变换工具,而多尺度变换工具能够从多分辨率角度对图像的细节特征进行表示,因此不引入图像分解工具会使融合图像中的细节特征变得模糊。于是,文献[15]将SR应用在小波域中以实现图像去噪,且获得了较好的结果。随后,文献[16]将SR和小波变换相结合应用于图像融合,但文献[16]仅根据最大值规则选择稀疏系数,融合规则比较简单,容易导致源图像中的有效信息遗失。

针对这一问题,本文提出了一种改进的稀疏表示(Improved Sparse Representation, ISR)方法,具体为将自适应模糊逻辑算法引入到SR中,对稀疏后的系数利用模糊逻辑算法自适应地选择出融合后的系数。脉冲耦合神经网络(Pulse Coupled Neural Network, PCNN)是人工神经网络第三代模型,具有全局耦合性及脉冲同步性等特点,被广泛应用于图像处理[17]中。但由于单通道PCNN每次只能对单幅图像进行信息提取,而实际应用中一般都是利用两幅图像进行融合,因此人们提出了双通道脉冲耦合神经网络[18](Dual-channel Pulse Coupled Neural Network, 2PCNN),并应用在图像融合[19-20]中。但2PCNN中的链接强度为固定值,外部输入时直接使用子带系数且脉冲输出阶段使用的是硬限幅函数,从而不能有效提取源图像中的特征信息。为了克服这些缺点,本文提出了一种自适应双通道脉冲耦合神经网络(Adaptive Dual-channel Pulse Coupled Neural Network, 2APCNN)。

根据以上分析,利用SR和2APCNN的优点,本文提出了一种新的红外和可见光图像融合算法。首先对红外和可见光图像进行形态学变换[21],再利用改进的NSDTCT分解图像以获得低频系数和高频系数:对低频系数,由于它的稀疏性相对较差,先对其进行稀疏表示,再利用自适应模糊逻辑算法选择稀疏后的低频系数;对于高频系数,提出了一种2APCNN融合策略来选择融合后的高频子带。最终,对低频和高频利用NSDTCT逆变换获得融合后的图像。

2 NSDTCT原理

2.1DTCWT

针对传统小波变换方向选择性少且不具有平移不变性的不足,文献[9]提出了DTCWT,但由于DTCWT中存在结构不是完全对称等缺点。Kingsbury等[10]人提出了采用Q-shift滤波器的Q-shift DTCWT。Q-shift DTCWT利用希尔伯特变换设计的两组滤波器组对图像进行并行处理,从而拥有良好的方向选择性和平移不变性。经过Q-shift DTCWT分解后,图像可以获得低频系数和6个不同方向的高频系数。

2.2NSDTCT

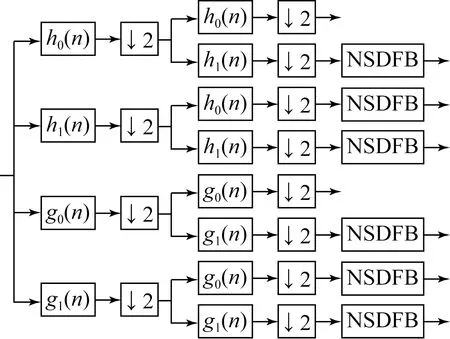

虽然Q-shift DTCWT克服了传统小波变换方向选择性小等缺点,但是通过Q-shift DTCWT获得的6个不同方向的高频子带系数仍然不能很好地表征图像中的细节特征。本文通过级联Q-shift DTCWT和NSDFB提出了改进的NSDTCT。其先利用Q-shift DTCWT对源图像进行分解获得双树结构子带系数;其次再利用NSDFB对高频子带系数进行分解,得到2n个方向的子带系数。从而具有更多的方向选择性,能够更好地表达图像中丰富的纹理特征和细节信息等。NSDTCT的分解结构如图1所示。

图1 NSDTCT的分解结构示意图

3 相关理论

3.1SR理论

图像稀疏表示是用过完备字典中少数非零原子的线性组合来刻画源图像。因为字典是过完备的,从而有许多方法可以用来表示源图像,图像稀疏表示的目的就是在字典中寻找可以描述源图像的最优线性组合。稀疏表示的模型可表示为:

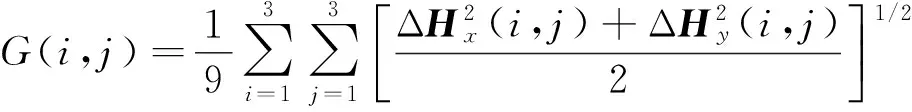

(1)

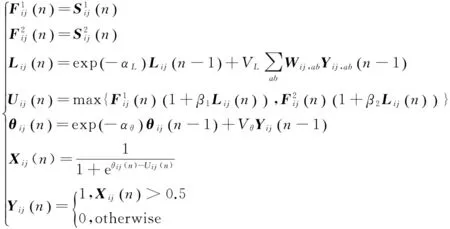

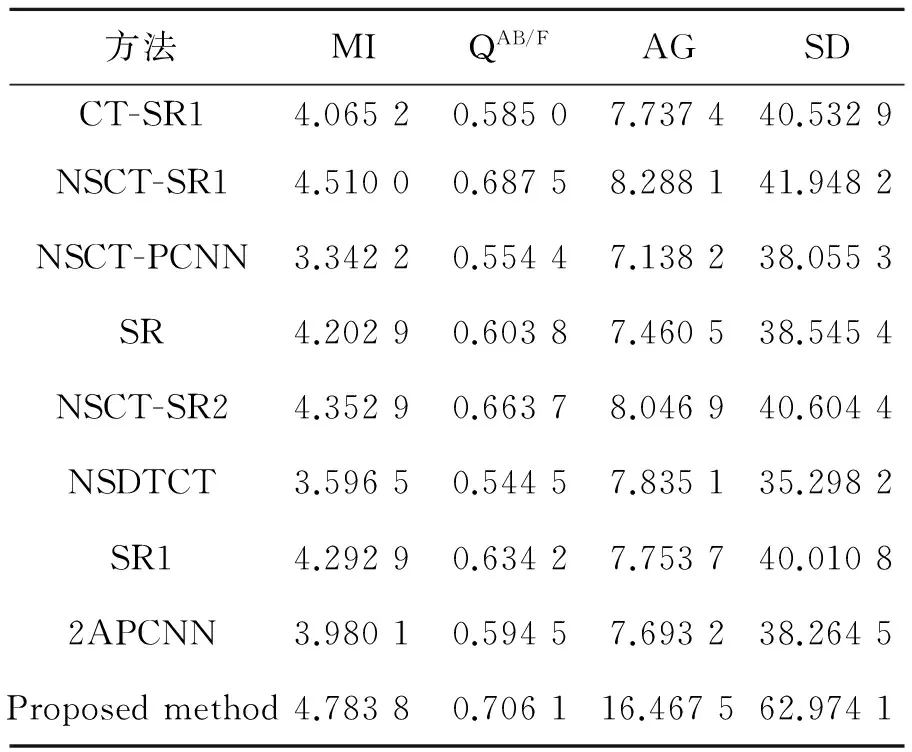

式中:x∈Rn为源信号,D∈Rn×m(n 3.22APCNN基本原理 传统的2PCNN中的链接强度被设置为常数,外部输入直接使用子带系数,而脉冲产生阶段使用的是硬限幅函数,这些都会导致融合效果不佳。针对传统2PCNN的不足,本文提出了一种自适应的双通道脉冲耦合神经网络(2APCNN),考虑人眼对边缘特征的敏感性,将平均梯度作为2APCNN的链接强度,自适应地选择相应的通道;将改进的空间频率作为其外部输入,并在脉冲输出阶段提出了一种软限幅S型函数。其具体的数学模型如下: (2) 平均梯度为: (3) (4) 4.1基本框架 图2为本文融合算法的结构流程图。主要步骤为:首先,采用形态学变换对源红外图像和可见光进行分别处理,再利用NSDTCT变换对处理后的图像进行分解,获得低频系数和一系列高频系数;其次,对低频系数先利用ISR进行稀疏处理,再利用自适应模糊逻辑算法选择融合后的系数。对高频系数,利用提出的2APCNN进行融合处理;最后,利用NSDTCT逆变换对融合后的低频和高频系数进行处理,从而获得一幅高质量的图像。 图2 融合算法流程图 4.2低频融合规则 经NSDTCT获得的低频子带是源图像的近似部分,它反映了源图像的主要能量信息。传统的低频子带融合策略是平均规则法。该方法简单却降低了融合图像的质量。文献[13]和[14]利用字典对低频子带进行稀疏,然后采用最大值规则选择稀疏后的低频系数,其融合规则比较简单,但易丢失源图像的有用信息。本文先利用源图像低频子带构成的样本集训练过完备字典,再将过完备字典对低频系数进行稀疏,然后采用模糊逻辑算法自适应地选择稀疏后的系数。 具体的低频融合规则如下。 步骤1:设源图像A、B的低频子带分别为LA和LB,采用滑动窗技术对Lk(k=A、B)进行分块处理,再把所有图像块转换成列向量[αA,αB]。 步骤2:从列向量中随机选取样本集,采用K-奇异值分解(K-Singular Value Decomposition,K-SVD )算法训练样本集得到字典D,再结合OMP算法计算出稀疏表示系数Sk(k=A、B)。 步骤3:利用模糊逻辑算法自适应地选择出融合后的系数。即: SF=ωA·SA+ωB·SB, 步骤4:将融合后的系数SF放至原来的位置,得到融合后的低频系数LF。 4.3高频融合规则 高频子带可反映图像的细节信息,但传统的高频子带融合方法大多采用“绝对值取大”,这将导致源图像的冗余信息丢失及引入人工信息等缺点。本文采用2APCNN作为高频子带的融合规则,并提出了一种改进的空间频率(Improved Spatial Frequency,ISF)作为2APCNN的外部输入,将平均梯度作为其链接强度,从而可以有效地提取图像的细节信息,获得较好的融合效果。 改进的空间频率定义为: (5) 其中: RF=[I(i,j)-I(i,j-1)]2 CF=[I(i,j)-I(i-1,j)]2 式中:I(i,j)表示图像在(i,j)处的系数,RF和CF分别表示行频率和列频率,MDF和SDF分别表示两个对角频率。 具体的高频融合规则如下。 步骤2:利用式(3)和式(4)计算高频子带的链接强度βk(i,j)(k=1,2)。 步骤3:通过式(2)分别得到神经元的链接输入Lij、神经元的内部状态Uij、门限阈值θij和点火输出幅度Xij。 步骤4:迭代步骤3直到所有神经元产生脉冲响应,然后选择融合后的高频系数: 其中: 为了检验本文所提融合方法的融合性能,本文对2组(图3)红外和可见光图像进行了实验验证,实验中图像均来自于http://www.imagefusion.org/。另外,本文将8种典型融合方法与提出的方法进行了比较。方法一和方法二分别采用CT和NSCT作为多尺度分解工具,其低频和高频融合规则与本文一致,但没有进行形态学变换,分别记为CT-SR1和NSCT-SR1;方法三:采用文献[20]的NSCT-PCNN的融合算法,其低频和高频分别采用PCNN进行融合,并将边缘能量作为外部输入;方法四:采用文献[14]的融合算法,记为SR;方法五:采用文献[16]的融合算法,将SR引入到NSCT的低通子带中,高频采用“绝对值取大”的融合策略,记作NSCT-SR2;方法六:采用NSDTCT分解源图像,其融合规则选用传统的低频取平均、高频取最大的策略,记为NSDTCT;方法七:采用本文改进的稀疏表示直接对源图像进行融合,记为SR1;方法八:采用2APCNN的融合算法,记为2APCNN。在融合实验中,2APCNN的参数设置为: αL=0.2,αθ=0.2,VL=1.5,Vθ=25,Wij,ab=[0.707,1,0.707;1,0,1;0.707,1,0.707]. 实验均在Matlab R2014a上运行,电脑配置为2.27 GHz主频,Corei3处理器,2 G内存,500 G 硬盘。本文还选用了4种评价指标来定量衡量实验的融合效果,分别为互信息[23](Mutual Information, MI)、边缘信息保留量[23]QAB/F,平均梯度[23](Average Gradient, AG)和标准差[23](Standard Deviation, SD)。MI用于衡量融合后图像从源图像中获得的信息量大小;QAB/F表示从源图像转移到融合后图像的边缘信息量;AG度量了融合图像的清晰度;SD用来测量融合图像中纹理信息的丰富程度。MI、QAB/F,AG和SD的值越大,就表明融合效果越佳。 图4和图5为通过不同方法获得的融合图像。从主观视觉来看,这几种方法都可以实现红外和可见光图像融合,但因为每种方法的多尺度分解工具和融合规则不同,使得融合后的图像质量也不一样。从融合结果图还可以看出,CT-SR因为在Contourlet变换时进行了下采样操作,故融合后图像中存在伪吉布斯现象;在NSDTCT方法中,由于融合规则过于简单,导致融合结果较差;文献[20]将PCNN与NSCT结合应用于图像融合,虽然在一定程度上提高了融合图像的质量,但是融合结果仍然不是很好;2APCNN方法由于会根据源图像中的有效信息自适应地选择相应的像素值,与PCNN相比,其融合效果有了一定的改善;文献[14]中,利用SR实现图像融合,但由于没有引入多尺度分解工具,因此不能充分地将源图像的细节信息提取到融合后的图像中,从而导致融合图像出现轮廓模糊;基于SR1的方法与SR方法相比,融合效果有了一定的提高,但细节信息仍然模糊;文献[16]中,将NSCT和SR相结合虽然可使融合图像的轮廓变得清晰,但由于融合规则不足,降低了融合图像的对比度;方法二中将本文的融合规则和NSCT结合改善了融合图像的视觉效果,但因为NSCT不是最优的多尺度分解工具,故融合结果仍不理想;本文先利用形态学变换对源图像进行增强,并采用NSDTCT作为图像的分解工具,再结合本文提出的融合规则,使得融合效果更好。综上可知,本文方法获得的融合图像的整体清晰度和对比度要明显优于其他方法,且融合图像的边缘信息更清晰,纹理等细节特征更丰富。 (a)可见光图像1(a)Visual image 1 (b) 红外图像1(b)Infrared image 1 (a)可见光图像2(a)Visual image 2 (b) 红外图像2(b)Infrared image 2 (a) CT-SR (b) NSCT-SR1 (c) NSCT-PCNN (d) SR (e) NSCT-SR2 (f) NSDTCT (g) SR1 (h) 2APCNN (a) CT-SR (b) NSCT-SR1 (c) NSCT-PCNN (d) SR (e) NSCT-SR2 (f) NSDTCT (g) SR1 (h) 2APCNN (i) Proposed method 表1和表2分别为图3中两幅红外和可见光图像通过9种方法融合后的客观评价指标。 表1 第1组图像通过不同方法融合的客观指标 由表1,2可知,与其他方法相比,本文方法的MI、QAB/F,AG和SD 4个客观指标均最高,这也与主观视觉效果一致。与其它8种方法中融合效果较好的文献[16]中的方法相比,本文的客观指标分别提高了9.89%、6.39%、104.64%、55.09%和9.53%、17.77%、95.66%、52.89%。其中通过比较方法一、方法二和本文方法的MI和QAB/F,可以发现本文的图像分解工具NSDTCT要优于传统的CT和NSCT,相比NSCT,本文的NSDTCT中两组图像的MI和QAB/F分别提高了6.07%、2.71%和3.45%、2.14%;本文提出的SR1的4个客观指标均要优于文献[14]的SR方法;与在空间域中实现图像融合的SR、SR1和2APCNN相比,本文的融合结果有了很大的提高。此外,本文AG和SD几乎是其他方法的2倍,说明本文方法有效改善了图像的清晰度和纹理信息。 表2 第2组图像通过不同方法融合的客观指标 本文先对源图像进行增强,再采用改进的NSDTCT作为图像分解工具,然后将稀疏表示和自适应双通道脉冲耦合神经网络将相结合并应用于图像融合中。实验表明,本文方法在客观数据和视觉效果上都要优于传统的图像融合算法,对比客观数据可知,本文方法的客观数据较其他方法分别提高了9.89%、6.39%、104.64%、55.09%和9.53%、17.77%、95.66%、52.89%。 [1]杨桄,童涛,陆松岩,等. 基于多特征的红外与可见光图像融合[J]. 光学 精密工程,2014,22(2):489-496. YANG G, TONG T, LU S Y,etal.. Fusion of infrared and visible images based on multi-features [J].Opt.PrecisionEng., 2014, 22(2): 489-496.(in Chinese) [2]曾祥通,张玉珍,孙佳嵩,等. 颜色对比度增强的红外与可见光图像融合方法[J].红外与激光工程,2015,44(4):1198-1202. ZENG X T, ZHANG Y ZH, SUN J S,etal.. One color contrast enhanced infrared and visible image fusion method [J].InfraredandLaserEngineering, 2015, 44(4): 1198-1202.(in Chinese) [3]陈贞,邢笑雪. 基于非下采样Shearlet变换与压缩感知的图像融合[J]. 液晶与显示, 2015, 30(6): 1024-1031. CHEN ZH, XING X X. Image fusion algorithm based on non-subsampled Shearlet transform and compressed sensing [J].ChineseJournalofLiquidCrystalsandDisplays, 2015, 30(6): 1024-1031.(in Chinese) [4]DO M N, VETTERLI M. The contourlet transform: an efficient directional multiresolution image representation [J].IEEETransactionsonImageProcessing, 2005, 14(12): 2091-2106. [5]da CUNHA A L, ZHOU J P, DO M N. The nonsub-sampled contourlet transform: theory, design, and applications [J].IEEETransactionsonImageProcessing, 2006, 15(10): 3089-3101. [6]杨粤涛,朱明,贺柏根,等. 采用改进投影梯度非负矩阵分解和非采样Contourlet变换的图像融合方法[J]. 光学 精密工程, 2011, 19(5): 1143-1150. YANG Y T, ZHU M, HE B G,etal.. Fusion algorithm based on improved projected gradient NMF and NSCT [J].Opt.PrecisionEng., 2011, 19(5): 1143-1150.(in Chinese) [7]殷明,刘卫. 非下采样Contourlet变换域混合统计模型图像去噪[J]. 光子学报, 2012, 41(6): 751-756. YING M, LIU W. Image denoising using mixed statistical model in nonsubsampled Contourlet transform domain [J].ActaPhotonicaSinica, 2012, 41(6):751-756.(in Chinese) [8]YING M, LIU W, ZHAO X,etal.. Image denoising using trivariate prior model in nonsubsampled dual-tree complex contourlet transform domain and non-local means filter in spatial domain [J].Optik, 2013, 124(24): 6896-6904. [9]KINGSBURY N. The dual-tree complex wavelet transform: a new efficient tool for image restoration and enhancement [C].ProceedingsofEuropenSignalProcessingConforence, 1998: 319-322. [10]KINGSBURY N. A dual-tree complex wavelet transform with improved orthogonality and symmetry properties [C].InternationalConferenceonImageProcessing, 2000, 2:375-378. [11]KINGSBURY N G. Design of Q-Shift complex wavelets for image processing using frequency domain energy minimization [C].ProcessingofIEEEInternationalConferenceonImageProcessing, 2003: 1013-1016. [12]YANG B, LI S T.Multifocus image fusion and restoration with sparse representation [J].IEEETransactionsonInstrumentationandMeasurement, 2010, 59(4): 884-892. [13]彭真明,景亮,何艳敏,等. 基于多尺度稀疏字典的多聚焦图像超分辨融合[J].光学 精密工程,2014,22(1):169-176. PENG ZH M, JING L, HE Y M,etal.. Superresolution fusion of multi-focus image based on multiscale sparse dictionary [J].Opt.PrecisionEng., 2014, 22(1): 169-176.(in Chinese) [14]DIANA D N, ANUSMINA D J. Fusion and restoration of multifocus image using sparse representation [C].IEEE-InternationalConferenceonAdvancesinEngineering,ScienceandManagement, 2012:291-296. [15]YAN R M, SHAO L, LIU Y. Nonlocal hierarchical dictionary using wavelets for image denoising [J].IEEETransactionsonImageProcessing, 2013, 22(12): 4689-4698. [16]LIU Y, LIU S P, WANG Z F. A general framework for image fusion based on multi-scale transform and sparse representation [J].InformationFusion, 2015, 24(7):147-164. [17]陈广秋,高印寒,段锦,等. 基于奇异值分解的PCNN红外与可见光图像融合[J].液晶与显示,2015,30(1):126-136. CHEN G Q, GAO Y H, DUAN J,etal.. Fusion algorithm of infrared and visible images based on singular value decomposition and PCNN [J].ChineseJournalofLiquidCrystalsandDisplays, 2015, 30(1): 126-136.(in Chinese) [18]WANG Z B, MA Y. Medical image fusion using m-PCNN [J].InformationFusion, 2008, 9(2):176-185. [19]ZHANG B H, LU X Q, JIA W T. A multi-focus image fusion algorithm based on an improved dual-channel PCNN in NSCT domain [J].Optik, 2013, 124(20): 4104-4109. [20]CHIHIRO I, ZHANG S J, YOKO U,etal.. A novel fusion algorithm for visible and infrared image using non-subsampled contourlet transform and pulse-coupled neural network[C].IEEE-InternationalConferenceonComputerVisionTheoryandApplications(VISAPP), 2014: 160-164. [21]CHEN J, ZHANG B, QI Y,etal.. Image edge detection method based on multi-structure and multi-scale mathematical morphology [J].InternationalConferenceonMultimediaTechnology, 2010:1-4. [22]CUI P, NI L. Joint reconstruction algorithm for distributed compressed sensing [J].InfraredandLaserEngineering,2015, 44(12):3825-3830.(in Chinese) [23]张小利,李雄飞,李军. 融合图像质量评价指标的相关性分析及性能评估[J]. 自动化学报,2014,40(2):306-315. ZHANG X L, LI X F, LI J. Validation and correlation analysis of metrics for evaluating performance of image fusion [J].ActaAutomaticaSinica,2014,40(2):306-315.(in Chinese) 褚标(1967-),男,安徽怀远人,博士,副教授,1990年于安徽师范大学获得学士学位,2000年、2008年于合肥工业大学分别获得硕士、博士学位,主要从事图像处理、CAGD等方面的研究。E-mail: hfgdhbt@163.com 段普宏(1991-),男,安徽安庆人,硕士研究生,2014年于宿州学院获得学士学位,主要从事小波分析与应用、稀疏表示等方面的研究。E-mail: duanpu hong@126.com 导师简介: 殷明(1962-),男,安徽合肥人,博士,教授,1985年于安徽师范大学获得学士学位,1991年、2012年于合肥工业大学分别获得硕士、博士学位,主要从事小波分析与图像处理等方面的研究。E-mail: ymhfut@126.com (版权所有未经许可不得转载) Fusion of infrared and visible images combined with NSDTCT and sparse representation YIN Ming, DUAN Pu-hong*, CHU Biao, LIANG Xiang-yu (SchoolofMathematics,HefeiUniversityofTechnology,Hefei230009,China) *Correspondingauthor,E-mail:duanpuhong@126.com A novel fusion method of infrared and visible images was proposed based on Non-subsampled Dual-tree Complex Contourlet Transform(NSDTCT) and sparse representation to overcome the shortcomings of traditional image fusion method based on wavelet transform. With the proposed method, morphological transform was used to deal with source images, and then the source images were decomposed by the NSDTCT to obtain the low frequency sub-band coefficients and high frequency sub-band coefficients. According to the different characteristics of the low and high frequency coefficients, an Improved Sparse Representation (ISR) fusion rule was proposed for the low frequency sub-bands; Then, the improved spatial frequency was used as the external input of a pulse coupled neural network, and a fusion method based on the improved adaptive dual channel pulse coupled neural network (2APCNN) was presented for the high frequency sub-bands. Finally, the fused image was obtained by performing the inverse NSDTCT. Experimental results indicate that the proposed method outperforms the conventional image fusion methods in terms of both objective evaluation criteria and visual quality. As compared with conventional NSCT-SR method, the fusion quality indexes, Mutual Information(MI), Mount of edge Information(QAB/F), Average Gradient(AG) and Standard Deviation(SD) have increased by 9.89%, 6.39%, 104.64%, 55.09%, and 9.53%, 17.77%, 95.66%, 52.89%, respectively. image fusion; infrared image; visible image; Non-subsampled Dual-tree Complex Contourlet Transform(NSDTCT); sparse representation; Adaptive Dual Channel Pulse Coupled Neural Network(APCNN); morphology transform 2016-02-26; 2016-04-25. 国家自然科学基金资助项目(No.11172086);安徽省自然科学基金资助项目(No.1308085MA09);安徽省教育厅自然科学研究重点资助项目(No.KJ2013A216) 1004-924X(2016)07-1763-09 TP391.4 Adoi:10.3788/OPE.20162407.1763

4 基于NSDTCT和SR的融合规则

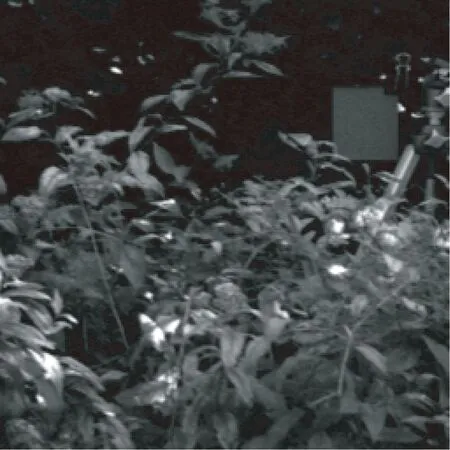

5 实验结果与性能分析

6 结 论