分块多特征自适应融合的多目标视觉跟踪*

施 滢,高建坡,崔 杰,孙丽娟,陈 宇

(南京理工大学电光院,江苏 南京210094)

0 引言

视频图像的多目标视觉跟踪是计算机视觉、人机交互领域的一个研究热点,它在安防监控、道路交通管制、客流量统计等领域有着广泛的应用。目前,国内外学者在多目标视觉跟踪领域的主要研究方法分成:特征提取、主动轮廓、模型以及运动估计等方法,并取得了一定的研究成果。基于主动轮廓的方法[1~3]是利用封闭的曲线轮廓表达运动目标,但初始化轮廓必须非常靠近目标真实边缘;基于模型的方法[4],是对目标建立二维或三维模型,虽能在一定程度上处理遮挡问题,但计算工作大,实时性较低;基于运动估计的方法[5],通过预测目标下一时刻的可能位置,但存在目标跟踪区域有限,无法自适应调整跟踪窗大小的问题;基于特征的方法,利用质心位置[7,8]、颜色[9,10]、Sift[11]、角点[12]等特征进行匹配跟踪,实现简单,可以跟踪各种形状目标,但利用单一特征容易受复杂环境及目标形变的影响。

由于多目标间的遮挡、背景的复杂性、光照的变化等因素使得多目标特征容易发生变化[13],如何可靠有效地通过运动目标表示,从而对多目标进行准确跟踪,具有重要的研究价值。本文结合特征和运动估计两种方法,对目标进行颜色、纹理和边缘特征描述,并对目标进行分块,建立多特征自适应融合子块直方图模型,在遮挡情况下,结合Kalman预测[14]判断子块遮挡情况来确定遮挡目标位置,提高多目标跟踪的可靠性。

1 多特征选择与融合

1.1 目标模型建立

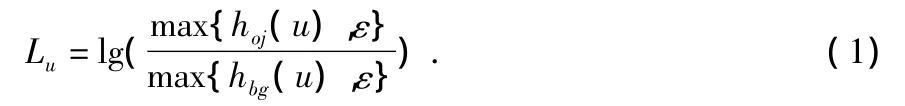

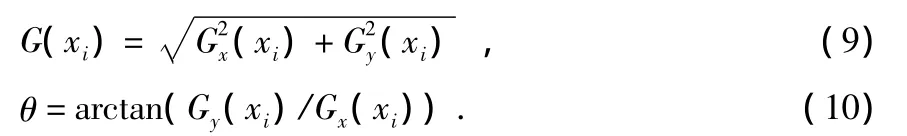

通过目标检测方法得到初始目标的外接矩形,但外接矩形中会引入背景,本文采用目标和背景区分度Lu来抑制框定目标中背景的分量。目标和背景区分度Lu定义为

其中,hoj(u)为特征值 u在目标直方图中的取值,hbg(u)为u在背景直方图中的取值。ε以防止分母为0。采用sigmoid函数将 Lu映射到区间(0,1)内,即 λu=

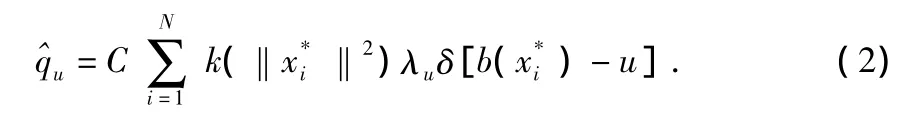

设{xi}i=1,…,M为候选目标区域的像素点集,中心点为y,则候选目标核加权特征直方图为

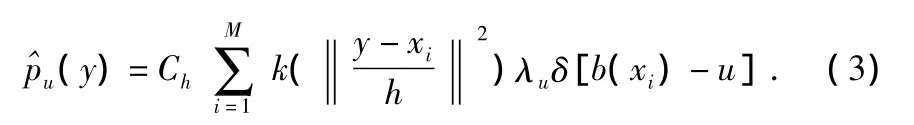

目标和候选目标之间的匹配度通过Bhattacharyya距离来度量,距离越小,说明两者越相似。它的定义为

其中,ρ(y)为 Bhattacharyya系数。

1.2 多特征选择

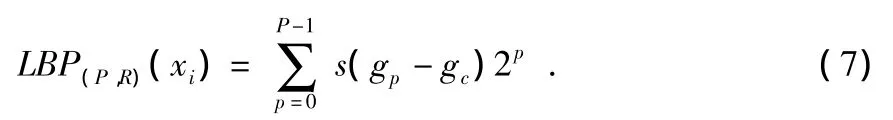

颜色是反映目标整体的特征。根据式(2)将颜色空间量化成83个子区间,得到核加权颜色直方图 qc=但颜色容易受到光照影响,而纹理是一种反映图像中同质现象的视觉特征。本文采用LBP纹理特征作为第二个描述目标的特征。LBP算子计算公式为

其中,P为领域值,R为半径,gc为中心点像素值,gp为以R为半径的各个像素值,函数s(x)定义为

本文采用LBP(8,1)算子,根据式(2)将纹理空间量化成28个子区间,得到核加权纹理直方图同时,边缘是图像细节特征,体现图像的高频细节信息。采用Sobel算子边缘检测方法得到水平边缘Gx(xi)和垂直边缘Gy(xi),像素的边缘幅值和方向为

将边缘方向角[0,2π)量化成36份,统计每个角度分格的像素边缘幅值,根据式(2)获得目标区域的核加权边缘直方图

1.3 自适应多特征融合

若将多特征分配相等的融合权值,或者分配固定的融合权值,则在遮挡时或目标与背景相似时等情况下,会影响目标跟踪的稳定性。为此,本文中采用自适应动态权值将多特征进行融合。根据式(6)计算目标和候选目标特征的Bhattacharyya系数ρj,j为特征个数,自适应融合距离公式为

2 分块多特征融合的目标跟踪

2.1 分块方式与目标定位

为了在遮挡情况下能够鲁棒地跟踪目标,本文将目标和候选目标进行分块,并根据式(11)计算每个子块的多特征融合Bhattacharyya系数,对目标进行匹配跟踪。首先将跟踪目标进行分块,本文采取图1(a)的分块方式。各子块中心相对于目标中心位置偏移量为 Δxi,i=1,…,t,t为子块个数。

图1 分块和目标背景示意图Fig 1 Sketch map of fragments object and background

根据式(11)计算每个目标子块与候选目标子块的多特征融合Bhattacharyya系数,当1,…,t}<th1时,说明有子块被遮挡,本文中 th1取 0.7。在遮挡时,本文采用置信度最大的子块的位置决定整体目标的位置。子块的置信度由子块与候选目标子块的多特征融合Bhattacharyya系数ρioj(y)和子块与背景的多特征融合Bhattacharyya系数 ρibg(y)共同决定。设各个子块置信度

2.2 轨迹预测的目标跟踪

当{max{ρi(y)},i=1,…,t}< th2时,表明子块全部被遮挡,本文th2取0.3。在目标发生严重遮挡时,目标的大部分信息都已丢失。此时对目标的跟踪最可靠的是目标的位置信息。Kalman滤波算法是一种经典的预测估计算法,对视频中人的运动而言,目标的运动可以看作是线性的,图像的噪声符合高斯分布,所以,可以利用Kalman滤波预测下一帧目标的位置。

Kalman是在最小均方误差准则下的线性系统最优估计方法,包含预测、更新两个部分。对系统的描述通过状态方程和观测方程来表示

状态方程

观测方程

其中,A为系统状态转移矩阵,H为观测矩阵,Wk为系统噪声,Vk为观测噪声。

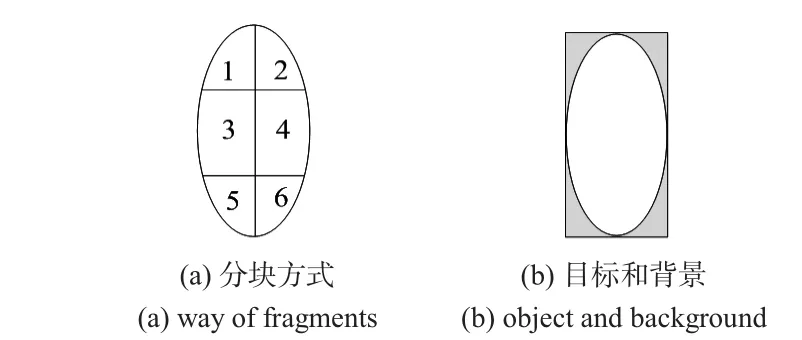

2.3 跟踪算法流程

本文算法原理框架如图2所示。

图2 算法原理框架Fig 2 Principle framework of algorithm

本文跟踪算法具体实现步骤如下

1)输入视频,当旧目标消失时,删除目标信息;当新目标出现时,对新目标分块,建立新目标的多特征空间。

2)利用Kalman滤波器作为预估计器,预测目标下一帧的位置。

3)目标和候选目标进行分块多特征融合匹配。若{min{ρioj(y)},i=1,…,t}< th1,认为目标被部分遮挡,选择置信度最大的子块的位置,再根据初始偏移量计算出跟踪目标位置。若{max{ρioj(y)},i=1,…,t}< th2,认为目标被全部遮挡,利用Kalman滤波器进行轨迹预测。

4)对未被遮挡的目标,更新特征空间。返回步骤(1)。

3 实验结果与分析

本文实验数据是利用HK-Vision摄像机采集的室内视频序列,视频大小为640像素×360像素。仿真实验硬件平台win8操作系统,主频2.3 GHz,内存4 GB;软件平台Visual Studio 2008和 Opencv2.3。

3.1 多特征自适应融合的多目标视觉跟踪

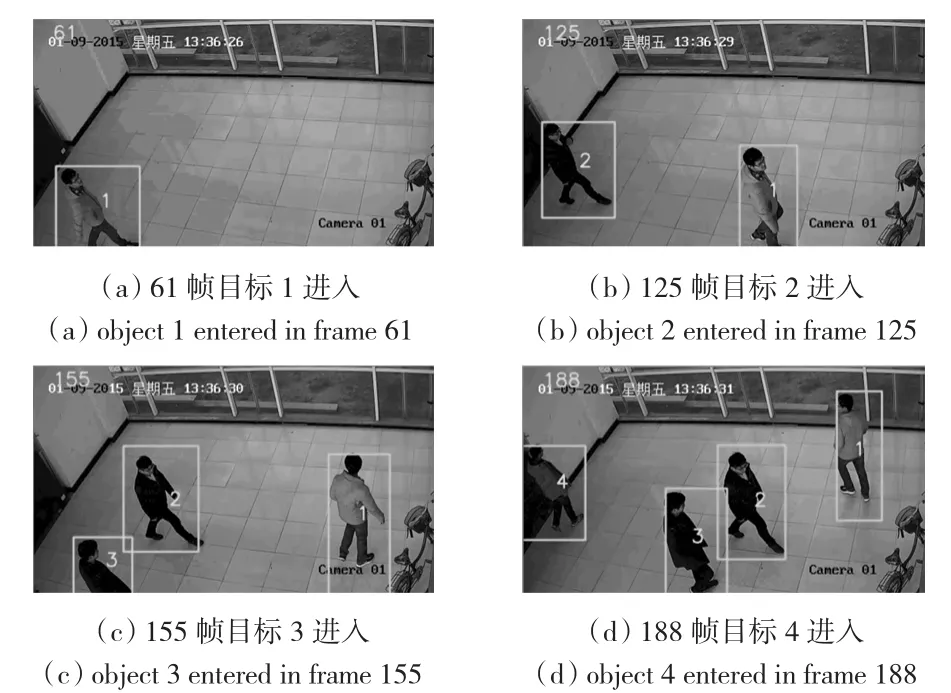

图3是多特征自适应融合的跟踪结果。视频先后出现4人,图3(a)目标1进入,图3(b)目标2进入,图3(c)目标3进入,图3(d)目标4进入。在跟踪过程中采用多特征自适应融合方法。图4(a)目标1从145帧到190帧内的自身相似度,图4(b)为目标2和3从145帧到190帧内的不同目标相似度,分别采用单一颜色特征和多特征融合的方法进行匹配。实验结果表明:多特征融合相对于单一颜色特征区分不同目标时有较好的跟踪效果。

图3 多特征自适应融合的多目标跟踪Fig 3 Multi-target tracking of multi-feature adaptive fusion

图4 相同目标和不同目标单一特征和融合特征相似度Fig 4 Similarity of single feature and fusion feature of the same and the different targets

3.2 遮挡时的分块多目标视觉跟踪

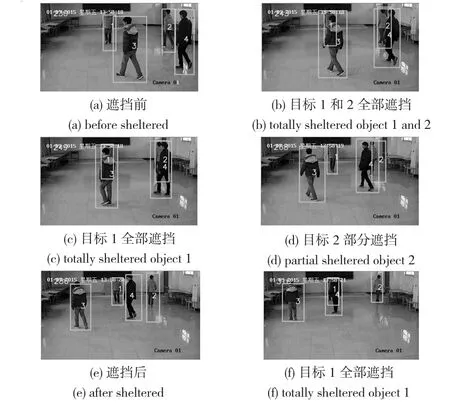

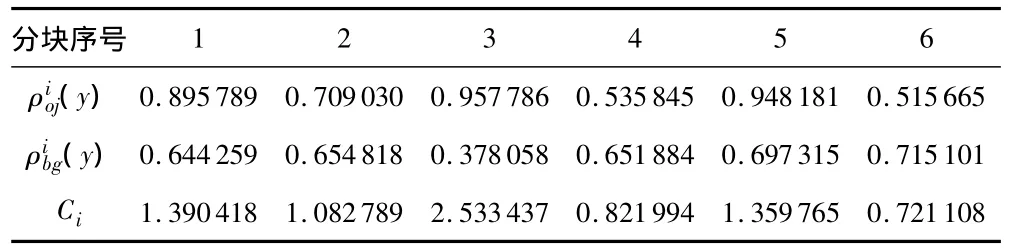

图5是发生遮挡的跟踪结果。视频先后出现4人,图5(a)4人遮挡前;图5(b)目标1和2部分遮挡;图5(c)目标1全部遮挡,目标2部分遮挡;图5(d)目标2部分遮挡;图5(e)4人遮挡后;图5(f)为目标1全部遮挡。图6(a)是第249帧目标2被目标4部分遮挡的截图,图6(b)是目标2模板,将目标和目标模版分块,分别采用分开多特征匹配,匹配结果如表1。选择置信度最大子块3,由子块3位置加上初始偏移决定整体目标2的位置。实验结果表明,本文方法有很好的跟踪效果。

图5 遮挡时的分块多目标跟踪Fig 5 Multi target tracking based on fragments when sheltered

图6 249帧目标2和模板目标分块示意图Fig 6 Sketch map of model target 2 and target 2 fragments in frame 249

表1 249帧2号目标子块置信度Tab 1 Confidence of fragments of target 2 in frame 249

4 结束语

本文对分块多特征自适应融合对目标视觉跟踪算法进行了研究。该算法采用目标底层颜色、纹理和边缘特征信息自适应融合,对不同目标采样单一颜色特征匹配平均值为0.680341,而采用融合特征匹配平均值为0.370283,体现了融合特征跟踪目标的优势;同时,算法对目标和模板目标分块匹配,结合Kalman预测能够鲁棒跟踪遮挡目标,通过多组实验表明:对遮挡目标识别效果达到95.3%,对每帧图像的平均处理时间为36.2 ms,实验结果证明了该算法可实现对多目标视觉跟踪,达到了实时性要求,且算法具有较强的鲁棒性和有效性。

[1]Paragios N,Deriche R.Geodesic active contours and level sets for the detection and tracking of moving objects[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2000,22(3):266-280.

[2]Hu W,Zhou X,Li W,et al.Active contour-based visual tracking by integrating colors,shapes,and motions[J].IEEE Transactions on Image Processing,2013,22(5):1778-1792.

[3]董春利,董育宁,刘 杰.基于粒子滤波和 GVF-Snake的目标跟踪算法[J].仪器仪表学报,2009,30(4):828-833.

[4]Ababsa F,Mallem M.Robust camera pose estimation combining 2D/3D points and lines tracking[C]∥2008 IEEE International Symposium on Industrial Electronics(ISIE),IEEE,2008:774-779.

[5]谷 静,史健芳.分布式粒子滤波算法在目标跟踪中的应用[J].传感器与微系统,2014,33(8):158-160.

[6]Yussiff A L,Yong S P,Baharudin B B.Parallel Kalman filterbased multi-human tracking in surveillance video[C]∥2014 International Conference on Computer and Information Sciences(ICOCINS),IEEE,2014:1-6.

[7]孙 凯,刘士荣.多目标跟踪的改进Camshift/卡尔曼滤波组合算法[J].信息与控制,2009,38(1):9-14.

[8]Yang T,Pan Q,Li J,et al.Real-time multiple objects tracking with occlusion handling in dynamic scenes[C]∥2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition(CVPR),IEEE,2005:970-975.

[9]李冠彬,吴贺丰.基于颜色纹理直方图的带权分块均值漂移目标跟踪算法[J].计算机辅助设计与图形学学报,2012,23(12):2059-2066.

[10]Nummiaro K,Koller-Meier E,Van Gool L.An adaptive colorbased particle filter[J].Image and Vision Computing,2003,21(1):99-110.

[11]钟 权,周 进,崔雄文.融合 SIFT特征的压缩跟踪算法[J].光电工程,2015,42(2):66-72.

[12]王向军,王 研,李 智.基于特征角点的目标跟踪和快速识别算法研究[J].光学学报,2007,27(2):360-364.

[13]Ross A A,Govindarajan R.Feature level fusion of hand and face biometrics[C]∥Int’l Conf on Defense and Security,International Society for Optics and Photonics,2005:196-204.

[14]Teutsch M,Kruger W,Beyerer J.Fusion of region and point-feature detections for measurement reconstruction in multi-target Kalman tracking[C]∥2011 Proceedings of the14th International Conference on Information Fusion,IEEE,2011:1-8.