视点合成中基于深度的空洞修复

杜 歆,邹 泷

(浙江大学信息与电子工程学系,浙江杭州310027)

视点合成中基于深度的空洞修复

杜 歆,邹 泷

(浙江大学信息与电子工程学系,浙江杭州310027)

为提高视点合成中空洞的修复质量,基于样本图像修复技术,提出利用深度信息进行修复的方法.通过深度图预处理、图像映射变换、合成深度图修复以及合成视图修复等步骤,实现对空洞区域的填充,得到虚拟视点视图.所提出的深度边缘单向膨胀预处理方法、先修复合成深度图再修复合成视图的策略以及匹配块的预编辑方法,可以提高最终合成视图的质量.实验结果表明:所提出方法在主观视觉对比、峰值信噪比(PSNR)以及运行耗时上优于现有方法,在图像边缘连续性的保持、前景和背景像素渗透现象的消除等方面具有较好的效果.

视点合成;空洞修复;深度图修复

虚拟视点合成是指用一个或多个视点的真实图像,通过相应参数,生成虚拟视点图像的过程.虚拟视点合成在虚拟现实、三维自由视点电视、人机交互、2D到3D视频转换等相关领域有着广泛的应用.目前,虚拟视点合成主要有2种方法:基于三维模型的绘制(model based rendering,MBR)和基于图像的绘制(image based rendering,IBR)[1].其中基于深度图像的绘制技术(depth image based rendering,DIBR)[2]只须输入参考视图和相应的深度图即可合成虚拟视点图像,是目前IBR方法中使用较为广泛的技术.

虽然DIBR易于实现,但是这种方法对深度图的精确度要求很高.如果深度图有错误,则会给视点合成结果带来较大的瑕疵,如:绘制后的图像中存在伪像、空洞等现象.除此之外,遮挡也是造成空洞的主要原因.为了消除这些空洞及伪像,学者们提出了一系列方法,这些方法大致可分为3类.1)层次化的深度图技术(layered depth image,LDI)[3],即图像的每一个像素点包含了多层深度的颜色信息.通过这种方式可以有效填充合成视图中由于遮挡所产生的空洞区域.文献[4]和[5]首先构造了全局背景,并以此为辅助填补映射结果中的空洞.王奎等[6]同样采用构造全局背景的方法修复Kinect的中深度图空洞.由于需要采集多层深度的颜色信息,这类方法存在的问题是采样复杂,数据量过大.2)深度图的预处理和合成视图的后处理.常用的方法是对深度图进行低通滤波平滑来减少合成视图中的空洞,并通过均值滤波、像素内插来修复合成视图中的较小空洞.Zhang等[7]采用高斯滤波对深度图进行预处理,Lee等[8]则选用了高斯双边非对称滤波器.高凯等[9]提出了À-Trous小波滤波方法,能够有效地保留深度图上的边缘.李应彬等[10]基于改进的双边滤波对深度图进行修复.这类方法对于较大空洞的修补效果并不理想.3)利用图像修复技术对空洞进行填补[11-12],即将二维图像的修复技术引入到立体图像空洞修复中.Ma等[13]在自由视点视频的修复过程中加入了深度信息的导引.Wu等[14]先将图像分为前景和背景,再利用分割信息对空洞进行修复.Xu等[15]在修复过程中采用先对深度图中空洞进行修复的策略.

本文提出一种新的空洞修复方法.首先提出一种深度边缘单向膨胀的预处理方法,该方法能有效抑制前景边缘深度误差所引起的合成视图中的像素渗透.其次,由于所合成的虚拟视角一般位于参考视角的水平方向上,如果视角右移,空洞会出现在前景右侧;如果视角左移,空洞则会出现在前景左侧,而且空洞处一般缺失的是背景像素.基于上述认识,本文在图像修复中将此与场景的深度信息相结合,有效提升图像修复结果.最后,在传统的基于样本的图像修复方法中加入深度辅助和匹配块预编辑的措施,得到较好的空洞修复效果.

1 整体流程

视点合成算法的整体流程如图1所示,算法仅需输入参考视图和对应的深度图,合成过程总共包含4个步骤:1)对深度图进行预处理,以消除合成视图的小空洞以及前景背景相互渗透的现象;2)对参考视图和预处理后的深度图进行像素映射变换,得到带有空洞的合成视图及其深度图;3)对合成深度图的空洞进行修复;4)用修复好的深度图对合成视图的空洞进行修复,得到最终结果视图.

图1 视点合成算法框图Fig.1 Flow chart of view synthesis algorithm

2 深度图预处理

在图像前景和背景的交界处,深度通常会发生显著变化,由于视角变化造成的遮挡,在合成的虚拟视图中会存在空洞区域.这些交界处的视点合成结果对输入的深度值错误异常敏感,极易出现前景像素和背景像素之间的互相渗透,从而造成明显的瑕疵.

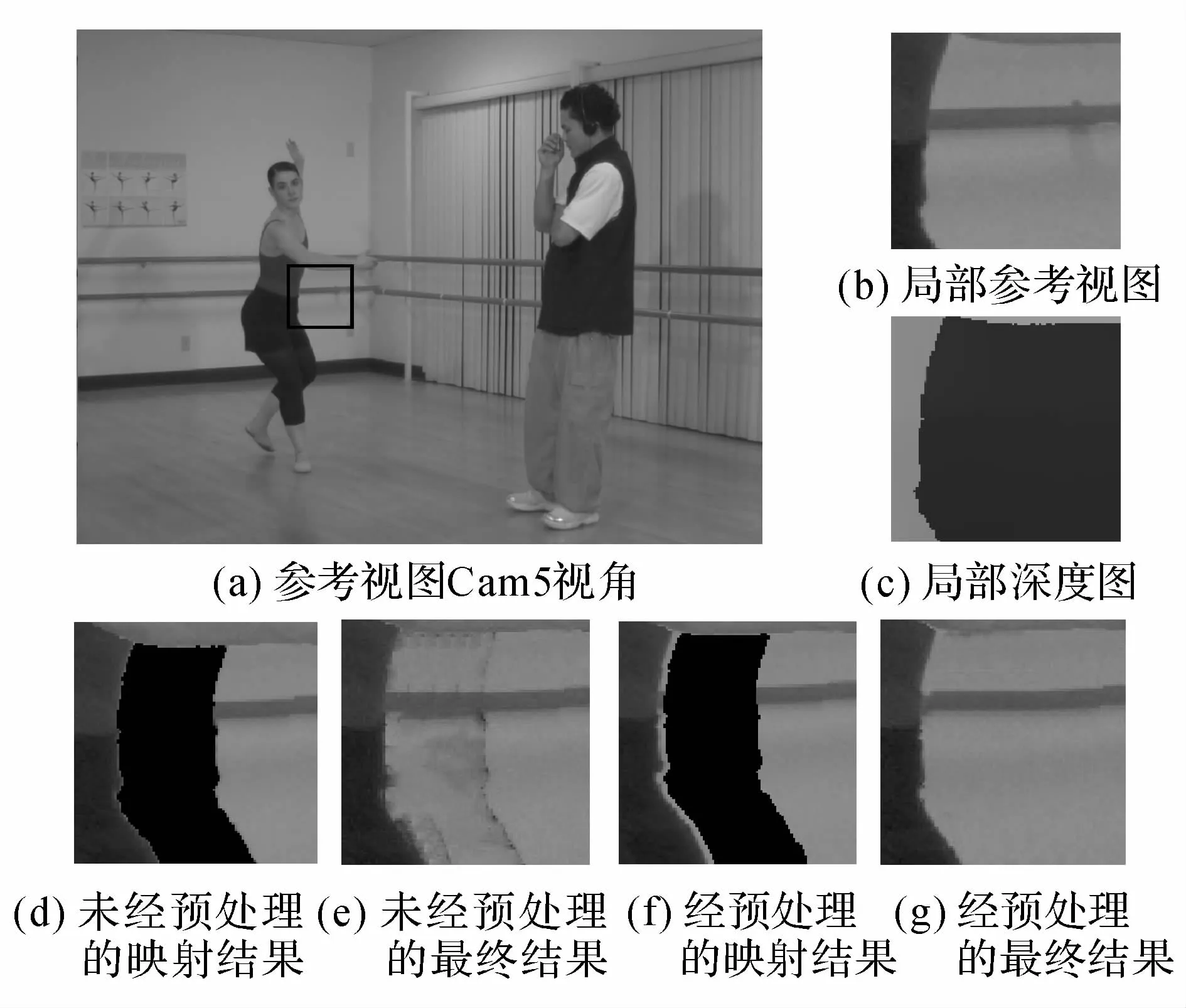

图2给出了采用微软“Ballet”序列[16]的实验结果,实验中以Cam5视角的第1帧为输入,合成Cam4视角.其中图2(a)为输入的Cam5视图,图中的黑框区域为典型的前景和背景交界处,图2(b)、(c)为该区域的放大图和相应的深度图.图2(d)和(e)分别为未经本文方法预处理的映射结果和填充后的结果,图中的黑色区域为由于遮挡造成的映射结果中的空洞区域.由于深度图在前景和背景交界处的不准确,在投影结果中很容易造成交界处前景像素和背景像素之间的混淆,使得边界不清晰.后续的空洞填充进一步将这种效应放大,从而形成明显的瑕疵.

图2 加入深度图预处理前后的合成视图结果Fig.2 Synthesis results before and after performing depth preprocessing

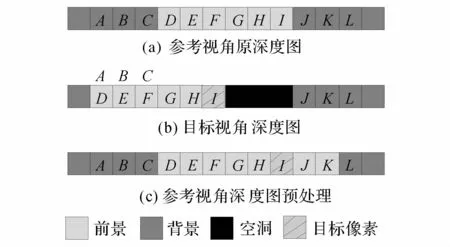

由于获得完全准确的深度图非常困难,为了有效消除这种相互渗透现象,提出一种深度边缘的单向膨胀方法,流程如图3所示.首先判断深度图中水平方向上相邻2点在映射变换后是否仍然相邻,若不相邻,则在该处产生空洞或发生像素重叠.这时需要选择这2点中深度值较大的前景像素继续进行判断.如果该点在映射变换后,被投射到新的背景上,则放弃该点的预处理,以避免前景边缘出现2种背景的突兀现象;反之,将该点的深度值向其水平邻域像素中膨胀,仅覆盖深度值小于该点的像素,图3中w为膨胀宽度.

图3 深度图预处理流程图Fig.3 Flowchart of depth map preprocessing

图4(a)为某视角原始深度图中的一行,A~L为该行中的像素.由像素值所代表的深度值可知,该行中A~C、J~L为背景像素,D~I为前景像素.为了判别这些在原始深度图中的像素在映射后是否相邻,先对这些像素进行像素映射变换(见图1中的映射变换),然后考察映射结果.如图4(b)所示,在图4(a)中相邻的像素C和D、像素I和J在图4(b)中不再相邻,像素C和D之间发生了重叠,而像素I和J之间产生了空洞.预处理选择其中深度值较大的前景像素,如上面的D和I.由于D被映射到新的背景A上,不会像I和J之间那样产生空洞,只须处理像素I.在原始深度图中将像素I的深度值赋给w邻域内深度值小于I的像素.实验中取w=2,将像素I赋给像素J、K,即J=I,K=I,得到图4(c)的预处理结果.

图4 深度图预处理Fig.4 Depth map preprocessing

通过上述深度边缘单向膨胀的预处理,原深度图中产生空洞的前景边缘会有所扩展.这能去除合成的虚拟视图的背景上的前景像素残留,相当于将空洞的背景一侧w单位宽度的像素移动拼接到前景边缘一侧,经预处理后的结果如图2(f)、(g)所示.

3 像素映射变换

像素点的映射变换是视点合成技术中一个重要的步骤.映射方式可分为2种:3D映射[2]和1D映射[17].3D映射是根据深度图、参考视图和相机参数,将参考视图中的像素点映射到世界坐标系下,将世界坐标系的点映射到目标视图上.这种方式可以合成任意视点下的虚拟视图.1D映射也被称为视点插值(view interpolation),其不同之处在于直接将参考视图的像素点水平映射到目标视图中同一行的对应位置,使用的是普通标准立体图像及其视差图,适用于合成视角位于基线上的虚拟视点视图.下面以3D映射为例对本文方法进行描述,并在最后的实验结果中增加1D映射方法的结果.

以“Ballet”序列Cam5视角第1帧为参考视图,经过深度图预处理后,采用3D映射方式合成Cam4视角的合成视图及其深度图如图5所示,图中黑色区域为待填充的空洞区域.为了消除合成视图中的小型空洞和裂缝,需要对映射结果进行中值滤波处理.

图5 3D映射变换的结果Fig.5 Results of 3D image warping

4 合成深度图修复

为了保证修改后的合成视点视图仍旧符合立体视觉性质,首先对合成深度图进行修复.图像修复技术包括基于像素的方法[18]和基于样本的方法[19].基于像素的方法通常沿等照度线方向将已知像素信息向空洞区域进行逐点扩散填充,容易造成模糊现象,无法处理纹理区域.基于样本的方法通常采用块填充的方式,通过搜索最佳匹配块对空洞区域进行填充,可有效保持图像的纹理性质.相比合成视图,合成深度图反映的是场景的深度变化,其纹理变化较平缓,对其修复适合采用基于像素的方法.

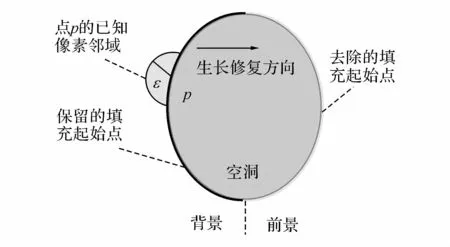

空洞像素的填充顺序对图像修复结果影响很大.传统方法大多采用“剥洋葱”的顺序,即沿各个方向同时向空洞的中心进行生长填充,如:Telea[18]提出的快速匹配法(fast marching method,FMM),在视点合成结果中,空洞区域一般为被遮挡的背景,如果填充从前景像素开始,容易造成前景像素向空洞的错误渗透,造成视觉上的突兀.本文利用前景和背景的相对位置信息,提出一种新的填充顺序,即只由空洞背景一侧向前景一侧生长填充.

在视点合成的应用中,虚拟视角的位置一般位于参考视点的水平方向上.在这样的合成视图中,前景、空洞、背景会在水平方向上呈“一”字型排列.定义由背景指向空洞的方向为v.若合成的目标视点相对于参考视点左移,空洞会出现在背景的右边,则v水平向右;反之,则v水平向左.

如图6所示,在传统的“剥洋葱”顺序中,填充的起始点只限定在空洞区域的边界像素,并没有对前景和背景进行区分.本文方法进一步对其进行限定,规定填充须从背景开始,沿着方向v进行.对于每一个空洞点p,利用其ε邻域内的已知像素的加权[18]得到其像素值.

图6 新填充顺序示意图Fig.6 Sketch map of new propagation mode

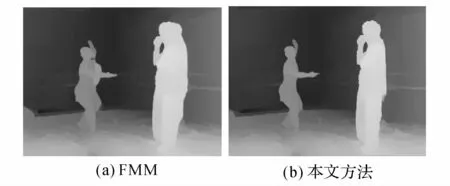

如图7所示,通过改进的填充顺序,最终的修复效果更加可靠,能保持更好的前景边缘.这对后续的合成视图修复提供了很好的深度参考.图7(a)为FMM的修复结果,图7(b)为本文方法的修复结果.

图7 2种方法的深度图修复结果Fig.7 Depth map inpainting result of two methods

5 合成视图修复

通过对深度图的修复,得到没有空洞的深度图(图7(b)),可利用其对如图5(a)所示的有空洞的合成视图像进行修复.对通常具有较丰富纹理的合成视图修复,将采用基于样本的方法.

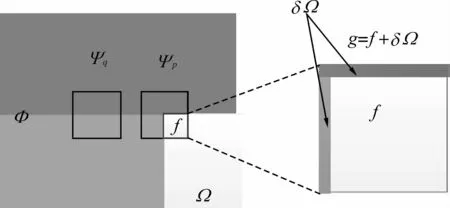

如图8所示,基于样本的图像修复[19]通常按照一定的填充顺序,以空洞区域Ω的边缘点p为中心的矩形块Ψp为参考,在已知区域Φ中搜索与之最相似的以点q为中心的矩形块Ψq,然后将Ψq填入Ψp的空洞中.图中,np为空洞边缘单位法向量.在上述过程中有3个关键问题要解决:1)以什么顺序进行填充;2)以什么度量来搜索匹配块Ψq;3)匹配块如何填入空洞.

图8 基于样本的图像修复Fig.8 Examplar-based image inpainting

5.1 填充顺序

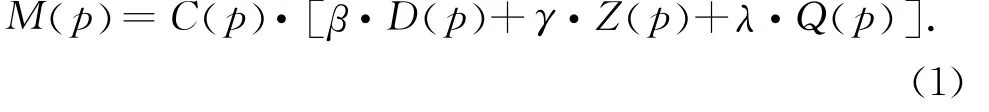

为了确定合适的填充顺序,对每一个空洞像素点计算优先值,然后根据优先值的大小来确定填充顺序.本文提出一种加入深度权重的优先值计算方法.由于待填充的空洞大多位于前景和背景的交界处,修复应尽量从背景一侧开始,即像素深度值越小,优先值越高.此外,在深度变化较大的前景和背景交界处,为了保持前景边缘的连续性,也应具有较高的优先值.最后得到优先值计算公式为

式中:C(p)为置信项,表示以点p为中心的矩形块中已知像素所占的百分比,C(p)越大,则填充该点的置信度越高;D(p)为数据项,该点像素值梯度越大,等照度线方向与空洞边缘法向越接近,则优先值越高,该项保证了纹理垂直于空洞边缘的点有更高的优先值,从而有利于纹理的保持;Z(p)为深度项,该点深度值越小,则优先值越高,深度值较小通常为背景,该项保证了空洞中背景相对于前景具有较高的优先值;Q(p)为深度变化项,在深度图变化大的地方,优先值较高;β、γ、λ为预定义的权重,在实验中分别取0.8、0.1、0.1.上述几项的具体定义如下:

式中:Ip为点p的像素值,dp为该点深度值,dmax和dmin分别为整幅图像最大、最小深度值,〈,〉为向量的内积;α和δ为归一化常数,通常取α=1/(255×图像通道数 ),δ=1/(dmax-dmin).运算符∇⊥表示求梯度后再将结果向量顺时针旋转90°,与等照度线方向相同.

式中:d(,)为非相似性度量,传统的图像修补方法通常取差的平方和或差的绝对值和度量.

由于已经对合成深度图进行了修复,有效利用深度图作为指引将得到更好的修复结果,提出加入深度信息的新度量为

5.2 搜索匹配块

假设优先值最高的点为p,首先构成一个以点p为中心,13×13大小的矩形块作为参考块Ψp,在相邻已知区域中搜索与Ψp最为相似的匹配块Ψq:

式中:Ip、dp分别为点p的像素值和深度值.通过式(7),匹配块搜索同时考虑了2个块之间纹理的相似性以及深度,与空洞区域具有相近深度的区域将具有更大的相似性.这一措施可以有效提高最终修复结果的质量.

5.3 填充块预编辑

由于搜索到的匹配块与填充的空洞区域仍存在差别,将其直接填充到空洞区域可能会造成明显的拼接痕迹,为此,需要对搜索到的匹配块进行预编辑再将其填入.预编辑的目标是让空洞处的像素梯度和匹配块对应点的梯度尽量相同.传统的泊松编辑[20]很容易出现错误的像素扩散.如图9所示,Ψp已经搜索到最佳的匹配块Ψq,这种简单的情况下直接复制填充效果会很好,但是如果对Ψq进行泊松编辑,则会出现如图9(b)所示深色向浅色扩散的现象.

图9 采用泊松编辑的匹配块填充结果Fig.9 Filling results of matching patch using poisson editing

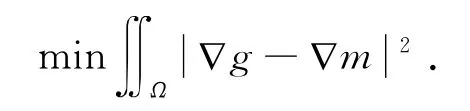

为了避免这种扩散现象,提出一种新的编辑方式.将Ψp中空洞区域f向已知区域扩展1个像素宽度,得到区域g,如图10所示.这时,优化处理方程转换为

其中,m为Ψq中对应于g的区域.将参考块中扩展的边缘像素作为区域g中的已知量,将匹配块中像素值作为区域g中对应位置的初值、分行、分列,采用共轭梯度迭代法求解可得到优化结果,即预编辑结果g,再将g中与空洞像素对应的点复制到空洞中.

图10 匹配块预编辑Fig.10 Pre-edit of matched patch

6 实验结果

为了验证算法的有效性,采用3D映射和1D映射2种方式分别进行视点合成实验.3D映射实验采用由微软提供的“Ballet”序列,其中包含8个视角的参考视图和深度图,同时提供所有视角拍摄时的相机参数.在3D映射中,在存在多参考视图的前提下,通常采用多参考视图的虚拟视点合成方法使目标视图中由遮挡产生的空洞区域降为最少.由于本文旨在对空洞修复问题进行讨论,为了更好验证本文方法的性能,实验中仍采用单参考视图的合成方式.对只给出视差图的1D映射情况,采用由Middlebury网站[21]提供的标准立体图像和标准视差图.

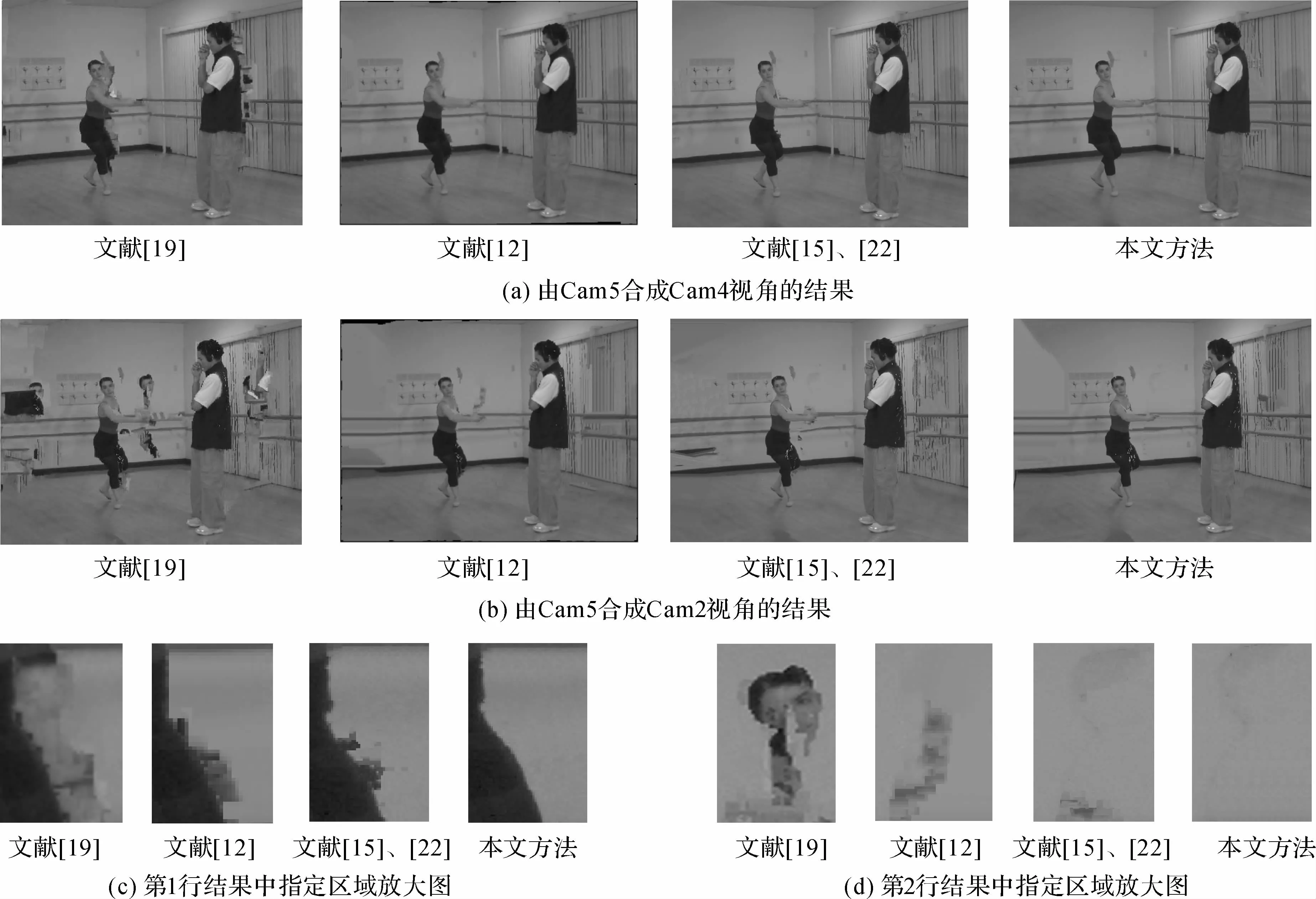

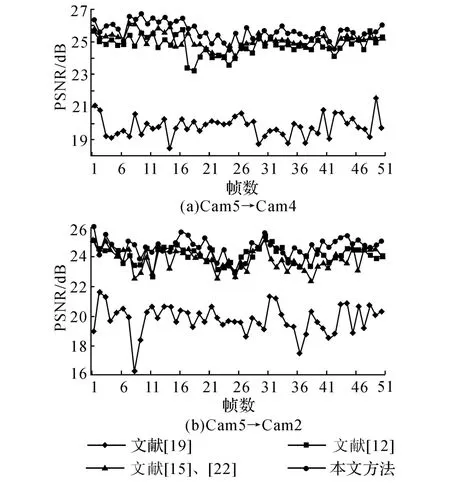

如图11所示为基于3D映射方法的结果比较.以“Ballet”序列Cam5视角作为输入,在图11(a)、(b)分别给出了合成Cam4和Cam2的视角视图,并在图11(c)给出了上述结果中标记区域的细节放大.由图中结果比较可见,本文方法的结果在前景边缘的保持、消除背景中的前景像素渗透等方面,要明显地优于其他3种方法.

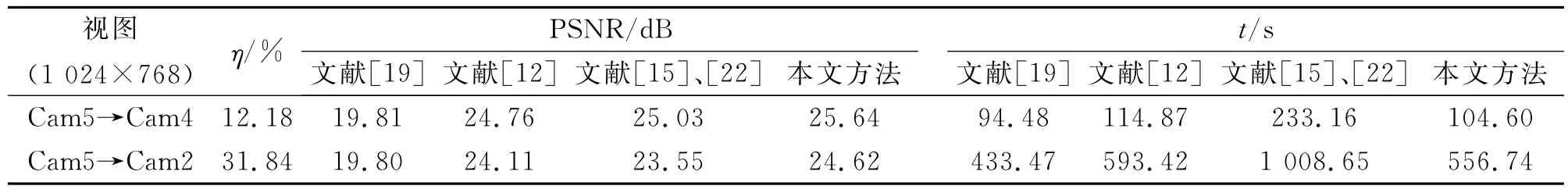

为了对算法性能进行定量评价,在图12中给出了上述方法的指标——峰值信噪比(peak signal to noise ratio,PSNR)曲线,计算时将对应视角的真实视图作为参考视图,且只对映射结果存在空洞的区域进行比较.由图12可知,本文方法对应的PSNR较高.

表1中给出了“Ballet”图像序列最终结果的统计数据,其中η表示空洞占全图面积的平均比例,t为平均每帧图像的处理耗时.可以看出,短基线(Cam5→Cam4)由于视角变化小,使得空洞区域面积较小,算法耗时较短且修复质量较高;而基线的增长(Cam5→Cam2)在增加算法耗时的同时,还会使视点合成质量降低.相对而言,本文方法在时间复杂度和性能的综合表现最佳,修复后图像的PSNR最高且耗时只是略多于文献[19]的方法.

图11 “Ballet”图像序列视点合成实验结果比较Fig.11 Comparison of experimental results of view synthesis for“Ballet”image sequence

表1 “Ballet”图像序列统计结果Tab.1 Statistical results of"Ballet"image sequence

在耗时方面,虽然本文方法在合成视图修复之前加入了深度图的修复,但由于深度图修复采用的是基于像素的快速修复方法,其耗时远小于合成视图空洞修复.4种方法在时间消耗上的差别主要体现在合成视图的修复过程中.本文方法、文献[12]和文献[15]、[22]的方法在合成视图修复时都在文献[19]的基础上加入了深度信息,故都更为耗时;文献[12]的方法在计算优先值时采用三维张量的形式,并有较复杂的矩阵运算,耗时稍长;文献[15]、[22]的方法在计算时有大量的指数运算,耗时最长;本文方法在引入深度信息时采用了较为简单的向量运算及少量指数运算,计算量较小,所以最终耗时较文献[19]和[15]、[22]中的方法要少.

图12 “Ballet”图像序列PSNR结果Fig.12 PSNR results of"Ballet"image sequence

图13 Middlebury立体图视点合成实验Fig.13 View synthesis on Middlebury stereo images

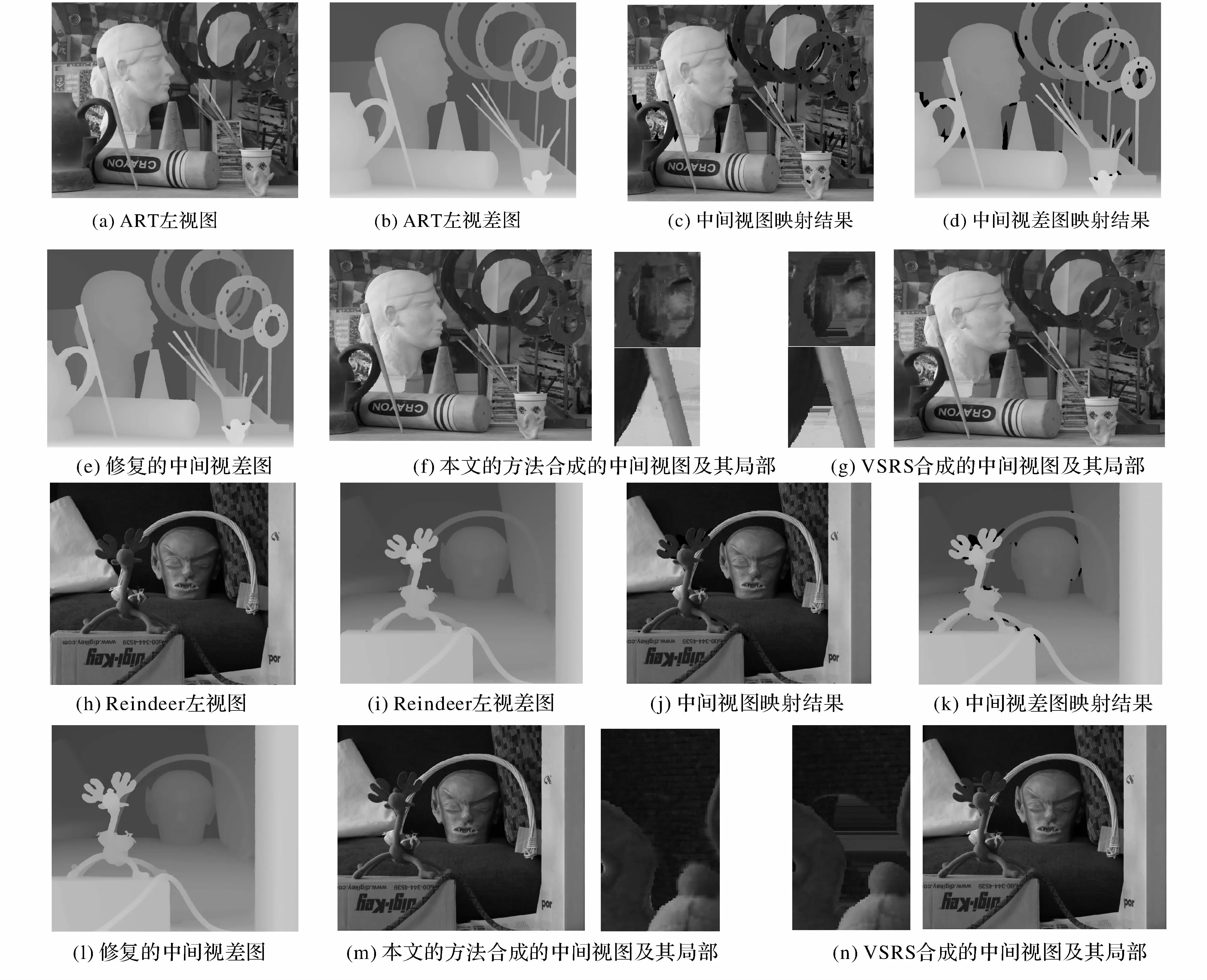

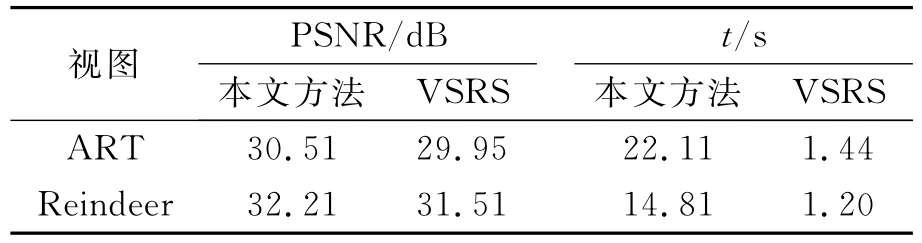

给出了以1D映射方式得到的视点合成结果,选用了“ART”和“Reindeer”标准立体图像的左右视图及其视差图作为输入,用于合成位于左右视图中间视角(即位于基线中点)的虚拟视点视图.其中“ART”和“Reindeer”图像分辨率分别为1 390× 1 110和1 342×1 110,中间视图映射结果中空洞区域面积占全图比例分别为2.15%和0.62%.以“ART”图像为例,图13(a)、(b)为输入的左视图和左视差图,作为输入图像质量参考.通过1D映射得到中间视角视图和视差图在图13(c)、(d)中给出,图中的黑色区域表示空洞待填充区域.对视差图13(d)中的空洞进行修复,结果见图13(e).结合修复后的视差图(e),对中间视图(c)中的空洞进行修补,最终结果及局部视图见图13(f).作为对比,在图13(g)中给出VSRS(view synthesis reference software)[23]的视点合成结果及局部视图.表2中给出了2组实验的统计结果.从图13中给出的实验结果和表2中给出的客观指标可以看出,本文方法对空洞的修补更为合理,最终得到的合成视图质量较高.本文方法的时间消耗长于VSRS,这是因为该软件对空洞的修复采用的是基于像素的图像修复方法,虽然速度较快,但无法还原图像的纹理结构,容易造成过于平滑和黏连的现象,修复的空洞质量较差.

表2 Middlebury立体视图统计结果Tab.2 Statistical results of Middlebury stereo images

7 结 语

本文算法在图像边缘连续性的保持、前景和背景像素渗透现象的消除等方面具有较好的效果.在视点合成中,充分利用立体图像的深度信息,以及各视角之间的相对位置关系,对提高合成视图质量能起到重要作用.例如:合成的虚拟视角一般位于参考视角的水平方向上,如果视角右移,空洞会出现在前景右侧;如果视角左移,空洞则会出现在前景左侧.空洞区域一般为被遮挡的背景,如果空洞填充从前景像素开始,容易造成前景像素向空洞的错误渗透,造成视觉上的突兀.基于由深度信息给出的前景和背景的相对位置,则可以给出更好的填充顺序.此外,在传统的基于样本的图像修复方法中加入深度信息辅助,也可以提高最终合成视图的质量.未来的研究将着眼于对深度和视差图的处理,以及通过相机参数的提取,获得更为精确的场景结构上.

(References):

[1]SHUM H Y,KANG S B.A review of image-based rendering techniques[C]∥Proceedings of SPIE 4067,Visual Communications and Image Processing 2000.Perth:SPIE,2000:2- 13.

[2]FEHN C.Depth-image-based rendering(DIBR),compression,and transmission for a new approach on 3D-TV[C]∥Proceedings of SPIE 5291,Stereoscopic Displays and Virtual Reality Systems XI.San Jose:SPIE,2004:93- 104.

[3]SHADE J,GORTLER S,HE L,et al.Layered depth images[C]∥Proceedings of the 25th Annual Conference on Computer Graphics and Interactive Techniques.Orlando:ACM,1998:231- 242.

[4]陈坤斌,刘海旭,李学明.构造全局背景的虚拟视点合成算法[J].信号处理,2013,29(10):1307- 1314.

CHEN Kun-bin,LIU Hai-xu,LI Xue-ming.Virtual view synthesis using generated global background[J].Journal of Signal Processing,2013,29(10):1307- 1314.

[5]YAO C,TILLO T,ZHAO Y,et al.Depth map driven hole filling algorithm exploiting temporal correlation information[J].IEEE Transactions on Broadcasting,2014,60(2):394- 404.

[6]王奎,安平,张兆杨,等.Kinect深度图像快速修复算法[J].上海大学学报:自然科学版,2012,18(5):454- 458.

WANG Kui,AN Ping,ZHANG Zhao-yang,et al.Fast inpainting algorithm for kinect depth map[J].Journal of Shanghai University:Natural Science Edition,2012,18(5):454- 458.

[7]ZHANG L,TAM W J.Stereoscopic image generation based on depth images for 3DTV[J].IEEE Transactions on Broadcasting,2005,51(2):191- 199.

[8]LEE P J,EFFENDI.Non-geometric distortion smoothing approach for depth map preprocessing[J].IEEE Transactions on Multimedia,2011,13(2):246- 254.

[9]高凯,陈贺新,赵岩,等.面向虚拟视点绘制的深度图滤波及上采样方法[J].中国图象图形学报,2013,18(9):1085- 1092.

GAO Kai,CHEN He-xin,ZHAO Yan,et al.Depth map filtering and up-sampling method for virtual view rendering[J].Journal of Image and Graphics,2013,18(9):1085- 1092.

[10]李应彬,冯杰,张华熊,等.基于改进双边滤波的Kinect深度图像空洞修复算法研究[J].工业控制计算机,2013,26(11):105- 106,109.

LI Ying-bing,FENG Jie,ZHANG Hua-xiong,et al.New algorithm of depth hole filling based on intensive bilateral filter[J].Industrial Control Computer,2013,26(11):105- 106,109.

[11]DARIBO I,SAITO H.Depth-aided image inpainting for novel view synthesis[C]∥Proceedings of 2010 IEEE International Workshop on Multimedia Signal Processing(MMSP).(S.l.):IEEE,2010:167- 170.

[12]GAUTIER J,LE MEUR O,GUILLEMOT C.Depth based image completion for view synthesis[C]∥3DTV Conference:the True Vision-Capture,Transmission and Display of 3D Video(3DTV-CON).Antalya:IEEE,2011:1- 4.

[13]MA L N,DO L,WITH D,et al.Depth-guided inpainting algorithm for free-viewpoint video[C]∥2012 19th IEEE International Conferenceon on Image Processing(ICIP).Orlando:IEEE,2012:1721- 1724.

[14]WU H Y,FENG J,ZHANG H X,et al.A virtual view synthesis algorithm based on image inpainting[C]∥Third International Conference on Networking and Distributed Computing.Hangzhou:IEEE,2012:153- 156.

[15]XU X Y,PO L M,Cheung C H,et al.Depth-aided exemplar-based hole filling for DIBR view synthesis[C]∥2013 IEEE International Symposium on Circuits and Systems(ISCAS).Beijing:IEEE,2013:2840-2843.

[16]ZITNICK C L,SING B K,MATTHEW U,et al.High quality video view interpolation using a layered representation[J].ACM Transactions on Graphics. 2004,23(3):600- 608.

[17]SCHARSTEIN D.Stereo vision for view synthesis[C]∥IEEE Computer Society Conference on Computer Vision and Pattern Recognition(CVPR’96).San Francisco:IEEE,1996:852- 858.

[18]TELEA A.An image inpainting technique based on the fast marching method[J].Journal of Graphics Tools,2004,9(1):23- 34.

[19]CRIMINISI A,PEREZ P,TOYAMA K,Region filling and object removal by exemplar-based image inpainting[J].IEEE Transactions on Image Processing,2004,13(9):1200- 1212.

[20]PEREZ P,GANGNET M,AND BLAKE A.Poisson image editing[J].Proceedings of the SIGGRAPH,2003,22(3):313- 318.

[21]SCHARSTEIN D,PAL C.Learning conditional random fields for stereo[C]∥IEEE Computer Society Conference on Computer Vision and Pattern Recognition(CVPR 2007).Minneapolis:IEEE,2007:1- 8.

[22]XU X Y,PO L M,NG K H,et al.Depth map misalignment correction and dilation for DIBR view synthesis[J].Signal Processing:Image Communication.2013,28(9):1023- 1045.

[23]TIAN D,LAI P L,PATRICK L.View synthesis techniques for 3D video[C]∥SPIE Optical Engineering and Applications.San Diego:SPIE,2009:74430T-74430T-11.

Depth-based hole filling in view synthesis

DU Xin,ZOU Shuang

(Department of Information Science and Electronic Engineering,Zhejiang University,Hangzhou 310027,China)

An image inpainting method based on exemplar-based image restoration technology was proposed to improve the quality of hole filling in view synthesis by using depth information.This method fills the holes and provides a synthesized view through depth map preprocessing,image warping,depth inpainting and color image inpainting.The final synthesized view quality is improved by the depth edge’s unidirectional dilation,the strategy that firstly inpaintes synthesized depth map and then the synthesized image,and the pre-editing of matched patch.The experimental results show that this method is superior to the existing methods in terms of subjective visual perception and objective index,such as peak signal to noise ratio(PSNR)and time consuming.The proposed method also has outstanding effects on maintaining the foreground edges and eliminating the infiltration from foreground to background.

view synthesis;hole-filling;depth map inpainting

10.3785/j.issn.1008-973X.2015.09.002

TP 391.4

A

1008- 973X(2015)09- 1616- 09

2014- 08- 01. 浙江大学学报(工学版)网址:www.journals.zju.edu.cn/eng

国家自然科学基金资助项目(61271339);浙江省自然科学基金资助项目(LY12F01019).

杜歆(1975-),男,副教授,博士,从事计算机视觉、3D视频处理研究.ORCID:0000-0002-6215-9733.E-mail:duxin@zju.edu.cn