一种多模型协同的目标提取方法

冀续烨,陈 明,冯国富,赵海乐

(上海海洋大学信息学院,上海201306)

一种多模型协同的目标提取方法

冀续烨,陈 明,冯国富,赵海乐

(上海海洋大学信息学院,上海201306)

固定摄像机目标提取多以高斯混合模型为背景模型,在检测运动缓慢、间歇停滞的目标时会出现前景目标空洞的问题。为此,提出一种能够适应目标间歇停滞的多模型协同目标提取方法。采用高斯混合模型进行背景学习,通过光线检测模型和场景状态检测模型协同控制背景适时更新,利用阴影检测模型剔除阴影。实验结果表明,与KaewTraKulPong P方法相比,该方法能较完整地提取到目标轮廓,且单帧处理时间较少。

目标提取;高斯混合模型;光线检测模型;场景状态检测模型;阴影检测模型;背景更新

1 概述

前景提取是将图像中有意义的特征或区域提取出来的过程,是目标检测、跟踪、分类和行为分析等图像理解方式的基础[1]。进行前景提取有两大优势:(1)过滤掉不必要的图像信息,提高了后续处理的精准度;(2)图像只处理感兴趣的范围,为后续处理过程节省了时间,有利于保持视频帧序列处理的实时性。因此,前景提取技术被广泛应用于视频监控领域。

针对静态场景,即固定摄像机场景的前景提取算法主要可以分为3类,即光流法[2]、帧差法[3]以及背景减除法[4-6]。光流法使用图像序列与光流表示移动物体的信息来计算真实速度场,通过分析运动场的变化对运动目标和场景进行检测与分割。然而,光流法对噪声、多光源、阴影和遮挡等因素敏感,而且计算量大难以实时处理。帧差法,又名帧间差分法,它是通过计算图像序列中相邻2帧或3帧间像素灰度差异,将差异值大于设置的阈值认为是前景像素。帧差法可以认为是背景减除法的一种,它以前一帧图像作为当前帧的背景,优点是具有较好的实时性,背景误差不会积累,且更新速度快、算法简单、计算量小。缺点是它对于物体移动产生光线的变化比较敏感,难以精确地检测快速移动或缓慢移动的物体,对颜色一致的物体也缺乏适应性。总之,帧差法检测到的前景区域是不完整的。

为解决上述问题,本文提出一种能适应目标间歇停滞的多模型协同目标提取方法。在背景减除法的基础上,通过构建光线检测模型和场景状态模型,协同、动态地控制背景模型的更新,从而提取更为完整的前景图像。

2 相关工作

背景减除法是前景提取中最典型的方法。它通过构建背景模型来近似场景中的真实背景,将当前帧与背景图像进行差分从而得到前景区域。由于视频监控的场景中光线是缓慢变化的或存在外部环境的背景干扰,因此背景图像必须随着光照或外部环境的变化更新。背景建模及其更新是背景减除法的关键所在。背景模型的重建方法通常是利用一定数量的历史图像序列来学习背景,可以分为2类: (1)纹理背景模型[7],如区域特征背景模型[5],这类模型能够适应局部场景细微变化,对背景更新要求较低,但无法取得目标精确形状;(2)颜色背景模型,如平均背景模型、高斯模型、非参数化背景模型和Codebook背景模型,这类模型能够精确提取目标形状,但对物体移动造成周围光线变化敏感,需要在检测后对阴影进行抑制和消除。

文献[8]提出一种固定摄像机的实时监控与跟踪复杂场景下的多个对象的方法。首先,背景模型由色度来构建,如果前景和背景色度没有区别,则建立一阶图像渐变,sobel算子从x和y方向估计渐变。从背景相减得到的二值图像用3×3像素窗口的中值滤波器进行滤波,然后利用一个已连接的组件标签算法对其进行扫描,当连接的组件面积小于阈值时丢弃得到检测的前景。背景减除法中最有名的是混合高斯混合模型(Gaussian Mixture Model, GMM)[9]。文献[10]利用马尔可夫模型自适应选择高斯分布的数目,文献[11]对每个像素的权值更新速率进行策略调整,文献[12]在GMM的基础上如入了阴影检测模型。

尽管高斯混合模型对复杂场景具有一定的适应性和鲁棒性,但主要适用于运动目标检测。当场景中出现长时间停滞的目标时,依然不能完整提取前景目标,而这种情况在室内监控中是很常见的。为此,本文提出一种多模型协同前景提取算法。

3 多模型协同前景提取方法

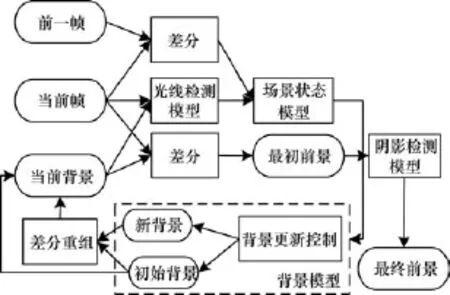

多模型协同方法主要由背景模型、帧差法、场景状态检测模型、光线检测模型和阴影检测模型组成,如图1所示。

图1 多模型协同前景提取方法流程

多模型协同前景提取算法通过从固定摄像机获取图像序列,背景模型利用一定数量的图像学习得到初始背景,初始背景也可以通过获取某帧图像指定。初始背景选取原则是最接近当前真实的背景,没有污染,为后续自动更新的新背景提供参照。这时当前帧与初始背景差分就得到最初的前景,为了抑制和消除阴影(这里阴影不仅是物体的影子,还包括物体移动造成周围光线变化),采用阴影检测模型消除阴影点得到前景区域。

由于场景中光线是缓慢变化的,需要对背景进行更新。然而,实时更新会造成长时间停滞目标的漏检,而且计算量过大,因此,多模型协同前景提取算法构建了场景状态检测模型和光线检测模型来控制背景模型产生新背景。光线检测模型通过布置若干个点集,通过这些点集与背景比较,检测场景中光线变化情况,并将该消息传递给场景状态检测模型。

场景状态检测模型通过当前帧与前一帧的差分图像中变化区域占整个场景区域的比例构建,它的作用是检测场景所处的状态。将场景的状态分为无目标状态、正常状态和异常状态,有目标运动视为正常状态,相邻帧差异过大视为异常状态。当场景状态从正常状态转为无目标状态或场景处于无目标状态且光线变化大于设定阈值时,通过背景模型更新初始背景,或者指定这一时刻的图像为初始背景。若场景处于正常状态光线变化大于设定阈值时,通过背景模型更新最新背景。新背景中可能存在静止的目标污染,将新背景与初始背景差分图像进行目标特征检测得到污染区域,使用初始背景替换新背景中的污染区域重组后更新当前背景。将获取的当前帧与当前背景差分,消除阴影后得到前景区域。

3.1 背景模型

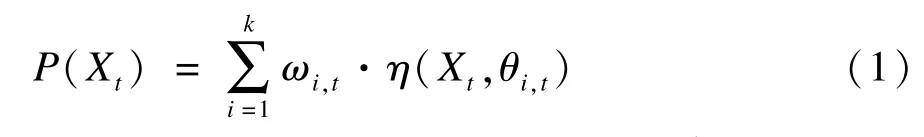

本文的背景模型采用高斯混合模型[10]作为背景模型。对于场景中的每一像素点在某一时刻t的值Xt可以用K个高斯分布叠加描述,Xt的概率密度函数为:

其中,μi,t表示t时刻第i个高斯分布的均值;Σi,t表示t时刻第i个高斯分布的协方差矩阵。

3.1.1 观察值匹配

将当前帧的每一个像素点值Xt和该点的K个高斯分布依次比较,若Xt满足,则称Xt与第i个分布匹配。

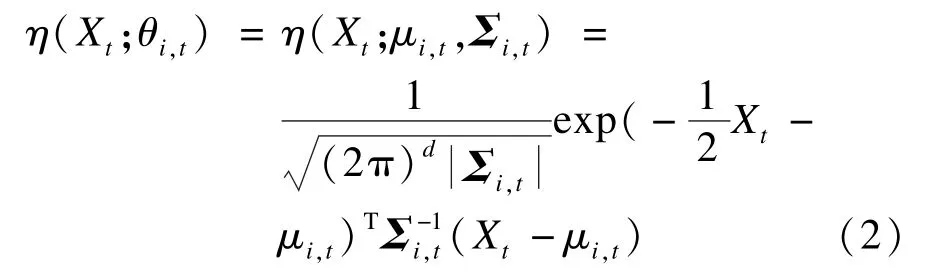

3.1.2 参数更新与前景分割

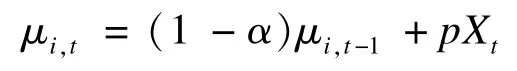

当Xt与某个高斯分布匹配,该点被视为背景点。权值按照以下公式进行更新:

其中,为 α更新速率,若 i=1时,Mi,t=1,否则Mi,t=0。

均值更新公式:

前面提到的协方差矩阵更新公式:

其中,p=αη(Xt,μi,);未匹配的 μi,t和 Σi,t保持不变。若当前像素点的观察值与所有K个分布皆不匹配时,该点被视为前景点。将优先级最低的高斯分布用一个新分布替换。新分布的均值即为当前观察值,并初始化一个较大的方差和一个较小的优先权值。将K个分布按照ω/σ2的值从大到小排列。

3.1.3 新背景模型的生成

选取前B个分布构成新背景模型:

其中,T是背景模型占有高斯分布的最小比例。

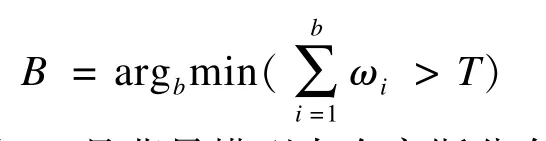

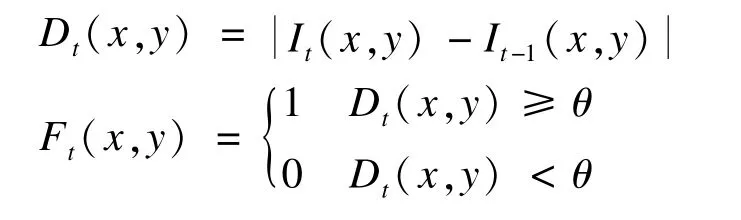

3.1.4 在线EM算法参数估计

为了满足不同图像大小以及不同的硬件配置的处理效果,不是手动设置学习速率α,而是采用EM算法对分布各参数进行估计。对于视频数据逐帧处理公式如下:

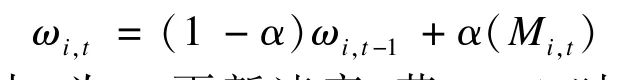

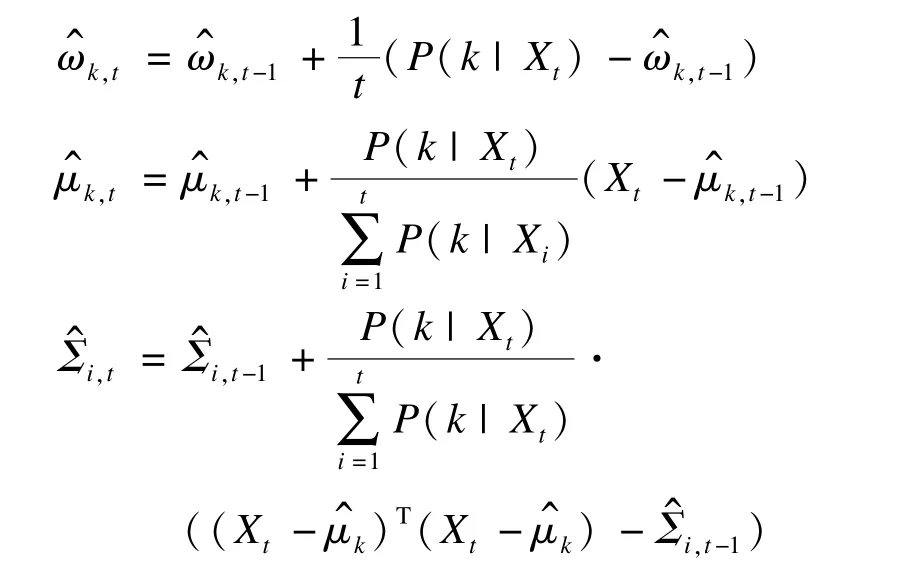

3.2 帧差法

帧差法首先将视频序列中当前帧与前一帧进行灰度处理转化成二值图像,然后进行差分,将2帧间灰度值变化大于阈值的像素作为前景点,否则视为背景点。公式如下:

其中,Dt(x,y),It(x,y),It-1(x,y),Ft(x,y)分别表示差分图像、t时刻图像、t-1时刻图像、二值前景图像;θ表示分割阈值。

由于帧差法不能完整地提取目标前景,不作为主方法来使用,但能准确地检测到场景的实时变化,可以分析这些变化判断当前场景所处的状态。设定合适分割阈值是帧差法的关键,为了有效地抑制图像噪声,本文将相邻2帧像素灰度值变化超过20的视为前景点,即θ=20。

3.3 光线检测模型

光线检测模型用于检测场景中光线变化情况,若光线发生较大变化,则发出消息更新背景。它通过侦听3个3×3像素的点集的均值与当前背景对比实现。3个点集的选取方法:

(1)将图像均匀分为3×3(将图像9等分)的9个单元。

(2)从9个单元中选取3个单元,使得3个单元既不在同一行也不在同一列。

(3)将选取的3个单元的边缘去掉1个像素,每个单元中随机选择一个像素,以这个像素为中心的3×3像素集合即为侦听的点集。

当多次观察到半数以上点集的变化大于设定阈值s,则认为光线发生较大变化,将这个变化情况传递到场景状态检测模型。阈值s的值设定为背景模型分割阈值的2.5倍。

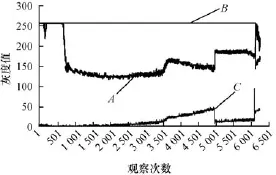

采用傍晚日落前的某室内场景对光线检测模型进行了测试。在图2场景下取得的视频(长度近2 h,在16:33~18:16)序列中按照上述方法选择3个点集(A(219,373),B(549,198),C(65,62)),每隔1 s观察3个灰度均值并记录,得到像素灰度值随光线变化如图3所示。

图2 日落场景(640×480像素)及3个随机点集中心坐标

图3A,B,C3点集的灰度值变化

图3 中点A在第651次观察后,由于光束偏移发生了较大的变化;在4 876次观察附近由于光照的忽明忽暗,A,C发生较大波动;第6 000次观察左右光源从自然光切换到摄像机红外光源,A,B,C均发生了波动;证明了光线检测模型的可行性。

3.4 场景状态检测模型

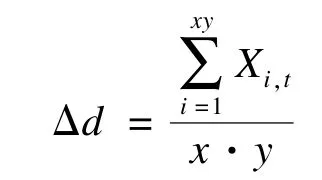

场景状态检测模型通过统计帧差法得到的二值前景图像中前景区域占整个图像的比例Δd:

其中,Xi,t表示二值前景图像的像素;x表示图像宽度;y表示图像高度。

当多次检测到Δd<0.001时,将场景状态置为无目标状态;当0.001<Δd<0.8时,场景状态处于正常模式;当Δd>0.8时,场景状态处于异常状态,摄像机可能出现剧烈摇晃或有物体目标离摄像机过近,可丢弃该帧。

场景状态检测模型通过检测状态变化结合光线检测模型的返回值来控制背景模型背景更新。更新结果有初始背景更新和最新背景更新。初始背景认为是最接近真实的背景,更新条件有:

(1)场景状态从正常状态变为无目标状态;

(2)场景处于无目标状态且光线发生较大变化。

最新背景是不能完全信任的背景,在场景处于正常状态且光线发生较大变化的条件下更新。

3.5 阴影检测模型

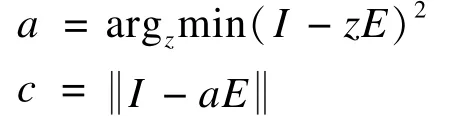

目标在场景中运动会造成局部光线变化,而产生阴影,为了有效地抑制和消除阴影,采用了阴影检测模型[12]。该模型主要通过色度和阈值对阴影进行抑制,包括背景像素RGB平均值E、预期色度线、色彩失真d、亮度阈值τ。给定一个像素观察值I,亮度失真值a和色度差异值c的计算公式如下:

在背景减除得到的最初前景中,若该前景中任意像素满足:(1)色度差异小于2.5倍的标准差; (2)τ<c<1。则该像素被视为一个移动的阴影点,予以剔除得到最终的前景。

4 实验结果与分析

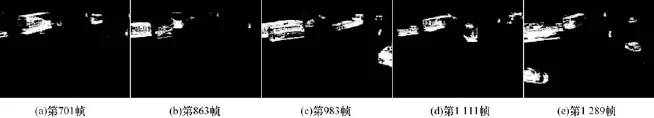

为了验证本文方法,设计实验研究该方法在复杂场景的适应性。实验视频场景采用十字路口监控视频和小区监控视频,视频分辨率为640×480像素,帧频率为24帧/s。实验对KaewTraKulPong P方法[12]和本文方法上述视频下进行测试比较。实验机器配置为Core(TM)i7-2600CPU 3.4 GHz,算法在Visual Studio平台利用Visual C++语言实现。测试结果如图4~图9所示。由图4~图9可知, KaewTraKulPong P方法在提取前景时,某些目标出现了巨大的前景空洞或未能提取到前景,这是因为高斯混合模型背景更新速度不能适应目标的缓慢运动或是间歇停滞。

图4 十字路口监控场景下原视频帧序列(部分)

图5 十字路口监控场景下KaewTraKulPong P方法的提取结果

图6 十字路口监控场景下本文方法的提取结果

图7 小区监控场景下原视频帧序列(部分)

图8 小区监控场景下KaewTraKulPong P方法的提取结果

图9 小区监控场景下本文方法的提取结果

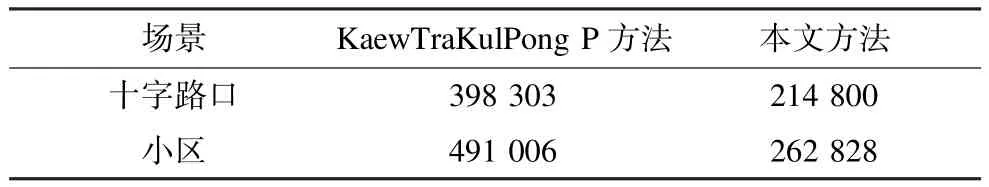

本文方法针对上述问题,构建了光线检测模型和场景检测模型,控制背景在必要时进行更新,较为完整地提取出了前景目标,表现出对目标移动速度较好的适应性。从时间复杂度来看,以单帧处理时间为指标来衡量,本文方法的单帧处理时间为126 ms,比KaewTraKulPong P方法节省了将近一半的时间。2种方法时间复杂度比较如表1所示,其中,本文方法和KaewTraKulPong P方法的平均单帧耗时分别为126.2 ms和235.1 ms。

表1 2种方法时间复杂度比较 ms

5 结束语

本文提出一种固定摄像机条件下,对视频序列运用多模型协同进行前景目标提取的方法。利用光线检测模型和场景状态检测模型协同控制更新背景模型。背景模型采用高斯混合模型,通过定期更新背景,适应场景中光线变化和清除上次背景更新可能积累的错误,将背景减除后的前景使用阴影检测模型剔除得到前景区域。实验结果表明,该方法有效地弥补了高斯混合模型对于长时间停滞目标存在的前景空洞,表现出对目标移动速度较好的适应性。今后将在本文前景提取的基础上,对目标检测问题进行研究。

[1]许新征,丁世飞,史忠植,等.图像分割的新理论和新方法[J].电子学报,2010,38(2):76-82.

[2]Li Wei,Wu Xiaojuan,Matsumoto K,et al.Foreground DetectionBasedonOpticalFlow andBackground Subtract[C]//Proceedings of IEEE International Conference on Communications,Circuits and Systems. Washington D.C.,USA:IEEE Press,2010:359-362.

[3]Gupta K,Kulkarni A V.Implementation of an Automated Single Camera Object Tracking System Using Frame Differencing and Dynamic Template Matching[EB/OL].[2014-02-21].http://link.springer.com/chapter/10. 1007%2F978-1-4020-8741-7_44#.

[4]Zhou Wei,Liu Yu,Zhang Weiming,et al.Dynamic Background Subtraction Using Spatial-color Binary Patterns[C]//Proceedingsofthe 6th International Conference on Image and Graphics.Washington D.C., USA:IEEE Press,2011:314-319.

[5]Hsiao P Y.A Region-based Background Modeling and Subtraction Using PartialDirected Hausdorff Distance[C]//Proceedings of ICRA’04.Washington D.C., USA:IEEE Press,2004:956-960.

[6]Fiala M,Shu Chang.Background Subtraction Using Selfidentifying Patterns[C]//Proceedings ofthe 2nd Canadian Conference on Computer and Robot Vision. Washington D.C.,USA:IEEE Press,2005:558-565.

[7]穆亚东,周秉锋.基于颜色和纹理信息的快速前景提取方法[J].计算机学报,2009,32(11):2252-2257.

[8]Wan Qin,Wang Yaonan.MultipleMoving Objects Tracking under Complex Scenes[C]//Proceedings of the 6th World Congress on Intelligent Control and Automation.Washington D.C.,USA:IEEE Press,2006: 9871-9875.

[9]Stauffer C,Grimson W E L.Adaptive Background Mixture Models for Real-time Tracking[C]//Proceedings of IEEE Computer Society Conference on Computer Vision and Pattern Recognition.Washington D.C., USA:IEEE Press,1999:252-255.

[10]Stenger B,Ramesh V,Paragios N,et al.Topology Free Hidden Markov Models:Application to Background Modeling[C]//Proceedings of the 8th IEEE International Conference on Computer Vision.Washington D.C.,USA: IEEE Press,2001:294-301.

[11]李百惠,杨 庚.高斯混合模型的自适应前景提取[J].中国图象图形学报,2013,18(12):1620-1627.

[12]Kaewtrakulpong P,Bowden R.An Improved Adaptive Background Mixture Model for Real-time Tracking with Shadow Detection[M]//Remagnino P,Graeme A, Paragios J N,et al.Video-based Surveillance Systems. Berlin,Germany:Springer,2002:135-144.

编辑 刘 冰

An Object Extraction Method of Multi-model Cooperation

JI Xuye,CHEN Ming,FENG Guofu,ZHAO Haile

(College of Information,Shanghai Ocean University,Shanghai 201306,China)

Gaussian Mixture Model(GMM)is adopted to solve foreground detection problems.However,GMM can not detect objects in which do not move in the scene.This paper proposes the multi-model cooperative method to detect foreground objects in complex scene.Under the assumption that the camera is fixed,it first uses the adaptive GMM to build a background which is updated by the light detection model and the scene detection model.A shadow detection model is also used in this paper at last.It mades a comparison with two algorithms.Experimental results show that this method can completely extract the object contour,and single frame processing time is less.

object extraction;Gaussian Mixture Model(GMM);light detection model;scene state detection model; shadow detection model;background update

1000-3428(2015)05-0254-05

A

TP391.41

10.3969/j.issn.1000-3428.2015.05.047

国家“863”计划基金资助项目(2012AA101905)。

冀续烨(1991-),男,硕士研究生,主研方向:图形图像处理;陈 明,教授;冯国富,副教授;赵海乐,硕士研究生。

2014-04-24

2014-06-13E-mail:xyji95@126.com

中文引用格式:冀续烨,陈 明,冯国富,等.一种多模型协同的目标提取方法[J].计算机工程,2015,41(5):254-258,263.

英文引用格式:Ji Xuye,Chen Ming,Feng Guofu,et al.An Object Extraction Method of Multi-model Cooperation[J]. Computer Engineering,2015,41(5):254-258,263.