结合目标色彩特征的基于注意力的图像分割

张建兴,李军,石庆龙

重庆大学自动化学院,重庆400044

1 引言

视觉注意力机制被研究者广泛运用于机器视觉和机器人目标跟踪领域[1],其主要包括两种类型[2-3]:自下而上注意力(Bottom-Up attention,BU注意力”)机制和自上而下注意力(Top-Down attention,TD注意力)机制。BU注意力机制即由底层数据到上层注意力的过程,注意目标的取得完全来源于场景图像信息。TD注意力机制遵循自上而下过程,即依据任务目标决定底层场景图像中吸引注意力的区域。这是两个完全相反的过程。

单纯的TD注意力机制有高度的自主性和复杂性,主要体现在任务目标的不确定性与随意性,难以较精确地建立其模型机制,导致运用上的局限性。另一方面,BU注意力过程依据输入场景图像的诸如亮度、颜色和方向等特征来选择注意力显著区域。该过程可以看做是人类早期视觉系统的注意力选择机制,其建模相对容易,受到很多研究者关注[4],其中的代表是Itti模型[5]。它利用从图像中提取亮度、颜色和方向等底层特征构造视觉注意力显著图,由视觉显著图吸引注意力,分割目标物体。该方法模型简单,对噪声的鲁棒性好,特别是当噪声的特性不直接破坏目标的主要特征的时候。缺点是当干扰物与目标有部分特征类似时,干扰物也会有不同程度的显著度,从而对目标的注意产生一定影响。Amudha与Soman[6]提出了一种新的基于注意力的感知方法,该方法使用任务并行和合并的选择调谐模型来进行注意区域检测。该模型作为目标识别算法包含预处理过程时,有效减少搜索的计算复杂度,在视频序列上进行标记应用的测试也取得较理想的结果。Itti与Baldi[7]提出一种新的贝叶斯惊奇模型,模型把贝叶斯理论运用到人类视觉注意力惊奇模型,以此衡量数据对观测者的吸引程度。尽管这个惊奇模型只是在场景时间和空间上的低水平量化,没有丰富的语义规则,但也较准确的检测到人类感兴趣区域,只是与其他方法相比,检测到的感兴趣目标相对较多。Wen[8]等人提出了一种基于小物体的视觉注意力感知模型,该模型以Itti注意力模型为基础,在生成显著图之后运用高斯混合模型(GMM)对显著图进行进一步精确化得到感兴趣区域。该方法能更精确地检测到目标,尤其对小目标的感知有较好的效果。

上述方法和运用虽然在特定运用场景中取得了较好的预期感知结果,但是经过仔细研究发现,当场景中目标的显著程度低于背景或其他物体时,注意力往往不被目标吸引,从而不能得到满意的结果。因此本文提出一种改进的基于注意力的图像分割方法,使得当目标显著度低于背景或其他物体时也能被较准确的分割。

2 目标分割算法

2.1 本文提出的算法

本文提出的目标分割方法如图1所示,包含三部分:场景特征图生成、集成显著图和图像分割目标的提取。其中场景特征图的生成由两类特征组成:单纯自下而上,由数据驱动直接从场景图像提取到的三类特征(颜色特征、亮度特征、方向特征);自上而下,结合目标任务与场景图像共同提取到的目标色彩特征。根据从场景图像中提取到的三类特征与结合目标任务、场景图像共同提取到的特征通过分步进行的方式集成一张最终显著图。图像分割目标的提取使用阈值分割法从最终显著图分割出注意力目标区域,进而分割出目标物体。

图1 图像分割系统结构图

2.2 场景特征图的生成

将输入的场景图像使用二进高斯金字塔产生9尺度图(0∶8尺度),在8个倍频程中从1∶1,1∶2,1∶4,…,1∶256(分别对应0,1,…,8尺度)。通过与视觉接受域类似的线性“中心围绕”操作计算每个特征,再用跨尺度融合。中心围绕算子在模型中通过对周围尺度s线性插值至中心尺度等大小后与中心尺度c进行点对点相减实现(下文用Θ表示)。中心是尺度c∈{2,3,4}中的像素,周围是尺度s=c+d,其中d∈{3,4}。

生成显著图的4个特征,分别是亮度特征、颜色特征、方向特征和目标色彩特征。对于RGB色彩模型,r、g、b分别代表红、绿、蓝3个色彩通道的值,取值范围[0,1]),亮度I经

计算得到。由9尺度高斯金字塔得到亮度高斯金字塔I(δ),δ∈[0..8]表示尺度。r、g、b用I归一化,目的是降低亮度对色彩的耦合。因为只有当亮度达到一定程度时,色彩才能被感知,故仅当I大于整个图像亮度1/10时进行归一化操作,否则r=g=b=0。特征图由高斯金字塔进行中心围绕操作(Θ)即上文提到的由中心细尺度c与周围粗尺度s的差值得到。亮度特征图I(c,s)计算公式如下:

将r、g、b 3个色彩通道扩展为R、G、B、Y(分别表示红、绿、蓝、黄)4个色彩通道,定义如下:

高斯金字塔R(δ)、G(δ)、B(δ)、Y(δ)分别由以上4个新通道得到。颜色特征图的构造是依据灵长类动物大脑皮质的“颜色双竞争”系统[9]:在视觉接受域中心,神经元被一种颜色(如红色)激发的同时抑制另一种颜色(如绿色),反过来也是一样的。这样在人类主要视觉皮质里就存在4个空间色彩对:红与绿,绿与红,蓝与黄,黄与蓝。在本文用特征图RG(c,s)表示红与绿和绿与红两个色彩对,用特征图BY(c,s)表示蓝与黄和黄与蓝两个色彩对,其计算公式如下:

方向特征图的构造运用了方向Garbor金字塔O(δ,θ),δ代表尺度,θ∈{0°,45°,90°,135°}代表4个方向。(Garbor滤波器使用余弦光栅与二维高斯卷积,目的是与视觉皮质中主要负责方向感知的神经元在视野中敏感性相一致)。方向特征图O(c,s,θ)计算公式如下:

目标色彩特征图是自上而下,依据任务目标得到的特征图。其形成是依据输入目标图像中色彩成分所占比重最多的两种颜色(两种颜色值分别用m1、m2表示),目的是强化目标的颜色特征,使其在较显著的背景或其他物体干扰的情形下也能被感知。目标色彩特征图P(c,s,m),计算原理如下(f(i,j)表示场景图像中对应点的颜色值,且值为(r0,g0,b0);m对应的颜色值为(r,g,b),m∈(m1,m2)。

(1)场景图像颜色与m越相似,则相应点特征值越大;

(2)相似度太低则对应点特征值为0,即若|r0-r|,|g0–g|,|b0–b|3个值中其中一个大于TT(本实验中取TT=80/255)则P(ψ,m)=0,(P(ψ,m)表示每个尺度的目标色彩特征值,ψ表示任意尺度);否则:

上式中先计算出中心尺度和周围尺度的目标色彩特征值,再使用中心围绕算子操作计算输入目标图像中色彩成分所占比重最多的两种颜色对应的目标色彩特征图。

2.3 视觉注意力显著图

根据得到的54幅特征图:亮度特征图6幅,颜色特征图12幅,方向特征图24幅,目标色彩特征图12幅。利用特征图生成视觉注意力显著图时,由于每个特征图都可能包含显著性不明显的物体,为了减少不明显物体的干扰,本文不是将所有特征图直接集成为一张显著图,而是采用分步进行的方式。第一步先将这些不同类别的特征图用归一化和跨尺度融合为4张显著图,分别是亮度显著图、颜色显著图、方向显著图和目标色彩显著图,第二步将这4幅显著图集成为1张最终显著图S(见公式(7))。

归一化操作(用N(·)表示)的目的是在缺少TD监督的情况下,整体提升有部分强刺激峰值,而整体抑制包含大量类似峰值响应。其计算方法是首先将图像取值规范化为[0,M],以消除幅值产生的差异,其次计算图像中最大值M和其他所有局部极大值的平均值,然后再整幅图像乘以

跨尺度融合(用“⊕”表示)过程是将每一个归一化的特征图压缩到尺度4再对应点相加。亮度显著图颜色显著图方向显著图和目标色彩显著图的生成,以及将这4幅显著图集成为最终显著图S的计算公式如下:

2.4 图像分割目标的提取

最终显著图S的最大值点定义了最显著图像的位置,即是注意力焦点。为了提取注意力焦点,将其双线性插值到0尺度(与原图等大小)计算每个单连通区域的平均值(例如S中有5个显著物体则有不多于5个连通区域,相应平均值记为Si,i∈{1,2,3,4,5}),假设最大的两个平均值分别是S1、S2,且S1>S2,则阀值T计算公式如下:

显著图用以下公式二值化(f(i,j)表示显著图的灰度值):

将二值化后的显著图与原图按位与运算即可提取到感知目标。整个处理步骤如下:

(1)将输入的场景图像使用二进高斯金字塔产生9尺度图;

(2)计算每个尺度的亮度I(δ)和亮度特征图I(c,s);

(3)计算每个尺度的R、G、B、Y和颜色特征图RG(c,s),BY(c,s);

(4)计算每个尺度方向特征O(δ,θ)和方向特征图O(c,s,θ);

(5)计算输入目标图像色彩成分所占比重最多的两种颜色m1、m2,从而计算每个尺度目标色彩特征值P(ψ,m),进一步计算目标色彩特征图P(c,s,m);

(6)采用分步进行的方式集成最终注意力显著图S;

(7)对最终注意力显著图S双线性插值到0尺度,计算T,然后二值化;

(8)二值化的显著图S与原输入场景图按位相与,分割出目标物体。

这一算法的处理过程如图2所示。

图2 图像分割流程图

3 实验及算法分析比较

本章描述运用增加目标色彩特征的改进型,基于注意力的图像分割算法的实验结果和分析。

3.1 实验设置

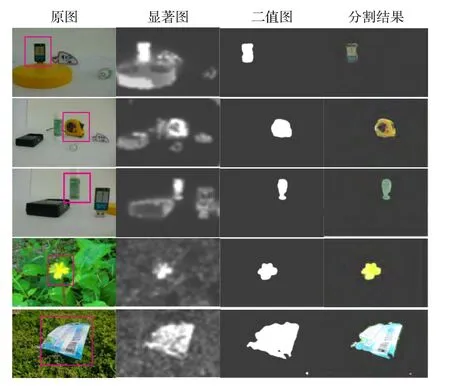

本实验图像分辨率为520像素×390像素的24位彩色图。如图2所示,首先采集目标任务的图像。为了更好地提取出所占比例最大的两种颜色成分,避免图像中背景干扰,输入前需要将背景替换为纯黑(r=g=b=0)或者纯白(r=g=b=1),然后输入系统。在系统中提取m1、m2时,考虑到实际采集的图像由于光照和视角的原因,即使是纯白(或纯黑)的目标在图像中也不是纯白(或纯黑)而是集中在靠近纯白(或纯黑)所在颜色范围,故忽略纯白与纯黑。接着输入视野中场景图像,通过线性滤波分别得到亮度、颜色、方向3个类别9尺度高斯金字塔(I(δ),C(δ),O(δ)),结合m1、m2得到目标色彩高斯金字塔(P(ψ,m))。然后进行“中心围绕”和归一化操作分别计算每个特征图,根据每个特征图用跨尺度融合和归一化计算每个类别的显著图,再集成为一张最终显著图S,用阈值T二值化之后对其双线性插值到0尺度(与原图等大小),与输入场景图按位相与。图3用5个有代表的视觉场景展示该改进算法的运算结果,第一列是原始图像,第二列为显著图,第三列是阀值处理后的二值图,最后一列为图像分割结果。

图3 图像分割结果

3.2 图像分割算法实现与比较

为了评估和分析本文改进的算法性能,使用该算法与传统的Itti算法、GBVS(Graph-Based Visual Saliency)算法[10]作比较。图4为这几种算法的最终分割结果对比(因二值分割阈值对最终分割结果影响较大且无统一计算标准,故本实验分割阈值取T=0.5)。

图4 算法对比图

由图4可见本文算法并非完全准确感知目标,但是在针对一些基本的运用(比如定位、目标识别、避障等)是足够的。

依据传统的Itti算法以及后来的GBVS算法生成的显著图能找到场景图像中的显著区域,但是往往该区域所包含的物体不一定是目标物体,尤其是目标物体显著度较低时,该现象尤为明显(例如图4的第三行、第四行)。

表1 本文方法与Itti算法及GBVS算法对比

为了更精确地分析和对比本文改进的算法,定义了两个变量命中指数D与失败指数Df。命中指数D与失败指数Df跟Si(上文已定义)的值相关,假设最大的两个平均值分别是S1、S2,且S1>S2,若S1对应的物体不是需要被感知的目标(即显著程度最高的区域不是目标物体),则D=0,表示感知失败,此时失败指数Df=(S2-S1)/S2;若S1对应的物体是需要被感知的目标(即显著程度最高的区域是目标物体),则D=(S1-S2)/S1,D越大说明目标越显著命中效果越好,此时失败指数Df=0。表1为根据图4所示实验计算得到的指数D与失败指数Df,由表中数据可见本文算法的优越性。

基于注意力的图像分割改进算法在超过100幅场景图像运用中,超过95%的处理结果显示本算法可以成功地在视觉场景中正确分割到目标物体。

4 结束语

提出一种新的基于注意力的图像分割方法。本文方法是一种多尺度多特征分析方法,既利用了自下而上的场景信息,又利用了自上而下的目标任务的色彩特征共同构成场景图像显著图,再从显著图中提取最显著区域,从而达到目标分割的目的。

从实验结果来看,由于本文方法加入了目标任务特征,在场景图像中背景或者干扰物体较明显的情形下,该方法依然能准确将注意力集中到目标物体所在区域,进而有效分割出目标物体,取得理想的实验结果。

[1]Yuanlong Y,George K,M ann I,et al.Target tracking for moving robots using object-based visual attention[C]//Proceedings of IEEE International Conference on Intelligent Robots and Systems,2010:2902-2907.

[2]Niebur E,Koch C.Computational architectures for attention[M].The Attentive Brain,Cambridge:M IT Press,1998:163-186.

[3]Qiaorong Z,Guochan G,Huim in X.Image segmentation based on visual attention mechanism[J].Journal of multimedia,2009,14(6):363-370.

[4]Yaoru S,Fisher R,Fang W,et al.A computer vision model for visual-object-based attention and eye movements[J].Computer Vision and Image Understanding,2008,112:126-142.

[5]Itti L,Koch C,Niebur E.A model of saliency-based visual attention for rapid scene analysis[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,1998,20(11):1254-1259.

[6]Amudha J,Soman K P.Selective tuning visual attention model[J].International Journal of Recent Trends in Engineering,2009,2(2):117-119.

[7]Itti L,Baldi P.Bayesian surprise attracts human attention[J].Vision Research,2009,49:1295-1306.

[8]Wen G,Changshe X,Songed M,et al.Visual attention based small object segmentation in natual images[C]//Proceedings of IEEE International Conference on Image Processing,2010:1565-1568.

[9]Engel S,Zhang X,Wandell B.Colour tuning in human visual cortex measured with functional magnetic resonance imaging[J].Nature,1997,388(6637):68-71.

[10]Harel J,Koch C,Perona P.Graph-Based visual saliency[C]//Proceedings of Neural Information Processing System s.[S.l.]:M IT Press,2006:545-552.