一种改进的帧间差光流场算法

吴振杰,毛晓波

郑州大学 电气工程学院,郑州 450001

一种改进的帧间差光流场算法

吴振杰,毛晓波

郑州大学 电气工程学院,郑州 450001

1 引言

序列图像中的运动目标检测与追踪技术是图像处理与计算机视觉研究领域一个非常活跃的分支,在国民经济和军事领域有着广泛的应用。对运动目标的检测是视觉跟踪、目标分类、行为理解等各种后续处理的基础。目前研究运动目标检测的方法有背景减除法、帧间差分法和光流场计算法等多种[1]。

背景减除法能提供完整的特征数据,且算法简单、快速,但对于如光照、阴影、背景扰动等环境变化特别敏感。帧间差分法对光照等环境变化的适应性强,但通常只能获得运动目标的部分信息,难以提取出物体完整的轮廓,同时也容易受到噪声干扰。光流场方法[2]反应了序列图像中的速度场,善于在运动场景中捕捉运动对象的运动特征,它对图像的运动场进行估计,能够直接用于摄像机运动下的目标检测[3],且不需要预先知道场景的信息,检测结果精确可靠。但大多数光流算法计算复杂,不适合实时处理。鉴于直接光流计算算法复杂且耗时太多,本文提出一种结合帧间差的光流计算方法,先对序列图像进行隔帧差分,针对差值图中不为零处的像素(它们往往对应于灰度梯度较大的点)来计算其光流,较之计算整个运动物体的光流场更为可靠、精确和快速。

2 隔帧差分法的运动区域提取

运动目标检测方法中许多是基于目标图像帧序列的灰度变化进行目标判别的[4],当视频帧图像中出现运动目标时,连续两帧之间灰度值会出现较为明显的差别,两帧相减得到两帧图像灰度值差的绝对值,通过阈值化和滤波等方法检测运动目标。该方法具有简单高效的特点,但对运动速度慢和弱小目标检测效果不理想。为了检测到不同运动速度的目标,并提高检测速度,采用隔帧差分法[5]先检测包含运动目标的区域,再用光流法在上述区域精确检测目标。

视频序列图像在经过中值滤波预处理后,去掉图像随机噪声,再将彩色的视频图像进行灰度变换,得到灰度图像。灰度模式可以使用多达256级灰度来表现图像,使图像的过渡更平滑细腻。灰度图像的每个像素有一个0(黑色)到255(白色)之间的亮度值。

在经过灰度变换后的动态视频图像中,以间隔n帧选取三帧图像,其中前一帧图像fi-n(x,y),当前帧图像fi(x,y),下一帧图像fi-n(x,y)。当n=1时,就是传统连续帧差分计算,当n=2时,为隔1帧差分,当n=3时,为隔2帧差分,依此类推。隔帧的时间间隔选择取决于运动目标的速度和大小,对快速运动或者大的物体,需要选择较小的时间间隔;对慢速运动或者弱小的物体,需要选择较大的时间间隔。

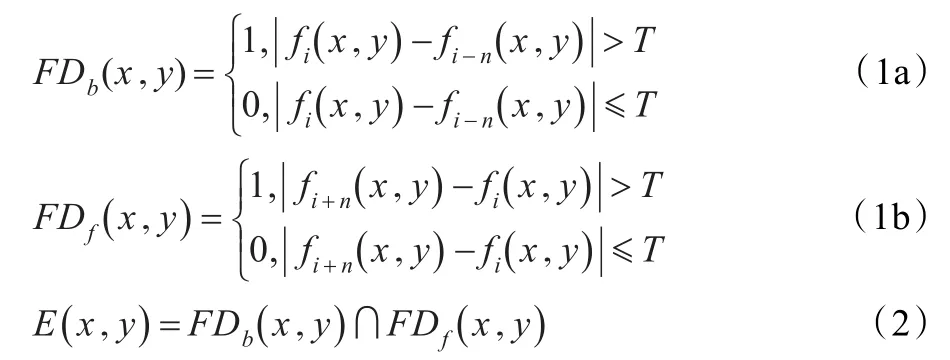

计算当前帧与前一帧的前向帧差图像FDb(x,y)和下一帧与当前帧的后向帧差图像FDf(x,y),通过阈函数值T,对隔帧差分后的图像进行阈值化处理,得到隔帧差分后的二值图像,其计算公式如式(1a)、(1b)所示。本文利用文献[6]介绍的二维Otsu阈值化的快速算法,确定阈值T。按式(2)计算帧差图像FDb(x,y)和FDf(x,y)的交集得到运动目标的运动区域E(x,y)。

隔帧差分的方法不仅能完整检测到大的目标,而且可以检测到帧间位移小于1个像元而多帧累积位移大于1个像元的运动点目标,因此不仅提高了视频运动目标检测速度,还提高了检测目标的能力。

3 改进光流场算法的运动目标检测

3.1 光流算法原理

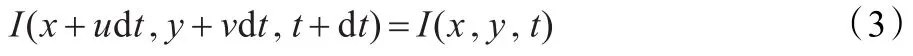

所谓光流指图像中灰度模式运动速度。光流计算进行像素级运动估计,记t时刻图像上的点(x,y)处的灰度值为I(x,y,t),如果u(x,y)和v(x,y)是该点光流的x和y分量,点在t+dt时运动到(x+dx,y+dy)时(其中dx=udt,dy=vdt),对应的灰度值为I(x+dx,y+dy,t+dt),假定它与I(x,y,t)相等,即

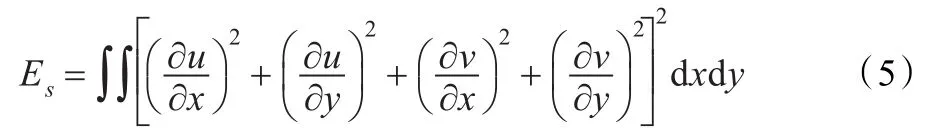

将左边在(x,y,z)点用泰勒公式展开,经简化并略去二阶和二阶以上项可以得到基本光流约束方程为:

由于光流场U=(u,v)T有两个变量,而基本约束方程只有一个,只能求出光流场沿梯度方向的值,因此从基本光流方程求解光流场是一个不适定问题,必须引入附加约束条件。

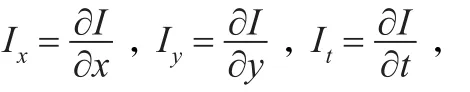

Horn和Schunck[7]使用光流在整个图像上光滑变化的假设来求解光流,即运动既满足光流约束方程又满足全局平滑性。Horn附加约束条件的基本思想是要求光流本身尽可能平滑,即引入了对光流的平滑性约束使平滑约束项极小化。即极小化Es:

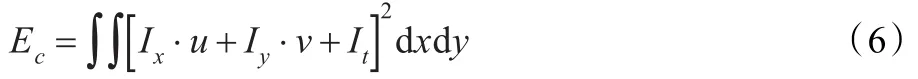

尽可能得小。另一方面,由基本等式,当然要求极小化Ec:

尽可能得小,于是将光流场(u,v)的计算归结为求如下的变分问题的解:

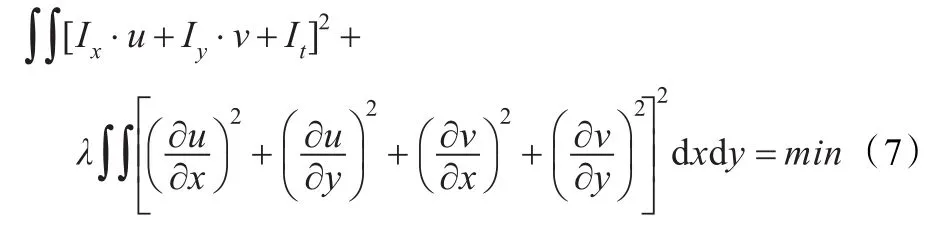

其中λ是一参数,它决定了上述两种误差(一种是偏离光滑性要求的误差Es,另一种是偏离基本等式的误差Ec)之间的相对权重。对此,采用迭代法求解:

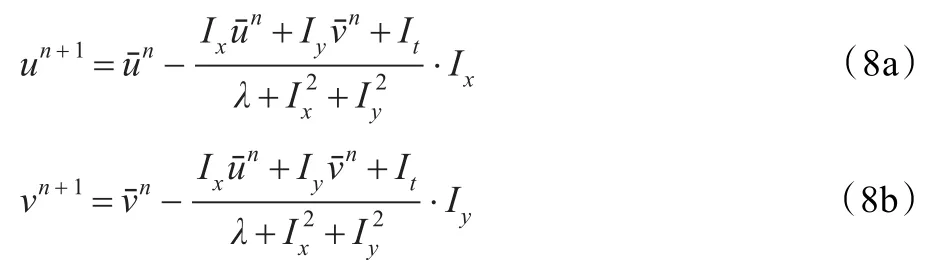

其中n是迭代次数,u0和v0是光流的初始值,一般取为零。当相邻两次迭代结果的距离小于预定的某一小值时,迭代过程终止。在以上公式中,如果Ii,j,k表示图像在(x,y,t)点的强度I(x,y,t),Ii,j,k+1表示图像在(x,y,t+dt)点的强度I(x,y,t+dt),那么Ix,Iy和It可由下式近似计算:

3.2 动态图像模型用于光流法改进

由于光流场的不连续性及违反守恒假设条件处光流场分布是不可靠的,针对差值图中不为零处的像素对应于灰度梯度较大的点,而这些点处的光流场基本方程近似成立。采用这种约束措施后,可使得计算出的光流场分布更为可靠和精确,同时也减少了计算量。因此,通过修正的光流定义来表示在动态图像中的几何变化和辐射度变化。这个修正的定义是用三个元素的向量来代替传统的两个元素向量。其中第三个元素表示这个点的亮度变化,引入通用动态图像模型(GDIM)[8],用来解决在亮度变化条件下光流估计问题中的辐射度变化。在GDIM中亮度变化描述成为数乘和一个偏移量。结合在上面公式(2)中得到的运动区域和GDIM模型定义新的约束模型:

其中m(r)和c(r)分别表示场亮度变化场的数乘和偏移量;r=[x,y,z]T是时空维上的一个点。基于GDIM的扩展光流模型为:

Er是帧差[9]区域中任意点的灰度,从t到t+dt的时间间隔里,图像中这点的灰度变化为dE=E(r+dr)-E(r)。在时变图像中同时包含了图像灰度模式的几何变化和辐射度变化的信息。m(r)的期望值接近于1,c(r)的期望值接近于0。当m(r)=1和c(r)=0时这个方程还原为亮度守恒的光流约束方程。

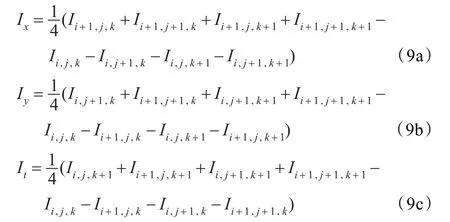

u,v和m,c四个变量由下式计算得到:

其中,W是一个很小的空间领域,这里取9×9像素大小。Ex,Ey和Et,E的计算与式(9)相同。通过该公式和初值可以快速准确计算出运动点的速度、坐标、方向和灰度值等运动信息,从而准确检测出运动目标。再通过对光流算法获得的运动信息进行后处理,可以完整地提取出检测到的运动目标[10]。本文改进算法的流程如图1所示,主要分为区域分析和光流分析两个阶段。

图1 改进光流算法流程

区域分析阶段通过联合帧间差分法提取运动对象所在区域;光流分析阶段对区域进行光流计算提取运动对象特征。

4 实验结果分析

下面对上述算法进行实验分析。实验系统环境为Windows XP,实验用软件Visual C++6.0、OpenCV视觉库。

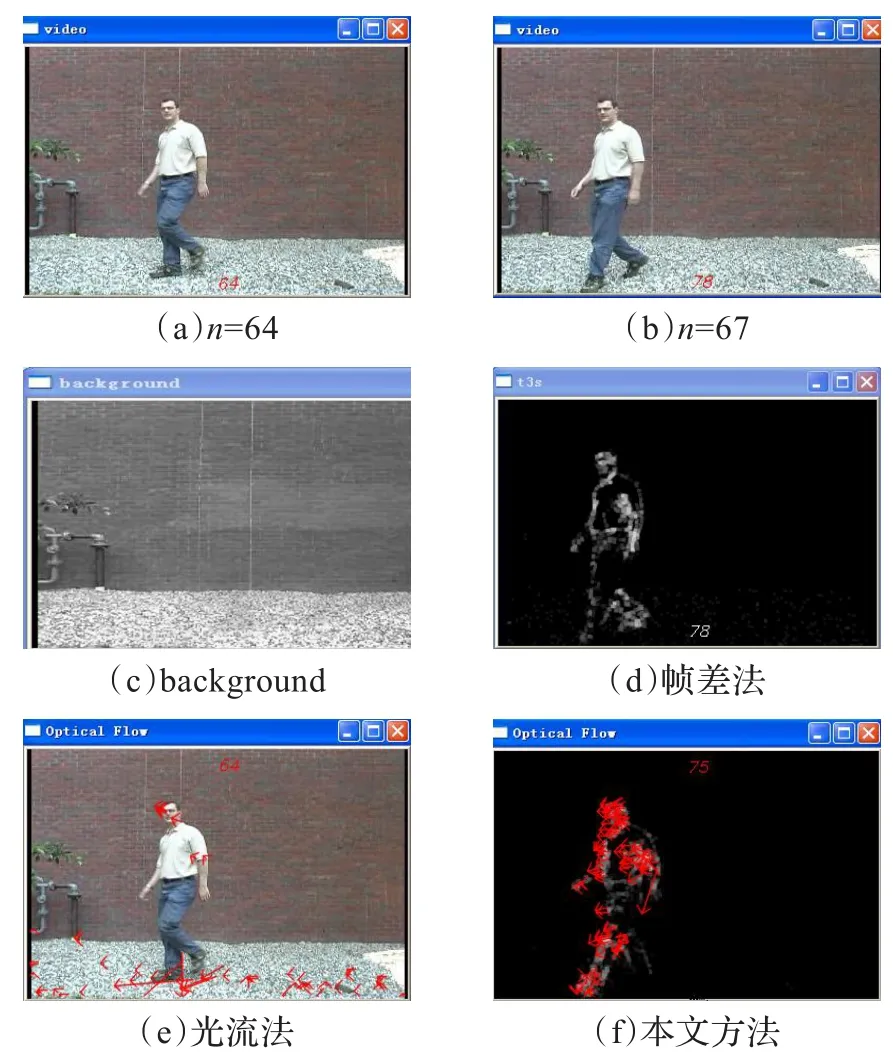

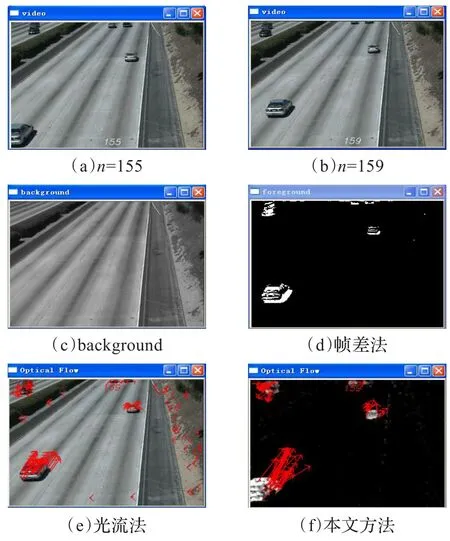

实验选用测试序列SampleVideo.avi和highway.avi。图2和图3分别给出了标准SampleVideo和highway序列分别用帧间差分法、上文的HS光流法和本文的隔帧差分光流法进行视频运动检测的比较结果。其中,(a)为原始视频图前一帧图像,(b)为后一帧的图像,(c)是背景图像,(d)为隔帧差分法检测结果,(e)为HS光流法检测的结果,(f)为本文算法检测结果。

图2 samplevideo序列检测结果比较

图3 highway序列检测结果比较

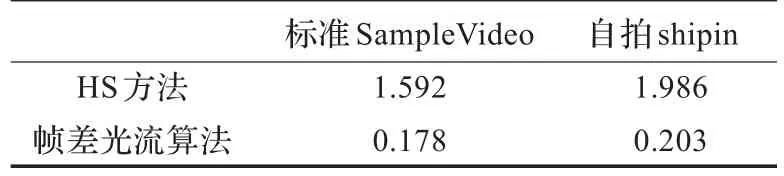

为了定量评价两种算法的优劣性,分别计算了两种算法的用时,其对比如表1所示。

表1 两种算法结果耗时定量比较 s

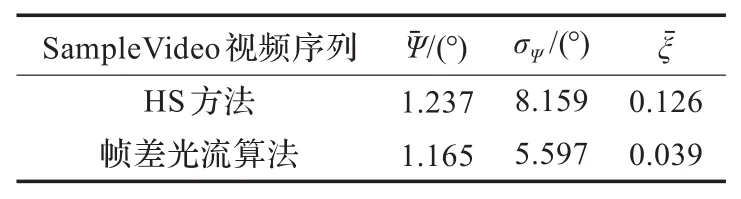

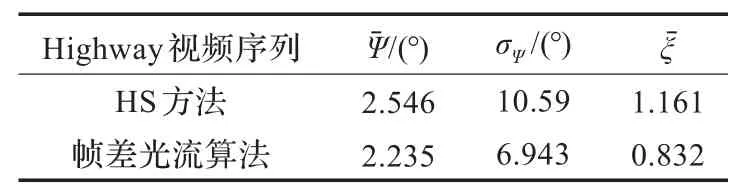

对光流计算结果进行误差估计,假定Vc(x,y)为真实的运动向量,Vg为计算所得的运动向量,则可以采用如下的方法进行误差估计,结果为表2和表3。

表2 SampleVideo序列两种光流算法误差比较

表3 highway序列的两种光流算法误差比较

(1)单个角度误差Ψ=arccos(Vc·Vg)

通过用时和误差分析可以看出,本文算法具有用时短、鲁棒性强、稳定性高的特点,能够比较稳定检测出图像序列中的光流。

5 结论

本文主要研究了帧间差光流场算法的原理以及应用,针对于光流算法在光流约束方程不成立时存在的无法检测到目标,本文提出了一种改进方法,引入通用动态图像模型,建立了像素点的梯度较大处的新的约束方程,提高了检测的精确性和检测时间,并且通过实例仿真,证明了算法的有效性与合理性。

[1]张娟,毛晓波,陈铁军,等.基于视频流连续性的快速运动目标检测方法[J].计算机应用研究,2010,27(8):3198-3200.

[2]Stein F.Efficient computation of optical flow using the census transform[J].Pattern Recognition,2004,3175(1):79-86.

[3]Wong K Y,Spetsakis M E.Tracking based motion segmentation under relaxed statistical assumptions[J].Computer Vision and Image Understanding,2006,101:45-64.

[4]魏巍,申铉京,千庆姬.工业检测图像灰度波动变化自适应阈值分割算法[J].自动化学报,2011,37(8):944-953.

[5]陈凤东,洪炳熔.基于动态阈值背景差分算法的目标检测方法[J].哈尔滨工业大学学报,2005,37(7):883-884.

[6]郝颖明,朱枫.2维Otsu自适应阈值的快速算法[J].中国图象图形学报,2005(4):484-488.

[7]Serre T,Kouh M,Knoblich U,et al.A theory of object recognition:computations and circuits in the feedforward path of the ventral steam in primate visual cortex[R].2005.

[8]Magee D.Tracking multiple vehicle using foreground background and motion models[J].Image and Vision Computing,2004,22(2):143-145.

[9]李超,熊璋,赫阳,等.基于帧间差的区域光流分析及其应用[J].计算机工程与应用,2005,41(31):195-197.

[10]Yuan Lei,Li Jinzong,Li Dongdong.Discontinuity preserving optical flow algorithm[J].Journal of Systems Engineering and Electronics,2007,18(2):347-354.

WU Zhenjie,MAO Xiaobo

School of Electrical Engineering,Zhengzhou University,Zhengzhou 450001,China

An improved optical flow estimation algorithm based on the frame difference is proposed,which is used for detecting the moving target.In the first part,the discontinuous frame difference is applied to detecting the moving target with the inter-frame displacement smaller than one pixel and accumulated displacement bigger than one pixel.In the second part,the General Dynamic Image Model(GDIM)is introduced to form a new optical constraint equation,which has overcome the problem that the equation is not tenable.Only not zero pixels are calculated by using the optical flow method.As a result,accuracy and speed of the target detection are improved.The effectiveness of the proposed method is verified by the simulation results.

target tracking;frame difference;optical flow;local optical flow

结合运动目标检测帧差法运算速度快和光流法活动目标检测准确度高的特点,提出一种改进的帧间差光流场计算的运动目标检测算法。在帧差部分采用隔帧差分从而可以检测到帧间位移小于1个像元而多帧累积位移大于1个像元的运动点目标;在光流计算时,引入通用动态图像模型(GDIM)建立新的光流约束条件,克服了亮度变化引起的约束方程不成立问题。算法仅对帧差法后图像中不为零的像素进行光流场计算,提高了目标检测的准确性和检测速度。仿真实验证明了该算法的有效性。

目标跟踪;帧差法;光流法;区域光流检测

A

TP39

10.3778/j.issn.1002-8331.1112-0475

WU Zhenjie,MAO Xiaobo.Improved optical flow estimation algorithm based on frame difference.Computer Engineering and Applications,2013,49(18):200-203.

高等学校博士学科点专项科研基金(No.20114101110005);河南省重大科技攻关项目(No.102101210100);河南省教育厅自然科学基础研究计划(No.2009A410001)。

吴振杰(1985—),男,硕士研究生,研究方向:计算机视觉;毛晓波(1965—),通讯作者,男,博士,教授,硕士生导师,研究方向:仿生机器视觉、智能仪器仪表。E-mail:mail-mxb@zzu.edu.cn

2011-12-26

2012-03-06

1002-8331(2013)18-0200-04

CNKI出版日期:2012-05-21 http://www.cnki.net/kcms/detail/11.2127.TP.20120521.1141.024.html

◎信号处理◎