基于局部-全局特征耦合与边界引导的遥感图像建筑物变化检测

摘 要:针对现有变化检测方法局部特征和全局特征难以兼顾、变化对象和背景之间分界模糊的问题,提出了一种基于局部-全局特征耦合与边界引导的遥感图像建筑物变化检测方法。该方法在编码阶段采用并行的卷积神经网络和Transformer分别提取遥感图像的局部特征与全局表示。在不同尺度下,使用局部-全局特征耦合模块融合局部特征和全局特征表示,以增强图像特征的表达能力。引入边界引导分支获取变化对象的先验边界信息,使其引导变化图突出建筑物的结构特征,促进边界精确定位。该方法在LEVIR-CD和WHU数据集上进行实验验证,其F1-score分别为91.25%和91.27%,IoU分别为83.90%和83.95%。实验结果表明,该方法在检测精度上有较大的提升,且具有良好的泛化能力。

关键词:遥感图像; 变化检测; 卷积神经网络; Transformer; 特征耦合; 边界引导

中图分类号:TP751.1 文献标志码:A

文章编号:1001-3695(2024)06-042-1888-05

doi:10.19734/j.issn.1001-3695.2023.09.0407

Building change detection in remote sensing images based onlocal-global feature coupling and boundary guidance

Abstract:The existing change detection methods are difficult to balance local features and global features, and the boundary between change objects and backgrounds is blurred, so this paper proposed a remote sensing image building change detection method based on local-global feature coupling and boundary guidance. In the encoding stage, the method adopted parallel convolutional neural network and Transformer to extract the local features and global representation of remote sensing images, respectively. At different scales, the local-global feature coupling module fused local features and global feature representation to enhance the expression ability of image features. In addition, it introduced the boundary guidance branch to obtain the prior boundary information of the change objects, so that its guide change map can highlight the structural characteristics of the building and promote the accurate boundary location. This paper conducted experiments on the LEVIR-CD and WHU datasets, resulting in F1-score of 91.25% and 91.27%, IoU of 83.90% and 83.95%, respectively. The experimental results show that the method has a great improvement in the detection accuracy and good generalization ability.

Key words:remote sensing images; change detection; convolutional neural network; Transformer; feature coupling; boundary guidance

0 引言

建筑物变化检测是指对特定地理区域内不同时期遥感图像进行检测,识别该区域内的建筑物是否发生变化[1]。随着对地观测技术的快速发展,遥感技术应用广泛,变化检测已经成为了遥感领域重要的研究课题。建筑物变化检测在城市地图更新[2]、土地利用[3]、城市规划[4]以及灾后评估[5]等方向的应用具有重大意义。

遥感图像的高空间分辨率使得图像细节更丰富、边界更复杂,这给变化检测任务带来了诸多挑战[6]。传统建筑物变化检测方法主要针对于中低分辨率遥感图像,通过提取建筑物的纹理、几何和光谱等低维特征判别是否发生变化,不仅特征表现能力较差,还容易受到光照条件、季节变化、传感器等因素的影响,显著影响了检测精度[7]。近年来,深度学习可以自适应提取大量遥感图像的深层特征,以更好地表达图像信息。因此,在遥感图像变化检测任务中,基于深度学习的方法成为研究热点。CNN作为经典的网络结构被引入变化检测任务中,Fang等人[8]对CNN构建密集的跳跃连接,减少了深层网络丢失的信息,提高了检测精度。但是CNN感受野小,容易丢失全局信息,对大目标建筑物检测不完整。BIT[9]首次引用了Transformer结构,其先使用浅层的CNN提取特征,再使用Transformer获取不同时间的图像特征。但是这种CNN和Transformer混合的方法不合适,浅层的CNN结构仍然会丢失全局信息。Bandara等人[10]使用多个Transformer块构建编码器,有效地提取了多尺度全局特征表示,但是无法兼顾局部细节。Conformer[11]是首个将CNN和Transformer并行的网络结构,其将局部特征耦合进Transformer结构中,经过多头自注意力后,又将全局特征耦合进CNN结构中,有效地结合了互补特征。Zhang等人[12]在医学图像分割任务上提出了一种新颖的双融合技术,利用注意力机制可以有效地耦合并行的局部特征和全局特征,为并行的CNN和Transformer网络结构提供新的解决方案。

在建筑物变化检测任务中,建筑物分布密集、屋顶材质不同和阴影遮挡等问题,使得建筑物与背景分界模糊,影响了检测精度[13]。EGRCNN[14]是一种边界引导的循环卷积神经网络模型,其在生成变化图的同时提取边界图,通过边界损失函数对其进行约束,进而生成更关注边界的变化图。MAEANet [15]对解码后的特征使用通道注意力机制和轮廓注意力机制增强特征的边界信息。EGCTNet[16]是一种基于边界引导的CNN和Transformer结合的建筑物变化检测网络模型,其构造了并行的CNN和Transformer网络结构,能有效地提取局部特征和全局特征,还构建了一个额外的边界提取分支用于提取边界信息,将其融入语义特征中引导模型关注边界结构特征。但是EGCTNet只是对局部特征和全局特征进行简单连接,特征耦合不够充分,对边界信息处理过于复杂。Sun等人[17]在伪装目标检测任务上提出了一种简单而有效的边界检测结构,提取边界信息作为额外的先验信息,以解决物体与背景之间的分界模糊问题。

综上所述,在遥感图像变化检测方法中,存在并行的CNN和Transformer提取的局部特征和全局特征耦合不充分、变化对象和背景之间分界模糊的问题。受到上述一些研究的启发,本文提出了一种基于局部-全局特征耦合与边界引导的遥感图像建筑物变化检测方法(building change detection in remote sensing images based on local-global feature coupling and boundary guidance,LGC-BGNet)。LGC-BGNet中的局部-全局特征耦合模块(LGCM)使用不同的注意力机制,分别对局部特征和全局特征增强局部细节和全局上下文信息,再对其进行交互融合,以增强特征的表达能力。在解码器阶段构建了一个差分增强模块(DEM)用于学习更具有判别能力的变化图。另外设计了一个用于建筑物变化检测任务上的边界引导分支,该分支先提取了低级边界特征和高级语义特征,融合得到先验边界信息,并使用损失函数对其约束。然后将先验边界信息注入各个尺度的变化图特征中,引导模型关注建筑物的边界结构细节。

1 网络结构

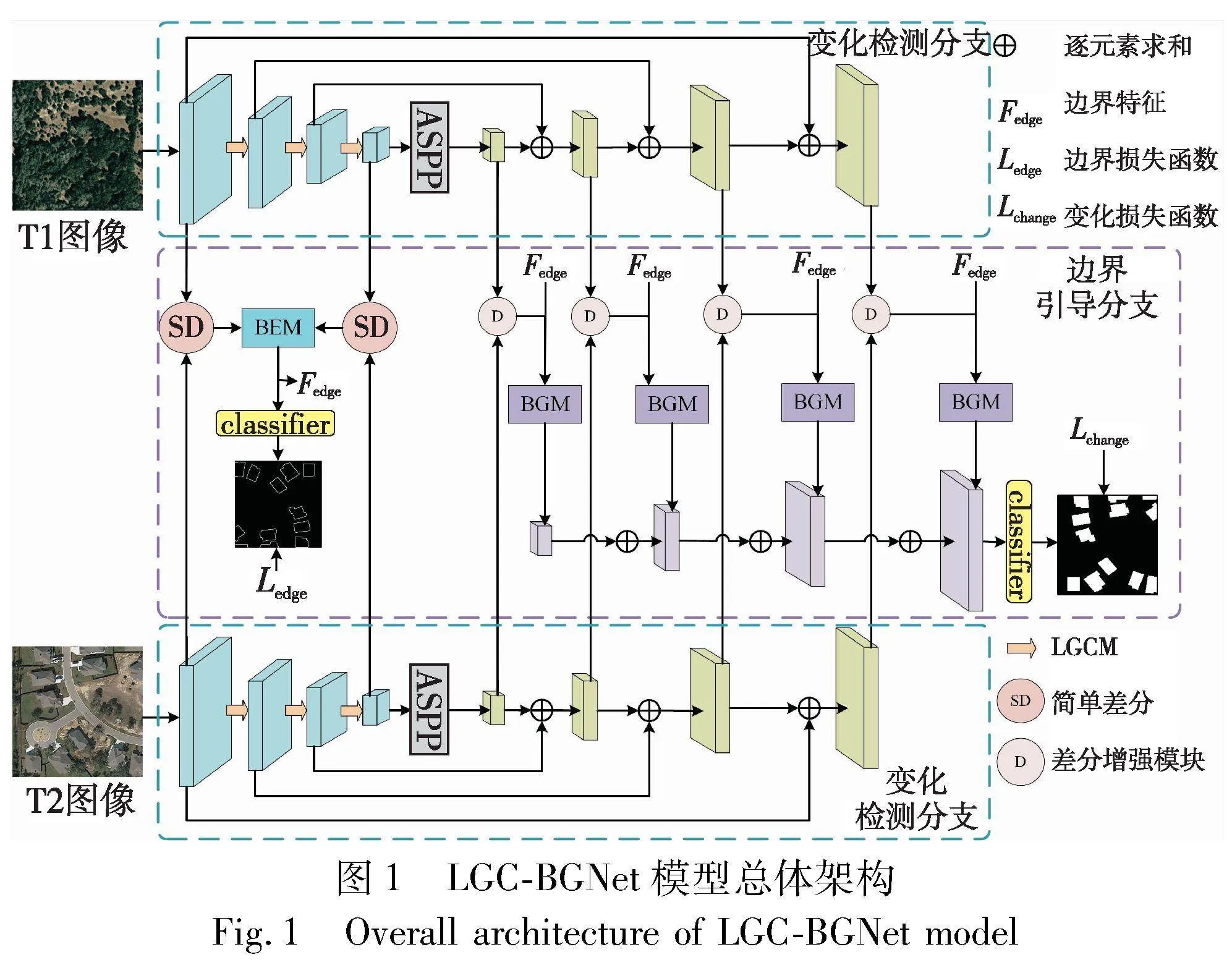

1.1 网络总体概述

图1为LGC-BGNet的总体架构,该结构主要分为变化检测分支和边界引导分支两个部分。变化检测分支使用了编码器-解码器结构,在编码器中使用了并行的ResNet分支[18]和Transformer分支[10]分别提取双时相遥感图像的多尺度局部特征和全局特征,并在每个尺度对局部特征和全局特征使用LGCM进行耦合,得到兼顾局部细节和全局空间信息的多尺度特征。最后一层经过一个空洞空间金字塔(ASPP)[19],以增强多尺度特征。在解码器中将编码器中的四个特征进行逐元素求和,以得到相应的多尺度变化图,多边输出融合策略可以解决遥感卫星图像背景复杂的问题[20]。然后使用DEM对每个尺度的变化图生成更有判别能力的差分变化图,减少背景噪声等干扰。边界引导分支包含了边界提取模块(BEM)和边界引导模块(BGM)。边界特征是浅层的低级特征,但是低级特征中又包含诸多无关变化的噪声,所以选择第一层具有边界细节的低级特征和第四层具有空间位置信息的高级语义特征。为了减少特征的丢失,使用了简单差分操作(SD)得到差分变化图,再经过BEM提取边界特征,得到先验边界信息,经过分类得到边界差分变化图,使用损失函数对其进行约束。最后使用多个BGM将先验边界信息与每个尺度的变化图结合,以增强边界表示,引导模型关注于建筑物的结构和边界细节,最后经过分类输出最终的变化图。

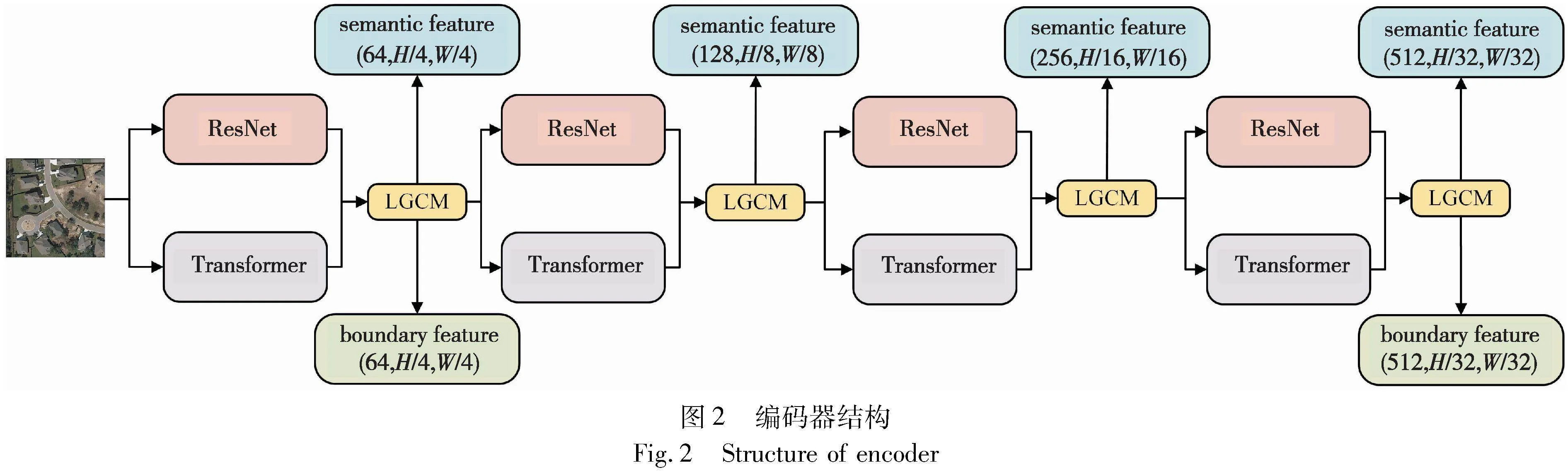

1.2 编码器

1.2.1 特征提取结构

编码器结构如图2所示,其由ResNet分支、Transformer分支和LGCM模块组成。并行的ResNet分支和Transformer分支组成了特征提取结构,ResNet分支采用ResNet34网络作为骨干网络,通过堆叠4组残差块提取图像的多尺度特征,每个下采样残差块的通道数分别为64、128、256和512。ResNet分支为模型引入了平移不变性和局部相关性。

Transformer分支包含了下采样块、自注意力模块和线性层,同样使用了4组Transformer块提取多尺度特征,Transfor-mer分支为网络提取了全局上下文信息。由于Transformer需要使用大量的参数计算图像序列,所以引入序列缩减[21]减少参数数量。以下是序列缩减的简单公式:

K′=Reshape(HW/R,C·R)K(1)

Kout=Linear(C·R,C)K′(2)

其中:K是要缩减的序列;R是缩减比;H、W、C分别是图像的高、宽、通道数;Reshape将K变形为K′;Linear是全连接层;最后,输出Kout的序列为(HW/R,C·R),大大减少了参数量。

边界特征是浅层的低级特征,但是又因为低级特征中包含了诸多噪声,需要具有空间位置信息的高级语义特征对其进行约束,所以选择第一层和第四层的特征输入到后续的边界引导分支中。

1.2.2 局部全局特征耦合模块(LGCM)

为了有效地融合ResNet和Transformer分支的编码特征,本文提出了一种基于注意力机制的局部-全局特征耦合模块(LGCM)。图3所示是LGCM的结构,在LGCM中对于ResNet分支提取的局部特征使用CBAM[22]中的空间注意力机制增强局部细节,并抑制无关变化的噪声干扰,使用通道注意力[23]对Transformer分支的全局特征起到促进的作用,增强全局信息。

在图3中,局部特征和全局特征分为两个分支,分别经过空间注意力和通道注意力,另有一个分支对局部特征和全局特征逐元素求和。具体公式如下:

g′=Sigmoid(MLP(MaxPool(g);AvgPool(g)))(3)

l′=Sigmoid(Conv(7×7)(MaxPool(l);AvgPool(l)))(4)

b=Conv(3×3)(g+l), f=Residual(Cat[g′,b,l′])(5)

其中:g是Transformer分支输出的全局特征;l是ResNet分支输出的局部特征;MaxPool是最大池化;AvgPool是平均池化;MLP是多层感知机;Conv(7×7)是7×7卷积;Conv(3×3)是3×3卷积;Cat是连接操作;Residual是残差操作;g分别进行最大池化和平局池化,再通过MLP,最后经过一个sigmoid函数,得到g′,完成对g的通道注意力操作。同样对l进行最大池化和平局池化,经过一个7×7的卷积,最后使用一个sigmoid函数得到l′。经过对g和l的逐元素求和运算,得到交互特征b。通过Cat操作,将g′、l′和b在通道上连接,最后使用Residual块获取特征f,有效地获取当前尺度的局部细节和全局上下文信息。

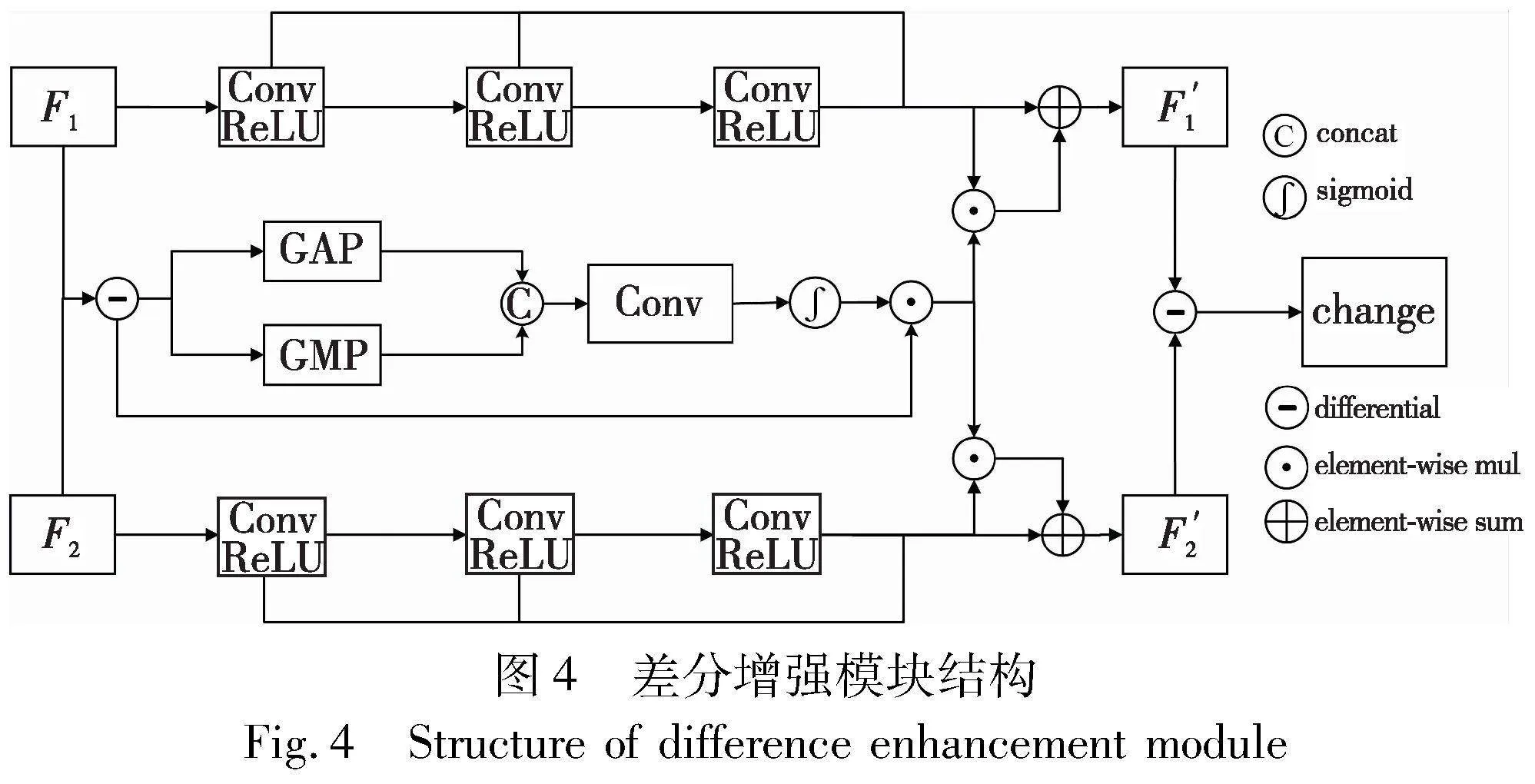

1.3 差分增强模块(DEM)

在遥感图像变化检测任务流程中,双时相图像的差分操作是关键一环。图4所示是本文提出的DEM结构,分为两个分支,其中一个分支分别在双时相特征上使用连续三个卷积块,每个卷积块包括卷积、BN和ReLU操作,用于增强变化区域的特征细节,可以获得更准确的边界。另一个分支对双时相图像进行差分,然后使用全局平局池化和全局最大池化增强差分信息,最后将差分信息分别融入双时相特征中,再一次经过差分得出差分变化图。

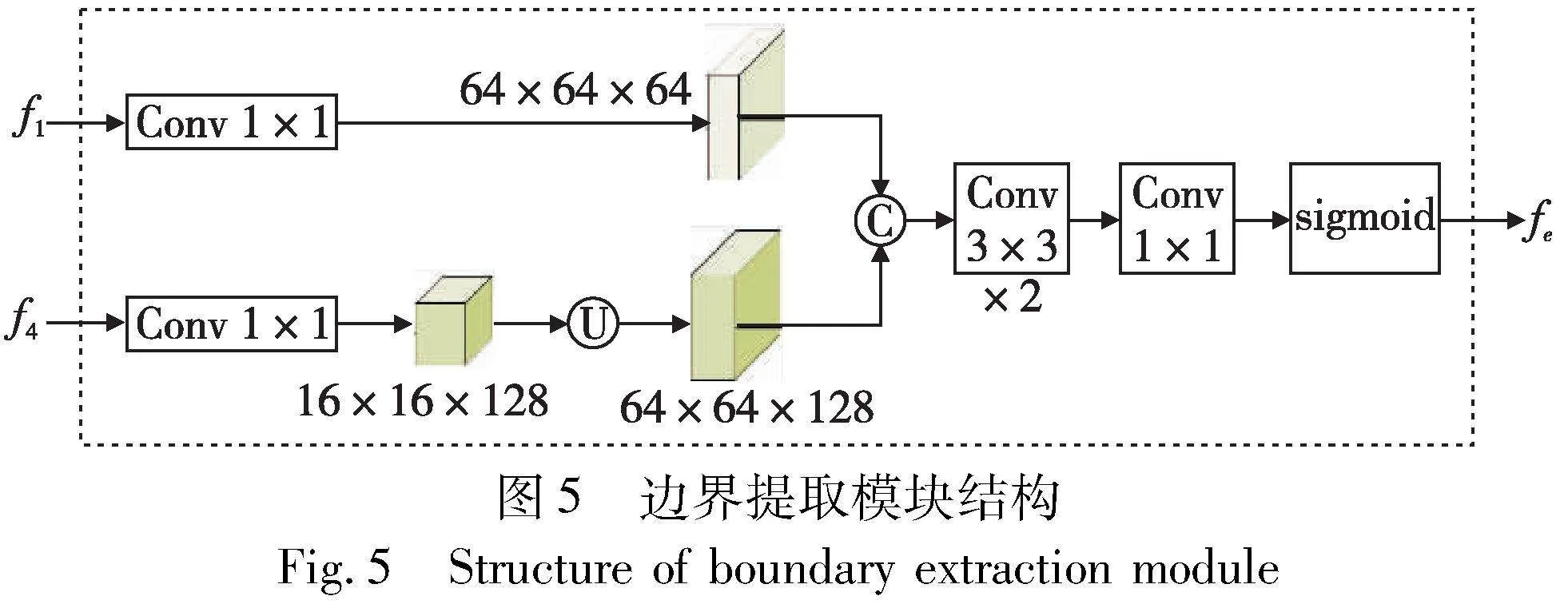

1.4 边界提取模块(BEM)

先验边界信息有助于对图像中的对象进行分割和定位。低级特征中包含着丰富的边界细节,但是也引入了许多非变化对象的噪声干扰,所以需要结合高级语义特征的空间位置信息促进对变化对象的边界定位。图5所示是BEM的网络结构,该模块结合了低级特征(f1)和高级特征(f4),提取变化对象的边界特征。首先将两个特征分别输入两个1×1卷积,对f4进行降维操作,然后将f1与上采样的f4按特征通道连接,再经过两个3×3卷积、一个1×1卷积和sigmoid函数,输出边界特征fe,fe经过分类后得到边界变化图,并使用损失函数对其进行约束,得到更准确的fe作为先验边界信息。

1.5 边界引导模块(BGM)

边界引导模块的目的是将先验边界信息输入到模型中,引导变化对象增强边界特征,提高边界完整性,降低漏检率。

图6所示是BGM的结构,fe是BEM中提取的先验边界信息,fi是DEM输出的多尺度差分变化图,CBAM是卷积注意力机制模块。输入特征fi(1,2,3,4)和fe,对fe进行下采样操作,使其与fi尺度对齐,再对fi和fe使用跳跃连接和逐元素相乘操作后,通过一个3×3卷积输出融合后的特征。为了增强特征细节,引入CBAM,通过通道注意力和空间注意力的作用促进特征的局部细节,CBAM输出的特征与融合后的特征逐元素相乘,再经过一个1×1卷积输出最终的变化图特征fi′。

1.6 损失函数

本文使用的损失函数包括了变化检测分支和边界引导分支的损失,公式如下:

L=λLDice+LBCE(6)

其中:LDice是监督边界引导分支的Dice Loss函数;LBCE是监督变化检测分支的二元交叉熵损失(BCE Loss)函数;λ是预定义的超参数,用于平衡两个损失函数。在变化检测任务中,变化像素的数量远少于未变化像素,Dice Loss函数常用于正负样本极其不平衡的任务上,在本文中用于边界引导分支。公式如下:

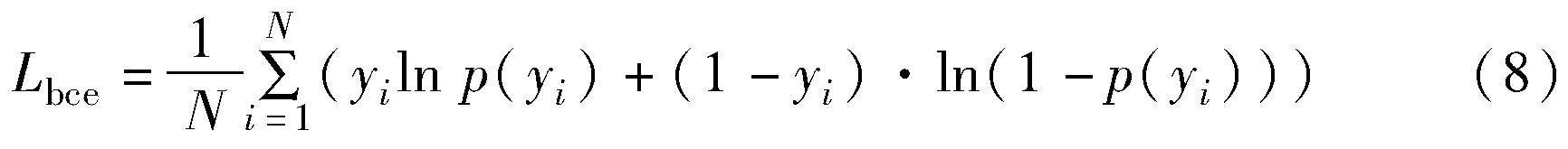

其中:X为预测为变化的置信度;Y是标签;∩是X与Y的交集。BCE Loss常用于二分类任务中,变化检测分为变化和未变化两类,公式如下:

其中:N是标签中的像素总数;yi是像素的标签;p是N个点为正样本的预测概率。

2 实验与分析

为了验证LGC-BGNet在建筑物变化检测任务上的有效性,选择在LEVIR-CD[24]和WHU[25]两个公开数据集与近年来多种先进的变化检测方法进行比较,并分析比较结果。

2.1 数据集介绍

1)LEVIR-CD数据集 LEVIR-CD数据集的双时相遥感图像来源于谷歌地球,其包含了637个超高分辨率(0.5 m/像素)图像对,每个图像的大小是1024像素×1024像素,时间跨度为5~14年。这些遥感图像的土地利用形式具有显著变化,主要是建筑物,涵盖了别墅住宅、车库、高层公寓等各类建筑物,重点关注于密集的小型建筑物。图像对中存在由季节性变化和光照变化引起的变化,在变化检测方法中,这可以减轻不相关变化对实际变化的影响。在实验前将每张图像裁剪成16张不重叠的256像素×256像素大小,保持原数据集所划分的训练集、验证集和测试集不变。

2)WHU建筑物数据集 WHU建筑物变化检测数据集是分别于2012年和2016年所拍摄的两组航空数据,地面空间分辨率为0.3 m,选取了大约1.6万个建筑物。数据集中存在多种尺度变化较大的建筑物,主要关注大而稀疏的建筑物。在实验前将原数据集裁剪成7 680张不重叠的256像素×256像素的图像对,并且随机以7∶2∶1的比例划分成训练集、验证集和测试集。

2.2 实验细节和评价指标

本文以PyTorch框架构建LGC-BGNet模型,使用NVIDIA GeForce RTX 2080 12G GPU对其进行训练。在数据输入前,对实验数据进行了数据增强,包括随机翻转、高斯模糊和随机裁剪等。在训练时,使用了AdamW优化器进行训练,初始学习率设置为0.000 2,权重衰减为0.01。批量大小设置为8,训练轮数设置为150。为了保证实验的可信性,对所有进行比较的方法尽可能使用相同的数据增强操作和超参数。

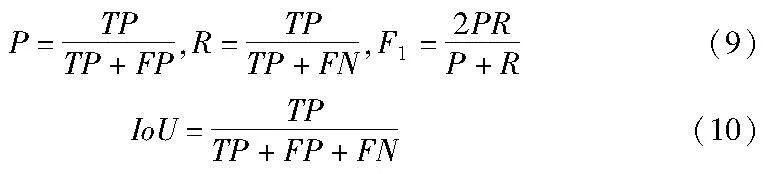

在实验中,选择使用准确率(precision,P)、召回率(recall,R)、F1-score(F1)和交并比(IoU)作为变化检测任务的主要指标。

其中:TP表示真阳性;TN表示真阴性;FP表示假阳性;FN表示假阴性;P值越高,误检率越低;R值越高,漏检率越低;F1和IoU分别可以表示模型的平均性能和泛化能力。

2.3 对比实验

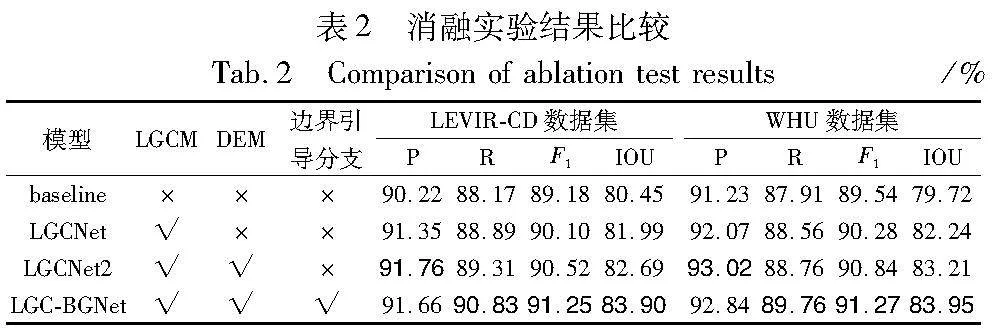

为了证明LGC-BGNet方法的有效性,将其与近几年变化检测任务的先进方法进行对比,包括STA-Net[24]、SNUNet[8]、BIT[9]、ChangeFormer[10]和EGCTNet[16],对比实验结果如表1所示。

LGC-BGNet在LEVIR-CD数据集上P和R分别达到了91.66%和90.83%,F1和IoU分别达到了91.25%和83.90%,相比于EGCTNet,LGC-BGNet的R、F1和IoU指标分别提高了1.62%、0.57%、0.95%。在WHU数据集上P和R分别达到了92.84%和89.76%,F1和IoU分别达到了91.27%和83.95%,相比于EGCTNet,LGC-BGNet的R、F1和IoU指标分别提高了1.68%、0.57%、0.97%。从实验数据可知,LGC-BGNet在召回率上提升较多,所以其F1和IoU指标均取得了最优的结果。总之,LGC-BGNet方法在两个数据集上均取得了优秀的实验结果,在密集的小型建筑物和稀疏的大型建筑物上的检测精度优于之前的几种方法,验证了其优异的泛化能力。

图7所示是各个方法在两个数据集实验的部分可视化结果。第1~4行是LEVIR-CD数据集的结果,第5~7行是WHU数据集的结果。STANet和SNUNet方法未引入Transformer结构,相比于其他方法,难以检测到完整的大型建筑物变化信息。然而,从第1、3、5、6行可知,BIT、ChangeFormer和EGCTNet方法虽然可以提取较为完整的全局表示,但是仍然存在局部细节丢失的问题。从第2~4行的框中可以看到,在密集分布的小型建筑物上,LGC-BGNet检测出更精细的局部细节信息,第7行显示其相比于其他方法,可以显示更完整、平滑的建筑物边界结构。综上所述,LGC-BGNet结合了CNN和Transformer的优点,在小型建筑物和大型建筑物中的检测结果均表现优异,不仅识别出了完整的全局信息,且在局部细节信息上更加精细,建筑物边界比其他方法更加突出。

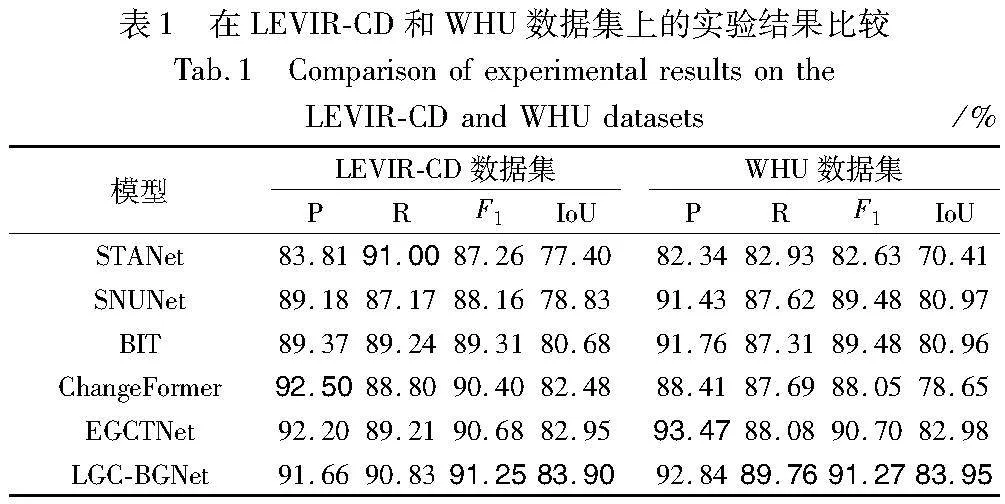

2.4 消融实验

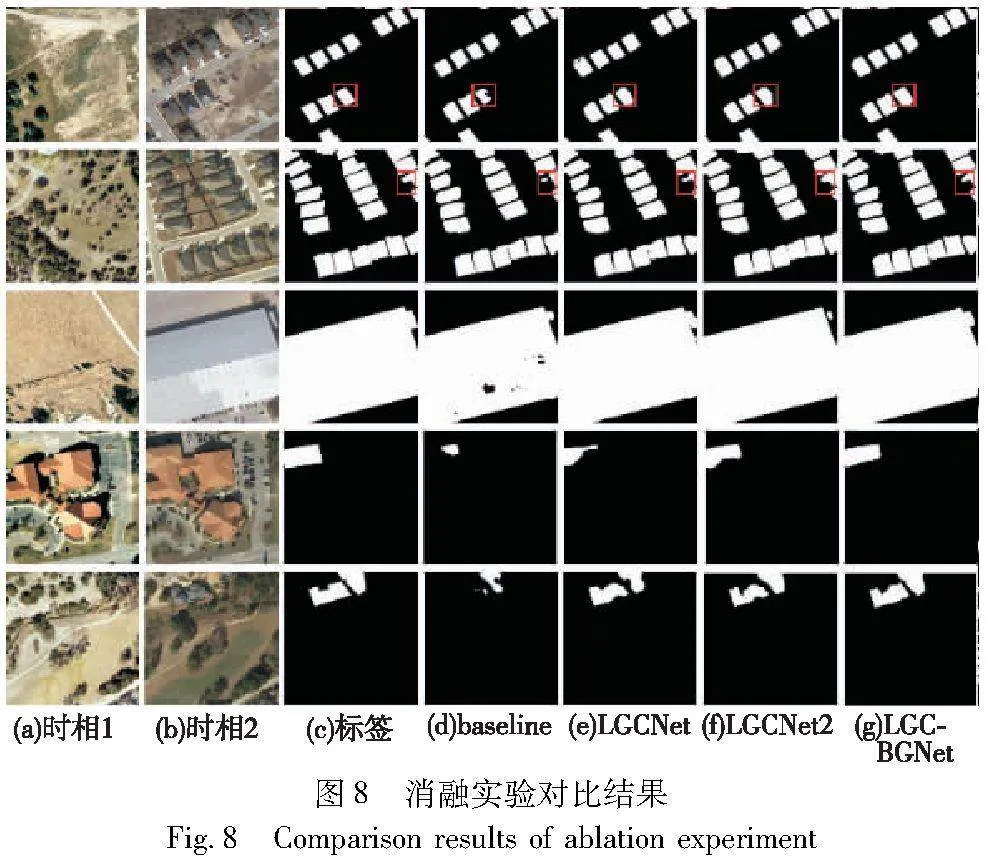

为了验证LGC-BGNet模型中的LGCM、DEM和边界引导分支的有效性,本文在LEVIR-CD和WHU数据集上进行消融实验。Baseline使用并行的ResNet和Transformer编码器用于提取图像特征,其局部特征和全局特征的耦合方式为简单求和,并设计了三组比较实验。LGCNet组实验在baseline上增加LGCM模块,LGCNet2组在LGCNet组的基础上使用了DEM,最后一组就是完整的LGC-BGNet。其结果如表2所示。黑体加粗表示结果最优。

通过表2可知,LGCNet组在baseline基础上增加LGCM模块后,在LEVIR-CD数据集上准确率和召回率分别提升了1.13%和0.72%,在WHU数据集上准确率和召回率分别提升了0.84%和0.65%。LGCM对局部特征与全局特征进行交互耦合,不仅减少了噪声干扰,还保留了局部细节特征和全局上下文信息,所以有效地降低了误检率和漏检率。LGCNet2引入了DEM模块,相比于LGCNet,在LEVIR-CD数据集上准确率和召回率分别提升了0.41%和0.42%,在WHU数据集上准确率和召回率分别提升了0.95%和0.20%,这表明了DEM增强双时相特征差分信息的有效性。LGC-BGNet组在引入边界引导分支后,在LEVIR-CD数据集上召回率、F1和IoU分别提升了1.52%、0.73%和1.21%,准确率下降了0.1%;在WHU数据集上召回率、F1和IoU分别提升了1.00%、0.43%和0.74%,准确率下降了0.18%,这表明先验边界信息引导变化图关注边界特征,有效地降低了漏检率,所以召回率大幅度提升,而准确率略微降低是因为先验边界信息会引入一些噪声,但是在两个不同的数据集上总体性能还是取得较大的提升,有效地证明了边界引导分支的泛化能力。图8所示为消融实验对比结果。在baseline的结果中,从第1、2行中可以看到,对于密集建筑物存在一些局部细节的缺失,从第3~5行可知,在大型建筑物检测上存在着全局信息不完整的问题。LGCNet组实验结果所示,引入LGCM模块的LGCNet在局部细节和全局上下文信息的完整性上都优于baseline,验证了LGCM模块的有效性。从LGCNet2组实验可知,增加了DEM模块后,检测出的变化区域更加完整。从LGC-BGNet组的第1和2行突出显示中可知,增加边界引导分支后,增强了变化对象的边界结构细节,从第3~5行可知,检测出了更完整的变化区域,降低了漏检率,验证了边界引导分支的有效性。

3 结束语

针对高分辨率遥感图像的建筑物变化检测任务,本文设计了一种基于局部-全局特征耦合与边界引导的LGC-BGNet模型。其中设计的局部全局耦合模块通过对并行的局部特征和全局特征进行交互、耦合,促进了模型的特征表示;设计的差分增强模块能够有效地增强双时相特征的差异信息;引入边界引导分支提取的先验边界特征,有效地降低了漏检率,并且在小型密集的建筑物和大型稀疏建筑物上都表现良好。

尽管LGC-BGNet在LEVIR-CD和WHU数据集上都取得了良好的结果,但是也存在一定的局限性。由于设计了多个结构化模块,使用了许多注意力机制,增加了模型的复杂度,提高了一定的计算量,日后的研究工作中,在保证模型性能的前提下,本文将优化模型结构以降低计算量。

参考文献:

[1]Qin Rongjun, Tian Jiaojiao, Reinartz P. 3D change detection-approaches and applications[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2016, 122: 41-56.

[2]Wen Dawei, Huang Xin, Bovolo F, et al. Change detection from very-high-spatial-resolution optical remote sensing images: methods, applications, and future directions[J]. IEEE Geoscience and Remote Sensing Magazine, 2021,9(4): 68-101.

[3]Zhu Qiqi, Guo Xi, Deng Weihuan, et al. Land-use/land-cover change detection based on a siamese global learning framework for high spatial resolution remote sensing imagery[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2022, 184: 63-78.

[4]陈璐, 管霜霜. 基于深度学习的城市高分遥感图像变化检测方法的研究[J]. 计算机应用研究, 2020, 37(S1): 320-323. (Chen Lu, Guan Shuangshuang. Research on change detection method of urban high-resolution remote sensing image based on deep learning[J]. Application Research of Computers, 2020,37(S1): 320-323.)

[5]Yang Chao, Xia Rongling, Li Qingquan, et al. Comparing hillside urbanizations of Beijing-Tianjin-Hebei, Yangtze River Delta and Guangdong-Hong Kong-Macau greater Bay area urban agglomerations in China[J]. International Journal of Applied Earth Observation and Geoinformation, 2021,102: 102460.

[6]Zheng Hanhong, Gong Maoguo, Liu Tongfei, et al. HFA-Net: high frequency attention siamese network for building change detection in VHR remote sensing images[J]. Pattern Recognition, 2022, 129: 108717.

[7]Jiang Huiwei, Peng Min, Zhong Yuanjun, et al. A survey on deep learning-based change detection from high-resolution remote sensing images[J]. Remote Sensing, 2022,14(7): 1552.

[8]Fang Sheng, Li Kaiyu, Shao Jinyuan, et al. SNUNet-CD: a densely connected siamese network for change detection of VHR images[J]. IEEE Geoscience and Remote Sensing Letters, 2021, 19: 1-5.

[9]Chen Hao, Qi Zipeng, Shi Zhenwei. Remote sensing image change detection with transformers[J]. IEEE Trans on Geoscience and Remote Sensing, 2021, 60: 1-14.

[10]Bandara W G C, Patel V M. A transformer-based siamese network for change detection[C]//Proc of IEEE International Geoscience and Remote Sensing Symposium. Piscataway, NJ: IEEE Press, 2022: 207-210.

[11]Peng Zhiliang, Huang Wei, Gu Shanzhi, et al. Conformer: local features coupling global representations for visual recognition[C]//Proc of IEEE/CVF International Conference on Computer Vision. Pisca-taway, NJ: IEEE Press, 2021: 357-366.

[12]Zhang Yundong , Liu Huiye , Hu Qiang . Transfuse: fusing transformers and CNNs for medical image segmentation[C]//Proc of the 24th International Conference on Medical Image Computing and Computer Assisted Intervention. Cham: Springer, 2021: 14-24.

[13]Zhou Yuan, Chen Zhanlong, Wang Bin, et al. BOMSC-Net: boun-dary optimization and multi-scale context awareness based building extraction from high-resolution remote sensing imagery[J]. IEEE Trans on Geoscience and Remote Sensing, 2022, 60: 1-17.

[14]Bai Beifang, Fu Wei, Lu Ting, et al. Edge-guided recurrent convolutional neural network for multitemporal remote sensing image building change detection[J]. IEEE Trans on Geoscience and Remote Sensing, 2021, 60: 1-13.

[15]Yang Bingjie, Huang Yuancheng, Su Xin, et al. MAEANet: multiscale attention and edge-aware siamese network for building change detection in high-resolution remote sensing images[J]. Remote Sensing, 2022,14(19): 4895.

[16]Xia Liegang, Chen Jun, Luo Jiancheng, et al. Building change detection based on an edge-guided convolutional neural network combined with a transformer[J]. Remote Sensing, 2022,14(18): 4524.

[17]Sun Yujia , Wang Shuo, Chen Chenglizhao, et al. Boundary-guided camouflaged object detection[EB/OL]. ( 2022-07-02). https://arxiv.org/abs/2207.00794.

[18]He Kaiming, Zhang Xiangyu, Ren Shaoqing, et al. Deep residual learning for image recognition[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2016: 770-778.

[19]Chen L C, Papandreou G, Kokkinos I, et al. DeepLab: semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs[J]. IEEE Trans on Pattern Analysis and Machine Intelligence, 2017, 40(4): 834-848.

[20]朱节中, 陈永, 柯福阳,等. 基于Siam-UNet+的高分辨率遥感影像建筑物变化检测[J]. 计算机应用研究, 2021, 38(11): 3460-3465. (Zhu Jiezhong, Chen Yong, Ke Fuyang, et al. High resolution remote sensing image building change detection based on Siam-UNet+[J]. Application Research of Computers, 2021,38(11): 3460-3465.)

[21]Sunkara R, Luo Tie. No more strided convolutions or pooling: a new CNN building block for low-resolution images and small objects[C]//Proc of Joint European Conference on Machine Learning and Know-ledge Discovery in Databases. Cham: Springer, 2022: 443-459.

[22]Woo S, Park J, Lee J Y, et al. CBAM: convolutional block attention module[C]//Proc of European Conference on Computer Vision. Cham: Springer, 2018: 3-19.

[23]Hu Jie, Shen Li, Sun Gang. Squeeze-and-excitation networks[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2018: 7132-7141.

[24]Bi Hongbo, Lu Di, Zhu Huihui, et al. STA-Net: spatial-temporal attention network for video salient object detection[J]. Applied Intelligence, 2021, 51: 3450-3459.

[25]Ji Shunping, Wei Shiqing, Lu Meng. Fully convolutional networks for multisource building extraction from an open aerial and satellite imagery dataset[J]. IEEE Trans on Geoscience and Remote Sensing, 2018, 57(1): 574-586.