基于循环生成对抗网络和Transformer的单幅图像去雾算法

王博 魏伟波 张为栋 潘振宽 李明 李金函

摘要:针对传统去雾算法在配对数据集上训练时产生过拟合的问题,基于密度和深度分解的非配对图像去雾网络模型,改进了自增强缩放网络。引入Transformer机制,将其与深度卷积神经网络模块深度融合,提出了一种使用未配对数据集训练的基于循环生成对抗网络和Transformer的CT-Nets图像去雾算法;提取输入图像的深度信息和散射系数特征值,利用大气散射模型尽可能恢复不同场景下真实雾的浓度信息,以提高去雾图像主观视觉质量;基于Swin-Transformer设计自增强精化层,以获得精细的细粒度信息,提高模型泛化能力和最终预测图像真实性。实验结果表明,相较于基于密度和深度分解的非配对图像去雾网络模型,CT-Nets图像去雾算法的峰值信噪比和结构相似性分别提升4%和4.1%。

关键词:深度学习;单幅图像去雾;自监督网络;循环生成对抗网络

中图分类号:TP391.41

文献标志码:A

光照经过不同介质时会发生漫散射,在有雾的特殊天气条件下,成像设备在获取数字图像时受到大气悬浮物的正透射光线影响会出现各种成像缺陷,如:动态范围缩小、对比度与饱和度降低、细节信息丢失和颜色偏移等,不仅影响图像的观赏价值,还会严重干扰视觉处理任务的输入、处理和输出。传统的去雾算法通常基于图像复原和图像增强理论,从统计分析或观察中发现无雾图像的先验,其中,暗通道先验理论[1]认为,在自然无雾图像中,红绿蓝(Red-Green-Blue,RGB)三通道原色的局部最低强度都应接近于零,通过捕捉有雾图像的暗通道图谱,结合先验的结果复原出无雾图像。由于在有雾场景下捕获的图像通常对比度较低,且伴随有限的场景可见性,二阶变分模型的图像去雾算法提出图像中有雾区域的值在RGB空间中主要呈一维线性分布,因此利用线与原点的偏移量并根据“马尔可夫随机场模型”,在给定噪声和散射的情况下,产生完整的正则化传输图可以达到去雾目的[2]。随着卷积神经网络(Convolutional Neural Network,CNN)的普及和大规模合成数据集的发展,基于深度学习的监督方法突破了手工制作先验的局限性并占据了主导地位。多尺度卷积网络去雾算法通过预测从粗到细的传输图,将先验信息融入到卷积层中,从而提取出有雾图像的特征[3]。粗尺度卷积神经网络输出粗略的透射率图,并作为细尺度卷积神经网络的输入。但在估计透射光和大气光时,可能会出现累积误差。为此,AOD-Net重新制定了大气散射模型公式,同时估计透射图和大气光[4]。尽管监督学习方法在合成数据集上展现出了优越的性能,但在训练时很容易产生过拟合问题,且不能很好地推广到其他有雾图像中,特别是处理真实环境雾气时。随着无监督学习方法的引入,适用于未配对数据集的学习模型中用于去雾的生成对抗网络[5]也可以达到一定的去雾效果。Dehaze-GAN算法[6]是利用对抗神经网络进行去雾的无监督学习算法,其利用基于U-net[7]体系结构的端到端生成式对抗网络训练方案,采用有雾图像的暗通道图提取和缩放的形式与模型中的特征融合,更好的保留图像细节。此后提出了循环生成对抗网络(Cycle-GAN),并快速应用于去雾算法的研究中[8]。Cycle-dehaze算法采用两组生成器和判别器来保持循环一致性,应用拉普拉斯金字塔网络处理高分辨率的图像时,通过增加循环感知一致性损失增强网络结构稳定性,从而训练得到生成器、全局或局部测试鉴别器等,最终预测去雾图像[9]。该模型没有引入大气散射模型,在生成有雾图像时,通常忽略深度和密度信息的多样性,导致生成的有雾图像失真,最终预测结果缺乏真实感。为解决过拟合和预测图像失真问题,本文提出一种图像去雾算法CT-Nets,采用未配对的数据集进行训练,在网络结构上采用基于Cycle-GAN的自监督学习网络;通过引入大气散射模型估计输入图像的散射系数和深度等物理量化信息;构建出深度捕获层、去雾层、自增强精化层3个独立的子网络并分别进行训练,相互配合,达到去雾目的。

1 图像去雾和Transformer机制相关研究

1.1 大气散射模型

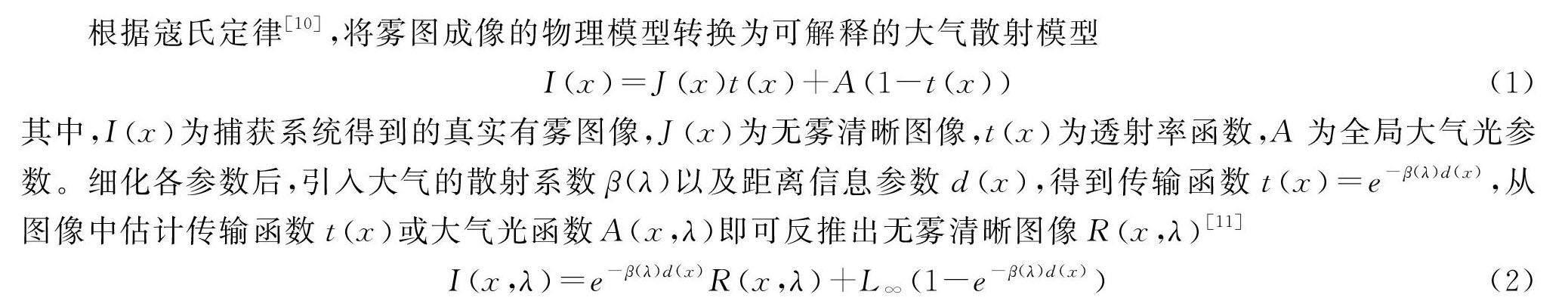

根据寇氏定律[10],将雾图成像的物理模型转换为可解释的大气散射模型

Ix=Jxtx+A1-tx(1)

其中,Ix为捕获系统得到的真实有雾图像,Jx为无雾清晰图像,tx为透射率函数,A为全局大气光参数。细化各参数后,引入大气的散射系数β(λ)以及距离信息参数dx,得到传输函数tx=e-β(λ)d(x),从图像中估计传输函数tx或大气光函数A(x,λ)即可反推出无雾清晰图像Rx,λ[11]

Ix,λ=e-β(λ)d(x)Rx,λ+L∞1-e-β(λ)d(x)(2)

1.2 基于密度和深度分解的神经网络

基于密度和深度分解的非配对图像去雾(Dehazing via Decomposing Transmission Map into Density and Depth,D4)模型是基于Cycle-GAN的无监督学习中较为先进的网络模型之一,模型中双循环“增雾—去雾,去雾—增雾”网络见图1[12]。

D4网络模型具有独立分层结构:深度捕获层、去雾层和精化层。将大气散射模型加入去雾网络层和深度捕获层,通过去雾网络得到针对密度系数的散射因子β;通过深度捕获层得到dx,然后通过传输函数tx反推出散射因子β;得到β的阈值,分别代入式(2),筛选出更接近于真实图像的预测图像。精化网络作为一个图像缩放网络,是以Efficientnet[13]为主体构建的CNN网络,作用是将初步预测出的小尺度有雾图像还原到与准确数据(GroundTruth)相同的尺度上。

1.3 Transformer机制

Transformer机制是深度学习常用的架构之一,最初应用于自然语言处理、语音识别等单一向量维度的学习算法中,替代处理序列数据常用的循环神经网络(RNN),后与CNN相结合使其适用于数字图像处理等领域[14],特点是通过自注意力机制和位置编码来捕捉输入序列中的长距离依赖关系。Transformer不受序列长度限制,在处理长序列数据时具有更高的效率和准确性,并能通过多头自注意力机制和前馈神经网络来提高模型的表达能力。

卷积神经网络构建于输入的局部连接上,通过不断迭代,逐渐扩大感受野,而Transformer则具备全局交互机制,其有效感受野能够迅速扩大[15]。对比DeepLabv3+和SegFormer的有效感受野[16]可以看出,相比于卷积神经网络,Transformer网络的有效感受野范围具备明显优势。虽然卷积核的尺寸可以设置为全图大小,但会显著增加参数的量,在图像数据处理中的应用价值不大。DeepLabv3+和SegFormer在有效感受野上的可视化对比见图2。

Transformer与CNN在连接范围、权重动态性和位置表示能力等方面存在区别与联系。CNN在处理长距离依赖关系时可能会受到限制,使其在复杂雾气场景下的性能下降。Transformer模型以自注意力机制为基础,能够捕获输入序列中的全局依赖关系,在长距离依赖建模方面表现优异。因此,Transformer所具备的长距离建模能力和并行计算能力可以应用于图像去雾领域[17]。利用Swin-Transformer[18]将两者相互融合,可以取长补短,充分发挥各自优势,该架构能将注意力限制在局部窗口内,进行显式交互,并引入局部特征学习[19]以建模局部关系,可作为深度神经网络的通用主干。

2 CT-Nets算法描述

CT-Nets在网络框架的设计上采用类D4网络模型,引入基于Swin-Transformer纹理深度还原机制的自增强精化(Self-Reinforced Refine,SR)层,替代D4中以Efficientnet为主体搭建的CNN网络。该层网络还融合了基于Swin-Transformer的适应性网络框架,最终得到的SR层为接近真实无雾图像预测并输出的关键,发挥了视觉Transformer在特征学习、结果产生和真值分配等方面的优势。下面从模型描述、训练过程和损失函数等方面详细阐述CT-Nets算法。

2.1 模型描述

CT-Nets框架流程主体的网络模型框架由D4网络模型改进而成,属于典型的类Cycle-GAN架构(图3)。网络可分为3个主要模块:去雾层(Nd)、深度捕获层(Ng)和自增强精化层(Nr)。所使用的数据集含真实无雾图集合(Rc):A(x,β)∈Rc和真实有雾图集合(Rh):B(z,β)∈Rh。

真实无雾循环分支如图4所示,将真实无雾图像Ax输入深度捕获层Ng,捕获当前场景中的深度信息

AxNgA[dx,β-](3)

通过式(3)捕获到当前输入真实无雾图像深度信息d,而β-为非固定阈值,通过调整β-值生成不同浓度的雾,结合均匀分布随机采样的散射因子,通过传输函数(公式(4))可以得到对应图像的密度信息

tx=e-β-d(x)(4)

β-的取值是“增雾”关键参数,需要通过训练得到,引入至式(5)得到伪增雾图像(图3(a)“FAKE HAZY”层),根据大气散射模型(式(2)),令A-x=L∞1-et(x),得到完整增雾公式

Cx=Ax-A-tx+A-(5)

图3(b)为“去雾—增雾”分支,该分支只调整了3个子网络的排列顺序,首先将真实雾像输入到去雾层(Nd),得到初步去雾图像,再将结果输入深度捕获层(Ng),捕获当前伪无雾图像场景中的密度和传输函数信息

Bx,βNgBtx︿,β-Bdx︿,β-(6)

通过式(6)得到当前伪无雾图像密度和传输函数(β,-tx︿)参数信息后,同样根据大气散射模型(式(2))得到当前深度信息模型

dx︿=ln [tx︿]-β-(7)

结合式(6)、(7)得到当前图像的深度图,再结合训练得到的散射因子β-,通过式(8)得到伪无雾图像(图3(b)“FAKE CLEAN”层),从而达到“去雾—增雾”的效果

Bx=CF-CLEANx︿e-β-d(x︿)+A1-e-β-d(x︿)(8)

图5为基于Transformer的SR层,即提取密度和浓度信息后,分别通过去雾网络层和深度捕获层网络得到初步处理后的图像,SR层是处理后图像进行超分的网络,是得到接近真实图像的重要步骤,因此采用基于Transformer精化层以及可学习的纹理提取器[20]。

在单图像超分辨率[21]任务中,利用参考图像进行超分辨率重建算法具有较高的泛化性,该算法中必须提取参考图像的纹理,因为准确和适当的纹理信息有助于超分辨率图像生成,并且参数将在端到端的训练过程中更新,而不是使用通过预先训练的分类模型提取的语义特征,从而得以捕获更精确的纹理特征。纹理特征Q(query)、K(key)和V(value)表示Transformer内部注意力机制的3个基本元素:Qi=EqiXLR↑,Ki=EkiXRef,Vi=EviXRef。其中,XLR↑、LR↑和Ref分别表示输入图像、4倍“双三次”上采样输入图像和参考图像,XLR↑代表先上采样再提取特征,XRef代表参考图像的像素信息。由于Ref图像和LR图像之间包含互补的尺度信息,将输入图像上采样到参考图像当中,可弥补Ref图像和LR图像之间的分辨率差距,保证输入的小尺寸图像和参考图像尺度对应纹理关系稳定匹配。CT-Nets算法利用数据集中初始的高分辨率干净无雾输入图像作为此精化层中的参考图像,不需要单独训练此网络层的数据集。

为解决参考图像中交换相关的纹理特征时出现匹配不当的问题,在训练中引入对应匹配和相似性感知纹理传递(图6)。首先将Qi和Ki分成若干patch,再计算两个patch间的相似度,找到Ki中和Qi的块最相似的位置。将Ref中对应位置的纹理特征迁移到LR中,并计算标注值,根据纹理特征对应关系大小分别赋予大或小的标注值,从而避免错误匹配对性能的影响。Alpi表示与对应第l个patch中特征量pi相关的注意力函数,ski表示从Ref图像中获取的Ki个纹理的权重系数,△pki表示第l个patch的Ki中对应的空间特征信息pki与pi的差值,pj表示对应patch中可学习的偏移量,mj表示对应patch中可学习掩码,累加运算,得

Alpi=∑Kk=1ski∑Jj=1Vlpi+△pki+pjmj(9)

2.2 训练过程和损失函数

训练过程中,CT-Nets 3个网络一起执行“去雾—增雾”或“增雾—去雾”循环。采用循环一致性损失和对抗性训练损失中的正则化惩罚项防止产生过拟合,通过伪散射系数监督损失强化对密度和深度两组物理特性的学习。循环一致性损失使两组特性相互影响,相互利用。A、B分别表示去雾和加雾映射函数,x、x分别示有雾和无雾图像的样本信息,循环生成对抗周期稳定性损失定义为

Lcyc=‖BAx-x‖+‖AB(x)-x‖(10)

针对去雾层(Nd),采取对抗性学习损失评估生成器所生成的图像是否达到要求的真实度。该层引入最小二乘法生成对抗网络[22](Least Squares Generative Adversarial Network,LS-GAN),利用其良好的稳定性保证了预测结果的图像质量。Ldisc表示判别器的损失函数;Lsac表示伪散射系数监督损失,用以约束β-FH-r(在增雾—去雾循环分支中产生模糊的随机抽样散射系数)和β-FH(从生成的有雾图像中估计的散射系数)的差值:Ladvdisc=[Dx-1]2+[Dx]2,Lsac=(β-FH-β-FH-r)2。

针对深度捕获层(Ng),由于训练集Bx中真实有雾图像没有直接输入到深度捕获层(Ng),导致无法直接获取真实有雾图像中地面真实散射系数。因此,采用交替随机抽样的散射系数和相应生成的模糊图像来训练所提出的去雾网络:伪深度监督损失,即采用从增雾后图像预测的深度图dx作为伪地面真实值,深度捕获层(Ng)从离散的图像Bx︿中估计深度图dx︿对抗性损失定义为:Ldepth=‖dx︿-dx‖。

针对SR层,生成器生成的低分辨率增雾或去雾后图像与初始输入原始图像作为训练的数据集,与原始图像的纹理分布一致,进而生成更加清晰、真实的纹理。采用重建损失函数:Lr=1CHW‖IHR-ISR‖,CHW分别表示高分辨率图像的通道数、高、宽的尺度信息,IHR和ISR分别表示作为Groundtruth的高分辨率图像和网络生成的“伪高分辨率”图像。利用λcyc、λadv和λsac平衡不同项的权重,可以得到:Ltotal=λcycLcyc+λadvLadv+λsacLsac。默认设置参数值分别为λcyc=λsac=1,λadv=0.2。

3 实验验证

3.1 真实场景下的对比实验

实验在Ubuntu18.04操作系统下运行,硬件为Intel(R)Core(TM) i7-8750H、16GB RAM、NVIDIA GTX1080 GPU,使用的编程语言和深度学习框架分别为python和pytorch。

考虑数据集的可采集性和严格配对性,通常采用室内数据集或室内、室外共同使用的数据集。但为还原出趋近于真实的图像,并且在实际应用中,室内出现雾的可能性极低,比较室内人工合成雾图像的去雾效果意义不大,因此所有的实验均采用Google提供的户外数据集SOT-outdoor。

对比算法有:FFA-Net[23]、HardGAN[24]、Cycle-dehaze[9]、D4[12]。Cycle-dehaze算法利用循环感知一致性损失思想和拉普拉斯金字塔模型改进和优化了Cycle-GAN的基础网络模型,在端到端的去雾算法中具有较高的参考价值;D4网络继承了Cycle-dehaze的优良特性并引入大气光散射模型,通过对图像进行雾浓度密度和像素深度分解,原出最接近真实场景下的参数信息,从而提升去雾能力(图7)。

可知,Cycle-dehaze网络未采用基于大气散射模型的设计,预测结果中忽略了真实场景下的深度信息,导致出现对比度过高,颜色失真,预测结果与GroundTruth之间偏离比较大,细节损失较多的问题。蓝色矩形框标注处,CT-Nets算法在细节上的去雾效果比其他算法更彻底、还原度更接近真实场景。基于平均PSNR数值最高的3个算法各自预测结果折线见图8。可以看出,CT-Nets算法预测图像的PSNR值相对稳定,在颜色还原、细节恢复等方面体现出了优势。

使用PSNR、结构相似性(SSIM)和色差公式[25](CIEDE2000)作为去雾算法的定量评估指标(表1)。PSNR和SSIM的数值越大表明去雾图像的质量越高,CIEDE2000数值越小代表复原图像的颜色失真程度越小。

相比于CNN模型生成的对抗网络,CT-Nets算法得益于对有雾图像和无雾图像的深度及密度信息的有效提取,以及加入感受野较大的Transformer机制,图像最终预测生成时,颜色、细节还原较好,在去雾效果的稳定度和真实性上优于以上其他去雾模型。

3.2 基于自建数据集的对比实验

模型训练时,基于监督学习的去雾算法需要大量精密的配对数据集,目前通常在室内进行人工“增雾”,或者对室外无雾图像进行雾气合成。这样虽然解决了数据集的规模化问题,但与真实场景下的有雾、无雾图像还有明显差距,而通过3D引擎自带的天气系统构建配对数据是一种有效的解决方法。在预测阶段的对比实验中,采用了基于“AnvilNext3.5”3D引擎制作的大尺度高清配对数据集,有雾图像通过最新的大规模场景渲染下3D引擎自带天气系统生成。

由于CT-Nets算法主要基于D4网络中三大网络层的基本框架结构,并在D4网络的基础上进行了优化和改进,因此,选取其他4种具有代表性的无监督算法进行效果对比。图9中,CT-Nets算法可以有效消除对于带有天空部分雾图的预测缺陷。可以看出,D4网络模型的预测结果中出现大量天空中不自然的涂抹痕迹,导致直观感受较差。选取对比实验中预测效果最好的3种算法的PSNR和SSIM绘制出对应对比曲线(图10),可以看出CT-Nets算法在测试集的PSNR和SSIM量化结果上能保持较高的去雾能力和预测结果平稳度。

3.3 消融实验

为充分比较引入基于Swin-Transformer的SR层之后对于模型带来的优化效果,设计两组对比实验。

首先,在训练过程中采用完全相同的数据集和硬件平台,设置相同的参数:β1=0.9、β2=0.999、学习率Learning rate=0.001、迭代次数=1 500 000,记录各自模型训练的拟合时间。经实验对比后,D4模型训练时间为153.35 h,CT-Nets模型训练时间为148.66 h,虽然理论上Transformer模型通常比EfficientNet更复杂,但从实验结果中可知:模型在优化之后,在训练时间上和D4算法相比提高了近3.1%。基于CNN的网络结构在处理视觉任务时需要在整个图像上使用卷积操作,较深的网络结构会影响计算效率。Swin-Transformer自身的分层结构和逐层的局部注意力机制使其更适用于需要全局信息的视觉任务,可以更好适应大规模数据集的训练,在处理低分辨率图像缩放的任务时,具备更好的拓展性。

在控制相同变量的条件下,两种算法各自从去雾网络输出小尺度的初步去雾图像后,分别输入基于EfficientNet的CNN精化层网络和基于Swin-Transformer的SR层的尺度效果对比(表2)。可知,通过生成器合成的同尺度雾图像和真实场景下的GroundTruth作损失比较,预测结果优于原CNN模型。Swin-Transformer机制将图像划分为若干非重叠的块,并在每个块内执行自注意力操作,该机制有别于需要较深网络设计的CNN模型,能够更高效地理解图像中的局部和全局特征,提取多尺度信息。Swin-Transformer机制能够更好地构建图像各层级特征提取的准确度,有效避免输入的小尺度图像中噪声影响。因此,得益于Swin-Transformer机制的全局性优势,CT-Nets在与EfficientNet模型接近的计算复杂度下,提升了图像缩放效果。

4 结论

CT-Nets算法在D4网络模型的基础上改进了自增强不成对图像去雾框架,利用大气散射模型,提取每幅图像的深度信息和散射系数特征值,尽可能多的还原不同场景下的真实雾厚度信息,在保证去雾后图像观赏性的同时还原更多的细粒度信息。将Transformer机制与CNN网络融合后,不仅可以保证基于大规模数据集训练的效率,也确保了预测图像的真实感。相关实验证明CT-Nets算法优于其它相关去雾方法。后续可考虑进一步研究云雾分离和天空中云彩细节恢复困难问题。

参考文献

[1]HE K, SUN J, TANG X. Single image haze removal using dark channel prior[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 33(12): 2341-2353.

[2]FATTAL R. Dehazing using color-lines[J]. ACM Transactions on Graphics, 2014, 34(1): 1-14.

[3]REN W Q, LIU S, ZHANG H, et al. Single image dehazing via multi-scale convolutional neural networks[C]// 14th European Conference on Computer Vision. Amsterdam: Springer, 2016: 154-169.

[4]LI B, PENG X, WANG Z, et al. An all-in-one network for dehazing and beyond[DB/OL]. [2023-12-15]. https://arxiv.org/abs/1707.06543.

[5]刘万军, 程裕茜, 曲海成. 基于生成对抗网络的图像自增强去雾算法[J/OL]. 系统仿真学报: 1-14[2023-12-15]. https://doi.org/10.16182/j.issn1004731x.joss.22-1551.

[6]REN W, ZHOU L, CHEN J. Unsupervised single image dehazing with generative adversarial network[J]. Multimedia Systems, 2023, 29(5): 2923-2933.

[7]RONNEBERGER O, FISCHER P, BROX T. U-net: Convolutional networks for biomedical image segmentation[C]// International Conference on Medical Image Computing and Computer-Assisted Intervention. Cham: Springer, 2015: 234-241.

[8]ZHU J Y, PARK T, ISOLA P, et al. Unpaired image-to-image translation using cycle-consistent adversarial networks[C]// IEEE International Conference on Computer Vision. Venice, 2017: 2223-2232.

[9]ENGIN D, GENC A, EKENEL H K. Cycle-dehaze: Enhanced cycleGAN for single image dehazing[C]// IEEE Conference on Computer Vision and Pattern Recognition Workshops. Salt Lake City, 2018: 938-946.

[10] KOSCHMIEDER H. Theorie der horizontalen Sichtweite[J]. Beitrage zur Physik der freien Atmosphare, 1924: 33-53.

[11] 王满利, 陈冰冰, 张长森. 基于扩展大气散射模型的低光照图像增强算法[J]. 光子学报, 2023, 52(6): 226-243.

[12] YANG Y, WANG C Y, LIU R S, et al. Self-augmented unpaired image dehazing via density and depth decomposition[C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans, 2022: 2037-2046.

[13] TAN M, LE Q. Efficientnet: Rethinking model scaling for convolutional neural networks[DB/OL] [2023-12-15]. https://arxiv.org/abs/1905.11946

[14] 洪季芳. Transformer研究现状综述[J]. 信息系统工程, 2022(2): 125-128.

[15] KHAN S, NASEER M, HAYAT M, et al. Transformers in vision: A survey[J]. ACM Computing Surveys, 2022, 54(10s): 1-41.

[16] XIE E Z, WANG W H, YU Z D, et al. SegFormer: Simple and efficient design for semantic segmentation with transformers[C]// 35th Conference on Neural Information Processing Systems (NeurIPS). Electr Network, 2021: 12077-12090.

[17] 张凯丽, 王安志, 熊娅维, 等. 基于Transformer的单幅图像去雾算法综述[J/OL]. 计算机科学与探索: 1-19[2023-12-15]. http://kns.cnki.net/kcms/detail/11.5602.TP.20231102.0938.002.html.

[18] LIANG J Y, CAO J Z, SUN G, et al. Swinir: Image restoration using swin transformer[C]// 18th IEEE/CVF International Conference on Computer Vision. Electr Network, 2021: 1833-1844.

[19] CAO J Z, LIANG J Y, ZHANG K, et al. Reference-based image super-resolution with deformable attention transformer[C]// 17th European Conference on Computer Vision. Tel Aviv, 2022: 325-342.

[20] YANG F Z, YANG H, FU J L, et al. Learning texture transformer network for image super-resolution[C]// IEEE/CVF Conference on Computer Vision and Pattern Recognition. Washington, 2020: 5791-5800.

[21] LU Z S, LI J C, LIU H, et al. Efficient transformer for single image super-resolution[DB/OL] [2023-12-15]. https://arxiv.org/abs/2108.11084.

[22] MAO X D, LI Q, XIE H R, et al. Least squares generative adversarial networks[C]// IEEE International Conference on Computer Vision, 2017: 2794-2802.

[23] QIN X, WANG Z L, BAI Y C, et al. FFA-Net: Feature fusion attention network for single image dehazing[C]// 10th AAAI Conference on Artificial Intelligence. New York, 2020: 11908-11915.

[24] DENG Q L, HUANG Z L, TSAI C C, et al. Hardgan: A haze-aware representation distillation GAN for single image dehazing[C]// European Conference on Computer Vision. Cham: Springer, 2020: 722-738.

[25] SHARMA G, WU W C, DALAL E N. The CIEDE2000 color-difference formula: Implementation notes, supplementary test data, and mathematical observations[J]. Color Research & Application, 2010, 30(1): 21-30.

[26] QU Y Y, CHEN Y Z, HUANG J, et al. Enhanced pixzpix dehazing network[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2019: 8160-8168.

[27] CHEN Z Y, WANG Y C, YANG Y, et al. PSD: Principled synthetic-to-real dehazing guided by physical priors[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Electr Network, 2021: 7180-7189.

[28] YANG X T, XU Z, LUO J B. Towards perceptual image dehazing by physics-based disentanglement and adversarial training[C]// 32nd AAAI Conference on Artificial Intelligence. New Orleans, 2018: 7485-7492.

[29] LI B Y, GOU Y B, GU S H, et al. You only look yourself: Unsupervised and untrained single image dehazing neural network[J]. International Journal of Computer Vision, 2021, 129: 1754-1767.

[30] ZHAO S Y, ZHANG L, SHEN Y, et al. RefineDNet: A weakly supervised refinement framework for single image dehazing[J]. IEEE Transactions on Image Processing, 2021, 30: 3391-3404.

Single Image Dehazing Algorithm Based on Cycle Generative Adversarial Networks and Transformer

WANG Bo1, WEI Wei-bo1, ZHANG Wei-dong1, PAN Zhen-kuan1, LI Ming2, LI Jin-han1

(1. College of Computer Science and Technology, Qingdao University, Qingdao 266071, China;

2. College of Computer Science and Technology, Ocean University of China, Qingdao 266100, China)

Abstract:

Aiming at the problem of overfitting in traditional dehazing algorithms trained on paired datasets, a non-paired image dehazing network model based on density and depth decomposition was improved with a self-enhancing scaling network. Introducing the Transformer mechanism and deeply integrating it with deep convolutional neural networks for network module deep fusion, a CT-Nets image dehazing algorithm based on cycle generative adversarial networks and Transformers trained on unpaired datasets was proposed. The depth information and scattering coefficient eigenvalues of the input image were extracted, and the atmospheric scattering model was used to restore the real fog concentration information in different scenes as much as possible to improve the subjective visual quality of the defogged image. Based on Swin-Transformer, a self-enhancing refinement layer to obtain finer-grained information was designed to improve the generalization ability of the model and the authenticity of the final predicted image. The experimental results show that compared to the dehazing via decomposing transmission map into density and depth network model, the peak signal-to-noise ratio and structural similarity of the CT-Nets image dehazing algorithm are improved by 4% and 4.1%, respectively.

Keywords:

deep learning; single image dehazing; self-supervised network; cycle generative adversarial