基于特征级与决策级融合的农作物叶片病害识别

王梓衡 沈继锋 左欣 武小红 孙俊

DOI: 10.3969/j.issn.1671-7775.2024.03.006

開放科学(资源服务)标识码(OSID):

摘要: 针对单网络模型存在对数据产生学习偏好的缺陷,提出了一种基于多模型融合的农作物病害识别方法.该方法首先对4种主流卷积神经网络ResNet50、DenseNet121、Xception和MobileNetV2进行单模型性能评估,然后对这4种单模型分别进行特征级和决策级多模型融合,最终输出识别结果.特征级融合方法分别对每个子网络的最后输出特征层进行平均化、最大值化和拼接压缩融合,实现异质特征的高效互补;而决策级融合方法分别对每个子网络的输出概率进行最大化和平均化融合,实现概率分布决策的高效联合.在农作物病害数据集PDR2018上的试验结果表明:特征级融合明显优于决策级融合和单模型方法,且拼接压缩特征融合方法具有最高的识别准确率,达到了98.44%.此外该模型在PlantDoc数据子集和实际拍摄图像的跨库试验结果同样表明:特征融合方法比单模型方法具有更好的精度和泛化性能.

关键词: 农作物病害; 特征级融合; 决策级融合; 卷积神经网络; 泛化性能

中图分类号: S126 文献标志码: A 文章编号: 1671-7775(2024)03-0286-09

引文格式: 王梓衡,沈继锋,左 欣,等. 基于特征级与决策级融合的农作物叶片病害识别[J].江苏大学学报(自然科学版),2024,45(3):286-294.

收稿日期: 2022-08-31

基金项目: 国家自然科学基金资助项目(61903164); 江苏省自然科学基金资助项目(BK20191427); 江苏大学农业装备学部项目(NZXB20210210); 江苏高校优势学科建设工程(三期)项目(PAPD-2018-87)

作者简介: 王梓衡(1997—),男,江苏淮安人,硕士研究生(1205755897@qq.com),主要从事计算机视觉的研究.

沈继锋(1980—),男,江苏宜兴人,副教授(通信作者,shenjifeng@ujs.edu.cn),主要从事农业智能信息处理与计算机视觉的研究.

Crop leaf disease recognition based on feature-level and

decision-level fusion

WANG Ziheng1, SHEN Jifeng1, ZUO Xin2, WU Xiaohong1, SUN Jun1

(1. School of Electrical and Information Engineering, Jiangsu University, Zhenjiang, Jiangsu 212013, China; 2. School of Computer, Jiangsu University of Science and Technology, Zhenjiang, Jiangsu 212003, China)

Abstract: To solve the shortcomings of single-network model with learning preference for data, the crop disease identification method was proposed based on multi-model fusion. The single model performance of four mainstream convolutional neural networks of ResNet50, DenseNet121, Xception and MobileNetV2 was evaluated by the proposed method, and the four single models were respectively conducted by multi-model feature-level and decision-level fusion to obtain the identification output. The feature-level fusion method was used to average, maximize and splice the final output feature layer of each sub-network to achieve efficient complementarity of heterogeneous features. The decision-level fusion method was used to maximize and average the output probability of each sub-network to achieve efficient union of probability distribution decisions. The experimental results on the PDR2018 crop disease datasets show that feature-level fusion outperforms decision-level fusion and single-model methods significantly. Among the fusion methods, splicing compression feature fusion achieves the highest recognition accuracy of 98.44%. The cross-database experiments on PlantDoc data subset and the actual images confirm that the feature fusion method exhibits superior accuracy and generalization performance compared to the single-model method.

Key words: crop disease; feature-level fusion; decision-level fusion; convolutional neural network; generalization performance

农作物病害是我国主要农业灾害之一,不仅影响农作物品质,还会给农业生产造成重大损失[1].传统农作物病害识别主要是采用人工分类方法[2],需要专业人员具备丰富的专业知识.然而随着样本数量和病害种类的增加,人工分类方法存在主观性效率低下、时效性无法保障等问题[3],会导致错失最佳治理时机而造成巨大的损失.因此精准病害识别是农作物病害治理的关键,也是目前精准农业和智慧农业[4]面临的一项重大挑战.

基于传统机器学习[5]的病虫害识别方法通常包含以下4个步骤:图像捕捉、图像预处理、图像分割和特征提取.文献[6]对葡萄叶片病害进行研究,用k均值聚类算法(k-means clustering algorithm)聚类出病害区域,同时提取叶片纹理和颜色特征,并使用支持向量机(support vector machine,SVM)进行病害分类,获得了88.89%的准确率.文献[7]对水稻叶片病害研究,使用了k邻近算法(k-nearest neighbor,KNN)进行分类,最终获得76.59%的准确率.文献[8]针对番茄叶片病害进行研究,通过提取健康和不健康番茄植物图像的颜色、形状和纹理特征用决策树算法进行分类,获得了97.3%的分类准确率.文献[9]提出了分段垂直投影的水稻秧苗中心线提取方法,使用最小二乘法进行特征点拟合,准确率达到了94.50%.虽然这些方法都能取得不错的结果,但是传统机器学习方法需要对图像进行人工预处理及特征提取,对不同的任务不具有通用性.并且特征选择直接影响图像分类的准确率,因此如何选择最佳的处理方法是分类人员面临的一项重要挑战.

随着深度学习技术[10]的发展,卷积神经网络(convlution natural network,CNN)在计算机视觉领域获得了广泛的应用.该方法首先堆叠多个卷积层来构建深层神经网络模型,再利用池化层对数据进行下采样以减少数据量,从而降低计算成本;然后通过大量训练样本自动学习数据特征;最终使用全连接层实现分类任务.文献[11]提出的AlexNet网络促进了深度学习在农作物智能化研究的发展.文獻[12]以玉米叶片病害为研究对象,将扩张卷积和多尺度卷积应用到AlexNet上,提高了模型的特征提取能力,最后引入批处理量纲一化防止模型过拟合,试验表明,改进后的AlexNet在玉米数据集上取得了98.62%的准确率.文献[13]将批量纲一化、全局池化加入到传统的AlexNet模型中,得到一种收敛迅速的模型,该模型在公共数据集Plant Village上获得了99.56%的平均测试准确率.文献[14]提出的视觉几何群网络(visual geometry group network,VGG)系列模型增加了层数和通道数,并且用小卷积核代替大卷积核,其模型结构简单、效果强大.文献[15]针对棉花病害在原VGG16模型基础上,优化全连接层层数,共享卷积层和池化层参数,在棉花病害领域具有良好分类性能,达到了89.51%的分类准确率.文献[16]对VGG16网络采取特征微调的方式,实现了对不同类别葡萄和苹果叶片的分类,平均分类准确率达到了97.87%.上述这些文献可以看出,卷积神经网络与传统机器学习方法相比,在简化了数据预处理步骤的同时,还获得了更高的识别准确率.然而随着卷积神经网络层数的加深,容易产生梯度消失、梯度爆炸问题,导致网络的分类性能下降.对此文献[17]提出了ResNet模型,在模型中添加残差块,不仅加速了模型的收敛速度,而且大大提升了模型的分类性能.文献[18]针对4类苹果病害问题,对ResNet18模型使用迁移学习,并结合使用正则化和Dropout层,在该数据集上得到了98.5%的分类精度.除了对卷积神经网络的层数加深和优化器方法的改进,近年来又涌现出了一批性能更加优异并且层数更深的分类网络模型: GoogleNet[19]、DenseNet[20]和InceptionV3[21],为农作物病害的识别提供了更多深度特征提取方法.文献[22]针对苹果叶片分类问题,使用VGG16、ResNet101和DenseNet161,并引入半监督噪声学生训练的思想,能够将分类精度提高至98.2%.文献[23]使用InceptionV3、ResNet101、ResNet50、GoogleNet等多种卷积神经网络架构,分别对小麦和马铃薯常见病害进行分类,找到适用于小麦和马铃薯病害的卷积神经网络架构,最终获得95.4%的分类结果.

上述文献成功将卷积神经网络成功应用于农作物病害识别中并取得了不错的结果,但都是只用了单个卷积神经网络,对分类结果具有不确定性[24],且分类准确率需要进一步提高.文献[25]针对苹果5类病害,将VGG16和ResNet50作为并联骨干网络进行融合,为模型的最后设置相同神经元个数的全连接层,再通过2个非线性变换,进一步提升融合效果.文献[26]提取农作物图像的局部二值化模式和灰度共生矩阵特征,分别输入支持向量机分类器并做分数级融合,再进行分类识别,在小麦和水稻的6种病害数据集获得89.3%的分类精度.文献[27]提出了一种卷积神经网络深度特征融合方法,针对番茄10类病害,首先自动提取不同深度神经网络模型的深度特征,利用典型相关分析(canonical correlation analysis,CCA)进行特征融合,增加特征空间的丰富性和鲁棒性,再结合线性判别分析降维算法(linear discriminant analysis,LDA)最大化类间距离,弥补CCA算法的弱点,对最终得到的特征用SVM分类,试验结果表明所提方法有效.上述融合方法虽取得了不错的结果,但没有考虑到不同特征之间存在互补关系.因此文中针对该问题,对多个主流卷积神经网络模型分别进行特征级和决策级融合以实现对农作物病害图像高精度分类,通过和其他方法进行对比,发现文中方法可以取得良好的分类结果.

1 试验数据

1.1 数据来源

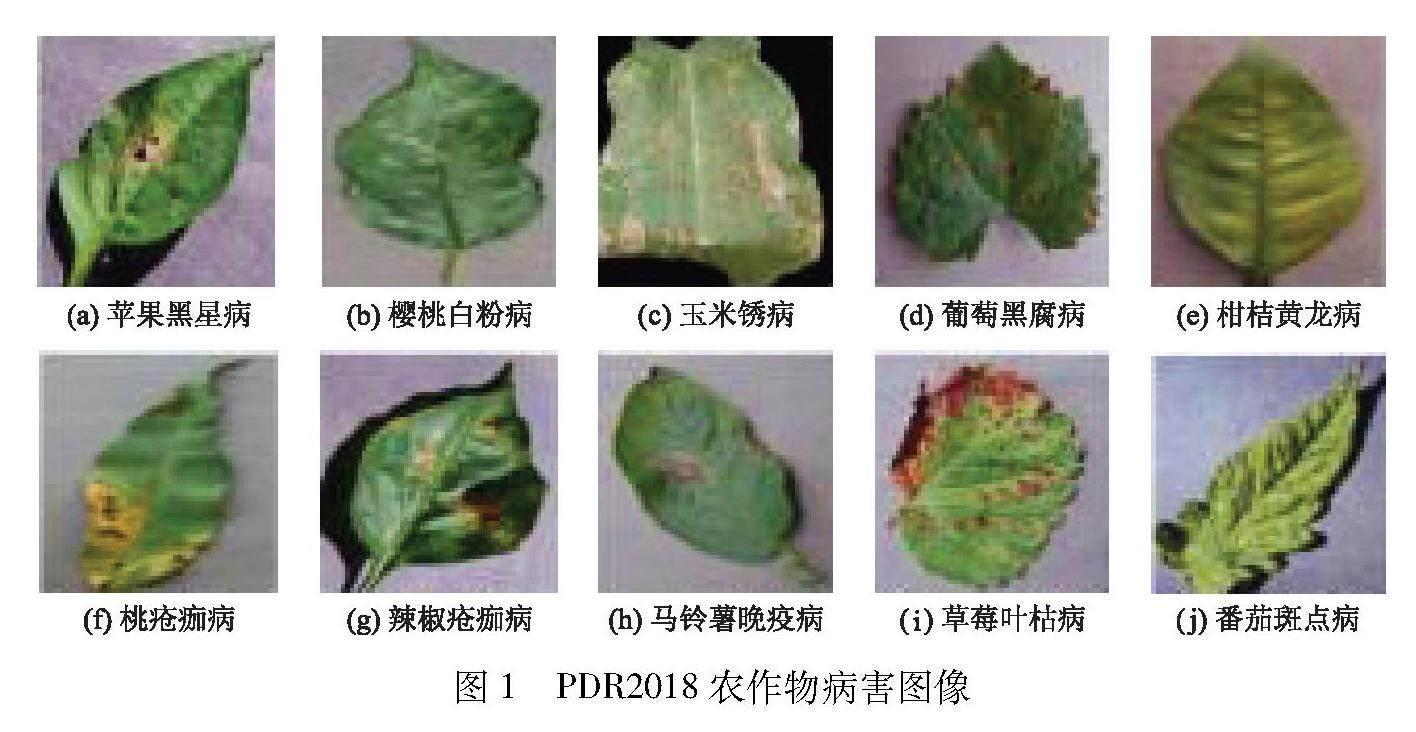

文中方法的第1个数据集来源于AI Challenger 2018比赛中的农作物病害图像(PDR2018),该数据集包含10类常见农作物(苹果、樱桃、葡萄、柑桔、桃、草莓、番茄、辣椒、玉米、马铃薯)健康叶片和多种常见病害类型(黑星病,灰斑病,锈病等)的图像,按“物种-病害-严重程度”共分为61类,部分图像如图1所示.文中主要研究基于多模型融合的农作物病害识别,不考虑病害严重程度,因此将数据集重新整理成36类(10类健康与26类病害图像).

第2个数据集来源于Plant Doc,该数据集包含13个植物物种和27个病害类别(17个疾病和10个健康)的 2 598张真实环境下的图像,部分病害图像如图2a、b、c所示.此外还拍摄了真实环境下的番茄叶片,将部分番茄病害和拍摄叶片进行合成(图2d)以作为对PlantDoc番茄叶片病害的补充,文中选取两个数据集中相同的10类病害类别用于文中泛化性能测试.

1.2 数据预处理

由于PDR2018数据集中存在一些重复样本图片,所以要进行数据清理,文中删除了存在标签交叉的图像以及文件名中含“副本”的图像,最终获得36 020张图像,按4∶1比例随机划分成训练集和测试集,如表1所示.由于PDR2018图像数量分布不均匀,每个类别数量从100张到4 000张不等.如果直接使用原始的数据集进行训练,会导致模型学习的权重偏向于样本多的类别,为了避免该问题的出现,选择对数据集超过1 300张以上的类别数量不做处理.对于1 300张以下的类别采取多角度旋转、错切变换、随机缩放、随机翻转等数据增强方式,扩大样本数量,减少过拟合现象.

2 文中方法

2.1 单模型方法

受大规模图像分类算法应用的启发,文中选择4种主流卷积神经网络(ResNet50、DenseNet121、Xception[28]和MobileNetV2[29])进行单模型性能评估.ResNet50引入了“跳跃连接”的新思路可以让梯度高效向后传播,在众多视觉任务上都能有效提升性能.与ResNet50思想类似,DenseNet121则是引入了一种密集跳跃连接模块,能够实现跨多个密集块的瓶颈连接,也有助于高效的梯度传播.Xception网络具有残差连接的深度可分离卷积层,并且可以进行线性堆叠,可以容易定义和修改体系结构.MobileNetV2网络采用倒置残差结构,和ResNet相反,其作用是将输入的低维特征扩展到高维空间,再使用深度可分离卷积提取特征,最后映射到低维空间,进行模型压缩.与ResNet101、GoogleNet、DenseNet169等深层网络模型相比,文中使用的网络模型具有参数量少与性能均衡等优点.

2.2 多模型融合方法

2.2.1 特征级融合

特征级融合是将CNN从图像中提取的特征进行融合,融合后的特征相较于初始特征更具有判别能力.文中特征级融合做法是对每个CNN中的最后一层特征图进行融合,原因是CNN最后一层特征图相比于之前层数的特征图反映出来的特征更具有代表性,语义信息强,特征级融合流程如图3所示.

首先输入农作物病害图像,将单模型里的4个卷积神经网络进行并联,分别得到4个特征F1、F2、F3和F4,即

Fi=Ψi(x),i=1,2,3,4,(1)

式中: Ψi是特征提取函数.接着对4个特征图做特征级融合(平均化、最大值化和拼接压缩)分别得到融合后的特征Fave、Fmax和Fconcat,接着在Fave、Fmax和Fconcat后添加全局平均池化层(global average pooling,GAP),变成1×1×C的向量,C代表特征图的输出通道数.用GAP代替传统的全连接层,可以减少参数量和计算量.再通过1个全连接层的非线性变换,进一步提升融合结果,最终通过Softmax层完成分类.

1) 平均融合.平均特征融合方面,每个CNN的最后一层特征图维度不一样,所以在进行平均特征融合前,为各个模型设置一个具有相同神经元个数的全连接层,将不同模型输出特征图的维度调整一致.目的是对每个特征图进行相加时避免出现维度不一致导致不能融合的问题.平均融合的方式首先对4个特征图进行相加,在每一个特征图上都有对应像素點值,所以相加可以理解为对特征图每点对应位置像素值求和,这样得到新的特征图上的像素值是求和后的结果.为了降低计算量和保证融合信息的完整性,再对求和后的特征图进行平均化处理,得到最后的特征图:

Fave=14(F1+F2+F3+F4).(2)

式(2)表示在进行平均融合时,每个特征图对应位置像素值按位置进行逐个元素相加求算术平均值,以该算术平均值作为融合特征图里对应位置的像素值.

2) 最大值融合.由于4个特征图维度不一致,为了在公平的环境下进行比较,和平均融合方式一样,在最大值特征融合之前,将每个特征图维度调整相同.每张特征图上各点像素值大小不一样,最大值特征融合是将特征图对应位置上的值进行大小比较,取出最大的像素值出来,按照对应位置顺序重新排列并组合成新的特征图:

Fmax=max(F1,F2,F3,F4).(3)

式(3)表示在进行最大融合处理时,比较每个特征图对应位置的像素值大小,以其中最大的像素值作为融合特征图在对应位置处的像素值.

3) 拼接压缩融合.对拼接压缩融合来说,将4个特征图按照通道进行拼接,不需要额外地进行维度调整操作.拼接后的特征图会加强本身的特征,有益于分类.接着再压缩通道进行降维得到融合的特征图:

Fconcat=σ1×1concat(F1,F2,F3,F4).(4)

σ1×1用来调整拼接后的特征图通道数,实现降维作用,降维后的通道数和平均值、最大值特征融合保持通道数一致,目的既是为了降低计算量,也是为了和前两种特征融合方法在相同的维度下比较结果.拼接压缩示意图如图4所示.

2.2.2 决策级融合

对于决策级融合将采用最大概率决策融合和平均概率决策融合,两种决策融合方法执行效率高.文中的决策融合流程如图5所示.输入一张病害图像,通过4个CNN的Softmax输出概率值Pi(i=1,2,3,4)对其分别进行最大和平均概率决策融合.最大概率决策融合是通过不同CNN对每一类病害的Softmax输出概率值计算出最大值,并以該值作为输入图像为其所属病害类型的概率.而平均决策融合兼顾到每个CNN的分类性能,通过不同CNN对每一类病害的概率进行相加求平均值,得到输入图像最终所属病害类型概率.

采用决策融合时输入一个叶片病害图像可以得到输出概率:

P(x)=(P1(x),P2(x),P3(x),P4(x)),(5)

Pi∈Rc,P∈Rc×4,

Pmax(x)=max(P1(x),P2(x),P3(x),P4(x)) ,(6)

Pave(x)=14sum(P1(x),P2(x),P3(x),P4(x)),(7)

式中: P(x)表示每个CNN对输入图像判定为某一类的概率输出值;c为农作物病害类型数目;Pmax表示对每一行求最大值,即为最大决策融合判定输入图像所属病害类别的概率值;Pave表示对Pi(x)求均值后的结果,以此表示预测类别平均后的概率值,以Pave的值作为每一类病害的准确率.

3 试验结果与分析

3.1 试验环境

文中试验均在Ubuntu 18.04 LTS 64位系统环境下运行,采用能够支持GPU加速和动态神经网络的Python3.6、Tensorflow1.13版本的深度学习开源框架,配合CUDA 10.1进行训练.计算机搭载的处理器为Inter(R)Core(TM)i9-7980XE@2.6 GHz,内存12 GB,显卡NVIDIA1080Ti.

3.2 评价指标

对于分类模型,分类网络的性能常常用准确率进行评估,但是当正负样本比例不均衡时,占比大的类别会对准确率产生更大的影响.所以结合精确率Pi、召回率Ri和综合评价指标F1-score共同作为模型的评价指标用来综合评估模型.

3.3 模型性能分析

常见农作物病害图像尺寸不一致,所以在训练之前提前缩放为256×256像素,训练的时候随机裁剪成224×224像素,批处理大小(Batch-size)设置为12,模型迭代次数共计60次.为了模型的识别准确率能够更好地收敛,本试验采用学习率衰减策略,初始学习率设置为0.001,每经过20次,学习率便衰减为原来的80%,所有的训练模型采用SGD优化器,其参数设置为默认.同时为避免模型发生过拟合,在全连接层前添加了参数设置为0.3的Dropout层.

为验证本方法的有效性,将本方法与单模型方法进行对比试验.表2给出了不同方法在数据集上的分类准确率、每幅图像的推理速度、参数总量、召回率、准确率和F1-score.由表2可知,对模型进行融合后,模型的各方面评价指标都有提升,表明文中特征融合方法具有较好的识别准确率.虽然多模型方法对于每幅图像的推理速度比单模型方法的推理速度稍久,但是推理速度集中在0.01~0.10 ms,属于可接受范围内,实际应用中不会产生很大的影响.

决策融合仅用于测试集,虽然提升了分类效果,但是效果不如特征融合,原因是每个CNN模型对每一类的准确率相差不大,进行最大概率决策融合时最终的输出结果也只是略高于所有的单模型方法.而进行平均概率决策融合时,并未考虑到分配一定的权重,仅仅只是对每个CNN模型输出概率做了算术平均运算,使得最终结果略微低于单模型方法里的DenseNet121和Xception.

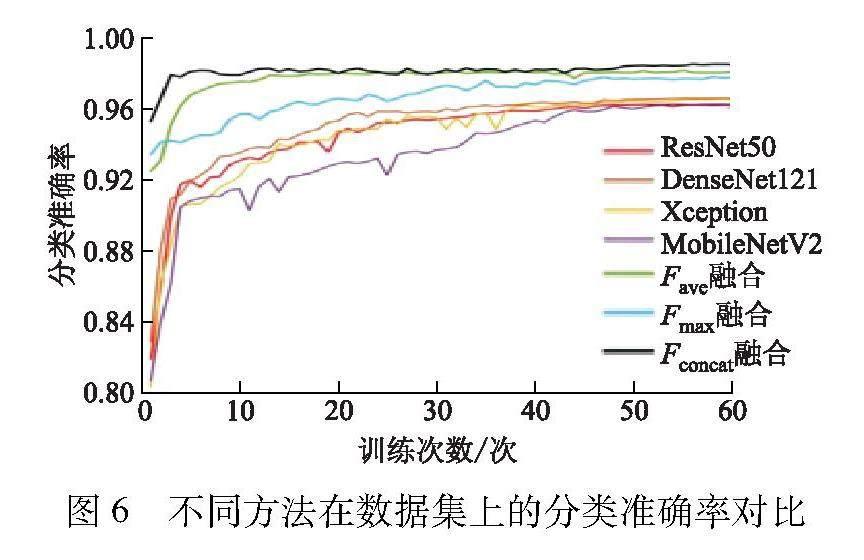

为便于观察分析,最终生成的各个模型在农作物病害数据集上的分类准确率变化曲线如图6所示.

由图6可以直观看出各个分类模型的准确率整体呈现上升趋势,模型在训练过程中不断提取病害特征进行学习,提升分类能力.文中构建的特征级融合方法准确率更高,原因是多模型里存在ResNet50和DenseNet121的跳过连接方式,使得模型在训练时,增加了梯度传递,能够重复利用上一层的特征,Xception和MobileNetV2的深度可分离卷积结构,拥有不同尺寸的卷积核可以对图像进行特征提取,都能够丰富叶片病害特征信息,提高了分类结果.其中拼接压缩融合方法准确率更高,分类效果更好.拼接压缩融合在扩张维度的情况下,增加了特征图描述的语义信息进而增加了有用的特征信息,从而使得模型获取更丰富的病害信息进行分类.

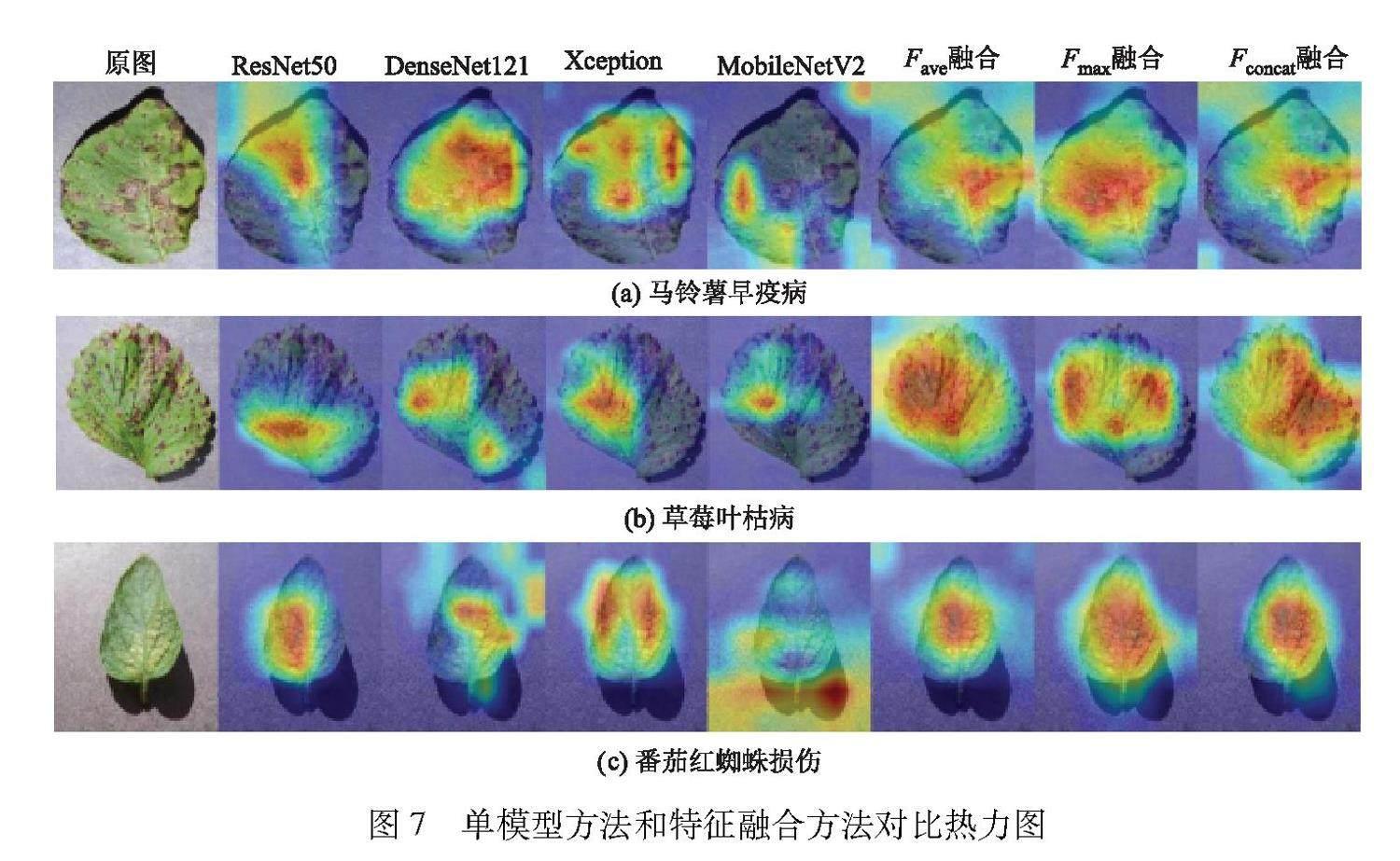

3.4 热力图可视化

类激活映射[30]能够对模型分类结果提供很好的可视化依据,可以进一步直观地理解分类模型.文中提取了部分测试图像在单模型方法和特征融合方法对比试验中的热力图,如图7所示.由图可以看出特征级融合方法相比于单模型方法更能准确定位选中叶片病害区域,更能正确地进行分类.

3.5 与其他分类方法对比

为进一步验证本方法的有效性,将文中方法与近几年代表性的分类方法进行了对比,结果如表3所示.由表可以发现文中方法在PDR2018数据集上可以取得最高的分类准确率.

3.6 模型泛化性

模型的泛化性能可以反映模型适应新数据的能力,为了进一步验证多模型融合方法的泛化性能,选择PlantDoc数据子集以及采集到的病害样本,开展跨库评估试验,评测了两个数据集中相同的10类病害类别,同时选取单模型和多模型中性能最优的DenseNet121和拼接压缩特征级融合方法作为测试模型,最后测试结果如表4所示.

从表4可以看出,两种方法在真实数据子集上泛化性能表现较差,是因为实验室环境和真实环境背景下的图像存在较大差异,真实图像容易受到光照、背景更加复杂等外界因素干扰,所以DenseNet121和拼接压缩融合方法在真实环境下的性能会下降,但是拼接压缩融合相较于DenseNet121在真实环境下仍然对农作物病害分类具有更好的分类效果,说明多模型特征融合方法具有较好的泛化能力.

4 结 论

1) 提出了一种基于多模型的特征级融合和决策级融合方法.基于4种主流卷积神经网络作为基础模型,特征级融合方法研究了将每个子网络的输出特征图分别做平均化、最大值化和拼接壓缩特征级融合,而决策级融合使用4种不同子网络获得的输出概率值,分别进行最大概率决策和平均概率决策融合,产生最终分类结果.

2) 在PDR2018农作物病害数据集上的试验结果表明,文中提出的多模型融合方法明显优于单模型分类方法及近几年代表性的方法,并且模型收敛得更快,最高准确率可达98.44%.

3) 为进一步验证本方法的泛化性能,利用PDR2018数据集上训练的模型在PlantDoc数据子集以及采集到的真实环境农作物病害图像进行了跨数据集测试.结果表明,本方法相比于传统的单模型方法具有良好的分类精度和泛化能力.

[WT5HZ]参考文献(References)[WT5”BZ]

[1] 朱家辉,苏维均,于重重.基于卷积神经网络的农作物叶片病害诊断[J].植物检疫,2021,35(2):28-32.

ZHU J H,SU W J,YU C C.Diagnosis of crop foliar di-seases based on convolutional neural network[J].Plant Quarantine, 2021,35(2):28-32.(in Chinese)

[2] 贾少鹏,高红菊,杭潇. 基于深度学习的农作物病虫害图像别技术研究进展[J].农业机械学报,2019,50(增刊1):313-317.

JIA S P, GAO H J, HANG X. Researchprogress on ima-ge recognition technology of crop pests and diseases based on deep learning[J]. Transactions of the CSAM, 2019,50(Sup1):313-317.(in Chinese)

[3] 王东方,汪军. 基于迁移学习和残差网络的农作物病害分类[J].农业工程学报,2021,37(4):199-207.

WANG D F,WANG J.Crop disease classification with transfer learning and residual networks[J].Transactions of the CSAE, 2021,37(4):199-207.(in Chinese)

[4] 张连宽,肖德琴,岑冠军,等. 基于叶片匹配的作物植株图像分离与计数方法[J].江苏大学学报(自然科学版), 2023,44(3):293-301.

ZHANG L K,XIAO D Q,CEN G J,et al.Individual plant extraction and counting from field images based on leaf matching[J].Journal of Jiangsu University(Natural Science Edition),2023,44(3):293-301.(in Chinese)

[5] 张善文,张传雷. 基于局部判别映射算法的玉米病害识别方法[J].农业工程学报,2014,30(11):167-172.

ZHANG S W,ZHANG C L. Maize disease recognition based on local discriminant algorithm[J]. Transactions of the CSAE, 2014,30(11):167-172.(in Chinese)

[6] PADOL P B, YADAV A A. SVM classifier based grape leaf disease detection[C]∥2016 Conference on Advances in Signal Processing, 2016:175-179.

[7] SURESHA M, SHREEKANTH K N, THIRUMALESH B V. Recognition of diseases in paddy leaves using KNN classifier[C]∥2017 2nd International Conference for Convergence in Technology, 2017:663-666.

[8] SABROL H, SATISH K. Tomato plant disease classification in digital images using classification tree[C]∥2016 International Conference on Communication and Signal Processing, 2016:1242-1246.

[9] 陈俞松,耿长兴,王永,等. 基于分段垂直投影的水田秧苗列中心线提取[J].江苏大学学报(自然科学版), 2022,43(3):289-295.

CHEN Y S,GENG C X,WANG Y,et al. Center line extraction of paddy seedling row based on segmented vertical projection[J].Journal of Jiangsu University(Natural Science Edition),2022,43(3):289-295.(in Chinese)

[10] 蘇仕芳,乔焰,饶元. 基于迁移学习的葡萄叶片病害识别及移动端应用[J].农业工程学报,2021,37(10):127-134.

SU S F, QIAO Y, RAO Y.Recognition of grape leaf di-seases and mobile application based on transfer learning[J]. Transactions of the CSAE, 201,37(10):127-134.(in Chinese)

[11] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. Imagenet classification with deep convolutional neural networks[J]. Advances in Neural Information Processing Systems, 2012,60:25-33.

[12] LYU M, ZHOU G, HE M, et al. Maize leaf disease identification based on feature enhancement and DMS-robust alexnet[J]. IEEE Access, 2020,8:57952-57966.

[13] 孙俊,谭文军,毛罕平,等. 基于改进卷积神经网络的多种植物叶片病害识别[J].农业工程学报,2017,33(19):209-215.

SUN J, TAN W J, MAO H P, et al. Real-time recognition of sugar beet and weeds in complex backgrounds using multi-channel depth-wise separable convolution model[J]. Transactions of the CSAE, 2017,33(19):209-215.(in Chinese)

[14] SIMONYAN K, ZISSERMAN A.Very deep convolutional networks for large-scale image recognition[J]. Computer Science,2014,6:113-123.

[15] 张建华,孔繁涛,吴建寨,等. 基于改进VGG卷积神经网络的棉花病害识别模型[J].中国农业大学学报,2018,23(11):161-171.

ZHANG J H,KONG F T,WU J Z,et al.Cotton disease identification model based on improved VGG convolution neural network[J]. Journal of China Agricultural University, 2018,23(11):161-171.(in Chinese)

[16] NAGARAJU Y, SWETHA S, STALIN S. Apple and grape leaf diseases classification using transfer learning via fine-tuned classifier[C]∥2020 IEEE International Conference on Machine Learning and Applied Network Technologies, 2020:1-6.

[17] HE K, ZHANG X, REN S, et al. Deep residual lear-ning for image recognition[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016:770-778.

[18] LI X, RAI L. Apple leaf disease identification and classification using resnet models[C]∥2020 IEEE 3rd International Conference on Electronic Information and Communication Technology, 2020:738-742.

[19] SZEGEDY C, LIU W, JIA Y, et al. Going deeper with convolutions[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2015:1-9.

[20] HUANG G, LIU Z, VAN DER MAATEN L, et al. Densely connected convolutional networks[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2017:4700-4708.

[21] SZEGEDY C, VANHOUCKE V, IOFFE S, et al. Rethinking the inception architecture for computer vision[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016:2818-2826.

[22] KEH S S. Semi-supervised noisy student pre-training on efficientnet architectures for plant pathology classification[J]. arXiv, DOI:10.48550/arXiv.2012.00332.

[23] KENDLER S, AHARONI R, YOUNG S, et al. Detection of crop diseases using enhanced variability imagery data and convolutional neural networks[J]. Computers and Electronics in Agriculture, 2022,193:1-8.

[24] 任永梅,杨杰,郭志强,等. 基于多尺度卷积神经网络的自适应熵加权决策融合船舶图像分类方法[J].电子与信息学报,2021,43(5):1424-1431.

REN Y M,YANG J,GUO Z Q,et al.Self-adaptive entropy weighted decision fusion method for ship image classification based on multi-scale convolutional neural network[J].Journal of Electronics and Information Techno-logy, 2021,43(5):1424-1431.(in Chinese)

[25] 李昊,王斌. 深度特征融合方法及其在葉片病害识别中的应用[J].计算机系统应用,2022,31(7):349-355.

LI H,WANG B.Deep feature fusion method and its application in leaf disease recognition[J].Computer Systems & Applications,2022,31(7):349-355.(in Chinese)

[26] 马玉琨,刘子琼,张文武,等. 多特征融合的农作物病害图像识别[J].河南科技学院学报(自然科学版), 2021,49(4):45-50,57.

MA Y K,LIU Z Q,ZHANG W W,et al.Image recognition of crop disease based on multi-feature fusion[J].Journal of Henan Institute of Science and Technology(Natural Science Edition),2021,49(4):45-50,57.(in Chinese)

[27] 杜忠康,房胜,李哲,等. 基于卷积神经网络深度特征融合的番茄叶片病害检测[J].中国科技论文,2021,16(7):701-707.

DU Z K,FANG S,LI Z,et al.Tomato leaf disease detection based on deep feature fusion of convolution neural network[J]. China Science Paper,2021,16(7):701-707.(in Chinese)

[28] CHOLLET F. Xception:deep learning with depthwise separable convolutions[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017:1251-1258.

[29] SANDLER M, HOWARD A, ZHU M, et al. MobileNetV2: inverted residuals and linear bottlenecks[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018:4510-4520.

[30] ZHOU B, KHOSLA A, LAPEDRIZA A, et al. Learning deep features for discriminative localization[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016:2921-2929.

[31] 王美华,吴振鑫,周祖光. 基于注意力改进CBAM的农作物病虫害细粒度识别研究[J].农业机械学报,2021,52(4):239-247.

WANG M H,WU Z X,ZHOU Z G.Fine-grained identification research of crop pests and diseases based on improved CBAM via attention[J].Transactions of the CSAM,2021,52(4):239-247.(in Chinese)

[32] 孙俊,朱伟栋,罗元秋,等. 基于改进MobileNet-V2的田间农作物叶片病害识别[J].农业工程学报,2021,37(22):161-169.

SUN J, ZHU W D, LUO Y Q, et al. Recognizing the diseases of crop leaves in fields using improved MobileNet-V2[J]. Transactions of the CSAE,2021,37(22):161-169.(in Chinese)

[33] BEHERA A, WHARTON Z, HEWAGE P R P G, et al. Context-aware attentional pooling (cap) for fine-grained visual classification[C]∥Proceedings of the AAAI Conference on Artificial Intelligence,2021,35(2):929-937.

[JY,2][HT5SS](责任编辑 祝贞学)