人工智能伦理视角下机器非殖民化的批判性设计研究①

王 帆(南京艺术学院 设计学院,江苏 南京 210013)

被计算成像和传感机器所包围的技术现实正塑造着我们的日常生活,从量化自我的智能手机到让人类自由裁量权黯然失色的人工智能,技术思想家亚当·格林菲尔德(Adam Greenfield)对信息时代的激进技术进行了紧迫而富有启示性的挖掘。[1]同时,机器感知与感官环境之间产生出新的纠缠与反馈,人工智能驱动的远超人类感知经验阈值的机器正在接管我们的感官意识。

一、机器中的非殖民化愿景

艺术家黑特·史德耶尔(Hito Steyerl)和特雷弗·帕格伦(Trevor Paglen)在蓬皮杜艺术中心展开过一次围绕“图像的自主性”对谈,意在探讨机器自动生成图像的政治性。她提出一个疑问,当图像制作与图像解读越来越多地在没有人眼的情况下自主发生时,机器如何观看?

1.机器的观看之道与非殖民化

在《机器可读的黑特》(图1)这个作品中,帕格伦拍摄了数百张黑特的照片,并对图像集进行了各种面部识别算法的处理,这些分类法的创建很快就开始变得非常政治化,一种内置于算法中的意识形态,正在通过有偏见的技术系统进行编码。[2]而艺术家詹姆斯·布里多(James Bridle)以“新的观看方法”正在为我们的数字时代构建约翰·伯格(John Berger)的主题——观看的“诡谲”。他认为,新技术从根本上改变了我们与图像的关系,但新的观看方法并不总是跟得上,尤其是因为技术本身越来越难以看懂,它消失在屏幕之后,变成难以捉摸的代码,所以态度与偏见变得更难质疑。[3]

图1 特雷弗·帕格伦,《机器可读的黑特》,2017

越来越多的学术研究正在追溯数字工具出现之前的压迫性结构是如何在技术系统中被迅速复制的。媒介研究学者尼克·坎德里(Nick Couldry)和乌利塞斯·梅希亚斯(Ulises Mejias)将数据收集的生态系统称为数据殖民主义(Data Colonialism),它结合了历史掠夺性榨取做法与计算机的抽象量化方法。换句话说,数据殖民主义是一种通过数据关系占用和提取社会资源以获取利润的新兴秩序。[4]认知科学家阿贝巴·比尔汉(Abeba Birhane)和奥利维亚·格斯特(Olivia Guest)则追溯了计算科学的历史,她们认为当务之急是承认当前计算科学生态系统的本质,并将我们从条件内化的盎格鲁中心主义、欧洲中心主义中解放出来。[5]研究学者凯特·克劳福德(Kate Crawford)将人工智能视为一种采掘业的地球基础设施,一个庞大的能力矩阵被调用——资源开采、人力劳动和算法处理的交错链条贯穿采矿、物流、分销、预测和优化的全球计算网络。这种扩展观点从采掘政治、气候变迁、劳工权利等方面揭示了人工智能在真实世界中的运作逻辑,破除了人工智能技术中立的神话。[6]

人工智能的影响正在通过类似算法压迫、算法剥削等技术问题引发全球社会风险。例如,在雅加达,印尼最大叫车公司“Gojek”的司机们正在通过社区建立抵制力量来脱离调度算法的控制和分裂;在新西兰偏远的农村小镇,一对原住民夫妇正在夺回对其社区数据的控制权,以振兴毛利语;委内瑞拉的人工智能数据标签公司在毁灭性的经济危机中寻找廉价的数字劳工,创造了一种新的劳动剥削模式;[7]加纳巨大的电子垃圾掩埋场阿格博格布洛谢,一味追求技术演进的电子废弃物在那里堆积,并发展出了一种新的工业形态——都市采矿。如今,学界正在倡导“非殖民化的人工智能”,通过将非殖民主义的批判方法嵌入技术实践,来关照全人类的利益与福祉。

2.算法决策与编码偏见

由机器学习驱动的算法决策越来越多地渗透到社会领域,从分配医疗服务到预测犯罪概率,再到筛选合适的求职者。复杂的、不断变化的社会挑战被自动化并包装成数学和工程问题,这往往被认为是客观的或中立的。阿贝巴·比尔汉认为,应用于机器学习和数据科学等领域的贝叶斯方法,在建立与统计推断相关的文化特权和确立数学预测的中立性方面发挥了关键作用。但贝叶斯模型(Bayesian Model)却很容易产生虚假关系,并放大社会上的偏见。[8]3同时,她还指出,机器学习系统的核心工作可以概括为聚类异同、抽象共性和检测模式,它基于看似共享的特征,给出巨大、杂乱和复杂的相似性,从而识别海量数据中的模式并做出预测。机器学习揭示的是统计上的相关性,但它并不了解因果机制。[8]7数据科学家凯瑟琳·海伦·奥尼尔(Catherine Helen O'Neil)也认为,忽略因果关系的模型可能会增加历史问题,而不是解决这些问题。它们只是社会事件的量化以及苍白的回声,并不能检测和预测语义的复杂或异常。[9]

算法不公正领域的大量研究表明,标准化的机构、社会价值观以及分类法往往会为训练数据集提供信息,这会造成一种情况,即作为人工智能系统的基础数据并不能准确反映所研究的人群或现象。这些偏见会转化为新的统计和计算规范,而这些规范一旦被使用,就会放大现有的结构性不平等。这种情况在族群、性别等方面尤为明显。[10]

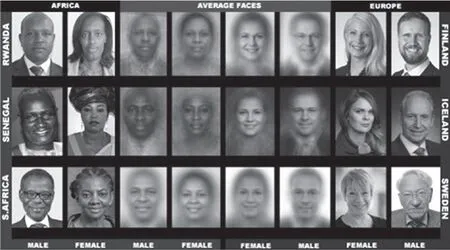

面部识别工具利用族群数据编码了凝视。人工智能伦理研究学者蒂姆尼特·格布鲁(Timnit Gebru)与乔伊·布拉姆维尼(Joy Buolamwini)为此设计了一种方法来评估自动面部分析算法和数据集中存在的与皮肤亚群有关的偏差(图2)。结果表明,深肤色女性最容易被错误分类,错误率为34.7%;浅肤色男性最容易被精准识别,错误率为0.8%。她们认为,如果商业公司要建立真正公平、透明和负责任的面部分析算法,那么性别分类系统中深色与浅色皮肤女性、深色与浅色皮肤男性分类准确率的巨大差异就急需关注。[11]此外, “COMPAS”是一种替代性制裁犯罪矫正管理剖析软件,皆在为美国法院评估罪犯再犯的潜在可能性。在多次的风险评估预测分析中,黑人被系统标记再次犯罪的概率是白人的两倍,之所以有这样的推论,是因为产生风险系数的算法建立在对有色人种多年来的不良数据和系统性偏见上。[12]这意味着,上述两种由机器学习驱动的算法决策都是基于对过去事件数据的分析,因此它们对未来的预测是由历史偏见决定的。

图2 蒂姆尼特·格布鲁与乔伊·布拉姆维尼,面部分析数据集PPB的示例图像和平均面孔,2017

从人类生成的语料库中学习到的词嵌入(Word Embeddings)继承了强烈的性别偏见,并且会通过下游模型进一步放大。[13]词嵌入是一种将文本数据表示为向量的流行框架,已被用于许多机器学习和自然语言处理任务中。例如,“圣杯”是亚马逊开发的自动简历筛选算法来匹配合适的求职者,但他们逐渐发觉程序正在系统地降低女性候选人的级别,标记为女子足球队或女子大学这样的词条,都会导致简历被降级。由于亚马逊在历史上雇用男性的比率很高,他们的算法系统便学会了认为男性比女性更适合这些工作。[14]普林斯顿大学计算机科学教授阿尔温德·纳拉亚南(Arvind Narayanan)对人工智能驱动就业决策做出了回应,他认为人类决策者可能有偏见,但至少有一个“偏见”的多样性。想象一下在未来,每个雇主都使用自动简历筛选算法,而这些算法都具有相同的启发式逻辑,而没有通过这些检查的求职者在任何地方都会被拒绝。[15]315

二、为非殖民化机器辩护的批判性设计

随着社会进程日益自动化,传统上在公开场合争论的社会问题,现在都变成了有技术解决方案的数学问题。数据记者梅雷迪斯·布萨德(Meredith Boussard)指出“技术沙文主义(Technochauvinism)”的困境,即毫无疑问地认为技术总是首选解决方案。[16]对技术纯粹功能性的认知还会导致一种风险——计算思维。计算思维内化了解决主义的核心要义。在这种思维主导下,我们思考世界、描述世界的方式只能通过计算得出。[17]所以仅用“去偏见”数据集来解决技术不公平是不够的,还需批判性审视与反思不对称的权力动态,这将有助于对机器和人工智能提出迫切性、根本性、替代性的看法。

1.非殖民化的边界思维与批判性设计

沃尔特·米尼奥洛教授(Walter Mignolo)认为,殖民权力矩阵(Colonial Matrix of Power)是现代性“西方代码”取得成功的基础。它们通过宣称欧洲中心主义的认识论、本体论和美学是普遍的,并在几个世纪的时间里持续传播,而且这种力量从未消失。[18]16他在《非殖民化调查的政治学》一书中讨论了非殖民化如何跨越思想的边界,提出:“最终的、最紧迫的非殖民化任务是与西方文明的认识论和美学统治的普遍性‘脱钩’,并重建那些被西方文明转化为‘赤贫的外部性’的非欧洲语言知识。”[19]这样一种非殖民化的边界思维,为知识的生产打造另一个空间。此外,波多黎各社会学家拉蒙·格罗斯福格尔(Ramón Grosfogue)也强调,非殖民主义的认识论不应该简单地用另一种抽象的普遍性来取代西方的普遍性,而是要以构建不同的批判性认识、伦理、观念之间的批判性对话为目标。这样一来,非殖民化的思维就包含了一种多元的普遍性,而不是一个普遍的世界。[18]17

设计似乎被重新定位为生产有关思想和行动的中心领域,“其他方式(Otherwise)”的概念来自于人类学家阿图罗·埃斯科瓦尔(Arturo Escobar)。在《为多元的世界设计》中,他将批判性设计研究理解为一种多元的、认知间对话,呼吁设计的“其他方式”与拉丁美洲、非洲裔人民非殖民化努力的历史相联系,这表明批判性设计研究正在被积极地重构。[20]

2.批判性设计的责任与批判框架

批判性设计采用思辨的方式,去挑战狭隘的假设和先入之见,这个概念源于设计学者安东尼·邓恩(Anthony Dunne)与菲奥娜·雷比(Fiona Raby)对技术进步以及人们盲目依赖技术的担忧。批判性设计除了提出想象和虚构的非现实美学之外,更多强调的是基于真实世界的技术现实,对另一种平行世界进行谨慎的推论。[21]但批判性设计经常受到质疑的是,设计师是否会在自己的社会背景之外想象未来,从而避免对未来承担责任。纽约现代艺术博物馆的展览“设计与暴力”就引发了一场关于特权空间中思辨有效性的精彩讨论。

《流涎共和国》这一作品,是设计师新田美智子(Michiko Nitta)和迈克尔·伯顿(Michael Burton)思考如果我们的社会面临粮食短缺和饥荒会发生什么,他们设想了一种反乌托邦式的后果,根据个人工作、情感、体力和智力需求,实施严格的食物配给政策。有人认为这个项目属于批判性设计或思辨性设计的范畴,它不是从解决方案回应问题的范式出发,而是从通过创造虚构情景来提高人们对问题的认识和辩论的立场出发。但另一部分人认为,作品中思辨的情况在世界许多地方都是现实,批判性设计的关注点只不过是人们与电子产品关系中“缺乏诗意的维度”。绝大多数批判性设计、思辨设计实践者所宣传的社会叙事和批判似乎只关于欧洲白人中产阶级如何通过技术手段改变现状的美丽思考,几乎没有对社会技术变革的驱动因素进行政治分析,也没有对事情应该走向何方采取立场。对于一门致力于批判性地回应主流设计观念的学科来说,从视觉话语到对近未来场景的表述,批判性设计似乎都显得非常冷漠和非政治化。[22]

这是一场经典的“设计作为解决问题”与“设计作为说服性修辞”的辩论,在此过程中,出现的最紧迫问题之一是批判性设计缺乏政治责任。面对批判性设计没有采取政治立场,是一种有关近未来不加反思的特权想象与技术空谈的指责。一个有用的参考是由设计师佩德罗·奥利维拉(Pedro Oliveira)和路易莎·普拉多(Luiza Prado)撰写的“非(或少)殖民主义思辨性设计手册”。他们整理了七条细则以便设计师检视自己的立场与特权。只有当批判性设计充分理解其试图影响改变对象的所有政治道德层面和伦理维度时,它就能够承担责任并在想象更好的社会中发挥作用。[23]此外,批判性框架还包括萨沙·科斯坦萨—乔克教授(Sasha Costanza-Chock)提出的“设计正义”概念,一种由边缘化群体主导的设计思维,让我们更多地思考设计的过程和跨越压迫的多轴权力动态,为践行和拓展批判性设计研究提供了有益的思考。[24]

三、机器非殖民化的批判性设计实践

算法系统产生的偏见与不公正各不相同,这取决于所使用的训练和验证数据、基本设计假设以及部署系统的具体环境等因素。[8]5算法系统的负面影响,尤其是对边缘化群体的影响,促进了有关算法公平性的研究。

1.“重新想象技术”替代“技术解决方案”

技术解决方案的工作范围主要集中在微调特定模型、使数据集更具包容性或代表性,以及“去偏见”数据集等方面。[8]1目前已有许多工作转向算法不平等的技术修复,例如,“Appolition”数字应用帮助无力支付保释金的人走出牢笼;[15]353“算法正义联盟”发起了安全面孔承诺,呼吁各组织采取公开立场,以减少对面部识别分析技术的滥用。[25]尽管这些干预可以构成部分补救措施,但从根本上讲,这种技术解决方案抑制了对更深远目标的呼吁,即数据实践应优先考虑深入的理解背景而非预测,这种实践会质疑先前的信念——根深蒂固的结构性不平等以及关于正义和技术本身的假设。[8]6公平之路必须审视更广泛的情况,将人工智能伦理与批判性研究置于技术解决方案之上,而不是将研究结果作为建立预测系统的算法规范。

批判性设计中的批判框架鼓励我们研究与实践未阐明的假设,以当代技术想象蕴含的隐喻为基础,通过数据叙事、调查美学两种创造性的方式颠覆技术现实,用新的视觉词汇来描述人类与机器之间的关系。重新想象技术可能看起来是一种激进的选择,但正如凯瑟琳·海伦·奥尼尔所说,“大数据过程是对过去的编纂,它们并没有发明未来,我们需要对社会公正的想象力进行更大的投资”。[15]390

2.数据叙事

个人数字助理、聊天机器人等不同形式的智能代理已经渗透到日常生活中。与族群和性别中立的商业化数字助理不同,当对话界面被用作一种叙事媒介时,这些社会偏见和技术限制也成了校准交互界面特性的工具。通过向智能代理Bina48和Teeny输送以生活经验为形式的族群数据,我们得以观察技术是如何调解族群观念并建立身份认同的。[26]1

Bina48是汉森公司仿照非裔美国企业家比娜·罗斯布拉特(Bina Rothblatt)制作的类人机器人,它被设计成拥有罗斯布拉特的“思想档案”,并且可以独立思考的智能代理。由黑人身份和个人记忆编织的族群观念在艺术家斯蒂芬妮·丁金斯(Stephanie Dinkins)的作品《与Bina48对话》(图3)中被用作发展进一步叙事的技术。这部作品包括四种类型的对话,其中有关“你了解族群观念吗?”这一问题,编码到Bina48中的个人记忆被调用并以第一人称回应了该问题,然而它的局限性在于只能模仿和叙述输入内容,并不能体现既定的经验。丁金斯与Bina48关于族群观念的对话清楚地表明,尽管被移植了个人生活经历,但它无法成为罗斯布拉特的替身,也无法代表黑人的主体性。因此,正是丁金斯精心挑选的有关Bina48的系列语言行为构成了它的性格与身份。[27]同时,作为一种可塑性工具,族群观念的叙事被用来对抗智能代理无族群的规范,这也可以在玛蒂娜·西姆斯(Martine Syms)的《神话存在》(图4)中看到。她利用“威胁模型(Threat Model)”创造了一个在场景中空白的数字声音,揭示了在日益中介化和自动化的世界中嵌入的意识形态及其放大效应。作者思辨的是“某种不想为你服务的代理”,所以她利用自己的身体来模拟所谓的“反Siri”,以数字化身Teeny颠覆了苹果Siri、亚马逊Alexa等数字助理的性别服从性期望。此外,Teeny和Bina48一样,也继承了由艺术家个人记忆编码的族群观念,通过文本与观众互动,以一种刻意夸张的自我方式行事。它使用非裔美国人的方言英语,以相当辱骂性的语言反思了整个网络数据和算法系统中固有的系统性偏见和族群成见。[28]学者李瑞勋(Suhun Lee)认为丁金斯与Bina48的对话以及观众与Teeny的互动塑造了它们的数字身份,这两部作品都反映了当代社会的价值体系,参与分享生活经验并承认其存在,从而为未来虚拟身份的构建提供了批判性的视角。[26]20

图3 斯蒂芬妮·丁金斯,《与Bina48对话》,2014-至今

图4 玛蒂娜·西姆斯,《神话存在》,2018

科技领域缺乏对黑人女性的多维度描述,能否通过让受众接触有色人种创作的认知增强内容来降低偏见和刻板印象?连字符实验室(Hyphen-Labs)借由作品《神经思辨非洲女性主义(NeuroSpeculative AfroFeminism)》(图5),将集体需求和体验置于不断发展的叙事中心,以美容经济学作为推进叙事的载体。作者利用Oculus传感跟踪器和头戴式耳机实现沉浸感和位置反馈,让观众置身于黑人女性的角色,通过重新语境化具有文化特色的美发仪式,窥见黑人女性开拓大脑研究和神经调节的思辨性未来。[29]在这个超现实的数字殿堂中陈列着专为有色人种女性设计的思辨性产品,包括设计师亚当·哈维(Adam Harvey)开发的计算机视觉伪装“超级面孔”,它的工作原理是根据人脸的理想算法表示提供最大激活的假面,将更多注意力转移到附近的假面区域来降低真面(人物)的置信度。这些最大激活的假面是针对特定算法的,如OpenCV的默认正面特征、卷积神经网络或基于HoG/SVM的边缘检测器等其他模式。[30]该技术概念源于设计师早期作品“计算机视觉炫彩(CV Dazzle)”(图5)的理念,这是一种通过最小化真面的置信分来实现计算机视觉匿名的伪装技术,在人脸检测阶段使用特定外观来降低概率判断的检测阈值,这打破了人脸的视觉连续性,降低了计算机视觉系统的理解能力。由于人脸检测是任何自动人脸识别系统的第一步,因此检测阶段的阻塞也会截断包括人脸识别和情绪识别等后续分析。伪装对计算机视觉的价值以及许多算法的脆性现已得到公认,上述作品验证了人脸如何以双重感知状态存在的,降低信息捕捉与分析的风险,挑战计算机视觉领域日益严重的不平等现象,特别是面部识别技术的广泛应用。[31]

图5 连字符工作室,《NSAF》(上),2017 亚当·哈维,“计算机视觉炫彩”(下),2020

这些作品挑战了人们对人机关系的传统理解,并以信息为驱动力,输出智能数据处理,但并不优先考虑人类对可读性或实用性的期望,而是在视觉蒙太奇中反映着批判性的数据叙事。

3.调查美学

如今,设计师们在人权保护、环境暴力和技术统治等领域展开调查工作;同时,一种新的美学维度也在科学与批判性计算、新闻与数据分析、法律与人权等传统意义上的调查领域中显现出来。[32]22这就是法证建筑(Forensic Architecture)创始人埃亚尔·韦兹曼(Eyal Weizman)所说的 “调查美学(Investigative Aesthetics)”,他们的工作成功地将设计从专业实践领域转移到国际法庭和人道主义组织。通过创造新的表现、分析和研究系统,将空间调查与图像制作、数据采集与虚拟建模相结合,解读微弱信号、搜集无意证据、还原事件描述,向社会表达真相。

法证建筑希望利用技术努力做到两件事。第一件事是实用性的,将技术作为调查、展示、传播数据与观点的有力工具。第二件事是关键性的,在使用技术的同时,对技术的构想和运作方式进行批判性自我反思。这可能包括对产生这些技术的历史、内部偏见或倾向以及目前可能将这些技术纳入其中的滥用情况进行调查。不过,这里的前提是,对特定技术的批判性审查往往可以通过使用和重新加工这些技术来实现。只有通过批判性的使用和实践,才能最充分地发现、理解并在可能的情况下揭露矛盾、偏见和局限性。例如,法证建筑通过使用机器学习和人工智能,来帮助筛选和分流网上流传的越来越多的视频证据,但他们也会借此机会试图揭示支撑这些证据的计算过程,否则这些过程往往是不透明的和不负责任的。[32]26-27

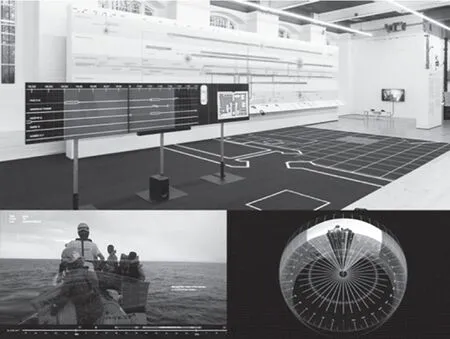

欧洲边界的悲惨事件是法证建筑关注的领域,他们采用卫星通信、遥感技术、流体动力学模拟、数据挖掘等方法,持续为此类案件调查和审判过程提供可视化的信息作为证据。在去年6月发生的移民沉船事件中,法证建筑建立了一个交互式制图平台(图6),绘制了移民船从利比亚东部海岸出发到国际水域希腊搜救区内沉没的路线。他们的地图汇集了不同的信息来源,包括船上乘客分享的求救信号、附近商船拍摄的视频照片、船只跟踪和飞行路径数据、卫星图像、航海日志以及证词。他们还使用相同的照片和视频制作了沉没移民船和小型公海巡逻艇的三维模型,并与代表幸存者的律师分享,以便他们在收集证词时使用。在这项工作中,模型与视频的关系构建了一个图像空间,它同时也是一种分析工具。在这个空间中,每个事件都可以采用多个摄像机同时拍摄,即多情景视角,而不是从建筑平面图所特有的俯视视角进行审视。这种将多视角摄像与视频图像编织在一起的方式,使每个图像都成为通向另一个图像源的铰链或大门。这些数据与幸存者的证词相互参照,帮助他们从各自的角度重建船上的状况以及推论导致移民船沉没的原因。[33]

图6 法证建筑,《反调查个展》(上),2018 《沉船事件》(下),2023

“调查美学”并不是一种美化行为,而是一种细心的调适和注意,它涉及调整和解读微弱的信号,并注意到在视觉、音频、数据文件中或在环境物质构成中记录的无意证据。“调查美学”既使用技术,又对所使用技术的政治性提出质疑,它并没有放弃其批判理论的根基,也没有转向过去的实证主义,它仍然对“事实”“证据”“真理”等术语心存疑虑,但寻求的是重构和开掘它们,而不是抛弃它们。这些术语被重新组合和使用,以产生批判性的洞察力。[32]27-29

四、结语

非殖民化的边界思维扩展了原本批判性设计中的框架与策略,它强调有责任的干预机制来审视特权想象,挑战编码到机器中的社会风险问题。这种由边缘化群体主导、包含多元普遍性的批判探索,不是通过乌托邦式的梦想或理想主义的图式,而是通过实际行动来推进未来思想的具体化,为创造更加平等和可持续发展的世界投射出一种积极变革的力量。