基于AI通信的大规模MIMO信道状态信息反馈网络*

刘为波,颜 彪,沈 麟,丁宇舟

(扬州大学 信息工程学院,江苏 扬州 225009)

0 引 言

作为第5代无线通信系统的关键技术,大规模多输入多输出(Multiple-Input Multiple-Output,MIMO)是当前最具有吸引力的未来无线接入技术之一[1-2]。但为了能获得大规模多输入多输出带来的容量增益,基站端(Base Station,BS)需要准确地接收到来自移动端(User Equipment,UE)的信道状态信息(Channel State Information,CSI)反馈。在时分双工(Time Division Duplex,TDD)模式下,下行信道状态信息可以根据信道的互易性从上行链路获得,而在频分双工(Frequency Division Duplex,FDD)模式下,信道不存在互易性,信道状态信息必须通过UE端进行信道估计然后反馈给基站端。尽管TDD模式为当前工作主流模式,但FDD模式下的低延迟特性在未来许多场景中可以得到充分的应用。天线数量的增加带来反馈开销的急剧上升,因此减少反馈开销的研究也随之展开。

传统的信道反馈技术[3-5]只考虑到了信道的稀疏性,却忽略了低秩的性质。近年来,机器学习方法在不同领域的成功证明了其强大的学习能力。CsiNet[6]的出现说明了深度学习在无线通信的物理层能够得到成功的应用,开创了CSI反馈新方法的先河。此方法采用encoder-decoder结构,进行端到端神经网络参数训练,通过编码器压缩一定大小的码字来进行反馈以达到减少负载开销的目的。随后的研究都是以CsiNet为基础进行的改进[7-20],大多数以数据驱动来设计网络,端到端的黑匣子设计方式其网络结构与性能难以解释。模型驱动[21-24]的方式能够减少对计算资源和训练时间的需求,也易于设计和解释网络结构。采用结合深度学习(Deep Learning,DL)的方法能够加快迭代速度,进一步提高性能。

受模型驱动的启发,本文提出AMFISTANet(Attention Module Fast Iterative Shrinkage Thresholding Algorithm Network),通过注意力机制与FISTANet结合,在网络层设计上可解释性强,嵌入式的注意力模块其复杂性极低,通过加入噪声模块更加贴合实际应用。仿真结果证明AMFISTANet的性能得到了进一步的提升,其鲁棒性也更好。

1 系统模型

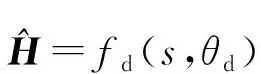

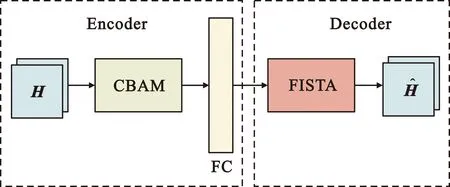

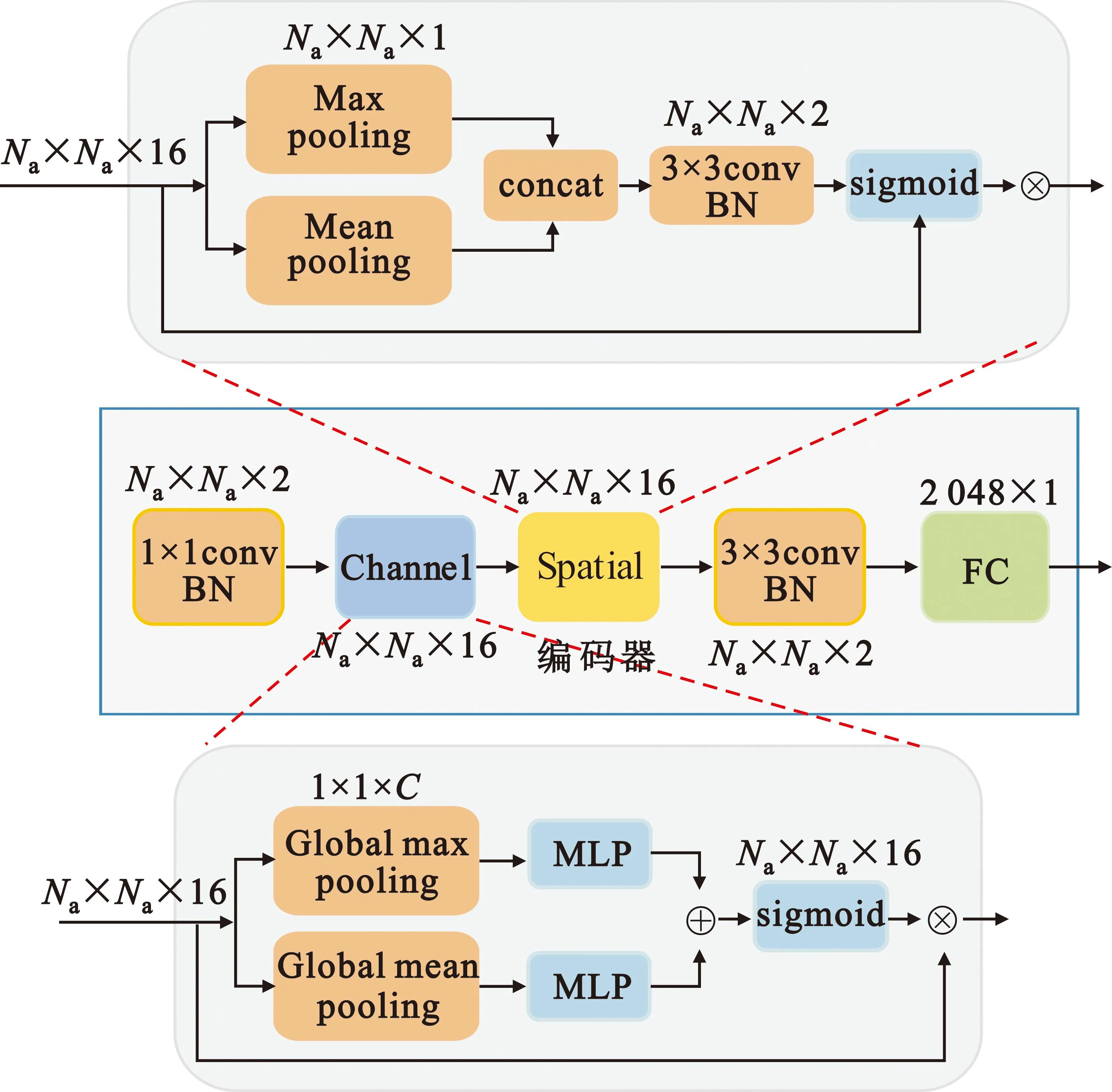

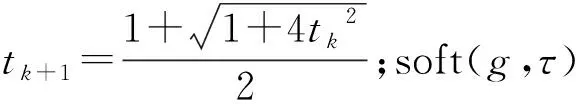

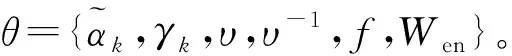

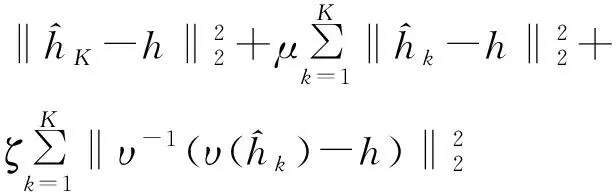

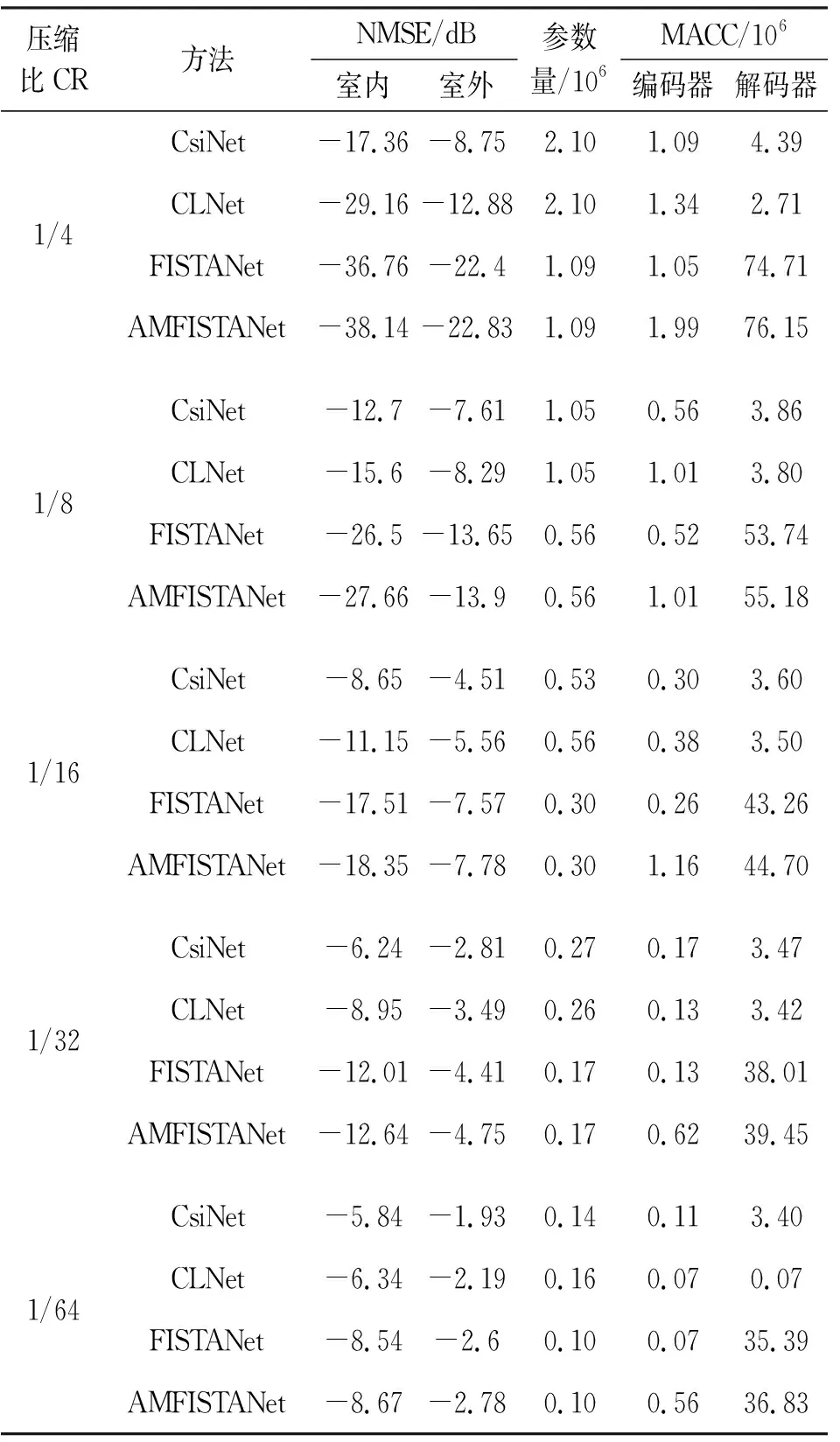

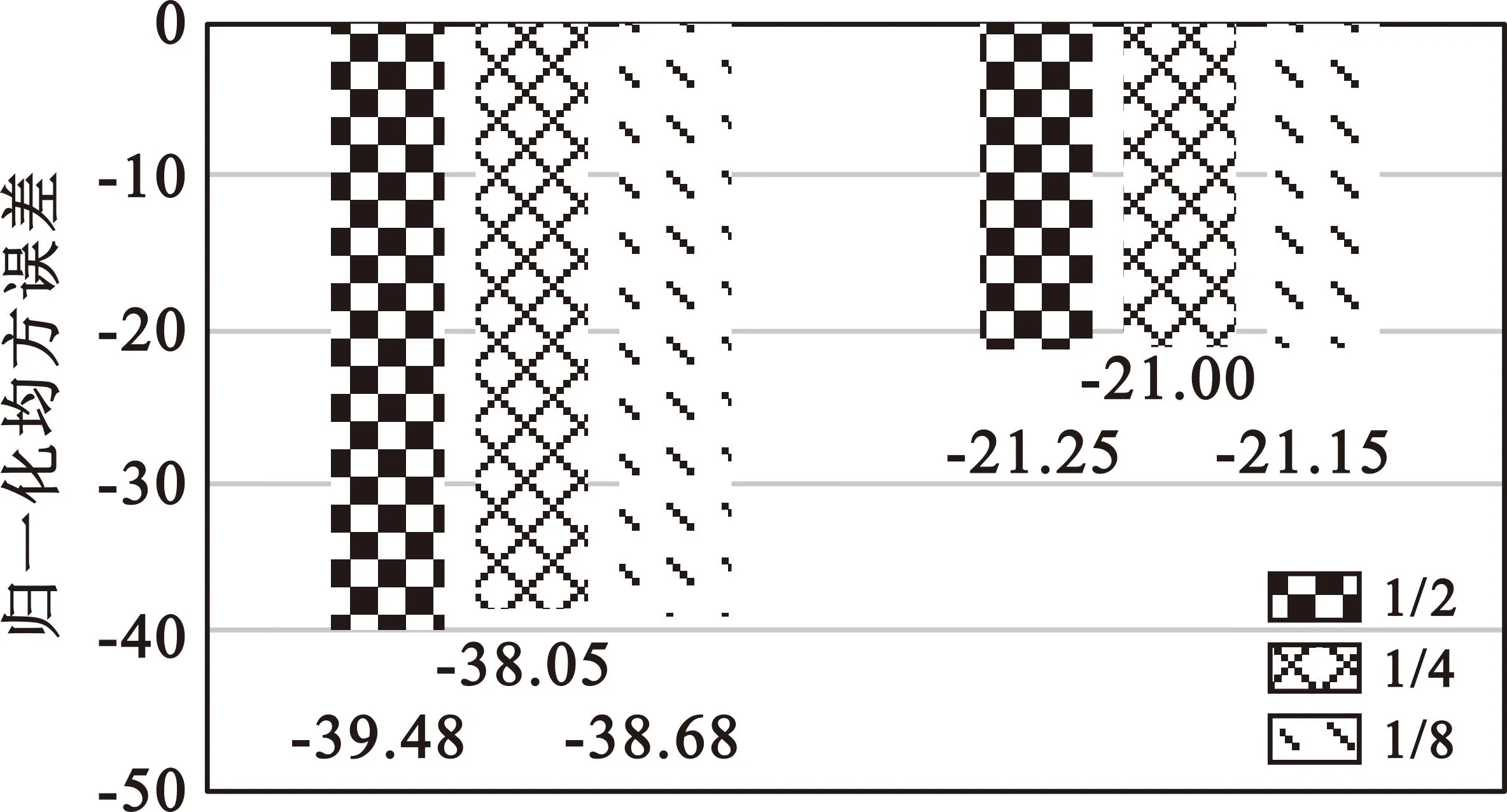

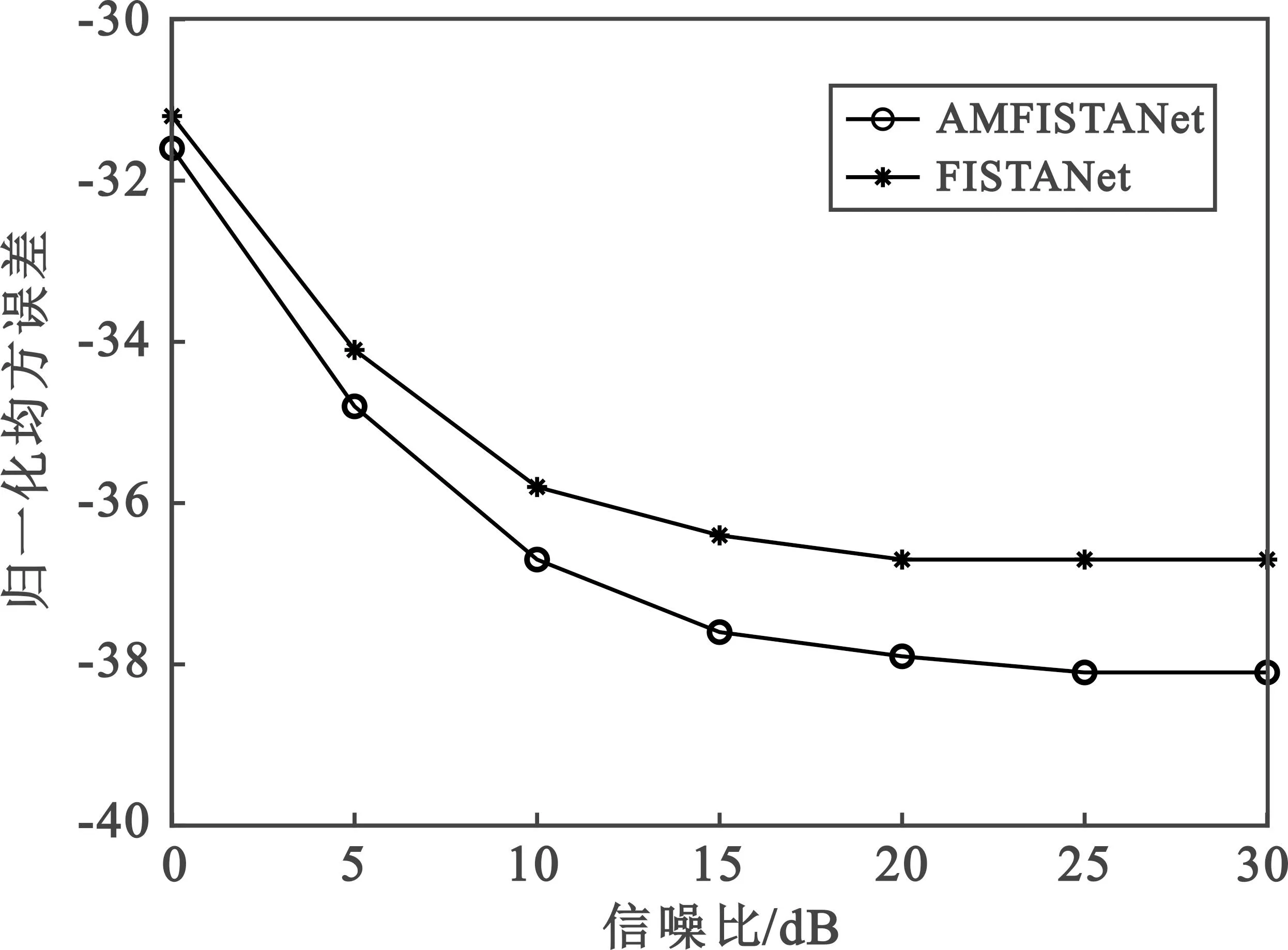

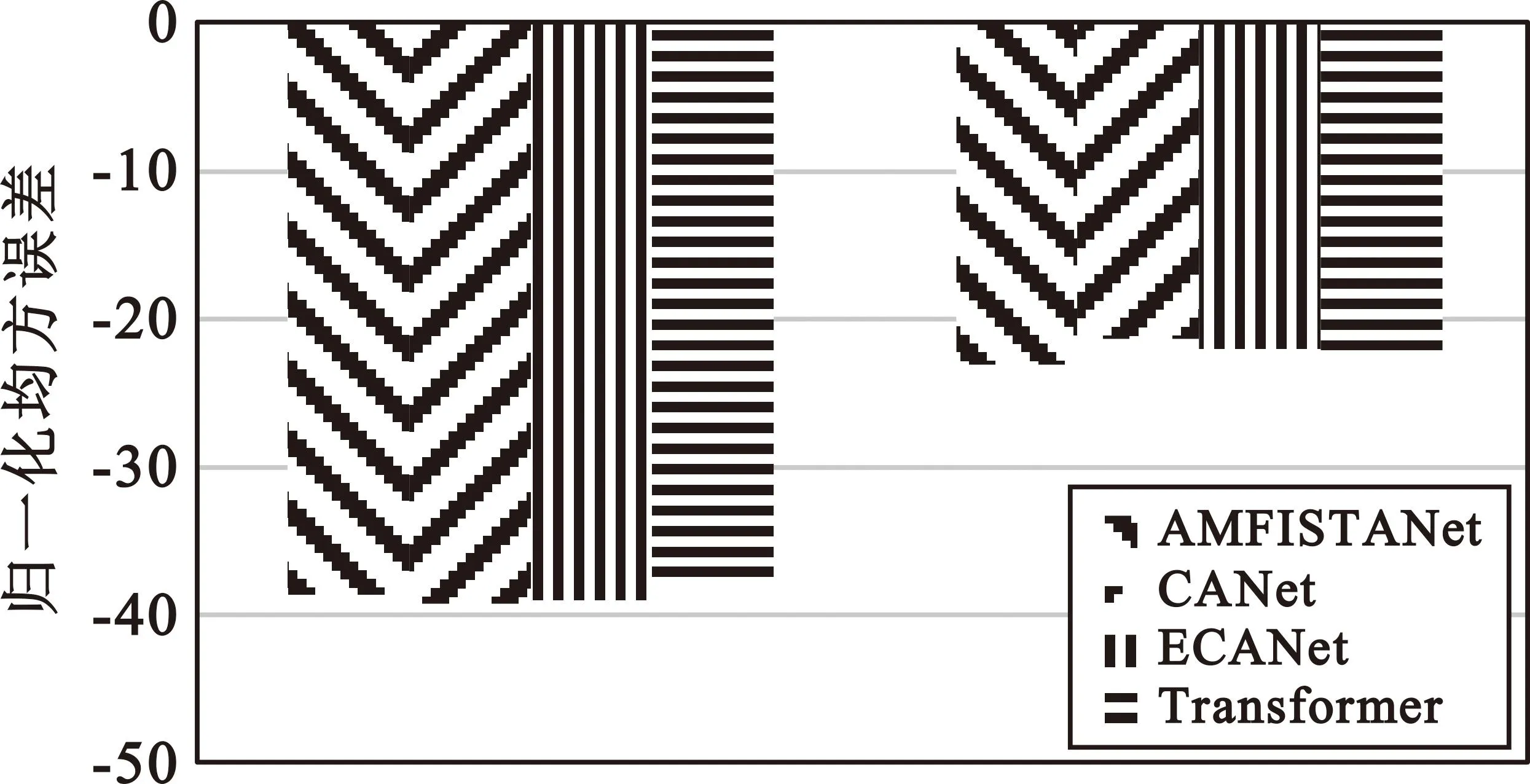

考虑一个单蜂窝FDD大规模MIMO系统模型,其中BS端和UE端分别包含Nt和Nr根发射天线,其中Nr< (1) (2) 式中:Tc和Tt的大小分别为Nc×Nc和Nt×Nt。角延迟矩阵H′中每个元素对应着一定的路径延迟和到达角,并且前Na行包含了大部分的非零值,取其前Na行的截断矩阵为H。尽管稀疏结构能够减少一大部分元素,但其反馈的负载开销依旧巨大,这就需要通过编译码器进一步地压缩才能反馈。设压缩比η=2NcNt/s,s为压缩后码字的长度,表示为 s=fe(H,θe) (3) (4) 式中:fd和θd分别代表编码处理和编码器参数。 (5) 整体网络的设计主要由编码器的CBAM(Convolutional Block Attention Module)[26]和译码器的FISTA网络组成,如图1所示。编码器处的CBAM模块包含通道注意力和空间注意力两个子模块,分别进行通道和空间上的attention。轻量化网络在残差结构做到轻松嵌入,节省了大量的参数和算力。神经网络只能实值训练,因此信道复系数需要虚实分开输入到网络中。 图1 AMFISTANet整体结构Fig.1 Overall structure of AMFISTANet 编码器实现如图2所示。首先,受CLNet的启发,笔者使用了1×1的卷积核进行虚实结合,产生c个通道,c为卷积核的数量,这样便能充分利用到复系数的相位关系。随后连接通道注意力模块,输入的特征图(H×W×C)通过残差进行分支,分别进行全局平均池化(avg)和全局最大池化(max),大小为1×1×C,然后送入到参数共享的多层感知机(Multilayer Perceptron,MLP)中,生成的特征进行逐点相加,通过sigmoid激活函数的结果与主干进行一个相乘即可完成通道注意。通道注意力操作可表示为 maskc=s[mlp(avg(F))+mlp(max(F))] (6) 式中:F为输入特征图;avg和max分别表示全局平均池化和全局最大池化;s为激活函数操作。 图2 编码器结构Fig.2 Structure of the encoder 空间注意机制通过最大池化和平均池化分别生成一个H×W×1的特征图,随后进行拼接操作,通过卷积层生成H×W×1的特征图与主干相乘,可表示为 masks=s[f(avg(F);max(F))] (7) 式中:F为特征图;avg为平均池化;max为最大池化;f为变成1通道的卷积操作;s为激活函数操作。最后CBAM经过一个3×3的卷积核输出到全连接层进行码字压缩,通过上行链路反馈给BS端的译码器进行重构。 软阈值迭代算法(ISTA)采用Nesterov加速技术得到快速迭代收缩阈值算法(FISTA),两种方法都是稀疏恢复的经典算法。FISTA用一种更为聪明的办法选择序列{xk},使得其基于梯度下降思想的迭代过程更加快速地趋近问题函数F(x)的最小值。通过深度学习神经网络参数化能够进一步提高计算速度[22]。通过向量化H,得到h=vec(H),解码器端的CSI重构问题可以表示为 (8) 式中:第二项为重构问题的约束项;l1范数作为正则化项,可以产生一个稀疏模型用于特征选择;Wen为编码器全连接层的权重;λ为稀疏变换;τ为惩罚系数。针对上式的凸优化问题,可以选择基于梯度下降的方法来求解,如FISTA算法。FISTA算法通过阈值收缩来更新h。首先设y1=h0,在第k次迭代中, (9) hk=λ-1(soft(λ(mk),τ)) (10) (11) soft(g,τ)=sign(g)max{|g|-τ,0} (12) 式中:sign(·)为符号函数。 (13) yk+1=hk+γk(hk-hk-1) (14) 经过式(13)的操作后,mk重塑成两通道的Mk方便输入到下一个卷积层。为了使λ能够得到更加稀疏的表示,添加了一个包括1×1卷积和5×5卷积以及一个线性修正单元(ReLu)非线性变换υ(·)和逆稀疏变换υ-1(·),以此替换掉λ和λ-1。同时3×3的卷积层用1×1卷积替代作为头部卷积,并在逆稀疏变换层后也进行添加。最后为了防止过拟合和梯度爆炸,添加了残差结构。式(9)推导出新公式: hk=Mk+f(υ-1(soft(υ(f(Mk)),τ))) (15) 式中:f为5×5卷积操作。 图3 第K次迭代的FISTANet Fig.3 The Kth iteration of FISTANet 训练过程中的损失函数可以重新定义为 (16) 式中:μ和ζ是平衡参数;第一项为标准的均方误差;第二项是第K阶段下真实值和迭代值的差异,第三项是为了让非线性变换υ和其逆变换υ-1通过哈达玛积相乘尽可能为单位矩阵,即υ∘υ-1=I。 为了能够得到统一对比,使用了COST2100信道模型产生的数据进行对比。更进一步讲,采用了CsiNet[6]中的预处理好的数据。室内和室外范围分别设置为20 m和400 m的方形区域,UE端在方形区域内随机采样,频段分别在5.3 GHz和300 MHz。使用了均匀线阵(Uniform Linear Array,ULA)天线方案,BS端部署32根天线,Nc=1 024,UE端配备单天线,通过2D离散傅里叶变换转换到角延迟域,保留前32行作为最后的H,大小为32×32。 信道模型产生的120 000样本,10 000作为训练集,20 000为测试集。epoch=300,迭代次数K=20,每次训练的批次为64。学习率采用衰减学习率,初始学习率为0.001,每100个epoch学习率乘0.1。 (17) 比较了几个最新的方法,包括CLNet[12]、FISTANet[24]以及CsiNet,在不同压缩比下室内室外环境的NMSE如表1所示。表1中性能最好的情况用加粗字体标出,可以看出,AMFISTANet在不同压缩比和不同环境下均表现出了更优异的性能。AMFISTANet和FISTANet在参数上的差距尤其是编码器部分几乎没有增加,衡量网络标准的复杂度MACC只有在基站的译码器部分有了一小部分的增加。值得注意的是,尽管复杂度高于目前最新的网络,但在实际部署中,新引入的信道样本训练往往不需要那么多次迭代,50个epoch以内的迭代即可达到总迭代性能的97%,而其他方法则需要更多的迭代次数才能达到方法的极限性能。 表1 不同方法NMSE对比Tab.1 Comparison of NMSE among different methods 文中提到阈值的选择会对恢复结果有很大影响,因此,针对ST-Net子网络的全连接层进行了消融研究,对MLP中间的全连接层设置不同的压缩比,实验分别设置通道压缩比为1/8,1/4,1/2。因为在网络训练期间前50个eopch就能达到很好的性能,因此,网络在epoch=50,SNR=20,CR=4时测试不同通道压缩比的性能,如图4所示,比较了室内和室外环境下性能差异。可以看出,通道压缩比为1/2时室内外环境表现最好,压缩比为1/4情况下表现较差。室内环境下不同MLP通道压缩比对阈值的选择有较大的影响,而室外环境几乎没有太大差异,原因可能在于室内环境相对于室外的CSI更具有一定的规律性,超参数的选择对有规律的CSI影响更大。 图4 MLP内不同通道压缩比性能比较Fig.4 Comparison of compression ratio performance among different channels within MLP 为了能够贴合实际应用,添加了加性高斯白噪声进行了比较,在CR=4的室内环境[26]下进行了对比,结果如图5所示,可见在大信噪比下AMFISTANet依旧能够保持很优异的性能。 图5 CR=4室内环境下的性能比较Fig.5 Comparison of performance in an indoor environment with CR=4 在网络训练的过程中,编码器网络还尝试加入不同的注意力机制,包括ECANet[27]、CANet[28]和Transformer[13]。图6比较了在CR=4下室内和室外的结果,尽管CANet、ECANet在室内表现的更佳,但在室外环境下其性能与FISTANet相比反而有所下降,因此选择了性能折中方法。在高压缩比(CR=64)的户外情况下,Transformer嵌入的编码器网络测试性能可以达到-3.0 dB,证明了Transformer对更加注重整体特征图而模糊细节部分。 图6 各种注意力嵌入比较Fig.6 Comparison under various attention embeddings 受以上注意力机制的启发,在实际环境部署中,可以考虑针对特定环境下设计反馈网络,以此进一步提高性能。 良好的CSI可以对下游工作如功率分配、天线选择、方案切换等带来益处,不仅可以提高通信质量,还可以降低系统整体的复杂度。 本文针对FDD模式下大规模MIMO的CSI反馈问题,提出了一种基于DL的网络结构AMFISTANet。在整个网络中,编码器端嵌入注意力机制并串联卷积层进行设计,其轻量化设计在实际部署也更容易实现;译码器端的FISTA网络其结构不仅具有可解释性,通过神经网络参数化,学习能力也得到增强。消融实验验证了在大信噪比的情况下其性能也进一步提升,多种注意力机制对比验证了AMFISTANet的优势。 在实际应用中需要考虑量化等步骤来提高整体性能,在未来工作中将考虑从信道本身特性出发去设计更易实现的高效网络。

2 网络设计

2.1 注意力模块

2.2 FISTANet

3 实验仿真

4 结束语