航空机载红外图像的车辆目标自主检测识别

杨 雪,修吉宏,刘小嘉,罗 宁

(1.中国科学院长春光学精密机械与物理研究所,吉林 长春 130031;2.中国科学院大学 北京 100190)

1 引 言

航空成像具有高时效、低成本等突出优势,通过有人或无人机搭载对地/海面目标成像,是实现侦察与监视的重要手段。红外光学成像载荷工作波长较长,具有较强的穿透特性,具备全天时成像探测能力。但与可见光图像相比,红外图像信噪比低、灰度范围窄,且由于航空机载红外成像的照相距离较远,其成像目标尤其是汽车等小目标在红外图像中所占有效像素较小,常常淹没在复杂背景杂波中,大大增加了红外目标的检测难度。此外,车辆目标容易受到场景变化影响,特别是随着光照强度、气候条件、地形等变化,目标在复杂背景下的显著性差异较大。如何快速有效地在复杂背景条件下实现红外图像中汽车等小目标的检测与识别具有重要意义。

传统的目标检测算法以手工设计特征为主,在复杂场景中的泛化能力较弱,具有一定的局限性,如Sobel边缘检测特征、DPM等。2012年的AlexNet使得目标检测开启了新的发展方向[1]。随着深度学习的发展,目标检测算法主要分为单阶段检测和双阶段检测两类,双阶段算法首先产生区域候选框,再对每个候选框提取特征,如R-CNN[2]、SPPNet[3]、Faster R-CNN[4]等,精度高但检测速度较慢,存在大量冗余的候选框。单阶段检测算法产生候选框并进行分类和边界框检测,如SSD[5]、RetinaNet[6]、YOLO系列等,在速度快的同时,随着算法不断地优化改进,检测性能及精确度也在不断地提高,被广泛应用于目标检测、目标追踪等任务中。

航空红外图像目标检测的重点是提高图像中物体的检测精度,降低误检率及漏检率,且考虑到机载光电成像系统对目标信息获取和处理均有一定的时间要求,目标检测算法的执行时间尽可能短,YOLOv5采用CSP结构,因而在模型部署的速度上有较大优势[7],在自动驾驶等方面得到了广泛的应用,但其在提取特征时对特征图进行多次下采样,使得特征信息丢失过多,对红外条件下车辆小目标检测的效果并不理想。在此背景下,本文提出一种基于YOLOv5的RBC-YOLOv5检测模型,主要贡献如下:(1)针对YOLOv5检测小目标效果差的缺点,在浅层特征层P3引入感受野模块,丰富语义信息,增强感受野;(2)针对YOLOv5没有有效利用底层特征的缺点,通过重复双向交叉连接与加权的特征融合机制,加强对底层特征的利用;(3)通过改进颈部网络,增强对融合后特征的提取能力,引入注意力机制,将有限的资源分配给YOLOv5中重要的部分。

2 基本原理

RBC-YOLOv5检测模型基于YOLOv5进行改进,本节主要对YOLOv5的基本原理及引入的各个模块结合航空红外图像特点进行介绍。根据其网络结构顺序,首先在浅层特征引入RFBs模块,提升对车辆小目标的检测精度;再添加CBAM模块,以提升模型对红外图像中模糊特征的注意力;最后使用BiFPN结构以实现更高层次的特征融合。

2.1 YOLOv5基本原理

YOLOv5[8]是一个高性能单阶段目标检测器,作为YOLO系列的延伸,代表了对人工智能开源方向的研究,在组成的各个部分基于YOLOv3均有改进,使得达到实时性的同时,对红外车辆目标的检测效果也得到了显著提升[9]。

对输入图像进行基于Cutmix的数据增强方式-马赛克(Mosaic)增强[10],增强背景的丰富度,扩充数据集中小样本的数量,使得小样本更小,在复杂的红外背景下,提高对车辆小目标的检测效果。YOLOv5通过自适应图片操作,将不同大小的红外车辆输入图像处理为统一尺寸,相比于针对不同数据集都需要先通过聚类提取先验框尺度并设定特定长宽的YOLOv4[11],YOLOv5自适应计算出最佳的锚框。

YOLOv5在主干网络引入了Focus结构,采用切片操作,直接处理输入的图像,再经过拼接(Concat)与卷积(Conv)操作,最后在通道(channel)维度进行拼接,用来减少浮点运算计算量(FLOPs)并增加计算速度,达到对航空图像实时检测的效果。主要使用SPPF模块增大感受野,对特征图进行多尺度特征提取,提高模型精度,原理类似于空间金字塔池化(Spatial Pyramid Pooling,SPP)[12],可以忽略输入红外图像的尺寸并产生固定大小的输出,用不同的尺寸去提取特征,且不会带来运算速度的减少。

输出端(Head)主要由颈部(Neck)特征融合结构与检测部分(Detect)组成。特征金字塔(Feature Pyramid Network,FPN)[13]与路径聚合结构(Path Aggregation Network,PAN)[14]相结合,将FPN自顶向下的高层的强语义信息传递给低层,再通过自底向上的PAN结构传达强定位特征,从而达到对不同的检测层进行参数聚合,有助于提升对航拍图像中不同大小车辆目标的检测效果。

2.2 RFBs模块

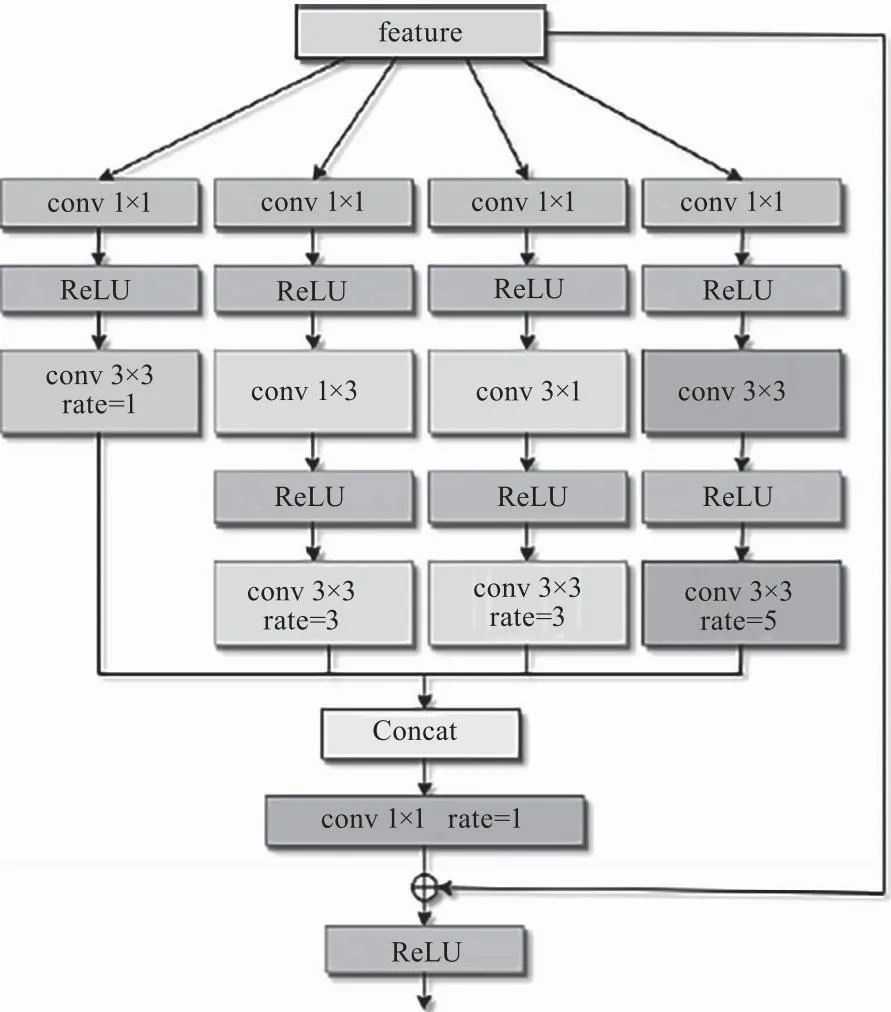

该RFBs[15]模块模拟人类视觉神经的特点,参考了Inception的并行思想,使用空洞率(rate)为1、3、5的空洞卷积来调节不同大小卷积核,使之能够完成轻量化任务,提高了网络的特征提取能力。相较于原始RFB模块,既减少了参数量,又有利于捕捉更小的感受野,能够有效保持YOLOv5的轻量级网络的速度,又能够提升检测精度。RFBs模块的结构如图1所示,使用3×3、1×3、1×1的不同卷积组合,分别等价于3×3、5×5、7×7的卷积,再引入rate为1、3、5的的空洞卷积提高感受野,通过拼接(Concat)对不同的感受野进行特征融合,最后使用1×1卷积提升模型的检测速度。

图1 RFBs模块

2.3 CBAM模块

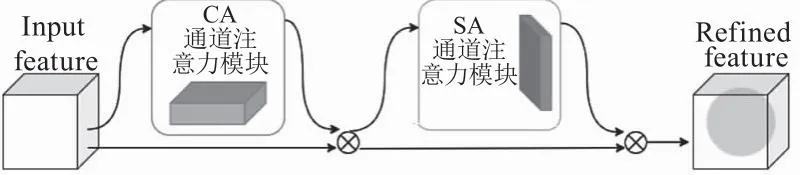

通道注意力机制自适应的关注通道,对通道生成掩码mask,每个通道都是特征图上每个特征点的特征浓缩,更加关注更高语义信息的特征,使其权重更高,如SENet[16]等。空间注意力机制自适应分辨空间中的区域,对空间进行mask的生成,网络自适应的去关注位置,使关注点的权重更大,如Spatial Attention Module。

CBAM是一种轻量化的注意力模块,同时对通道和空间注意力进行打分,依次应用通道和空间注意力模块,进行自适应特征细化。CBAM注意力模块的结构如图2所示,能够增强对目标特征的提取能力,使得网络有效关注提取区域,提高检测性能,并且可广泛应用于语音识别、自言语言处理等领域当中[17]。

图2 CBAM注意力模块

2.4 BiFPN

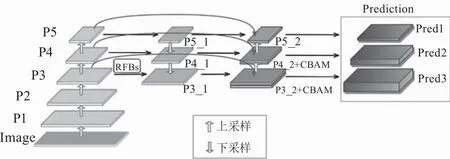

随着深度学习的发展,特征融合的方法在不断地改进。近年来使用较多的是PANet,特征图同时具备高语义信息和位置信息,有效提高目标检测等任务的精度,NAS-FPN[18]结构的检测效果好,但网络结构不规则且运行需要消耗大量计算资源,M2det[19]兼顾效率和速率,但参数过多。BiFPN[20]是一种高效的特征融合方法,具备自顶向下与自底向上的双向加权特征金字塔结构,同时传递高层的语义信息与底层的位置信息,并可学习不同输入特征的重要程度,重复的跳跃连接融合,进一步提升了检测精度。可看做是加强版的PANet,BiFPN结构图如图3所示。

图3 BiFPN结构

3 RBC-YOLOv5模型

由YOLOv5包含YOLOv5n、YOLOv5s、YOLOv5m、YOLOv5l、YOLO5x 五个模型变体,由左至右模型复杂度逐渐增加,参数量depth_multiple与width_multiple也在逐渐增加,检测精度越高,但检测速度越慢。本文选用YOLOv5s作为基础模型,节省了一定的计算成本,检测速度快的同时兼具较高的检测精度。

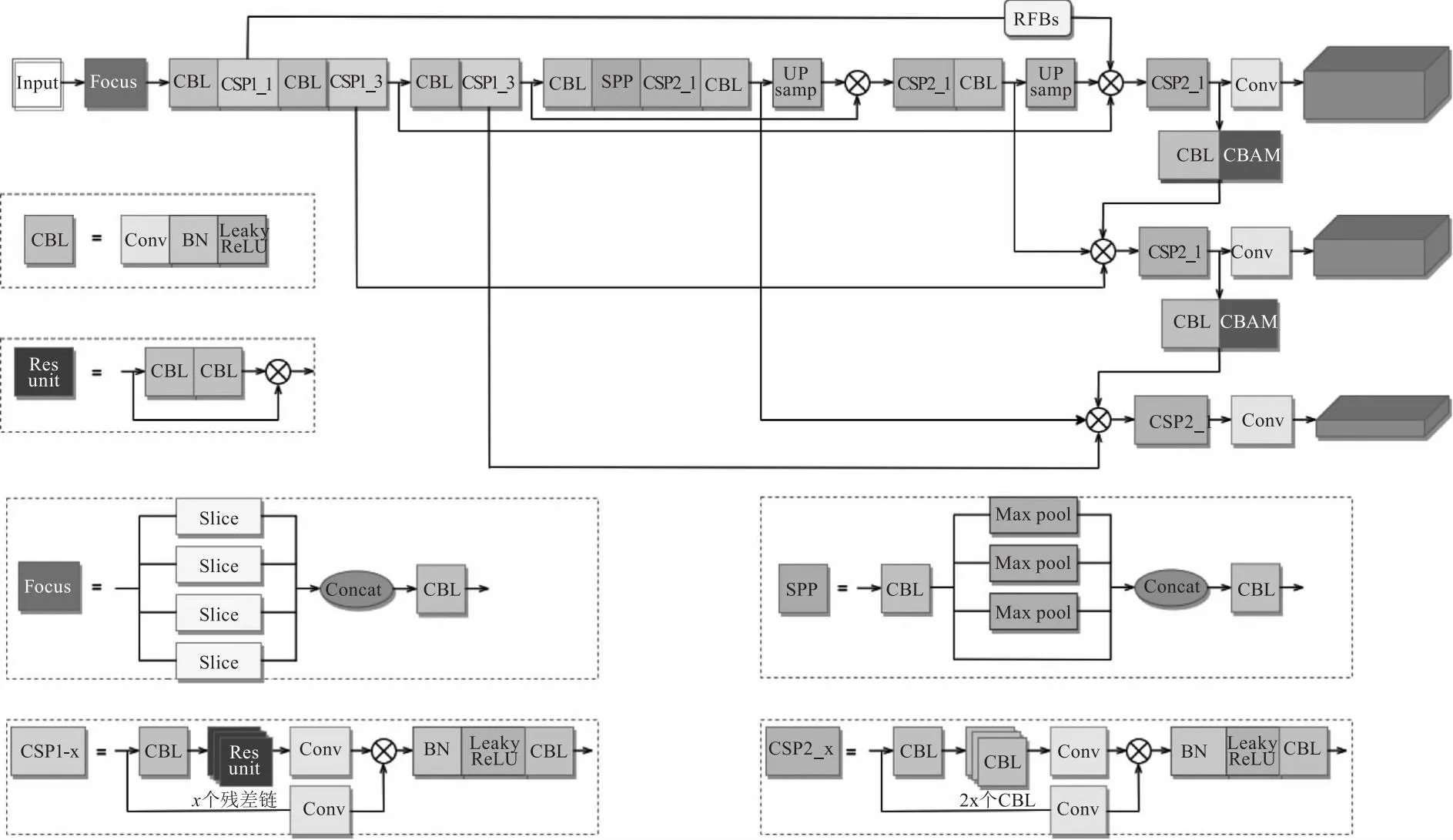

针对像素点小、边缘特征不明显的航空机载红外图像,对YOLOv5进行改进,提出了RBC-YOLOv5模型结构,在浅层特征层引入RFBs感受野模块,提升小尺寸目标的检测精度,使用BiFPN结构实现更高层次的特征融合,添加CBAM注意力模块有效提升检测精度,使其更适用于对比度低和边缘不清晰的红外车辆小目标检测,其网络组件及网络结构如图4所示。

图4 RBC-YOLOv5模型结构图

3.1 输入端(Input)改进

YOLOv5使用Mosaic数据增强方法,本文在此基础上,引入mixup数据增强方法,将输入的两张图像先进行一定的翻转、缩放,并按照一定比例进行混合,形成一张新的图像传入到网络当中,通过样本与标签的线性插值得到新的训练样本,可以用来提升模型的鲁棒性和泛化性,能够降低样本中存在的噪声,减轻过拟合现象。假设xi,j与yi,j为随机样本,λ的值域为[0-1],则核心公式如(1)、(2)所示:

(1)

(2)

将图片预处理成640×640大小传入网络中,并进行归一化等操作,采用改进后的数据增强方式提升网络计算速度及训练精度,利用自适应图片缩放操作及自适应锚框计算操作,将图像通过缩放比例缩放到适合于模型的大小并自适应计算出最佳的锚点框。

3.2 主干网络(backbone)改进

backbone使用CSPDarknet53及Focus结构,主要使用CBL模块与SPPF模块,有效提升模型推理速度,在YOLOv5的多尺度目标检测算法中,共进行5次下采样,得到特征层P1~P5,Pi_1层为Pi层图像大小的1/2,将P3~P5传入Neck进行特征融合,但随着特征尺度的减小,目标经多次下采样的分辨率也在逐渐变小,进一步增加了红外车辆目标的检测难度。

浅层特征的分辨率较大,可用于检测小目标,但语义信息不够丰富、感受野较小,为了进一步提升航拍红外图像中汽车等小目标的检测精度,在backbone的P3层与融合后的P3_1层之间引入RFBs模块,增强语义信息、增大感受野,提升YOLOv5对图像中车辆小目标的检测效果。RBC-YOLOv5模型简化结构如图5所示。

图5 RBC-YOLOv5模型简化结构图

3.3 颈部网络(Neck)改进

在航拍红外车辆目标检测的场景下,虽然红外图像具备一定的揭伪能力,能够规避可见光图像无法在夜间成像的限制,但由于照相机距离地面较远,所拍摄物体所占像素较小,对于背景复杂且边缘模糊的目标检测具有一定难度。

使用原始FPN+PAN进行检测时自顶向下与自底向上相结合的融合计算量较大,并且没有融合backbone中所含有的原始特征。为尽可能的保留原始特征,并多次利用同一层,因此本文采用双向加权的BiFPN,通过跨连接将Pi层特征传递给Pi_2层(i=3,4,5),在不增加过多计算量的同时,提升对特征的重复有效利用,以实现更高层次的特征融合。

由于小尺寸目标只能在底层P3、P4层被检测出来,为提升对小目标的检测效果和精度,根据Hu[21]等人所述,通过注意力机制模块增加小目标的上下文信息,可提升网络对小目标的检测率,因此在颈部网络融合后的特征中引入两个CBAM注意力模块,先通过通道注意力机制的全局平均池化、采用ReLU与Sigmoid激活函数的全连接,调整更具意义的通道信息的权重,提取出更加重要的通道特征,再经过空间注意力机制,在特征图的每一个点取最大值和平均值,经过sigmoid,获得了每个特征点的比重,与输入进来的特征层相乘,也就是完成了空间注意力机制,使得在目标尺寸小、特征不明显的条件下,改善网络特征提取能力及特征融合能力。

4 实验分析

4.1 数据集

DroneVehicle数据集[22]是 RGB/红外跨模式车辆检测数据集,涵盖不同的物体和场景,如城市道路、农村、住宅区、停车场和高速公路等,不同的高度、角度和光照条件来模拟现实中的数据分布。在不同高度获取的图像包含不同尺度的物体,在不同角度获取的图像显示出各种形状的物体,在不同光照条件下获取的图像包含更多的阴影遮挡和亮度变化,各种复杂条件使得DroneVehicle数据集更具挑战性。

本文从中抽取部分红外图像,包括汽车(car)、卡车(truck)、公交车(bus)、货车(freight_car)四类,共28439个样本,训练集(train)中包含17990张图像,测试集(test)中包含8980张图像,验证集(val)中包含1469张图像,数据可视化结果如图6所示。

图6 数据可视化结果

4.2 网络设置与训练

本文所使用的配置为NVIDIA GeForce GTX 1660,显存6 GB,处理器(CPU)为 Intel Core i7-4770 @3.40GHz 八核,Python版本3.9.7,PyTorch版本1.7.1。

对训练数据进行数据增强,包含Mix-up、Mosaic、Flip left-right、Hsv等数据增强方法,以提高模型的泛化能力,具体参数如表1所示。

表1 数据增强参数

使用YOLOv5s模型结构,设置深度倍数depth_mulyiple为0.33,宽度倍数width_multiple为0.5,改进后的RBC-YOLOv5模型的训练参数如表2所示。

表2 模型训练参数

4.3 评价指标

为验证模型的性能,本文采用平均精度(AP),平均精度均值(mAP),精确率(P),召回率(R)为评价指标来评估模型性能,公式如(3)、(4)所示:

(3)

(4)

其中,TP为真样本被正确识别;TN为假样本被正确识别;FP为假样本被错误识别;FN为真样本被错误识别;准确率P为TP所占比例,召回率R为被正确识别为真样本的比例。通过P、R绘制P-R曲线。

AP为P-R曲线下的面积;mAP是多个类别AP的平均值,公式见(5)和(6):

(5)

(6)

4.4 实验结果分析

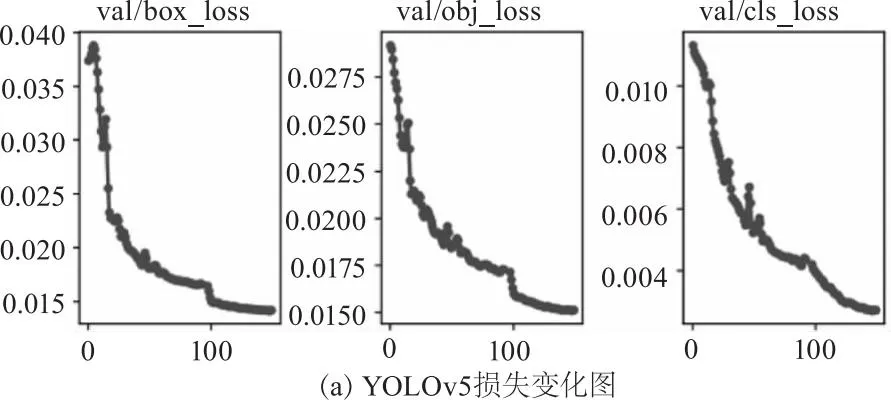

将改进的RBC-YOLOv5模型训练150个epochs,与原始YOLOv5在验证集上进行测试,边界框回归损失(box_loss)通过预测框和真实框的IoU值来反应预测结果的好坏,目标置信度损失(obj_loss)由正样本匹配得到的样本对计算损失,类别损失(cls_loss)通过预测框的类别分数和目标框类别的独热编码表现来计算类别损失,观察各类损失的变化,可见RBC-YOLOv5模型的收敛速度更快,各损失更低,box_loss稳定在0.0148左右不再降低,obj_loss稳定在0.0149左右,cls_loss稳定在0.0027左右,具体如图7所示。

图7 损失变化图

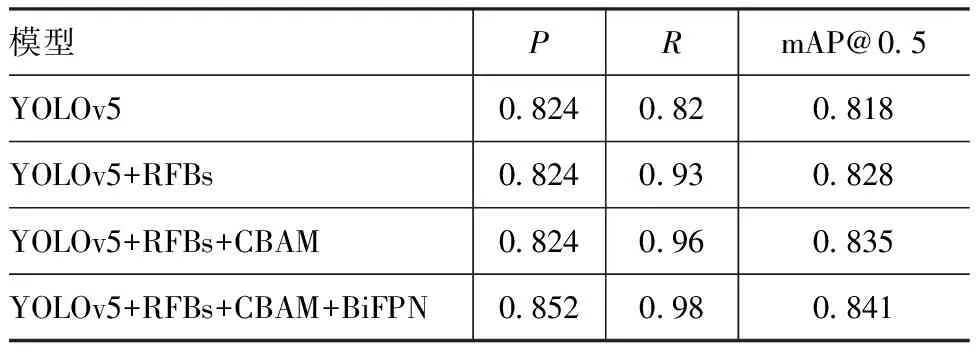

在迭代150个epochs后,P提升2.8 %,R提升16 %,mAP提升2.3 %,具体数据如表3。

表3 YOLOv5与RBC-YOLOv5性能指标对比

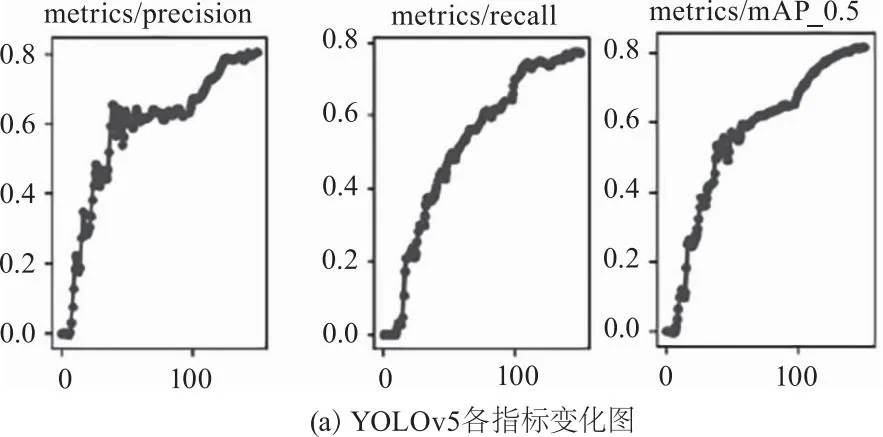

在验证集上测试,观察P、R与mAP的变化,如图8所示,RBC-YOLOv5模型的性能整体优于YOLOv5。

图8 指标变化图

消融实验是系统分析的最直接方式,通过消融实验观察不同改进带来的变化,改进内容包括感受野模块RFBs、卷积注意力模块CBAM、加权双向特征金字塔BiFPN,从表4可以观察到,BiFPN使精确度提升了2.8 %,RFBs与CBAM对召回率其关键作用,分别提升了11 %和3 %,RFBs与CBAM使平均精度均值分别提升了1 %和0.7 %。

表4 RBC-YOLOv5消融实验结果

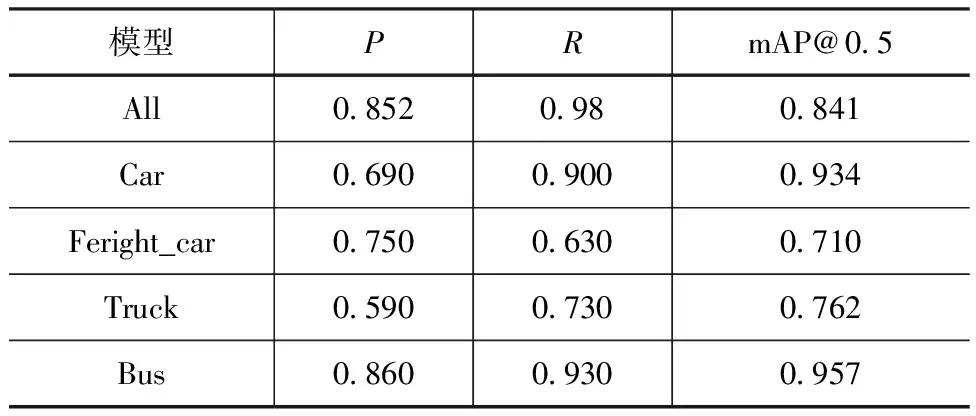

RBC-YOLOv5在DroneVehicle数据集中各个类别的测试数据如表5所示。

表5 测试集RBC-YOLOv5性能指标

4.5 实验结果展示

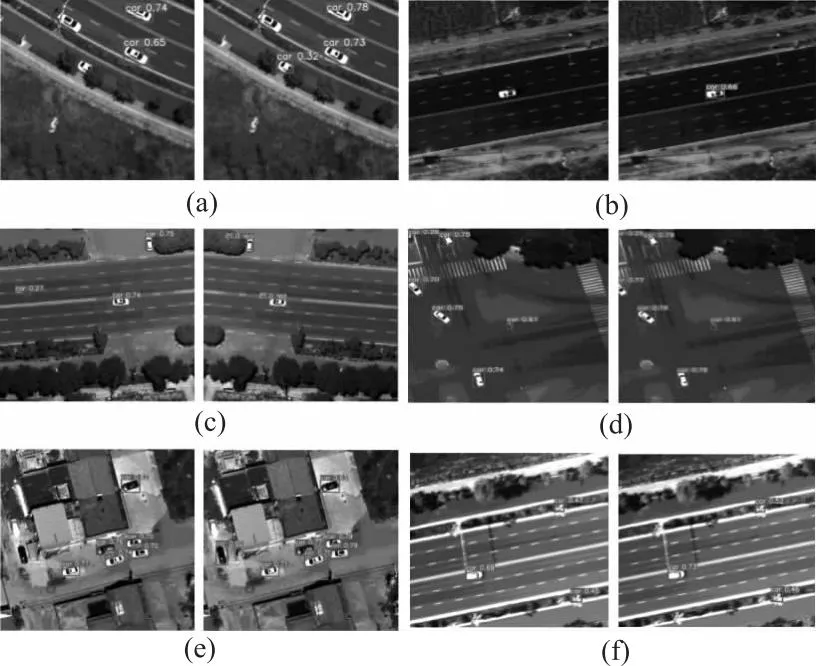

图9为RBC-YOLOv5在DroneVehicle数据集上的一些检测结果。

检测结果

图10为将RBC-YOLOv5模型应用于某型航空相机实际航拍图像的检测结果。左侧为YOLOv5检测结果,右侧为RBC-YOLOv5模型检测结果。如图10(a)与10(b),对于遮挡及漏检的汽车,原YOLOv5不能检测出目标,改进模型能检测出目标,降低漏检率,其检测精度分别为0.65和0.66,如图10(c),原YOLOv5将斑马线误检为目标,改进后的模型有效识别出真实目标,降低了误检率,如图10(d)、(e)与(f),RBC-YOLOv5模型能够有效提升1 %~9 %的检测精度,进一步验证了RBC-YOLOv5的检测性能。

图10 航空机载红外图像检测结果

5 结论与展望

针对机载红外图像车辆目标的检测问题,本文提出基于YOLOv5的改进模型,在浅层特征层引入感受野模块,提高对小目标的检测效果,将PANet替换为BiFPN,强化底层特征,引入CBAM模块,使模型更加关注重要特征,有效提升对特征的提取能力,本文在DroneVehicle数据集与实拍航空红外图像中做了多组对比实验,实验结果表明,检测的精确率提升了2.8 %、召回率提升了16 %与平均精度提升了2.3 %,降低了漏检率及误检率,证明了本文方法的有效性,不过本文所用的加权双向融合方法增加了模型的大小,后续工作致力于提升模型精度的同时减小模型大小。