基于孪生网络和Transformer的小目标跟踪算法SiamTrans

公海涛,陈志华*,盛斌,祝冰艳

基于孪生网络和Transformer的小目标跟踪算法SiamTrans

公海涛1,陈志华1*,盛斌2,祝冰艳1

(1.华东理工大学 信息科学与工程学院,上海 200237; 2.上海交通大学 电子信息与电气工程学院,上海 200240)(∗通信作者电子邮箱czh@ecust.edu.cn)

针对现有小目标跟踪算法的鲁棒性差、精度及成功率低的问题,提出一种基于孪生网络和Transformer的小目标跟踪算法SiamTrans。首先,基于Transformer机制设计一种相似度响应图计算模块。该模块叠加若干层特征编码-解码结构,并利用多头自注意力机制和多头跨注意力机制在不同层次的搜索区域特征图中查询模板特征图信息,从而避免陷入局部最优解,并获得一个高质量的相似度响应图;其次,在预测子网中设计一个基于Transformer机制的预测模块(PM),并利用自注意力机制处理预测分支特征图中的冗余特征信息,以提高不同预测分支的预测精度。在Small90数据集上,相较于TransT(Transformer Tracking)算法,所提算法的跟踪精度和跟踪成功率分别高8.0和9.5个百分点。可见,所提出的算法具有更优异的小目标跟踪性能。

目标跟踪;小目标;孪生网络;注意力机制;Transformer

0 引言

目标跟踪是计算机视觉研究中的一个重要方向,通过对视频中不同帧之间目标位置的连续预测实现对目标运动的稳定跟踪。从任务结果看,目标跟踪与目标检测任务存在着一定的相似性,目的都是预测图片中目标的位置;但是目标跟踪需要处理在时间上具有连续性的不同视频帧。此外,目标的运动过程还受到形变、遮挡、背景模糊等因素的干扰,因此目标跟踪任务更具挑战性。

本文将小目标定义为目标面积小于图片面积1%的目标。小目标是一种特殊的目标,自身尺度较小,无法为跟踪器提供足够的特征进行学习。另外,小目标在运动过程中更易受到环境因素的影响,比如:简单的遮挡就会导致小目标在运动视野中完全消失;低分辨率图像中小目标可提供的特征更少。这些问题导致对小目标稳定跟踪的难度更大。随着无人机、无人驾驶等产业的发展,小目标跟踪技术也存在广泛的应用前景,但是因为技术上的难度以及相关产业的滞后性,目标跟踪任务的研究重点多为常规目标,专门跟踪小目标的研究相对较少。将针对常规目标设计的跟踪算法直接应用在小目标跟踪任务中存在较大问题,如Henriques等[1]提出的KCF(Kernelized Correlation Filters)算法、Li等[2]提出的SiamRPN(Siamese Region Proposal Network)算法、Guo等[3]提出的SiamCAR(Siamese fully Convolutional classification And Regression)算法在跟踪小目标时容易丢失目标,还存在预测精度较低的问题;此外,现有的小目标跟踪算法漏检、误检问题也较多。

针对上述问题,本文基于孪生网络和Transformer算法[4]提出了一种小目标跟踪算法SiamTrans。在目前已提出的单目标跟踪算法中,孪生网络架构优越性显著,王梦亭等[5]总结了基于孪生网络的经典单目标跟踪算法,因此本文算法也选择孪生网络架构。通过设计基于Transformer算法的相似度响应图计算模块,本文算法提高了相似度响应图的计算精度,为预测子网提供了高精度的输入信息;此外,在预测子网中设计了一个基于Transformer算法的预测模块(Prediction Module, PM),通过自注意力机制提高目标位置预测的准确性。

本文的主要工作如下:

1)基于Transformer算法提出了一种相似度响应图计算模块,该模块中包含特征编码-解码结构,利用多头自注意力机制和多头跨注意力机制实现目标特征与搜索区域特征的有效融合,提高相似度响应图的计算精度,从而为预测子网提供高质量输入信息。

2)基于Transformer算法提出了一种预测模块,该模块利用自注意力机制增强了对目标前景、背景和目标位置信息的关注度,准确预测了目标位置。

3)提出了一种基于孪生网络与Transformer的小目标跟踪算法SiamTrans,将相似度响应图计算模块和预测模块嵌入孪生网络,实现了对小目标的有效跟踪。在Small90[6]、LaTOT(Large-Scale Tiny Object Tracking benchmark)[7]、UAV123(Unmanned Aerial Vehicle123)[8]等数据集上的测试结果表明SiamTrans具有较优的性能。

1 相关技术

1.1 小目标跟踪算法

为了增强目标跟踪的鲁棒性,常用的方法是特征融合或者注意力机制,如朱文球等[9]提出的目标跟踪算法中提出了融合空间注意力和通道注意力的混合注意力机制。已有的小目标跟踪算法主要通过增强特征的方式实现目标跟踪。Ahmadi等[10]在跟踪算法中整合空间特征信息和频率特征信息,增强了目标特征图中的目标特征信息,从而提高了目标位置预测的准确度。相似地,Ahmadi等[11]为了解决复杂环境中小目标跟踪的问题,提出了一种多层次的小目标跟踪算法,增强了小目标跟踪的鲁棒性。Marvasti-Zadeh等[12]则提出了一种双流网络,该网络训练时会学习不同尺寸的特征信息并通过注意力机制过滤不相关的特征信息。通过这些策略,目标跟踪算法较好地解决了目标运动过程中的遮挡以及视角变化问题。Liu等[6]提出了一种目标特征签名机制,通过特征签名算法提高了小目标特征在特征图中的区别度使得目标更容易被预测。尽管这些方法已经在小目标跟踪任务上取得了一定的进展,但是仍然存在一些问题,比如在计算相似度响应图时仅利用单层特征图,未充分利用目标特征信息与当前帧不同特征层之间的特征关系;此外,利用互相关操作计算相似度响应图容易丢失语义信息并陷入局部最优解。这些问题制约着小目标跟踪算法的性能。

1.2 常规目标跟踪算法

常规目标跟踪算法可以分为基于相关滤波的跟踪算法和基于深度学习的跟踪算法。早期阶段,基于相关滤波的跟踪算法在跟踪速度以及精度上表现优异,很多优秀的算法,如KCF[1]、CSK(Circulant Structure of tracking-by-detection with Kernels)[13]、SAMF(Scale Adaptive Multiple Feature)[14]、ECO(Efficient Convolution Operators)[15]等算法被先后提出。尽管这些算法在相关数据集上的测试结果具有明显优点,但是也存在着明显缺点,如学习目标特征的能力不足,在复杂场景中算法不能稳定跟踪目标等。这些因素制约了相关滤波算法的进一步发展。

深度学习方法在巨量数据的基础上,对模型中的参数进行调整,使得模型不断得到优化,拟合能力不断增强。这也意味着深度学习算法有着强大的特征学习能力,这一能力使它在目标跟踪、目标检测、语义分割等任务中具有巨大优势。在跟踪任务中,基于孪生网络的算法将跟踪问题建模为一个相似度匹配问题,通过端到端的训练实现了跟踪精度与速度的平衡,并在多个数据集上超越了基于相关滤波的跟踪算法。SiamFC(Fully-Convolutional Siamese network)算法[16]是目标跟踪任务中首个全卷积的跟踪网络,它设计了一种非常简洁的模型结构,通过计算搜索区域中不同位置与目标特征的相似度实现对目标位置的准确预测。此后,基于孪生网络结构的优秀跟踪模型大量涌现,如SiamRPN[2]将在目标检测任务中大获成功的RPN(Region Proposal Network)引入跟踪任务中,在不增加计算量的前提下,利用预制的锚框实现了对目标位置的高质量回归。在SiamRPN[2]的基础上,SiamRPN++算法[17]优化了特征提取子网以及相似度计算方法,并在多个数据集上获得了更好的结果。此外,DaSiamRPN(Distractor-aware SiamRPN)[18]、SiamMask[19]、SiamBAN(Siamese Box Adaptive Network)[20]等算法也是基于孪生网络的代表性工作。

Transformer算法[4]是一种完全基于注意力机制的算法,它成功应用于自然语言处理任务和计算机视觉任务中。Yan等[21]提出了包含一种编码-解码的Transformer组件的跟踪算法,该组件会编码视频帧序列中包含的时间、空间特征信息,并利用解码模块直接预测候选框。相似地,Wang等[22]也设计了一个包含编码-解码结构的Transformer模块并整合到基于孪生网络结构的跟踪算法中,Transformer模块的目的是融合视频帧中的时序信息以提升相似度计算的准确性。与前两种算法不同的是,Blatter等[23]则是在预测子网的分支中引入了Transformer模块,通过替换预测子网分支中的卷积结构并引入一个轻量级的特征提取模块,模型在CPU上就达到了较高的处理速度。上述针对常规目标设计的跟踪算法直接应用到小目标跟踪任务中会存在漏检、误检的问题,但这些方法的设计思想对小目标跟踪算法的设计具有启发性。

2 本文算法设计

2.1 特征提取子网

2.2 相似度响应图计算模块

2.2.1特征编码模块

2.2.2特征解码模块

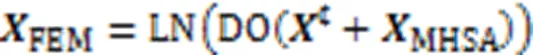

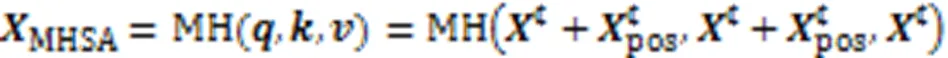

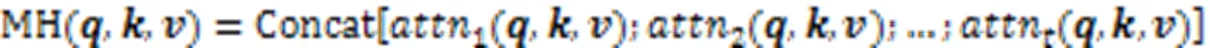

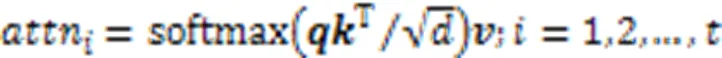

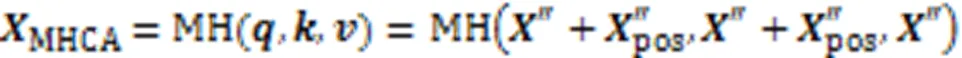

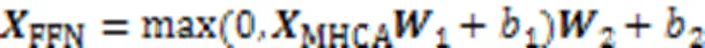

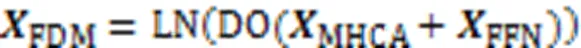

FDM的结构如图2(b)所示。FDM的作用是融合模板特征图以及搜索区域特征图,从而得到与互相关操作输出结果类似的相似度响应图。与FEM不同,在FDM中设计一个多头跨注意力机制层,该层的输入信息为FEM输出的模板特征编码响应图以及上一层FDM输出的相似度响应图。此外,为了强化相似度响应图中的目标位置信息,在该模块中同样引入目标的空间编码信息。该模块中多头跨注意力机制的计算公式如式(6)所示:

2.3 预测子网

在跟踪任务中,用预测子网预测目标位置。现有的基于孪生网络的跟踪算法中,预测子网由卷积结构组成,包含分类分支和回归分支两个分支:前者用来区分搜索区域中的前景和背景;后者用来预测目标预测框的位置。在预测任务中,跟踪算法需要重点关注前景信息和目标位置信息,过滤冗余信息,因此基于Transformer[4]设计了预测模块,模块中包含了一个自注意力层,以增强跟踪器对前景信息以及目标位置的感知能力,提高目标预测的精度。预测模块的结构如图2(c)所示。算法分别在分类分支以及回归分支中嵌入6个预测模块,两个分支末尾分别引入了1个卷积层以调整输出结果,最终得到对目标位置的预测结果。

图2 FEM,FDM和PM的结构

3 实验与结果分析

实验的硬件设备如下:显卡型号为NVIDIA Geforce RTX 3090,CPU型号为8核心 2.1 GB Intel Xeon Silver 4208,内存型号为16 GB DDR4 RAM。算法使用梯度下降法在COCO(Common Objects in COntext)[25]、ImageNet DET(ImageNetwork DETection)[26]、LaTOT[7]以及GOT-10k[27]等数据集进行训练。特征提取子网两个分支的输入图像大小分别设定为256×256、128×128。算法选择在ImageNet数据集上预训练的ResNet-50作为特征提取器。模型一共训练800轮,批处理尺寸设置为16,学习率设置为0.000 1,训练400轮学习率衰减至1/10。训练好的算法在5个数据集上进行了测试,分别是Small90[6]、Small112[6]、UAV123_10fps[8]、UAV20L[8]和LaTOT[7],具体的实验结果如下。

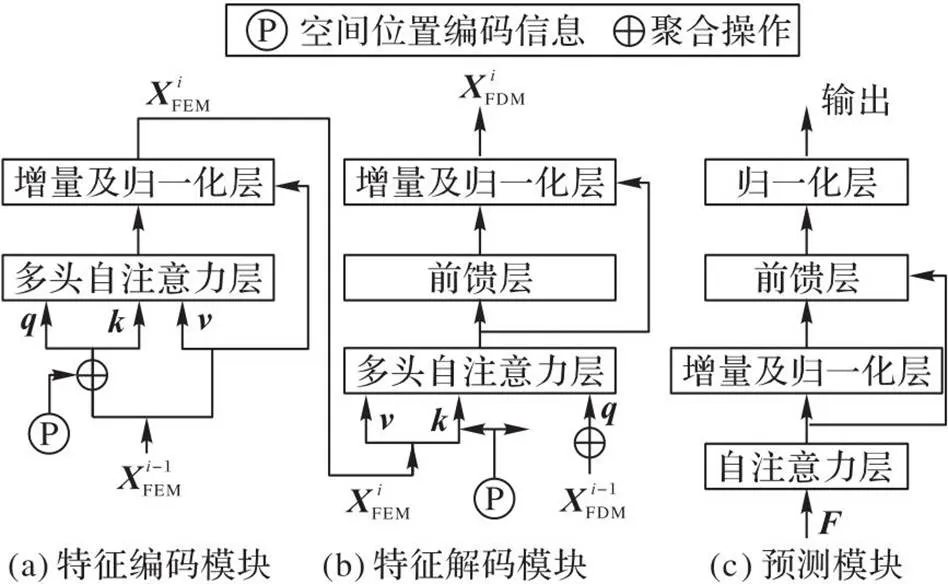

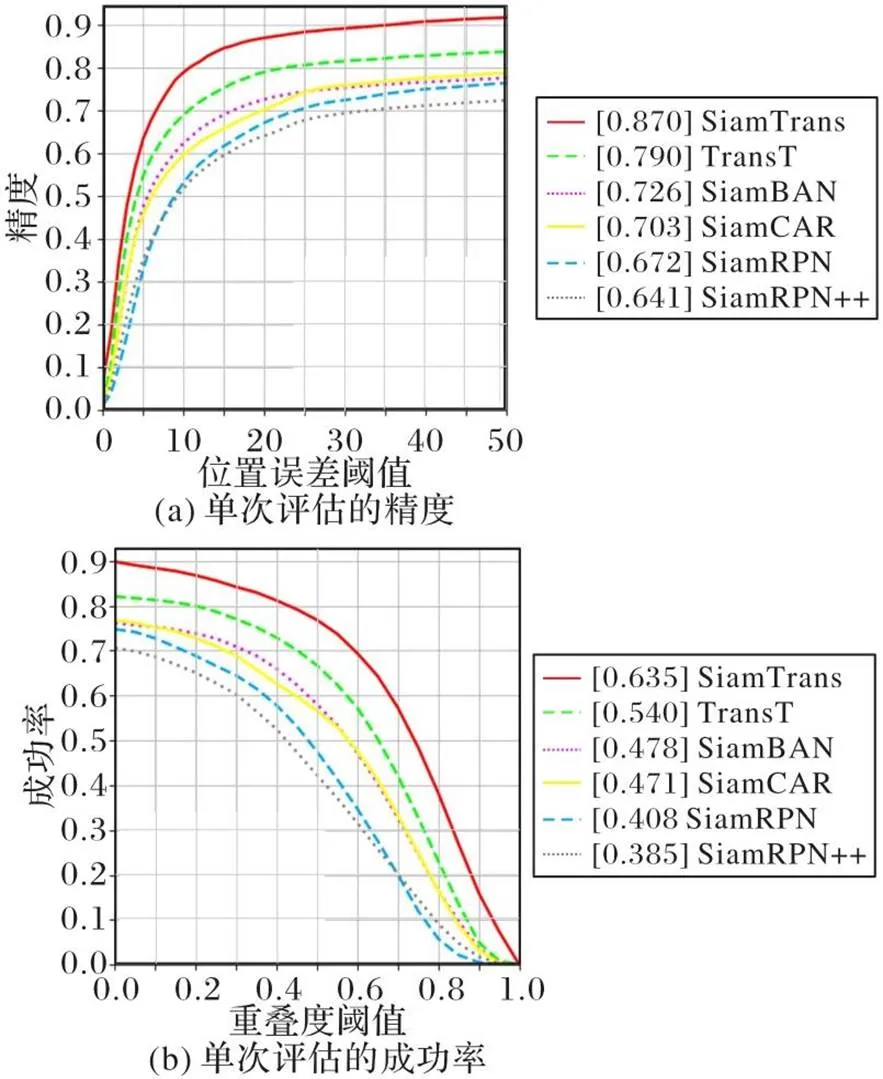

3.1 Small90数据集

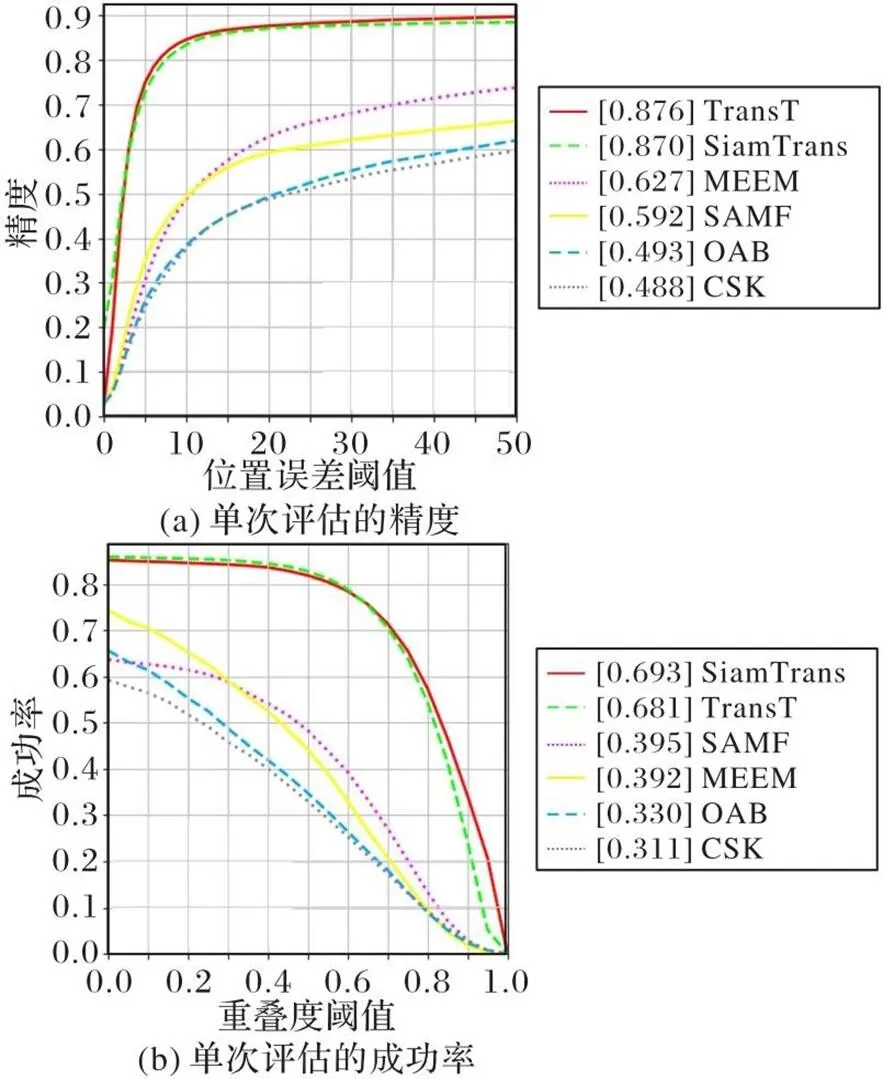

为了评估提出的小目标跟踪算法的性能,Liu等[6]在UAV123[8]等数据集的基础上收集了90个视频序列,提出了Small90数据集。Small90数据集中视频序列包含的目标均为小目标。根据目标运动过程中的特点,这些视频序列包含光照变化、尺度变化、遮挡、形变,运动模糊、快速运动、平面内旋转、平面外旋转、目标消失、背景杂波和低分辨率这11个属性。通过分析跟踪算法在不同属性上的跟踪精度可以准确评估跟踪器针对目标不同运动特点的鲁棒性。图3为本文算法与其他跟踪算法的对比结果。从图3可以看出,本文算法明显优于其他对比算法,其中方括号数值为测试算法的精度和成功率为曲线下面积值(Area Under Curve, AUC)。具体地,SiamTrans算法在跟踪精度和成功率上分别比次优算法TransT(Transformer Tracking)[28]高8.0个百分点和9.5个百分点。表1对比了SiamTrans与SCT(Structuralist Cognitive Tracker)[29]、KCF_AST(Kernelized Correlation Filters_Aggregation Signature Tracker)[6]、MDNet_AST(Multi-Domain Convolutional Neural Networks_Aggregation Signature Tracker)[6]和ECO(Efficient Convolution Operators)[15]在不同视频属性上的表现,SiamTrans仅在遮挡、低分辨率属性上表现略差,在其他属性上表现最优。

图3 不同算法在Small90数据集上的结果

表1不同算法在Small90数据集上不同属性下的跟踪精度以及成功率比较结果

Tab.1 Comparison results of tracking precision and success rate for different algorithms in different attributes on Small90 dataset

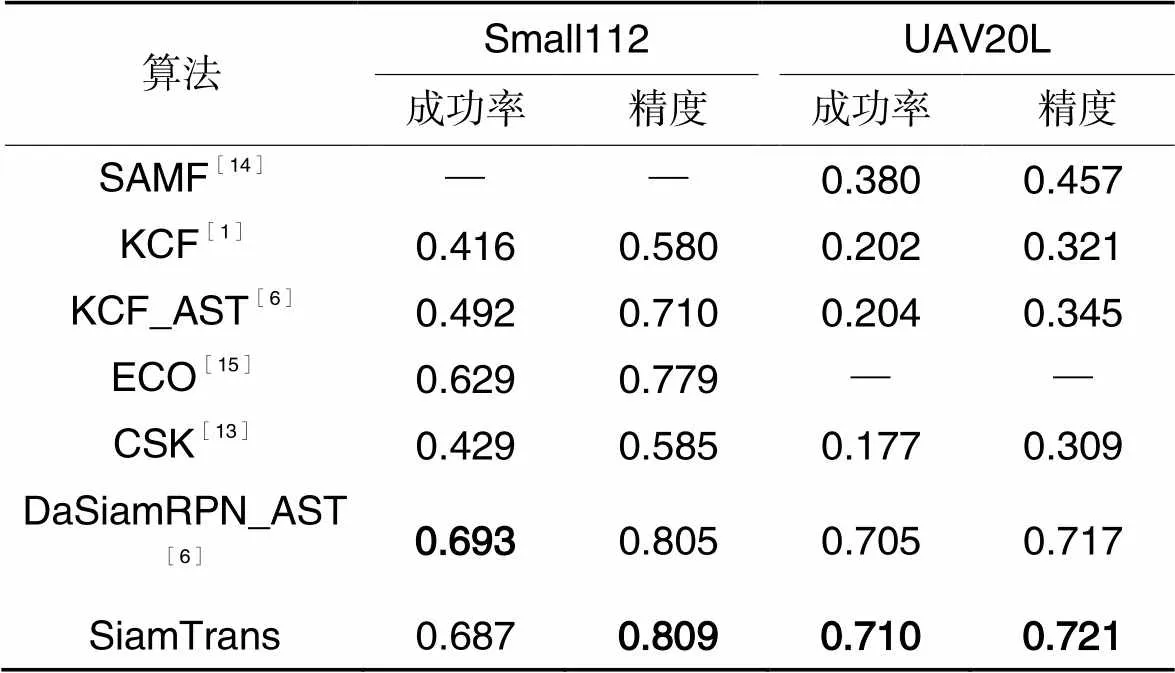

3.2 Small112数据集

与Small90数据集[6]相比,Small112数据集[6]又加入了22个更具有挑战性的视频序列,新增的视频序列对算法的跟踪能力提出了更高的要求。Small112数据集的实验结果如表2所示,SiamTrans与6个跟踪算法作了对比。DaSiamRPN_AST(Distractor-Aware Siamese Networks_Aggregation Signature Tracker)[6]在Small112数据集上的成功率最高,SiamTrans的跟踪精度最优。

3.3 UAV123_10fps数据集

小目标跟踪任务的一个重要应用场景是无人机领域,可以利用无人机对特定目标进行长时跟踪。UAV123_10fps数据集[8]中的123个视频序列由无人机在低空拍摄,因为拍摄角度和高度的特殊性,视频中的目标尺寸更小,跟踪难度更高。比如,远距离拍摄导致目标更加难以判别、拍摄视野中的目标更加容易丢失。图4为跟踪算法在UAV123_10fps数据集上的跟踪结果,分别测试了本文算法与CSK[13]、SAMF[14]、OAB(Online version of the AdaBoost Algorithm)[30]、MEEM(Multiple Experts using Entropy Minimization)[31]和TransT[28]。在跟踪精度上SiamTrans与TransT算法[28]表现相近。在跟踪成功率上,SiamTrans超过次优算法1.2个百分点,表现最优。

图4 不同算法在UAV123_10fps数据集上的结果

3.4 UAV20L数据集

UAV20L数据集[8]对跟踪算法的长时跟踪能力提出了更高的要求,因为数据集中包含的20个视频序列的平均帧数超过1 000,均为长时视频。如果跟踪器没有鲁棒的跟踪能力,就容易在跟踪过程中丢失目标,影响跟踪的成功率和跟踪精度。UAV20L数据集的跟踪结果如表2所示。与DaSiamRPN_AST[6]等6个跟踪算法相比,本文算法在成功率和精度上都表现最优,这也表明SiamTrans具有优秀的长时跟踪能力。

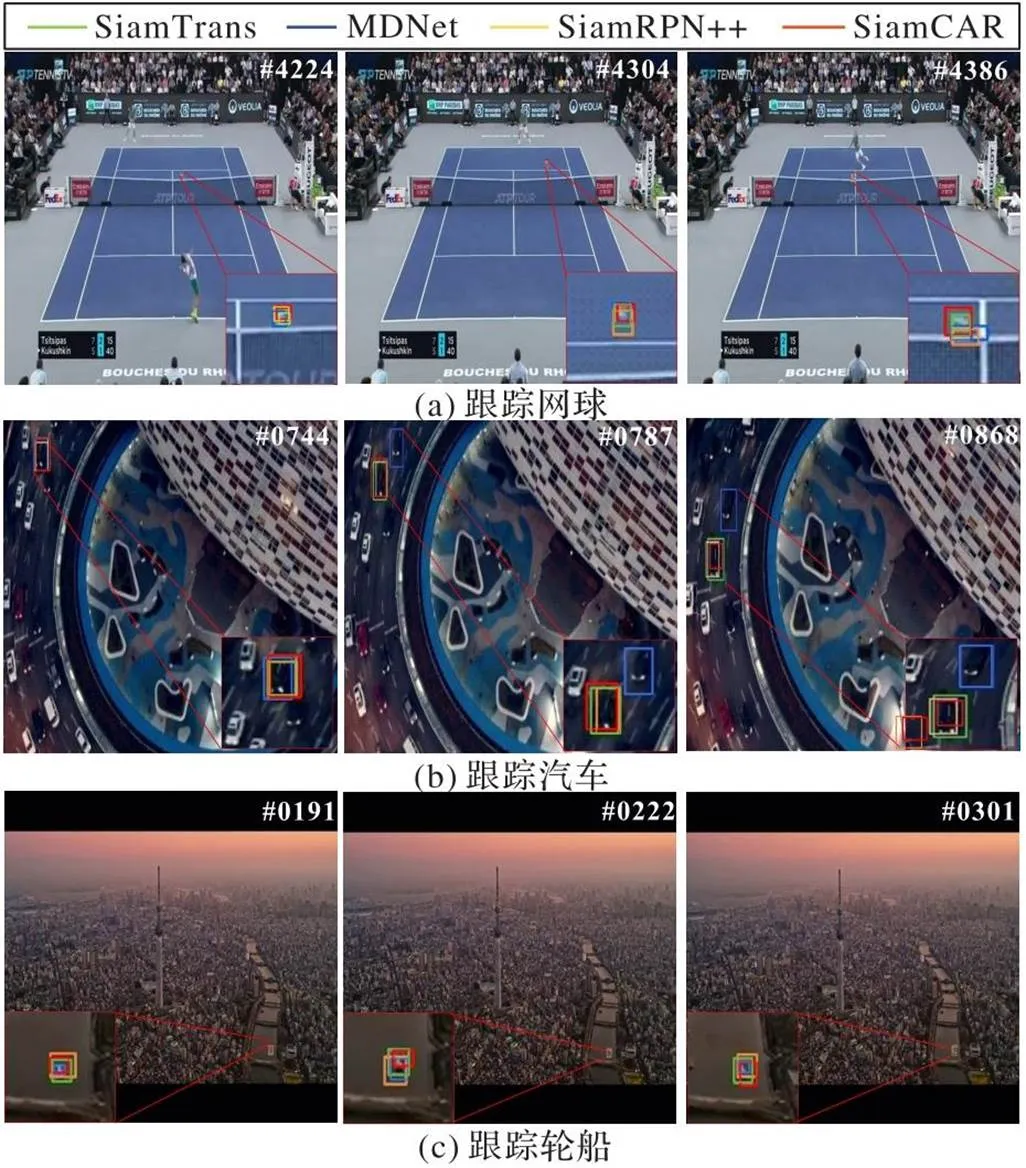

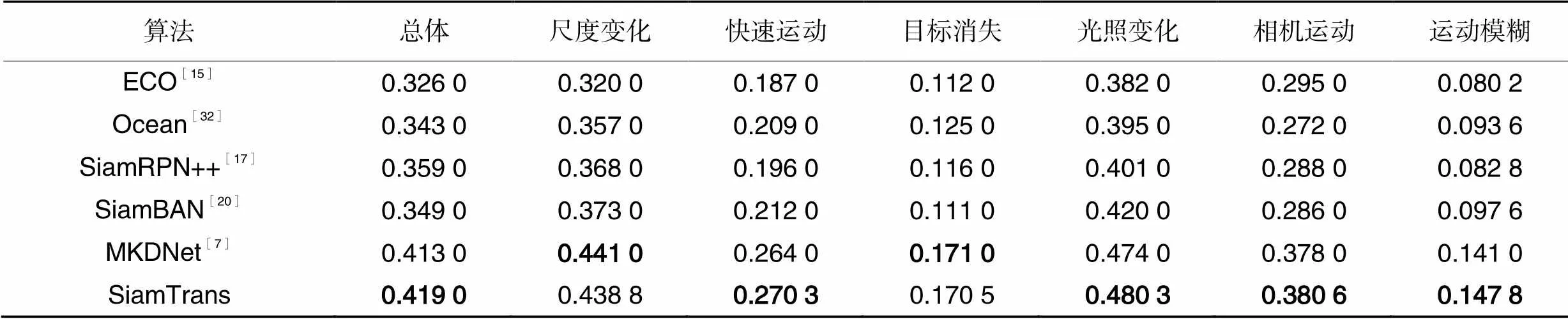

3.5 LaTOT数据集

深度学习有海量数据的支撑,而小目标跟踪任务缺乏大规模训练数据集的支撑。LaTOT数据集[7]在一定程度上解决了这个问题。LaTOT数据集中的数据海量且多样,包含了434个视频序列,超过217 000帧图像,覆盖了48个类别,270个场景。这一大规模数据集的出现在一定程度上弥补了它与常规目标跟踪任务之间的差距。图5是在LaTOT数据集上的可视化结果。本文算法的对比算法包括MDNet算法[32]、SiamRPN++算法[17]和SiamCAR算法[3]。表3是本文算法与其他算法在LaTOT数据集上的对比结果。小目标跟踪算法MKDNet(Multilevel Knowledge Distillation Network)[7]在LaTOT数据集中尺度变化、目标消失两个属性上的成功率优于SiamTrans,在其他属性上SiamTrans表现最优。

表2不同算法在Small112和UAV20L数据集上的跟踪成功率和精度比较结果

Tab.2 Comparison results of tracking success rate and precision for different algorithms on Small112 and UAV20L datasets

图5 SiamTrans算法跟踪结果的可视化结果

表3 不同算法在LaTOT数据集上不同属性下的跟踪成功率

4 消融实验与结果

为了证明相似度响应图计算模块以及预测模块的作用,在本章设计相应的消融实验。

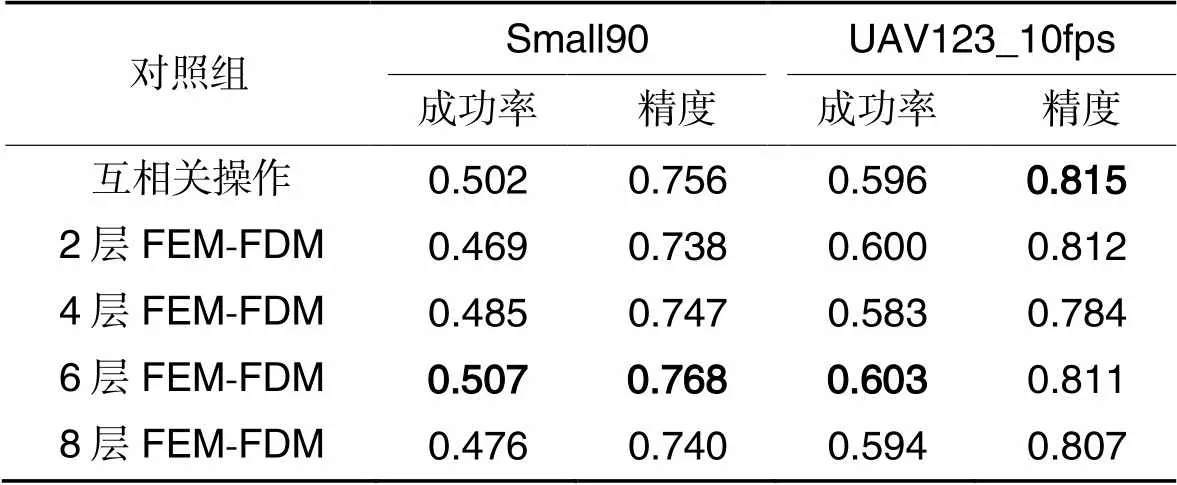

4.1 相似度响应图计算模块

在相似度响应图计算模块中叠加了若干个特征编码模块以及特征解码模块。为了验证模块以及FEM-FDM叠加层数的有效性,在消融实验中验证了只使用互相关操作计算相似度响应图以及叠加不同层FEM-FDM对跟踪器预测精度的影响,结果如表4所示。从表4中可见,与其他层数的FEM-FDM相比,叠加6层FEM-FDM的效果最好。作为经典的相似度响应图计算方法,互相关操作仍然具有一定优势,它在UAV123_10fps数据集[8]上跟踪精度最高,但是在Small90数据集[6]上的跟踪精度和成功率以及UAV123_10fps数据集上的成功率均低于叠加6层编码-解码模块的模型。

表4相似度响应图计算模块的消融实验结果

Tab.4 Ablation experimental results of similarity response map calculation module

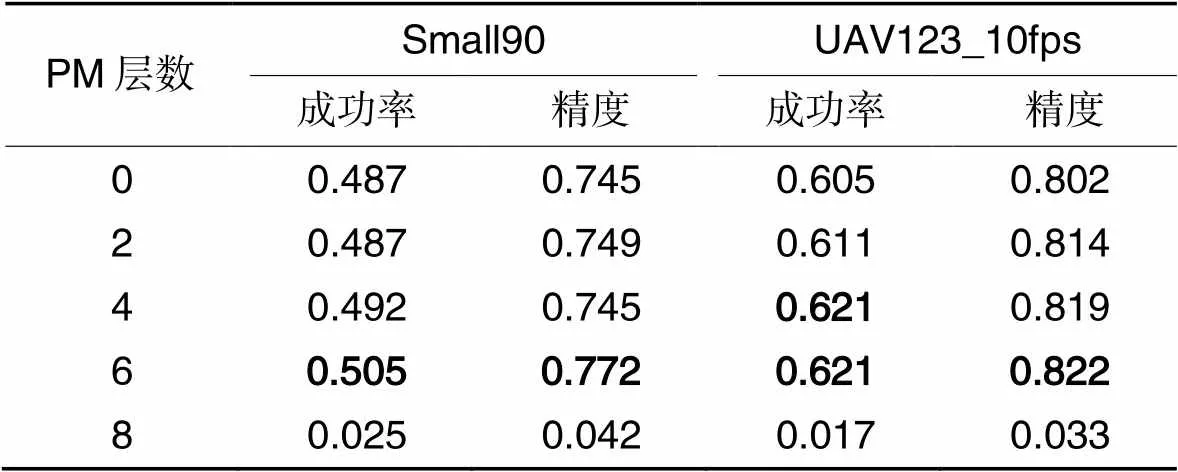

4.2 预测模块

在预测模块的消融实验中,设计仅使用卷积模块的预测分支以及叠加不同层预测模块的预测分支。表5展示了消融实验的结果。从实验结果可以看出,在预测分支中设计6层预测模块时的结果优于仅有卷积结构时模型的结果以及添加其他层数预测模块时模型的表现。

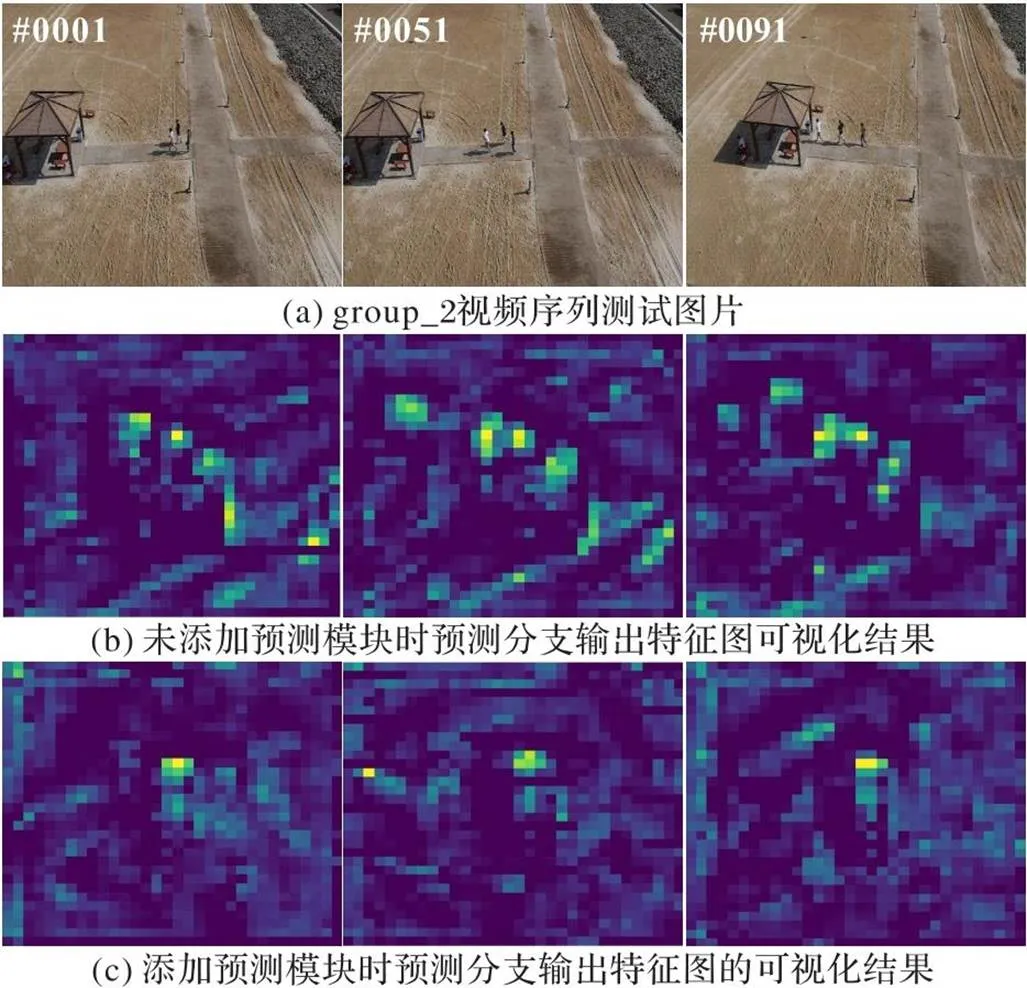

图6为预测分支的特征图的可视化结果。

表5预测模块的消融实验结果

Tab.5 Ablation experiment results of prediction module

图6 预测分支的特征图的可视化结果

图6中选择的视频帧为Small90数据集中group_2视频序列中的第1、51、91帧。从图6可以看出,因为图片中存在多个相似的目标,在未添加预测模块时,特征图中存在多个峰值,不利于预测分支预测目标位置。在添加预测模块后,特征图中的其他峰值得到抑制,目标特征被突出,这有利于跟踪器实现准确的预测。

5 结语

本文将孪生网络和Transformer结合,提出了小目标跟踪算法SiamTrans。在模型中,提出了基于Transformer结构的相似度响应图计算模块以及基于Transformer结构的预测模块,丰富了小目标跟踪任务的解决方案,增强了跟踪小目标的鲁棒性。实验结果表明,相较于其他跟踪算法,SiamTrans算法对小目标的跟踪精度以及准确率均有了明显提升。实验过程中,发现模型在一些特殊场景下仍然会出现丢失目标的问题,这也是将来需要改进的地方。

[1] HENRIQUES J F, CASEIRO R, MARTINS P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 583-596.

[2] LI B, YAN J, WU W, et al. High performance visual tracking with Siamese region proposal network[C]// Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2018: 8971-8980.

[3] GUO D, WANG J, CUI Y, et al. SiamCAR: Siamese fully convolutional classification and regression for visual tracking [C]// Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2020: 6268-6276.

[4] VASWANI A, SHAZEER N, PARMAR N, et al. Attention is all you need [C]// Proceedings of the 31st International Conference on Neural Information Processing Systems. Red Hook, NY: Curran Associates Inc., 2017: 6000-6010.

[5] 王梦亭,杨文忠,武雍智. 基于孪生网络的单目标跟踪算法综述[J]. 计算机应用, 2023, 43(3):661-673.(WANG M T, YANG W Z, WU Y Z. Survey of single target tracking algorithms based on Siamese network [J]. Journal of Computer Applications, 2023, 43(3): 661-673.)

[6] LIU C, DING W, YANG J, et al. Aggregation signature for small object tracking [J]. IEEE Transactions on Image Processing, 2020, 29: 1738-1747.

[7] ZHU Y, LI C, LIU Y, et al. Tiny object tracking: a large-scale dataset and a baseline[EB/OL]. (2022-02-11)[2022-09-16].https://arxiv.org/pdf/2202.05659.pdf.

[8] MUELLER M, SMITH N, GHANEM B. A benchmark and simulator for UAV tracking [C]// Proceedings of the 2016 European Conference on Computer Vision, LNCS 9905. Cham: Springer, 2016: 445-461.

[9] 朱文球,邹广,曾志高. 融合层次特征和混合注意力的目标跟踪算法[J]. 计算机应用, 2022, 42(3): 833-843.(ZHU W Q, ZOU G, ZENG Z G. Object tracking algorithm with hierarchical features and hybrid attention[J]. Journal of Computer Applications, 2022, 42(3): 833-843.)

[10] AHMADI K, SALARI E. Small dim object tracking using frequency and spatial domain information[J]. Pattern Recognition, 2016, 58: 227-234.

[11] AHMADI K, SALARI E. Small dim object tracking using a multi objective particle swarm optimisation technique[J]. IET Image Processing, 2015, 9(9): 820-826.

[12] MARVASTI-ZADEH S M, KHAGHANI J, CHANEI-YAKHDAN H, et al. COMET: context-aware IoU-guided network for small object tracking [C]// Proceedings of the 2020 Asian Conference on Computer Vision, LNCS 12623. Cham: Springer, 2021: 594-611.

[13] HENRIQUES J F, CASEIRO R, MARTINS P, et al. Exploiting the circulant structure of tracking-by-detection with kernels[C]// Proceedings of the 2012 European Conference on Computer Vision, LNCS 7575. Berlin: Springer, 2012: 702-715.

[14] LI Y, ZHU J. A scale adaptive kernel correlation filter tracker with feature integration[C]// Proceedings of the 2014 European Conference on Computer Vision, LNCS 8926. Cham: Springer, 2015: 254-265.

[15] DANELLJAN M, BHAT G, SHAHBAZ KHAN F, et al. ECO: efficient convolution operators for tracking [C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2017: 6931-6939.

[16] BERTINETTO L, VALMADRE J, HENRIQUES J F, et al. Fully-convolutional Siamese networks for object tracking[C]// Proceedings of the 2016 European Conference on Computer Vision, LNCS 9914. Cham: Springer, 2016: 850-865.

[17] LI B, WU W, WANG Q, et al. SiamRPN++: evolution of Siamese visual tracking with very deep networks [C]// Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2019: 4282-4291.

[18] ZHU Z, WANG Q, LI B, et al. Distractor-aware Siamese networks for visual object tracking[C]// Proceedings of the 2018 European Conference on Computer Vision, LNCS 11213. Cham: Springer, 2018: 103-119.

[19] WANG Q, ZHANG L, BERTINETTO L, et al. Fast online object tracking and segmentation: a unifying approach [C]// Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2019: 1328-1338.

[20] CHEN Z, ZHONG B, LI G, et al. Siamese box adaptive network for visual tracking[C]// Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2020: 6667-6676.

[21] YAN B, PENG H, FU J, et al. Learning spatio-temporal Transformer for visual tracking [C]// Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Piscataway: IEEE, 2021: 10428-10437.

[22] WANG N, ZHOU W, WANG J, et al. Transformer meets tracker: exploiting temporal context for robust visual tracking [C]// Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2021: 1571-1580.

[23] BLATTER P, KANAKIS M, DANELLJAN M, et al. Efficient visual tracking with Exemplar Transformers [C]// Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2023: 1571-1581.

[24] HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition [C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016: 770-778.

[25] LIN T Y, MAIRE M, BELONGIE S, et al. Microsoft COCO: common objects in context [C]// Proceedings of the 2014 European Conference on Computer Vision, LNCS 8693. Cham: Springer, 2014: 740-755.

[26] RUSSAKOVSKY O, DENG J, SU H, et al. ImageNet large scale visual recognition challenge [J]. International Journal of Computer Vision, 2015, 115(3): 211-252.

[27] HUANG L, ZHAO X, HUANG K. GOT-10k: a large high-diversity benchmark for generic object tracking in the wild[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2021, 43(5): 1562-1577.

[28] CHEN X,YAN B,ZHU J,et al. Transformer tracking[C]//Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway:IEEE,2021:8122-8131.

[29] CHOI J, CHANG H J, JEONG J, et al. Visual tracking using attention-modulated disintegration and integration[C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016: 4321-4330.

[29] NAM H, HAN B. Learning multi-domain convolutional neural networks for visual tracking [C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016: 4293-4302.

[30] GRABNER H, GRABNER M, BISCHOF H. Real-time tracking via on-line boosting [EB/OL]. [2022-11-20]. https://citeseerx.ist.psu.edu/viewdoc/download;jsessionid=0653CED71417C5E6632E7117161E2201?doi=10.1.1.91.8743&rep=rep1&type=pdf.

[31] ZHANG J, MA S, SCLAROFF S. MEEM: robust tracking via multiple experts using entropy minimization [C]// Proceedings of the 2014 European Conference on Computer Vision,LNCS 8694. Cham:Springer, 2014:188-203.

[32] ZHANG Z, PENG H, FU J, et al. Ocean: object-aware anchor-free tracking [C]// Proceedings of the 2020 European Conference on Computer Vision, LNCS 12366. Cham: Springer, 2020: 771-787.

[33] CHEN X, YAN B, ZHU J, et al. Transformer tracking[C]// Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2021: 8122-8131.

SiamTrans: tiny object tracking algorithm based on Siamese network and Transformer

GONG Haitao1, CHEN Zhihua1*, SHENG Bin2, ZHU Bingyan1

(1,,200237,;2,,200240,)

Aiming at the problems of poor robustness, low precision and success rate in the existing tiny object tracking algorithms, a tiny object tracking algorithm, SiamTrans, was proposed on the basis of Siamese network and Transformer. Firstly, a similarity response map calculation module was designed based on the Transformer mechanism. In the module, several layers of feature encoding-decoding structures were superimposed, and multi-head self-attention and multi-head cross-attention mechanisms were used to query template feature map information in feature maps of different levels of search regions, which avoided falling into local optimal solutions and obtained a high-quality similarity response map. Secondly, a Prediction Module (PM) based on Transformer mechanism was designed in the prediction subnetwork, and the self-attention mechanism was used to process redundant feature information in the prediction branch feature maps to improve the prediction precisions of different prediction branches. Experimental results on Small90 dataset show that, compared to the TransT (Transformer Tracking) algorithm, the tracking precision and tracking success rate of the proposed algorithm are 8.0 and 9.5 percentage points higher, respectively. It can be seen that the proposed algorithm has better tracking performance for tiny objects.

object tracking; tiny object; Siamese network; attention mechanism; Transformer

This work is partially supported by Fund Project of National Key Laboratory of Space Intelligent Control (HTKJ2022KL502010).

GONG Haitao, born in 1998, M. S. candidate. His research interests include computer vision, deep learning.

CHEN Zhihua, born in 1969, Ph. D., professor. His research interests include computer vision, machine learning.

SHENG Bin, born in 1981, Ph. D., professor. His research interests include virtual reality, computer graphics.

ZHU Bingyan, born in 1998, M. S. candidate. Her research interests include computer vision, deep learning.

TP391.4

A

1001-9081(2023)12-3733-07

10.11772/j.issn.1001-9081.2022111790

2022⁃12⁃06;

2023⁃02⁃23;

2023⁃02⁃27。

空间智能控制技术全国重点实验室开放基金课题(HTKJ2022KL502010)。

公海涛(1998—),男,山东临沂人,硕士研究生,主要研究方向:计算机视觉、深度学习;陈志华(1969—),男,江西上饶人,教授,博士,CCF杰出会员,主要研究方向:计算机视觉、机器学习;盛斌(1981—),男,湖北武汉人,教授,博士,CCF会员,主要研究方向:虚拟现实、计算机图形学;祝冰艳(1998—),女,安徽六安人,硕士研究生,主要研究方向:计算机视觉、深度学习。