基于CGAN算法的服装款式交互设计

沈晓琪,陈 郁

(上海工程技术大学 纺织服装学院, 上海 201620)

款式的多样化和个性化是服装时尚的重要发展方向,私人定制在其中起到重要的作用。私人定制时服装尺寸的确定较为容易,而款式的确定却较为复杂,因为描述款式的语言难以做到准确充分,因而从成千上万的图库中选择出客户中意的款式是一个复杂耗时的工程。

传统的定制方式主要采用客户提供样品或与设计师面谈交流的方式,但这种方式存在客户描述不尽准确以及设计师提供初步样本范围有限的问题,因而传统的定制方式较为耗时,工作效率相对较低。利用信息技术的交互式设计能够缩短双方交流时间,并为设计师和顾客提供更多的款式选择,显著提高定制过程的效率。目前采用的交互式设计主要有交互遗传算法、图像生成算法等。

交互式遗传算法Interactive Genetic Algorithm(IGA)模拟了生物演化的自然规律,常应用于解决隐式性能指标优化问题的智能计算。陈奕帆等[1]以西服为例,使用遗传算法得到符合用户期望的服装设计图,提高了西服个性化定制的工作效率。周海媚[2]使用遗传算法建立了交互设计系统,采用三维服装软件展现设计效果,并完成了服装纸样的输出。IGA算法通过编码的方式描述需要解决的问题,但编码的长度以及规范性都会对结果产生影响,如张卓等[3]通过引入交互式遗传算法建立款式推荐系统,但由于编码长度的限制,这种算法只适用于样本较少的方案设计。

生成对抗网络Generative Adversarial Networks(GAN)是一种重要的图像生成技术并得到了广泛的研究。Yoo等[4]在生成的模型中增加转换器和再鉴别模型,从而增加域鉴别器,实现了提取人体着装图中的服装款式图。Makkapati等[5]引入了对称损失函数训练GAN,生成了对称性更好衬衫图像,也减少了其前中位置变形的问题。Lassner等[6]基于GAN方法开发了人体的服装着装模型,这种模型能够在人体上实现服装生成的虚拟试衣效果,但对服装细节的处理仍不够完善。为解决这一问题,Han等[7]提出了虚拟试衣的网络模型,该模型能够用粗略的服装廓形图生成细致的服装图片。GAN方法也被用于服装款式图的交互式设计,任雨佳等[8]通过训练深度卷积的生成对抗网络Deep Convolutional Generative Adversarial Networks(DCGAN)生成稳定的服装款式图,但对于用户偏好选择款式时需要多次迭代,效率偏低。

在已有的GAN的基础上,对生成器加入标签,通过训练可获得有特征指向性的图片,这一图像生成处理技术被称为条件生成对抗网络Conditional Generative Adversarial Nets(CGAN)。这种深度学习算法也被用于服装的款式图设计,成为了一种服装款式交互设计的新方法。

本文以单色连衣裙款式图为例,介绍CGAN算法在服装款式图交互设计上的应用,通过卷积神经网络(CNN)提取用户样裙款式特征,再基于款式特征利用CGAN网络生成相近的款式图,经用户筛选后进一步迭代,通过多次迭代获得用户高满意度的款式图。相较于已有的交互式服装款式设计方法,这一方法具有用户指向性好、迭代次数少的优势。

1 系统框架

CGAN是一种生成对抗网络[9],与传统的GAN不同,其不仅输入了随机噪声作为生成器的输入,还输入了指定条件作为生成器的输入,同时判别器不仅能判断生成样本是否真实,还能判断其是否符合指定的条件。这种对抗机制使得CGAN可以生成符合特定条件的样本。

本文构建了以CGAN网络为核心的服装款式图设计交互系统,该系统能分析出用户提供款式样图的关键词,将关键词作为指定条件生成与样图相似的款式图,如图1所示。

图1 服装款式图交互设计框架Fig.1 Interactive design framework of clothing style diagram

由图1可见,系统包括关键词库、CNN关键词提取、CGAN图像生成、用户评估反馈4个模块。关键词库通过对单色连衣裙分结构和分档的调查投票确定;CNN关键词提取模块能自动提取出用户提供的款式图中的关键词;CGAN图像生成模块根据提供的关键词生成清晰稳定的单色连衣裙款式图并交给用户交流选择,用户满意的款式图将被收入训练库中进行迭代训练,如此循环直至用户满意。

2 实验部分

本文以单色连衣裙作为研究对象,重点关注单色连衣裙的款式图,忽略色彩、面料、纹理等带来的影响,下文统称为“单色裙”。

2.1 关键词设计

首先从购物平台及近年来的专家访谈中提取出连衣裙设计的主要服装分结构[10],忽略其中的品牌、色彩、图案等因素,初步选取廓形、袖长、裙长、领型、合体度5种与款式图设计相关的主要服装分结构,通过调查问卷进一步确定款式的分结构和分档如表1所示。

表1 单色连衣裙分结构及分档Tab.1 Substructure and classification of monochrome dress

表1中单色裙款式分结构确定为廓形、袖长、裙长和合体度4种,领型因在黑白单色裙的图片中不明显而被去除。单色裙款式廓形分为A、H、X型3档,在问卷中都获得50%以上的认可度。A、H、X型分别代表与裙形近似的字母,即A型上窄下宽、H型上下相当和X型收腰的特点。

2.2 关键词提取

LeNet-5是一种结构简单且鲁棒性好的CNN网络架构,在处理小尺寸的灰度图像时,具有较高的识别准确度和识别效率。本文选择LeNet-5网络作为从单色裙图片自动提取关键词标签的工具。图2示出了3条由客户提供的单色裙样图。

图2 客户提供的单色裙Fig.2 Customer offered monochrome dress.(a)Slip dress;(b)Bubble sleeved princess skirt;(c)Straight skirt

采用训练后的LeNet-5网络提取图2中3款单色裙的关键词,图2(a)吊带裙被归类到了X廓形的无袖合体短裙中,其中合体、无袖和短裙与其在购物网站上紧身、吊带和短裙的标签相符,廓形标签并未在该购物网站上出现,但该裙在腰部有收紧,可以划为X廓形;图2(b)泡泡袖公主裙被归类到了A廓形的短袖宽松短裙中,符合该裙的属性;图2(c)直筒裙被归类到了H廓形的短袖宽松长裙中,其中宽松、短袖、长裙与其在购物网站上的标签一致,宽松也符合该裙属性。

2.3 模型训练

本文实验的模型训练主要过程为加载数据集、构建Generator网络和Discriminator网络,然后构建CGAN网络、设置损失函数并调整优化,同时调试其他参数、对比不同参数下生成的图片效果,最后选择效果最优的一组参数,达到优化程序的目的。利用此模型可按不同输入条件生成不同的单色裙款式图。

本文实验的操作系统为Windows10,64位,以Tensorflow1.14为框架,编程语言使用python3.5。用于网络训练的数据集来自于文献[8]中构建的单色裙图库,所有图片大小为96像素×96像素图像,格式为JPG。如图3所示。

图3 单色裙款式样本库Fig.3 Monochrome dress flat sample library

从图库中选取6 000张图片,部分用于训练,部分用于测试,全部的卷积运算都在显卡 NVIDIA GeForce RTX 2060 SUPER下进行。参数配置方面,生成器和判别器均使用LeakyReLU激活函数。为了防止过拟合的发生,生成器以及判别器中均使用批归一化处理(BN)进行优化。损失函数方面,利用Adam优化器优化生成器和判别器所使用的交叉熵损失函数。经过对比生成器以及判别器的多轮训练结果,最终设置学习率为0.000 2,设置生成器与判别器训练次数比为2∶1,即每训练1次判别网络就训练2次生成网络,训练周期设置为100 epochs。上述参数能够使CGAN模型生成较为完整的单色裙款式图,以X型为例,根据不同条件组合生成的款式图效果如图4树状结构图所示。

图4 根据不同条件组合生成的款式图Fig.4 Style map generated according to different conditions

使用CGAN生成的图片基本符合设定的生成条件,但部分长度方面的条件控制仍然不够精确,生成的部分裙子短袖与长袖的区分度不明显,例如生成的“短袖-长裙-合体”的前2张图片的袖长较长,其次仍有部分图片生成细节不够完善,部分图片有小空洞和扭曲。

3 结果与分析

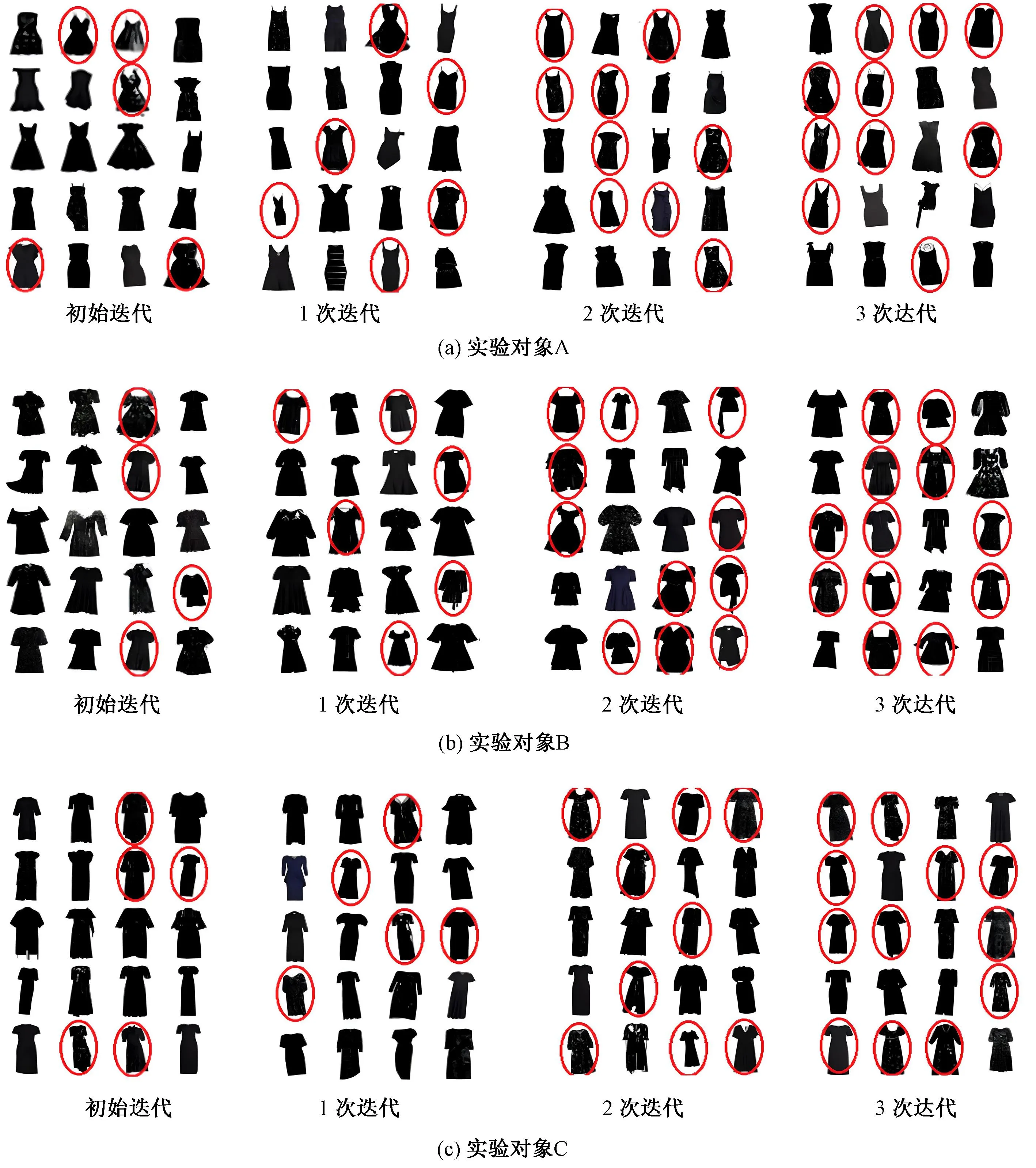

邀请3名年龄在22~26岁的女大学生对本文设计的交互系统进行测试,3名实验对象分别提供自己喜欢的单色裙照片,记为实验对象A、B、C。系统使用CNN模块自动提取分类标签后使用CGAN网络生成对应的单色裙款式图集,在剔除少部分畸变、扭曲以及残缺的款式图后,取200张款式图,以9张1组的方式供测试者选择,实验对象的选择结果(圈出的款式图)分别如图5所示。

图5 实验对象A、B、C每轮筛选的结果(部分)Fig.5 The results of each round of screening for subjects A, B and C (partial). (a) Subject of experiment A; (b) Subject of experiment B; (c) Subject of experiment C

由图5(a)可见,初始迭代中有较多的裙子被选中,且被选中的裙子都符合X廓形、无袖、合体短裙的特点,说明交互系统根据条件生成的单色裙符合测试者的需求。将实验对象A选中的图片打上分类标签放入CGAN训练集中,并对CGAN进行迭代训练,训练完成的CGAN网络命名为CGAN-A,其余2名实验对象迭代训练完成的网络依次命名为CGAN-B和CGAN-C。表2示出了3名实验对象在不同轮次选中裙子的数量和比例。

表2 实验对象每轮正向选择的款式图数量及百分比Tab.2 Number and percentage of style maps selected by subjects in each round

由表2可知,随迭代次数增加,实验对象A正向选择的款式图数量由18.5%提高到了27.5%;实验对象B正向选择的款式图数量由19.5%提高到了31.5%;实验对象C正向选择的款式图数量由21.5%提高到了33.0%。将本文每轮迭代的平均选中率与基于文献[8]的DCGAN方法进行对比,结果如图6所示。

图6 基于CGAN与基于DCGAN服装交互设计平均选中率的比较Fig.6 Comparison of average selection rate of CGAN based and DCGAN based clothing interactive design

由图6可知,CGAN初始迭代就具有较高的选中率,且随着迭代次数的增加,选中率逐步提高,总体选中率比DCGAN方法高约10%。这是因为本文使用CNN方法提取了测试者提供样图的款式关键词,根据关键词有针对性地生成了单色裙,因此选中率较DCGAN有较大提升。DCGAN方法需要测试者提供较大量的喜好图片用于训练,而CGAN方法只需测试者提供少量乃至1~2张样图即可生成单色裙款式图。除了用户提供单色裙样图外,本文方法能直接以不同属性的标签生成单色裙款式图,增加了用户使用的灵活性。

4 结束语

为了提升服装个性化设计中用户的参与度,本文以条件生成对抗网络为核心构建了服装款式交互式设计系统,采用问卷调查法确定了服装款式的各分结构和分档关键词,通过卷积神经网络提取用户提供样图中的款式关键词,由条件对抗网络(CGAN)根据关键词生成款式图,实现了基于用户偏好的服装款式图交互设计,并通过单色裙加以验证。结果表明该系统能够快速准确地生成与样图相似的款式图,并可以通过迭代训练来提高用户对服装款式图的满意度。未来将继续完善款式图的局部细节生成,如领型、袖口等,并可拓展应用于生成其他类型的服装款式,提升用户参与度与满意度的同时优化个性化服装定制服务,实现消费者追求个性、展示自我的需求,助力服装行业的繁荣发展。