基于大数据技术的数据中心建设路径研究

邓汝和

(广东长高通信服务有限公司,广东清远 511500)

0 引言

随着互联网等新一代信息技术的快速发展,全球各行各业产生了海量的数据,这些数据包含着宝贵的信息和价值,但如何高效的管理和分析这些数据成为一个挑战。大数据技术的出现和发展为有效处理这些海量数据提供了新的解决方案。数据中心作为大数据技术的重要载体,承担着数据存储、处理、分析和交换的重要任务,成为信息社会中不可或缺的基础设施。

1 数据中心建设目标

1.1 统一数据源及数据口径

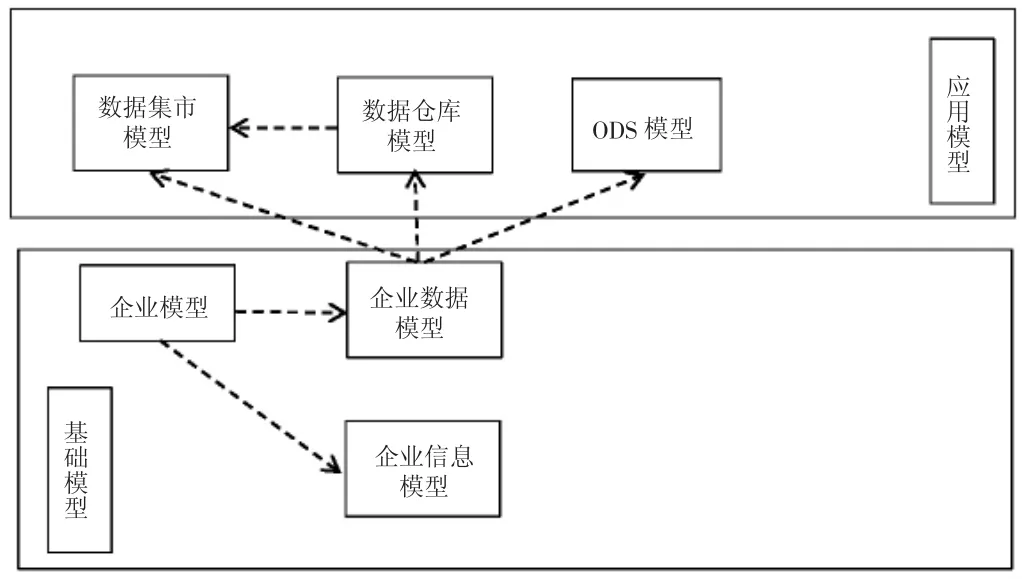

数据中心目标的实现有助于提高数据管理的效率和质量,统一数据源及数据口径可以确保不同部门或系统使用的数据是一致的,这有助于避免数据之间的矛盾或不一致,提升数据的可信度和可靠性。其中,统一数据源能够减少数据的重复存储和冗余,优化数据存储结构,节约存储资源,并简化数据管理和维护流程。统一数据口径则意味着数据的格式、标准和定义统一规范,这有助于提高数据分析的效率[1]。分析人员无须花费过多时间在数据解释和清洗上,可以更专注于数据分析和挖掘价值。统一数据源和口径有助于不同业务系统间的数据交互和集成,这样可以更顺畅地实现业务流程的整合和协同,提高企业整体运作效率。同时也提供了更加可靠和一致的数据基础,有利于企业管理层进行准确、可靠的决策制定,从而推动企业发展。因此通过统一数据源及数据口径,数据中心可以更好地满足不同部门和业务需求,提高数据的管理和应用效率,为企业的发展提供更可靠的数据支持,统一数据模型如图1 所示。

图1 统一数据模型

1.2 一致的数据出入口

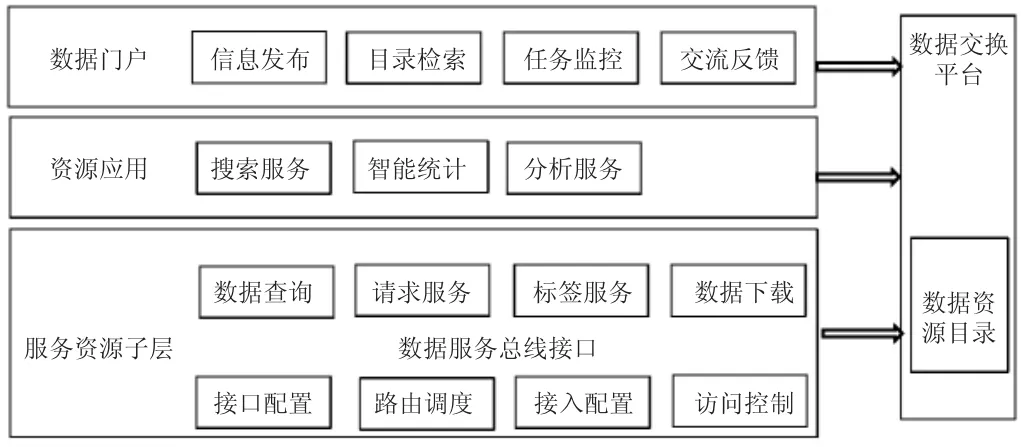

实现一致的数据出入口意味着在数据中心内部,所有数据的进出流程是经过统一规范和管理的,这一目标的实现对于数据中心的运作和数据管理具有重要的意义。数据出入口流程如图2 所示。

图2 数据出入口流程

一致的数据出入口要求数据流程按照统一的规范进行,包括数据的采集、传输、存储、处理和交换等各个环节,这有助于确保数据的质量和完整性,减少数据在传输和处理过程中的错误和丢失。还可以加强数据的安全性管理,通过统一的出入口,可以实现对数据进行严格的访问控制和权限管理,确保只有授权人员能够访问和操作数据,从而防止数据的泄露和滥用。一致的数据出入口有助于优化数据管理流程,通过规范数据的输入和输出,可以降低数据管理的复杂性和难度,提高数据管理的效率和准确性。这种一致性也为数据的整合和共享提供了基础,不同部门或系统之间的数据可以通过统一的出入口进行交互和共享,实现数据的一致性和集成,促进企业内部各个部门之间的协同工作。通过规范数据的出入流程,可以减少数据的清洗和整理工作,使数据分析师能够更快地获得可靠的数据,从而提高数据分析的准确性和效率。

1.3 构建管控中心

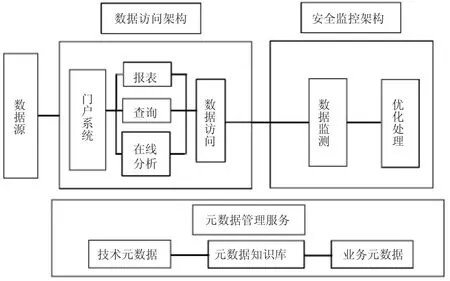

管控中心应能够实时监控数据中心内部的各项运行指标,可以及时发现并解决潜在的问题,确保数据中心的稳定运行。管控中心负责对数据中心的资源进行合理的分配和优化,通过监测各个服务器、存储设备和网络设备的利用率,可以根据需求进行资源的动态调整,确保资源的高效利用和避免资源的浪费。管控中心应具备故障诊断和应急响应的能力,一旦发生故障或异常情况,管控中心应能够迅速定位问题并采取相应的应急措施,以最小化对数据中心运行的影响。管控中心负责数据中心的安全监控工作,包括对入侵、攻击和数据泄露等安全事件的监测和响应,通过建立完善的安全体系,可以保障数据中心的信息安全。管控中心应通过监测和分析数据中心的性能指标,提出性能优化的建议,这包括提高数据处理速度、降低延迟、优化网络带宽等方面,以确保数据中心的高效运行,管控中心的执行架构如图3 所示

图3 管控中心的执行架构

管控中心需要负责确保数据中心的运作符合相关法规和标准,这包括数据隐私法规、安全标准等,保障数据中心的合规性,防范法律风险。通过建立强大的管控中心,数据中心能够更加灵活、高效地应对各种挑战,确保数据中心的稳定、安全和可靠运行。

2 大数据技术下数据中心的具体建设

2.1 集成异构数据

在建设路径的初期阶段进行充分的需求分析是关键,了解业务部门和用户的需求,确定需要集成的异构数据类型和来源,明确数据中心的整体目标。确定数据中心需要集成的异构数据源,包括数据库、文件系统、日志文件等,建立标准的数据接入接口,确保能够顺利地接入各种不同类型的数据源。针对不同的数据源进行数据格式的标准化工作,主要包括统一数据的字段命名、数据单位、时间格式等,以确保数据在集成过程中能够保持一致性和可比性[2]。进行数据清洗和转换操作,解决异构数据之间的差异,确保数据质量。这可能涉及缺失值的处理、异常值的处理、数据格式的转换等工作。建立元数据管理系统,记录和维护各种异构数据的元数据信息,包括数据源、数据格式、数据所有权等,元数据管理有助于数据的可理解性和可维护性。部署数据集成平台,通过该平台实现对异构数据的集成,例如,可以采用ETL 工具,也可以选择其他适合的数据集成解决方案,确保数据集成的过程能够高效、稳定地进行。异构数据集成涉及多个数据源,因此需要严格的数据安全措施和权限控制机制,确保只有授权人员能够访问敏感数据,防止数据泄露和滥用。针对需要实时处理的异构数据,考虑引入实时集成和流处理技术,可以通过使用流处理平台或类似的技术来实现,确保数据的实时性和及时性。对数据集成的过程进行性能优化,包括优化数据传输速度、降低延迟等,确保在大数据环境下,异构数据的集成能够高效运行,实现系统的稳定性和可靠性。

2.2 采用追溯法进行数据疏理

在建设数据中心时,可以采用追溯法进行数据疏理,追溯法是一种从末端数据逐步追溯到源头数据的数据分析方法,其主要目的是通过对数据流向、转换和处理过程的追溯,了解数据的来源、流向和转换规则,从而实现数据的疏理和清晰化。首先明确数据中心的建设需求和数据范围,确定需要疏理的数据类型和数据来源。从数据中心的末端数据开始,即最终被使用的数据,追溯其来源和处理过程,这些末端数据可能是报表、分析结果、业务应用数据等。逐步追溯末端数据的流向,了解数据是如何从源头到达末端的,包括数据经过的系统、应用、处理流程等。在追溯过程中识别数据经历的转换规则和处理过程,这可能涉及数据清洗、加工、整合等过程。记录并整理追溯过程中得到的数据元数据,包括数据的来源、流向、转换规则、格式等信息。根据追溯的结果疏理和整理数据的流程,建立数据流程图或数据地图,清晰展示数据的流向和处理过程。在追溯的过程中评估数据的质量,发现数据质量问题并提出改进建议。根据追溯结果制定数据管理策略和规范,包括数据采集、存储、处理、共享等方面的管理规定。

2.3 建立概念模型,开展数据整合

概念模型是对业务领域中数据和信息关系的抽象表示,它有助于理清业务流程、数据关系和数据元素之间的联系,为数据整合提供指导。利用业务建模工具或方法,绘制业务流程图、数据流程图等,理清业务过程和数据流动,这有助于识别业务实体、业务规则和业务事件[3]。通过分析业务流程,标识出业务领域中的实体和实体之间的关系,实体可以是业务对象、概念或事件,而关系则表示实体之间的联系。为每个实体定义属性,即实体所包含的数据项。这有助于明确数据的内容和特征。基于上述分析,绘制概念模型图,其中包括实体、关系和属性,这可以采用实体关系图(ER 图)或其他概念建模工具,概念逻辑模型如图4 所示。

图4 概念逻辑模型

建立数据字典详细记录概念模型中每个实体和属性的定义,以及它们之间的关系,数据字典是整合数据的参考工具,确保数据的一致性和标准化。在概念模型的基础上,确定数据整合的策略和方法,这可能涉及数据的抽取、转换和加载(ETL),数据集成平台的选择,以及数据标准化和清洗等步骤。根据概念模型和整合策略,开始实施数据整合工作,包括数据的抽取、清洗、转换和加载,确保数据能够按照概念模型的定义进行整合[4]。

2.4 数据建设

数据建设涉及数据的采集、存储、处理、分析和应用等方面,旨在建立一个高效、可靠、可管理的数据基础设施,以支持业务需求和决策。设计数据存储架构,包括选择合适的数据库技术、存储设备和数据备份策略,考虑数据的结构化和非结构化存储需求,并确保存储方案能够支持业务的快速发展。实施数据集成,确保不同系统之间的数据能够无缝流通,使用合适的集成工具和标准接口,确保数据的一致性和完整性。制定数据质量管理策略,包括数据清洗、去重、验证等步骤,确保数据质量符合业务需求,提高决策的准确性和可信度[5]元数据是描述数据的信息,建立元数据管理体系有助于理解数据的含义、来源和关系,确保元数据的准确性和及时更新。利用数据分析和挖掘技术,发掘数据中的潜在信息和模式,建立数据分析模型,支持业务决策和优化业务流程。数据建设流程如图5 所示。

图5 数据建设流程

3 结语

综上所述,在大数据技术下,建设数据中心能够提升数据的处理和分析能力,更好的满足日益增长的数据需求。在进行数据中心建设的时候,主要是从异构数据、数据疏理、数据整合、数据建设等方面入手,让数据中心的建设更加高效,保障数据的完整性和保密性,降低数据泄漏和损坏的风险。