挑战垄断者,摆脱英伟达

朱秋雨

“这一定是很痛苦的……却是不得不做的事。”在2023中国计算机大会上,谈及国产AI算力是否应摆脱对国际的依赖,中科院计算所研究员崔慧敏说道。

在场的专家都点了头。

那是在10月末的秋日沈阳。就在10天前,美国商务部工业和安全局(BIS)宣布重磅规定—对中国升级芯片出口管制。

规则制定者之一,美国商务部负责出口管理的助理部长西亚·肯德勒曾明确放话:“中国已投入大量资源开发超级计算的能力,力争到2030年成为世界人工智能的领先者。”“我们的行动将保护美国的国家安全和外交政策利益,同时发出明确的信息,美国的技术领先地位关乎价值观和创新。”

于是,10月17日,BIS的禁售令,将上述信号再度传递给中国。这则最严芯片出口令将于30天后生效,涵括三大方面:

一是将向中国禁售高性能芯片的标准改为“性能密度”。这一标准将更多AI芯片列入禁止出口名单中,英伟达、AMD、英特尔的产品均在列。

二是扩大了另外40多个国家出口的许可要求,以规避高性能AI芯片从海外其他地区辗转到中国。

最后是将13家中国公司添加到“实体清单”。其中有两家国产GPU企业,壁仞科技、摩尔线程。进入实体清单的公司,未来不得在台积电等先进工厂生产芯片。

一纸新规让如火如荼的AI大模型元年气氛愈发紧张。AI芯片领域,全球格局已经是“一家独大”。花旗研究分析师在今年7月预计,英伟达占据了AI 芯片市场“至少 90%”的份额。

“脱钩”风云中,被“卡脖子”的国产芯片尽早突破英伟达,是现今中国业界的共识。用国家超算计天津中心首席科学家孟祥飞在上述大会的话说:“这不是一个可选项,而是一个必选项。”

问题是,有路吗?怎么走?

被禁以后

无论从什么角度来说,英伟达高端芯片被禁,对多数中国AI创业者而言,都像被浇了一盆冷水。

“现在拿到卡了就是大爷。”10月,一位不愿具名的清华大学计算机教授在私下交流时说道。

一切源于OpenAI率先开启的“暴力美学”—大模型需要至少千亿级参数历练才能涌现智能。成本、计算速度和节能等因素,都催促着慢人一步的中国AI公司,使用最先进的AI芯片。

如果按照部署位置分类,基于深度学习的AI芯片大致有两类:一是部署在边缘侧的芯片。也就是位于产品终端,比如,在一辆自动驾驶汽车里。

这些终端芯片基于训练好的模型进行实时推理、决策,强调实时性。腾讯、Meta推出的自研芯片,都是推理类型。

但当下更稀缺的,是技术门槛更高、部署在云端的芯片。它们的作用更基础—训练大模型,以期AI涌现出类似大学生的智能。

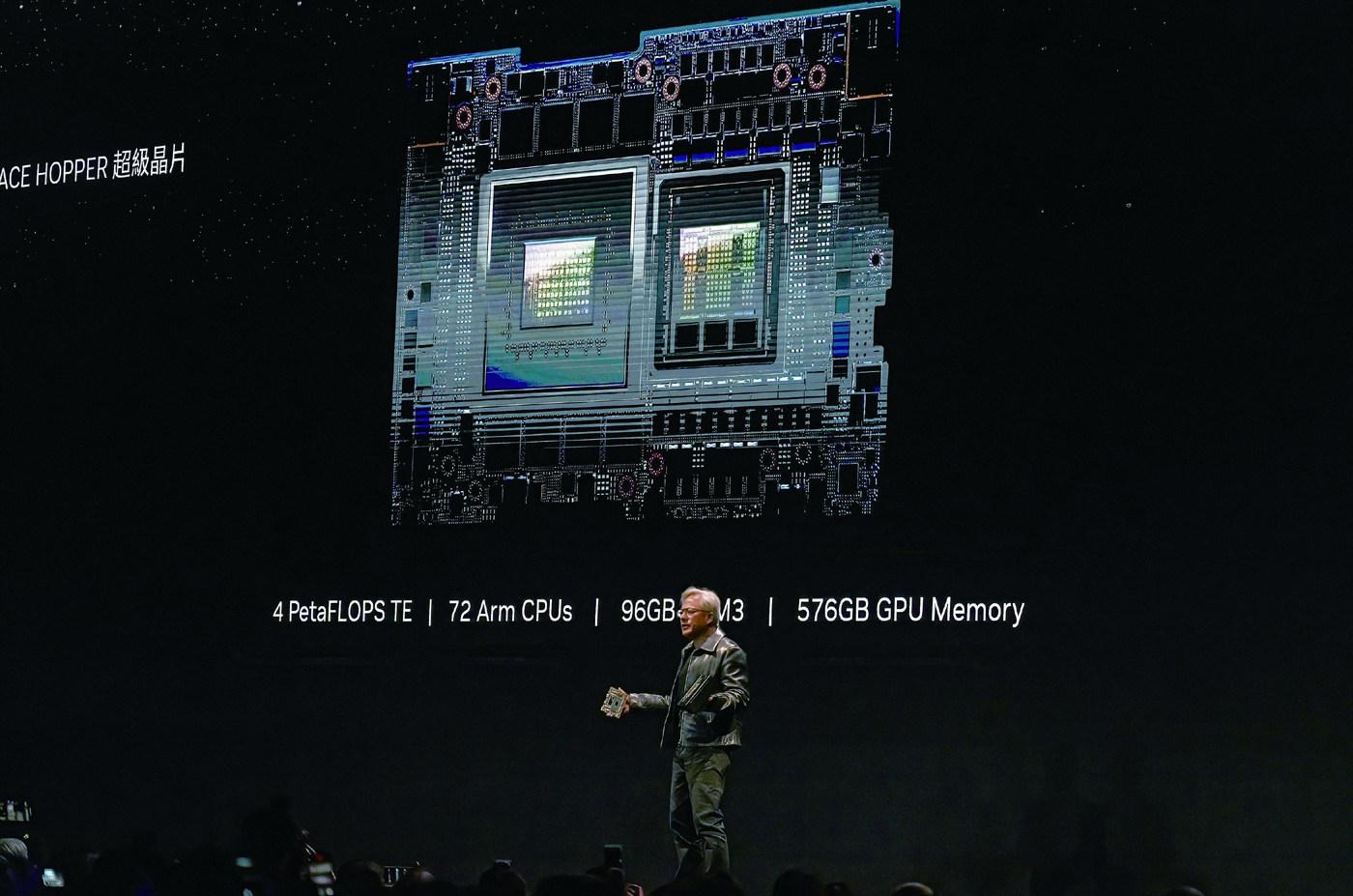

上海通信技术中心前CEO、著有《AI芯片:前沿技术与创新未来》的张臣雄告诉南风窗,自2014年深度学习算法在全球人工智能越加火热以后,美国厂商英伟达推出的GPU获得了巨大市场空间。

一切都是来自技术上的恰好契合:尽管深度学习算法拥有复杂的结构,但这些结构大部分的运算和处理都与一个东西有关—矩阵乘法。

恰好,英伟达此前用于渲染图像、游戏的GPU,尤其擅长矩阵和矩阵的乘法。张臣雄介绍,正是因为发现了GPU的这个特性,从此英伟达逐渐迭代产品,开发出多款适用于AI训练的芯片。

更重要的是,相比于通用型的芯片CPU(中央处理器),英伟达的GPU还完美契合了深度神经网络(DNN)并行计算的特性。不同于CPU按顺序进行计算,GPU有着大量并行架构的设计。这与DNN在训练和推理过程要进行大量独立的、同时进行的矩阵乘法的操作不谋而合。

据南风窗统计,截至2023年11月,明确对外称有训练AI大模型能力的中国芯片公司在个位数。

也因此,基于深度神经网络的大模型,中国公司对GPU的需求达到了顶峰。上海某信息科技公司生态合作副总监张迎告诉南风窗,从2023年上半年开始,英伟达高性能GPU已经在市面上极度短缺。他的公司早在6月订购了十几台英伟达H800。

“稀缺啊,半年了到現在还没拿到货。”张迎说。

紧张的AI芯片供应以2022年为分界线。为了 “遏制中国实现在人工智能和先进计算领域的突破”,美国政府明确实行全面的芯片限制。2022年8月9日,美国总统拜登签署《2022年芯片与科学法案》,要求接受补贴的美国厂商未来10年不得扩大在中国大陆的投资。

紧接着,8月31日,英伟达A100和H100、AMD MI250等AI芯片被禁销往中国。

一年后,10月17日,美国商务部再度颁布最严出口令。其中,市场主流的7种英伟达AI芯片,包括特供给中国的A800、H800,都将在1个月后禁止出口中国。

禁运的AI芯片让大模型创业大军立刻感到“捉襟见肘”。“浙商证券”曾估算,长期来看,考虑国内5家头部大模型厂商对标GPT-4模型的训练需求,还额外需要13705台A100、A800服务器。也就是对应近11万张GPU。

11月7日,在北京提供AI算力的云厂商杨加在行业群兴奋宣布,手上有17台A100服务器出售。“现货。”他强调。

这个在去年被美国列为禁止向中国出口的芯片,过往每张标价约1万美元(合计7万元)。中国市面上现在流行的A100,多为去年禁令前囤积,以非正规渠道流通。

如今,在杨加这里,包含8张显卡、散热器等整机服务器部署下来,售价高达190万元。至于更高性能的H100,整机价格已经达到270万-330万区间。

“太夸张了。”几个创业者听到报价后感叹。

追赶的玩家

大洋彼岸主动发起的“脱钩”,让中国AI企业和机构不得不面对赤裸的现实。抓紧提出以国产芯片和硬件为主的替代方案,成为唯一的选项。

事实上,近年我国的AI芯片赛道并不冷门。除了老牌的A股上市公司,比如做AI推理芯片的寒武纪,服务于军事用途起家的景嘉微以外,兴起的AI芯片公司还有两类。一类是以华为、百度、腾讯为代表的大厂队,还有一类是在过去6年加入的创业公司。

最新被BIS列入实体清单的中国公司摩尔线程、壁仞科技,便是两家创立于2019年后的年輕公司。巧合的是,两家公司创始人都有在美国芯片公司工作的背景,现在都将野心瞄准了制造高端GPU。

其中,摩尔线程的速度为外界称奇。成立仅3年的时间内,该公司宣布量产了苏堤、春晓、曲院三颗全功能GPU芯片。它同时发布了MUSA元计算统一系统架构,包括统一的编程模型、软件运行库、指令集架构和芯片架构,在AI计算领域表现突出。

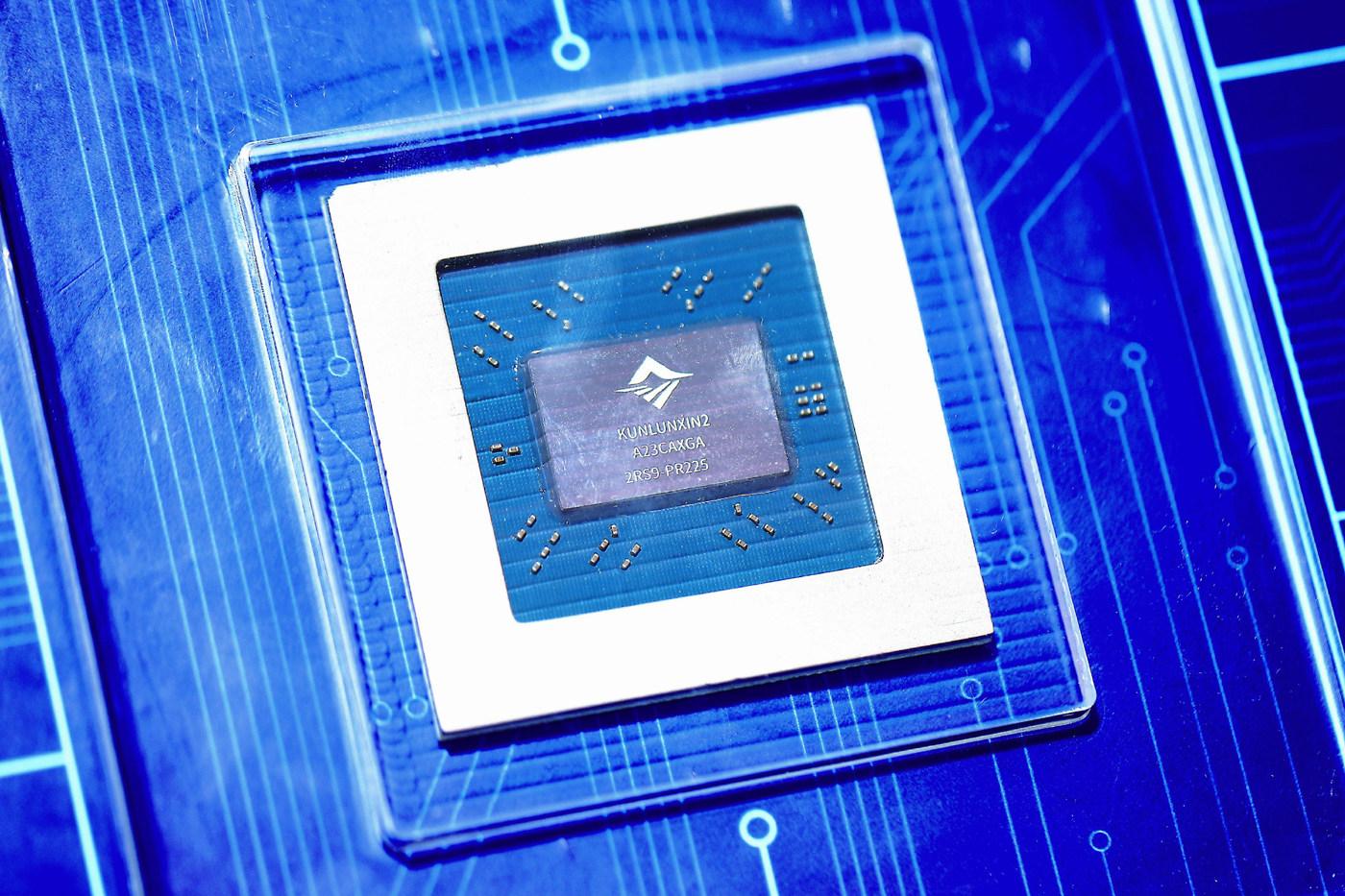

百度孵化的昆仑芯也提出了一个不同于GPU、CPU的全新架构—XPU。据介绍,配备XPU的昆仑芯二代专为当前的AI场景设计。它不仅与文心一言及其他大模型适配,且有更多的AI加速单元,为大模型时代“高性价比的计算力产品”。

但这是国产玩家的少数。

据南风窗统计,截至2023年11月,明确对外称有训练AI大模型能力的中国芯片公司在个位数。其中包括大厂队的华为昇腾,百度昆仑芯,以及创业公司天数智芯、燧原、摩尔线程、壁仞科技。

更多数的AI芯片厂家,例如腾讯、寒武纪、地平线、沐曦、登临等,选择入局技术门槛更低的AI推理芯片。

摩尔线程CEO张建中曾在受访时解释,造GPU芯片的难度很大,因为这是一个由短板决定的创新过程。

人才、资金、技术、产业链环环相扣,缺一不可,“就像打游戏打通关一样”。

只是,即使暂时通关成为赛道的“王者”,还有更严峻的现实摆在面前。造出国产GPU是一回事,怎么让企业替换已经在用的英伟达芯片,又是另一回事。

一位南京某云服务厂商告诉南风窗,为了鼓励使用国产芯片,许多由政府组建的超算中心会被要求购买一定份额的国产芯片。“虽然买了国产,但用终归还是英伟达好用。”

而据《财经十一人》报道,2023年6月,部分地方政府出资建设“数字经济算力中心”时,曾向承建方提议,是否能采购一定数量国产AI芯片。但这家作为承建方的国资企业拒绝了,理由是,国产AI芯片相比英伟达的性能不足。

张臣雄对南风窗分析,造出训练AI的GPU之所以难度更高,最难的还是GPU集群之中的通信和控制。

“把这么多的芯片连起来并行计算,那么如果没有很好的设计,容易出现很多问题。”张臣雄说。

让国产芯片在现实场景中跑起来后,将为后续迭代、完善技术提供丰富原料。此后,才会逐渐出现技术加速迭代的正向循环。

这也是很多国内AI大模型企业仍不敢大量使用国产GPU的一大原因。稳健、不出错,看上去是一个基本的要求,背后却需要成熟的软硬件配套和反复迭代的技术。在创业进入“百模大战”的极度紧张之际,有条件的公司都不希望将过多时间花在出错和调试硬件问题上。

华为昇思MindSpore系统架构师苏腾博士也在公开场合透露,当下训练GPU集群的一大关键—确保高度可用。

“大家有参与过训练大模型的话,都有体会,每个星期或者每隔两三天,集群总要崩溃一次。”苏腾说。因此,他的工作重点经常围绕着提高大模型训练过程的“可靠性”,以及“快速地将故障恢复”。

突围护城河之路

好消息是,在使用国产硬件成为必选项的当下,有中国公司跑出来了。

华为昇腾910系列是其中被认为性能最为全面,同时使用程度也最高的国产GPU。科大讯飞创始人刘庆峰曾在8月透露,讯飞大模型接上了国产硬件。

“我特别高兴地告诉大家,华为的GPU能力现在已经跟英伟达一样,”刘庆峰说,“任正非高度重视,华为的三位董事到科大讯飞专班工作,现在已经把它做到了能对标英伟达的A100。”

11月7日,据路透社爆料,早在美国宣布出口禁令前,百度就在8月订购了总价值4.5亿元的共计1600个华为昇腾910B。

这显然是国产芯片的一大胜利。

让国产芯片在现实场景中跑起来后,将为后续迭代、完善技术提供丰富原料。此后,才会逐渐出现技术加速迭代的正向循环。

不过,业内人士都很清楚,这只是国产GPU进展的第一步。

这时维持审慎,是因为芯片的能力不止来自硬件,同时是软件能力的体现。

英伟达过往20年的领先就在于此—这不是单纯的硬件公司,而是由软件定义的巨头。

回到1993年,英伟达成立的1990年代,市面上有70多家做图形渲染的公司。

转机直到2006年出现。英伟达此后开发了一个名为CUDA的平台。这个平台首先由3000多个工程师合力编写,接着,越来越多人加入。2023年,全球超过400万开发者在CUDA生态里。

张臣雄对南风窗解释,CUDA最大的作用,是为GPU提供了整套编程模型和编程语言。

更通俗地说,CUDA相当于一个编译器。“程序员编了很多(软件)程序,通过CUDA,能把它编译成机器最底层的硬件语言,相当于中间翻译。”

有了这个编译器和编程语言,软件工程师能高效地调试硬件,而不用重新从底层硬件进行更新,大大提升了效率。

CUDA的发明,让英伟达验证了俗语—“早起的鸟儿有虫吃”。目前,世界上主流的深度学习框架都只与CUDA适配。就像苹果系统内部的闭环生态,赢家通吃的局面也在AI芯片领域存在。

这也是当下中国AI芯片公司面临的艰难抉择:很多企业的代码都是基于英伟达推出的运算平台CUDA编程而写的。如果要与英伟达完全脱钩,换一个新的生态,就意味着要做大量代码性迁移及改变,工程量巨大得难以想象。

逐渐打破被垄断的生态,成为国产芯片公司在日益“脱钩”的背景下努力的方向。

现在正处于国产芯片“被迫”独立自主的关键期,这次,对我国而言更重要的是,走出长期的思维误区。“一定要摆脱follow(跟随)的习惯。”

2023年,以华为与百度为首的大厂,相比于推荐自己的底座大模型,都将更多的力气放在了建立开发者生态之中。

苏腾也在上述场合中提到了这一点。比起硬件上的发明,对华为来说,更难的在于迅速建立起生态。

“现在国际上很多新的算法和优化手段,总是在英伟达的GPU和CUDA上率先出现。”苏腾透露。华为也会将CUDA的创新在昇腾的Mindspore上复现,并基于此做一些创新。

但是,他坦言,“我们自己所做的创新,相对于英伟达的整个生态来说,肯定是九牛一毛。”

这背后,关乎发展时间,关乎人才,也关乎创新的环境。

张臣雄分析,虽然起步慢,但中国的AI芯片“现在搞也来得及”。主要原因在于中国背靠巨大的市场。

“可以合力建立一个开放的生态系统,有很多家企业合起来做,使用开源的架构。”

他同时认为,现在正处于国产芯片“被迫”独立自主的关键期,这次,对我国而言更重要的是,走出长期的思维误区。

“一定要摆脱follow(跟随)的习惯。”

他告诉南风窗,从发展历史回看,英伟达的GPU一开始并非用于AI,而是用于图形、游戏渲染。也就是说,制造AI芯片,远不止做出GPU这一个解法。

模仿英伟达的产品未必等于可行,重要的是在研制AI芯片过程中找到前进的目标—满足深度学习网络的矩阵乘法和并行运算的需求。

好消息是,回溯历史的芯片之战,还有一个共同点:创新出现的一个重要动力,在于挑战垄断者。

处于下位者的公司,往往有强动力奋起直追,改变垄断者控制的游戏规则。这是ARM、AMD、苹果等等巨头在研制芯片的故事。

这注定是充满痛苦且有曲折的路。但一切正如美国经济历史學家克里斯·米勒在《芯片战争》所描述的那样:“战争会改变我们,不要辜负这场战争。”

(文中杨加为化名)