基于多模态特征融合的行人穿越意图预测方法*

陈 龙,杨 晨,蔡英凤,王 海,李祎承

(1.江苏大学汽车工程研究院,镇江 212013;2.江苏大学汽车与交通工程学院,镇江 212013)

前言

城市交通环境纷繁复杂,行人是道路交通参与者中最易暴露和最脆弱的道路使用者之一,根据世界卫生组织报告统计结果,在全球每年死于交通事故的135 万人中,超过一半的交通事故死亡者为弱势道路使用者,保护行人等弱势道路使用者的安全刻不容缓[1]。保护行人安全的关键在于避免人车冲突,如今随着先进驾驶辅助技术和自动驾驶技术的迅速发展,自动驾驶汽车可以借助视觉、激光雷达和毫米波雷达等车载传感器感知周围的道路环境、车辆和行人等目标,进而预测行人行为,让自动驾驶汽车可以提前进行规划和决策,从而避免发生人车冲突。在交通管理的背景下,人车冲突多发于人行横道,能够准确预测行人是否从车辆前方穿越,可以减少行人延误和交通拥堵,提高道路行车效率,从而帮助自动驾驶汽车找到安全和效率之间的平衡[2]。

目前解决行人穿越意图预测问题的主流方法主要有两种,一是基于行人未来轨迹预测的方法,二是基于人体姿态估计的方法。其中基于轨迹预测的方法相对更加普遍,行人轨迹预测领域的研究也已经相对成熟,许多基于人机交互模型预测行人轨迹的模型已经被提出。例如Alahi 等[3]提出了Social-LSTM,其将最大池化应用于邻近交通参与者,建模交通场景中的人人交互。Gupta 等[4]提出了Social-GAN,其将Social-LSTM 扩展为基于递归神经网络(RNN)的生成模型,将最大池化应用于所有交通参与者。Kosaraju 等[5]提出了Social-BiGAT,其也是一种基于GAN 的方法,它引入图注意力网络(GAT)建模场景中的人人交互,解除先前模型中的RNN 依赖。Mohamed 等[6]提出了Social-STGCNN,其使用图卷积网络代替先前模型的交互机制,使用TCN 代替先前模型的循环递归架构,用时空图捕捉随时间变化的动态交互作用。考虑到视角和自身运动,Yagi等[7]针对第一人称视频中的行人轨迹预测问题提出了一种新型行人轨迹预测模型,其采用一种多流卷积-反卷积架构的预测框架聚合相机自我运动、行人尺度和人体姿态信息预测行人的未来轨迹,该模型克服了相机视角的问题,但模型结构和性能还有较大的优化空间。近期的研究表明,行人穿越前的早期动作(如走动、挥手、注视等)与行人的穿越意图有关[8]。基于人体姿态特征进行行人穿越意图预测开始受到研究者们的广泛关注。早期的方法多基于CNN[9]和LSTM[10]处理人体骨架特征进行动作识别和轨迹预测,例如Fang 等[11]提出基于单目视觉的人体姿态估计方法来预测行人和骑自行车人的意图。Zhang 等[12]提出使用多层 LSTM 网络进行基于骨架的动作识别的几何特征,提供了一种与 RNN 模型增强垂直的简单通用空间建模方法,进一步提高了模型性能。最近的研究开始在人体姿态估计任务中引入图结构,例如Cadena 等[13]开发了二维行人图结构和行人图网络,以预测行人是否要过马路。Huynh等[14]提出了GPRAR 模型,该模型基于图卷积网络进行人体姿势重建和动作识别,模型包括一个特征聚合器(FA),FA以通道方式聚合学习到的特征:人体姿势、动作、位置和相机运动,使用基于编码器-解码器的时间卷积神经网络来预测未来位置。

综上所述,现有的运动轨迹预测方法,常常是借助先验的历史轨迹信息在未来的某个时刻对其进行轨迹预测,且没有充分考虑到自然驾驶环境下外界条件的不确定性干扰。此外,这些方法大多需要在俯视视角下的位置信息,这受限于要借助移动摄像机来获得场景的俯视图,且目前也缺乏俯视视角下带有行人位置信息和穿越意图标签的数据集。基于人体姿态估计的行人意图预测方法在特定的环境下表现出不错的性能,但在复杂的城市交通环境中,人体姿态关键点的检测精度会受到变化的相机视角、人车距离、遮挡等因素的较大影响,且行人通常表现出受到各种背景元素影响的复杂行为,具有高度的可变性,仅通过行人的历史轨迹进行推断或是只通过人体姿态估计不足以在复杂的城市交通背景下实现行人穿越意图的准确预测。

为继承上述方法的优点,同时避开其缺陷,近期的研究已经开始转向关注基于多流循环网络和多输入特征的行人意图预测方法,例如Aliakbarian 等[15]使用多流LSTM 对视觉特征、光流图像和车辆动力学进行编码,其输出被连接后生成用于意图预测的共享表示。自 JAAD[16]和PIE[17]数据集被提出后,Fussi-Net[18]、SF-GRU[19]、PCPA[20]等依赖多种输入特征的行人穿越意图预测模型逐渐被提出,并在公开数据集上表现出不错的性能,这些模型的输入特征一般是检测到的行人边界框、姿势、外观,甚至是自我车辆信息。总的来说,尽管该领域在近几年的研究中取得了显著进展,但仍普遍存在诸如行人穿越意图预测精度不高、模型输入考虑不全面以及模型泛化性能不强等问题。究其原因,主要是现有方法在充分利用交通场景中的环境上下文信息以及各个交通对象之间的交互信息方面存在不足。此外,现有意图预测模型在探究多模态特征融合策略和模型优化方向的方法系统性存在局限。

针对上述问题,本文中提出一种基于多模态特征融合的行人穿越意图预测方法,实现了在复杂交通场景下对行人意图的准确预测。首先,针对全局场景上下文信息、局部场景上下文信息、自车车速等输入信息,该方法以输入目标行人的边界框信息为基准设计了正交试验,并通过试验分析筛选获得性能最佳的模型架构;其次,建立了一种新型全局场景上下文交互信息提取模块,该模块包含膨胀卷积、SE 模块和交互注意力机制,依赖场景语义掩码对行人与交通元素间的交互关系进行建模;同时,构建了局部场景时空特征提取模块,该模块结合通道注意力、空间注意力和AUGRU,基于多重注意力机制提升了模型捕获复杂交通场景下局部交通场景的时空信息的能力;最后,设计了一种基于混合融合策略的多模态特征融合模块,根据不同信息源的复杂程度实现了对视觉特征和运动特征的联合推理,为行人穿越意图预测模块提供可靠信息。在公开数据集JAAD上的验证结果显示,相比于现有的同类型模型,文中所提出的方法在行人穿越意图预测方面优于最先进的模型。综上所述,本文的主要贡献可以归纳为:

(1)提出了一种基于多模态特征融合框架的行人穿越意图预测方法,设计正交试验法筛选获得最佳输入条件,通过混合融合方式对视觉特征和运动特征进行联合推理,进而实现对行人意图的准确预测。

(2)建立了一种新型全局场景上下文交互信息模块,该模块基于多种注意力机制构建交互建模注意力关系网络处理全局场景的语义掩码,从而捕获行人与其周围环境之间的交互关系。

1 行人穿越意图预测模型构建

1.1 问题描述

本文将人行横道上的行人穿越意图预测定义为一个与多个模态信息输入源相关的优化问题,即它通过聚合的受试者的反应来测量并被重新调整到 [0,1]的范围内,因此对于每个目标行人i,给定从车辆前视图观察到的m个时步的视频帧序列和自车运动的相关信息,根据所设计的模型可以估计出目标行人t+n时刻在车辆前方穿越的概率。

1.2 框架概览

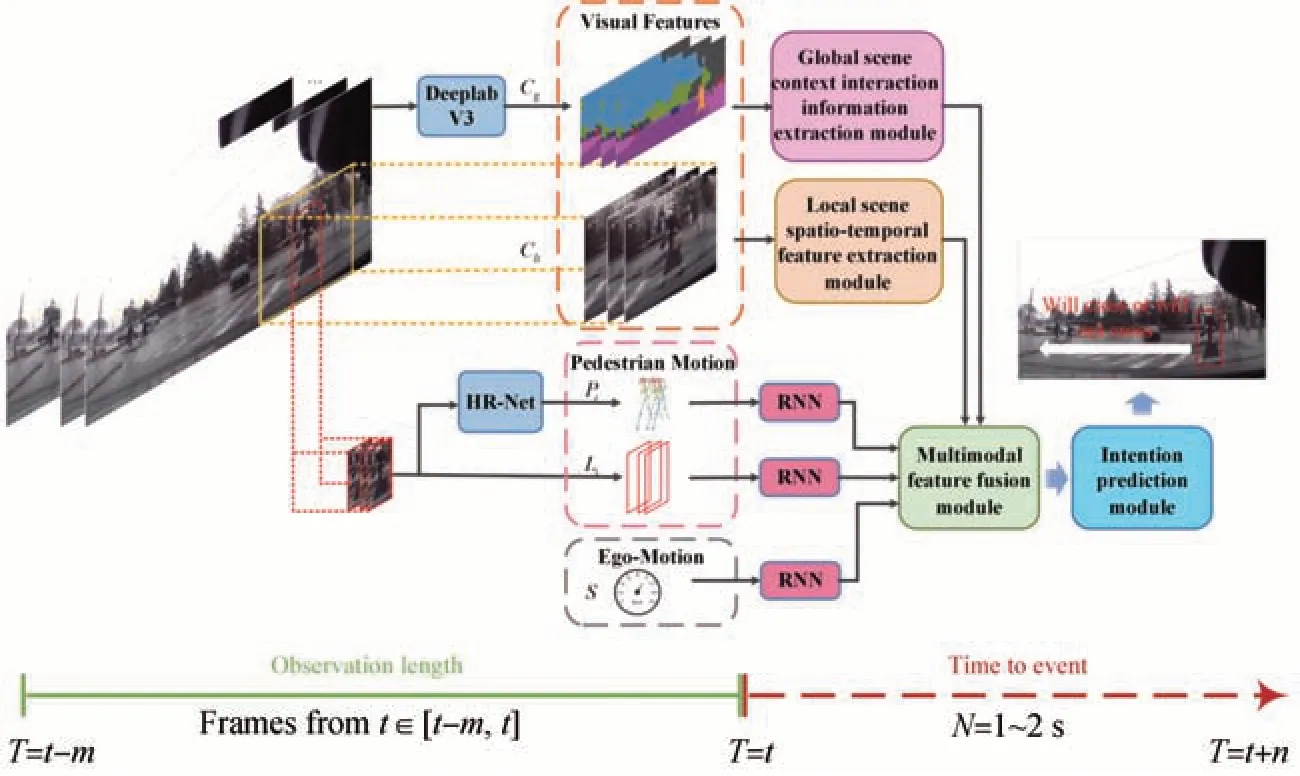

所提出的意图预测模型的整体架构图如图1 所示。该模型架构主要由RNN 模块、全局场景上下文交互信息提取模块、局部场景的时空特征提取模块、多模态特征融合模块以及行人穿越意图预测模块5个部分组成,下面对该模型中各输入特征的获取以及模型中的各个模块进行详细介绍。

图1 本文所提算法的整体架构图

1.3 输入信息获取

1.3.1 自车车速信息及行人边界框信息获取

本文提出的模型主要在JAAD 数据集上进行实验验证。行人的边界框位置坐标和自车车速是JAAD数据集中注释的显式特征,因此自车车速和行人的二维边界框位置轨迹信息可以直接从数据集的标签信息中获取。自车车速可以从自车的车速传感器中直接获取,这里直接采用数据集中自车速度的地面实况标签,也即S={st-m,st-m+1,...,st}。目标行人i的二维边界框位置轨迹信息表示为Bi=其中bi由边界框的左上角和右下角的位置坐标表示,也即

1.3.2 行人周边局部场景图像信息获取

本文所指的局部环境上下文信息包括目标行人及其周围局部环境的外观变化,由目标行人周围的局部场景图像序列表示,具体表示为Cli=在给定的时间步长,通过裁剪放大的二维边界框来提取每个行人的局部环境图像序列,然后调整缩放框的尺寸,使其高度与宽度相匹配。

1.3.3 行人姿态关键点信息获取

行人的姿态关键点信息可以表示目标行人每一帧的姿态,姿态可以反映目标行人详细的运动状态(如行走、站立、蹲下以及行人的凝视方向等),表示为由于JAAD 数据集自带的数据标签中不包含行人的姿态关键点,在正交试验中采用在COCO 数据集[21]上预训练的HRNet[22]提取JAAD数据集中的行人姿态信息(即由18个人体关键点坐标连接而成的36维特征向量pi),具体可以表示为

1.3.4 全局场景上下文信息获取

全局场景上下文提供了解释目标行人与其他交通参与者以及道路环境之间或其他交通参与者之间的多重交互的视觉特征,文中将其表示为Cg={ct-m,ct-m+1,...,ct},对于输入的交通场景图像序列,本文采用在Cityscapes[23]上预训练的deeplabV3[24]来提取输入场景图像中各交通参与者与静态交通环境的语义地图。

1.4 RNN模块

所提出的模型涉及到的输入信息均为序列特征,结合注意力机制的RNN 模块可以自动为序列特征分配权重,使更重要的特征分配到更大的权重,从而突出特征变化,提高模型处理序列特征的准确性。本文在GRU 模块中引入注意力机制构成了AUGRU模块[25],其在对目标行人的边界框位置序列提取特征时,可以通过概率分配的方式自动提高模型对重要的行人边界框位置坐标的关注程度,突出行人横向位移以及人车距离变化等关键信息,在不额外增加计算和储存成本的前提下改善行人过街意图预测的准确度。

和LSTM 网络[10]一样,GRU[26]也是RNN 的一种变体,两者都是为解决简单RNN 所面临的长期依赖问题而被提出来的,但GRU 相比于LSTM 网络参数量更少,可以更快地在更少计算量的前提下获得更好的表现。图2 所示为GRU 的结构图,它有两个门神经元,分别为更新门和重置门,其均采用Sigmoid作为激活函数。更新门控制前一时步的状态信息被代入到当前状态中的程度,重置门则控制忽略前一时步的状态信息的程度。假设t时刻GRU 网络的输入为X=(x1,x2,...,xn),则GRU 中各变量的关系表达式如下。

图2 GRU结构简图

更新门:

重置门:

t时刻的新记忆:

t时刻隐藏层的状态量:

式中:xt表示当前时刻的输入;r(t)和u(t)分别表示重置门和更新门的权重;表示当前时刻隐藏层新的记忆状态;h(t)和h(t-1)分别表示当前时刻和前一时刻的隐藏层状态;σ为Sigmoid(·)函数;tanh(·)为双曲正切激活函数;b(r)、b(u)和分别表示重置门、更新门和新记忆中的偏差项,其余参数均可在训练过程中获得。

AUGRU 的模型结构如图3所示,其在GRU 的基础上引入了注意力机制,将GRU 的update gage 替换为attention-score*update-gate,即将注意力权重α(t)乘到更新门u(t)上,然后用更新门控制当前信息与历史信息保留的比例。注意力分数(attention score)可以反映隐向量ea与输入h(t)的关系,且它们之间的相关性强度会影响attention score。

注意力分数的计算公式为

则AUGRU中更新门的输出为

AUGRU中隐藏层的状态量为

式中:ea为GRU 编码器输出的隐状态连接得的隐向量;W为可通过学习获得的记忆矩阵。

1.5 全局场景上下文交互信息提取模块

提出一种新型的全局场景上下文交互信息提取模块,其结构如图4 所示。这是一种结合SE 通道注意力机制[27]和交互注意力机制的新型交互建模注意力关系网络,它依赖场景的语义解析隐式的建模目标行人与不同交通元素之间的交互关系。对于输入的交通场景图像序列,首先采用在Cityscapes数据集上预训练的deeplabV3 来提取输入场景图像中各交通参与者与静态交通环境的语义地图,这里参考交通场景中最常见的几种交通对象,根据所提取的语义掩码将语义地图分为目标行人 (p)、目标行人附近的行人 (pl)、骑行者 (b)、周边车辆 (v) 以及其他静态交通场景 (st) 5个类别作为全局语境。

图4 全局场景上下文交互信息提取模块

考虑到仅使用多层卷积对语义地图进行连续的下采样处理会丢失较多的细节特征,从而无法在更高的分辨率下表达更广泛的上下文信息。为克服这个缺点,尽可能多地捕捉目标行人与其周边交通参与者之间的交互特征,提出采用膨胀卷积[28]策略来处理语义地图。相比之下,膨胀卷积可以在保持参数量不变的情况下增大卷积核的感受野,让每个卷积输出都包含较大范围的信息,同时它可以保证输出的特征映射的大小不变,这允许模型在不需要下采样的情况下捕获更加广泛的空间上下文特征。

膨胀卷积处理后的语义类别特征经过SE 注意力模块后进入GRU 编码生成各语义图的时空表示。在SE注意力模块中,Fsq(·)表示Squeeze操作,将尺寸为H×W×C的特征图压缩为1×1 ×C,该操作通过全局平均池化来实现。Fex(·,W)表示Excitation 操作,这里通过使用两个FC全连接层对每个通道的重要性进行预测,一个FC 层降低维度,一个FC 层恢复维度,从而可以在特征维度不变的情况下得到不同通道的重要性大小。Fscale(·,·)表示Scale 操作,这里指对每个通道的特征进行加权操作。

连接AUGRU 的隐藏状态可以得到如下的时空分类表示:

时空表示被连接并输入全局交互注意模块[29]生成统一的加权表示,各语义图的加权输出经连接后即得到大小为[1,256]的全局场景上下文的关系特征Ca。

在全局交互注意模块中,输入为连接的各个AUGRU 在[t-m+1,t]时步的隐藏状态,该模块通过测量最后一个时步与其他的每个时步之间的相似性来生成注意力分数:

式中:上角标“′”表示转置操作;Wa为可训练权重。由注意力分数可计算得每个时步的注意力权重为

计算得上下文向量为

全局环境交互上下文最终表示为

式中:⊕为连接操作;Wc为可训练权重。

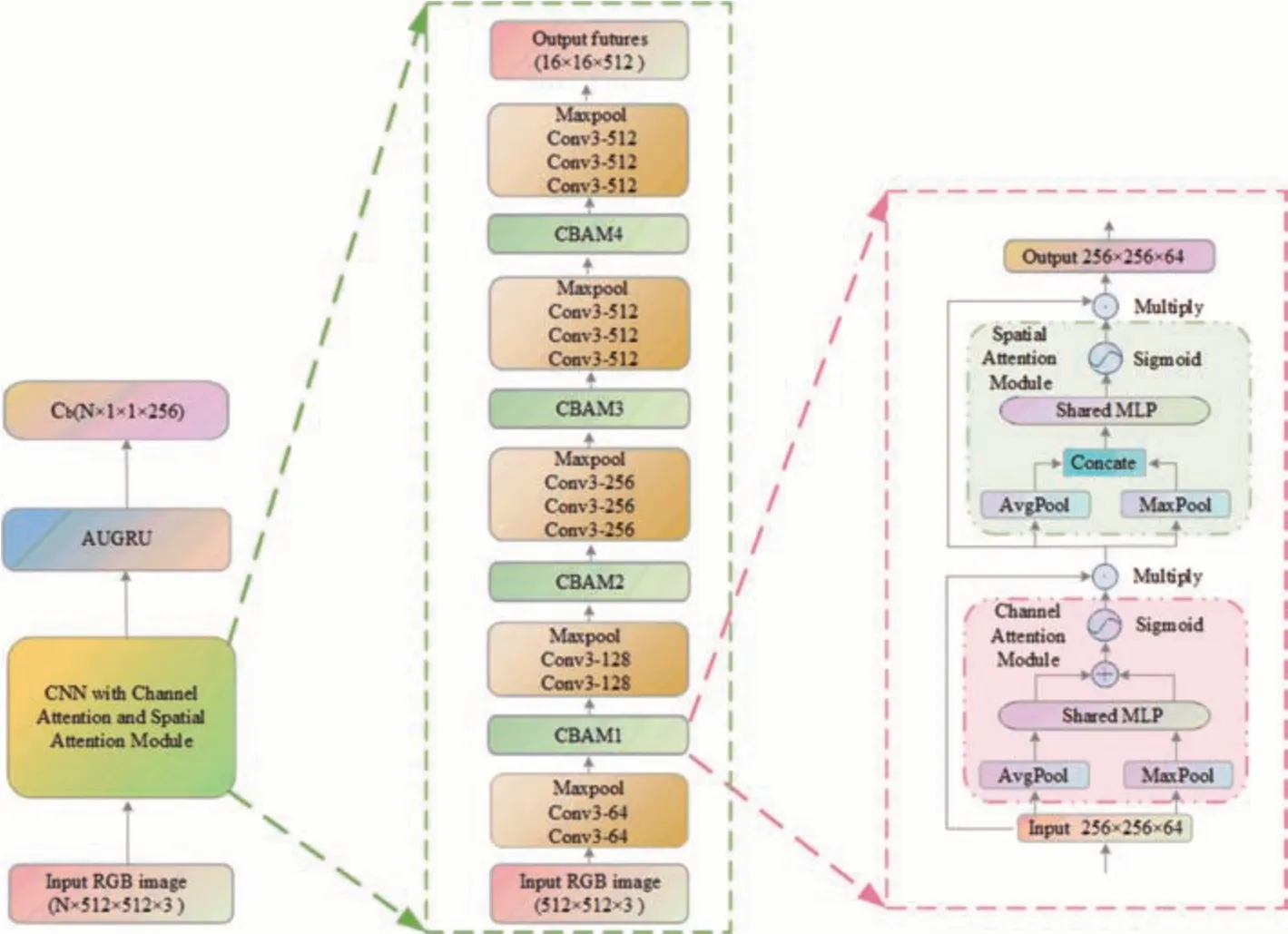

1.6 局部场景时空特征提取模块

针对局部场景图像,本文联合多层卷积和AUGRU 对其进行结合时空注意力机制的时空特征提取。首先统一局部场景图像的尺寸为[512,512],则输入大小为[16,512,512,3](N、H、W、C),结合VGG16 网络[30]、通道注意力、空间注意力和AUGRU设计了一个基于时空注意力机制的局部场景时空特征提取模块,最终得到大小为N×1×1×256 的局部场景时空特征Cb。该模块的具体构造如图5 所示,其在连续的两个VGG Block 间插入了一个CBAM 模块[31],该模块结合了通道注意力机制和空间注意力机制,可以在不改变特征图尺寸的情况下增强有用的特征表达。

图5 局部场景时空特征提取模块

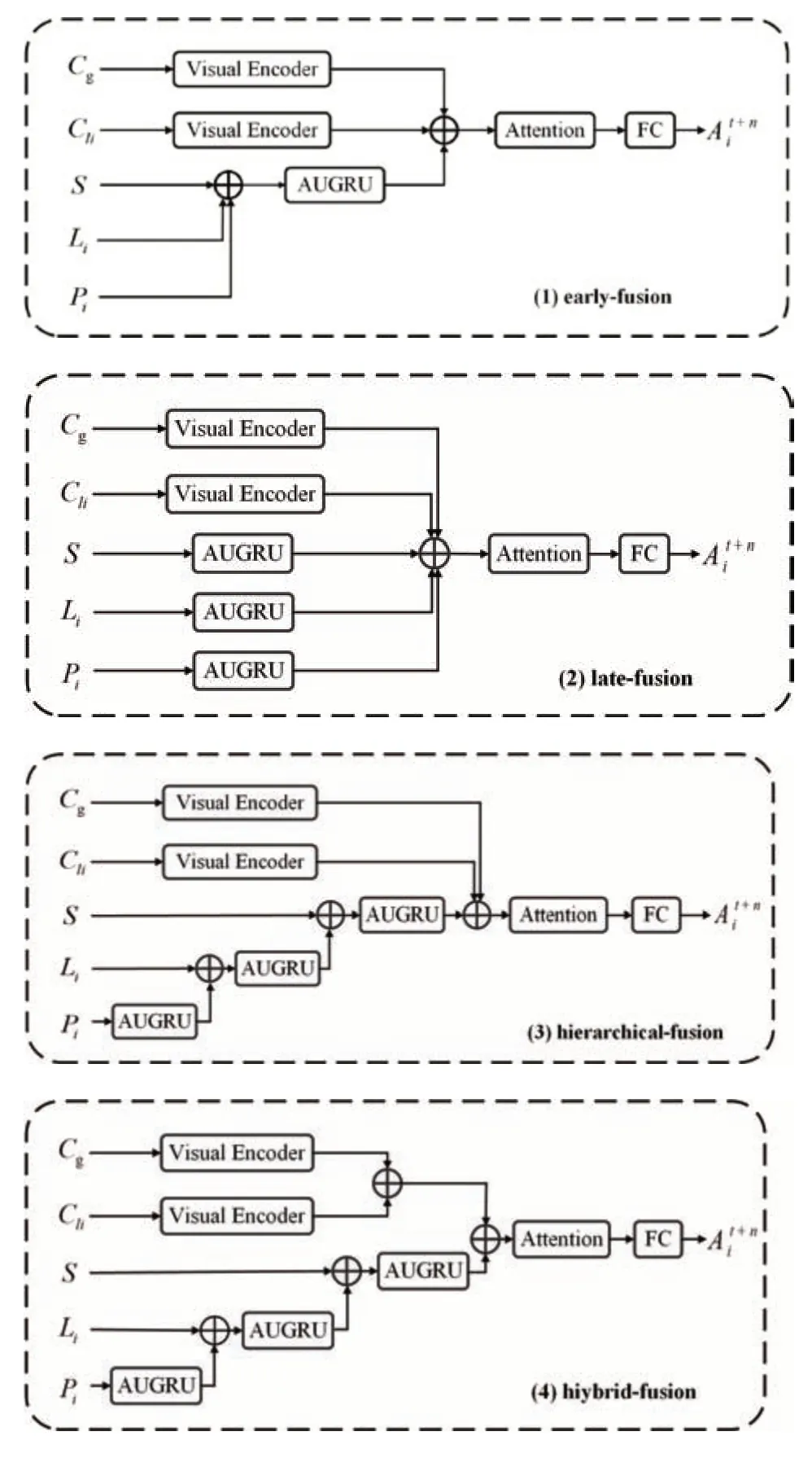

1.7 多模态特征融合模块

如何合理地利用和融合不同模态的特征是提高行人意图预测性能的一个重要研究方向,现有的多模态特征融合方法总体上可以分为像素级融合、特征级融合以及决策级融合,且根据以往的试验表明,特征级别的融合相比之下具有更好的性能。如前文所述,所提出的过街意图预测模型的输入包括行人边界框位置轨迹、车速、行人姿态关键点以及图像视觉特征等多种异构信息,在此基础上本文根据不同信息源的复杂程度提出了4 种不同的融合策略,具体结构如图6 所示。图6 中(1)为early-fusion,其先融合多层特征,然后采用融合后的特征训练分类器,常用有concat 和add 两种操作,本文中采用了add;(2)为late-fusion,其与early-fusion 相对应,采用类似特征金字塔的方法,对特征融合后进行预测;(3)为hierarchical-fusion,其为一种分层融合架构,这里将输入的非图像特征按其复杂程度进行先后融合,每一次融合都采用与(1)中相同的early-fusion。(4)为hiybrid-fusion,在该框架中对视觉类特征和非视觉特征分别根据其特征复杂程度进行先后融合,特征融合同样采用了add 操作,是一种混合融合方式。

图6 4种融合策略对应示意图

1.8 意图预测模块

如图6 所示,模型预测模块由一个注意力模块和一个全连接层组成,处理后的各输入特征经融合模块和注意力模块后生成用于最终预测的特征表示V,可表示为

则最终的预测结果可表示为

2 试验设计

2.1 公开数据集介绍

本文在自动驾驶联合注意数据集(JAAD)上对所提出的意图预测模型的性能进行评估,JAAD数据集是由约克大学的研究者提出的用于研究交通参与者行为的大型自然公开数据集,其包含有346 段由车载相机拍摄的高分辨率交通场景视频剪辑。JAAD 数据集提供两个子集,其中行人行为数据集(JAADbeh)包含了涵盖各种场景下具有穿越意图的686个行人(正在穿越495人/即将穿越191人),而完整的JAAD 数据集(JAADall)则包含所有的可见行人,相比JAADbeh 增加了2 100 个远离道路且没有穿越行为的人。本文对数据集的训练集、验证集和测试集的分割处理保持与文献[32]中相同的设定,使用数值为0.8 的采样重叠率,所有模型的观测长度固定为16 帧。此外,本文遵循与PCPA 模型中相同的数据采样程序,使用与PCPA 模型架构中相同的评估指标(准确性、AUC 曲线、F1 评分、精密度和召回率)报告所有的试验结果。

2.2 实施细节

所采用的试验平台搭载了一块RTX 2080Ti GPU 和一块Intel I9 CPU,试验环境为Ubuntu18.04、Pytorch 框架。分别在JAADbeh 和JAADall 上训练所有的模型45 个epoch,训练采用的优化器为Adam,设置最大学习率为5e-6,L2 正则化项为0.000 2,训练采用二元交叉熵损失函数,受计算平台的限制,本文将batch size设为2。

2.3 正交试验

多模态学习可以聚合多源数据的信息,使模型学习到的表示更加完备。行人意图预测模型的性能受多种因素的影响,理论上模型输入的特征量越多,模型的性能会越好,但特征量增多的同时也会带来计算量的大幅增加,且一些因素之间可能存在交互作用。正交试验法是多因素分析的有效手段,有助于在考虑到交互作用的情况下评估相关因素对试验指标的影响,并根据其效果对它们进行排序,从而便于优化模型。为系统地探究各个输入信息源对意图预测模块性能影响的显著性,从而优化模型设计出行人意图预测的最佳模型架构,本文首先引入了正交试验法对多模态输入的意图预测模型进行充分试验。

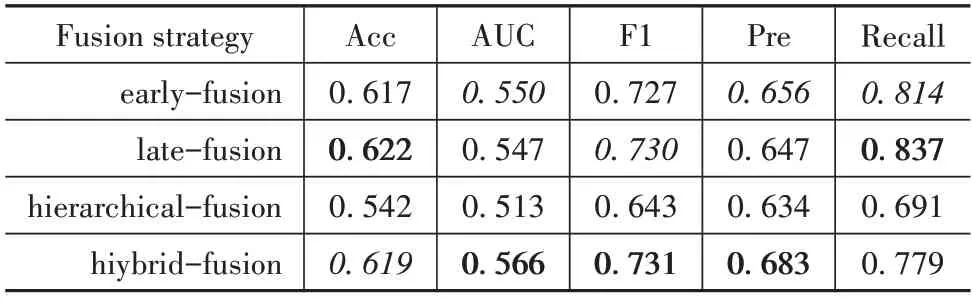

为最终能够得到最佳的模型,首先在默认所有影响因子均输入的情况下分别在JAADall 和JAADbeh 上针对3 种不同的融合方式进行了对比试验。试验结果如表1 和表2 所示。试验的评估指标包括准确性(Accuracy)、AUC 曲线(AUC)、F1 评分(F1 Score)、精密度(Precision)和召回率(Recall)。表中字体加黑数据为最佳数据,斜体数据次之。

表1 JAADall上采用不同融合策略的模型对比试验

表2 JAADbeh上采用不同融合策略的模型对比试验

如表1 所示,对比4 种不同融合策略模型在JAADall上的试验结果,基于hiybrid-fusion融合框架的模型在Acc、AUC 和F1 精度上均得到最优且远超其它模型的结果,在未达到最优性能Pre和Recall也仅仅是稍微有些逊色;表2 所示的在JAADbeh 上的结果也类似。综上根据表1和表2的试验结果,基于多模态输入混合融合的模型架构综合性能最佳,因此本文基于混合融合的模型架构设计了正交试验,试验因素水平表如表3 所示。正交表的表示方法为Ln(tm),其中L为正交表代号,n代表正交表的行数也即试验次数,t代表因子水平数,m代表正交表列数也即最多可安排的因子个数。本试验以仅输入行人边界框位置轨迹为基准,设计7 因素2 水平正交试验,因此选取L8(27)标准正交表,具体的试验结果如表4所示,这里以精度作为模型的主要评估指标。

表3 多模态输入行人意图预测模型正交试验因素水平表

表4 基于正交试验的行人意图预测试验数据分析计算表

如表4 所示,对正交试验的结果进行极差分析,本试验采用7 因素2 水平正交表,其余3 个空列的极差大小反映试验误差的大小,本试验中3 个空列的极差远远小于试验因子的极差,可忽略不计。由结果可知,在JAADall 上,4 个因子对行人意图预测性能的影响程度顺序为:局部场景上下文>全局场景上下文>人体姿态关键点>自车车速,且在4 个因子均输入的情况下模型的性能最佳。在JAADbeh 上,4 个因子对行人意图预测性能的影响程度顺序为:全局场景上下文>局部场景上下文>自车车速>人体姿态关键点,且在试验2(不输入人体姿态关键点信息)的情况下模型性能最佳。表中:Ⅰ1=JAADall 上因素水平为1 时所对应的评估指标值的平均值;

Ⅱ1=JAADall 上因素水平为2 时所对应的评估指标值的平均值;

Ⅰ2=JAADbeh 上因素水平为1 时所对应的评估指标值的平均值;

Ⅱ2=JAADbeh 上因素水平为2 时所对应的评估指标值的平均值;

T1=JAADall上所有评估指标值的平均值;

T2=JAADbeh上所有评估指标值的平均值。

分析试验结果可知:(1)视觉特征对行人意图的预测性能影响程度较大,而全局环境上下文信息作为重要的视觉特征在以往的方法中并未被充分地考虑进去,而本文所提出的新全局上下文特征提取模块的有效性也得到了验证。(2)非视觉特征对模型性能的影响程度较小。但之前的工作中有研究者仅根据人体姿态估计进行行人意图预测,并取得了不错的结果,因此这两个因子的信息可能是没有被充分地提取或没有得到有效利用,在后续研究中,也会把对这两个因子信息的提取和应用作为该模型优化的重点方向。

2.4 试验结果分析

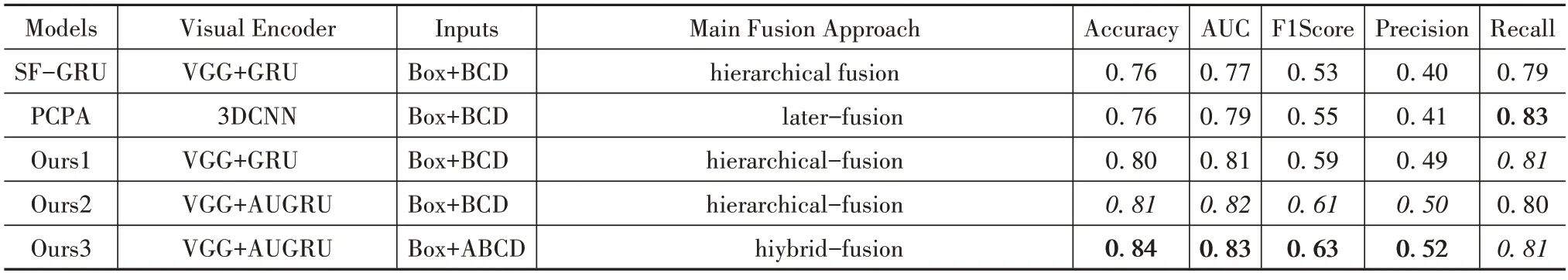

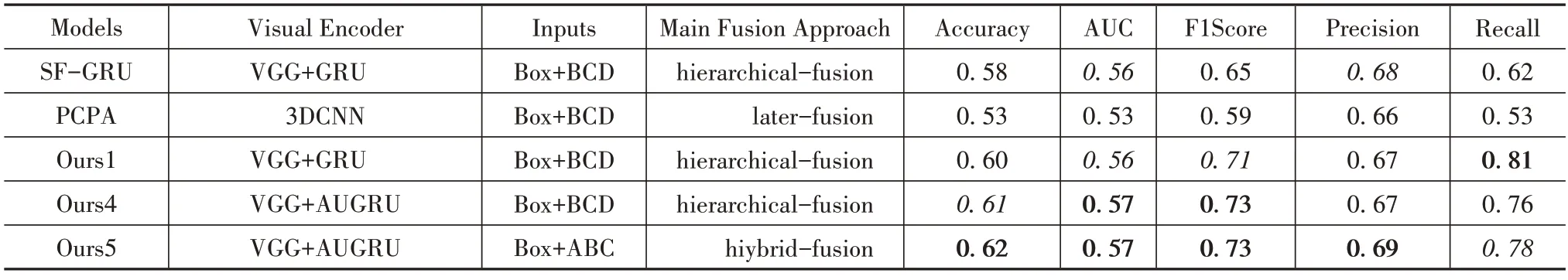

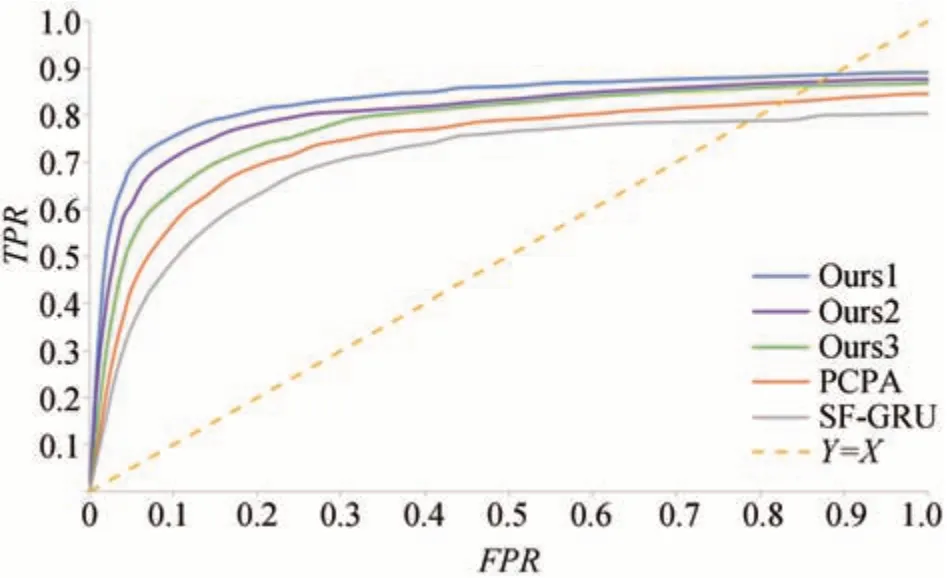

本文遵循相同的数据采样设置,报告了模型优化前后的试验结果,并报告了该模型与其他主流方法的对比结果。定量结果如表5 和表6 所示,图7 和图8 分别为在JAADall 和JAADbeh 数据集上定量试验的ROC 曲线,试验的定性分析如图9 所示。图中ROC 曲线的横纵坐标分别为FPR和TPR,FPR=FP/(TN+FP),TPR=TP/(TP+FN),其中TP、FN、FP和TN分别为分类结果混淆矩阵中的真正例、真反例、假正例和假反例。

表5 JAADall数据集上的定量结果

表6 JAADbeh数据集上的定量结果

图7 JAADall数据集上定量试验的ROC曲线

图8 JAADbeh数据集上定量试验的ROC曲线

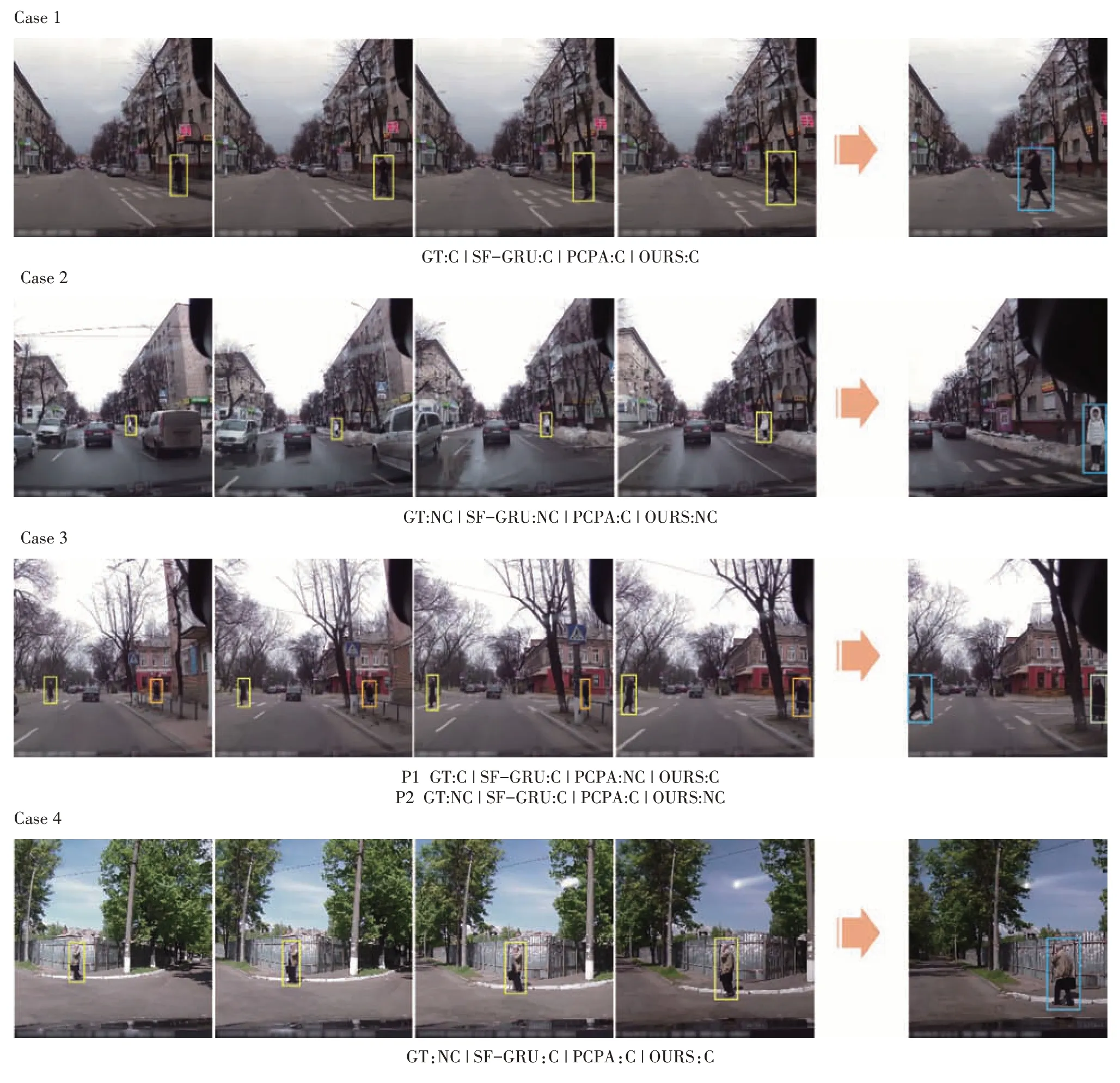

图9 该模型在JAAD数据集上的定性结果

2.4.1 定量试验

为更好地与其他方法进行对比,分别在JAADall和JAADbeh 数据集上选取了3 种模型,前两种模型是在保证与其他方法同输入下的分层融合模型,区别在于第1 种模型中的RNN 采用普通GRU,第2 种模型中的RNN 采用引入注意力机制的AUGRU,第3种则是在正交试验中得到的两个数据集上综合多模态输入条件的最优模型。分析表5和表6可知,除在召回率上略逊于PCPA 模型,本文方法在其它性能指标上的表现均优于现有方法,其综合性能达到了最优水平。分别在两个数据集上对本文提出的模型进行纵向对比,可以发现模型在引入AUGRU 后,除在召回率上略有下降外,其它性能均有较大幅度的提升,且在正交试验中取得的最优模型在两个数据集上的定量对比试验中均取得了最佳的综合性能。

2.4.2 定性试验

图9 所示为本文所提出的模型在JAAD 数据集上的定性结果。观察目标行人前1 s 内的历史信息并预测其在未来1 s的穿越意图,目标行人在图像中被边界框包围。本文主要将所提出的模型与SFGRU 和PCPA 模型进行比较,报告所提出的模型、SF-GRU 模型和PCPA 模型所预测出的行人穿越意图结果,以及数据集中的真实标注(ground truth),意图预测的结果以及实况标签表示为目标行人在车辆前方穿越(crossing)和不穿越(not crossing)。图9 报告了3 个模型在4 个不同场景下的预测结果,图中GT 表 示ground truth,C 表 示crossing,NC 表 示not crossing,图中彩色标签显示为真实标注值和对应的模型预测结果,预测正确时,标签字体显示为绿色,预测错误时,标签字体显示为红色。

仔细分析4个案例可以发现,有以下3种情况较难实现行人意图的准确预测:(1)站在路边或人行道旁但没有穿越意图的人,如Case2 所示。(2)行人的运动方向发生变化,如Case3 所示。(3)车辆运动方向发生变化,导致视角发生变化,如Case4 所示。这些情况下需要结合更多的全局环境上下文信息来预测行人的穿越意图。

根据图9 可知,本文所提出的方法在复杂道路环境下表现略优于SF-GRU 模型和PCPA 模型,尤其是在Case3 中行人运动方向变化的情况下,只有本文方法实现了行人穿越意图正确预测,但在Case4这个具有挑战性的案例中,所有的模型均预测失败,主要原因是这些模型都没有考虑到自车行驶方向这个影响因素。在不知道车辆转弯导致相机视角发生变化的情况下,Case4中的目标行人被误判为在车辆前方朝反方向运动,而实际上该行人只是沿街行走。针对这种情况,未来的工作可以考虑在模型中加入车辆的横向运动信息。

3 结论

本文提出采用正交试验法研究不同模态输入特征对该模型性能的影响显著性,为模型优化方向提供了有力的理论支撑,并通过系统详尽的试验分析获得JAADall 和JAADbeh 数据集上性能最佳的模型架构。通过试验证明了本文所提出的方法有效提高了预测精度,可以起到在智能驾驶领域为决策规划提供可靠依据的作用。此外,该模型不仅适用于城市道路场景,也可用于停车场及其他复杂路况。

根据正交试验的结果,道路交通场景上下文信息对模型性能的影响最为显著,这也验证了本文所提出的新型全局上下文特征提取模块的有效性。试验的自车车速和人体姿态对模型性能的影响较小,未来的研究应把针对这两个特征的提取和应用作为该模型优化的重点考虑方向。此外,JAAD数据集中的数据量有限,在未来的工作中,将在更多的数据集上评估本文所提出的模型,验证其在现实世界中部署的潜力。