强化前景感知的相关滤波目标跟踪

姜文涛,徐晓晴

1.辽宁工程技术大学 软件学院,辽宁 葫芦岛 125105

2.辽宁工程技术大学 研究生院,辽宁 葫芦岛 125105

在现代化数字城市中,目标跟踪技术占据重要地位[1-6],在智能监控[7]、现代化军事[8]和医学图像[9]等领域被广泛应用。但实际生活场景较为复杂多变,这些不确定性给目标跟踪带来了极大的挑战[10]。因此,实现较为鲁棒的目标跟踪仍是一项极具挑战性的任务[11-13]。

相关滤波算法具有鲁棒性强、速度快及精度高等特点,近年来得到了国内外广泛的关注及应用。2010年,Bolme等[14]将信号处理领域的相关滤波方法引入到目标跟踪领域,提出了最小输出误差平方和(minimum output sum of squared error,MOSSE)算法,该算法将计算转换到频域内,在频域内快速学习并检测,有效提高了跟踪速度。2014 年,Danelljan 等[15]提出了判别型尺度空间跟踪(discriminative scale space tracking,DSST)算法,增加了尺度滤波器,使独立的尺度滤波器和位置滤波器分别学习,可以较好地应对尺度变化,提高了尺度自适应能力。随后,Henriques等[16]将多通道的HOG(histogram of oriented gradients)特征引入,提出了著名的核相关滤波(kernel correlation filters,KCF)算法,算法通过核函数将非线性问题转化为线性问题,有效提高了模型跟踪的准确性。相关滤波算法采用循环移位策略进行采样,使算法易受边界效应影响。Danelljan等[17]在2015年提出了基于空间正则化的相关滤波(spatially regularized correlation filters,SRDCF)算法,在扩大检测区域的同时,加入了空间正则化惩罚项,有效缓解了边界效应。2016年,Bertinetto等[18]在DSST算法的基础上融合了颜色直方图特征,提出互补性实时跟踪Staple算法,将相关滤波响应和颜色直方图概率响应以固定权值进行融合,根据融合后的响应进行目标定位。随后,Danelljan 等[19]提出了快速判别尺度空间跟踪(fast discriminative scale space tracking,fDSST)算法,在DSST基础上通过压缩维数和线性插值方式,加快了算法的运算速度。2017 年,Galoogahi 等[20]提出了背景感知相关滤波(background-aware correlation filters,BACF)算法,该算法联合背景信息,扩大循环采样区域,剪裁出高质量样本并增加其数量,有效提高了算法定位精度。2018年,Li等[21]提出了时空正则化相关滤波器(spatial-temporal regularized correlation filters,STRCF)算法,加入了时间正则项并在跟踪过程中只使用上一帧的信息,大幅度提高了算法的精度及速度。2019年,Huang等[22]引入抑制跟踪异常机制,提出了畸变抑制正则化相关滤波(aberrance repressed correlation filters,ARCF)算法,有效避免了由响应图畸变造成的跟踪误差累计问题。2020年,Li等[23]提出了自动时空正则化跟踪(automatic spatio-temporal regularization tracking,AutoTrack)算法,多特征训练滤波器并自适应调整正则化参数,提高了跟踪算法的鲁棒性。2021年,Xu等[24]提出了自适应信道选择判别相关滤波器(adaptive channel selection with discriminative correlation filters,ACSDCF)算法,通过衡量多通道特征的相关性进行通道的选择,可以较好地应对目标变化。

以上相关滤波算法在各个方面都有不同程度的提高,但仍然存在着许多不足。当目标出现形变、快速移动、运动模糊、相似物干扰以及遮挡时,跟踪效果不理想。大多相关滤波方法都是提取单特征进行匹配并且每一帧都进行模型更新,在复杂情况下跟踪鲁棒性较低。另外一些(如Staple)是将多特征以固定权值进行融合,在不同的跟踪情况下并不一定是最优策略。本文针对以上问题提出了强化前景感知的相关滤波目标跟踪,本文采用相关滤波器提取目标的梯度方向直方图(HOG)特征并进行相关运算得到目标的相关滤波响应,同时将改进的颜色直方图干扰感知模型[25]引入,通过加强前景和背景颜色直方图差异部分使得前景像素更加显著,并通过其干扰感知模型预测存在的相似干扰区域并抑制。再将相关滤波响应和颜色直方图概率响应自适应加权融合,融合后的干扰感知响应图中最大值位置即为目标位置,其融合权重通过利用颜色直方图干扰感知模型计算目标区域内像素点为目标的概率均值控制。最后通过平均峰相关能量(average peak-to correlation energy,APCE)值[26]和最大响应值fmax设置高置信度判别条件,只有当两者值都以一定比例高于其历史均值时,认为目标跟踪结果具有较高可信度,再通过计算帧差均值[27]判断目标或背景的变化幅度,当变化较大时进一步通过计算前后帧间欧式距离[28]判断是目标运动还是背景运动,最后针对不同情况设置相应的相关滤波模型更新学习率。

1 相关滤波器原理

fDSST算法是基于DSST的改进算法,在保障了算法鲁棒性的前提下,对位置滤波器提取的HOG 特征采用主成分分析(principal component analysis,PCA)方法进行压缩降维,同时采用插值运算,大大提升了跟踪算法的实时性,从而本文选取此方法作为相关滤波部分的基算法。

首先,手动选取跟踪目标的第一帧,循环采样得到一系列目标样本x(n)∈R(d),fDSST 算法对目标区域提取d维HOG 特征,记作x(l),l∈(1,2,…,d),l表示特征通道。通过构建最小化相关响应与期望输出g之间的代价函数ε获得最优相关滤波器h(l),目标函数如下:

式中,∗为循环相关操作;g为高斯函数类型的期望输出响应分数;λ为正则化参数,用于避免滤波器过拟合;h(l)、x(l)与g具有相同的大小及维数。

为了加速计算,将式(1)的线性最小二乘问题通过Parseval公式转化到傅里叶域进行运算,求解最优相关滤波器H(l):

式中,H、G、X均表示其对应量的离散傅里叶变换(dis crete Fouriertransform,DFT),表示复共轭。首先将H(l)转化为式(3)的分数形式,并采用如下更新策略:

为了提高算法的实时性,fDSST算法引入主成分分析法对特征进行降维压缩,从而减少快速傅里叶变换次数。更新目标模板,再通过最小化目标模板的重构误差ε构建大小为的投影矩阵Rt,用于将高维特征投影到低维子空间。投影矩阵Rt通过式(4)获取:

对于新一帧图像,利用前一帧的目标位置信息在特定的背景区域提取不同维度特征样本,对其进行压缩降维后得到候选样本zt,再经快速傅里叶变换(fast Fourier transform,FFT)得到,计算得到最终的响应分数为:

对上式得到的响应分数Yt进行傅里叶逆变换(inverse fast Fourier transform,IFFT)得到最终的滤波器响应fcf,利用其最大响应值定位目标。相关滤波响应fcf表达式如下:

为了更好地应对跟踪过程中目标尺度不断变化的问题,在定位目标后,采用尺度滤波器估计目标的最佳尺度。尺度滤波器与位置滤波器有相似的滤波学习过程,首先构造尺度金字塔,然后将尺度池中不同尺度通过相关滤波器滤波得到17 维的响应向量,再对17 维响应向量进行插值得到33 维的尺度响应向量,其中最大响应尺度即为所求的目标最优尺度。尺度响应的计算表达式如下:

2 本文算法

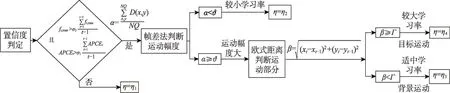

本文在相关滤波算法的基础上融合了增强前景的颜色直方图干扰感知模型,将相关滤波算法得到的目标响应与颜色直方图响应自适应加权融合得到最终的干扰感知响应图,利用此图中最高峰位置定位目标。最后通过平均峰相关能值和响应图最大值联合判断目标跟踪的可信度。当跟踪可信度较低时说明目标跟踪不准确或出现跟踪漂移,不进行模板更新;反之,通过帧差法判断目标变化程度,目标变化程度较大时利用前后帧间欧式距离判断属于目标变化或背景变化。每种情况设置不同的相关滤波模型的学习率以实现模型的自适应更新。本文算法总体框架如图1所示。

图1 总体框架图Fig.1 General frame diagram

2.1 改进颜色直方图干扰感知模型

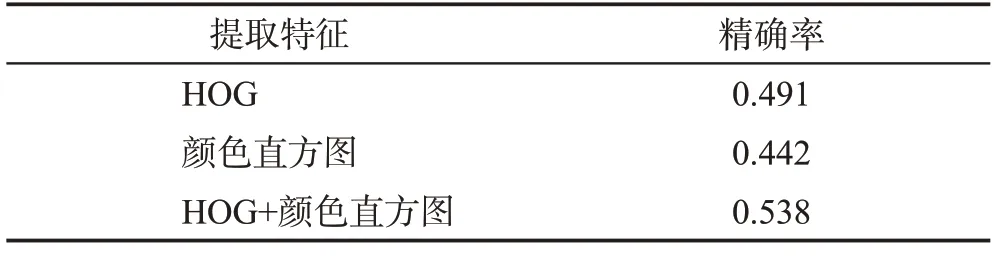

为了提高算法在快速运动、形变、运动模糊及相似物干扰下的跟踪鲁棒性,将颜色直方图干扰感知模型引入本文算法。相关滤波目标跟踪算法提取的特征通常为局部特征(HOG 特征),对运动模糊及光照变化不敏感,如图2(a)所示,但在快速运动、形变等情况下跟踪效果不佳,如图3(a)所示。而统计目标的全局颜色特征对目标外观变化及边缘信息较为鲁棒,可以有效弥补HOG 特征的局限性,如图3(b)所示,但颜色直方图干扰感知模型只关注颜色,不关注像素所处的位置,易受到相似背景颜色干扰,当存在运动模糊及相似颜色背景时,易出现跟踪漂移,如图2(b)所示,此时HOG特征可以较好地应对颜色直方图干扰感知模型的缺陷。因此将两者结合可以有效弥补传统相关滤波算法的缺点,减少目标丢失及漂移情况。为了验证融合特征目标跟踪的有效性,表1分别列出单特征和融合特征进行目标跟踪的精确率。

表1 单特征及融合特征跟踪精确率Table 1 Single feature and fusion feature tracking accuracy

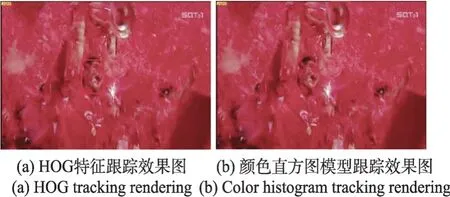

图2 运动模糊及相似颜色背景跟踪序列Fig.2 Motion blur and similar color background tracking sequence

图3 形变及快速跟踪序列Fig.3 Deformation and fast motion tracking sequence

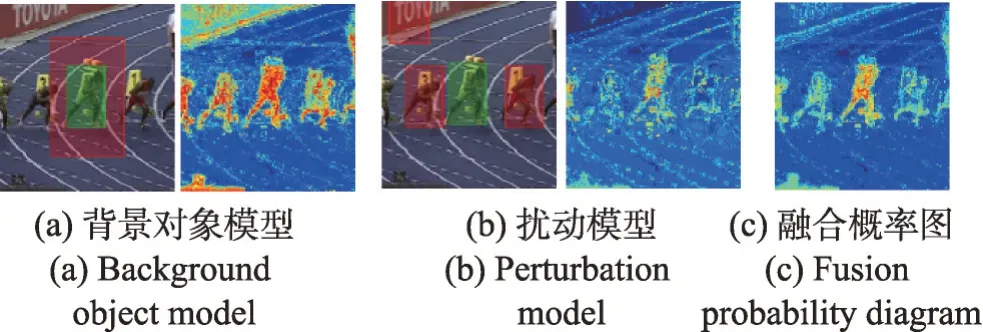

颜色直方图干扰感知模型主要分为三部分:(1)前后背景分离。利用其背景对象模型将目标像素从输入帧中提取出来。(2)利用目标扰动模型预先检测存在的相似干扰区域并对其进行抑制。(3)融合目标区域及干扰区域,得到融合后响应图。图4为颜色直方图干扰感知模型原理示意图。

图4 颜色直方图干扰感知模型原理示意图Fig.4 Schematic diagram of color histogram interference perception model

建立颜色直方图干扰感知模型,为了将目标前景像素和背景像素有效区分开,采用颜色直方图的贝叶斯分类器对目标像素以及背景像素进行建模:

(1)背景对象模型。根据贝叶斯公式得到像素x属于目标区域的概率为:

式中,O和D分别为目标像素区域和背景像素区域;P(ℓx|x∈O)为目标区域O中像素x属于区间ℓx的直方图概率,P(ℓx|x∈D)为背景区域D中像素x属于区间ℓx的直方图概率,计算见式(10);P(x∈O|O,D,ℓx)为构造的贝叶斯分类模型。

(2)前景增强的背景对象模型。在实际目标跟踪场景中,由于相似背景干扰造成的目标跟踪漂移尤为常见。当相似背景干扰出现时,背景像素被误判属于前景的概率较高,为了更加准确地提取前景像素,本文提出了增强前景的颜色直方图干扰感知模型,在传统背景对象模型的基础上重视前景与背景颜色差异部分并增强前景直方图与背景直方图颜色差异分量,增强了目标像素在复杂背景下的显著性,使得前景更加突出,更加准确地将前景像素从背景中分离。图5 为第t帧前景颜色直方图和背景颜色直方图对比,其横坐标为像素值,纵坐标为像素值对应的像素个数,通过加强两个直方图中对应的直方柱的差值达到强化前景像素的目的。因此对式(11)进一步改进:

图5 Green通道前后背景颜色直方图Fig.5 Foreground color histogram and background color histogram of Green channel

其中,Δ=1+ζ∙(P(ℓx|x∈O)-P(ℓx|x∈D));ζ为增强系数,用于控制模型突出前景的程度;P(ℓx|x∈O)-P(ℓx|x∈D)为归一化后的前景颜色直方图和背景颜色直方图的差值。差值越小Δ越趋近于1,此时P(x∈O|O,D,ℓx)值变化较小,而差值越大说明像素点在两个直方图对应的直方柱上差异越大,是前景相对突出的部分,Δ同样增大,同时P(x∈O|O,D,ℓx)值也变大,说明像素点x属于目标区域O的似然概率越大,从而计算得到突出前景的像素为目标区域的概率,达到突出前景的目的。

(3)为了进一步提高模型抗扰动能力,引入目标扰动模型:

式中,K为目标扰动区域,即与目标外观相似区域。

(4)将改进的背景对象模型与扰动模型整合得到目标的联合概率模型如下:

式中,υ为设定的权重。

通过上式得到像素级颜色概率图,搜索所有与预测尺度大小相等的目标候选框Ot,i,采用积分法计算每个候选框内像素属于目标区域的概率和,此概率和为对应目标框中心位置为目标中心位置的概率,从而得到改进的颜色直方图干扰感知模型中心位置响应图fhist(I)。

式中,Pt(x)=P(x∈O|ℓx)为第t帧图像中像素x为目标区域的概率。

为了更加适应光照及形变变化,对颜色直方图概率模型进行更新:

式中,ηtemp为模型更新学习率。

2.2 自适应融合相关滤波响应与颜色直方图响应

大多数现有的多特征融合算法都是以固定权值进行线性融合,在复杂场景下并不一直是最优策略,因此本文采用自适应特征融合策略进行相关滤波响应和颜色直方图干扰感知模型概率响应的融合,其加权融合示意图见图6。

图6 自适应加权融合示意图Fig.6 Diagram of adaptive weighted fusion

(1)当判别器认为像素点x属于目标时,Pt(x)的值会增大,同时区域内像素属于目标的概率均值也会变大,这时要增加算法对颜色直方图干扰感知模型概率响应的关注,此时利用颜色直方图干扰感知模型计算目标区域像素点为目标的概率均值M来确定自适应融合权值ω,即:

式中,O∗为颜色直方图干扰感知模型计算得到的目标区域,即n为目标区域O∗中的像素个数。

考虑到概率均值M计算的准确性,在计算像素点为目标的概率均值M基础上减掉像素点属于环绕背景区域D的概率均值,确保了概率均值M的相对准确性。因此将式(17)进一步改进得到更加精确的概率均值M′如下:

(2)在有颜色相似物体干扰下,由于颜色直方图概率模型只关注颜色特征,不关注像素的具体位置,此时易将颜色相似的背景像素错判为目标像素,Pt(x)值和概率均值M′同样会增大,这时HOG 特征比颜色直方图特征更加鲁棒,应减小颜色直方图干扰感知模型概率响应的权值并控制其所占权重ω小于0.5,防止学习到过多背景信息。因此设置阈值ρ,当概率均值M′≥ρ时,权重ω采用指数函数计算得到:

图7为Skating序列下各特征跟踪效果图,图7(a)为各特征在序列第220 帧到350 帧的跟踪置信度曲线图,其中第225~229 帧目标发生形变、第273~278帧目标发生快速运动,HOG 特征跟踪置信度较低。结合图7(b)和图7(c)可以看出,此时利用HOG特征跟踪出现了严重的偏差,而颜色直方图特征准确率较高,此时本文算法增加颜色直方图的融合权重,使得算法可以较为准确地跟踪到目标。第317~322 帧目标运动模糊,第337~345 帧存在相似颜色背景干扰,如图7(d)及图7(e)所示,颜色直方图特征跟踪结果误差较大,此时本文算法选用指数函数降低了颜色直方图算法融合权重,有效提升了算法的跟踪性能及鲁棒性。基于图7的定量及定性分析,结果显示本文算法控制权重具有可行性及有效性。

图7 Skating序列各特征融合效果分析Fig.7 Analysis of fusion effect of Skating sequence features

最终融合后的干扰感知响应为:

2.3 目标定位

本文在目标定位阶段利用得到的最终扰动感知响应图的最大位置定位目标。该融合响应图最大值位置即是所寻求的目标位置。

式中,Wt为确定的目标最终位置。

2.4 自适应模型更新策略

在目标连续跟踪过程中,目标必然受到形变、旋转、快速运动及遮挡等噪声影响,处于不断变化的过程中。因此选择一个合适的模板更新策略应对不断变化的情况,确保更新过程中不出现效果退化是目标鲁棒跟踪的关键之一。现有的目标模型更新算法大多都是采取逐帧并且以固定学习率进行更新,没有考虑当前帧跟踪结果的可靠性及目标的变化程度,可能导致误差累计,则在复杂情况下滤波器不能较好地跟踪到目标,最后影响跟踪效果。因此本文基于平均峰值相关能量值和响应图最大值fmax判断目标跟踪的可靠性,并采用自适应更新学习率策略更新相关滤波模板。自适应模型更新策略流程如图8所示。

图8 自适应模型更新策略流程图Fig.8 Flow chart of adaptive model update strategy

(1)高置信度判定条件

fmax是以响应图的峰值从局部的角度反映跟踪置信度,不考虑响应图的旁瓣值,APCE 值可以反映响应图震荡变化程度,是从整体的角度反映跟踪置信度。因此将两个指标互补结合可以更好地从多角度反映跟踪过程是否出现异常情况,具有较好的普适性。当跟踪目标较为明显或受干扰较小时,此时将得到较为理想的响应图,即响应图为单峰形式且APCE值较高;反之,当目标受到背景较大影响,遮挡甚至跟踪丢失时,APCE 值会极速减小。同时,在整个跟踪过程中目标变化对响应图的影响具有连续性,因此将历史帧置信度信息融入高置信度判定部分。只有在当前帧的APCE值以σ1的比例超过历史帧APCE均值且当前帧fmax值以σ2的比例超过历史帧fmax均值时,才可认为当前帧的跟踪结果具有较高的置信度,否则认为出现异常情况,不进行模型更新。只有同时满足以下两个条件时,认为当前帧跟踪结果具有较高置信度。

式中,APCEt为第t帧平均峰相关能量,计算公式见式(23);ft,max为第t帧响应图最大值;σ1及σ2为设定的比例系数。APCE值的计算公式如下:

式中,fmax为响应图的峰值;fmin为响应图的最低值;fx,y为坐标(x,y)处的响应值。

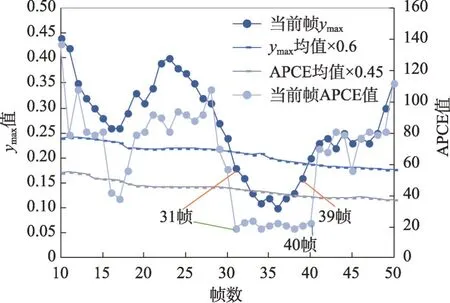

图9为coke视频序列在跟踪过程中,各置信度分量变化情况,其中目标从第28 帧到第42 帧出现遮挡。由图可以看出,第31帧到第39帧,fmax曲线位于fmax置信度曲线下方,此时不符合式(22)所设条件,同理在第31帧到第40帧,APCE值位于APCE置信度曲线下方,不满足高置信度条件。因此,跟踪模型在第31帧到第40帧属于低置信度区间,不进行模型更新,有效避免了学习过多背景信息造成模型的错误更新。

图9 coke视频序列跟踪置信度分量变化Fig.9 Component changes of coke sequence tracking confidence

(2)自适应更新模型学习率

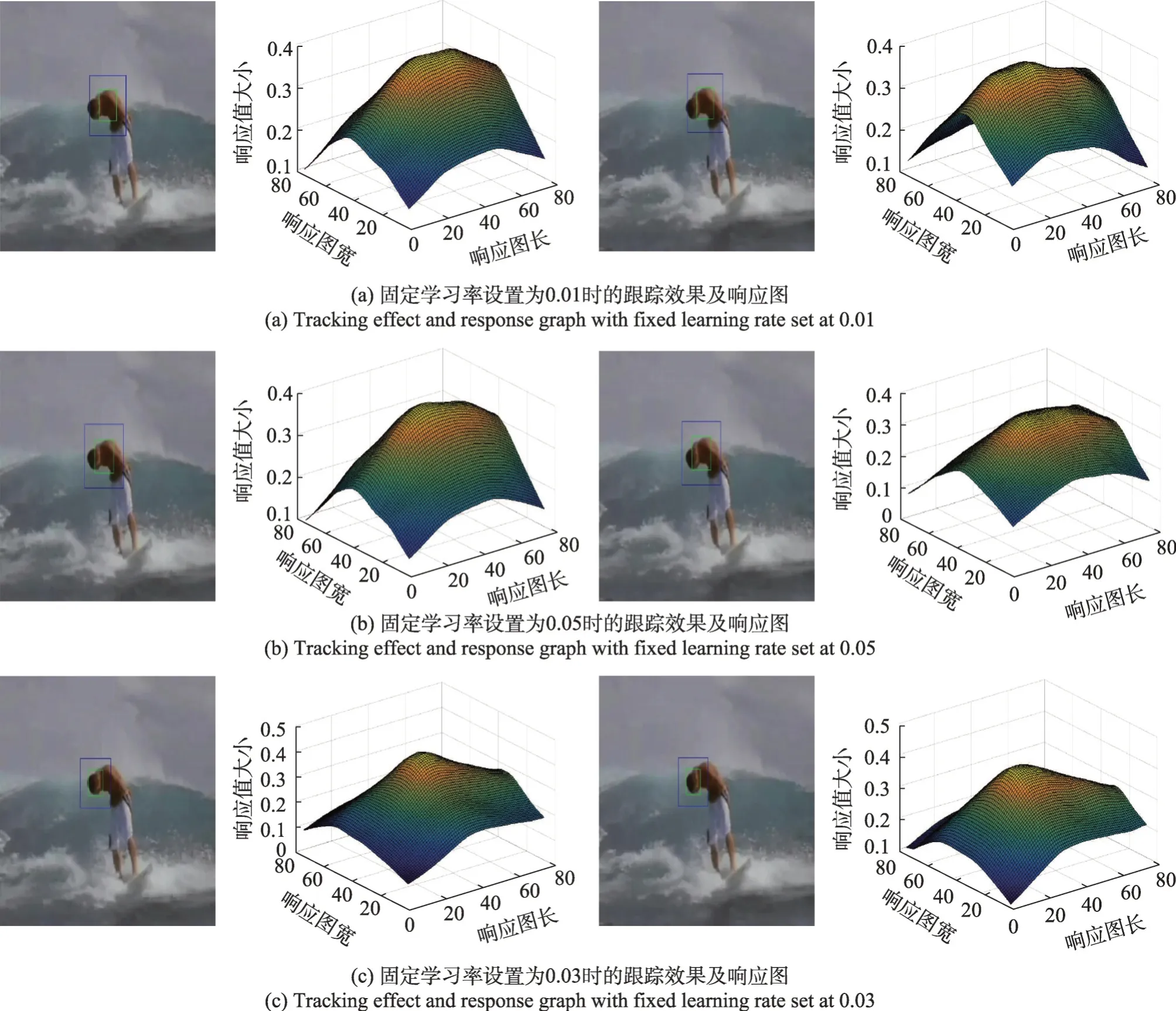

在跟踪过程中,当目标出现形变、旋转和快速运动等情况时,容易导致跟踪漂移,这是因为当目标发生较大变化时,设置的固定学习率较小不能使模型快速学习到目标的变化,只能学习当前帧中较少的信息,从而导致跟踪结果不准确,如图10(a)所示。若设置的学习率过大,一旦上一帧由于遮挡、形变、快速运动等因素导致跟踪结果有偏差时,模型会大量学习背景信息,误差累计到一定程度模型可能会将背景误判为跟踪目标,导致目标丢失,如图10(b)所示。而图10(c)为学习率适中的跟踪效果,针对以上问题,本文提出了联合帧差法及前后帧间欧式距离判断目标的变化程度并设置相应的相关滤波更新学习率,达到自适应更新模型的目的。

图10 不同学习率下的跟踪效果图Fig.10 Tracking renderings of different learning rates

①通过(1)判断当前帧跟踪结果的置信度,当置信度不满足高置信度条件时,不进行模型更新,学习率保持不变。此时η=η1。

②当置信度满足高置信度条件时进行模型更新,此时用式(24)帧差法判断目标的变化程度,设置阈值ϑ,当帧差均值α<ϑ,说明目标或背景变化幅度较小,仅需设置较小的学习率,此时η=η2;反之说明变化较剧烈,需要进一步判断是目标变化还是背景发生变化。

式中,α为帧差均值;D(x,y)为前后两帧图像的灰度差;N、Q为差分图像大小。

③通过②可判断目标或是背景变化的幅度,当α≥ϑ变化幅度较大时,通过计算前后两帧的欧氏距离β判断目标是否发生较大运动,设置阈值Γ,当欧式距离β<Γ时,说明目标的移动位移较小,可能是背景在发生变化,此时设置适中学习率η=η3;反之,当α≥ϑ且β≥Γ时,说明目标发生了较大位移,此时目标可能发生了较大的变化或处于快速运动状态,此时应该设置较大的学习率,使算法可以更好地适应目标变化η=η4。

欧式距离β计算公式:

通过(1)和(2)判断目标状态并根据其状态设置不同的学习率η,保证在相邻两帧目标变化较小时设置较小的学习率,目标变化较大时设置较大学习率来加快对模型的更新,通过自适应改变学习率可以使模型更好地跟踪到目标。

2.5 算法步骤

(1)建立初始帧样本模型。手动选定初始帧跟踪目标和目标框位置(x,y)及其背景区域。

(2)滤波器训练。提取目标的HOG特征,通过式(2)和式(9)训练二维位置滤波器和一维尺度滤波器,同时通过式(14)训练颜色直方图干扰感知模型。

(3)定位目标。截取目标候选区域并提取特征,将其与上一帧训练得到的相关滤波器通过式(7)和式(8)进行相关运算,生成相关滤波响应图fcf(I)。同时利用改进的颜色直方图干扰感知模型通过式(14)计算像素属于目标区域的概率,然后代入式(15)得到颜色直方图概率响应fhist(I),最后通过式(18)和式(19)确定fcf(I)和fhist(I)的融合权重ω并代入式(20)计算融合后的干扰感知响应图f(I),此响应图最高峰位置即为目标所在位置。

(4)高置信度判别。利用APCE值和最高响应值fmax进行可靠性判断,通过判别结果转至步骤(6)选择相应的更新策略。

(5)目标尺度估计。根据式(9)创建尺度金字塔,利用尺度滤波器计算最大响应求得目标的最佳尺度。

(6)自适应模型更新。步骤(4)判别跟踪结果满足高置信度条件时,通过式(6)更新颜色直方图干扰感知模型,同时利用式(24)及式(25)确定相关滤波自适应更新学习率η,实现相关滤波模型的自适应更新。

(7)输出跟踪结果。将跟踪结果可视化输出,跳转至步骤(2)继续跟踪下一帧图像目标。

3 实验结果分析

3.1 实验环境及参数配置

本文算法采用GUN Octave 作为实验测试开发平台,处理器为Intel®CoreTMi5-9300H CPU,操作系统Windows 10,8 GB内存。本文算法参数设置:相关滤波位置滤波器中,初始未压缩的特征维度d=32,降维后的特征维度=17,正则化参数设置为λ=0.001。颜色直方图干扰感知模型中:前景增强系数为ζ=9.5,联合概率模型融合权重υ=0.3,模型学习率ηtemp=0.04。尺度模型中:尺度因子a=1.02,压缩后的特征维数s=17。自适应融合阈值ρ采用最优化步长逼近方式获得:阈值ρ取值范围为(0,1),根据设置的步长由粗到精地找到最佳阈值ρ的大小。首先将起始步长设置为0.1,根据逐次实验得到其最佳阈值大小为0.4。再以0.4为中心、以长度为0.02的步长为基准在范围(0.34,0.46)内进行逐次实验比较,其实验得到的最佳阈值的取值为ρ=0.38,最后以0.01长度为基准步长在范围(0.35,0.41)进行对应的实验比较,得到最终的最优阈值取值为ρ=0.38。置信度比例值的设定:σ1=0.45,σ2=0.60。目标更新学习率及其阈值大小的设定:帧差阈值及位移阈值同样通过步长逼近方式经过多次实验比对获得,其中帧差阈值设定为ϑ=3.5,目标位移阈值为Γ=11。四种学习率分别设置为η1=0,η2=0.005,η3=0.009,η4=0.02。

3.2 评价指标

本文选取OTB100 数据集用于与其他主流算法进行实验对比,OTB100数据集是目标跟踪实验中常用的数据集,其包含100个涉及了11种不同视觉目标跟踪挑战属性的视频序列。OTB100 数据集包含的11 种属性分别为:光照变化(illumination variation,IV)、尺度变化(scale variation,SV)、遮挡(occlusion,OCC)、非刚性变化(deformation,DEF)、运动模糊(motion blur,MB)、快速运动(fast motion,FM)、平面内旋转(in-plane rotation,IPR)、平面外旋转(out-plane rotation,OPR)、超出视野(out of view,OV)、复杂背景(background clutter,BC)、低分辨率(low resolution,LR)。这11 种属性可以更加清晰地、综合地与其他算法进行跟踪性能的对比。本文算法采用一次性通过评估(one-pass evaluation,OPE)分析算法的性能及鲁棒性,以第一帧标注的目标位置为初始位置,测试整个视频序列组,将跟踪成功率和精确率作为评价标准。

3.3 对比实验结果分析

本文选取了8种主流算法进行对比实验,验证其有效性及鲁棒性。对比算法分别为:STRCF、BACF、fDSST、Staple、ARCF、DeepSTRCF、AutoTrack、ACSDCF。

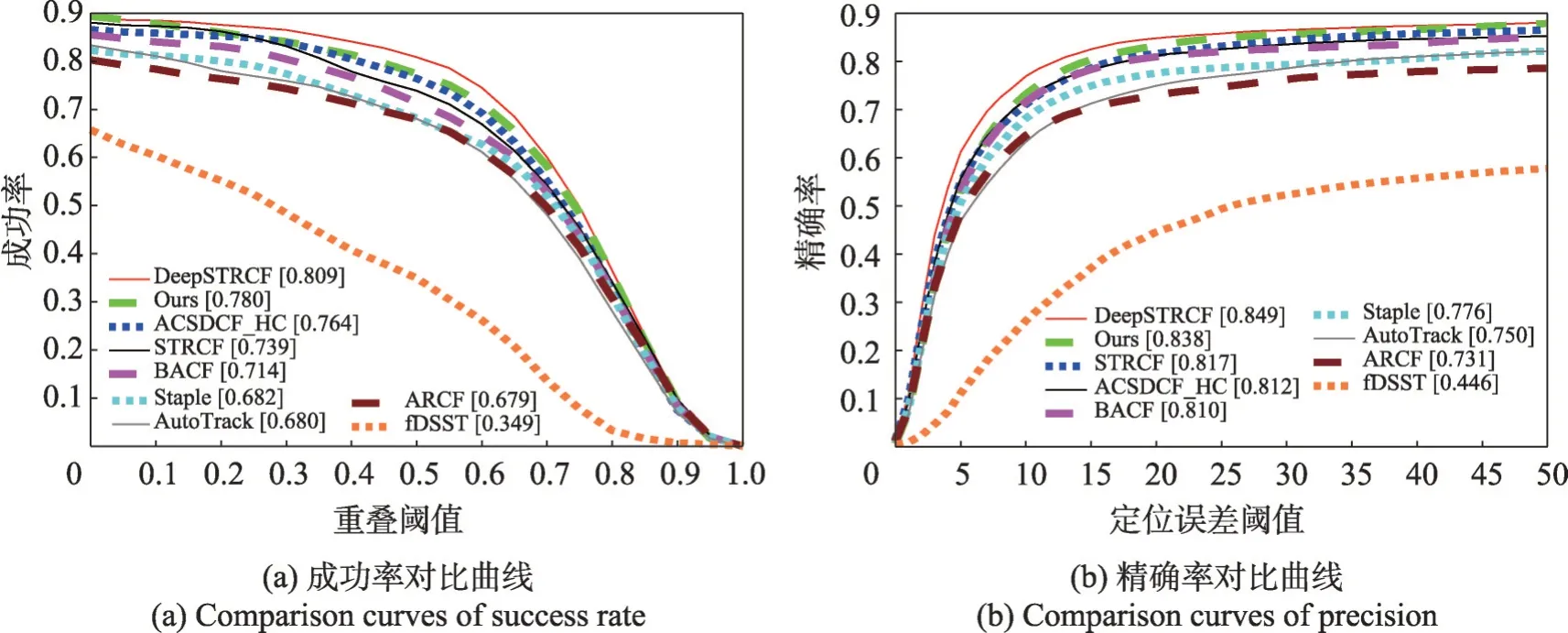

3.3.1 定量比较

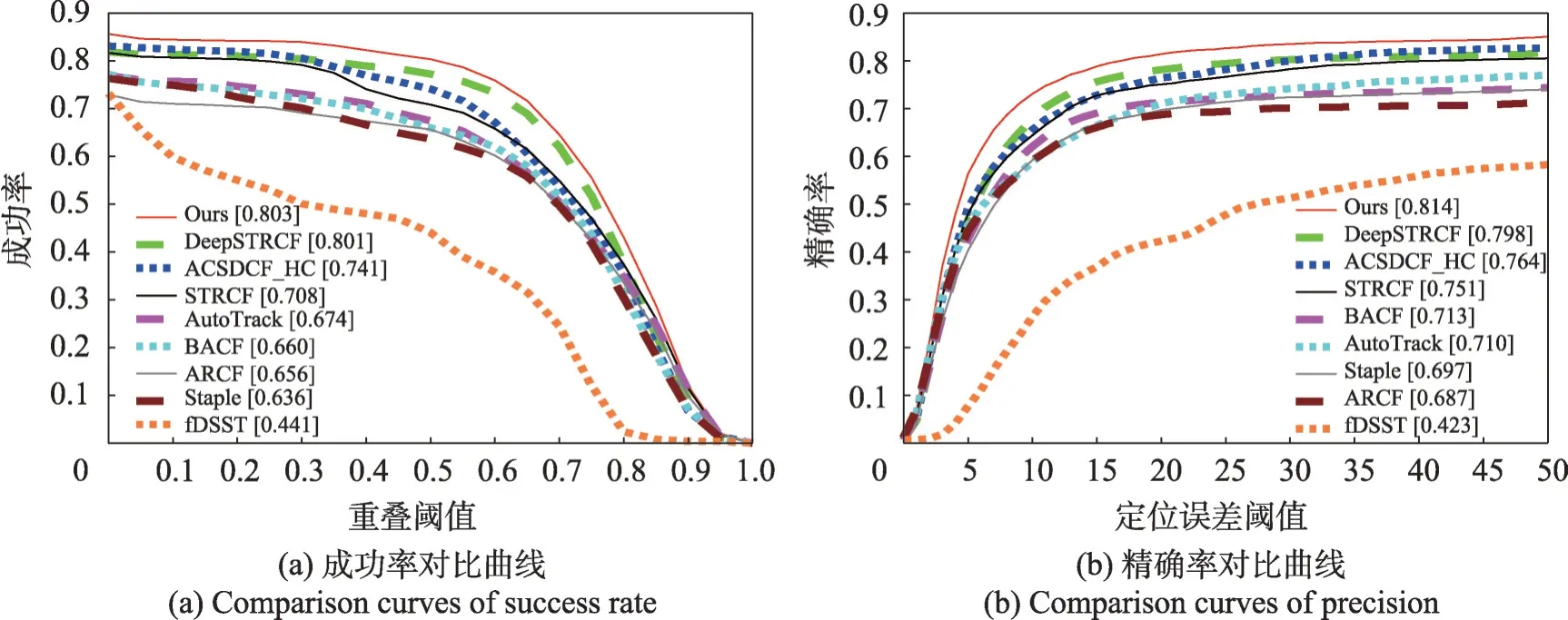

图11 为9 种算法在OTB100 数据集上的精确率和成功率曲线,本文算法的成功率为0.780,仅低于深度学习DeepSTRCF算法0.029,高于次优ACSDCF算法0.016,精确率为0.838,低于深度学习DeepSTRCF算法0.011,高于次优STRCF 算法0.021。本文在相关滤波的基础上结合了强化前景的颜色直方图干扰感知模型,有效弥补了相关滤波算法采用局部特征进行特征提取时,对于边缘模糊情况下跟踪精度较低的不足,因此提高了目标在形变、运动模糊及快速运动挑战下的鲁棒性,整体性能最优。最后,进行异常分析和自适应更新学习率,跟踪异常出现时,不更新模型,有效避免了学习过多背景信息造成的跟踪漂移。由图12 可见,本文算法在形变属性下成功率和精确率都达到了最高,分别是0.768和0.843。如图13 所示,本文算法在运动模糊属性下成功率和精确率达到了0.803 和0.814,远远超过其他算法。如图14 所示,本文算法在快速运动属性下成功率和精确率高达0.796和0.818,均位居第一。

图11 9种跟踪算法对比曲线Fig.11 Comparison curves of 9 tracking algorithms

图13 9种跟踪算法运动模糊属性对比曲线Fig.13 Comparison curves of 9 tracking algorithms motion blur sequence

为了更加直观地对比本文算法与其他算法在各属性下的跟踪效果,表2 和表3 分别列出了这9 种算法在OTB100 数据集上11 种视频属性下的跟踪精确率和成功率。

表2 9种跟踪算法在各属性序列上的精确率得分Table 2 Precision scores of 9 tracking algorithms on attribute sequences

表3 9种跟踪算法在各属性序列上的成功率得分Table 3 Success scores of 9 tracking algorithms on attribute sequences

3.3.2 定性分析

为了更加直观地比较本文算法和其他8 种算法在这11种属性下的跟踪效果,图15列出了包含这11种属性的部分视频序列。

图15 各算法跟踪结果对比Fig.15 Comparison of tracking results of each algorithm

skiing序列中包含了形变、旋转、背景杂乱、低分辨率及尺度变化等视频属性。在第11 帧时,目标发生了第一次旋转及形变,导致ACSDCF、STRCF、ARCF、fDSST 及DeepSTRCF 算法均发生不同程度的漂移;到第15 帧时,AutoTrack 和Staple 算法不能够及时学习到目标变化也逐渐发生漂移;在第22帧到第51帧,目标不断发生旋转和形变,且背景较为杂乱导致目标分辨率较低,而本文算法在传统背景对象模型的基础上突出了前后背景的颜色差异分量,更好地应对杂乱背景,此时只有本文算法和BACF算法能够准确地跟踪目标,其他算法均漂移到了背景上,导致目标丢失;到第63 帧时,目标发生形变且远离摄像头,造成目标尺度发生变化,BACF算法不能适应目标的尺度变化导致跟踪框较大,包含了较多的背景信息,降低了跟踪精度。此时只有本文算法可以精确定位目标,其余算法均存在跟踪误差。

在Bolt2视频序列中,目标具有形变、尺度变化等属性并存在大量相似物干扰。在第8帧时,目标发生自身形变,此时从图中可以看出ACSDCF、STRCF、ARCF、AutoTrack、fDSST算法不能适应目标的变化,在跟踪过程中学习到较多的背景信息,从而逐渐导致目标跟踪漂移,而本文算法采用自适应更新学习率策略并结合了全局颜色特征可以更好地应对目标形变;在第11帧时,ARCF及STRCF算法甚至跟踪漂移到了目标相似物上,而本文算法改进了增强前景的背景对象模型,可以有效避免相似物的干扰;在第22帧到第33帧,目标形变较大且出现自身尺度变化,DeepSTRCF、Staple、BACF算法逐渐发生不同程度的漂移,只跟踪到了目标的一部分,只有本文算法跟踪较为准确;到第86 帧,目标一直发生形变及尺度变化,只有本文算法可以准确地跟踪到目标,其他算法均发生严重漂移。

DragonBaby视频序列中包含快速运动、遮挡、旋转、形变、出视野等属性。第27帧到第32帧,目标第一次发生旋转并造成形变和自身遮挡,在翻转开始时(第27帧)除本文算法、ACSDCF、BACF算法,其他算法均发生漂移,第32帧目标再次出现时,BACF 和ACSDCF出现中度漂移,只有本文算法和DeepSTRCF算法较准确地定位到目标;在第45帧时,目标由于快速运动造成运动模糊和出视野,此时仅有本文算法正确跟踪到目标,其他算法不能较好地提取到目标特征导致跟踪漂移;在序列第82 帧到第91 帧,由于目标再次发生快速运动及自身形变,仅本文算法和ACSDCF 可以准确定位目标,其他算法不能较好地学习到目标的变化,导致目标丢失。本文引入了颜色直方图模型,因此对目标外观变化及边缘信息较为鲁棒,可以较好地解决快速运动、形变及运动模糊造成的目标丢失问题。

在Girl2 视频序列中,存在遮挡、形变、尺度变化及运动模糊等挑战。从初始帧到第102帧,所有算法均可准确地跟踪到目标;第107帧到第134帧目标出现遮挡,目标被部分遮挡时(第107 帧),ARCF 和fDSST算法完全漂移,Staple、BACF算法也部分漂移到遮挡物上;到第135帧时遮挡结束,目标再次出现,从第135帧到第295帧,只有本文算法和ACSDCF算法可重新定位到目标,其余算法均发生严重漂移,丢失目标;第345帧时,目标自动移动到STRCF、DeepSTRCF算法目标跟踪框位置时,STRCF 和DeepSTRCF 算法才重新跟踪到目标;在第972帧时,目标出现形变及尺度变化,ACSDCF 算法不能适应目标的尺度变化,同时STRCF 及DeepSTRCF 算法也只能跟踪到目标的一部分,出现中度漂移。从初始帧到最后一帧只有本文算法可以准确跟踪目标,说明本文算法对于遮挡、形变及尺度变化的鲁棒性较高。

在BlurOwl 序列中,目标具有快速运动、旋转及运动模糊等属性。从序列第47 帧到第52 帧目标发生旋转、快速运动并导致运动模糊,可以看到Staple、BACF、fDSST、ARCF 算法跟踪精度显著降低,出现一定程度的漂移;序列第68帧、第155帧及第443帧,摄像头再次快速旋转导致目标模糊严重、分辨率较低、目标边缘特征极不明显,此时,DeepSTRCF、ACSDCF、AutoTrack 和STRCF 算法提取不到目标的边缘轮廓特征,出现严重漂移,只有文本算法准确定位目标。本文算法利用强化前景的颜色直方图模型进行颜色特征统计,有效弥补了局部特征的缺陷,增强了目标在快速运动及运动模糊等挑战下的鲁棒性,使算法较准确地跟踪到目标。

在Matrix 视频序列中,目标背景比较复杂,存在光照变化、形变、快速运动等属性。在第21 帧时,目标自身旋转,ARCF、AutoTrack算法首先丢失目标;在第36 帧,目标发生旋转及快速运动,ARCF、STRCF、Staple、BACF、DeepSTRCF 及ACSDCF 算法陆续脱离正确位置,丢失目标;在序列第44 帧时,出现严重光照变化,此时只有本文算法具有较高的适应性,准确跟踪目标;在第50 帧到第72 帧,目标一直处于复杂背景及光照变化条件下,同时目标姿态也不断发生变化,BACF 和ACSDCF 算法跟踪精度较低,部分跟踪框漂移到背景上,其他算法均丢失目标,仅本文算法精确定位目标。

3.4 实时性分析

本文从OTB100 数据集中随机选取了30 组视频序列进行算法的跟踪实时性对比,以每秒读取帧数的平均值作为跟踪速度的评价指标,9种算法的测试结果如表4所示。结合表2及表3,结果显示,相比其他算法,本文算法在保障了算法实时性的前提下,有效提高了跟踪算法的性能。

表4 9种跟踪算法在各属性序列上的平均跟踪速度Table 4 Average tracking speed of 9 tracking algorithms on attribute sequences 单位:FPS

4 结束语

针对传统相关滤波算法通常提取局部特征(HOG 特征)导致目标边缘信息模糊或发生变化时,跟踪效果不佳的问题,本文在相关滤波算法的基础上自适应融合了颜色直方图干扰感知模型,两者有效互补减少了跟踪的局限性,且本文改进了颜色直方图干扰感知模型,增大前后背景颜色差异部分以达到强化突出前景的作用。因此,提高了目标在形变、运动模糊、快速运动及相似物干扰等挑战下的跟踪鲁棒性。同时,进行跟踪异常判断,当跟踪精度较低时,不更新模型,有效避免了目标错判及学习较多背景信息。另外,当跟踪置信度较高时,自适应更新学习率使得跟踪模板可以较好地适应目标变化。本文算法在OTB100数据集上进行了大量的对比实验,本文的成功率和精确率均高于其他8种主流算法,表明本文算法具有较高的跟踪准确性及鲁棒性。本文算法虽满足跟踪实时性,但为了进一步提高算法速度,在今后的工作中考虑将相关滤波算法与深度学习算法进行结合。